简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在当前的技术环境下,大型语言模型(LLMs)已经成为人工智能领域的一个重要里程碑。这些模型能够在各种任务上展现出人类水平的性能,包括但不限于文本生成、语言理解和问题解答。随着开源项目的发展,个人开发者现在有机会在本地部署这些强大的模型,以探索和利用它们的潜力。本文将详细介绍如何使用Ollama,一个开源项目,在Mac上本地运行大型模型(Win同理)。通过遵循以下步骤,即使是配备了几年前硬件的电脑,

随着大语言模型(LLM)的快速发展,将企业内部知识库与 AI 工具结合成为热门解决方案。作为一名技术探索者,我对构建私有知识库充满兴趣,也希望测试 LLM 的能力,尤其是像 Ollama 和千问这类模型。此外,AnythingLLM 是一个开源项目,具有较高的社区关注度,因此我决定对其进行深入调研。基于 RAG(检索增强生成)技术,AnythingLLM[1] 提供了从数据处理到用户界面的全栈解决

聊天机器人看着是一个很简单的功能,但能把聊天机器人做好却不是一件简单的事**”**在大模型的众多应用中,聊天机器人可以说是其中比较简单,也是拥有众多应用场景的一个功能;从技术的角度来说,聊天机器人的实现很简单,但其实也很复杂。那到底怎么实现一个聊天机器人呢?聊天机器人的实现对很多学习大模型技术的人来说,可能聊天机器人就是你的第一个实操项目;原因就是其实现起来比较简单,从技术实现来看只需要使用大模型

2025年AI大模型学习路线指南:从零基础到实战进阶 摘要:本文针对2025年AI大模型学习需求,系统梳理了高效学习路径,避免常见误区。学习路线分为四个阶段:1-2周基础认知(理解原理与应用场景)、3-6周核心实践(掌握Prompt工程、RAG、LangChain等工具)、2-3个月深度优化(学习微调与评估方法),最后持续项目实战。强调"先建立框架再深入细节"的学习逻辑,推荐结

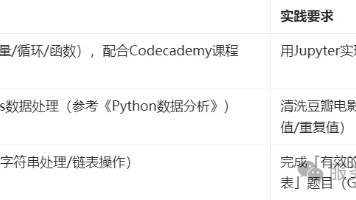

本文为非科班背景人士提供AI转型全攻略,涵盖自学资源、项目经验、职业突破策略和企业面试要点。详细规划了100天机器学习计划,分基础构建、技能突破和求职冲刺三阶段,配合GitHub热力图、Kaggle竞赛等学习监控工具。强调通过做中学,每日坚持代码提交,最终实现从零基础到具备大模型开发能力的转变。推荐AI辅助编程工具提升学习效率,证明持续学习热情与执行力比初始学历更重要。

最近DeepSeek异常火爆,我也积极的体验,研究它的API和模型,确实很Nice,搞私活真的很香,搭建个人的知识库也很爽!今天继续给大家带来手把手的教学,本地化搭建DeepSeek+RAGFlow,构建个人知识库!掌握了本文的方法, 你也可以在骚气的搭建个人知识库,首先要说明下为啥要构建个人知识库呢?在线版DeepSeek需要将数据传输到云端服务器处理,存在日志留存的可能,用户需要信任服务商的隐

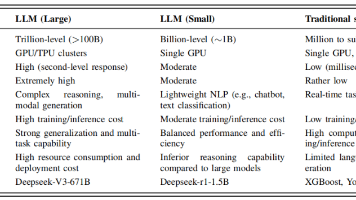

本文提出Sentosa LLM智能维护框架,通过分层架构整合大模型语义理解与小模型精准计算能力,针对工业场景实时性、可靠性等挑战提出解决方案。经通信机房节能与储能电站故障检测案例验证,该框架显著提升预测精度、决策可解释性和协同效率,为智能维护系统发展提供新方向。

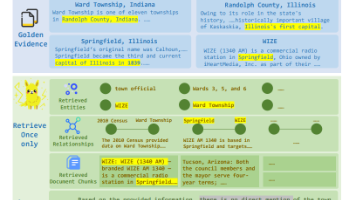

GraphSearch解决了GraphRAG两大痛点:检索浅导致关键实体丢失和图结构闲置。通过六模块Agent循环(QD、CR、QG、LD、EV、QE)实现深度检索,结合双通道检索(语义查文本+关系查图)提升召回率10-20%。该方法无需微调,即可插即用,在多个数据集上SubEM指标最高提升46%,显著降低token消耗30%+,是RAG开发者的实用工具。

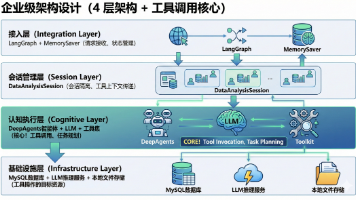

本文详细介绍如何使用LangChain团队推出的DeepAgents框架构建MySQL数据分析助手。文章阐述了DeepAgents的核心能力(任务规划、工具调用等)及在数据分析中的优势,深入解析了基于会话的分层架构设计和工具调用实现原理,包括获取表名、表结构、执行SQL等核心功能。通过完整的环境配置、代码实现和Agent Chat UI可视化调试指南,帮助开发者快速搭建企业级数据分析助手,实现从查

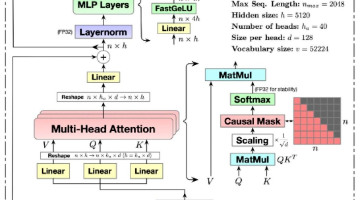

本文以Qwen3-Coder-FP8模型为例,详细分析了其参数量和计算量。模型由62层transformer组成,采用MoE架构,其中FFN部分参数占比高达97.5%。文章计算了Attention和FFN两部分的参数量与计算量,指出当序列长度超过8.7K时,Attention计算开销将超过FFN。此外,还介绍了GQA技术对KV Cache的优化作用。此分析有助于理解大模型的资源需求和性能瓶颈。