简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

LangChain是由哈佛大学Harrison Chase于2022年10月开发的开源框架,专注于大语言模型(LLM)驱动的应用开发。其核心功能是连接LLM、外部数据与工具,支持智能体、问答系统等应用搭建,并集成主流LLM如GPT、Claude。LangChain生态包含核心组件(Chains、Agents)、第三方集成(langchain-community)、基础抽象层(langchain-c

本文围绕扣子Coze平台展开,先介绍其作为字节跳动打造的一站式AI Bot开发平台,能降低开发门槛,让无编程经验者也可搭建智能Bot,还具备多场景适配、可视化调试等优势。接着讲解AI工作流,它可借助AI技术拆分并自动化业务流程,在多领域落地。最后详细阐述了Coze从开发平台创建、智能体与工作流添加,到工作流搭建、模型发布的完整步骤。

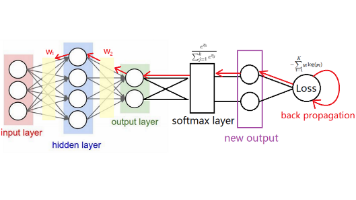

本文围绕“掌握梯度下降、链式法则、反向传播”目标,详解多层神经网络训练技术。先回顾梯度下降,说明参数更新公式及学习率影响,解析Epoch、Batch、Iteration概念,对比BGD、SGD、Mini-Batch差异;再讲前向传播数据流转、反向传播误差传递逻辑,借复合函数示例讲链式法则,附常用函数导数;结合PyTorch代码实现网络构建、正反向传播与参数更新;最后通过计算图和Softmax推导,

本文围绕扣子Coze平台展开,先介绍其作为字节跳动打造的一站式AI Bot开发平台,能降低开发门槛,让无编程经验者也可搭建智能Bot,还具备多场景适配、可视化调试等优势。接着讲解AI工作流,它可借助AI技术拆分并自动化业务流程,在多领域落地。最后详细阐述了Coze从开发平台创建、智能体与工作流添加,到工作流搭建、模型发布的完整步骤。

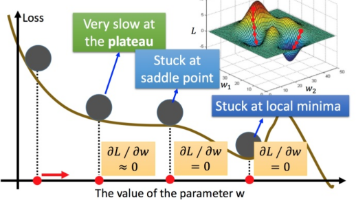

本文围绕深度学习训练核心技巧展开,包括参数初始化、优化方法、正则化及批量归一化。参数初始化中,推荐均匀分布、Kaiming和Xavier初始化,避免全0、全1等方式。优化方法有Momentum(平滑梯度)、AdaGrad(自适应学习率)、RMSProp(优化学习率衰减)及融合两者的Adam。Dropout通过随机丢弃神经元降低复杂度以缓解过拟合。批量归一化控制数据分布,稳定训练并加速收敛,这些技巧

本文梳理人工智能 70年 发展脉络:1956年达特茅斯会议正式提出“人工智能”概念,开启探索之路。从早期基于规则的系统、统计机器学习,到2012年AlexNet推动深度学习崛起,再到2017年Transformer架构革新、AlphaGo引爆关注。2022年ChatGPT 开启大模型时代,GPT-3.5、GPT-4等持续迭代,2025年GPT-5 引入通用智能。同时涵盖技术分支(NLP、CV等)及