简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

从零开始搭建深度学习大厦系列-4.Transformer生成式大语言模型

最近在学习文本预处理(分词与词和位置嵌入)、自注意力机制(Self-Attention)、多头自注意力机制、Transformer Block和GPT-2、GPT-3的基本架构。本文是相关内容的第一篇文章,主要讲解大模型的基础架构和代码构建过程;后续文章将着重讲解大模型的预训练、指令微调、奖励模型构建和强化学习(RLHF)过程。

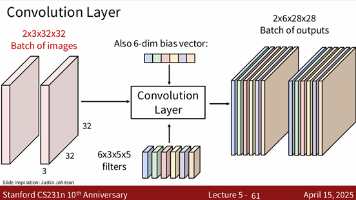

从零开始搭建深度学习大厦系列-2.卷积神经网络基础(5-9)

本篇主要分析:【1】CNN卷积神经网络中卷积层、池化层、批规范化层、激活层、“暂退层”的作用原理;

到底了