AMD Mini AI工作站:让每个人都成为超级开发者

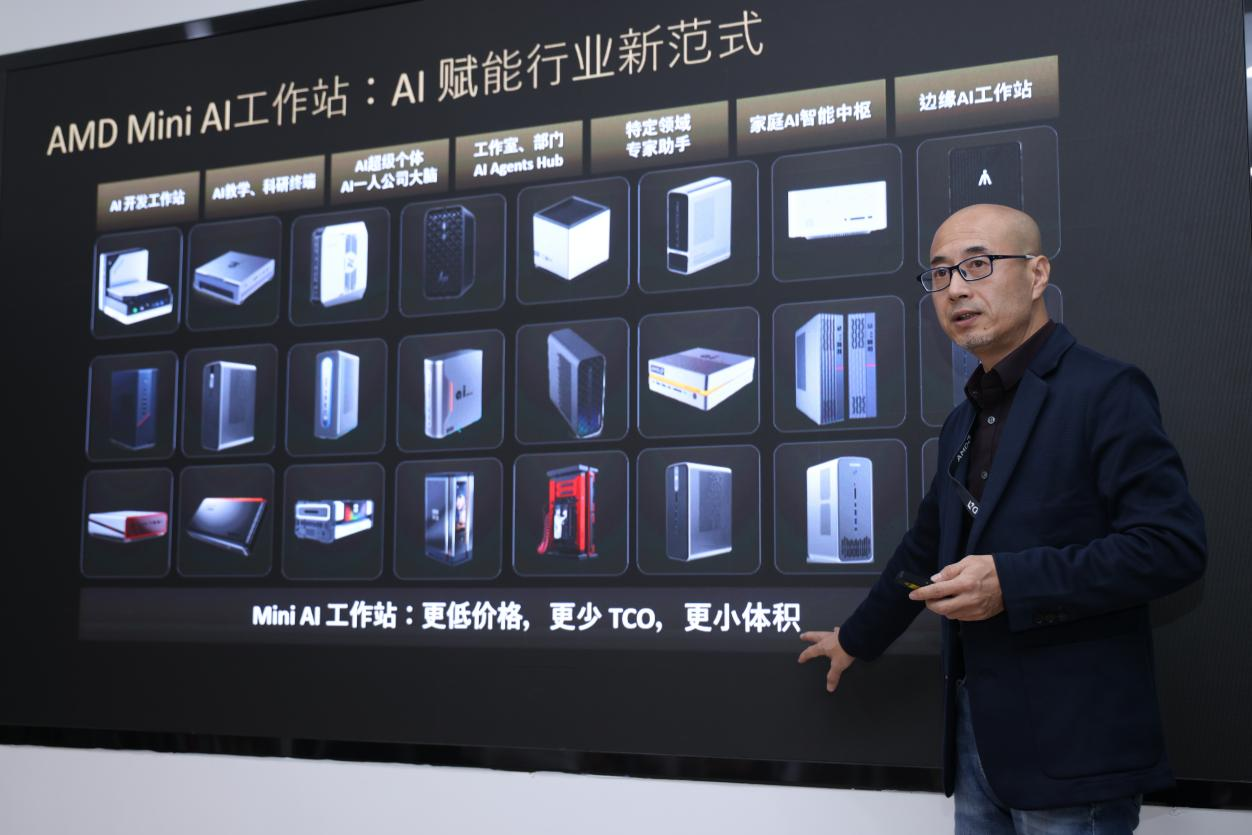

基于AMD锐龙AI Max+ 395 Mini AI工作站,AMD正在下一盘大棋,除了前面提到的中小企业、个人开发者,Mini AI工作站还瞄准了AI教育、超级个体、数据分析、家庭AI HUB、空间智能等多个领域,并依托AMD从数据中心到边缘侧、嵌入式、再到终端设备的全栈式、端到端的全链AI解决方案优势,以及AMD中国AI应用创新联盟上百家优秀AI ISV伙伴,在硬件和软件上共同推动、赋能AI企业

俗话说,工欲善其事,必先利其器。有了趁手的工具,便意味着更大概率的事半功倍。

AI大模型对未来生产力的革命性提升已毋庸置疑,千行百业都在争先恐后地进行AI应用探索,以让自己不在这场生产力变革中掉队,甚至立于潮头。

基础大模型不是谁都玩得起的,所以大多数企业的共识是选择在基础大模型之上,加入所在企业或者行业积累的数据,形成自有的垂类小模型,在此基础上进行相应的模型推理和AI应用开发。

但由于企业自有数据或者精心积累的行业数据,很大程度上是私有资产,大部分企业并不会选择使用云端的MaaS(Model as a Service,模型即服务),而是倾向于在本地环境中进行模型推理和应用开发。

2025年DeepSeek的横空出世,带来了大模型一体机的热潮。大模型一体机可以称得上是AI技术演进、市场需求与行业痛点驱动的产物,是面向企业私有化、场景化、安全化部署大模型的“交钥匙解决方案”,可以说是很好地满足了前面所述的企业本地大模型应用探索的需求。但大模型一体机动辄几十万、上百万元,便宜的也要十几万元,这个价格再加上其对场地、供电等的要求,直接劝退了数量庞大的中小企业和个人开发者——毕竟,在还没看到实际收益的前提下,这是一笔不小的投资。

如何破局?

近日,在AMD的一场活动上,我们发现了一个不错的解题思路——AMD Mini AI工作站,一万元出头的价格,就能够低成本解决大模型端侧和边缘部署难题,赋能AI应用开发的最后一公里。

AMD Mini AI工作站,为低成本解决大模型端侧部署难题而生

“中小企业要想在公司级层面用好AI、个人开发者要想做专业的大模型应用开发,就需要有一个从30B-120B参数不等的可靠的模型底座,还要能跑自己的知识库(至少需要8GB显存),还要跑MCP和各种Agent(一般需要16GB显存),以及超长上下文的支持、提示词工程,以上加在一起一般需要48GB左右显存,这早已超出了一个普通AIGC(人工智能生成内容)的能力范畴。”AMD大中华区市场营销副总裁纪朝晖这样分析道。

AMD大中华区市场营销副总裁纪朝晖

在一体机投入高的情况下,AMD Mini AI工作站可谓生逢其时,为中小企业、个人开发者带来AI应用创新平台,体验到接近于大型一体机的AI推理能力。

“在7月10日深圳生态伙伴大会上,我们已经展示了超过20款的AMD锐龙AI Max+ 395 Mini AI工作站产品,这些产品以更低的价格提供96GB超大显存,以更低的TCO、更小的体积为中小企业、AI开发者提供一个可用的、理想的端侧和边缘侧的AI推理平台。”纪朝晖表示。

活动现场展示了8款Mini AI工作站产品,包括HP Z2 Mini G1a、Abee AI Station 395 Max、希未SEAVIV AideaStation R1、六联智能AXB35-02-H02-BQ、零刻Beelink GTR9 Pro、极摩客GMKtec EVO-X2、铭凡MS-S1 MAX、天钡NEX395。目前,这些产品大多已于各大电商平台开启售卖。

这里特别要提的是,8月27日,在深圳(国际)通用人工智能产业博览会上,AMD携手奥尼电子、Abee发布了全球首款基于锐龙AI Max+ 395的液冷Mini AI工作站SMART AI Hub。盒子大小的Mini AI工作站用上了液冷,简直不要太酷!

AMD锐龙AI Max+ 395:Mini AI工作站基石

为低成本解决大模型端侧部署难题而生的AMD Mini AI工作站,有个强劲的后台,那就是前面提到的AMD锐龙AI Max+ 395。

纪朝晖讲到,“首先CPU得是最好的16核32线程,频率超过5GHz,ZEN 5架构,集成一张相当于4060/4070独显级别的显卡,有一个可以达到40CU的GPU。这个处理器还有50+ TOPS的NPU,符合微软的Windows11 AI+PC的规范。”

由此,AMD锐龙AI Max+ 395的目标也顺理成章地致力于成为端侧与边缘侧AI推理优选平台。

作为AMD Strix Halo处理器家族的旗舰型号,锐龙 AI Max+ 395采用了AMD独特的UMA(Unified Memory Architecture,统一内存架构)技术,至高可以支持128GB内存,并把内存灵活分配给CPU、GPU和NPU使用——其中至高96GB的内存专属给显卡用,从而直接获得一个带96GB显存的4060/4070级别独显显卡,此外还有16GB共享给显卡,总显存也就达到了惊人的112GB。这样的显卡配置加上不到2万块钱的价格,为整个AI Infra(AI基础设施)市场带来了极大的想象空间。

据了解,在96GB显存支持下,锐龙 AI Max+ 395在跑大模型的时候显示出非常独特的能力和优势,因为96GB的显存已足以放下100B级大模型,而消费级显卡甚至商用级显卡显存大多是20GB、24GB、最多32GB,大部分中大模型都没有办法在上面跑——比如在做Qunt4量化的情况下,Qwen3-30B-A3B需要18GB显存才能跑;Llama4 109B-A17B需要66GB显存才能跑;Mistral Large 123B需要68GB显存才能跑;OpenAI GPT-OSS-120B则需要80GB显存才能跑。更进一步,GPT-OSS-120B在锐龙 AI Max+ 395上甚至跑出了40+ Tokens/s的成绩。

不止于Mini AI工作站,AMD全面赋能开发者

能跑模型不是目的,AI生产力价值实现要靠数以万计的AI应用。

因此,AMD还与RIPPLE(波澜)合作,基于AMD锐龙AI Max+ 395 Mini AI工作站搭建了一个类似“AI时代树莓派”的开发者平台,内置完善的二次开发SDK,开箱即用,同时为开发者提供远程测试环境和教程,让开发者不用自己凑硬件、找模型、搭框架,直接搞定AI应用开发。

可以说,基于AMD锐龙AI Max+ 395 Mini AI工作站,AMD正在下一盘大棋,除了前面提到的中小企业、个人开发者,Mini AI工作站还瞄准了AI教育、超级个体、数据分析、家庭AI HUB、空间智能等多个领域,并依托AMD从数据中心到边缘侧、嵌入式、再到终端设备的全栈式、端到端的全链AI解决方案优势,以及AMD中国AI应用创新联盟上百家优秀AI ISV伙伴,在硬件和软件上共同推动、赋能AI企业应用的“最后一公里”。

更多推荐

已为社区贡献801条内容

已为社区贡献801条内容

所有评论(0)