Jenkins持续集成入门到精通

Jenkins持续集成,gitlab+Jenkins+sonarqube+docker+k8s

Jenkins持续集成入门到精通

文章目录

-

- Jenkins持续集成入门到精通

-

- 1. 持续集成及Jenkins介绍

- 2. Jenkins安装和持续集成环境配置

- 3. Jenkins构建Maven项目

-

- 3.1 Jenkins项目构建类型(1)-Jenkins构建的项目类型介绍

- 3.2 Jenkins项目构建类型(2)-自由风格项目构建

- 3.3 Jenkins项目构建类型(3)-Maven项目构建

- 3.4 Jenkins项目构建类型(4)-Pipeline流水线项目构建(*)

- 3.5 Jenkins项目构建细节(1)-常用的构建触发器

- 3.6 Jenkins项目构建细节(2)-Git hook自动触发构建(*)

- 3.7 Jenkins项目构建细节(3)-Jenkins的参数化构建

- 3.8 Jenkins项目构建细节(4)-配置邮箱服务器发送构建结果

- 3.9 Jenkins+SonarQube代码审查(1) - 安装SonarQube

- 3.10 Jenkins+SonarQube代码审查(2) - 实现代码审查

- 4. Jenkins+Docker+SpringCloud微服务持续集成(上)

-

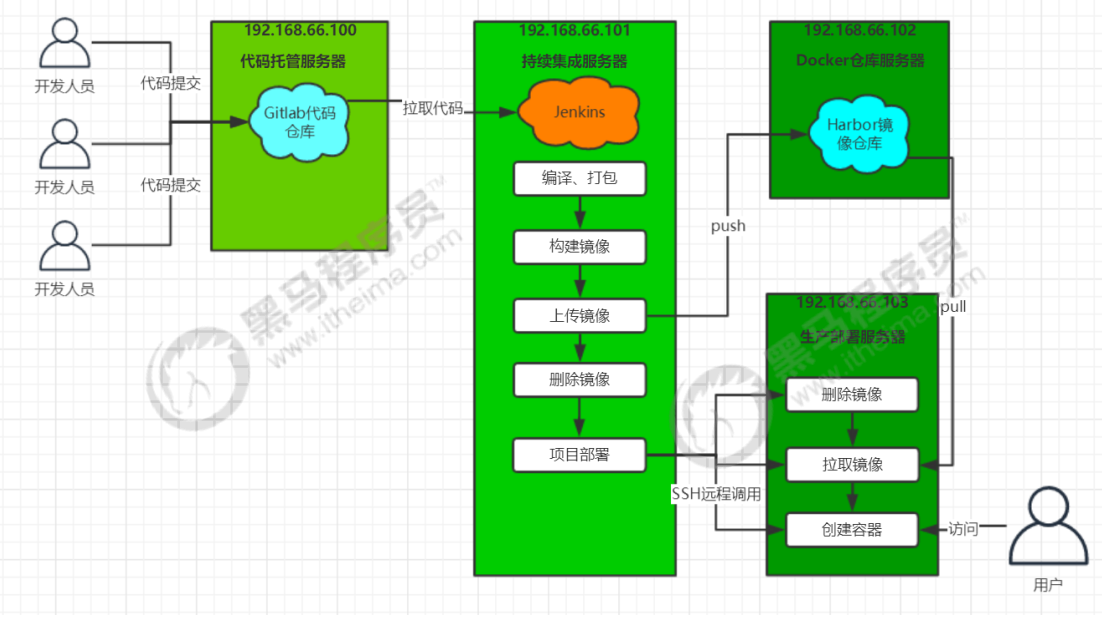

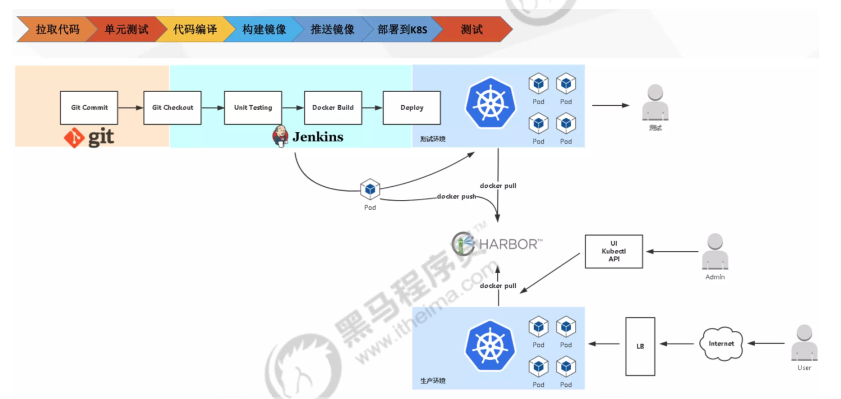

- 4.1 Jenkins+Docker+SpringCloud持续集成流程说明

- 4.2 SpringCloud微服务源码概述

- 4.3 本地部署(1)-SpringCloud微服务部署

- 4.4 本地部署(2)-前端静态web网站

- 4.5 环境准备(1)-Docker快速入门

- 4.6 环境准备(2)-Dockerfile镜像脚本快速入门

- 4.7 环境准备(3)-Harbor镜像仓库安装及使用

- 4.8 微服务持续集成(1)-项目代码上传到Gitlab

- 4.9 微服务持续集成(2)-从Gitlab拉取项目源码

- 4.10 微服务持续集成(3)-提交到SonarQube代码审查

- 4.11 微服务持续集成(4)-使用Dockerfile编译、生成镜像

- 4.12 微服务持续集成(5)-上传到Harbor镜像仓库

- 4.13 微服务持续集成(6)-拉取镜像和发布应用

- 4.14 微服务持续集成(7)-部署前端静态web网站

- 5. Jenkins+Docker+SpringCloud微服务持续集成(下)

- 6. 基于Kubernetes/K8S构建Jenkins持续集成平台(上)

- 7. 基于Kubernetes/K8S构建Jenkins持续集成平台(下)

1、持续集成及Jenkins介绍

2、Jenkins安装和持续集成环境配置

3、Jenkins构建Maven项目

4、Jenkins+Docker+SpringCloud微服务持续集成

5、基于Kubernetes/K8S构建Jenkins微服务持续集成平台

1.6之前理论部分从略

1. 持续集成及Jenkins介绍

1.1 软件开发生命周期

1.2 软件开发瀑布模型

1.3 软件的敏捷开发

1.3.1 什么是敏捷开发

1.3.2 敏捷开发如何迭代

1.3.3 敏捷开发有什么好处

1.4 什么是持续集成

1.5 持续集成的组成要素

1.6 持续集成的好处

1.7 Jenkins介绍

Jenkins 是一款流行的开源持续集成(Continuous Integration)工具,广泛用于项目开发,具有自动 化构建、测试和部署等功能。官网: http://jenkins-ci.org/。

1.7.1 Jenkins的特征

- 开源的Java语言开发持续集成工具,支持持续集成,持续部署。

- 易于安装部署配置:可通过yum安装,或下载war包以及通过docker容器等快速实现安装部署,可方便web界面配置管理。

- 消息通知及测试报告:集成RSS/E-mail通过RSS发布构建结果或当构建完成时通过e-mail通知,生成JUnit/TestNG测试报告。

- 分布式构建:支持Jenkins能够让多台计算机一起构建/测试。

- 文件识别:Jenkins能够跟踪哪次构建生成哪些jar,哪次构建使用哪个版本的jar等。

- 丰富的插件支持:支持扩展插件,你可以开发适合自己团队使用的工具,如git,svn,maven, docker等。

2. Jenkins安装和持续集成环境配置

2.1 持续集成流程说明

- 首先,开发人员每天进行代码提交,提交到Git仓库

- 然后,Jenkins作为持续集成工具,使用Git工具到Git仓库拉取代码到集成服务器,再配合JDK,Maven等软件完成代码编译,代码测试与审查,测试,打包等工作,在这个过程中每一步出错,都重新再执行一次整个流程。

- 最后,Jenkins把生成的jar或war包分发到测试服务器或者生产服务器,测试人员或用户就可以访问应用

服务器列表

本课程虚拟机统一采用CentOS7。

| 名称 | ip地址 | 安装的软件 |

|---|---|---|

| 代码托管服务器 | 192.168.139.139 | Gitlab-v14.7.0 |

| 持续集成服务器 | 192.168.139.140 | Jenkins 2.341,JDK1.8,Maven3.6.3,Git |

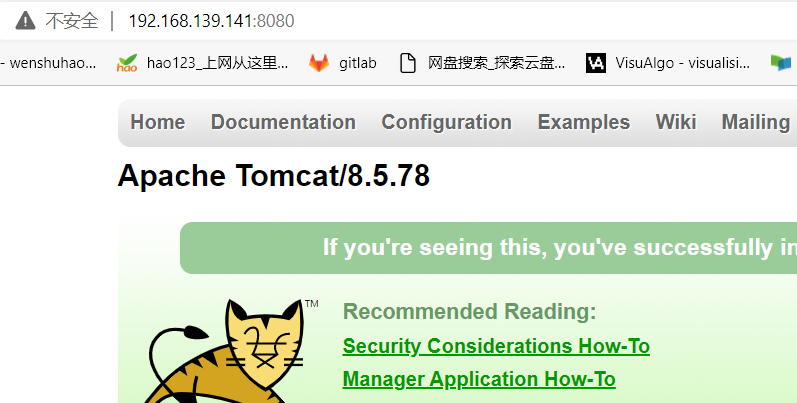

| 应用测试服务器 | 192.168.139.141 | JDK1.8,tomcat8.5 |

2.2 Gitlab代码托管服务器安装

2.2.1 Gitlab简介

2.2.2 Gitlab安装

-

安装相关依赖

yum -y install policycoreutils openssh-server openssh-clients postfix -

启动ssh服务&设置为开机启动

systemctl enable sshd && sudo systemctl start sshd -

设置postfix开机自启,并启动,postfix支持gitlab发信功能

systemctl enable postfix && systemctl start postfix -

开放ssh以及http服务,然后重新加载防火墙列表

firewall-cmd --add-service=ssh --permanent firewall-cmd --add-service=http --permanent firewall-cmd --reload如果关闭防火墙就不需要做以上配置

-

下载gitlab包,并且安装

在线下载安装包:wget https://mirrors.tuna.tsinghua.edu.cn/gitlab-ce/yum/el7/gitlab-ce-14.7.0-ce.0.el7.x86_64.rpm安装:

sudo rpm -i gitlab-ce-14.7.0-ce.0.el7.x86_64.rpm -

修改gitlab配置

vi /etc/gitlab/gitlab.rb修改gitlab访问地址和端口,默认为80,我们改为82

external_url 'http://192.168.66.100:82' nginx['listen_port'] = 82 -

重载配置及启动gitlab

gitlab-ctl reconfigure gitlab-ctl restart -

把端口添加到防火墙

firewall-cmd --zone=public --add-port=82/tcp --permanent firewall-cmd --reload启动成功后,看到以下修改管理员root密码的页面,修改密码后,然后登录即可.

2.2.3 Gitlab添加组、创建用户、创建项目

2.3 源码上传到Gitlab仓库

略

2.4 持续集成环境(1)-Jenkins安装

-

安装JDK

Jenkins需要依赖JDK,所以先安装JDK1.8

yum install java-1.8.0-openjdk* -y安装目录为:/usr/lib/jvm

-

获取jenkins安装包

下载页面:https://jenkins.io/zh/download/

wget http://mirrors.jenkins-ci.org/redhat/jenkins-2.341-1.1.noarch.rpm -

安装文件:jenkins-2.341-1.1.noarch.rpm

sudo rpm -ivh jenkins-2.341-1.1.noarch.rpm -

修改Jenkins配置

vi /etc/syscofig/jenkins修改内容如下:

JENKINS_USER=“root”

JENKINS_PORT=“8888”

-

启动Jenkins

systemctl start jenkins -

打开浏览器访问 http://192.168.139.140:8888

注意:本服务器把防火墙关闭了,如果开启防火墙,需要在防火墙添加端口

-

获取并输入admin账户密码

cat /var/lib/jenkins/secrets/initialAdminPassword -

跳过插件安装

因为Jenkins插件需要连接默认官网下载,速度非常慢,而且经过会失败,所以我们暂时先跳过插件安装

-

添加一个管理员账户,并进入Jenkins后台

2.5 持续集成环境(2)-Jenkins插件管理

Jenkins本身不提供很多功能,我们可以通过使用插件来满足我们的使用。例如从Gitlab拉取代码,使用 Maven构建项目等功能需要依靠插件完成。接下来演示如何下载插件。

2.5.1 修改Jenkins插件下载地址

Jenkins国外官方插件地址下载速度非常慢,所以可以修改为国内插件地址:

Jenkins->Manage Jenkins->Manage Plugins,点击Available

这样做是为了把Jenkins官方的插件列表下载到本地,接着修改地址文件,替换为国内插件地址

cd /var/lib/jenkins/updates

sed -i 's/http:\/\/updates.jenkinsci.org\/download/https:\/\/mirrors.tuna.tsinghua.edu.cn\/jenkins/g' default.json && sed -i

's/http:\/\/www.google.com/https:\/\/www.baidu.com/g' default.json

最后,Manage Plugins点击Advanced,把Update Site改为国内插件下载地址

https://mirrors.tuna.tsinghua.edu.cn/jenkins/updates/update-center.json

Sumbit后,在浏览器输入: http://192.168.66.101:8888/restart ,重启Jenkins。

2.5.2 下载中文汉化插件

Jenkins->Manage Jenkins->Manage Plugins,点击Available,搜索"Chinese"

重启Jenkins后,就看到Jenkins汉化了!(PS:但可能部分菜单汉化会失败)

2.6 持续集成环境(3)-Jenkins用户权限管理

我们可以利用Role-based Authorization Strategy 插件来管理Jenkins用户权限。

2.6.1 安装Role-based Authorization Strategy插件

开启权限全局安全配置,授权策略切换为"Role-Based Strategy",保存。

2.6.2 创建角色

在系统管理页面进入 Manage and Assign Roles

2.6.3 创建用户

2.6.4 给用户分配角色

创建项目测试权限

2.7 持续集成环境(4)-Jenkins凭证管理

凭据可以用来存储需要密文保护的数据库密码、Gitlab密码信息、Docker私有仓库密码等,以便 Jenkins可以和这些第三方的应用进行交互。

2.7.1 安装Credentials Binding插件

要在Jenkins使用凭证管理功能,需要安装Credentials Binding插件

安装插件后,可以管理凭据

-

可以添加的凭证有5种:

常用的凭证类型有:Username with password(用户密码)和SSH Username with private key(SSH 密钥).

接下来以使用Git工具到Gitlab拉取项目源码为例,演示Jenkins的如何管理Gitlab的凭证。

2.7.2 安装Git插件和Git工具

为了让Jenkins支持从Gitlab拉取源码,需要安装Git插件以及在CentOS7上安装Git工具。

-

Git插件安装:

-

CentOS7上安装Git工具:

yum install git -y git --version用户密码类型

-

Jenkins->凭证->系统->全局凭证->添加凭证

选择"Username with password",输入Gitlab的用户名和密码,点击"确定"。

-

测试凭证是否可用

-

创建一个FreeStyle项目:新建Item->FreeStyle Project->确定

-

找到"源码管理"->“Git”,在Repository URL复制Gitlab中的项目URL

-

保存配置后,点击构建”Build Now“ 开始构建项目

-

查看/var/lib/jenkins/workspace/目录,发现已经从Gitlab成功拉取了代码到Jenkins中。

-

SSH密钥类型

-

SSH免密登录示意

-

使用root用户生成公钥和私钥

ssh-keygen -t rsa在/root/.ssh/目录保存了公钥和私钥

-

把生成的公钥放在Gitlab中

-

以root账户登录->点击头像->Settings->SSH Keys

-

复制刚才id_rsa.pub文件的内容到这里,点击"Add Key"

-

-

在Jenkins中添加凭证,配置私钥

在Jenkins添加一个新的凭证,类型为"SSH Username with private key",把刚才生成私有文件内容复制过来

-

测试凭证是否可用

新建"test02"项目->源码管理->Git,这次要使用Gitlab的SSH连接,并且选择SSH凭证

同样尝试构建项目,如果代码可以正常拉取,代表凭证配置成功。

-

-

2.8 持续集成环境(5)-Maven安装和配置

在Jenkins集成服务器上,我们需要安装Maven来编译和打包项目。

2.8.1 安装Maven

上传或者下载maven安装包到jenkins服务器

tar -xzf apache-maven-3.6.3-bin.tar.gz #解压

mkdir -p /opt/maven #创建目录

mv apache-maven-3.6.3/* /opt/maven #移动文件

2.8.2 配置环境变量

vi /etc/profile

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk

export MAVEN_HOME=/opt/maven

export PATH=$PATH:$JAVA_HOME/bin:$MAVEN_HOME/bin

source /etc/profile #配置生效

mvn -v #查找Maven版本

2.8.3 全局工具配置关联JDK和Maven

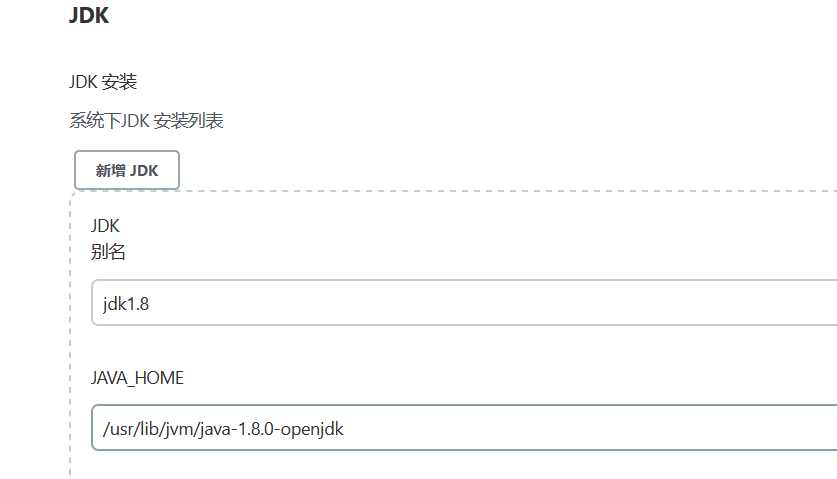

- Jenkins->Global Tool Configuration->JDK->新增JDK,配置如下:

-

Jenkins->Global Tool Configuration->Maven->新增Maven,配置如下:

2.8.4 添加Jenkins全局变量

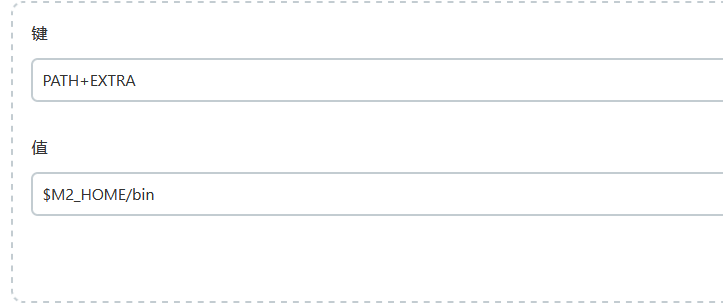

Manage Jenkins->Configure System->Global Properties ,添加三个全局变量 JAVA_HOME、M2_HOME、PATH+EXTRA

2.8.5 修改Maven的settings.xml

mkdir /root/repo #创建本地仓库目录

vi /opt/maven/conf/settings.xml

本地仓库改为:/root/repo/

添加阿里云私服地址:

alimaven aliyun maven http://maven.aliyun.com/nexus/content/groups/public/ central

2.8.6 测试Maven是否配置成功

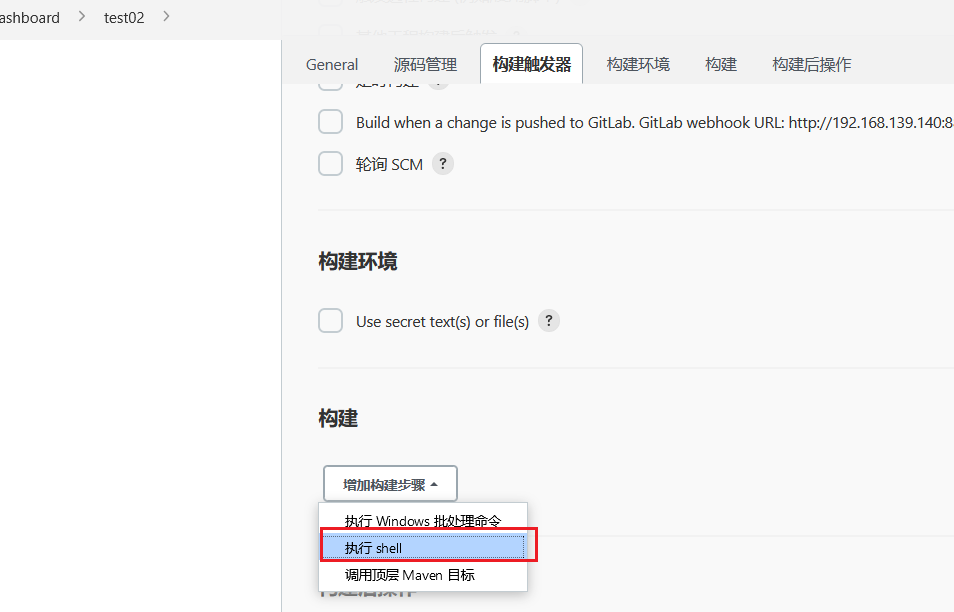

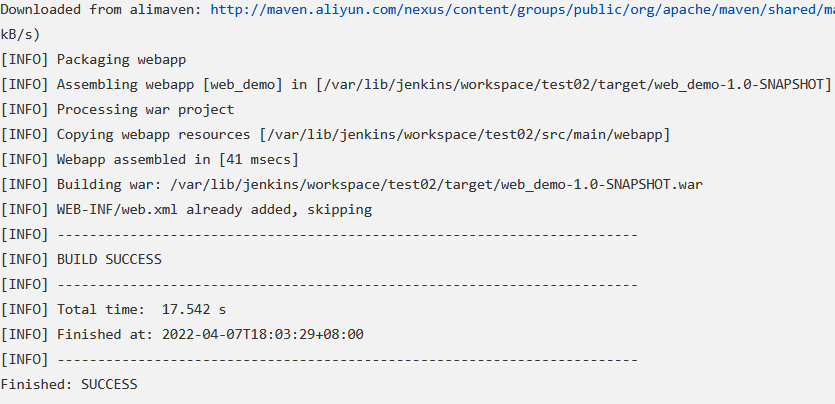

使用之前的gitlab密码测试项目,修改配置

构建->增加构建步骤->Execute Shell

输入

mvn clean package

再次构建,如果可以把项目打成war包,代表maven环境配置成功啦!

2.9 持续集成环境(6)-Tomcat安装和配置

2.9.1 安装Tomcat8.5

把Tomcat压缩包上传到192.168.139.141服务器

yum install java-1.8.0-openjdk* -y #安装JDK(已完成)

tar -xzf apache-tomcat-8.5.47.tar.gz #解压

mkdir -p /opt/tomcat #创建目录

mv /root/apache-tomcat-8.5.47/* /opt/tomcat #移动文件

/opt/tomcat/bin/startup.sh #启动tomcat

注意:服务器已经关闭了防火墙,所以可以直接访问Tomcat。

地址为:http://192.168.139.141:8080

2.9.2 配置Tomcat用户角色权限

默认情况下Tomcat是没有配置用户角色权限的。但是,后续Jenkins部署项目到Tomcat服务器,需要用到Tomcat的用户,所以修改tomcat以下配置, 添加用户及权限

vi /opt/tomcat/conf/tomcat-users.xml

<tomcat-users>

<role rolename="tomcat"/>

<role rolename="role1"/>

<role rolename="manager-script"/>

<role rolename="manager-gui"/>

<role rolename="manager-status"/>

<role rolename="admin-gui"/>

<role rolename="admin-script"/>

<user username="tomcat" password="tomcat" roles="manager-gui,manager-script,tomcat,admin-gui,admin-script"/>

</tomcat-users>

用户和密码都是:tomcat

注意:为了能够让刚才配置的用户登录到Tomcat,还需要修改以下配置

vi /opt/tomcat/webapps/manager/META-INF/context.xml

<!--

<Valve className="org.apache.catalina.valves.RemoteAddrValve"

allow="127\.\d+\.\d+\.\d+|::1|0:0:0:0:0:0:0:1" />

-->

把上面这行注释掉即可!

2.9.3 重启Tomcat,访问测试

/opt/tomcat/bin/shutdown.sh 停止

/opt/tomcat/bin/startup.sh 启动

访问: http://192.168.66.102:8080/manager/html ,输入tomcat和tomcat,看到以下页面代表成功.

3. Jenkins构建Maven项目

3.1 Jenkins项目构建类型(1)-Jenkins构建的项目类型介绍

Jenkins中自动构建项目的类型有很多,常用的有以下三种:

- 自由风格软件项目(FreeStyle Project)

- Maven项目(Maven Project)

- 流水线项目(Pipeline Project)

每种类型的构建其实都可以完成一样的构建过程与结果,只是在操作方式、灵活度等方面有所区别,在 实际开发中可以根据自己的需求和习惯来选择。

PS:个人推荐使用流水线类型,因为灵活度非常高。

3.2 Jenkins项目构建类型(2)-自由风格项目构建

下面演示创建一个自由风格项目来完成项目的集成过程:

拉取代码->编译->打包->部署

3.2.1 拉取代码

-

创建一个自由风格的项目

-

配置源码管理,从gitlab拉取代码

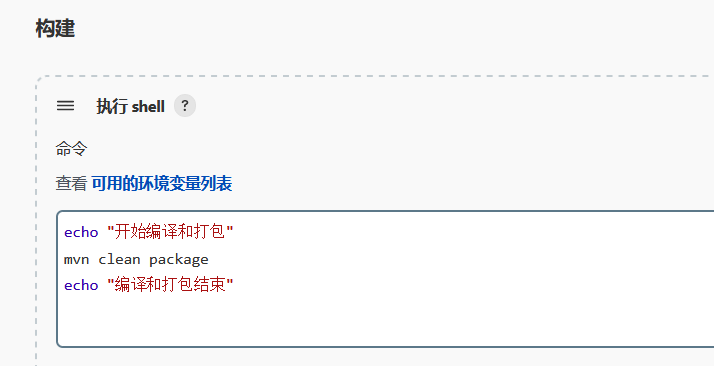

3.2.2 编译打包

构建->添加构建步骤->Executor Shell

3.2.3 部署

把项目部署到远程的Tomcat里面

-

安装 Deploy to container插件

Jenkins本身无法实现远程部署到Tomcat的功能,需要安装Deploy to container插件实现

-

添加Tomcat用户凭证

-

添加构建后操作

点击"Build Now",开始构建过程

-

部署成功后

访问项目 http://192.168.139.141:8080/web_demo-1.0-SNAPSHOT/

3.2.4 演示改动代码后的持续集成

- IDEA中源码修改并提交到gitlab

- 在Jenkins中项目重新构建

- 访问Tomcat

3.3 Jenkins项目构建类型(3)-Maven项目构建

-

安装Maven Integration插件

-

创建Maven项目

-

配置项目

拉取代码和远程部署的过程和自由风格项目一样,只是"构建"部分不同。

3.4 Jenkins项目构建类型(4)-Pipeline流水线项目构建(*)

3.4.1 Pipeline简介

-

概念

Pipeline,简单来说,就是一套运行在 Jenkins 上的工作流框架,将原来独立运行于单个或者多个节点 的任务连接起来,实现单个任务难以完成的复杂流程编排和可视化的工作。

-

使用Pipeline有以下好处(来自翻译自官方文档):

代码:Pipeline以代码的形式实现,通常被检入源代码控制,使团队能够编辑,审查和迭代其传送流 程。 持久:无论是计划内的还是计划外的服务器重启,Pipeline都是可恢复的。 可停止:Pipeline可接 收交互式输入,以确定是否继续执行Pipeline。 多功能:Pipeline支持现实世界中复杂的持续交付要 求。它支持fork/join、循环执行,并行执行任务的功能。 可扩展:Pipeline插件支持其DSL的自定义扩 展 ,以及与其他插件集成的多个选项。

-

如何创建 Jenkins Pipeline呢?

- Pipeline 脚本是由 Groovy 语言实现的,但是我们没必要单独去学习 Groovy

- Pipeline 支持两种语法:Declarative(声明式)和 Scripted Pipeline(脚本式)语法

- Pipeline 也有两种创建方法:可以直接在 Jenkins 的 Web UI 界面中输入脚本;也可以通过创建一 个 Jenkinsfile 脚本文件放入项目源码库中(一般我们都推荐在 Jenkins 中直接从源代码控制(SCM) 中直接载入 Jenkinsfile Pipeline 这种方法)。

3.4.2 安装Pipeline插件

Manage Jenkins->Manage Plugins->可选插件

安装插件后,创建项目的时候多了“流水线”类型

3.4.3 Pipeline语法快速入门

-

Declarative声明式-Pipeline

-

创建流水线项目

-

流水线->选择HelloWorld模板

生成内容如下:

stages:代表整个流水线的所有执行阶段。通常stages只有1个,里面包含多个stage

stage:代表流水线中的某个阶段,可能出现n个。一般分为拉取代码,编译构建,部署等阶段。

steps:代表一个阶段内需要执行的逻辑。steps里面是shell脚本,git拉取代码,ssh远程发布等任意内容。

编写一个简单声明式Pipeline:

pipeline { agent any stages { stage('拉取代码') { steps { echo '拉取代码' } } stage('编译构建') { steps { echo '编译构建' } } stage('项目部署') { steps { echo '项目部署' } } } }点击构建,可以看到整个构建过程

-

-

Scripted Pipeline脚本式-Pipeline

创建项目

这次选择"Scripted Pipeline"

node { def mvnHome stage('Preparation') { // for display purposes } stage('Build') { } stage('Results') { } }- Node:节点,一个Node就是一个Jenkins节点,Master或者Agent,是执行 Step 的具体运行环境,后续讲到Jenkins的Master-Slave架构的时候用到。

- Stage:阶段,一个Pipeline 可以划分为若干个Stage,每个Stage代表一组操作,比如: Build、Test、Deploy,Stage是一个逻辑分组的概念。

- Step:步骤,Step是最基本的操作单元,可以是打印一句话,也可以是构建一个Docker 镜像, 由各类Jenkins 插件提供,比如命令:sh ‘make’,就相当于我们平时shell终端中执行make命令一样。

编写一个简单的脚本式Pipeline

node { def mvnHome stage('拉取代码') { // for display purposes echo '拉取代码' } stage('编译构建') { echo '编译构建' } stage('项目部署') { echo '项目部署' } }构建结果和声明式一样!

3.4.4 拉取代码

pipeline {

agent any

stages {

stage('拉取代码') {

steps {

checkout([$class: 'GitSCM', branches: [[name: '*/master']], extensions: [], userRemoteConfigs: [[credentialsId: '030197b4-3b90-4bba-afb4-beb12c7589c1', url: 'git@192.168.139.139:itcast_group/web_demo2.git']]])

}

}

}

}

3.4.5 编译打包

pipeline {

agent any

stages {

stage('拉取代码') {

steps {

checkout([$class: 'GitSCM', branches: [[name: '*/master']], extensions: [], userRemoteConfigs: [[credentialsId: '030197b4-3b90-4bba-afb4-beb12c7589c1', url: 'git@192.168.139.139:itcast_group/web_demo2.git']]])

}

}

stage('编译构建') {

steps {

sh 'mvn clean package'

}

}

}

}

3.4.6 部署

pipeline {

agent any

stages {

stage('拉取代码') {

steps {

checkout([$class: 'GitSCM', branches: [[name: '*/master']], extensions: [], userRemoteConfigs: [[credentialsId: '030197b4-3b90-4bba-afb4-beb12c7589c1', url: 'git@192.168.139.139:itcast_group/web_demo2.git']]])

}

}

stage('编译构建') {

steps {

sh 'mvn clean package'

}

}

stage('项目部署') {

steps {

deploy adapters: [tomcat8(credentialsId: 'f87f0ff5-62f8-4933-8ce9-fc5cb6ac47ae', path: '', url: 'http://192.168.139.141:8080/')], contextPath: null, war: 'target/*.war'

}

}

}

}

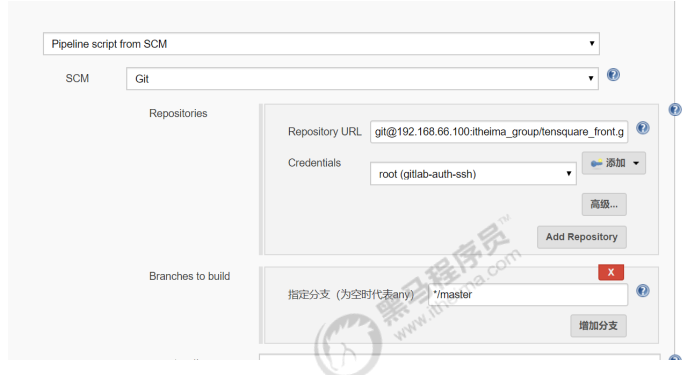

3.4.7 Pipeline Script from SCM

刚才我们都是直接在Jenkins的UI界面编写Pipeline代码,这样不方便脚本维护,建议把Pipeline脚本放在项目中(一起进行版本控制)

-

在项目根目录建立Jenkinsfile文件,把内容复制到该文件中

把Jenkinsfile上传到Gitlab

-

在项目中引用该文件

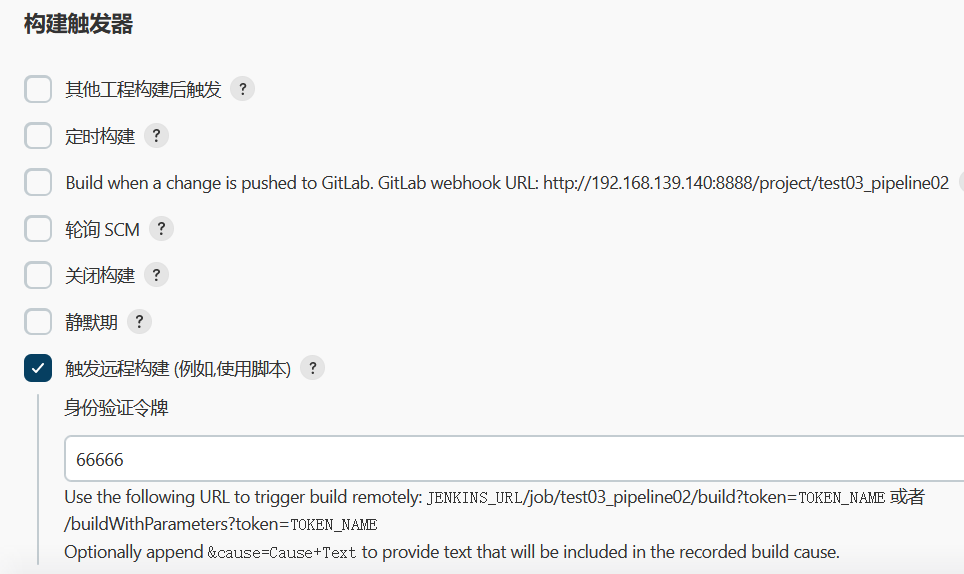

3.5 Jenkins项目构建细节(1)-常用的构建触发器

Jenkins内置4种构建触发器:

- 触发远程构建

- 其他工程构建后触发(Build after other projects are build)

- 定时构建(Build periodically)

- 轮询SCM(Poll SCM)

3.5.1 触发远程构建

触发构建url:http://192.168.139.140:8888/job/test03_pipeline02/build?token=66666

3.5.2 其他工程构建后触发

- 创建pre_job流水线工程

- 配置需要触发的工程

3.5.3 定时构建

定时字符串从左往右分别为: 分 时 日 月 周

一些定时表达式的例子:

每30分钟构建一次:H代表形参 H/30 * * * * 10:02 10:32

每2个小时构建一次: H H/2 * * *

每天的8点,12点,22点,一天构建3次: (多个时间点中间用逗号隔开) 0 8,12,22 * * *

每天中午12点定时构建一次 H 12 * * *

每天下午18点定时构建一次 H 18 * * *

在每个小时的前半个小时内的每10分钟 H(0-29)/10 * * * *

每两小时一次,每个工作日上午9点到下午5点(也许是上午10:38,下午12:38,下午2:38,下午

4:38) H H(9-16)/2 * * 1-5

3.5.4 轮询SCM

轮询SCM,是指定时扫描本地代码仓库的代码是否有变更,如果代码有变更就触发项目构建。

注意:这次构建触发器,Jenkins会定时扫描本地整个项目的代码,增大系统的开销,不建议使用。

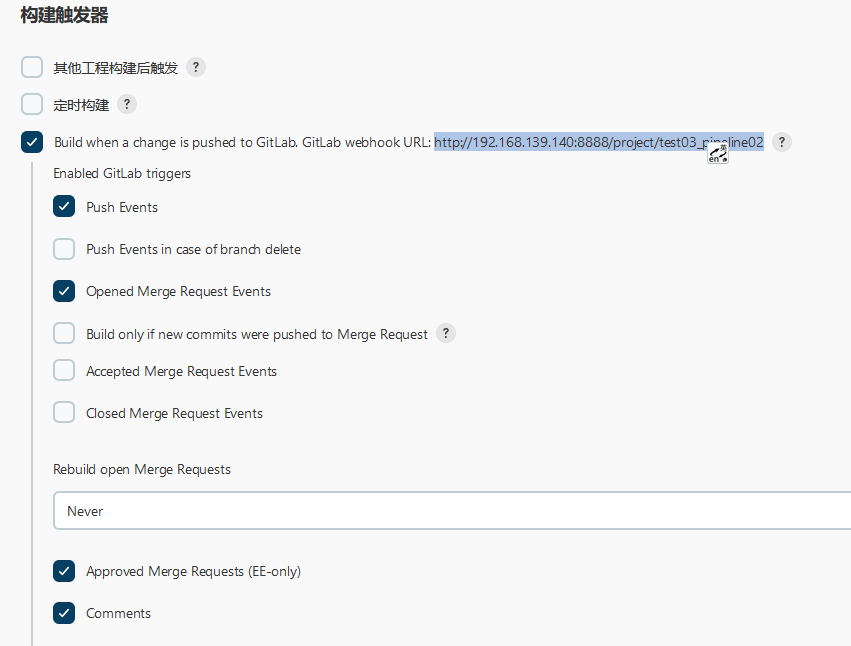

3.6 Jenkins项目构建细节(2)-Git hook自动触发构建(*)

刚才我们看到在Jenkins的内置构建触发器中,轮询SCM可以实现Gitlab代码更新,项目自动构建,但是

该方案的性能不佳。那有没有更好的方案呢? 有的。就是利用Gitlab的webhook实现代码push到仓

库,立即触发项目自动构建。

3.6.1 安装Gitlab Hook插件

需要安装插件:

GitLab Plugin

3.6.2 Jenkins设置自动构建

等会需要把生成的webhook URL配置到Gitlab中。

3.6.3 Gitlab配置webhook

-

开启webhook功能

使用root账户登录到后台,点击Admin Area -> Settings -> Network

勾选"Allow requests to the local network from web hooks and services"

-

在项目添加webhook

点击项目->Settings->Webhooks

注意:以下设置必须完成,否则会报错!

Manage Jenkins->Configure System

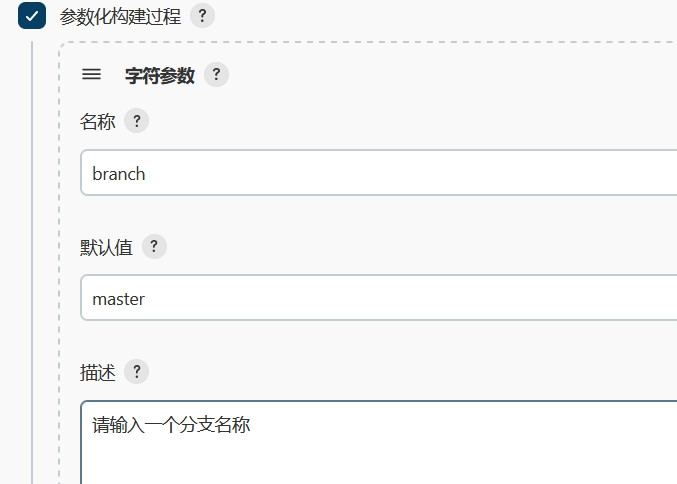

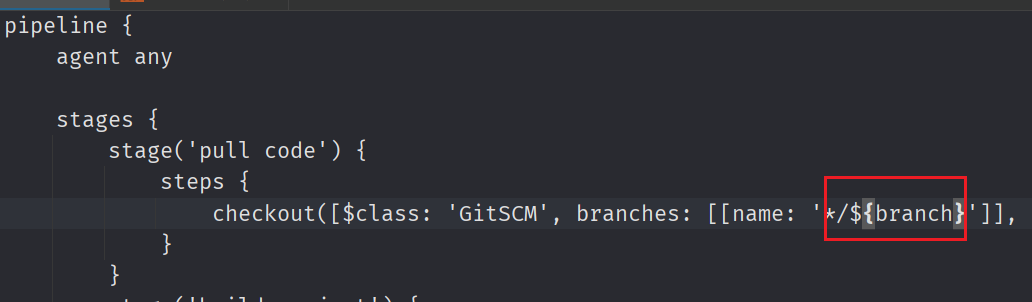

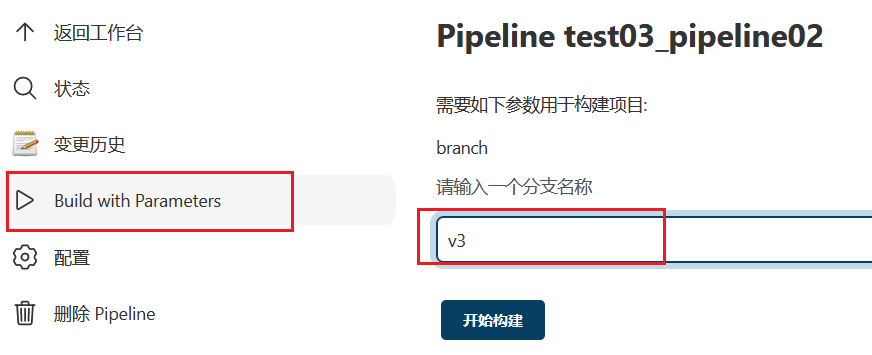

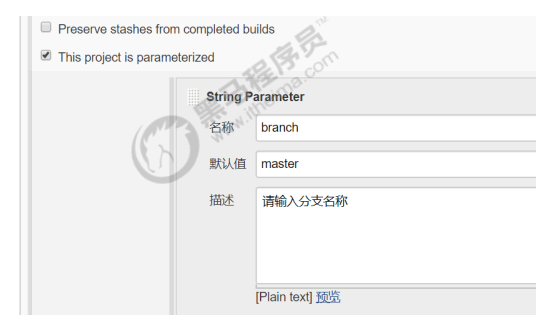

3.7 Jenkins项目构建细节(3)-Jenkins的参数化构建

有时在项目构建的过程中,我们需要根据用户的输入动态传入一些参数,从而影响整个构建结果,这时

我们可以使用参数化构建。

- Jenkins支持非常丰富的参数类型

- 接下来演示通过输入gitlab项目的分支名称来部署不同分支项目。

3.7.1 项目创建分支,并推送到Gitlab上

新建分支:v1,代码稍微改动下,然后提交到gitlab上。

这时看到gitlab上有一个两个分支:master和v1

3.7.2 在Jenkins添加字符串类型参数

3.7.3 改动pipeline流水线代码

3.7.4 点击Build with Parameters

输入分支名称,构建即可!构建完成后访问Tomcat查看结果。

3.8 Jenkins项目构建细节(4)-配置邮箱服务器发送构建结果

3.8.1 安装Email Extension插件

3.8.2 Jenkins设置邮箱相关参数

-

Manage Jenkins->Configure System

-

设置邮件参数

token: cxurcmxwpqkpbgia

-

设置Jenkins默认邮箱信息

3.8.3 准备邮件内容

在项目根目录编写email.html,并把文件推送到Gitlab,内容如下:

<!DOCTYPE html>

<html>

<head>

<meta charset="UTF-8">

<title>${ENV, var="JOB_NAME"}-第${BUILD_NUMBER}次构建日志</title>

</head>

<body leftmargin="8" marginwidth="0" topmargin="8" marginheight="4" offset="0">

<table width="95%" cellpadding="0" cellspacing="0" style="font-size: 11pt; font-family: Tahoma, Arial, Helvetica, sansserif">

<tr>

<td>(本邮件是程序自动下发的,请勿回复!)</td>

</tr>

<tr>

<td>

<h2>

<font color="#0000FF">构建结果 - ${BUILD_STATUS}</font>

</h2>

</td>

</tr>

<tr>

<td>

<br />

<b>

<font color="#0B610B">构建信息</font>

</b>

<hr size="2" width="100%" align="center" />

</td>

</tr>

<tr>

<td>

<ul>

<li>项目名称 : ${PROJECT_NAME}</li>

<li>构建编号 : 第${BUILD_NUMBER}次构建</li>

<li>触发原因: ${CAUSE}</li>

<li>构建日志:

<a href="${BUILD_URL}console">${BUILD_URL}console</a>

</li>

<li>构建 Url :

<a href="${BUILD_URL}">${BUILD_URL}</a>

</li>

<li>工作目录 :

<a href="${PROJECT_URL}ws">${PROJECT_URL}ws</a>

</li>

<li>项目 Url :

<a href="${PROJECT_URL}">${PROJECT_URL}</a>

</li>

</ul>

</td>

</tr>

<tr>

<td>

<b>

<font color="#0B610B">Changes Since Last Successful Build:</font>

</b>

<hr size="2" width="100%" align="center" />

</td>

</tr>编写Jenkinsfile添加构建后发送邮件

<tr>

<td>

<ul>

<li>历史变更记录 :

<a href="${PROJECT_URL}changes">${PROJECT_URL}changes</a>

</li>

</ul>${CHANGES_SINCE_LAST_SUCCESS,reverse=true, format="Changes for Build #%n:

<br />%c

<br />",showPaths=true,changesFormat="

<pre>[%a]

<br />%m</pre>",pathFormat=" %p"}</td>

</tr>

<tr>

<td>

<b>Failed Test Results</b>

<hr size="2" width="100%" align="center" />

</td>

</tr>

<tr>

<td>

<pre style="font-size: 11pt; font-family: Tahoma, Arial, Helvetica,

sans-serif">$FAILED_TESTS</pre>

<br />

</td>

</tr>

<tr>

<td>

<b>

<font color="#0B610B">构建日志 (最后 100行):</font>

</b>

<hr size="2" width="100%" align="center" />

</td>

</tr>

<tr>

<td>

<textarea cols="80" rows="30" readonly="readonly" style="font-family: Courier New">${BUILD_LOG, maxLines=100}</textarea>

</td>

</tr>

</table>

</body>

</html>

3.8.4 编写Jenkinsfile添加构建后发送邮件

pipeline {

agent any

stages {

stage('拉取代码') {

steps {

checkout([$class: 'GitSCM', branches: [[name: '*/master']], extensions: [], userRemoteConfigs: [[credentialsId: '030197b4-3b90-4bba-afb4-beb12c7589c1', url: 'git@192.168.139.139:itcast_group/web_demo2.git']]])

}

}

stage('编译构建') {

steps {

sh 'mvn clean package'

}

}

stage('项目部署') {

steps {

deploy adapters: [tomcat8(credentialsId: 'f87f0ff5-62f8-4933-8ce9-fc5cb6ac47ae', path: '', url: 'http://192.168.139.141:8080/')], contextPath: null, war: 'target/*.war'

}

}

}

post {

always {

emailext(subject: '构建通知:${PROJECT_NAME} - Build # ${BUILD_NUMBER} - ${BUILD_STATUS}!', body: '${FILE,path="email.html"}', to: 'xxx@qq.com')

}

}

}

3.8.5 测试

PS:邮件相关全局参数参考列表:

系统设置->Extended E-mail Notification->Content Token Reference,点击旁边的?号

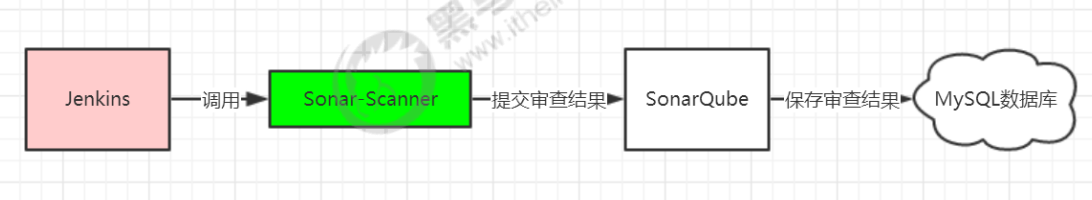

3.9 Jenkins+SonarQube代码审查(1) - 安装SonarQube

3.9.1 SonaQube简介

SonarQube是一个用于管理代码质量的开放平台,可以快速的定位代码中潜在的或者明显的错误。目前

支持java,C#,C/C++,Python,PL/SQL,Cobol,JavaScrip,Groovy等二十几种编程语言的代码质量管理与检

测。

官网:https://www.sonarqube.org/

3.9.2 环境要求

| 软件 | 服务器 | 版本 |

|---|---|---|

| JDK | 192.168.139.140 | 1.8 |

| MYSQL | 192.168.139.140 | 5.7 |

| SonarQube | 192.168.139.140 | 7.8 |

3.9.3 安装SonarQube

-

安装mysql

-

安装SonarQube

-

访问sonar

http://192.168.139.140:9000

默认账户:admin/admin

创建tokenadministrator->security->generate token

itcast

c9f4b660f937c9f404f1627bd4b8c5d887b604ef

3.10 Jenkins+SonarQube代码审查(2) - 实现代码审查

3.10.1 安装SonarQube Scanner插件

3.10.2 添加SonarQube凭证

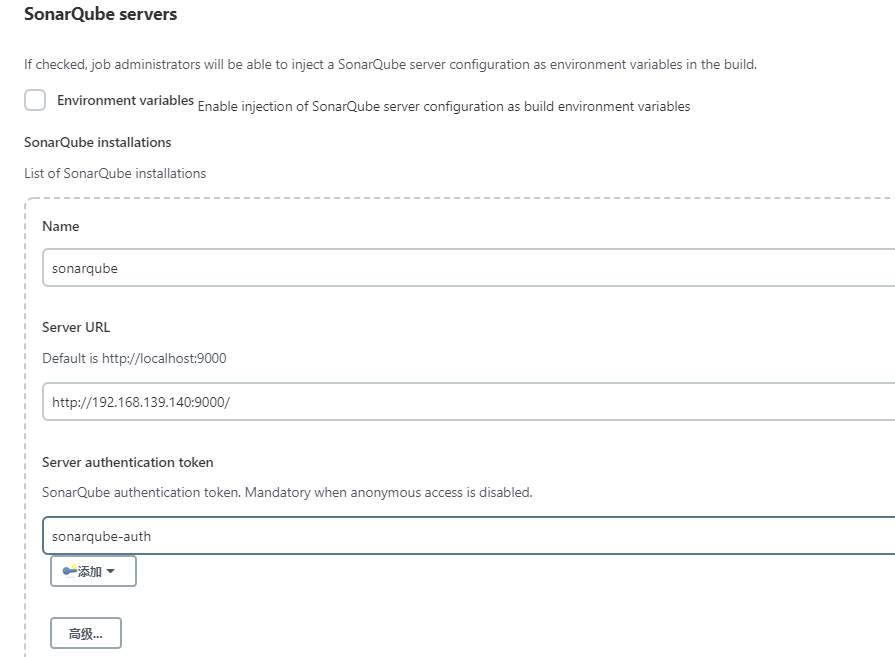

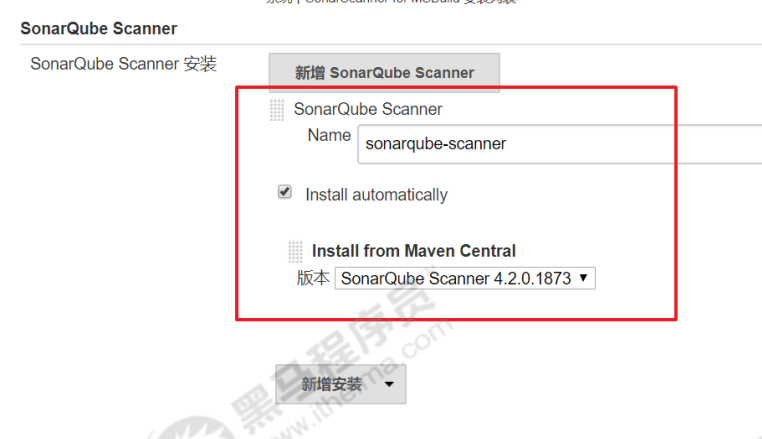

3.10.3 Jenkins进行SonarQube配置

Manage Jenkins->Configure System->SonarQube servers

Manage Jenkins->Global Tool Configuration

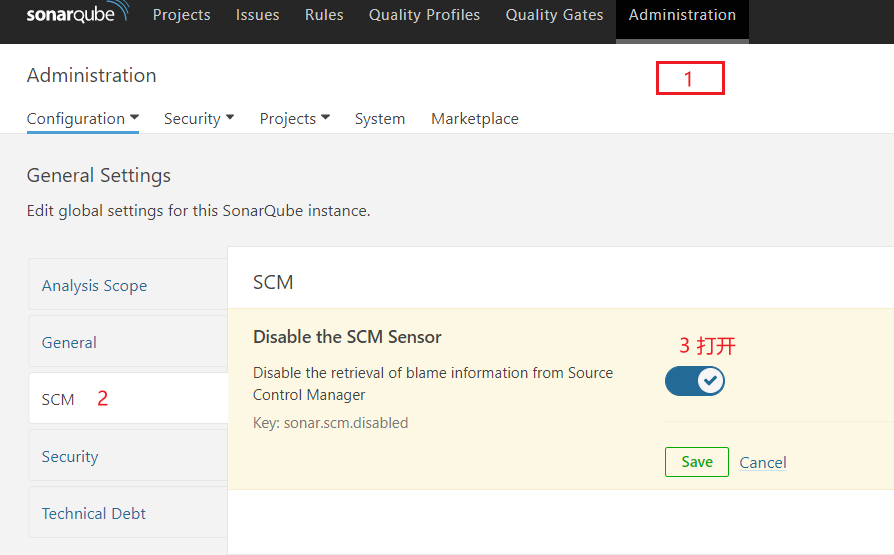

3.10.4 SonaQube关闭审查结果上传到SCM功能

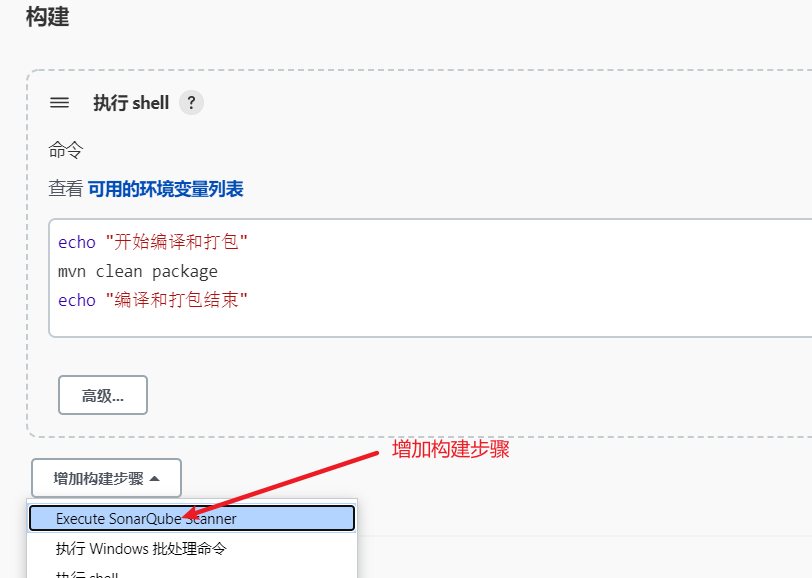

3.10.5 在项目添加SonaQube代码审查(非流水线项目)

添加构建步骤:

# must be unique in a given SonarQube instance

sonar.projectKey=web_demo

# this is the name and version displayed in the SonarQube UI. Was mandatory

prior to SonarQube 6.1.

sonar.projectName=web_demo

sonar.projectVersion=1.0

# Path is relative to the sonar-project.properties file. Replace "\" by "/" on

Windows.

# This property is optional if sonar.modules is set.

sonar.sources=.

sonar.exclusions=**/test/**,**/target/**

sonar.java.source=1.8

sonar.java.target=1.8

# Encoding of the source code. Default is default system encoding

sonar.sourceEncoding=UTF-8

3.10.6 在项目添加SonaQube代码审查(流水线项目)

-

项目根目录下,创建sonar-project.properties文件

-

修改Jenkinsfile,加入SonarQube代码审查阶段

-

到SonarQube的UI界面查看审查结果

4. Jenkins+Docker+SpringCloud微服务持续集成(上)

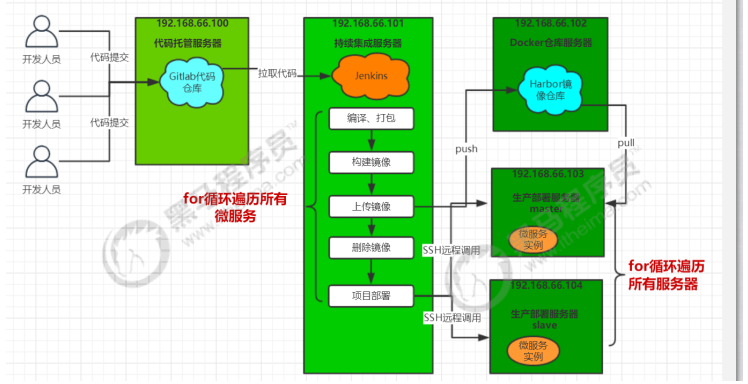

4.1 Jenkins+Docker+SpringCloud持续集成流程说明

流程说明:

- 开发人员每天把代码提交到Gitlab代码仓库

- Jenkins从Gitlab中拉取项目源码,编译并打成jar包,然后构建成Docker镜像,将镜像上传到

Harbor私有仓库。 - Jenkins发送SSH远程命令,让生产部署服务器到Harbor私有仓库拉取镜像到本地,然后创建容器。

- 最后,用户可以访问到容器

4.1.1 服务列表(红色的软件为需要安装的软件,黑色代表已经安装)

| 服务器名称 | IP地址 | 安装软件 |

|---|---|---|

| 代码托管服务器 | 192.168.139.139 | Gitlab |

| 持续集成服务器 | 192.168.139.140 | Jenkins+Maven+Docker |

| Docker仓库服务器 | 192.168.139.141 | Docker+Harbor |

| 生产部署服务器 | 192.168.139.142 | Docker |

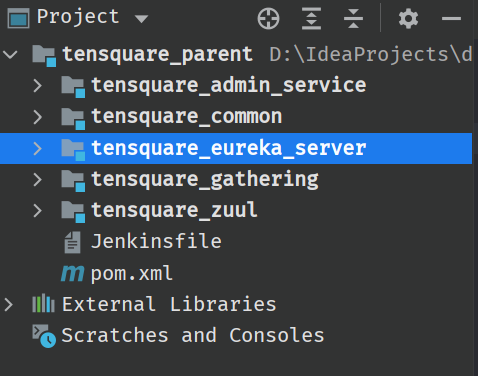

4.2 SpringCloud微服务源码概述

项目架构:前后端分离

后端技术栈:SpringBoot+SpringCloud+SpringDataJpa(Spring全家桶)

微服务项目结构:

- tensquare_parent:父工程,存放基础配置

- tensquare_common:通用工程,存放工具类

- tensquare_eureka_server:SpringCloud的Eureka注册中心

- tensquare_zuul:SpringCloud的网关服务

- tensquare_admin_service:基础权限认证中心,负责用户认证(使用JWT认证)

- tensquare_gathering:一个简单的业务模块,活动微服务相关逻辑

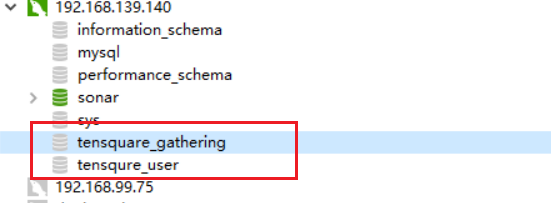

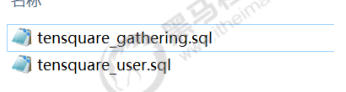

数据库结构:

- tensquare_user:用户认证数据库,存放用户账户数据。对应tensquare_admin_service微服务

- tensquare_gathering:活动微服务数据库。对应tensquare_gathering微服务

微服务配置分析:

- tensquare_eureka

- tensquare_zuul

- tensquare_admin_service

- tensquare_gathering

4.3 本地部署(1)-SpringCloud微服务部署

4.3.1 本地运行微服务

4.3.2 本地部署微服务

4.4 本地部署(2)-前端静态web网站

4.5 环境准备(1)-Docker快速入门

4.5.1 Docker简介

4.5.2 Docker安装

4.5.3 Docker基本命令快速入门

4.6 环境准备(2)-Dockerfile镜像脚本快速入门

4.6.1 Dockerfile简介

4.6.2 Dockerfile常见命令

4.6.3 使用Dockerfile制作微服务镜像

我们利用Dockerfile制作一个Eureka注册中心的镜像

-

上传Eureka的微服务jar包到linux

-

编写Dockerfile

FROM openjdk:8-jdk-alpine ARG JAR_FILE COPY ${JAR_FILE} app.jar EXPOSE 10086 ENTRYPOINT ["java","-jar","/app.jar"] -

构建镜像

docker build --build-arg JAR_FILE=tensquare_eureka_server-1.0-SNAPSHOT.jar -t eureka:v1 . -

查看镜像是否创建成功

docker images -

创建容器

docker run -i --name=eureka -p 10086:10086 eureka:v1 -

访问容器

http://192.168.139.140:10086/

4.7 环境准备(3)-Harbor镜像仓库安装及使用

4.7.1 Harbor简介

Harbor(港口,港湾)是一个用于存储和分发Docker镜像的企业级Registry服务器。

除了Harbor这个私有镜像仓库之外,还有Docker官方提供的Registry。相对Registry,Harbor具有很

多优势:

- 提供分层传输机制,优化网络传输 Docker镜像是是分层的,而如果每次传输都使用全量文件(所以

用FTP的方式并不适合),显然不经济。必须提供识别分层传输的机制,以层的UUID为标识,确定

传输的对象。 - 提供WEB界面,优化用户体验 只用镜像的名字来进行上传下载显然很不方便,需要有一个用户界

面可以支持登陆、搜索功能,包括区分公有、私有镜像。 - 支持水平扩展集群 当有用户对镜像的上传下载操作集中在某服务器,需要对相应的访问压力作分

解。 - 良好的安全机制 企业中的开发团队有很多不同的职位,对于不同的职位人员,分配不同的权限,

具有更好的安全性。

4.7.2 Harbor安装

Harbor需要安装在192.168.139.141上面

-

先安装Docker并启动Docker(已完成)

-

先安装docker-compose

-

下载Harbor的压缩包

https://github.com/goharbor/harbor/releases

-

上传压缩包到linux,并解压

tar -xzf harbor-offline-installer-v1.9.2.tgz mkdir /opt/harbor mv harbor/* /opt/harbor cd /opt/harbor -

修改harbor配置

vi harbor.yml修改hostname和port

hostname: 192.168.139.141 port: 85 -

安装Harbor

./prepare ./install.sh -

启动Harbor

-

访问Harbor

http://192.168.139.141:85/

默认账户密码:admin/Harbor12345

4.7.3 在Harbor创建用户和项目

-

创建项目

Harbor的项目分为公开和私有的:

公开项目:所有用户都可以访问,通常存放公共的镜像,默认有一个library公开项目。

私有项目:只有授权用户才可以访问,通常存放项目本身的镜像。

我们可以为微服务项目创建一个新的项目:

-

创建用户

创建的用户为:

freedom/Freedom@163.com

-

给私有项目分配用户

进入tensquare项目->成员

角色 权限 访客 对于指定项目拥有只读权限 开发人员 对于指定项目拥有读写权限 维护人员 对于指定项目拥有读写权限,创建 Webhooks 项目管理员 除了读写权限,同时拥有用户管理/镜像扫描等管理权限 -

以新用户登录Harbor

4.7.4 把镜像上传到Harbor

-

给镜像打上标签

docker tag eureka:v1 192.168.139.141:85/tensquare/eureka:v1 -

推送镜像

docker push 192.168.139.141:85/tensquare/eureka:v1The push refers to repository [192.168.139.141:85/tensquare/eureka]

Get https://192.168.139.141:85/v2/: http: server gave HTTP response to HTTPS

client这时会出现以上报错,是因为Docker没有把Harbor加入信任列表中

-

把Harbor地址加入到Docker信任列表

vi /etc/docker/daemon.json{ "registry-mirrors": ["https://nw9lv2m9.mirror.aliyuncs.com"], "insecure-registries": ["192.168.139.141:85"] }需要重启Docker

-

再次执行推送命令,会提示权限不足

denied: requested access to the resource is denied

需要先登录Harbor,再推送镜像

-

登录Harbor

docker login -u 用户名 -p 密码 192.168.139.141:85WARNING! Using --password via the CLI is insecure. Use --password-stdin.

WARNING! Your password will be stored unencrypted in /root/.docker/config.json.

Configure a credential helper to remove this warning. See

https://docs.docker.com/engine/reference/commandline/login/#credentials-store

Login Succeeded

4.7.5 从Harbor下载镜像

需求:在192.168.66.103服务器完成从Harbor下载镜像

-

安装Docker,并启动Docker

-

修改Docker配置

vi /etc/docker/daemon.json{ "registry-mirrors": ["https://nw9lv2m9.mirror.aliyuncs.com"], "insecure-registries": ["192.168.139.141:85"] }重启docker

-

先登录,再从Harbor下载镜像

docker login -u 用户名 -p 密码 192.168.139.141:85 docker pull 192.168.139.141:85/tensquare/eureka:v1

4.8 微服务持续集成(1)-项目代码上传到Gitlab

在IDEA操作即可,参考之前的步骤。包括后台微服务和前端web网站代码

4.9 微服务持续集成(2)-从Gitlab拉取项目源码

4.9.1 创建Jenkinsfile文件

//gitlab的凭证

def git_auth = "68f2087f-a034-4d39-a9ff-1f776dd3dfa8"

node {

stage('拉取代码') {

checkout([$class: 'GitSCM', branches: [[name: '*/${branch}']], doGenerateSubmoduleConfigurations: false, extensions: [], submoduleCfg: [], userRemoteConfigs: [[credentialsId: "${git_auth}", url:'git@192.168.66.100:itheima_group/tensquare_back.git']]])

}

}

4.9.2 拉取Jenkinsfile文件

4.10 微服务持续集成(3)-提交到SonarQube代码审查

4.10.1 创建项目,并设置参数

创建tensquare_back项目,添加两个参数

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-WG64ZbJN-1649818206970)(C:\Users\WenSh\AppData\Roaming\Typora\typora-user-images\image-20220410163429439.png)]](https://i-blog.csdnimg.cn/direct/9c99b17c0602481a914637218d30205f.png)

4.10.2 每个项目的根目录下添加sonar-project.properties

# must be unique in a given SonarQube instance

sonar.projectKey=tensquare_zuul

# this is the name and version displayed in the SonarQube UI. Was mandatory prior to SonarQube 6.1.

sonar.projectName=tensquare_zuul

sonar.projectVersion=1.0

# Path is relative to the sonar-project.properties file. Replace "\" by "/" on

Windows.

# This property is optional if sonar.modules is set.

sonar.sources=.

sonar.exclusions=**/test/**,**/target/**

sonar.java.binaries=.

sonar.java.source=1.8

sonar.java.target=1.8

sonar.java.libraries=**/target/classes/**

# Encoding of the source code. Default is default system encoding

sonar.sourceEncoding=UTF-8

注意:修改sonar.projectKey和sonar.projectName

4.10.3 修改Jenkinsfile构建脚本

//gitlab的凭证id

def git_auth = "68f2087f-a034-4d39-a9ff-1f776dd3dfa8"

//构建版本的名称

def tag = "latest"

node {

stage('拉取代码') {

checkout([$class: 'GitSCM', branches: [[name: '*/${branch}']], doGenerateSubmoduleConfigurations: false, extensions: [], submoduleCfg: [], userRemoteConfigs: [[credentialsId: "${git_auth}", url:'git@192.168.66.100:itheima_group/tensquare_back.git']]])

}

stage('代码审查') {

def scannerHome = tool 'sonarqube-scanner'

withSonarQubeEnv('sonarqube') {

sh """

cd ${project_name}

${scannerHome}/bin/sonar-scanner

"""

}

}

}

4.11 微服务持续集成(4)-使用Dockerfile编译、生成镜像

利用dockerfile-maven-plugin插件构建Docker镜像

4.11.1 在每个微服务项目的pom.xml加入dockerfile-maven-plugin插件

<plugin>

<groupId>com.spotify</groupId>

<artifactId>dockerfile-maven-plugin</artifactId>

<version>1.3.6</version>

<configuration>

<repository>${project.artifactId}</repository>

<buildArgs>

<JAR_FILE>target/${project.build.finalName}.jar</JAR_FILE>

</buildArgs>

</configuration>

</plugin>

4.11.2 在每个微服务项目根目录下建立Dockerfile文件

#FROM java:8

FROM openjdk:8-jdk-alpine

ARG JAR_FILE

COPY ${JAR_FILE} app.jar

EXPOSE 10086

ENTRYPOINT ["java","-jar","/app.jar"]

注意:每个项目公开的端口不一样

4.11.3 修改Jenkinsfile构建脚本

//gitlab的凭证

def git_auth = "68f2087f-a034-4d39-a9ff-1f776dd3dfa8"

//构建版本的名称

def tag = "latest"

//Harbor私服地址

def harbor_url = "192.168.xxx.xxx:85/tensquare/"

node {

stage('拉取代码') {

checkout([$class: 'GitSCM', branches: [[name: '*/${branch}']], doGenerateSubmoduleConfigurations: false, extensions: [], submoduleCfg: [], userRemoteConfigs: [[credentialsId: "${git_auth}", url:'git@192.168.139.139:itheima_group/tensquare_back.git']]])

}

stage('代码审查') {

def scannerHome = tool 'sonarqube-scanner'

withSonarQubeEnv('sonarqube') {

sh """

cd ${project_name}

${scannerHome}/bin/sonar-scanner

"""

}

}

stage('编译,构建镜像') {

//定义镜像名称

def imageName = "${project_name}:${tag}"

//编译,安装公共工程注意:如果出现找不到父工程依赖,需要手动把父工程的依赖上传到仓库中

sh "mvn -f tensquare_common clean install"

//编译,构建本地镜像

sh "mvn -f ${project_name} clean package dockerfile:build"

}

}

4.12 微服务持续集成(5)-上传到Harbor镜像仓库

4.12.1 修改Jenkinsfile构建脚本

//gitlab的凭证

def git_auth = "68f2087f-a034-4d39-a9ff-1f776dd3dfa8"

//构建版本的名称

def tag = "latest"

//Harbor私服地址

def harbor_url = "192.168.xxx.xxx:85/tensquare/"

node {

stage('拉取代码') {

checkout([$class: 'GitSCM', branches: [[name: '*/${branch}']], doGenerateSubmoduleConfigurations: false, extensions: [], submoduleCfg: [], userRemoteConfigs: [[credentialsId: "${git_auth}", url:'git@192.168.66.100:itheima_group/tensquare_back.git']]])

}

stage('代码审查') {

def scannerHome = tool 'sonarqube-scanner'

withSonarQubeEnv('sonarqube6.7.4') {

sh """

cd ${project_name}

${scannerHome}/bin/sonar-scanner

"""

}

}

stage('编译,构建镜像') {

//定义镜像名称

def imageName = "${project_name}:${tag}"

//编译,安装公共工程注意:如果出现找不到父工程依赖,需要手动把父工程的依赖上传到仓库中

sh "mvn -f tensquare_common clean install"

//编译,构建本地镜像

sh "mvn -f ${project_name} clean package dockerfile:build"

//给镜像打标签

sh "docker tag ${imageName} ${harbor_url}/${harbor_project_name}/${imageName}"

//登录Harbor,并上传镜像

withCredentials([usernamePassword(credentialsId: "${harbor_auth}", passwordVariable: 'password', usernameVariable: 'username')]) {

//登录

sh "docker login -u ${username} -p ${password} ${harbor_url}"

//上传镜像

sh "docker push ${harbor_url}/${harbor_project_name}/${imageName}"

}

//删除本地镜像

sh "docker rmi -f ${imageName}"

sh "docker rmi -f ${harbor_url}/${harbor_project_name}/${imageName}"

}

}

4.12.2 使用凭证管理Harbor私服账户和密码

先在凭证建立Harbor的凭证,在生成凭证脚本代码

4.13 微服务持续集成(6)-拉取镜像和发布应用

4.13.1 安装 Publish Over SSH 插件

安装以下插件,可以实现远程发送Shell命令

4.13.2 配置远程部署服务器

-

拷贝公钥到远程服务器

ssh-copy-id 192.168.139.xxx -

系统配置->添加远程服务器

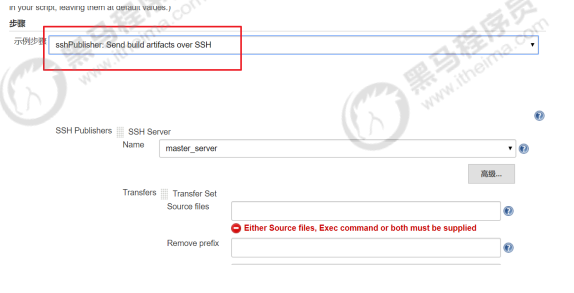

4.13.3 修改Jenkinsfile构建脚本

生成远程调用模板代码

添加一个port参数

//gitlab的凭证

def git_auth = "68f2087f-a034-4d39-a9ff-1f776dd3dfa8"

//构建版本的名称

def tag = "latest"

//Harbor私服地址

def harbor_url = "192.168.xxx.xxx:85/tensquare/"

node {

stage('拉取代码') {

checkout([$class: 'GitSCM', branches: [[name: '*/${branch}']], doGenerateSubmoduleConfigurations: false, extensions: [], submoduleCfg: [], userRemoteConfigs: [[credentialsId: "${git_auth}", url:'git@192.168.66.100:itheima_group/tensquare_back.git']]])

}

stage('代码审查') {

// 定义当前Jenkins的sonarqubeScanner工具

def scannerHome = tool 'sonarqube-scanner'

// 引用当前JenkinsSonarqube环境

withSonarQubeEnv('sonarqube') {

sh """

cd ${project_name}

${scannerHome}/bin/sonar-scanner

"""

}

}

stage('编译,构建镜像') {

//定义镜像名称

def imageName = "${project_name}:${tag}"

//编译,安装公共工程注意:如果出现找不到父工程依赖,需要手动把父工程的依赖上传到仓库中

sh "mvn -f tensquare_common clean install"

//编译,构建本地镜像

sh "mvn -f ${project_name} clean package dockerfile:build"

//给镜像打标签

sh "docker tag ${imageName} ${harbor_url}/${harbor_project_name}/${imageName}"

//登录Harbor,并上传镜像

withCredentials([usernamePassword(credentialsId: "${harbor_auth}", passwordVariable: 'password', usernameVariable: 'username')]) {

//登录

sh "docker login -u ${username} -p ${password} ${harbor_url}"

//上传镜像

sh "docker push ${harbor_url}/${harbor_project_name}/${imageName}"

}

//删除本地镜像

sh "docker rmi -f ${imageName}"

sh "docker rmi -f ${harbor_url}/${harbor_project_name}/${imageName}"

//=====以下为远程调用进行项目部署========

sshPublisher(publishers: [sshPublisherDesc(configName: 'master_server', transfers: [sshTransfer(cleanRemote: false, excludes: '', execCommand: " , execTimeout: 120000, flatten: false, makeEmptyDirs: false, noDefaultExcludes: false, patternSeparator: '[, ]+', remoteDirectory: '', remoteDirectorySDF: false, removePrefix: '', sourceFiles: '')], usePromotionTimestamp: false, useWorkspaceInPromotion: false, verbose: false)])

}

}

4.13.4 编写deploy.sh部署脚本

#! /bin/sh

#接收外部参数

harbor_url=$1

harbor_project_name=$2

project_name=$3

tag=$4

port=$5

imageName=$harbor_url/$harbor_project_name/$project_name:$tag

echo "$imageName"

#查询容器是否存在,存在则删除

containerId=`docker ps -a | grep -w ${project_name}:${tag} | awk '{print $1}'`

if [ "$containerId" != "" ] ; then

#停掉容器

docker stop $containerId

#删除容器

docker rm $containerId

echo "成功删除容器"

fi

#查询镜像是否存在,存在则删除

imageId=`docker images | grep -w $project_name | awk '{print $3}'`

if [ "$imageId" != "" ] ; then

#删除镜像

docker rmi -f $imageId

echo "成功删除镜像"

fi

# 登录Harbor私服

docker login -u 用户名 -p 密码 $harbor_url

# 下载镜像

docker pull $imageName

# 启动容器

docker run -di -p $port:$port $imageName

echo "容器启动成功"

上传deploy.sh文件到/opt/jenkins_shell目录下,且文件至少有执行权限!

chmod +x deploy.sh #添加执行权限

4.13.5 导入数据,测试微服务

注意:jenkins构建发现未拉取镜像、启动容器。修改sshPublisher中verbose属性为true,显示连接harbor_url为https。

Docker自从1.3.X之后docker registry交互默认使用的是HTTPS,但是搭建私有镜像默认使用的是HTTP服务,所以与私有镜像交时出现以上错误。所以需要修改daemon.json

vim /etc/docker/daemon.json

{

"registry-mirrors": ["https://nw9lv2m9.mirror.aliyuncs.com"],

"insecure-registries": ["192.168.139.141:85"]

}

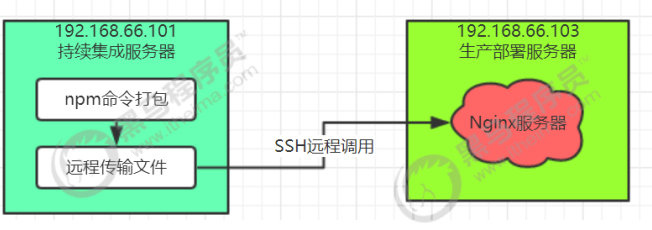

4.14 微服务持续集成(7)-部署前端静态web网站

4.14.1 安装Nginx服务器

修改nginx的端口,默认80,改为9090

还需要关闭selinux,将SELINUX=disabled \

setenforce 0 #先临时关闭

vi /etc/selinux/config #编辑文件,永久关闭 SELINUX=disabled

启动Nginx

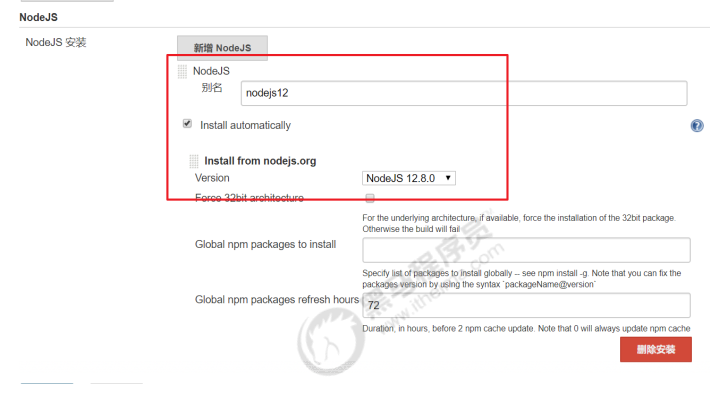

4.14.2 安装NodeJS插件

4.14.3 Jenkins配置Nginx服务器

Manage Jenkins->Global Tool Configuration

4.14.4 创建前端流水线项目

4.14.5 建立Jenkinsfile构建脚本

//gitlab的凭证

def git_auth = "68f2087f-a034-4d39-a9ff-1f776dd3dfa8"

node {

stage('拉取代码') {

checkout([$class: 'GitSCM', branches: [[name: '*/${branch}']], doGenerateSubmoduleConfigurations: false, extensions: [], submoduleCfg: [], userRemoteConfigs: [[credentialsId: "${git_auth}", url: 'git@192.168.139.139:itheima_group/tensquare_front.git']]])

}

stage('打包,部署网站') {

//使用NodeJS的npm进行打包

nodejs('nodejs12'){

sh '''

npm install

npm run build

'''

}

//=====以下为远程调用进行项目部署========

sshPublisher(publishers: [sshPublisherDesc(configName: 'master_server', transfers: [sshTransfer(cleanRemote: false, excludes: '', execCommand: '', execTimeout: 120000, flatten: false, makeEmptyDirs: false, noDefaultExcludes: false, patternSeparator: '[, ]+', remoteDirectory: '/usr/share/nginx/html', remoteDirectorySDF: false, removePrefix: 'dist', sourceFiles: 'dist/**')], usePromotionTimestamp: false, useWorkspaceInPromotion: false, verbose: false)])

}

}

完成后,访问:http://nginxIp:9090 进行测试。

5. Jenkins+Docker+SpringCloud微服务持续集成(下)

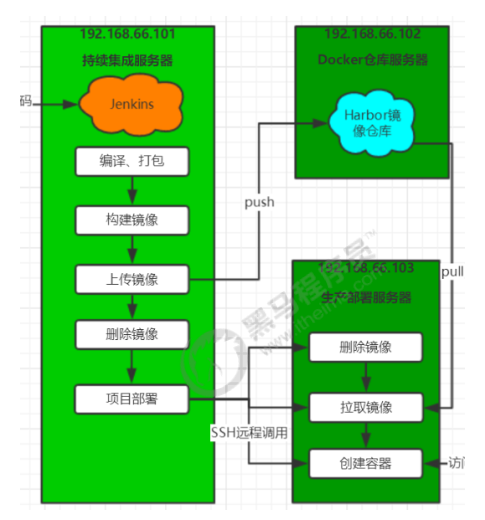

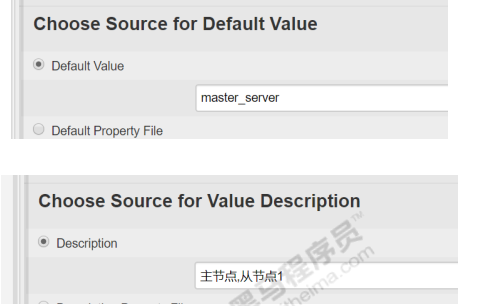

5.1 Jenkins+Docker+SpringCloud部署方案优化

上面部署方案存在的问题:

- 一次只能选择一个微服务部署

- 只有一台生产者部署服务器

- 每个微服务只有一个实例,容错率低

优化方案:

- 在一个Jenkins工程中可以选择多个微服务同时发布

- 在一个Jenkins工程中可以选择多台生产服务器同时部署

- 每个微服务都是以集群高可用形式部署

5.2 Jenkins+Docker+SpringCloud集群部署流程说明

5.3 修改所有微服务配置

5.3.1 注册中心配置

# 集群版

spring:

application:

name: EUREKA-HA

---

server:

port: 10086

spring:

# 指定profile=eureka-server1

profiles: eureka-server1

eureka:

instance:

# 指定当profile=eureka-server1时,主机名是eureka-server1

hostname: 192.168.139.141

client:

service-url:

# 将自己注册到eureka-server1、eureka-server2这个Eureka上面去

defaultZone: http://192.168.139.141:10086/eureka/,http://192.168.139.142:10086/eureka/

---

server:

port: 10086

spring:

profiles: eureka-server2

eureka:

instance:

hostname: 192.168.139.142

client:

service-url:

defaultZone: http://192.168.139.141:10086/eureka/,http://192.168.139.142:10086/eureka/

在启动微服务的时候,加入参数: spring.profiles.active 来读取对应的配置

5.3.2 其他微服务配置

除了Eureka注册中心以外,其他微服务配置都需要加入所有Eureka服务

# Eureka配置

eureka:

client:

service-url:

defaultZone: http://192.168.139.141:10086/eureka,http://192.168.139.142:10086/eureka # Eureka访问地址

instance:

prefer-ip-address: true

把代码提交到Gitlab中

5.4 设计Jenkins集群项目的构建参数

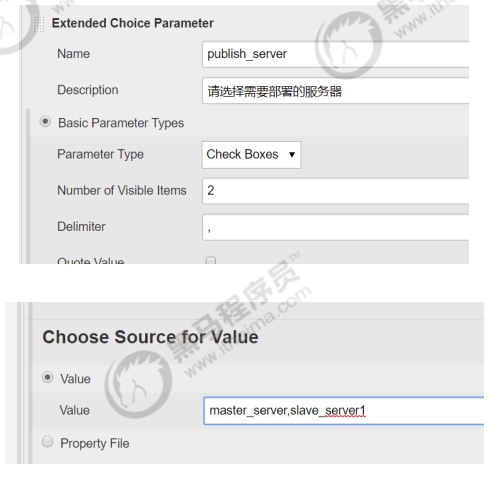

5.4.1 安装Extended Choice Parameter插件

支持多选框

5.4.2 创建流水线项目

5.4.3 添加参数

-

字符串参数:分支名称

-

多选框:项目名称

-

最后效果

5.5 完成微服务构建镜像,上传私服

// git凭证ID

def git_auth="030197b4-3b90-4bba-afb4-beb12c7589c1"

//git的url地址

def git_url="git@192.168.139.139:itcast_group/tensquare_back.git"

def tag="latest"

def harbor_url = "192.168.139.141:85"

def harbor_auth = "15d9596d-1c51-4f5e-ba09-35f332fa2dab"

def harbor_project="tensquare"

node {

stage("拉取代码") {

checkout([$class: 'GitSCM', branches: [[name: "*/${branch}"]], extensions: [], userRemoteConfigs: [[credentialsId: "${git_auth}", url: "${git_url}"]]])

}

stage("代码审查") {

def scannerHome = tool 'sonarqube-scanner'

withSonarQubeEnv('sonarqube') {

sh """

cd ${project_name}

${scannerHome}/bin/sonar-scanner

"""

}

}

stage('编译,安装子工程') {

//编译,安装公共工程注意:如果出现找不到父工程依赖,需要手动把父工程的依赖上传到仓库中

sh "mvn -f tensquare_common clean install"

}

stage('编译、打包微服务工程'){

sh "mvn -f ${project_name} clean package dockerfile:build"

// 定义镜像名称

def imageName = "${project_name}:${tag}"

// 对镜像打标签tag

sh "docker tag ${imageName} ${harbor_url}/${harbor_project}/${imageName}"

// 镜像推送到harbor

withCredentials([usernamePassword(credentialsId: "${harbor_auth}", passwordVariable: 'password', usernameVariable: 'username')]) {

// 登录harbor

sh "docker login -u ${username} -p ${password} ${harbor_url}"

// 镜像上传

sh "docker push ${harbor_url}/${harbor_project}/${imageName}"

sh "echo 镜像上传成功!"

}

sh "echo 开始调用部署应用脚本!"

// 部署应用

sshPublisher(publishers: [sshPublisherDesc(configName: 'master_server', transfers: [sshTransfer(cleanRemote: false, excludes: '', execCommand: "/opt/jenkins_shell/deploy.sh $harbor_url $harbor_project ${project_name} $tag ${port}", execTimeout: 120000, flatten: false, makeEmptyDirs: false, noDefaultExcludes: false, patternSeparator: '[, ]+', remoteDirectory: '', remoteDirectorySDF: false, removePrefix: '', sourceFiles: '')], usePromotionTimestamp: false, useWorkspaceInPromotion: false, verbose: true)])

}

}

5.6 完成微服务多服务器远程发布

5.6.1 配置远程部署服务

-

拷贝公钥到远程服务器

ssh-copy-id 192.168.139.142 -

系统配置->添加远程服务器

5.6.2 修改Docker配置信任Harbor私服地址

{

"registry-mirrors": ["https://nw9lv2m9.mirror.aliyuncs.com"],

"insecure-registries": ["192.168.139.141:85"]

}

sudo systemctl daemon-reload

sudo systemctl restart docker

5.6.3 添加参数

多选框:部署服务器

最终效果:

5.6.4 修改Jenkinsfile构建脚本

// git凭证ID

def git_auth = "030197b4-3b90-4bba-afb4-beb12c7589c1"

//git的url地址

def git_url = "git@192.168.139.139:itcast_group/tensquare_back.git"

def tag = "latest"

def harbor_url = "192.168.139.141:85"

def harbor_auth = "15d9596d-1c51-4f5e-ba09-35f332fa2dab"

def harbor_project = "tensquare"

node {

// 获取当前选择的项目

def selectedProjectNames = "${project_name}".split(",")

// 获取需要部署的服务器

def selectedServers = "${publish_server}".split(",")

stage("拉取代码") {

checkout([$class: 'GitSCM', branches: [[name: "*/${branch}"]], extensions: [], userRemoteConfigs: [[credentialsId: "${git_auth}", url: "${git_url}"]]])

}

stage("代码审查") {

def scannerHome = tool 'sonarqube-scanner'

for (int i = 0; i < selectedProjectNames.length; i++) {

def projectInfo = selectedProjectNames[i]

def currentProjectName = "${projectInfo}".split("@")[0]

// def currentProjectPort="${projectInfo}".split("@")[1]

withSonarQubeEnv('sonarqube') {

sh """

cd ${currentProjectName}

${scannerHome}/bin/sonar-scanner

"""

}

}

}

stage('编译,安装子工程') {

//编译,安装公共工程注意:如果出现找不到父工程依赖,需要手动把父工程的依赖上传到仓库中

sh "mvn -f tensquare_common clean install"

}

stage('编译、打包微服务工程') {

for (int i = 0; i < selectedProjectNames.length; i++) {

def projectInfo = selectedProjectNames[i]

def currentProjectName = "${projectInfo}".split("@")[0]

def currentProjectPort = "${projectInfo}".split("@")[1]

sh "mvn -f ${currentProjectName} clean package dockerfile:build"

// 定义镜像名称

def imageName = "${currentProjectName}:${tag}"

// 对镜像打标签tag

sh "docker tag ${imageName} ${harbor_url}/${harbor_project}/${imageName}"

// 镜像推送到harbor

withCredentials([usernamePassword(credentialsId: "${harbor_auth}", passwordVariable: 'password', usernameVariable: 'username')]) {

// 登录harbor

sh "docker login -u ${username} -p ${password} ${harbor_url}"

// 镜像上传

sh "docker push ${harbor_url}/${harbor_project}/${imageName}"

sh "echo 镜像上传成功!"

}

for (int j = 0; j < selectedServers.length; j++) {

def currentServerName = selectedServers[j]

def activeProfile = "--spring.profiles.active="

// 加上的参数格式 --spring.profiles.active=eureka-server1/eureka-server2

if (currentServerName == "master_server") {

activeProfile = activeProfile + "eureka-server1"

} else if (currentServerName == "slave_server1") {

activeProfile = activeProfile + "eureka-server2"

}

// 部署应用

sshPublisher(publishers: [sshPublisherDesc(configName: "$currentServerName", transfers: [sshTransfer(cleanRemote: false, excludes: '', execCommand: "/opt/jenkins_shell/deployCluster.sh $harbor_url $harbor_project ${project_name} $tag $currentProjectPort $activeProfile", execTimeout: 120000, flatten: false, makeEmptyDirs: false, noDefaultExcludes: false, patternSeparator: '[, ]+', remoteDirectory: '', remoteDirectorySDF: false, removePrefix: '', sourceFiles: '')], usePromotionTimestamp: false, useWorkspaceInPromotion: false, verbose: true)])

}

}

}

}

注意:需要部署的服务器都需要有部署脚本deployCluster.sh

5.6.5 编写deployCluster.sh部署脚本

#! /bin/sh

#接收外部参数

harbor_url=$1

harbor_project_name=$2

project_name=$3

tag=$4

port=$5

profile=$6

imageName=$harbor_url/$harbor_project_name/$project_name:$tag

echo "$imageName"

#查询容器是否存在,存在则删除

containerId=`docker ps -a | grep -w ${project_name}:${tag} | awk '{print $1}'`

if [ "$containerId" != "" ] ; then

#停掉容器

docker stop $containerId

#删除容器

docker rm $containerId

echo "成功删除容器"

fi

#查询镜像是否存在,存在则删除

imageId=`docker images | grep -w $project_name | awk '{print $3}'`

if [ "$imageId" != "" ] ; then

#删除镜像

docker rmi -f $imageId

echo "成功删除镜像"

fi

# 登录Harbor私服

docker login -u freedom -p Freedom@163.com $harbor_url

# 下载镜像

docker pull $imageName

# 启动容器

docker run -di -p $port:$port $imageName $profile

echo "容器启动成功"

5.6.6 集群效果

5.7 Nginx+Zuul集群实现高可用网关

1)安装Nginx(已完成)

2)修改Nginx配置

vi /etc/nginx/nginx.conf

upstream zuulServer{

server 192.168.66.103:10020 weight=1;

server 192.168.66.104:10020 weight=1;

}

server {

listen 85 default_server;

listen [::]:85 default_server;

server_name _;

root /usr/share/nginx/html;

include /etc/nginx/conf.d/*.conf;

location / {

#指定服务器负载均衡服务器

proxy_pass http://zuulServer/;

}

}

3)重启Nginx:

systemctl restart nginx

4)修改前端Nginx的访问地址

config.json

6. 基于Kubernetes/K8S构建Jenkins持续集成平台(上)

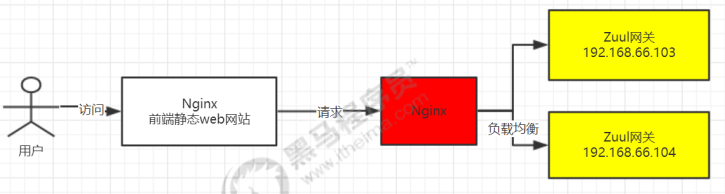

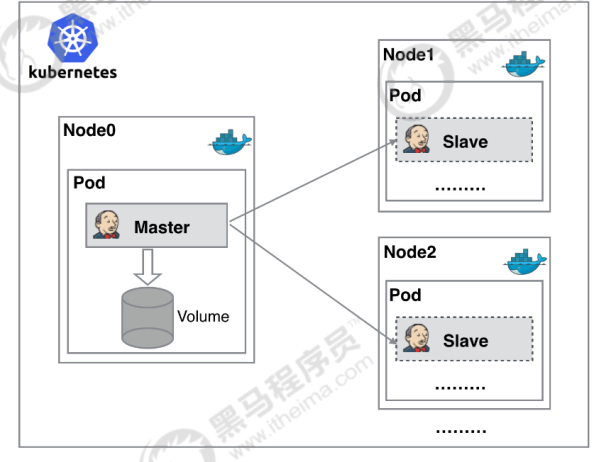

6.1 Jenkins的Master-Slave分布式构建

6.1.1 什么是Master-Slave分布式构建

Jenkins的Master-Slave分布式构建,就是通过将构建过程分配到从属Slave节点上,从而减轻Master节

点的压力,而且可以同时构建多个,有点类似负载均衡的概念。

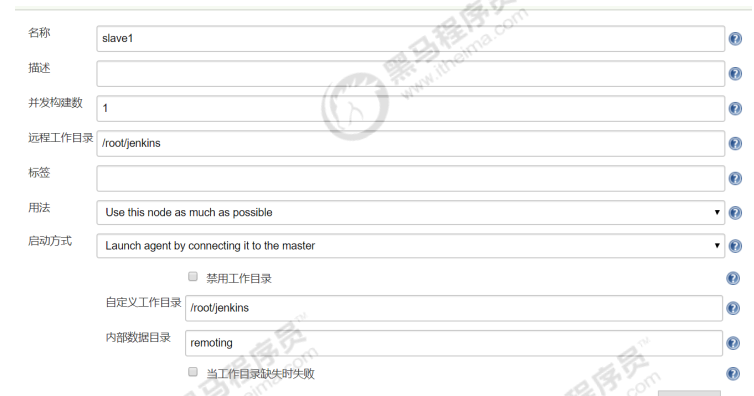

6.1.2 如何实现Master-Slave分布式构建

1、开启代理程序的TCP端口

Manage Jenkins -> Configure Global Security

2、新建节点

Manage Jenkins—Manage Nodes—新建节点

有两种在Slave节点连接Master节点的方法

我们选择第二种:

3、安装和配置节点

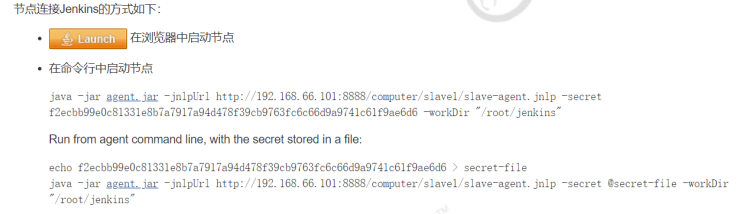

下载agent.jar,并上传到Slave节点,然后执行页面提示的命令

java -jar agent.jar -jnlpUrl http://192.168.139.141:8888/computer/slave1/slaveagent.jnlp -secret

f2ecbb99e0c81331e8b7a7917a94d478f39cb9763fc6c66d9a9741c61f9ae6d6 -workDir

"/root/jenkins"

刷新页面

4、测试节点是否可用

自由风格和Maven风格的项目:

流水线风格的项目:

node('slave1') {

stage('check out') {

checkout([$class: 'GitSCM', branches: [[name: '*/master']],doGenerateSubmoduleConfigurations: false, extensions:[], submoduleCfg: [], userRemoteConfigs: [[credentialsId: '68f2087f-a034-4d39-a9ff-1f776dd3dfa8', url:'git@192.168.66.100:itheima_group/tensquare_back_cluster.git']]])

}

}

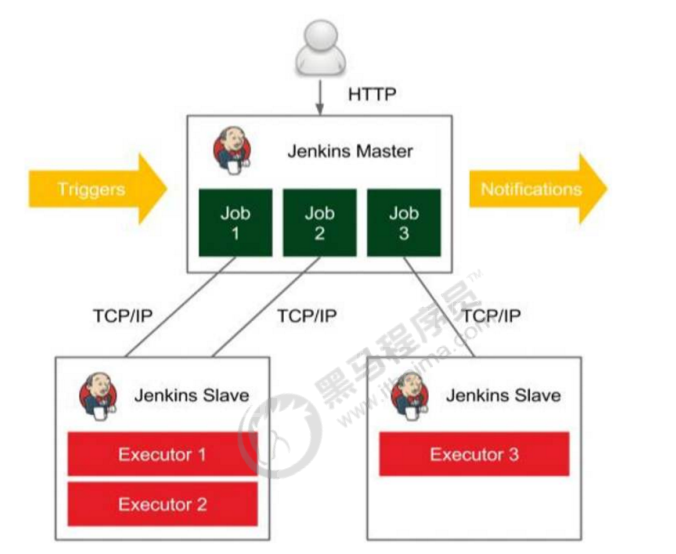

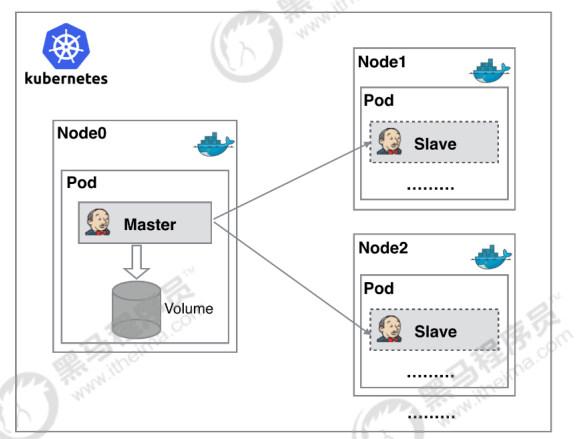

6.2 Kubernetes实现Master-Slave分布式构建方案

6.2.1 传统Jenkins的Master-Slave方案的缺陷

- Master节点发生单点故障时,整个流程都不可用了

- 每个 Slave节点的配置环境不一样,来完成不同语言的编译打包等操作,但是这些差异化的配置导致管理起来非常不方便,维护起来也是比较费劲

- 资源分配不均衡,有的 Slave节点要运行的job出现排队等待,而有的Slave节点处于空闲状态

- 资源浪费,每台 Slave节点可能是实体机或者VM,当Slave节点处于空闲状态时,也不会完全释放

掉资源

以上种种问题,我们可以引入Kubernates来解决!

6.2.2 Kubernates简介

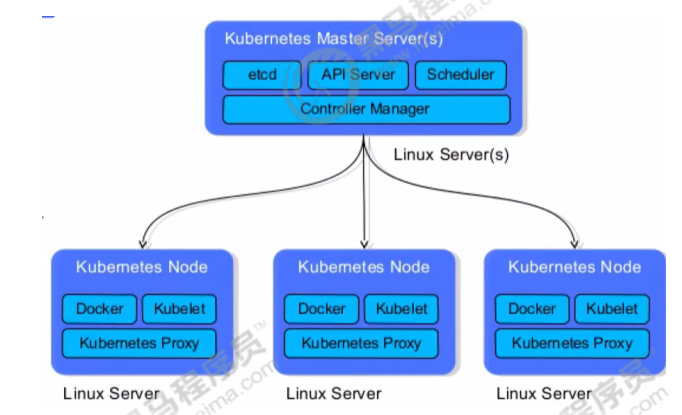

Kubernetes(简称,K8S)是Google开源的容器集群管理系统,在Docker技术的基础上,为容器化的

应用提供部署运行、资源调度、服务发现和动态伸缩等一系列完整功能,提高了大规模容器集群管理的

便捷性。 其主要功能如下:

- 使用Docker对应用程序包装(package)、实例化(instantiate)、运行(run)。

- 以集群的方式运行、管理跨机器的容器。

- 解决Docker跨机器容器之间的通讯问题。

- Kubernetes的自我修复机制使得容器集群总是运行在用户期望的状态

6.2.3 Kubernates+Docker+Jenkins持续集成架构图

大致工作流程:手动/自动构建 -> Jenkins 调度 K8S API ->动态生成 Jenkins Slave pod -> Slave pod

拉取 Git 代码/编译/打包镜像 ->推送到镜像仓库 Harbor -> Slave 工作完成,Pod 自动销毁 ->部署

到测试或生产 Kubernetes平台。(完全自动化,无需人工干预)

6.2.4 Kubernates+Docker+Jenkins持续集成方案好处

-

服务高可用:当 Jenkins Master 出现故障时,Kubernetes 会自动创建一个新的 Jenkins Master

-

容器,并且将 Volume 分配给新创建的容器,保证数据不丢失,从而达到集群服务高可用。

-

动态伸缩,合理使用资源:每次运行 Job 时,会自动创建一个 Jenkins Slave,Job 完成后,Slave

自动注销并删除容器,资源自动释放,而且 Kubernetes 会根据每个资源的使用情况,动态分配

Slave 到空闲的节点上创建,降低出现因某节点资源利用率高,还排队等待在该节点的情况。

-

扩展性好:当 Kubernetes 集群的资源严重不足而导致 Job 排队等待时,可以很容易的添加一个

Kubernetes Node 到集群中,从而实现扩展。

6.3 Kubeadm安装Kubernetes

6.3.1 Kubernetes的架构

6.3.2 安装环境说明

6.3.3 三台机器都需要完成

-

修改三台机器的hostname及hosts文件

hostnamectl set-hostname k8s-master hostnamectl set-hostname k8s-node1 hostnamectl set-hostname k8s-node2 cat >>/etc/hosts<<EOF 192.168.66.101 k8s-master 192.168.66.103 k8s-node1 192.168.66.104 k8s-node2 EOF -

关闭防火墙和关闭SELinux

systemctl stop firewalld systemctl disable firewalld setenforce 0 临时关闭 vi /etc/sysconfig/selinux #永久关闭, 改为SELINUX=disabled -

设置系统参数

设置允许路由转发,不对bridge的数据进行处理

-

创建文件

vi /etc/sysctl.d/k8s.conf内容如下:

net.bridge.bridge-nf-call-ip6tables = 1 net.bridge.bridge-nf-call-iptables = 1 net.ipv4.ip_forward = 1 vm.swappiness = 0 -

执行文件

sysctl -p /etc/sysctl.d/k8s.conf

-

-

kube-proxy开启ipvs的前置条件

cat > /etc/sysconfig/modules/ipvs.modules <<EOF #!/bin/bash modprobe -- ip_vs modprobe -- ip_vs_rr modprobe -- ip_vs_wrr modprobe -- ip_vs_sh modprobe -- nf_conntrack_ipv4 EOF chmod 755 /etc/sysconfig/modules/ipvs.modules && bash /etc/sysconfig/modules/ipvs.modules && lsmod | grep -e ip_vs -e nf_conntrack_ipv4 -

所有节点关闭swap

swapoff -a 临时关闭 vi /etc/fstab 永久关闭 注释掉以下字段 /dev/mapper/cl-swap swap swap defaults 0 0 -

安装kubelet、kubeadm、kubectl

- kubeadm: 用来初始化集群的指令。

- kubelet: 在集群中的每个节点上用来启动 pod 和 container 等。

- kubectl: 用来与集群通信的命令行工具。

清空yum缓存

yum clean all设置yum安装源

cat <<EOF > /etc/yum.repos.d/kubernetes.repo [kubernetes] name=Kubernetes baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/ enabled=1 gpgcheck=0 repo_gpgcheck=0 gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg EOF安装:

yum install -y kubelet kubeadm kubectlkubelet设置开机启动(注意:先不启动,现在启动的话会报错)

systemctl enable kubelet查看版本

kubelet --version安装的是最新版本:Kubernetes v1.16.3(可能会变化)

6.3.4 Master节点需要完成

1、运行初始化命令

kubeadm init --kubernetes-version=1.17.0 \

--apiserver-advertise-address=192.168.66.101 \

--image-repository registry.aliyuncs.com/google_containers \

--service-cidr=10.1.0.0/16 \

--pod-network-cidr=10.244.0.0/16

注意:apiserver-advertise-address这个地址必须是master机器的IP

常用错误:

错误一:[WARNING IsDockerSystemdCheck]: detected “cgroupfs” as the Docker cgroup driver

作为Docker cgroup驱动程序。,Kubernetes推荐的Docker驱动程序是“systemd”

解决方案:修改Docker的配置: vi /etc/docker/daemon.json,加入

{

"exec-opts":["native.cgroupdriver=systemd"]

}

然后重启Docker

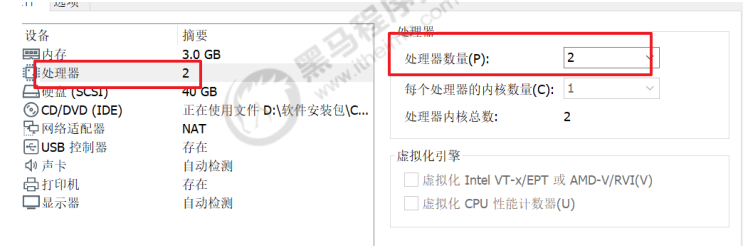

错误二:[ERROR NumCPU]: the number of available CPUs 1 is less than the required 2

解决方案:修改虚拟机的CPU的个数,至少为2个

安装过程日志:

最后,会提示节点安装的命令,必须记下来

kubeadm join 192.168.66.101:6443 --token 754snw.9xq9cotze1ybwnti \

--discovery-token-ca-cert-hash

sha256:3372ff6717ea5997121213e2c9d63fa7c8cdfb031527e17f2e20254f382ea03a

2、启动kubelet

systemctl restart kubelet

3、配置kubectl工具

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

4、安装Calico

mkdir k8s

cd k8s

wget https://docs.projectcalico.org/v3.10/gettingstarted/kubernetes/installation/hosted/kubernetes-datastore/caliconetworking/1.7/calico.yaml

sed -i 's/192.168.0.0/10.244.0.0/g' calico.yaml

kubectl apply -f calico.yaml

5、等待几分钟,查看所有Pod的状态,确保所有Pod都是Running状态

kubectl get pod --all-namespaces -o wide

6.3.5 Slave节点需要完成

1、让所有节点加入集群环境

使用之前Master节点产生的命令加入集群

kubeadm join 192.168.66.101:6443 --token 754snw.9xq9cotze1ybwnti \

--discovery-token-ca-cert-hash

sha256:3372ff6717ea5997121213e2c9d63fa7c8cdfb031527e17f2e20254f382ea03a

2、启动kubelet

systemctl start docker

3、回到Master节点查看,如果Status全部为Ready,代表集群环境搭建成功!!

kubectl get nodes

6.3.6 kubectl常用命令

kubectl get nodes 查看所有主从节点的状态

kubectl get ns 获取所有namespace资源

kubectl get pods -n {$nameSpace} 获取指定namespace的pod

kubectl describe pod的名称 -n {$nameSpace} 查看某个pod的执行过程

kubectl logs --tail=1000 pod的名称 | less 查看日志

kubectl create -f xxx.yml 通过配置文件创建一个集群资源对象

kubectl delete -f xxx.yml 通过配置文件删除一个集群资源对象

kubectl delete pod名称 -n {$nameSpace} 通过pod删除集群资源

kubectl get service -n {$nameSpace} 查看pod的service情况

7. 基于Kubernetes/K8S构建Jenkins持续集成平台(下)

Jenkins-Master-Slave架构图回顾:

7.1 安装和配置NFS

7.1.1 NFS简介

NFS(Network File System),它最大的功能就是可以通过网络,让不同的机器、不同的操作系统可以

共享彼此的文件。我们可以利用NFS共享Jenkins运行的配置文件、Maven的仓库依赖文件等

7.1.2 NFS安装

我们把NFS服务器安装在192.168.66.101机器上

-

安装NFS服务(在所有K8S的节点都需要安装)

yum install -y nfs-utils -

创建共享目录

mkdir -p /opt/nfs/jenkins vi /etc/exports 编写NFS的共享配置 内容如下: /opt/nfs/jenkins *(rw,no_root_squash) *代表对所有IP都开放此目录,rw是读写 -

启动服务

systemctl enable nfs 开机启动 systemctl start nfs 启动 -

查看NFS共享目录

showmount -e 192.168.66.101

7.2 在Kubernetes安装Jenkins-Master

7.2.1 创建NFS client provisioner

nfs-client-provisioner 是一个Kubernetes的简易NFS的外部provisioner,本身不提供NFS,需要现有的NFS服务器提供存储。

-

上传nfs-client-provisioner构建文件

其中注意修改deployment.yaml,使用之前配置NFS服务器和目录

-

构建nfs-client-provisioner的pod资源

cd nfs-client kubectl create -f . -

查看pod是否创建成功

kubectl get nodes

7.2.2 安装Jenkins-Master

-

上传Jenkins-Master构建文件

其中有两点注意:

第一、在StatefulSet.yaml文件,声明了利用nfs-client-provisioner进行Jenkins-Master文件存储

第二、Service发布方法采用NodePort,会随机产生节点访问端口

-

创建kube-ops的namespace

因为我们把Jenkins-Master的pod放到kube-ops下

kubectl create namespace kube-ops -

构建Jenkins-Master的pod资源

cd jenkins-master kubectl create -f . -

查看pod是否创建成功

kubectl get pods -n kube-ops -

查看信息,并访问

查看Pod运行在那个Node上

kubectl describe pods -n kube-ops查看分配的端口

kubectl get service -n kube-ops最终访问地址为:http://192.168.66.103:30136 (192.168.66.103为k8s-node1的IP)

安装过程跟之前是一样的!

-

先安装基本的插件

- Localization:Chinese

- Git

- Pipeline

- Extended Choice Parameter

7.3 Jenkins与Kubernetes整合

7.3.1 安装Kubernetes插件

系统管理->插件管理->可选插件

7.3.2 实现Jenkins与Kubernetes整合

系统管理->系统配置->云->新建云->Kubernetes

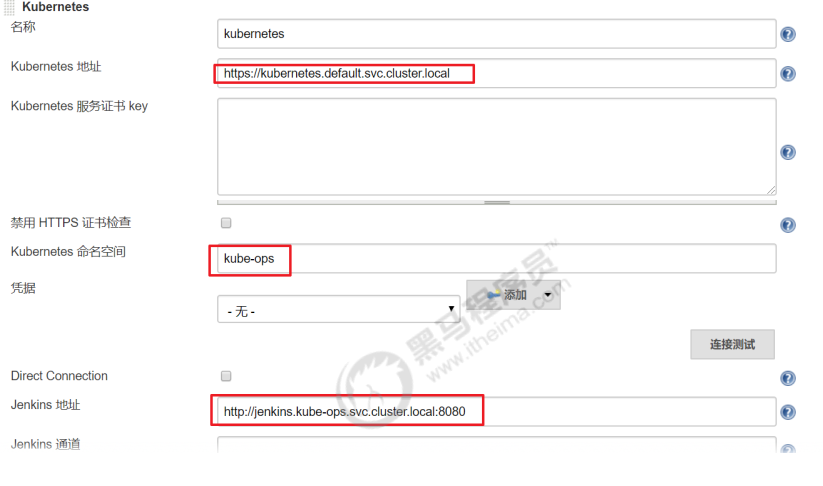

- kubernetes地址采用了kube的服务器发现:https://kubernetes.default.svc.cluster.local

- namespace填kube-ops,然后点击Test Connection,如果出现 Connection test successful 的提示信息证明 Jenkins 已经可以和 Kubernetes 系统正常通信

- Jenkins URL 地址:http://jenkins.kube-ops.svc.cluster.local:8080

7.4 构建Jenkins-Slave自定义镜像

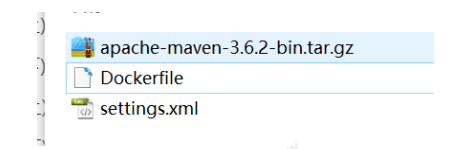

Jenkins-Master在构建Job的时候,Kubernetes会创建Jenkins-Slave的Pod来完成Job的构建。我们选择运行Jenkins-Slave的镜像为官方推荐镜像:jenkins/jnlp-slave:latest,但是这个镜像里面并没有Maven环境,为了方便使用,我们需要自定义一个新的镜像:

准备材料:

Dockerfile文件内容如下:

FROM jenkins/jnlp-slave:latest

MAINTAINER itcast

# 切换到 root 账户进行操作

USER root

# 安装 maven

COPY apache-maven-3.6.2-bin.tar.gz .

RUN tar -zxf apache-maven-3.6.2-bin.tar.gz && \

mv apache-maven-3.6.2 /usr/local && \

rm -f apache-maven-3.6.2-bin.tar.gz && \

ln -s /usr/local/apache-maven-3.6.2/bin/mvn /usr/bin/mvn && \构建出一个新镜像:jenkins-slave-maven:latest

ln -s /usr/local/apache-maven-3.6.2 /usr/local/apache-maven && \

mkdir -p /usr/local/apache-maven/repo

COPY settings.xml /usr/local/apache-maven/conf/settings.xml

USER jenkins

构建出一个新镜像:jenkins-slave-maven:latest

然把镜像上传到Harbor的公共库library中

docker tag jenkins-slave-maven:latest 192.168.66.102:85/library/jenkins-slavemaven:latest

docker push 192.168.66.102:85/library/jenkins-slave-maven:latest

7.5 测试Jenkins-Slave是否可以创建

-

创建一个Jenkins流水线项目

-

编写Pipeline,从GItlab拉取代码

def git_address = "http://192.168.66.100:82/itheima_group/tensquare_back_cluster.git" def git_auth = "9d9a2707-eab7-4dc9-b106-e52f329cbc95" //创建一个Pod的模板,label为jenkins-slave podTemplate(label: 'jenkins-slave', cloud: 'kubernetes', containers:[containerTemplate(name: 'jnlp', image:"192.168.66.102:85/library/jenkins-slave-maven:latest")]) { //引用jenkins-slave的pod模块来构建Jenkins-Slave的pod node("jenkins-slave"){ // 第一步 stage('拉取代码'){ checkout([$class: 'GitSCM', branches: [[name: 'master']], userRemoteConfigs: [[credentialsId: "${git_auth}", url: "${git_address}"]]]) } } } -

查看构建日志

7.6 Jenkins+Kubernetes+Docker完成微服务持续集成

7.6.1 拉取代码,构建镜像

-

创建NFS共享目录

让所有Jenkins-Slave构建指向NFS的Maven的共享仓库目录

vi /etc/exports #添加内容: /opt/nfs/jenkins *(rw,no_root_squash) /opt/nfs/maven *(rw,no_root_squash) systemctl restart nfs #重启NFS -

创建项目,编写构建Pipeline

def git_address = "http://192.168.66.100:82/itheima_group/tensquare_back_cluster.git" def git_auth = "9d9a2707-eab7-4dc9-b106-e52f329cbc95" //构建版本的名称 def tag = "latest" //Harbor私服地址 def harbor_url = "192.168.66.102:85" //Harbor的项目名称 def harbor_project_name = "tensquare" //Harbor的凭证 def harbor_auth = "71eff071-ec17-4219-bae1-5d0093e3d060" podTemplate(label: 'jenkins-slave', cloud: 'kubernetes', containers: [containerTemplate( name: 'jnlp', image: "192.168.66.102:85/library/jenkins-slave-maven:latest"), containerTemplate(name: 'docker', image: "docker:stable", ttyEnabled: true, command: 'cat'),],volumes: [ hostPathVolume(mountPath: '/var/run/docker.sock', hostPath: '/var/run/docker.sock'), nfsVolume(mountPath: '/usr/local/apache-maven/repo', serverAddress: '192.168.66.101' , serverPath: '/opt/nfs/maven'),]) { node("jenkins-slave"){ // 第一步 stage('拉取代码'){ checkout([$class: 'GitSCM', branches: [[name: '${branch}']], userRemoteConfigs: [[credentialsId: "${git_auth}", url: "${git_address}"]]]) } // 第二步 stage('代码编译'){ //编译并安装公共工程 sh "mvn -f tensquare_common clean install" } // 第三步 stage('构建镜像,部署项目'){ //把选择的项目信息转为数组 def selectedProjects = "${project_name}".split(',') for(int i=0;i<selectedProjects.size();i++){ //取出每个项目的名称和端口 def currentProject = selectedProjects[i]; //项目名称 def currentProjectName = currentProject.split('@')[0] //项目启动端口 def currentProjectPort = currentProject.split('@')[1] //定义镜像名称注意:在构建过程会发现无法创建仓库目录,是因为NFS共享目录权限不足,需更改权限 def imageName = "${currentProjectName}:${tag}" //编译,构建本地镜像 sh "mvn -f ${currentProjectName} clean package dockerfile:build" container('docker') { //给镜像打标签 sh "docker tag ${imageName} ${harbor_url}/${harbor_project_name}/${imageName}" //登录Harbor,并上传镜像 withCredentials([usernamePassword(credentialsId: "${harbor_auth}", passwordVariable: 'password', usernameVariable: 'username')]) { //登录 sh "docker login -u ${username} -p ${password} ${harbor_url}" //上传镜像 sh "docker push ${harbor_url}/${harbor_project_name}/${imageName}" } //删除本地镜像 sh "docker rmi -f ${imageName}" sh "docker rmi -f ${harbor_url}/${harbor_project_name}/${imageName}" } } } }注意:在构建过程会发现无法创建仓库目录,是因为NFS共享目录权限不足,需更改权限

chown -R jenkins:jenkins /opt/nfs/maven chmod -R 777 /opt/nfs/maven还有Docker命令执行权限问题

chmod 777 /var/run/docker.sock需要手动上传父工程依赖到NFS的Maven共享仓库目录中

7.6.2 微服务部署到K8S

修改每个微服务的application.yml

-

Eureka

server: port: ${PORT:10086} spring: application: name: eureka eureka: server: # 续期时间,即扫描失效服务的间隔时间(缺省为60*1000ms) eviction-interval-timer-in-ms: 5000 enable-self-preservation: false use-read-only-response-cache: false client: # eureka client间隔多久去拉取服务注册信息 默认30s registry-fetch-interval-seconds: 5 serviceUrl: defaultZone: ${EUREKA_SERVER:http://127.0.0.1:${server.port}/eureka/} instance: # 心跳间隔时间,即发送一次心跳之后,多久在发起下一次(缺省为30s) lease-renewal-interval-in-seconds: 5 # 在收到一次心跳之后,等待下一次心跳的空档时间,大于心跳间隔即可,即服务续约到期时间(缺省为90s) lease-expiration-duration-in-seconds: 10 instance-id: ${EUREKA_INSTANCE_HOSTNAME:${spring.application.name}}:${server.port}@${random.long(1000000,9999999)} hostname: ${EUREKA_INSTANCE_HOSTNAME:${spring.application.name}} -

其他微服务需要注册到所有Eureka中

# Eureka配置 eureka: client: serviceUrl: defaultZone: http://eureka-0.eureka:10086/eureka/,http://eureka-1.eureka:10086/eureka/ # Eureka访问地址 instance: preferIpAddress: true-

安装Kubernetes Continuous Deploy插件

-

修改后的流水线脚本

def deploy_image_name = "${harbor_url}/${harbor_project_name}/${imageName}" //部署到K8S sh """ sed -i 's#\$IMAGE_NAME#${deploy_image_name}#' ${currentProjectName}/deploy.yml sed -i 's#\$SECRET_NAME#${secret_name}#' ${currentProjectName}/deploy.yml """ kubernetesDeploy configs: "${currentProjectName}/deploy.yml", kubeconfigId: "${k8s_auth}" -

建立k8s认证凭证

-

kubeconfig到k8s的Master节点复制

cat /root/.kube/config -

生成Docker凭证

Docker凭证,用于Kubernetes到Docker私服拉取镜像

docker login -u itcast -p Itcast123 192.168.66.102:85 #登录Harbor kubectl create secret docker-registry registry-auth-secret --dockerserver=192.168.66.102:85 --docker-username=itcast --docker-password=Itcast123 --docker-email=itcast@itcast.cn #生成 kubectl get secret #查看密钥 -

在每个项目下建立deploy.xml

Eureka的deply.yml

--- apiVersion: v1 kind: Service metadata: name: eureka labels: app: eureka spec: type: NodePort ports: - port: 10086 name: eureka targetPort: 10086 selector: app: eureka --- apiVersion: apps/v1 kind: StatefulSet metadata: name: eureka spec: serviceName: "eureka" replicas: 2 selector: matchLabels: app: eureka template: metadata: labels: app: eureka spec: imagePullSecrets: - name: $SECRET_NAME containers: - name: eureka image: $IMAGE_NAME ports: - containerPort: 10086 env: - name: MY_POD_NAME valueFrom: fieldRef: fieldPath: metadata.name - name: EUREKA_SERVER value: "http://eureka-0.eureka:10086/eureka/,http://eureka-1.eureka:10086/eureka/" - name: EUREKA_INSTANCE_HOSTNAME value: ${MY_POD_NAME}.eureka podManagementPolicy: "Parallel"其他项目的deploy.yml主要把名字和端口修改:

--- apiVersion: v1 kind: Service name: zuul labels: app: zuul spec: type: NodePort ports: - port: 10020 name: zuul targetPort: 10020 selector: app: zuul --- apiVersion: apps/v1 kind: StatefulSet metadata: name: zuul spec: serviceName: "zuul" replicas: 2 selector: matchLabels: app: zuul template: metadata: labels: app: zuul spec: imagePullSecrets: - name: $SECRET_NAME containers: - name: zuul image: $IMAGE_NAME ports: - containerPort: 10020 podManagementPolicy: "Parallel" -

项目构建后,查看服务创建情况

kubectl get pods -owide kubectl get service效果如下:

-

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)