Milvus_local_RAG,笔记本也能跑的本地知识库&RAG来了,大模型入门到精通,收藏这篇就足够了!

多数前端开发工程师可能都面临这样一个困境:每天需要查阅大量技术文档、项目规范和学习资料。传统的文件夹分类和搜索方式效率低下,经常为了找一个API用法翻遍整个项目文档。

多数前端开发工程师可能都面临这样一个困境:每天需要查阅大量技术文档、项目规范和学习资料。传统的文件夹分类和搜索方式效率低下,经常为了找一个API用法翻遍整个项目文档。

一些大公司,可能会采用企业级知识库方案,通过智能问答来解决这个问题。但问题是:

1、不是所有公司都有这个预算

2、个人部署一套企业级知识库,环境配置复杂、学习门槛高,对新手极不友好

3、使用企业级知识库的平替,在线服务又会出现数据隐私泄露风险。

当然,以上问题不止是前端会遇到,所有有复杂文档管理、检索需求的朋友,其实都会遇到。

那怎么解决?这篇“milvus_local_rag”指南正是为你准备的。

这个轻量级RAG方案,用一台普通笔记本就能搭建起个人知识库,查询响应时间,也可以从几分钟缩短到几秒钟。

(备注:本项目是基于Shubham Saboo作者开源的awesome-llm-apps项目二次开发完成的。)

01

核心概念解释

在开始之前,让我们先了解几个关键概念,这样后续的操作会更加清晰:

**RAG(检索增强生成):**简单来说,就是让AI在回答问题时,先从你的文档库中找到相关信息,再基于这些信息给出答案。就像考试时可以"翻书"一样,让AI的回答更准确、更有依据。

**向量数据库:**把文档转换成数字形式存储的"智能仓库"。它能理解文档的含义,当你提问时,能快速找到最相关的内容片段。

**嵌入模型:**负责把文字转换成数字的"翻译官"。它能理解文字的语义,让计算机也能"读懂"文档内容。

02

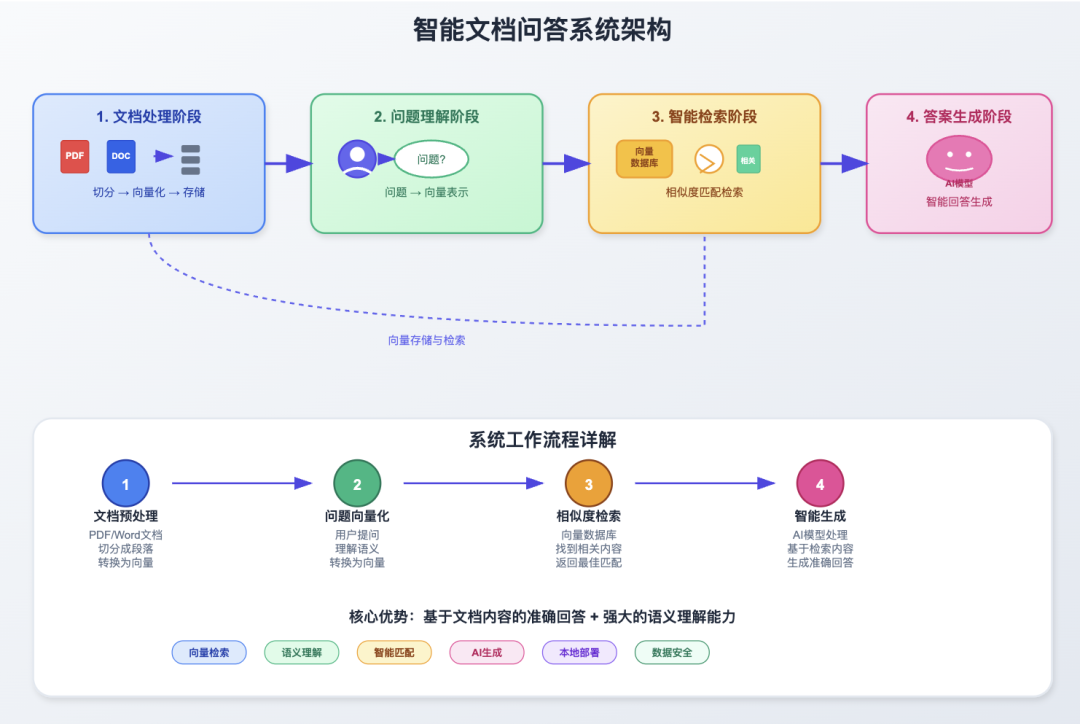

RAG工作原理:从文档到智能问答的完整流程

了解了基本概念后,让我们看看整个系统是如何工作的:

这个流程确保了AI的回答既基于你的文档内容,又具备良好的理解能力。

03

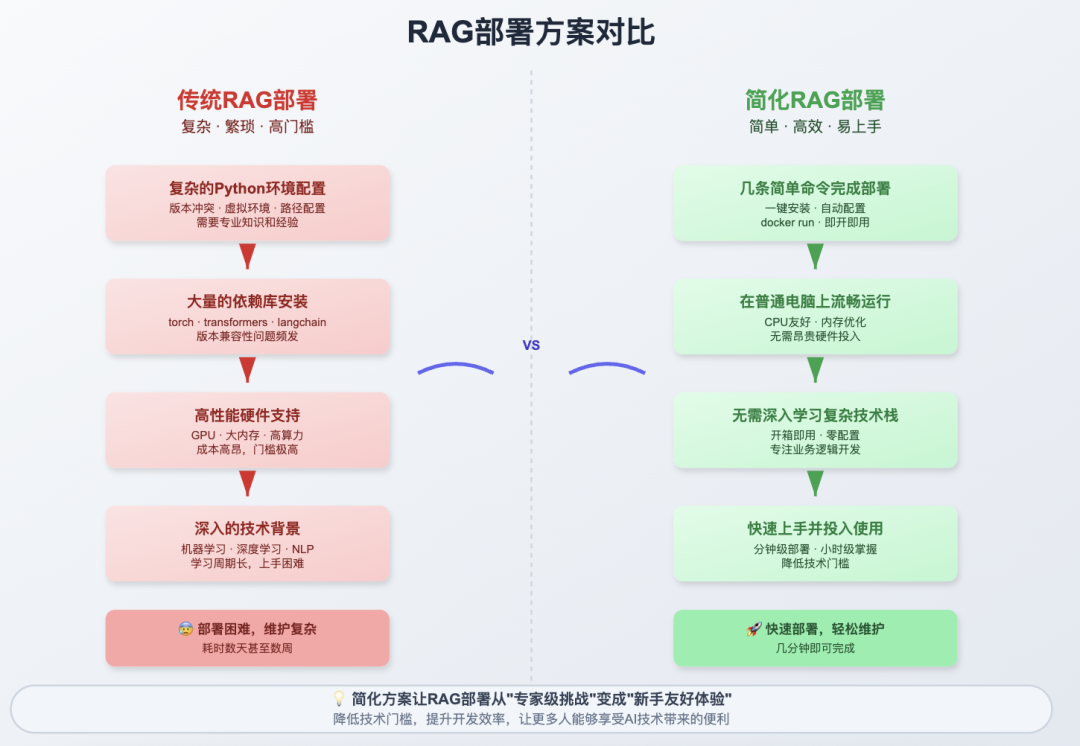

为什么选择轻量级方案?

这是一个专为个人用户设计的轻量级RAG项目,核心思路是用最少的依赖实现最完整的功能。本文作者对awesome-llm-apps项目源代码进行了调整,整个系统只需要Ollama和Qdrant两个组件,一条命令就能启动完整的本地知识库。

核心特点:

- 真正的本地化:支持Qwen、Gemma等多种本地模型,数据完全不出本地

- 极简部署:无需复杂环境配置,Docker一键启动向量数据库

- 智能检索:文档相似度搜索+网络搜索双重保障,确保答案质量

- 灵活切换:可在纯RAG模式和直接对话模式间自由切换

实际价值:让你用最小的成本获得企业级RAG能力,适合处理个人文档、学习资料或项目知识库,既保护隐私又提供智能问答体验。

04

实践部署

(1)环境准备要求

本教程不含Python3、Conda以及Ollama安装展示,请自行按照官方手册进行配置。

相关官网链接:

- Python3官网:https://www.python.org/

- Conda官网:https://www.anaconda.com/

- Milvus官网:https://milvus.io/docs/prerequisite-docker.md

- Ollama官网:https://ollama.com

- Docker官网:https://www.docker.com/

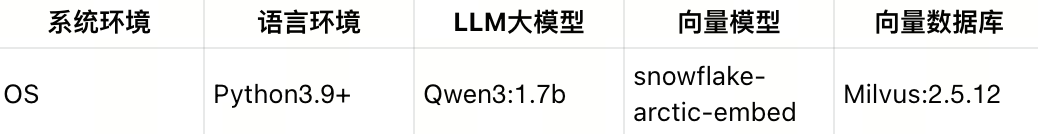

(2)系统环境配置表

(3)Milvus向量数据库部署

Milvus简介

Milvus是由Zilliz开发的全球首款开源向量数据库产品,能够处理数百万乃至数十亿级的向量数据,在Github获得3万+star数量。基于开源Milvus,Zilliz还构建了商业化向量数据库产品Zilliz Cloud,这是一款全托管的向量数据库服务,通过采用云原生设计理念,在易用性、成本效益和安全性上实现了全面提升。

部署环境要求

必要条件:

- 软件要求:docker、docker-compose

- CPU:8核

- 内存:至少16GB

- 硬盘:至少100GB

下载部署文件

wget https://github.com/milvus-io/milvus/releases/download/v2.5.12/milvus-standalone-docker-compose.yml -O docker-compose.yml

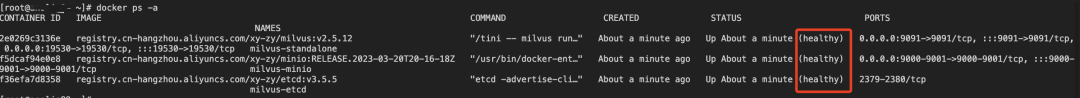

启动Milvus服务

docker-compose up -d

docker-compose ps -a

(4) 模型下载与配置

下载大语言模型

# 下载Qwen3模型

ollama pu

ll qwen3:1.7b

下载嵌入模型

# 下载embedding模型

ollama pull snowflake-arctic-embed

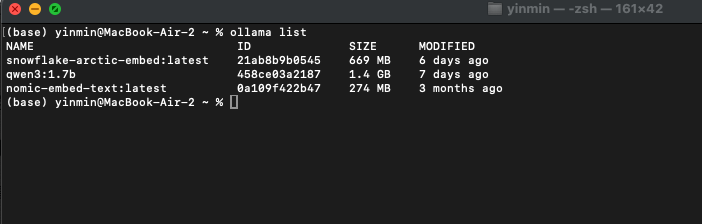

验证模型安装

# 查看已安装模型列表

ollama list

(5)Python环境配置

创建虚拟环境

# 创建conda虚拟环境

conda create -n milvus

# 激活虚拟环境

conda activate milvus

# 克隆项目代码

git clone https://github.com/yinmin2020/milvus_local_rag.git

依赖包安装

# 安装项目依赖

pip3 install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple/

参数配置说明

关键配置参数:

COLLECTION_NAME:自定义集合名称(必须配置)

"uri": "tcp://192.168.7.147:19530":Milvus连接地址(必须修改为实际地址)

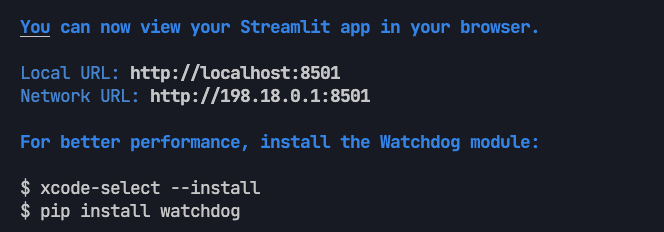

# 启动Streamlit应用

streamlit run release.py

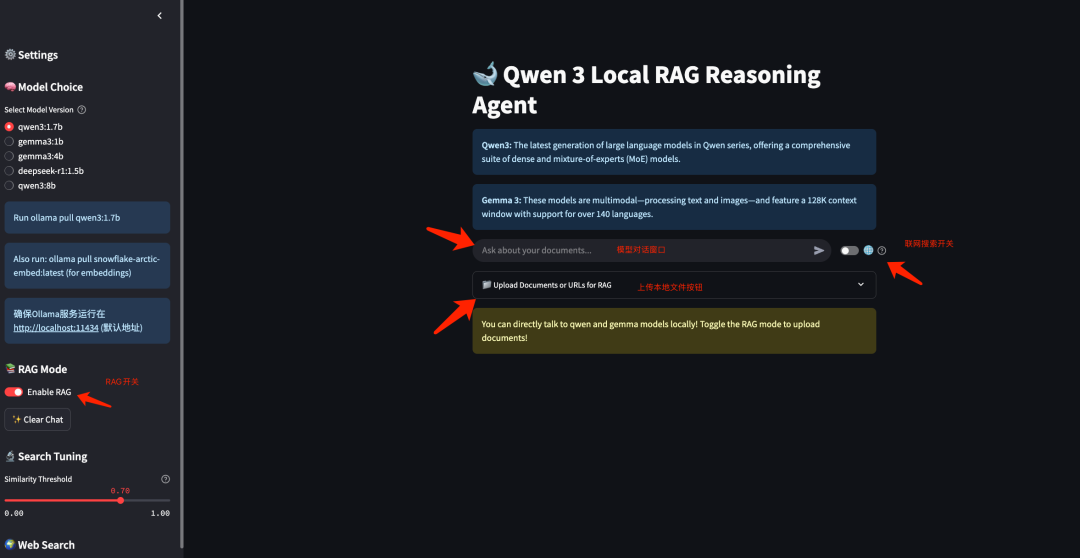

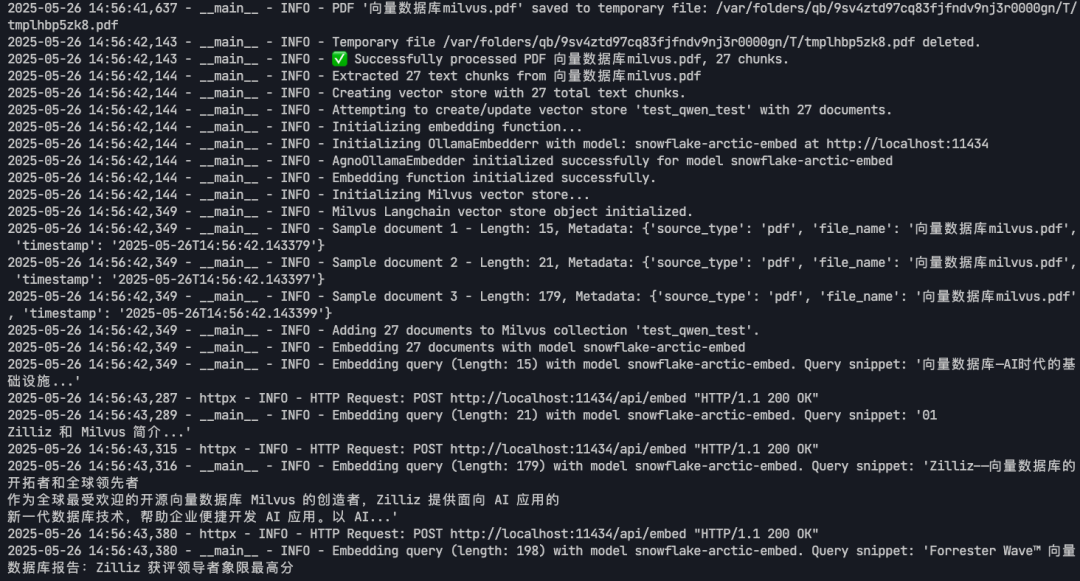

(7)功能测试与验证

访问应用界面

应用启动后会自动跳转到Web界面,通常地址

http://localhost:8501

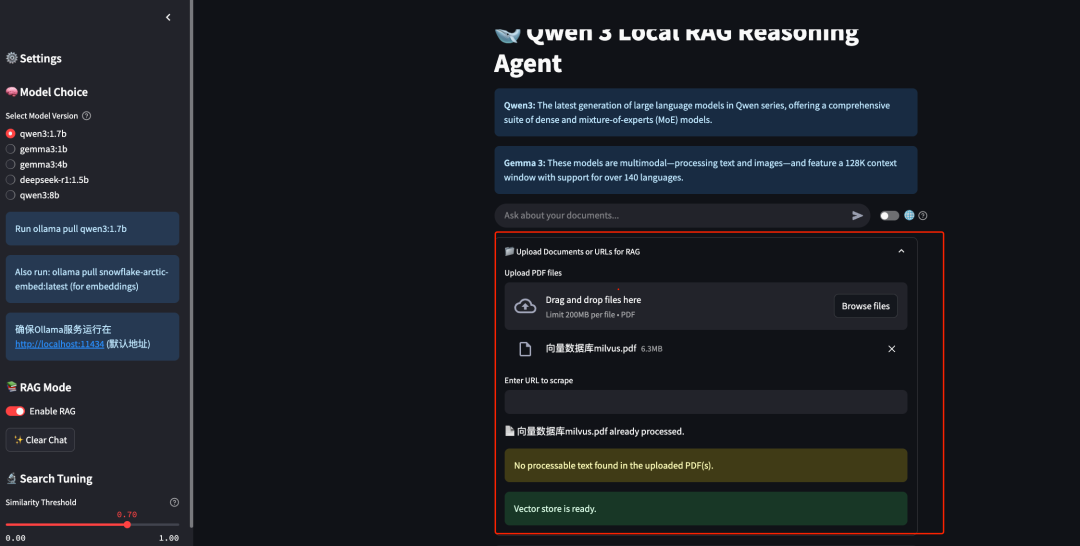

文档上传测试

- 在Web界面中选择文档上传功能

- 上传测试PDF文档(建议使用Milvus相关介绍文档)

- 等待文档处理完成

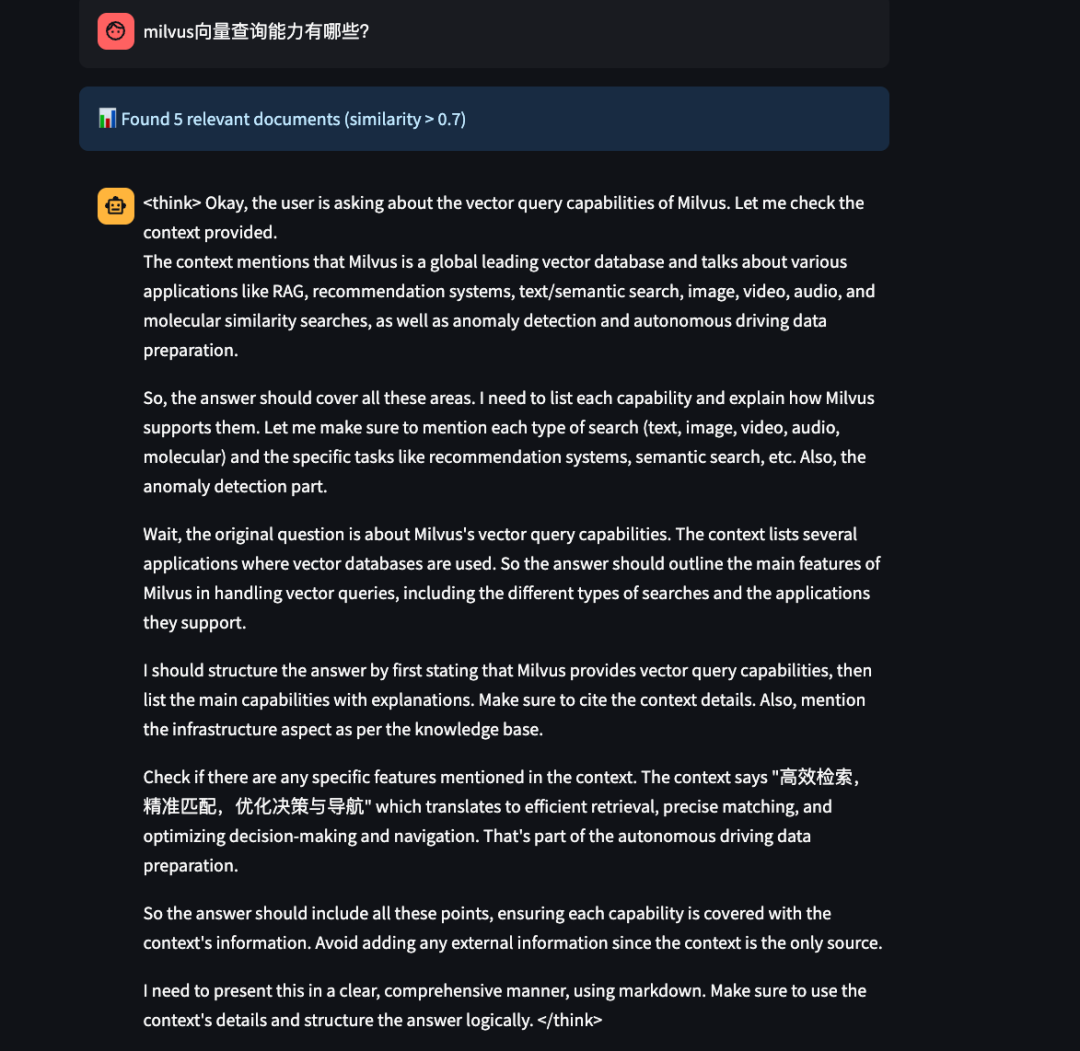

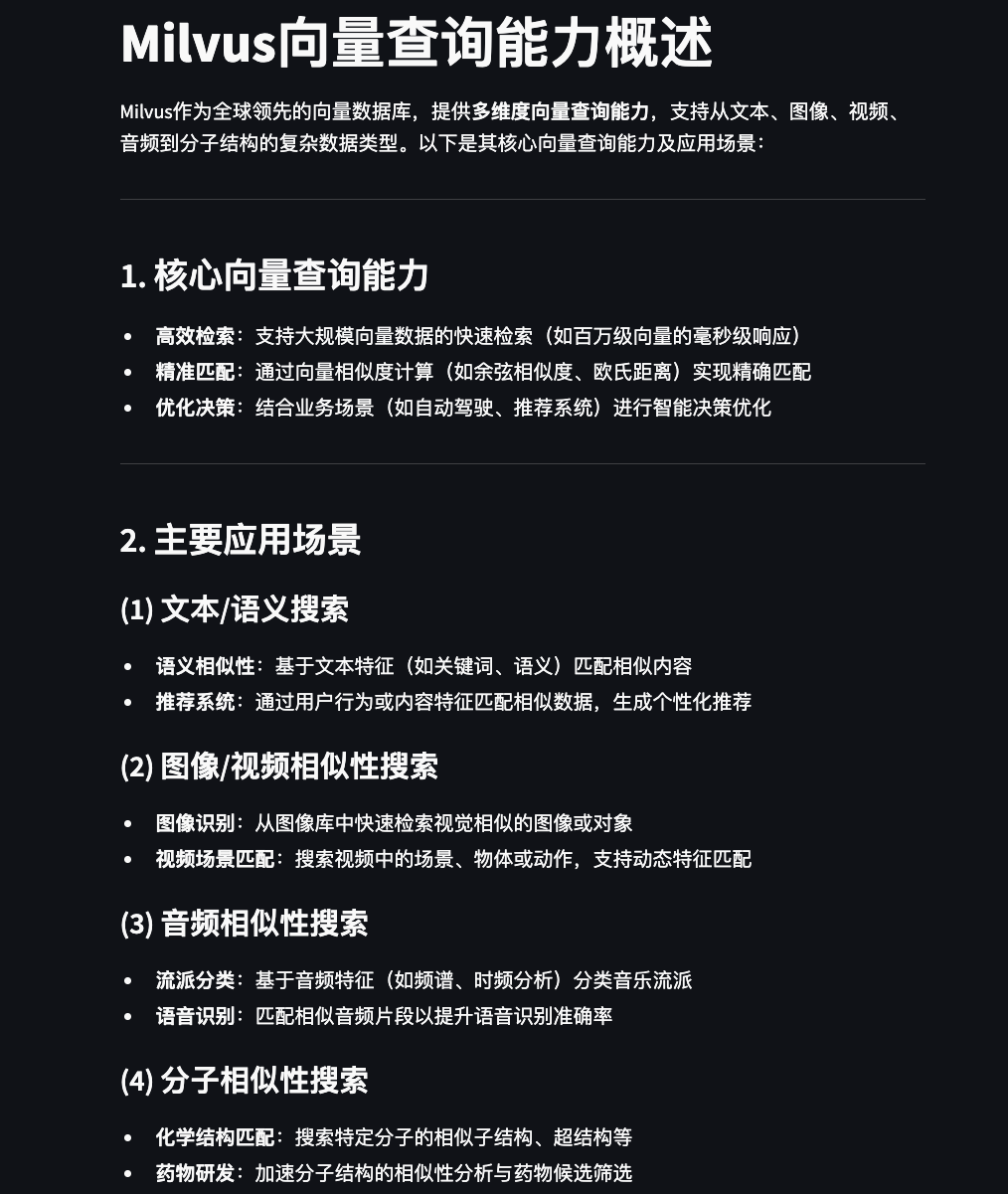

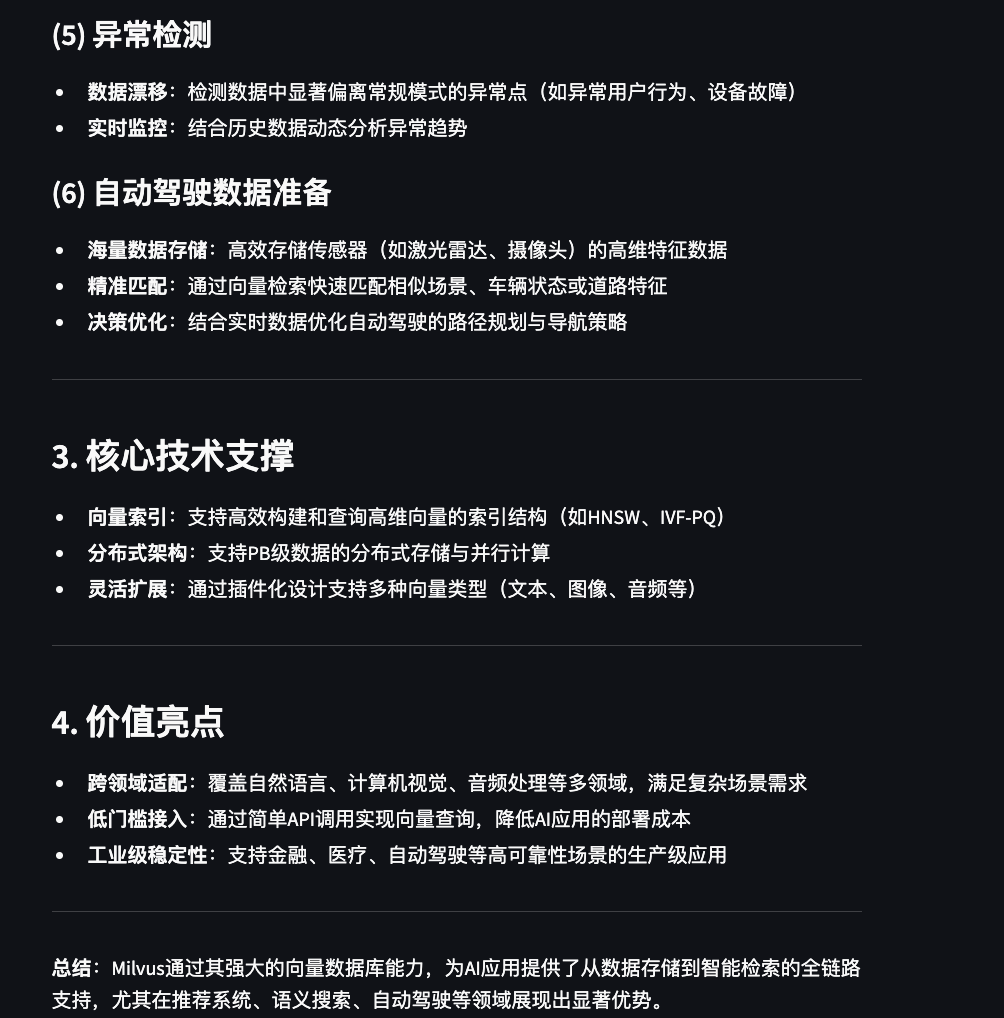

RAG功能验证

测试查询示例:

milvus向量查询能力有哪些?

通过此查询可以验证:

- 向量数据库检索功能

- RAG(检索增强生成)能力

- 问答系统的准确性

05

写在最后

回望文章开头提到的那些令人望而却步的部署障碍:做RAG为什么要让简单的事情变得复杂?

其实,企业级知识库流行的同时,轻量级RAG也逐渐成为了个人侧的主流趋势。

轻量级RAG最大的价值在于各种成本低,能解决的问题很实在。几行代码就能让文档"活"起来,能问能答,而且简单好用,是很多中小企业或者个人用户入门RAG的第一步。

我们该怎样系统的去转行学习大模型 ?

很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习门槛,降到了最低!

在这个版本当中:

第一您不需要具备任何算法和数学的基础第二不要求准备高配置的电脑第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型教程已经给大家整理并打包分享出来, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的

核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调;并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)