智能光学计算成像技术与应用

智能光学计算成像技术结合光学系统设计、计算成像算法和人工智能(AI),通过优化光场信息采集与处理,突破传统成像在分辨率、视场、景深等方面的限制。该技术广泛应用于医学影像、遥感探测、自动驾驶等领域。

智能光学计算成像技术概述

智能光学计算成像技术结合光学系统设计、计算成像算法和人工智能(AI),通过优化光场信息采集与处理,突破传统成像在分辨率、视场、景深等方面的限制。该技术广泛应用于医学影像、遥感探测、自动驾驶等领域。

核心技术方法

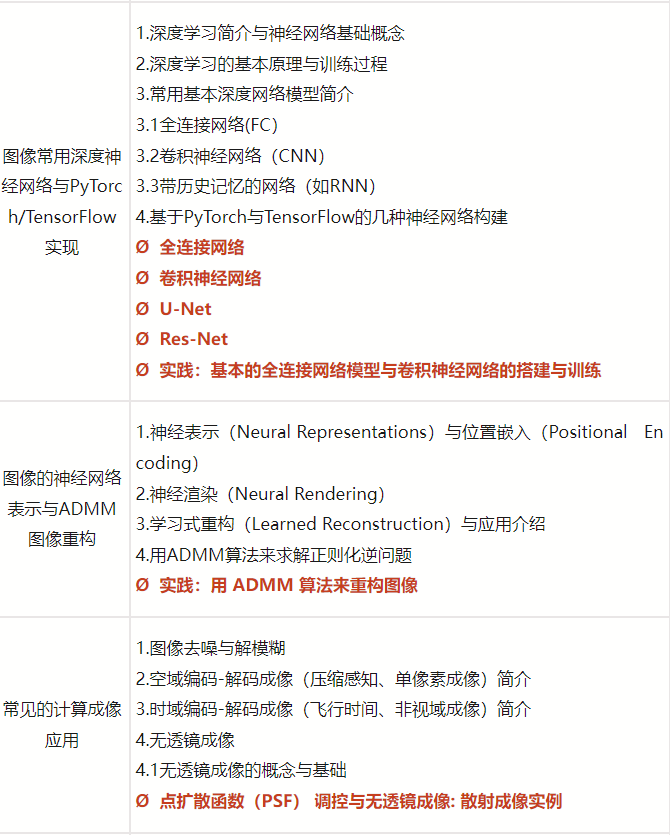

光场调制与编码

通过编码孔径、相位掩模等光学元件调制光场,结合压缩感知理论重建高维信息。例如,单像素相机利用DMD(数字微镜器件)实现稀疏采样,大幅降低数据量。

深度学习重建算法

采用卷积神经网络(CNN)或Transformer架构,从低质量原始数据中恢复高分辨率图像。典型模型如U-Net、DIP(深度图像先验)被用于解决病态逆问题。

联合优化设计

端到端优化光学硬件与算法,例如可微分光学模型(Diffractive Optical Elements)与神经网络协同训练,提升系统鲁棒性。

典型应用场景

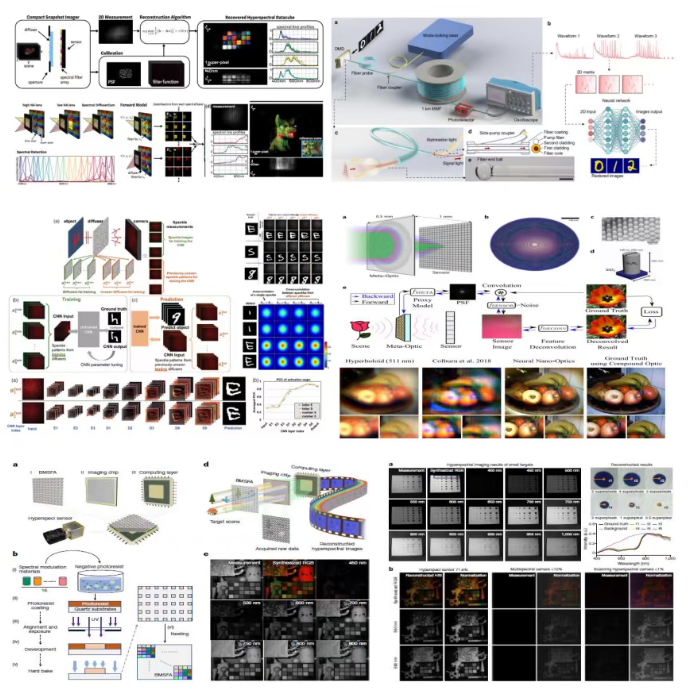

医学内窥镜成像

基于光纤束的微型化计算成像系统,结合AI实时去噪与超分辨,显著提升早期癌症诊断精度。

自动驾驶感知

利用事件相机(Event Camera)的高动态范围特性,通过脉冲神经网络处理异步数据流,增强极端光照条件下的目标检测能力。

遥感与天文观测

通过多光谱计算成像重建大气扰动下的清晰图像,如NASA的James Webb望远镜采用相位检索算法校正镜面误差。

关键技术挑战

实时性瓶颈

复杂算法(如逆问题求解)需硬件加速,FPGA或光子芯片成为研究热点。

数据依赖性强

深度学习模型依赖大量标注数据,自监督学习与小样本方法是当前突破方向。

标准化缺失

光学-计算联合系统的评价指标尚未统一,需建立跨学科协作框架。

代码示例:基于PyTorch的光场重建

import torch

import torch.nn as nn

class ReconstructionNet(nn.Module):

def __init__(self):

super().__init__()

self.encoder = nn.Sequential(

nn.Conv2d(1, 64, kernel_size=3, padding=1),

nn.ReLU(),

nn.MaxPool2d(2)

)

self.decoder = nn.Sequential(

nn.ConvTranspose2d(64, 1, kernel_size=3, stride=2, padding=1, output_padding=1),

nn.Sigmoid()

)

def forward(self, x):

x = self.encoder(x)

return self.decoder(x)

数学建模示例

成像过程可表述为线性逆问题:

y=Ax+ϵ y = Ax + \epsilon y=Ax+ϵ

其中 yyy 为观测数据,AAA 为测量矩阵,xxx 为目标图像,ϵ\epsilonϵ 为噪声。通过优化目标函数求解:

x^=argminx∥y−Ax∥22+λR(x) \hat{x} = \arg\min_x \|y - Ax\|_2^2 + \lambda R(x) x^=argxmin∥y−Ax∥22+λR(x)

R(x)R(x)R(x) 为正则化项(如TV范数),λ\lambdaλ 为权衡参数。

未来发展趋势

- 光子神经网络:利用光学衍射实现超低功耗矩阵运算

- 量子计算成像:量子纠缠增强的成像灵敏度

- 元宇宙交互:轻量化计算成像设备推动AR/VR体验升级

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)