大模型 VS Agent I 核心差异+合规落地

其以大模型为 “大脑”,叠加环境感知、任务规划、工具调用能力,可自主判断需求、调用资源、执行动作。不管是大模型还是Agent,要想真正落地应用、实现商业价值,首要条件就是守住法律红线,实现合规落地。,核心价值在于理解与生成自然语言,需依赖用户输入(Prompt)触发响应,无法主动感知环境或发起任务。○ 工具白名单与漏洞扫描:仅允许调用经过安全验证的工具,并定期扫描第三方 API 漏洞。人工智能技术

附完整原文阅读:

引言

人工智能技术飞速发展的今天,在从“智能感知”向“认知智能”跃迁的过程中,大模型与智能体(Agent)始终是两个被频繁提及却极易混淆的核心概念。

今天这篇文章将从两者的核心差异、发展趋势、落地合规几大维度,系统地拆解两者的本质内容与协同逻辑。

一、核心差异

1、本质定位

大模型:通常是指“预训练语言认知工具”,核心价值在于理解与生成自然语言,需依赖用户输入(Prompt)触发响应,无法主动感知环境或发起任务。

(图源 infoQ研究中心:大模型研究报告,侵权删)

Agent(智能体):本质是 “目标驱动的自主体”,核心价值在于闭环完成任务。其以大模型为 “大脑”,叠加环境感知、任务规划、工具调用能力,可自主判断需求、调用资源、执行动作。

Agent:OpenAI的组成结构

2、核心能力

| 能力维度 | 大模型 | Agent |

| 核心能力 | 文本生成、翻译、问答、情感分析 | 环境感知、任务规划、工具调用、结果反馈 |

| 决策逻辑 | 基于触发被动响应,无自主决策 | 基于目标拆解子任务,动态调整执行策略 |

| 外部交互 | 依赖插件实现有限交互(如搜索) | 原生支持 API 调用、设备控制、多系统协同 |

| 典型应用 | 内容创作、文本生成、智能客服 | 机器人、虚拟助手、智能家居 |

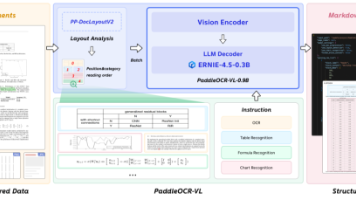

3、技术化架构

大模型架构:核心是 “预训练 - 微调 -Transformer架构- 推理”

Agent 架构:核心是 “感知 - 决策 - 执行 - 记忆” 的模块闭环。

二、发展趋势

1、大模型

中国大模型目前市场竞争梯队:

未来发展趋势:

从通用能力到场景适配的深化,更加转向能力精细化与服务轻量化。

2、Agent

Agent 的发展核心是 “解决落地痛点”(如成本高、可控性差),并向 “更复杂场景” 延伸。大型基础模型的发展,给Agent也带来了新的发展和挑战。

三、合规落地

不管是大模型还是Agent,要想真正落地应用、实现商业价值,首要条件就是守住法律红线,实现合规落地。而合规落地的第一步就是完成算法备案和大模型备案。

针对算法备案和大模型备案的具体流程我们已经在过往文章中拆析过,点击链接查看文章内容:

在这里我们就大模型和Agent在备案中的不同难点来做一个简单的介绍。

1、大模型:聚焦生成质量管控

① 风险1:知识幻觉

➢ 表现:大模型因预训练知识过时或推理错误,生成与事实不符的内容

➢ 应对措施:

○ 采用检索增强生成(RAG)等技术,链接实时知识库,减少幻觉。

○ 通过提示工程和上下文学习,引导模型生成更可靠的暑促

② 风险2:内容安全

➢ 表现:生成不符合价值观、恶意引导的内容

➢ 应对措施:多层内容审核:实时拦截违规输出.

③风险3:数据泄露

➢ 表现:大模型泄露训练数据中的用户隐私

➢ 应对措施:

○ 数据脱敏:预训练阶段剔除敏感数据。

○ 输出脱敏:对生成结果中的敏感信息自动替换。

(敏感个人信息界定)

2、Agent:聚焦执行过程管控

Agent的核心风险是“执行端自主权限滥用”,需要全流程防控。

① 风险1:权限滥用

➢ 表现:因为权限设计不当,执行超出范围的操作。

➢ 应对措施:

○ 最小权限:为每个 Agent 分配独立凭证,仅开放必要权限

○ 反问确认:对关键操作的参数进行合法性校验,必要时向用户确认

② 风险 2:供应链攻击(第三方工具漏洞)

➢ 表现:Agent 调用的第三方工具存在漏洞,导致攻击渗透。

➢ 应对措施:

○ 工具白名单与漏洞扫描:仅允许调用经过安全验证的工具,并定期扫描第三方 API 漏洞。

○ 攻击链追踪:记录 Agent 的工具调用链路,便于事后溯源。

AIGC一手服务商,已帮助300+企业成功备案

END

严正声明:

文章版权归©通晓集团所有,如需转载请联系小编

未经允许禁止搬运、引用、抄袭等

否则将视为侵权,我司依法保留追究权

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)