基于强化学习的动态多智能体协同推理框架

随着科技的不断进步,多智能体系统在诸如自动驾驶、智能交通管理、物流配送、机器人协作等众多领域得到了广泛应用。在这些实际应用场景中,环境往往是动态变化的,单个智能体的能力和信息获取范围有限,难以独立完成复杂的任务。基于强化学习的动态多智能体协同推理框架的目的在于解决多智能体在动态环境下的协同决策和推理问题,通过智能体之间的协作,充分利用各自的信息和能力,提高系统整体的性能和效率。

基于强化学习的动态多智能体协同推理框架

关键词:强化学习、动态多智能体、协同推理框架、智能体交互、决策优化

摘要:本文深入探讨了基于强化学习的动态多智能体协同推理框架。随着人工智能技术的发展,多智能体系统在众多领域展现出巨大应用潜力。动态多智能体协同推理框架旨在让多个智能体在动态环境中通过协同合作进行高效推理和决策。文章首先介绍了该框架的背景,包括目的、预期读者等内容。接着详细阐述核心概念与联系,给出原理和架构的文本示意图及 Mermaid 流程图。深入讲解核心算法原理,用 Python 代码进行详细示例。分析数学模型和公式,并举例说明。通过项目实战展示代码实际案例及详细解释。探讨实际应用场景,推荐相关工具和资源。最后总结未来发展趋势与挑战,解答常见问题并提供扩展阅读和参考资料。

1. 背景介绍

1.1 目的和范围

随着科技的不断进步,多智能体系统在诸如自动驾驶、智能交通管理、物流配送、机器人协作等众多领域得到了广泛应用。在这些实际应用场景中,环境往往是动态变化的,单个智能体的能力和信息获取范围有限,难以独立完成复杂的任务。基于强化学习的动态多智能体协同推理框架的目的在于解决多智能体在动态环境下的协同决策和推理问题,通过智能体之间的协作,充分利用各自的信息和能力,提高系统整体的性能和效率。

本框架的范围涵盖了多智能体系统的建模、智能体之间的通信与交互机制、强化学习算法在多智能体协同中的应用、协同推理的实现以及系统性能的评估等方面。旨在为多智能体系统的设计和开发提供一个通用的、可扩展的框架,以适应不同的应用场景和需求。

1.2 预期读者

本文的预期读者主要包括以下几类人群:

- 科研人员:对多智能体系统、强化学习等领域的研究感兴趣,希望深入了解动态多智能体协同推理的原理和方法,为进一步的研究提供理论和技术支持。

- 工程师和开发者:在实际项目中需要开发多智能体系统的专业人员,如自动驾驶工程师、机器人开发者等。他们可以借鉴本框架的设计思想和实现方法,解决实际应用中的协同决策和推理问题。

- 学生:计算机科学、人工智能等相关专业的学生,通过阅读本文可以加深对多智能体系统和强化学习的理解,拓宽知识面,为今后的学习和研究打下基础。

1.3 文档结构概述

本文将按照以下结构进行组织:

- 核心概念与联系:介绍动态多智能体协同推理框架的核心概念,包括智能体、环境、协同推理等,并阐述它们之间的联系。给出核心概念原理和架构的文本示意图及 Mermaid 流程图,帮助读者直观地理解框架的整体结构。

- 核心算法原理 & 具体操作步骤:详细讲解强化学习算法在动态多智能体协同推理中的应用原理,包括策略梯度算法、Q - learning 算法等。使用 Python 源代码进行详细示例,展示算法的具体实现步骤。

- 数学模型和公式 & 详细讲解 & 举例说明:建立动态多智能体协同推理的数学模型,给出相关的公式,并对公式进行详细讲解。通过具体的例子说明数学模型在实际问题中的应用。

- 项目实战:代码实际案例和详细解释说明:通过一个具体的项目实战,展示基于强化学习的动态多智能体协同推理框架的实际应用。包括开发环境的搭建、源代码的详细实现和代码解读,帮助读者更好地理解和掌握框架的使用方法。

- 实际应用场景:探讨动态多智能体协同推理框架在不同领域的实际应用场景,如自动驾驶、智能交通管理、物流配送等,分析框架在这些场景中的优势和挑战。

- 工具和资源推荐:推荐相关的学习资源、开发工具框架和论文著作,帮助读者进一步深入学习和研究动态多智能体协同推理框架。

- 总结:未来发展趋势与挑战:总结本文的主要内容,分析动态多智能体协同推理框架的未来发展趋势和面临的挑战。

- 附录:常见问题与解答:解答读者在学习和使用动态多智能体协同推理框架过程中可能遇到的常见问题。

- 扩展阅读 & 参考资料:提供相关的扩展阅读材料和参考资料,方便读者进一步深入研究。

1.4 术语表

1.4.1 核心术语定义

- 智能体(Agent):具有自主决策和行动能力的实体,可以感知环境信息,并根据一定的策略做出决策和采取行动。在多智能体系统中,智能体之间可以进行通信和协作。

- 强化学习(Reinforcement Learning):一种机器学习方法,智能体通过与环境进行交互,根据环境反馈的奖励信号来学习最优的行为策略,以最大化长期累积奖励。

- 动态多智能体系统(Dynamic Multi - Agent System):由多个智能体组成的系统,环境是动态变化的,智能体需要不断地感知环境变化,并与其他智能体进行协同合作,以适应环境变化并完成任务。

- 协同推理(Collaborative Reasoning):多个智能体通过共享信息、交流意见等方式,共同进行推理和决策的过程。在协同推理中,智能体可以利用其他智能体的信息和知识,提高推理的准确性和效率。

1.4.2 相关概念解释

- 状态(State):环境在某一时刻的描述,包括智能体自身的状态和环境的状态。智能体根据当前状态来选择行动。

- 动作(Action):智能体在某一状态下可以采取的行为。不同的动作会导致环境状态的不同变化,并获得不同的奖励。

- 奖励(Reward):环境对智能体采取的动作的反馈,用于评估动作的好坏。智能体的目标是通过学习最优的策略,最大化长期累积奖励。

- 策略(Policy):智能体根据当前状态选择动作的规则。策略可以是确定性的,也可以是随机性的。

1.4.3 缩略词列表

- RL:Reinforcement Learning,强化学习

- MDP:Markov Decision Process,马尔可夫决策过程

- Q - learning:一种基于值函数的强化学习算法

- PG:Policy Gradient,策略梯度算法

2. 核心概念与联系

核心概念原理

智能体

智能体是动态多智能体协同推理框架的基本组成单元。每个智能体都具有感知环境、做出决策和执行动作的能力。智能体的感知模块可以收集环境中的信息,如传感器数据、其他智能体的状态信息等。决策模块根据感知到的信息和自身的策略,选择合适的动作。执行模块将决策模块选择的动作作用于环境。

环境

环境是智能体所处的外部世界,它可以是物理环境,如现实世界中的道路、建筑物等;也可以是虚拟环境,如游戏场景、模拟实验环境等。环境会根据智能体的动作发生变化,并反馈给智能体相应的奖励信号。

协同推理

协同推理是多个智能体之间通过信息共享和合作,共同完成推理和决策任务的过程。在协同推理中,智能体可以交换各自的信息和知识,以提高推理的准确性和效率。例如,在一个智能交通系统中,多个车辆智能体可以共享交通流量信息、道路状况信息等,共同规划最优的行驶路线。

架构的文本示意图

以下是基于强化学习的动态多智能体协同推理框架的架构文本示意图:

+---------------------+

| 动态多智能体协同推理框架 |

+---------------------+

| 智能体 1 |

| 感知模块 |

| 决策模块 |

| 执行模块 |

+---------------------+

| 智能体 2 |

| 感知模块 |

| 决策模块 |

| 执行模块 |

+---------------------+

| ... |

+---------------------+

| 智能体 n |

| 感知模块 |

| 决策模块 |

| 执行模块 |

+---------------------+

| 环境 |

| 状态更新模块 |

| 奖励反馈模块 |

+---------------------+

| 通信网络 |

| 信息共享模块 |

+---------------------+

该示意图展示了框架的主要组成部分,包括多个智能体、环境和通信网络。每个智能体都有自己的感知、决策和执行模块,环境负责状态更新和奖励反馈,通信网络用于智能体之间的信息共享。

Mermaid 流程图

该流程图展示了动态多智能体协同推理框架的基本工作流程。智能体首先感知环境信息,然后根据信息和共享的知识进行决策,选择合适的动作并执行。环境根据智能体的动作更新状态,并反馈奖励。智能体根据奖励调整策略,直到任务结束。在整个过程中,智能体之间可以进行信息共享,以提高决策的准确性和效率。

3. 核心算法原理 & 具体操作步骤

强化学习基础

强化学习的核心是智能体与环境进行交互,通过不断地尝试不同的动作,根据环境反馈的奖励信号来学习最优的行为策略。在强化学习中,通常使用马尔可夫决策过程(MDP)来描述智能体与环境的交互过程。

马尔可夫决策过程(MDP)

马尔可夫决策过程可以用一个五元组 <S,A,P,R,γ><S, A, P, R, \gamma><S,A,P,R,γ> 来表示,其中:

- SSS 是状态集合,表示环境的所有可能状态。

- AAA 是动作集合,表示智能体在每个状态下可以采取的所有可能动作。

- P(s′∣s,a)P(s'|s, a)P(s′∣s,a) 是状态转移概率,表示智能体在状态 sss 下采取动作 aaa 后转移到状态 s′s's′ 的概率。

- R(s,a,s′)R(s, a, s')R(s,a,s′) 是奖励函数,表示智能体在状态 sss 下采取动作 aaa 并转移到状态 s′s's′ 后获得的奖励。

- γ∈[0,1]\gamma \in [0, 1]γ∈[0,1] 是折扣因子,用于权衡短期奖励和长期奖励。

智能体的目标是找到一个最优策略 π∗\pi^*π∗,使得长期累积奖励最大化,即:

π∗=argmaxπE[∑t=0∞γtR(st,at,st+1)∣s0,π] \pi^* = \arg\max_{\pi} \mathbb{E}\left[\sum_{t = 0}^{\infty} \gamma^t R(s_t, a_t, s_{t + 1}) \mid s_0, \pi\right] π∗=argπmaxE[t=0∑∞γtR(st,at,st+1)∣s0,π]

策略梯度算法原理

策略梯度算法是一种直接对策略进行优化的强化学习算法。策略通常用一个参数化的函数 πθ(a∣s)\pi_{\theta}(a|s)πθ(a∣s) 表示,其中 θ\thetaθ 是策略的参数。策略梯度算法的目标是通过调整策略的参数 θ\thetaθ,使得智能体在与环境交互过程中获得的长期累积奖励最大化。

策略梯度定理表明,策略的梯度可以表示为:

∇θJ(θ)=Eπθ[∇θlogπθ(a∣s)Qπθ(s,a)] \nabla_{\theta} J(\theta) = \mathbb{E}_{\pi_{\theta}}\left[\nabla_{\theta} \log \pi_{\theta}(a|s) Q^{\pi_{\theta}}(s, a)\right] ∇θJ(θ)=Eπθ[∇θlogπθ(a∣s)Qπθ(s,a)]

其中 J(θ)J(\theta)J(θ) 是策略的性能指标,Qπθ(s,a)Q^{\pi_{\theta}}(s, a)Qπθ(s,a) 是动作价值函数,表示在策略 πθ\pi_{\theta}πθ 下,智能体在状态 sss 下采取动作 aaa 后获得的长期累积奖励的期望。

具体操作步骤及 Python 代码实现

以下是一个简单的基于策略梯度算法的动态多智能体协同推理的 Python 代码示例:

import numpy as np

import torch

import torch.nn as nn

import torch.optim as optim

# 定义智能体策略网络

class PolicyNetwork(nn.Module):

def __init__(self, input_dim, output_dim):

super(PolicyNetwork, self).__init__()

self.fc1 = nn.Linear(input_dim, 64)

self.fc2 = nn.Linear(64, output_dim)

self.softmax = nn.Softmax(dim = 1)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = self.fc2(x)

x = self.softmax(x)

return x

# 定义智能体类

class Agent:

def __init__(self, input_dim, output_dim, lr):

self.policy_network = PolicyNetwork(input_dim, output_dim)

self.optimizer = optim.Adam(self.policy_network.parameters(), lr = lr)

self.states = []

self.actions = []

self.rewards = []

def choose_action(self, state):

state = torch.FloatTensor(state).unsqueeze(0)

probs = self.policy_network(state)

action = torch.multinomial(probs, 1).item()

return action

def store_transition(self, state, action, reward):

self.states.append(state)

self.actions.append(action)

self.rewards.append(reward)

def learn(self):

states = torch.FloatTensor(self.states)

actions = torch.LongTensor(self.actions)

rewards = torch.FloatTensor(self.rewards)

# 计算折扣奖励

discounted_rewards = []

discounted_reward = 0

for reward in reversed(rewards):

discounted_reward = reward + 0.9 * discounted_reward

discounted_rewards.insert(0, discounted_reward)

discounted_rewards = torch.FloatTensor(discounted_rewards)

# 计算策略梯度

probs = self.policy_network(states)

log_probs = torch.log(probs.gather(1, actions.unsqueeze(1)).squeeze(1))

loss = (-log_probs * discounted_rewards).mean()

# 更新策略网络

self.optimizer.zero_grad()

loss.backward()

self.optimizer.step()

# 清空存储的过渡信息

self.states = []

self.actions = []

self.rewards = []

# 模拟环境

class Environment:

def __init__(self):

self.state = np.random.rand(10)

def step(self, action):

# 简单模拟状态转移和奖励反馈

next_state = np.random.rand(10)

reward = np.random.rand()

done = False

return next_state, reward, done

# 主函数

def main():

input_dim = 10

output_dim = 5

lr = 0.001

num_agents = 3

agents = [Agent(input_dim, output_dim, lr) for _ in range(num_agents)]

env = Environment()

for episode in range(100):

states = [env.state for _ in range(num_agents)]

dones = [False for _ in range(num_agents)]

while not all(dones):

actions = [agent.choose_action(state) for agent, state in zip(agents, states)]

next_states = []

rewards = []

for i in range(num_agents):

next_state, reward, done = env.step(actions[i])

next_states.append(next_state)

rewards.append(reward)

agents[i].store_transition(states[i], actions[i], reward)

dones[i] = done

states = next_states

# 智能体学习

for agent in agents:

agent.learn()

print("Training finished!")

if __name__ == "__main__":

main()

代码解释

- 策略网络定义:

PolicyNetwork类定义了智能体的策略网络,使用了两层全连接层和一个 Softmax 激活函数,用于输出动作的概率分布。 - 智能体类:

Agent类封装了智能体的主要功能,包括选择动作、存储过渡信息和学习更新策略。choose_action方法根据当前状态选择动作,store_transition方法存储状态、动作和奖励,learn方法根据存储的过渡信息计算策略梯度并更新策略网络。 - 环境类:

Environment类模拟了环境的状态转移和奖励反馈。step方法根据智能体的动作返回下一个状态、奖励和是否结束的标志。 - 主函数:

main函数初始化多个智能体和环境,进行多轮训练。在每一轮训练中,智能体与环境进行交互,存储过渡信息,最后进行学习更新。

4. 数学模型和公式 & 详细讲解 & 举例说明

马尔可夫决策过程(MDP)详细讲解

在动态多智能体协同推理中,马尔可夫决策过程(MDP)是描述智能体与环境交互的基础模型。如前文所述,MDP 由五元组 <S,A,P,R,γ><S, A, P, R, \gamma><S,A,P,R,γ> 表示。

状态集合 SSS

状态集合 SSS 包含了环境的所有可能状态。在不同的应用场景中,状态的定义和表示方式会有所不同。例如,在智能交通系统中,状态可以包括车辆的位置、速度、方向,以及周围车辆和道路的信息等。在一个简单的网格世界环境中,状态可以用智能体在网格中的坐标表示。

动作集合 AAA

动作集合 AAA 表示智能体在每个状态下可以采取的所有可能动作。同样,动作的定义也取决于具体的应用场景。在智能交通系统中,动作可以包括加速、减速、左转、右转等。在网格世界环境中,动作可以包括向上、向下、向左、向右移动。

状态转移概率 P(s′∣s,a)P(s'|s, a)P(s′∣s,a)

状态转移概率 P(s′∣s,a)P(s'|s, a)P(s′∣s,a) 描述了智能体在状态 sss 下采取动作 aaa 后转移到状态 s′s's′ 的概率。这个概率通常由环境的动态特性决定。例如,在一个随机环境中,智能体采取某个动作后,可能会以一定的概率转移到不同的状态。在确定性环境中,状态转移概率为 1 或 0。

奖励函数 R(s,a,s′)R(s, a, s')R(s,a,s′)

奖励函数 R(s,a,s′)R(s, a, s')R(s,a,s′) 用于评估智能体在状态 sss 下采取动作 aaa 并转移到状态 s′s's′ 后获得的奖励。奖励函数的设计直接影响智能体的学习目标和行为。例如,在智能交通系统中,奖励可以根据车辆的行驶速度、到达目的地的距离、是否发生碰撞等因素来定义。如果车辆能够快速、安全地到达目的地,则可以获得较高的奖励;如果发生碰撞,则会获得较低的奖励。

折扣因子 γ\gammaγ

折扣因子 γ∈[0,1]\gamma \in [0, 1]γ∈[0,1] 用于权衡短期奖励和长期奖励。当 γ\gammaγ 接近 1 时,智能体更注重长期奖励;当 γ\gammaγ 接近 0 时,智能体更注重短期奖励。例如,在一个需要长期规划的任务中,如自动驾驶,通常会选择较大的 γ\gammaγ 值,以鼓励智能体做出更长远的决策。

动作价值函数和状态价值函数

在强化学习中,动作价值函数 Qπ(s,a)Q^{\pi}(s, a)Qπ(s,a) 和状态价值函数 Vπ(s)V^{\pi}(s)Vπ(s) 是两个重要的概念。

动作价值函数 Qπ(s,a)Q^{\pi}(s, a)Qπ(s,a)

动作价值函数 Qπ(s,a)Q^{\pi}(s, a)Qπ(s,a) 表示在策略 π\piπ 下,智能体在状态 sss 下采取动作 aaa 后获得的长期累积奖励的期望。其定义为:

Qπ(s,a)=Eπ[∑t=0∞γtR(st,at,st+1)∣s0=s,a0=a] Q^{\pi}(s, a) = \mathbb{E}_{\pi}\left[\sum_{t = 0}^{\infty} \gamma^t R(s_t, a_t, s_{t + 1}) \mid s_0 = s, a_0 = a\right] Qπ(s,a)=Eπ[t=0∑∞γtR(st,at,st+1)∣s0=s,a0=a]

状态价值函数 Vπ(s)V^{\pi}(s)Vπ(s)

状态价值函数 Vπ(s)V^{\pi}(s)Vπ(s) 表示在策略 π\piπ 下,智能体从状态 sss 开始获得的长期累积奖励的期望。其定义为:

Vπ(s)=Eπ[∑t=0∞γtR(st,at,st+1)∣s0=s] V^{\pi}(s) = \mathbb{E}_{\pi}\left[\sum_{t = 0}^{\infty} \gamma^t R(s_t, a_t, s_{t + 1}) \mid s_0 = s\right] Vπ(s)=Eπ[t=0∑∞γtR(st,at,st+1)∣s0=s]

动作价值函数和状态价值函数之间存在以下关系:

Vπ(s)=∑a∈Aπ(a∣s)Qπ(s,a) V^{\pi}(s) = \sum_{a \in A} \pi(a|s) Q^{\pi}(s, a) Vπ(s)=a∈A∑π(a∣s)Qπ(s,a)

策略梯度公式详细讲解

策略梯度算法的核心是通过调整策略的参数 θ\thetaθ 来最大化策略的性能指标 J(θ)J(\theta)J(θ)。策略梯度定理表明,策略的梯度可以表示为:

∇θJ(θ)=Eπθ[∇θlogπθ(a∣s)Qπθ(s,a)] \nabla_{\theta} J(\theta) = \mathbb{E}_{\pi_{\theta}}\left[\nabla_{\theta} \log \pi_{\theta}(a|s) Q^{\pi_{\theta}}(s, a)\right] ∇θJ(θ)=Eπθ[∇θlogπθ(a∣s)Qπθ(s,a)]

公式解释

- ∇θlogπθ(a∣s)\nabla_{\theta} \log \pi_{\theta}(a|s)∇θlogπθ(a∣s):这是策略 πθ(a∣s)\pi_{\theta}(a|s)πθ(a∣s) 的对数似然梯度。它表示在状态 sss 下采取动作 aaa 的概率对策略参数 θ\thetaθ 的梯度。这个梯度反映了策略参数的微小变化对采取动作 aaa 的概率的影响。

- Qπθ(s,a)Q^{\pi_{\theta}}(s, a)Qπθ(s,a):动作价值函数,表示在策略 πθ\pi_{\theta}πθ 下,智能体在状态 sss 下采取动作 aaa 后获得的长期累积奖励的期望。它作为一个权重,用于调整策略梯度的方向和大小。如果 Qπθ(s,a)Q^{\pi_{\theta}}(s, a)Qπθ(s,a) 为正,则表示采取动作 aaa 是有益的,应该增加采取该动作的概率;如果 Qπθ(s,a)Q^{\pi_{\theta}}(s, a)Qπθ(s,a) 为负,则表示采取动作 aaa 是不利的,应该减少采取该动作的概率。

举例说明

假设我们有一个简单的网格世界环境,智能体的目标是从起点到达终点。状态 sss 用智能体在网格中的坐标 (x,y)(x, y)(x,y) 表示,动作 aaa 包括向上、向下、向左、向右移动。策略 πθ(a∣s)\pi_{\theta}(a|s)πθ(a∣s) 是一个神经网络,输出每个动作的概率。

状态转移和奖励

- 状态转移:如果智能体采取向上移动的动作,并且当前位置的上方没有障碍物,则智能体将移动到上方的格子;否则,智能体将保持在当前位置。

- 奖励:如果智能体到达终点,则获得奖励 10;如果智能体撞到障碍物,则获得奖励 - 1;其他情况下,获得奖励 - 0.1。

策略梯度计算

假设智能体在状态 s=(2,3)s = (2, 3)s=(2,3) 下采取动作 a=a =a= 向上移动,并且获得了奖励 r=−0.1r = -0.1r=−0.1。根据策略梯度公式,我们需要计算 ∇θlogπθ(a∣s)\nabla_{\theta} \log \pi_{\theta}(a|s)∇θlogπθ(a∣s) 和 Qπθ(s,a)Q^{\pi_{\theta}}(s, a)Qπθ(s,a)。

- 计算 ∇θlogπθ(a∣s)\nabla_{\theta} \log \pi_{\theta}(a|s)∇θlogπθ(a∣s):首先,通过神经网络计算 πθ(a∣s)\pi_{\theta}(a|s)πθ(a∣s),然后对其取对数并求梯度。

- 计算 Qπθ(s,a)Q^{\pi_{\theta}}(s, a)Qπθ(s,a):可以使用蒙特卡罗方法或时序差分方法来估计 Qπθ(s,a)Q^{\pi_{\theta}}(s, a)Qπθ(s,a)。例如,通过多次模拟智能体从状态 sss 采取动作 aaa 后的轨迹,计算长期累积奖励的平均值。

最后,根据策略梯度公式更新策略的参数 θ\thetaθ,使得智能体在状态 sss 下采取动作 aaa 的概率朝着获得更高奖励的方向调整。

5. 项目实战:代码实际案例和详细解释说明

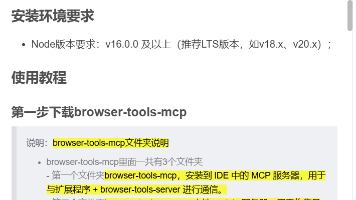

5.1 开发环境搭建

操作系统

本项目可以在多种操作系统上进行开发,如 Windows、Linux 和 macOS。建议使用 Linux 系统,因为它在开发和部署方面具有更好的稳定性和兼容性。

Python 环境

我们使用 Python 作为开发语言,建议使用 Python 3.7 及以上版本。可以通过 Anaconda 或 Miniconda 来管理 Python 环境。以下是创建和激活虚拟环境的步骤:

# 创建虚拟环境

conda create -n multi_agent_rl python=3.8

# 激活虚拟环境

conda activate multi_agent_rl

依赖库安装

本项目需要安装以下主要依赖库:

torch:用于深度学习模型的构建和训练。numpy:用于数值计算。matplotlib:用于数据可视化。

可以使用以下命令安装这些库:

pip install torch numpy matplotlib

5.2 源代码详细实现和代码解读

项目需求

我们要实现一个简单的多智能体协同探索环境的项目。在一个二维网格世界中,有多个智能体需要协同探索环境,找到目标位置。每个智能体可以感知周围的环境信息,并与其他智能体进行通信。

代码实现

import numpy as np

import torch

import torch.nn as nn

import torch.optim as optim

import matplotlib.pyplot as plt

# 定义智能体策略网络

class PolicyNetwork(nn.Module):

def __init__(self, input_dim, output_dim):

super(PolicyNetwork, self).__init__()

self.fc1 = nn.Linear(input_dim, 128)

self.fc2 = nn.Linear(128, output_dim)

self.softmax = nn.Softmax(dim = 1)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = self.fc2(x)

x = self.softmax(x)

return x

# 定义智能体类

class Agent:

def __init__(self, input_dim, output_dim, lr):

self.policy_network = PolicyNetwork(input_dim, output_dim)

self.optimizer = optim.Adam(self.policy_network.parameters(), lr = lr)

self.states = []

self.actions = []

self.rewards = []

def choose_action(self, state):

state = torch.FloatTensor(state).unsqueeze(0)

probs = self.policy_network(state)

action = torch.multinomial(probs, 1).item()

return action

def store_transition(self, state, action, reward):

self.states.append(state)

self.actions.append(action)

self.rewards.append(reward)

def learn(self):

states = torch.FloatTensor(self.states)

actions = torch.LongTensor(self.actions)

rewards = torch.FloatTensor(self.rewards)

# 计算折扣奖励

discounted_rewards = []

discounted_reward = 0

for reward in reversed(rewards):

discounted_reward = reward + 0.9 * discounted_reward

discounted_rewards.insert(0, discounted_reward)

discounted_rewards = torch.FloatTensor(discounted_rewards)

# 计算策略梯度

probs = self.policy_network(states)

log_probs = torch.log(probs.gather(1, actions.unsqueeze(1)).squeeze(1))

loss = (-log_probs * discounted_rewards).mean()

# 更新策略网络

self.optimizer.zero_grad()

loss.backward()

self.optimizer.step()

# 清空存储的过渡信息

self.states = []

self.actions = []

self.rewards = []

# 定义环境类

class Environment:

def __init__(self, grid_size, num_agents, target_position):

self.grid_size = grid_size

self.num_agents = num_agents

self.target_position = target_position

self.agent_positions = [np.random.randint(0, grid_size, 2) for _ in range(num_agents)]

def get_state(self, agent_index):

agent_position = self.agent_positions[agent_index]

# 简单的状态表示:智能体的位置和目标位置的相对坐标

state = np.concatenate([agent_position, self.target_position - agent_position])

return state

def step(self, actions):

rewards = []

for i in range(self.num_agents):

action = actions[i]

agent_position = self.agent_positions[i]

if action == 0: # 向上移动

agent_position[1] = max(agent_position[1] - 1, 0)

elif action == 1: # 向下移动

agent_position[1] = min(agent_position[1] + 1, self.grid_size - 1)

elif action == 2: # 向左移动

agent_position[0] = max(agent_position[0] - 1, 0)

elif action == 3: # 向右移动

agent_position[0] = min(agent_position[0] + 1, self.grid_size - 1)

self.agent_positions[i] = agent_position

# 计算奖励

distance = np.linalg.norm(agent_position - self.target_position)

if distance == 0:

reward = 10

else:

reward = -0.1

rewards.append(reward)

done = all([np.linalg.norm(pos - self.target_position) == 0 for pos in self.agent_positions])

return rewards, done

# 主函数

def main():

grid_size = 10

num_agents = 3

target_position = np.array([8, 8])

input_dim = 4

output_dim = 4

lr = 0.001

num_episodes = 1000

agents = [Agent(input_dim, output_dim, lr) for _ in range(num_agents)]

env = Environment(grid_size, num_agents, target_position)

episode_rewards = []

for episode in range(num_episodes):

total_reward = 0

states = [env.get_state(i) for i in range(num_agents)]

done = False

while not done:

actions = [agent.choose_action(state) for agent, state in zip(agents, states)]

rewards, done = env.step(actions)

for i in range(num_agents):

agents[i].store_transition(states[i], actions[i], rewards[i])

states = [env.get_state(i) for i in range(num_agents)]

total_reward += sum(rewards)

# 智能体学习

for agent in agents:

agent.learn()

episode_rewards.append(total_reward)

if episode % 100 == 0:

print(f"Episode {episode}: Total reward = {total_reward}")

# 绘制奖励曲线

plt.plot(episode_rewards)

plt.xlabel('Episode')

plt.ylabel('Total Reward')

plt.title('Training Reward Curve')

plt.show()

if __name__ == "__main__":

main()

代码解读

- 策略网络定义:

PolicyNetwork类定义了智能体的策略网络,使用了两层全连接层和一个 Softmax 激活函数,用于输出动作的概率分布。 - 智能体类:

Agent类封装了智能体的主要功能,包括选择动作、存储过渡信息和学习更新策略。choose_action方法根据当前状态选择动作,store_transition方法存储状态、动作和奖励,learn方法根据存储的过渡信息计算策略梯度并更新策略网络。 - 环境类:

Environment类定义了二维网格世界环境。get_state方法返回智能体的状态,step方法根据智能体的动作更新环境状态,并返回奖励和是否结束的标志。 - 主函数:

main函数初始化多个智能体和环境,进行多轮训练。在每一轮训练中,智能体与环境进行交互,存储过渡信息,最后进行学习更新。同时,记录每一轮的总奖励,并绘制奖励曲线。

5.3 代码解读与分析

策略网络分析

策略网络使用了两层全连接层,第一层将输入特征映射到 128 维的隐藏层,第二层将隐藏层的输出映射到动作空间的维度。Softmax 激活函数将输出转换为动作的概率分布。这种简单的网络结构可以在一定程度上捕捉智能体的决策信息。

智能体学习过程分析

智能体在与环境交互的过程中,不断存储状态、动作和奖励信息。在每一轮训练结束后,智能体根据存储的过渡信息计算策略梯度,并更新策略网络。通过多次训练,智能体可以逐渐学习到最优的策略,以最大化长期累积奖励。

环境交互分析

环境根据智能体的动作更新状态,并返回奖励。奖励的设计直接影响智能体的学习目标。在本项目中,如果智能体到达目标位置,则获得较高的奖励;否则,获得较低的负奖励。这种奖励设计鼓励智能体尽快找到目标位置。

训练效果分析

通过绘制奖励曲线,可以观察到智能体的训练效果。随着训练轮数的增加,总奖励逐渐提高,说明智能体在不断学习和优化策略。当奖励曲线趋于稳定时,说明智能体已经学习到了相对稳定的策略。

6. 实际应用场景

自动驾驶

在自动驾驶领域,基于强化学习的动态多智能体协同推理框架具有重要的应用价值。多个自动驾驶车辆可以看作是多个智能体,它们需要在动态的交通环境中协同行驶,避免碰撞,提高交通效率。

协同导航

多个自动驾驶车辆可以通过信息共享,协同规划行驶路线。例如,当一辆车辆检测到前方道路拥堵时,可以将该信息传递给其他车辆,其他车辆可以根据该信息重新规划路线,避免陷入拥堵。

避碰与跟车

在行驶过程中,车辆智能体需要实时感知周围车辆的状态,并进行协同避碰和跟车操作。通过强化学习,智能体可以学习到最优的避碰和跟车策略,提高行驶的安全性。

智能交通管理

智能交通管理系统涉及多个交通控制设备和车辆,如交通信号灯、智能公交、自动驾驶汽车等。基于强化学习的动态多智能体协同推理框架可以用于优化交通流量,减少拥堵。

交通信号控制

多个交通信号灯可以看作是多个智能体,它们可以根据实时的交通流量信息,协同调整信号灯的时长。例如,当某个路口的车流量较大时,信号灯可以适当延长绿灯时间,以提高车辆的通行效率。

公交调度

智能公交可以根据实时的乘客需求和交通状况,协同调整行驶路线和发车间隔。通过强化学习,公交智能体可以学习到最优的调度策略,提高公交服务的质量。

物流配送

在物流配送领域,多个物流机器人和配送车辆可以组成一个多智能体系统,协同完成货物的分拣、运输和配送任务。

仓库货物分拣

在仓库中,多个物流机器人可以协同工作,根据货物的位置和订单信息,快速准确地完成货物的分拣任务。通过强化学习,机器人智能体可以学习到最优的分拣策略,提高分拣效率。

货物配送

多个配送车辆可以根据实时的交通状况和货物配送需求,协同规划配送路线。例如,当某个区域的订单较多时,车辆可以相互协作,共同完成配送任务,提高配送效率。

机器人协作

在工业生产和服务领域,多个机器人可以组成一个协作团队,共同完成复杂的任务。

工业装配

在工业生产线上,多个机器人可以协同完成零件的装配任务。每个机器人负责不同的装配步骤,通过信息共享和协同决策,提高装配的精度和效率。

服务机器人协作

在酒店、商场等场所,多个服务机器人可以协同工作,为顾客提供服务。例如,一个机器人负责引导顾客,另一个机器人负责提供信息和解答问题,通过协同合作,提高服务质量。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《Reinforcement Learning: An Introduction》(第二版):这是强化学习领域的经典教材,由 Richard S. Sutton 和 Andrew G. Barto 所著。该书全面介绍了强化学习的基本概念、算法和应用,是学习强化学习的必读之书。

- 《Multi - Agent Systems: Algorithmic, Game - Theoretic, and Logical Foundations》:这本书详细介绍了多智能体系统的理论基础,包括算法、博弈论和逻辑等方面的内容。对于深入理解多智能体系统的原理和设计方法非常有帮助。

- 《Artificial Intelligence: A Modern Approach》(第三版):这是人工智能领域的经典教材,由 Stuart Russell 和 Peter Norvig 所著。该书涵盖了人工智能的各个方面,包括搜索算法、知识表示、机器学习、多智能体系统等,是学习人工智能的重要参考书籍。

7.1.2 在线课程

- Coursera 上的《Reinforcement Learning Specialization》:这是一个由 University of Alberta 提供的强化学习专项课程,包括多门课程,从基础的强化学习概念到高级的算法和应用都有涉及。课程内容丰富,讲解详细,适合初学者和有一定基础的学习者。

- edX 上的《Multi - Agent Artificial Intelligence》:该课程由 Massachusetts Institute of Technology 提供,主要介绍多智能体系统的理论和实践。课程涵盖了多智能体决策、博弈论、通信与协作等方面的内容,对于学习多智能体系统非常有帮助。

- 网易云课堂上的《Python 强化学习实战》:该课程结合 Python 代码,详细介绍了强化学习的各种算法和应用。通过实际案例的讲解,帮助学习者更好地理解和掌握强化学习的编程实现。

7.1.3 技术博客和网站

- OpenAI Blog(https://openai.com/blog/):OpenAI 是人工智能领域的知名研究机构,其博客上经常发布关于强化学习、多智能体系统等方面的最新研究成果和技术文章。

- Medium 上的 Towards Data Science(https://towardsdatascience.com/):该网站汇集了大量的数据科学和人工智能相关的技术文章,其中有很多关于强化学习和多智能体系统的优质文章,对于学习和了解最新的技术动态非常有帮助。

- 知乎上的人工智能相关话题:知乎上有很多关于人工智能、强化学习和多智能体系统的讨论和分享,通过关注相关话题和优秀的答主,可以获取到很多有价值的信息和经验。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:这是一款专门为 Python 开发设计的集成开发环境(IDE),具有强大的代码编辑、调试和项目管理功能。它支持多种 Python 框架和库,对于开发基于强化学习的多智能体系统非常方便。

- Visual Studio Code:这是一款轻量级的代码编辑器,具有丰富的插件生态系统。通过安装相关的插件,可以实现 Python 代码的编辑、调试和版本控制等功能。它的优点是简洁易用,适合快速开发和调试。

7.2.2 调试和性能分析工具

- TensorBoard:这是 TensorFlow 提供的一个可视化工具,用于监控和分析深度学习模型的训练过程。通过 TensorBoard,可以查看模型的损失函数、准确率、梯度等指标的变化情况,帮助开发者更好地理解模型的训练过程和性能。

- PyTorch Profiler:这是 PyTorch 提供的一个性能分析工具,用于分析 PyTorch 模型的性能瓶颈。通过 PyTorch Profiler,可以查看模型的计算时间、内存使用情况等信息,帮助开发者优化模型的性能。

7.2.3 相关框架和库

- OpenAI Gym:这是一个用于开发和比较强化学习算法的工具包,提供了多种环境和任务,如经典控制问题、机器人控制问题等。通过使用 OpenAI Gym,可以快速搭建强化学习实验环境,测试和验证算法的性能。

- Stable Baselines3:这是一个基于 PyTorch 的强化学习库,提供了多种经典的强化学习算法的实现,如 A2C、PPO、DQN 等。它具有简单易用的接口和高效的性能,适合初学者和开发者使用。

- PettingZoo:这是一个用于开发和研究多智能体强化学习的工具包,提供了多种多智能体环境和任务,如合作游戏、竞争游戏等。通过使用 PettingZoo,可以快速搭建多智能体强化学习实验环境,研究多智能体之间的协作和竞争关系。

7.3 相关论文著作推荐

7.3.1 经典论文

- “Policy Gradient Methods for Reinforcement Learning with Function Approximation”(Sutton et al., 2000):这篇论文提出了策略梯度算法,是强化学习领域的经典论文之一。它为直接优化策略提供了理论基础,推动了强化学习算法的发展。

- “Q - learning”(Watkins and Dayan, 1992):这篇论文提出了 Q - learning 算法,是基于值函数的强化学习算法的代表。Q - learning 算法具有简单易用、收敛性好等优点,在很多领域得到了广泛应用。

- “Multi - Agent Reinforcement Learning: Independent vs. Cooperative Agents”(Tan, 1993):这篇论文探讨了多智能体强化学习中独立智能体和合作智能体的区别和联系,为多智能体强化学习的研究奠定了基础。

7.3.2 最新研究成果

- “Mastering the Game of Go without Human Knowledge”(Silver et al., 2017):这篇论文介绍了 AlphaGo Zero,一个通过自我对弈学习掌握围棋游戏的人工智能系统。它展示了强化学习在复杂游戏中的强大能力,引起了广泛的关注。

- “Emergent Complexity via Multi - Agent Competition”(OpenAI et al., 2017):这篇论文通过多智能体竞争的方式,让智能体在复杂环境中学习到了复杂的行为和策略。它展示了多智能体系统在涌现复杂行为方面的潜力。

- “Multi - Agent Actor - Critic for Mixed Cooperative - Competitive Environments”(Lowe et al., 2017):这篇论文提出了 MADDPG 算法,用于解决混合合作 - 竞争环境下的多智能体强化学习问题。它通过引入集中式训练和分布式执行的方法,提高了多智能体系统的性能。

7.3.3 应用案例分析

- “Autonomous Vehicle Decision - Making and Planning Using Deep Reinforcement Learning: A Review”(Kiran et al., 2020):这篇论文对基于深度强化学习的自动驾驶车辆决策和规划方法进行了综述,分析了不同方法的优缺点和应用场景。

- “Multi - Robot Exploration Using Reinforcement Learning”(Hoffmann et al., 2018):这篇论文介绍了一种基于强化学习的多机器人探索方法,通过多机器人之间的协同合作,提高了探索效率。

- “Logistics Robot Path Planning Based on Deep Reinforcement Learning”(Zhang et al., 2021):这篇论文提出了一种基于深度强化学习的物流机器人路径规划方法,通过训练智能体学习最优的路径规划策略,提高了物流机器人的工作效率。

8. 总结:未来发展趋势与挑战

未来发展趋势

深度强化学习与多智能体系统的融合

随着深度学习技术的不断发展,深度强化学习在多智能体系统中的应用将越来越广泛。深度强化学习可以处理复杂的环境和高维的状态空间

更多推荐

已为社区贡献44条内容

已为社区贡献44条内容

所有评论(0)