告别“无脑”生成!VChain视频推理链:仅靠几个关键帧,自动拍出因果清晰的“电影级”短片

VChain:基于视觉思维链的视频生成推理框架 VChain提出了一种创新的视频生成方法,通过引入多模态大模型的视觉思维链(chain-of-visual-thought)来增强视频的逻辑连贯性。该框架的核心是利用GPT等大型模型推理生成具有因果关系的稀疏关键帧序列,作为视频生成的指导。在推理阶段仅对这些关键帧进行轻量化微调,显著提升了复杂动态场景的生成质量,如物体交互和状态转变。实验表明,VCh

文章链接:https://arxiv.org/pdf/2510.05094

项目链接:https://eyeline-labs.github.io/VChain

git链接:https://github.com/Eyeline-Labs/VChain

亮点直击

VChain,一种利用多模态大模型的视觉思维链(chain-of-visual-thought)来将高层推理引入视频生成的新框架。

设计了视觉思维推理(Visual Thought Reasoning)流程,这是一个由 GPT 引导的流程,用于合成稀疏且具有因果基础的关键帧,以指导视频生成。

大量实验表明,在这些关键帧上进行稀疏监督可以提高模型生成具有连贯视觉结果和可解释状态转变的视频的能力。

本文的方法完全在推理阶段运行,不需要外部训练数据,并且仅增加极少的计算开销。

总结速览

解决的问题

当前的视频生成模型虽然能够生成平滑且视觉上美观的片段,但在处理复杂动态与因果链一致性方面仍存在显著不足:

-

难以准确建模视觉状态随时间的变化与结果的因果关系。

-

在多步场景中(如“杯子掉落—撞地—液体飞溅”),模型常遗漏关键因果步骤,导致生成结果逻辑不连贯、物理不合理。

提出的方案

提出 VChain —— 一种推理时(inference-time)链式视觉思维框架(chain-of-visual-thought framework),旨在引入多模态模型的推理能力来指导视频生成。

核心思想:

-

将视频的时序演化表示为一系列稀疏的 “视觉思维(Visual Thoughts)” —— 即由多模态模型推理得到的关键中间状态关键帧。

-

利用这些关键帧对预训练视频生成模型进行稀疏推理时微调(Sparse Inference-Time Tuning),以在关键时刻引导生成过程。

应用的技术

- Visual Thought Reasoning(视觉思维推理)

-

使用大型多模态模型(如 GPT-4o)将文本提示分解为因果上关键的中间视觉状态。

-

这些关键帧作为“视觉推理蓝图”,刻画出事件的逻辑演变路径。

-

- Sparse Inference-Time Tuning(稀疏推理时微调)

-

在推理阶段仅针对关键帧对预训练视频生成模型进行快速、轻量的调整。

-

避免密集训练或视频级监督,提升推理效率与实用性。

-

达到的效果

-

自包含性:无需外部标注、数据集或检索系统,所有监督信号均由多模态模型即时生成。

-

高效性:仅使用少量关键帧与有限迭代即可完成调整,计算开销极低。

-

有效性:在复杂多步视频生成任务中显著提升了生成结果的动态真实性、逻辑一致性与因果连贯性。

-

创新意义:提出了将多模态模型视为推理模块(reasoning module)、在推理阶段增强视频生成逻辑一致性的全新范式。

VChain 框架

VChain 是一个推理时推理框架,旨在增强视频生成的因果和物理一致性。该框架建立在一个预训练的视频生成器之上,目标是提升模型在反映推理、物理、因果关系以及常识理解方面的能力,从而生成更符合物理规律且因果一致的视频。

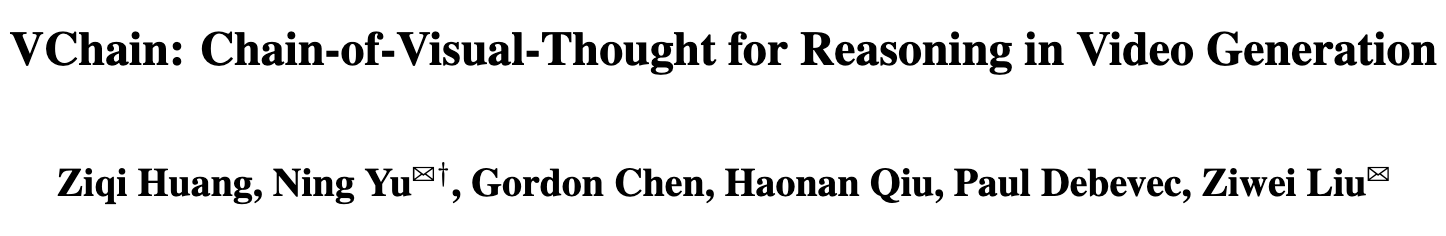

VChain概述。一个用于视频生成推理的推理时间调整框架。给定用户提供的提示(例如,“一块岩石和一根羽毛正在从天而降到地面上”),VChain 利用大型多模态模型生成视觉思维链,这是一组稀疏的因果重要关键帧,通过稀疏推理时间调整来指导视频生成器。VChain 有效改进视频生成中的推理,无需进行大量再训练

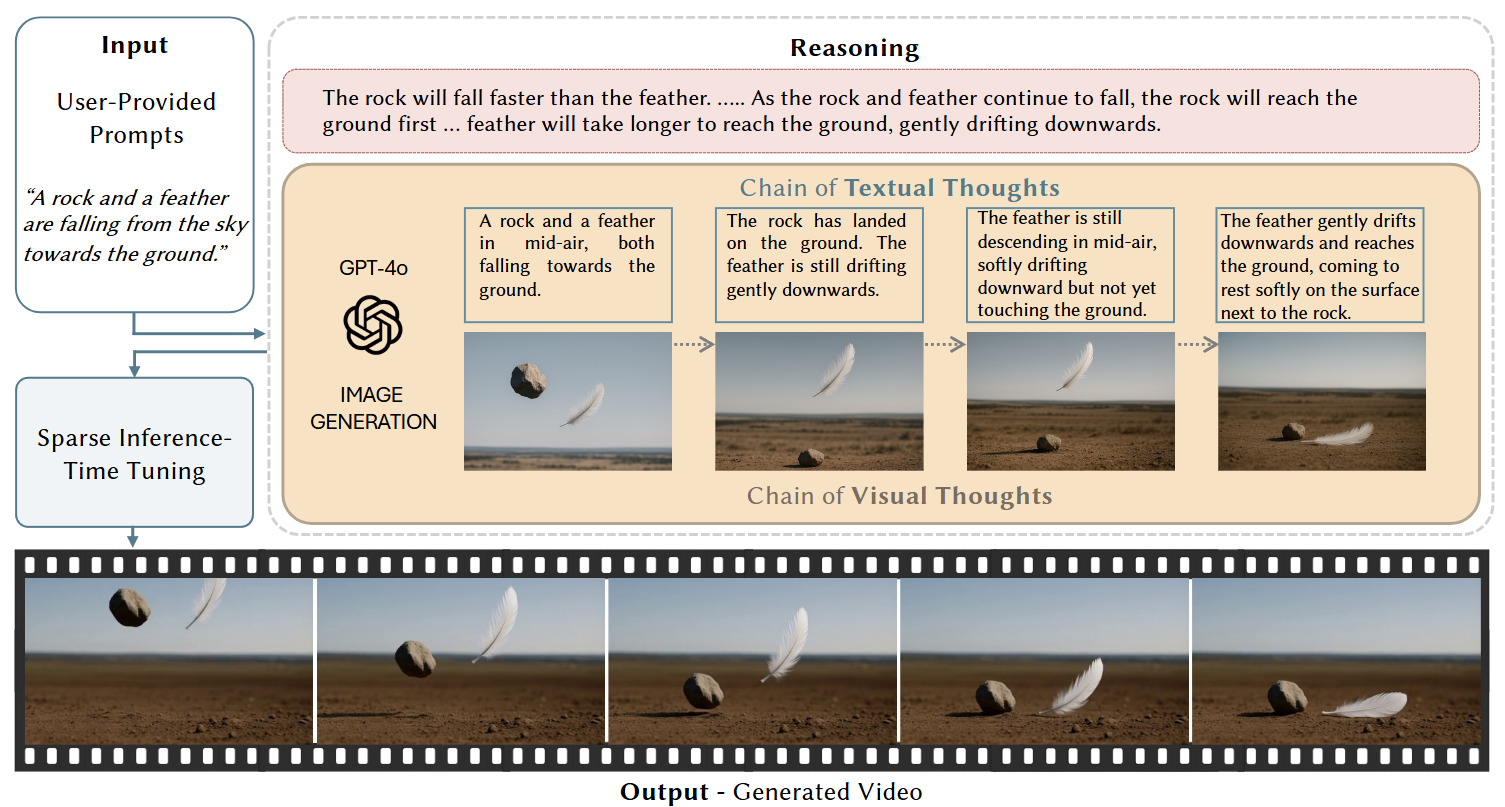

如下图 2 所示,VChain 框架包含三个关键阶段: (1) 视觉思维推理(Visual Thought Reasoning):使用大型多模态模型推理关键事件及其结果,形成一系列稀疏的视觉快照; (2) 稀疏推理时微调(Sparse Inference-Time Tuning):通过轻量化的 LoRA 自适应,将第一阶段的视觉思维注入预训练视频生成器中; (3) 视频采样(Video Sampling):利用第一阶段的思维与第二阶段微调后的视频生成器共同生成最终视频。

视觉思维推理(Visual Thought Reasoning)

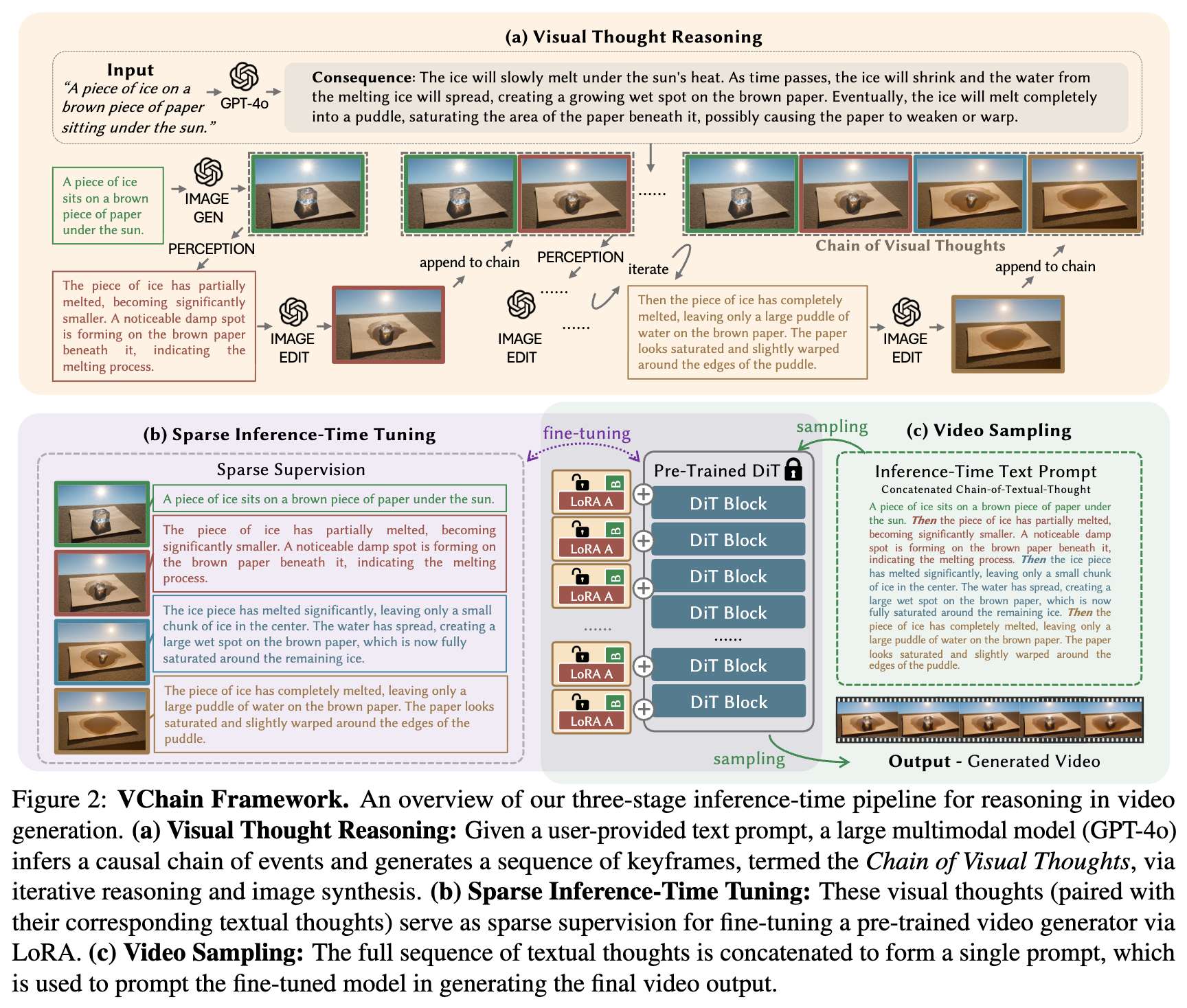

给定用户提供的视频生成文本提示 ,利用 GPT-4o 的强大多模态推理能力生成一系列图像,称为视觉思维链(Chain of Visual Thoughts),用于捕捉目标视频的关键时刻。视觉思维推理的步骤与定义在下算法 1 中列出。

本文首先提示 GPT-4o 对用户输入提示 所隐含的可能结果进行推理。如图 2 所示,给定提示 “一块冰放在阳光下的棕色纸上”,GPT-4o 推断冰会因受热而融化,形成水洼并浸湿纸张。该步骤确立了目标视频的真实轨迹(即结果),作为构建场景展开关键转变的基础。 然后,指示 GPT-4o 生成描述视觉思维链中第一帧的文本 ,并通过 GPT-4o 的原生图像生成模块将其转换为图像 。 接下来,GPT-4o 基于提示 、结果(consequence)以及当前时间步的视觉思维链 ,预测编辑指令 ,以生成链中时间步 的关键时刻。然后使用 生成后续图像 。 该过程迭代进行,GPT-4o 不断预测编辑指令并生成相应图像,直到结果被视觉思维链 完全捕获为止。 最终输出是一系列连贯的关键帧序列,即视觉思维链 及其对应的文本思维 ,用于捕捉用户提示所隐含的时间演化过程。 这种方法还允许用户在不显式预测或指定场景后果的情况下生成因果一致的图像序列。

关于视觉思维推理过程的详细描述,包括系统提示、生成的中间输出及工作流程细节,请参见附录。

稀疏推理时微调(Sparse Inference-Time Tuning)

给定上一阶段生成的稀疏且具有因果基础的视觉思维链,我们在预训练视频生成器上执行轻量化的推理时微调。

我们仅使用这些关键帧作为监督,将其视为编码重要状态变化(例如融化、破碎或物体移动)的锚点。

设 为 个视觉思维(关键帧)序列, 为其对应的文本思维。

每个 被视为一个单帧视频,并与文本描述 配对。 这些对 用作训练数据,以相同的 Flow Matching 目标函数(如公式 )对视频扩散模型进行微调:

其中 ,, 从对数逻辑正态分布中采样,,与流匹配设置相同, 是文本 的文本嵌入。

这种稀疏微调方案提供了两个关键优势:

1)聚焦监督:通过仅关注编码关键时刻(例如物体破裂、融化或出现)的关键帧,我们引导模型专注于推理因果结果和关键视觉状态变化;

2)高效性:由于微调仅基于图像,调优速度快且内存高效。这使得本文的方法在推理时适配中非常实用。

微调不需要额外的数据库或标签。整个监督信号完全由视觉和文本思维内部生成,使得 VChain 能够轻松插入通用的预训练视频生成器中。

视频采样

在稀疏推理时微调之后,将来自文本思维链 的每个文本思维 连接成一个复合提示 。该最终提示被用作微调后的视频生成器的输入,以生成输出视频。生成结果反映了推理出的事件序列和模型适应后的能力。

实验

实验设置

对于视觉思维推理,使用 GPT 系列模型作为大型多模态模型。使用 gpt-4o 进行聊天和感知,使用 gpt-image-1 处理涉及图像生成和编辑的步骤。主要实验使用最先进的预训练视频生成器 Wan2.1-T2V-1.3B进行。本文设计了 20 个多样化的测试场景,用于人工评估和定量比较。实现细节、测试用例和时间成本分解列于附录中。

比较方法

本文将所提出的方法 VChain 与若干基线和消融变体进行比较。

基线比较 包括以下基线方法:

-

T2V:未经任何修改的原始预训练文本到视频生成模型。

-

T2V + Prompt Aug:输入文本提示通过基于 GPT 的提示增强进行扩展。

消融研究 为了进一步理解 VChain 各组件的影响,设计了以下消融设置:

-

无视觉思维(Without Visual Thought):使用视觉思维推理流程生成复合文本提示 和视觉思维链 ,但仅将 输入视频生成器,省略视觉思维用于稀疏微调。该消融评估了在视频生成中进行视觉链式推理的必要性,表明仅使用文本思维不足以进行有效推理。

-

无稀疏微调(Without Sparse Tuning):直接使用 GPT 生成的关键帧进行视频插值,而不对视频生成器进行微调。该变体评估稀疏微调在使动态与推理信号对齐中的必要性。

-

VChain(本方法):我们的完整框架,结合视觉思维推理与稀疏推理时微调,以在视频生成中实现推理能力。

定量比较

下面介绍用于实验比较的各个方面。

VBench 质量得分。 为了在不考虑推理或因果能力的情况下评估 VChain 对视频基础质量的影响,我们使用 VBench进行定量评估。该评估框架旨在评估视频生成的关键技术维度,如帧级保真度、时间一致性和运动动态等。如表 1 所示,VChain 相比原始预训练生成器和其他基线方法,获得了相当或略优的得分。

还进行了以视频质量三大核心方面为重点的补充人工评估:

-

帧质量(Frame Quality):评估单帧的视觉质量,包括美学、成像清晰度和真实感。

-

时间质量(Temporal Quality):评估运动平滑度、时间一致性以及跨帧整体动态真实感。

-

视频-文本对齐(Video-Text Alignment):评估生成视频与用户提供的文本提示的匹配程度。

虽然 VChain 主要旨在增强视频生成中的高层推理能力(例如常识、因果关系和物理规律),但表 1 中的结果表明,它并不会削弱基本的视觉质量。事实上,它常常带来一定的改进。

为了直接评估 VChain 的推理能力,我们沿以下维度进行了针对性的人类研究:

-

物理性(Physics):评估视频是否遵循物理规律,如重力和空气摩擦(例如,石头在空气中比羽毛下落得更快)。参与者对视频遵守物理规律的程度进行评分。

-

常识推理(Commonsense Reasoning):评估视频中的事件是否反映日常现实世界的知识。例如,蓝色颜料与黄色混合后变成绿色,或油漂浮在水面上。用户对视频反映常识的程度进行评分。

-

因果推理(Causal Reasoning):评估视频是否捕捉到适当的因果关系。例如,石头落入水中引起水花,球在枕头上无法弹起,或开关打开灯光。参与者被问到:“该视频在多大程度上反映了初始设置的因果结果?”

人类评估者被展示生成的视频及其对应的输入提示。本文的方法与基线方法的输出以随机顺序展示,以避免偏差。共有 32 名评估者对每个视频在每个评估维度上按 1 到 5 的尺度进行评分。然后将得分取平均并标准化为百分比尺度,如表 1 所示。

VChain 在推理相关维度(如物理性、常识性和因果性)上始终优于基线方法。这些改进展示了我们框架在视频生成推理时集成的有效性。

定性比较

大量的定性结果和比较也在附录中提供。

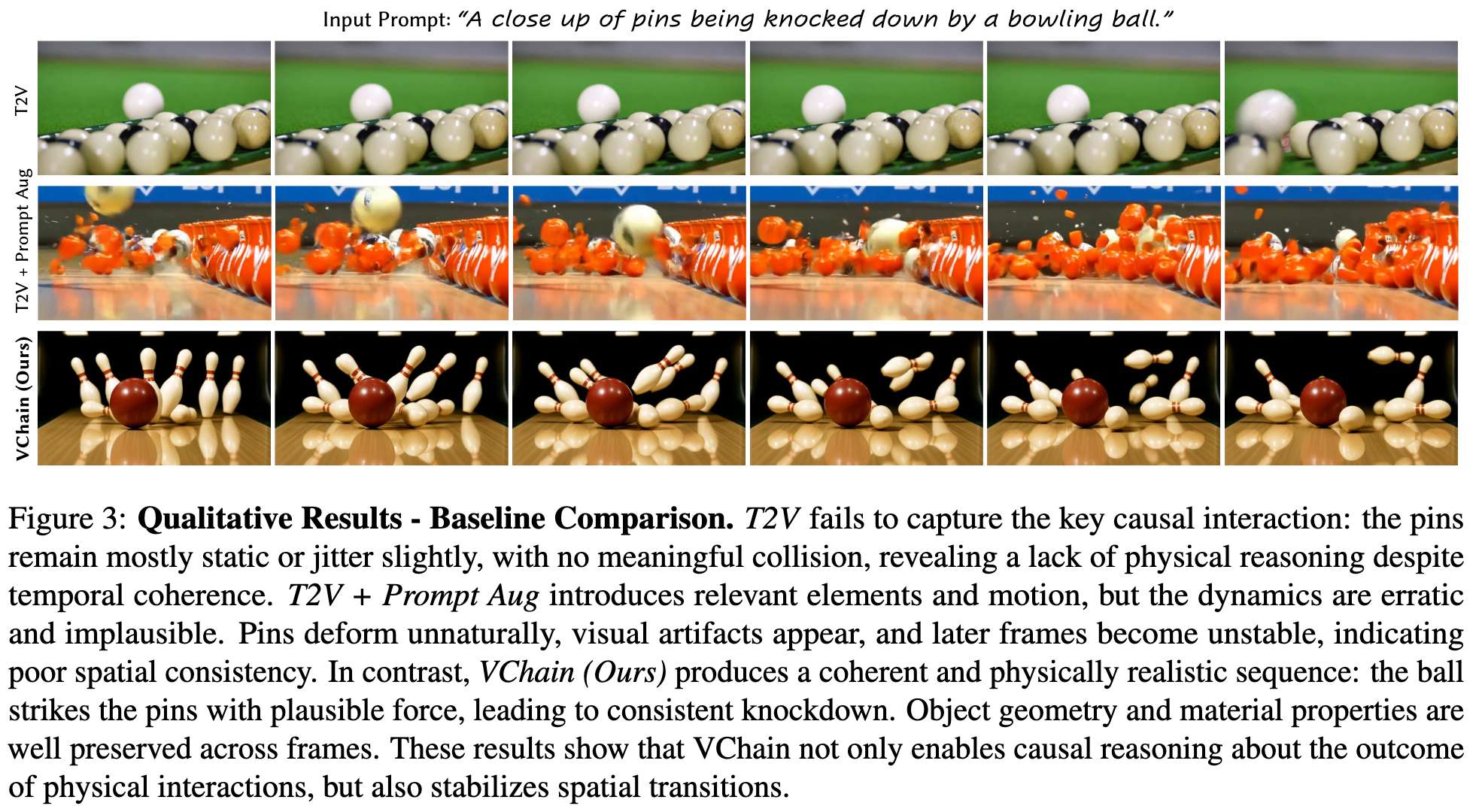

基线比较。 在下图 3 中展示了与基线方法的定性比较。在 T2V 基线中,模型未能产生任何有意义的物理交互:球瓶大多保持静止或仅表现出轻微抖动,没有可见的撞击或倒下。尽管在时间上稳定,但输出与输入提示在语义上不一致,缺乏保龄球击倒球瓶这一关键因果事件。T2V + Prompt Aug 变体引入了球和球瓶,表现出一定程度的碰撞与运动。然而,其动态表现混乱且不符合物理规律。球瓶出现不合理的变形或散落,场景还存在视觉伪影和时间不稳定性,尤其是在后期帧中。相比之下,VChain(我们的)生成了连贯且具有物理基础的序列。保龄球以逼真的冲击击中球瓶,球瓶倒下的方向与预期物理行为一致。这一结果得益于视觉思维链推理(chain-of-visual-thought reasoning),它为模型提供了结构化且具有因果进展的事件序列。此外,物体的几何形状和材质特征得到了良好保留。球瓶与保龄球在视觉上区分明确且渲染准确。

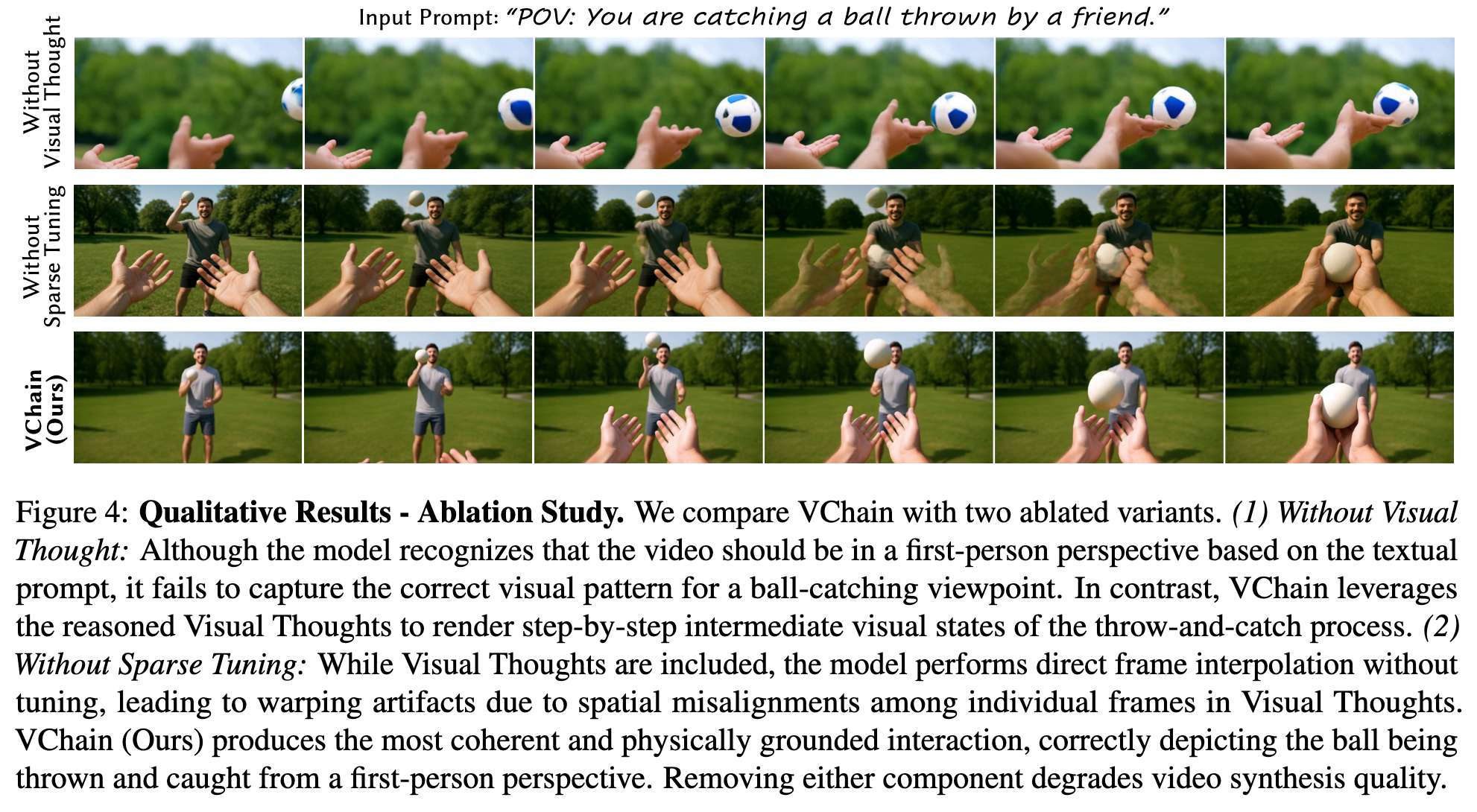

消融研究。 下图4展示VChain 与两个消融变体进行比较: 1)无视觉思维(Without Visual Thought):虽然该变体能够根据文本思维生成第一人称视角,但未能构想出正确的“接球”视觉模式。相比之下,本文的方法得益于直接“看到”视觉思维,从而实现对空间的准确理解与交互渲染。 2)无稀疏微调(Without Sparse Tuning):该变体直接利用视觉思维进行帧插值,但在尝试连接视觉思维关键帧的空间不对齐时,会出现变形伪影。VChain(我们的)生成了最连贯且符合物理规律的交互,准确描绘了投掷和接球的动作。移除任一组件都会导致视频合成质量下降。

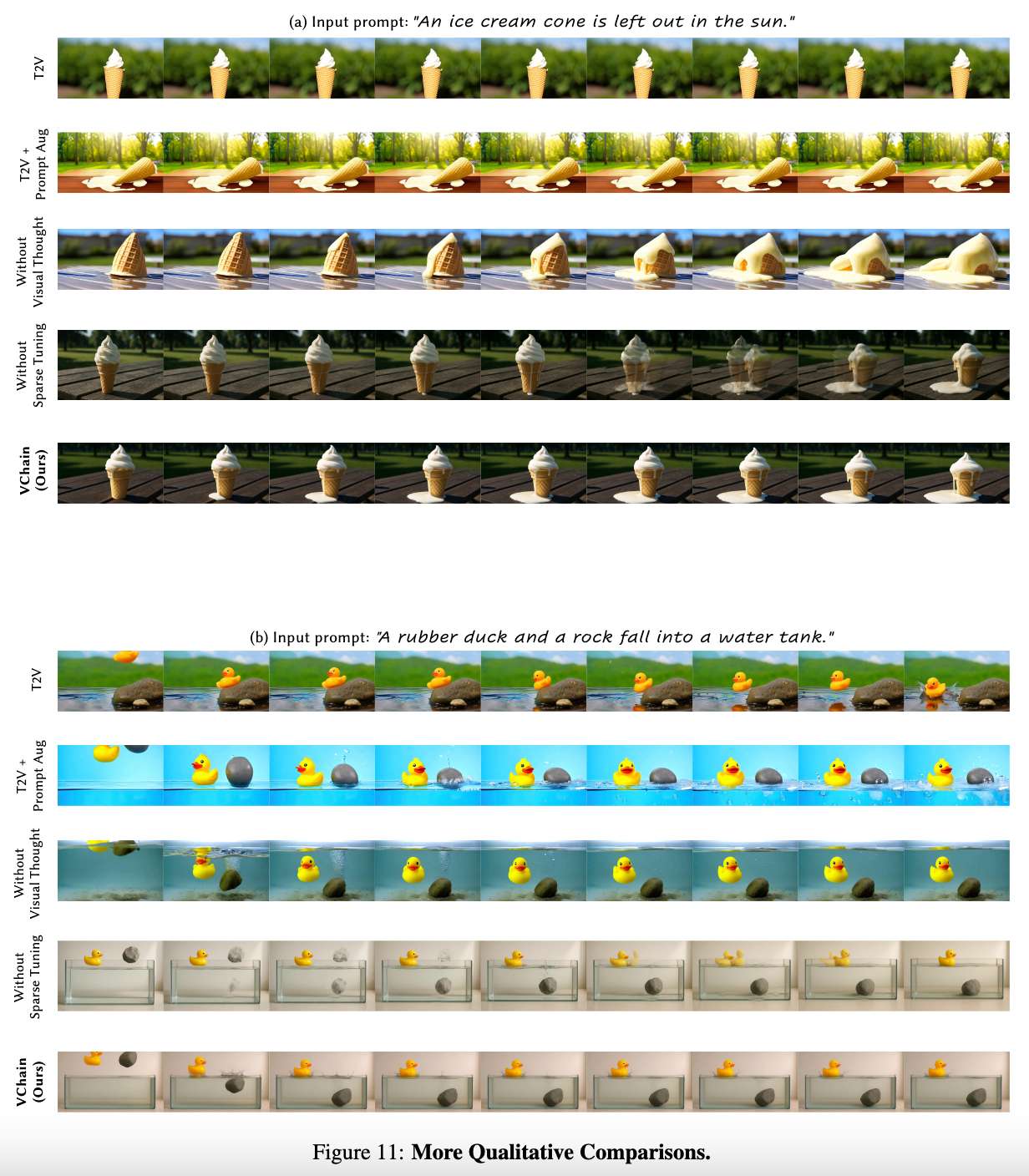

图 11(b) 展示了另一个示例:橡皮鸭与石头掉入水中的情景。在没有视觉思维的情况下,橡皮鸭出现在水下,违背了“橡皮鸭应漂浮于水面”的基本物理直觉。相反,本文的方法正确地描绘了橡皮鸭漂浮在水面上的情景。这强调了在推理阶段引入视觉思维(而不仅仅是文本思维)的重要性:在推理过程中“看到”视觉思维至关重要——需要真正“看到”橡皮鸭如何漂浮在水面上,而不是下沉。我们提供的演示视频展示了更直观的比较。

限制

视觉思维生成的限制

本文的框架继承了当前 GPT-4o 图像生成模型的一些限制。

首先,gpt-image-1 倾向于对编辑后的图像产生轻微的过饱和和过度平滑。由于每个生成的图像都会作为输入传回模型以生成图像序列中的下一帧,这种效果会迭代累积,导致图像序列中出现轻微的黄色偏色和整体过度平滑的现象。该伪影在一定程度上削弱了后续帧的真实感,并在序列中引入轻微的颜色不一致。定性示例在附录中提供。

另一个限制是 API 成本。每个生成的关键帧都需要两次调用 GPT-4o。因此,API 调用总数会随着图像序列长度线性增长,而令牌消耗则呈二次增长。因此,对专有模型的依赖可能会限制没有足够计算预算或 API 配额的用户在可访问性和可复现性方面的能力。尽管如此,实际开销仍较为有限:一次视频的推理阶段推理通常仅需要 3–6 张图像,使得成本保持相对较低。

稀疏推理时微调的限制

本文的方法使用少量关键帧(即视觉思维)作为监督,对预训练的视频生成器进行微调。这种稀疏微调引入了固有的权衡:如果在静态关键帧上优化过强,可能会削弱运动动态性,因为模型主要适应静态图像;而如果优化不足,则可能削弱注入到生成器中的推理信号,使结果更接近未经微调的基线。

尽管存在潜在的权衡,这种稀疏微调策略具有两个主要优点:(1) 聚焦的适应性:模型将容量集中于语义关键的过渡(例如融化、破碎或物体交互),而非重建整个视频序列;(2) 高效性:它消除了对密集视频的需求,显著减少了数据准备与计算开销。这使得本文的方法非常适合在推理阶段集成到现有管线上。

虽然稀疏监督无法完全捕捉视频样本中的动态性,但在语义对齐与因果一致性方面的改进通常超过了动态性的损失。这一范式也挑战了传统假设——即微调需要完整视频序列——表明精心选择的一组关键帧已经能够为视频生成器在适应新提示或场景时提供足够的指导。

结论

VChain,一种在推理阶段将多模态推理融入视频生成的通用框架。通过将场景表示为稀疏的视觉思维序列——由多模态大模型推断出的关键中间状态关键帧——VChain 在推理阶段直接注入因果与常识推理信号。这一范式使视频生成器能够在无需密集标注或昂贵再训练的情况下建模有意义的状态转变。

在复杂的多步骤场景实验中,VChain 显著提升了生成视频的连贯性、因果一致性和合理性,同时保持了高效性与视觉质量。从更广的角度看,VChain 展示了大型多模态模型的推理能力如何与视频生成器的渲染与运动先验有效结合。我们将此框架视为连接“推理”与“生成”的一步,并希望能启发未来关于视频生成推理的进一步研究。

参考文献

[1] VChain: Chain-of-Visual-Thought for Reasoning in Video Generation

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)