AI 人工智能中联邦学习通信效率优化的隐私保护方案

在当今数字化时代,数据是推动 AI 人工智能发展的重要燃料。然而,数据往往分散在不同的机构或个人手中,且由于隐私和安全等问题,不能随意共享。联邦学习作为一种新兴的机器学习范式,允许在不共享原始数据的情况下进行模型训练,解决了数据隐私和安全问题。但联邦学习在通信过程中存在效率低下的问题,影响了其大规模应用。本文旨在探讨如何优化联邦学习的通信效率,同时保障数据的隐私安全,适用于对联邦学习和隐私保护感兴

AI 人工智能中联邦学习通信效率优化的隐私保护方案

关键词:AI 人工智能、联邦学习、通信效率优化、隐私保护方案、数据安全

摘要:本文聚焦于 AI 人工智能领域中联邦学习通信效率优化的隐私保护方案。首先介绍了相关背景知识,包括联邦学习的概念及通信效率和隐私保护的重要性。接着详细解释了核心概念,如联邦学习、通信效率、隐私保护等,并阐述了它们之间的关系。通过数学模型和公式分析通信效率和隐私保护的原理,给出了具体的优化方案及 Python 代码示例。还介绍了该方案在实际中的应用场景,推荐了相关工具和资源,探讨了未来发展趋势与挑战。最后进行总结,提出思考题,方便读者进一步理解和应用所学知识。

背景介绍

目的和范围

在当今数字化时代,数据是推动 AI 人工智能发展的重要燃料。然而,数据往往分散在不同的机构或个人手中,且由于隐私和安全等问题,不能随意共享。联邦学习作为一种新兴的机器学习范式,允许在不共享原始数据的情况下进行模型训练,解决了数据隐私和安全问题。但联邦学习在通信过程中存在效率低下的问题,影响了其大规模应用。本文旨在探讨如何优化联邦学习的通信效率,同时保障数据的隐私安全,适用于对联邦学习和隐私保护感兴趣的研究人员、开发者等。

预期读者

本文预期读者包括对 AI 人工智能、机器学习、数据隐私保护等领域感兴趣的学生、研究人员、开发者以及相关行业从业者。无论你是初学者还是有一定经验的专业人士,都能从本文中获得关于联邦学习通信效率优化和隐私保护的新知识和启发。

文档结构概述

本文首先介绍核心概念,通过故事引入主题,解释联邦学习、通信效率和隐私保护等核心概念及其关系。然后通过数学模型和公式分析原理,给出具体的优化方案和 Python 代码示例。接着介绍实际应用场景,推荐相关工具和资源,探讨未来发展趋势与挑战。最后进行总结,提出思考题,方便读者进一步学习和思考。

术语表

核心术语定义

- 联邦学习:一种机器学习技术,多个参与方在不共享原始数据的情况下,通过交换模型参数等中间结果来共同训练模型。

- 通信效率:指在联邦学习过程中,数据传输的速度和资源利用率,包括传输时间、带宽占用等。

- 隐私保护:确保在联邦学习过程中,参与方的原始数据不被泄露,保护数据所有者的隐私安全。

相关概念解释

- 差分隐私:一种在数据发布和处理过程中添加噪声以保护数据隐私的技术。

- 同态加密:一种允许在加密数据上进行计算的加密技术,计算结果解密后与在原始数据上进行计算的结果相同。

缩略词列表

- FL:联邦学习(Federated Learning)

- DP:差分隐私(Differential Privacy)

- HE:同态加密(Homomorphic Encryption)

核心概念与联系

故事引入

想象一下,有一群小朋友想要一起完成一幅超级大的拼图,但每个小朋友都只能看到自己手中的那一部分拼图,而且不能把自己的拼图给别人看。他们该怎么办呢?这时候,老师想出了一个办法,让每个小朋友根据自己手中的拼图信息,告诉大家一些关于拼图的线索,然后大家一起根据这些线索来拼出完整的拼图。这个过程就有点像联邦学习,每个小朋友的拼图就是自己的数据,不能共享,但可以通过交换信息来共同完成任务。在这个过程中,小朋友们交流线索的速度就相当于通信效率,而不能把自己的拼图给别人看就是隐私保护。

核心概念解释(像给小学生讲故事一样)

- 核心概念一:联邦学习

联邦学习就像刚才说的小朋友拼拼图的游戏。在现实世界中,有很多公司或者机构都有自己的数据,比如医院有病人的病历数据,银行有客户的交易数据。这些数据因为隐私和安全等原因不能随便拿出来分享。但是他们又想一起训练一个强大的 AI 模型,就像小朋友们想拼出完整的拼图一样。联邦学习就提供了一种方法,让他们可以在不共享原始数据的情况下,通过交换模型的一些信息(就像小朋友交换拼图线索)来共同训练模型。 - 核心概念二:通信效率

通信效率就好比是小朋友们交流拼图线索的速度。在联邦学习中,参与方需要不断地交换模型参数等信息。如果通信速度很慢,就像小朋友们交流线索很慢,那么整个拼图(模型训练)的过程就会变得很长。通信效率高,模型训练就可以更快完成,节省时间和资源。 - 核心概念三:隐私保护

隐私保护就像小朋友不能把自己的拼图给别人看一样。在现实生活中,每个人的数据都包含了很多个人隐私信息,比如我们的健康状况、消费习惯等。如果这些数据被泄露,可能会给我们带来很多麻烦。隐私保护就是要确保在联邦学习过程中,参与方的原始数据不会被泄露出去,即使模型信息在交换过程中也不会暴露原始数据的内容。

核心概念之间的关系(用小学生能理解的比喻)

- 概念一和概念二的关系:联邦学习和通信效率就像小朋友拼拼图和交流线索的速度。如果小朋友们交流线索的速度快(通信效率高),那么他们就能更快地拼出完整的拼图(完成联邦学习的模型训练)。反之,如果交流速度慢,拼图的过程就会变得漫长。

- 概念二和概念三的关系:通信效率和隐私保护就像在保证小朋友不把自己的拼图给别人看的前提下,还要让他们快速交流线索。在联邦学习中,我们既要保证数据隐私不被泄露,又要提高通信效率,这就需要找到一个平衡点。就像小朋友们可以用一些加密的语言来交流线索,既不会让别人知道自己的拼图内容,又能快速传达有用的信息。

- 概念一和概念三的关系:联邦学习和隐私保护是相辅相成的。联邦学习的出现就是为了解决数据隐私问题,让参与方在不共享原始数据的情况下进行模型训练。而隐私保护是联邦学习能够正常运行的基础,如果不能保证数据隐私,那么联邦学习就失去了意义。

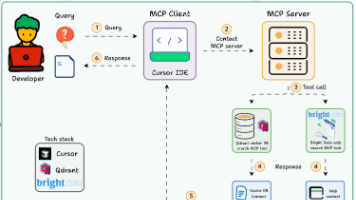

核心概念原理和架构的文本示意图

联邦学习的基本架构包括多个参与方(客户端)和一个中心服务器。参与方在本地使用自己的数据训练模型,然后将模型参数发送给中心服务器。中心服务器对收到的参数进行聚合,得到一个全局模型,再将全局模型发送回参与方。参与方根据全局模型更新自己的本地模型,如此反复迭代,直到模型收敛。在这个过程中,通信效率主要受参数传输的速度和频率影响,隐私保护则通过对数据和参数进行加密、添加噪声等方式实现。

Mermaid 流程图

核心算法原理 & 具体操作步骤

通信效率优化原理

为了优化联邦学习的通信效率,我们可以采用模型压缩、参数聚合优化等方法。模型压缩可以减少需要传输的参数数量,例如使用量化技术将模型参数从浮点数转换为整数,减少数据量。参数聚合优化可以减少参数传输的频率,例如采用异步聚合方式,让参与方在不同时间点上传参数,避免同步等待。

隐私保护原理

隐私保护主要通过差分隐私和同态加密等技术实现。差分隐私通过在模型参数中添加噪声,使得攻击者无法从参数中推断出原始数据的信息。同态加密允许在加密数据上进行计算,在不解密数据的情况下完成模型训练和参数聚合。

具体操作步骤

- 模型压缩:在客户端对本地模型参数进行量化处理,将浮点数参数转换为整数。例如,使用 8 位整数代替 32 位浮点数,减少数据量。

- 参数聚合优化:采用异步聚合方式,参与方在本地模型训练一定步数后,将参数上传到服务器。服务器在收到参数后,立即进行聚合,而不需要等待所有参与方都上传。

- 差分隐私:在客户端上传参数之前,添加高斯噪声,满足差分隐私的要求。

- 同态加密:在服务器和客户端之间使用同态加密算法对参数进行加密传输,确保数据在传输过程中的隐私安全。

Python 代码示例

import numpy as np

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, Dataset

# 模拟客户端数据

class CustomDataset(Dataset):

def __init__(self, data, labels):

self.data = data

self.labels = labels

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

return self.data[idx], self.labels[idx]

# 定义简单的神经网络模型

class SimpleModel(nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.fc1 = nn.Linear(10, 20)

self.fc2 = nn.Linear(20, 2)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

# 模型量化函数

def quantize_model(model, bits=8):

for param in model.parameters():

param.data = torch.round(param.data * (2**bits - 1)) / (2**bits - 1)

return model

# 差分隐私添加噪声

def add_differential_privacy(parameters, epsilon=0.1):

noise = torch.normal(0, 1 / epsilon, parameters.shape)

return parameters + noise

# 模拟联邦学习过程

def federated_learning():

# 初始化多个客户端

num_clients = 3

clients = []

for _ in range(num_clients):

data = torch.randn(100, 10)

labels = torch.randint(0, 2, (100,))

dataset = CustomDataset(data, labels)

dataloader = DataLoader(dataset, batch_size=10, shuffle=True)

model = SimpleModel()

optimizer = optim.SGD(model.parameters(), lr=0.01)

clients.append((dataloader, model, optimizer))

# 中心服务器

global_model = SimpleModel()

num_rounds = 10

for round in range(num_rounds):

client_models = []

for dataloader, model, optimizer in clients:

model.train()

for data, labels in dataloader:

optimizer.zero_grad()

outputs = model(data)

loss = nn.CrossEntropyLoss()(outputs, labels)

loss.backward()

optimizer.step()

# 模型量化

model = quantize_model(model)

# 添加差分隐私噪声

for param in model.parameters():

param.data = add_differential_privacy(param.data)

client_models.append(model.state_dict())

# 服务器聚合模型

global_params = {}

for key in client_models[0].keys():

param_sum = sum([client[key] for client in client_models])

global_params[key] = param_sum / num_clients

global_model.load_state_dict(global_params)

# 客户端更新模型

for _, model, _ in clients:

model.load_state_dict(global_model.state_dict())

return global_model

# 运行联邦学习

final_model = federated_learning()

print("联邦学习训练完成,最终模型已得到。")

数学模型和公式 & 详细讲解 & 举例说明

通信效率优化的数学模型

通信效率主要受传输的数据量和传输次数影响。假设每次传输的数据量为 DDD,传输次数为 NNN,则总的通信量 C=D×NC = D \times NC=D×N。为了优化通信效率,我们可以通过减少 DDD 和 NNN 来实现。

模型压缩

假设原始模型参数为 xxx,量化后的参数为 x^\hat{x}x^。量化过程可以表示为 x^=Q(x)\hat{x} = Q(x)x^=Q(x),其中 QQQ 是量化函数。量化后的数据量 DquantizedD_{quantized}Dquantized 小于原始数据量 DoriginalD_{original}Doriginal,从而减少了通信量。

参数聚合优化

在异步聚合方式中,假设参与方的上传时间为 t1,t2,⋯ ,tnt_1, t_2, \cdots, t_nt1,t2,⋯,tn,服务器的聚合时间为 TaggT_{agg}Tagg。总通信时间 TtotalT_{total}Ttotal 可以表示为 Ttotal=max(t1,t2,⋯ ,tn)+TaggT_{total} = \max(t_1, t_2, \cdots, t_n) + T_{agg}Ttotal=max(t1,t2,⋯,tn)+Tagg,相比于同步聚合方式,减少了等待时间。

隐私保护的数学模型

差分隐私

差分隐私通过添加噪声来保护数据隐私。假设原始数据为 xxx,添加噪声后的数据为 x′x'x′。差分隐私的定义为:对于任意两个相邻数据集 D1D_1D1 和 D2D_2D2,以及任意输出 SSS,满足 Pr[M(D1)∈S]≤eϵPr[M(D2)∈S]Pr[M(D_1) \in S] \leq e^{\epsilon} Pr[M(D_2) \in S]Pr[M(D1)∈S]≤eϵPr[M(D2)∈S],其中 MMM 是一个随机算法,ϵ\epsilonϵ 是隐私预算。

同态加密

同态加密允许在加密数据上进行计算。假设明文数据为 mmm,加密后的密文为 c=E(m)c = E(m)c=E(m),其中 EEE 是加密函数。在加密数据上进行计算 f(c)f(c)f(c),解密后得到的结果 D(f(c))D(f(c))D(f(c)) 与在明文数据上进行计算 f(m)f(m)f(m) 的结果相同,即 D(f(c))=f(m)D(f(c)) = f(m)D(f(c))=f(m),其中 DDD 是解密函数。

举例说明

假设我们有一个简单的线性回归模型 y=wx+by = wx + by=wx+b,其中 www 和 bbb 是模型参数。原始参数 w=2.5w = 2.5w=2.5,b=1.2b = 1.2b=1.2。在模型量化过程中,我们将参数转换为 8 位整数,www 量化后为 2,bbb 量化后为 1,减少了数据量。在差分隐私保护中,我们添加高斯噪声,假设 ϵ=0.1\epsilon = 0.1ϵ=0.1,噪声的标准差为 1/ϵ=101 / \epsilon = 101/ϵ=10。我们从高斯分布中采样一个噪声值 n=1.5n = 1.5n=1.5,则添加噪声后的参数 w′=w+n=2.5+1.5=4w' = w + n = 2.5 + 1.5 = 4w′=w+n=2.5+1.5=4,b′=b+n=1.2+1.5=2.7b' = b + n = 1.2 + 1.5 = 2.7b′=b+n=1.2+1.5=2.7,使得攻击者难以从参数中推断出原始数据的信息。

项目实战:代码实际案例和详细解释说明

开发环境搭建

- 安装 Python:建议使用 Python 3.7 及以上版本,可以从 Python 官方网站下载安装。

- 安装 PyTorch:PyTorch 是一个常用的深度学习框架,可以使用以下命令安装:

pip install torch torchvision

源代码详细实现和代码解读

数据集和模型定义

# 模拟客户端数据

class CustomDataset(Dataset):

def __init__(self, data, labels):

self.data = data

self.labels = labels

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

return self.data[idx], self.labels[idx]

# 定义简单的神经网络模型

class SimpleModel(nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.fc1 = nn.Linear(10, 20)

self.fc2 = nn.Linear(20, 2)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

CustomDataset类用于模拟客户端的数据集,包含数据和标签。SimpleModel类定义了一个简单的两层神经网络模型,用于分类任务。

模型量化和差分隐私

# 模型量化函数

def quantize_model(model, bits=8):

for param in model.parameters():

param.data = torch.round(param.data * (2**bits - 1)) / (2**bits - 1)

return model

# 差分隐私添加噪声

def add_differential_privacy(parameters, epsilon=0.1):

noise = torch.normal(0, 1 / epsilon, parameters.shape)

return parameters + noise

quantize_model函数将模型参数进行量化,减少数据量。add_differential_privacy函数在模型参数中添加高斯噪声,实现差分隐私保护。

联邦学习过程

# 模拟联邦学习过程

def federated_learning():

# 初始化多个客户端

num_clients = 3

clients = []

for _ in range(num_clients):

data = torch.randn(100, 10)

labels = torch.randint(0, 2, (100,))

dataset = CustomDataset(data, labels)

dataloader = DataLoader(dataset, batch_size=10, shuffle=True)

model = SimpleModel()

optimizer = optim.SGD(model.parameters(), lr=0.01)

clients.append((dataloader, model, optimizer))

# 中心服务器

global_model = SimpleModel()

num_rounds = 10

for round in range(num_rounds):

client_models = []

for dataloader, model, optimizer in clients:

model.train()

for data, labels in dataloader:

optimizer.zero_grad()

outputs = model(data)

loss = nn.CrossEntropyLoss()(outputs, labels)

loss.backward()

optimizer.step()

# 模型量化

model = quantize_model(model)

# 添加差分隐私噪声

for param in model.parameters():

param.data = add_differential_privacy(param.data)

client_models.append(model.state_dict())

# 服务器聚合模型

global_params = {}

for key in client_models[0].keys():

param_sum = sum([client[key] for client in client_models])

global_params[key] = param_sum / num_clients

global_model.load_state_dict(global_params)

# 客户端更新模型

for _, model, _ in clients:

model.load_state_dict(global_model.state_dict())

return global_model

# 运行联邦学习

final_model = federated_learning()

print("联邦学习训练完成,最终模型已得到。")

federated_learning函数模拟了联邦学习的整个过程,包括客户端本地训练、模型量化、添加差分隐私噪声、服务器聚合模型和客户端更新模型等步骤。

代码解读与分析

- 代码通过模拟多个客户端和一个中心服务器,实现了联邦学习的基本流程。

- 模型量化和差分隐私的添加在客户端进行,减少了通信量并保护了数据隐私。

- 服务器通过聚合客户端的模型参数,得到全局模型,并将全局模型发送回客户端进行更新。

实际应用场景

医疗领域

在医疗领域,不同医院拥有大量的患者病历数据,但由于隐私和安全原因,不能直接共享。通过联邦学习,可以在不泄露患者隐私的情况下,联合多家医院的数据训练一个更准确的疾病诊断模型。例如,多家医院可以共同训练一个癌症诊断模型,提高癌症诊断的准确率。

金融领域

金融机构拥有大量的客户交易数据,这些数据包含了客户的隐私信息。联邦学习可以让金融机构在不共享原始数据的情况下,进行风险评估、反欺诈等模型的训练。例如,多家银行可以联合训练一个反欺诈模型,识别异常交易行为,提高金融安全。

物联网领域

物联网设备产生了大量的数据,但这些数据往往分散在不同的设备和用户手中。联邦学习可以在不传输原始数据的情况下,对物联网设备进行模型训练,提高设备的智能化水平。例如,智能家居设备可以通过联邦学习共同训练一个智能控制模型,实现更智能的家居控制。

工具和资源推荐

工具

- TensorFlow Federated:是 Google 开发的一个用于联邦学习的开源框架,提供了丰富的工具和接口,方便开发者进行联邦学习的开发和实验。

- PySyft:是一个基于 PyTorch 的隐私保护深度学习框架,支持联邦学习、差分隐私等隐私保护技术,易于使用和扩展。

资源

- 《Federated Learning: Challenges, Methods, and Future Directions》:一篇关于联邦学习的综述论文,详细介绍了联邦学习的概念、挑战、方法和未来发展方向。

- GitHub 上的联邦学习开源项目:可以在 GitHub 上搜索相关的联邦学习开源项目,学习他人的代码和经验。

未来发展趋势与挑战

发展趋势

- 与其他技术的融合:联邦学习将与区块链、边缘计算等技术融合,进一步提高数据的安全性和通信效率。例如,区块链可以提供可信的分布式账本,确保数据的不可篡改和可追溯性;边缘计算可以在设备端进行模型训练,减少数据传输量。

- 应用领域的拓展:联邦学习将在更多领域得到应用,如教育、交通、能源等。随着数据隐私意识的提高,越来越多的行业将采用联邦学习技术来解决数据隐私和安全问题。

挑战

- 通信效率的进一步优化:虽然目前已经有一些通信效率优化方法,但在大规模应用中,通信效率仍然是一个瓶颈。需要进一步研究更高效的通信协议和算法,减少通信开销。

- 隐私保护的加强:随着攻击技术的不断发展,隐私保护面临着更大的挑战。需要研究更强大的隐私保护技术,确保在复杂的攻击环境下数据的安全性。

总结:学到了什么?

核心概念回顾

- 联邦学习:是一种在不共享原始数据的情况下进行模型训练的机器学习范式,解决了数据隐私和安全问题。

- 通信效率:指联邦学习过程中数据传输的速度和资源利用率,通过模型压缩、参数聚合优化等方法可以提高通信效率。

- 隐私保护:通过差分隐私、同态加密等技术,确保在联邦学习过程中数据的隐私安全。

概念关系回顾

联邦学习和通信效率相互影响,通信效率的提高可以加速联邦学习的模型训练过程。通信效率和隐私保护需要找到一个平衡点,在保证数据隐私的前提下提高通信效率。联邦学习的出现是为了解决数据隐私问题,隐私保护是联邦学习能够正常运行的基础。

思考题:动动小脑筋

思考题一

在医疗领域应用联邦学习时,如何进一步优化通信效率,同时确保患者数据的隐私安全?

思考题二

除了文中提到的应用场景,你能想到联邦学习在其他哪些领域有应用潜力?如何实现?

附录:常见问题与解答

问题一:联邦学习和传统机器学习有什么区别?

联邦学习和传统机器学习的主要区别在于数据的使用方式。传统机器学习需要将所有数据集中到一个地方进行训练,而联邦学习允许参与方在不共享原始数据的情况下进行模型训练,解决了数据隐私和安全问题。

问题二:模型量化和差分隐私会影响模型的性能吗?

模型量化和差分隐私会在一定程度上影响模型的性能。模型量化会降低模型的精度,差分隐私添加的噪声也会影响模型的准确性。但通过合理的参数选择和优化,可以在保证数据隐私和通信效率的前提下,将性能损失控制在可接受的范围内。

扩展阅读 & 参考资料

- 《Federated Learning: Challenges, Methods, and Future Directions》

- TensorFlow Federated 官方文档:https://www.tensorflow.org/federated

- PySyft 官方文档:https://pysyft.readthedocs.io/en/latest/

- GitHub 上的联邦学习开源项目:https://github.com/search?q=federated+learning

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)