生成式隐式记忆!Agent记忆的第三种可能?

本文提出MemGen框架,通过动态生成式隐式记忆机制解决LLM智能体记忆系统的核心挑战。MemGen由记忆触发器(决策调用时机)和记忆编织器(生成并整合记忆)组成,在完全不修改主模型参数的前提下,实现推理与记忆的深度耦合。实验表明,MemGen在跨领域任务中性能最高超过全参数微调方法13.4%,并展现出卓越的泛化能力和持续学习稳定性。分析还发现MemGen能自发形成功能分化的记忆结构(规划记忆、程

作者:Guibin Zhang

原文:https://mp.weixin.qq.com/s/pqCPoUw0p2oTsnMUj9t2mw

>> 加入青稞AI技术交流群,与青年AI研究员/开发者交流最新AI技术

导语

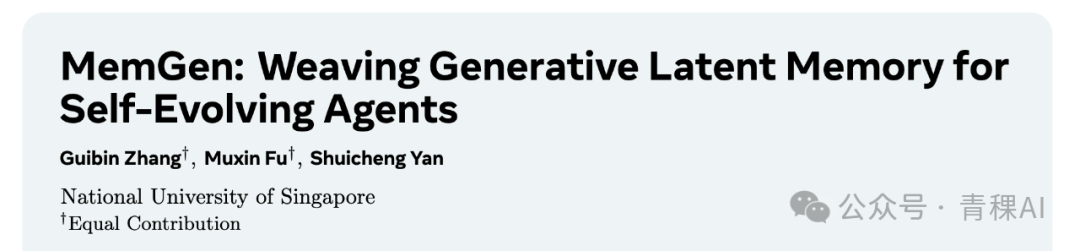

由大型语言模型(LLM)驱动的智能体(Agent)的进化路径,其核心在于记忆机制的构建。现有范式主要分为两类:

其一为参数化记忆(Parametric Memory),它通过修改模型权重来内化经验,但面临灾难性遗忘的风险;

其二为基于检索的记忆(Retrieval-based Memory),它将经验外化,虽保留了模型的通用性,却受限于僵化的“检索-注入”流程,未能实现记忆与推理的深度融合。

为突破此瓶颈,新加坡国立大学的研究团队提出了MemGen框架。该框架引入了一种动态的、生成式的隐式记忆(Latent Memory)机制。MemGen的核心由记忆触发器(Memory Trigger)与记忆编织器(Memory Weaver)构成,二者协同作用,在推理时按需生成并整合与当前认知状态高度相关的隐式记忆。

在不对主模型进行任何任何微调的前提下,MemGen只将外部知识注入到外部记忆模块,并在解码时动态注入,所实现的性能最高超过全参数量微调的GRPO高达13.4%。

论文:MemGen: Weaving Generative Latent Memory for Self-Evolving Agents

链接:https://arxiv.org/abs/2509.24704

代码:https://github.com/KANABOON1/MemGen

01. 研究背景与动机

LLM驱动智能体的能力涌现,激发了对“自进化”机制的探索,其中记忆扮演着枢轴角色。当前主流的记忆实现路径存在固有矛盾:

-

• 参数化记忆:该范式通过直接微调(如SFT, DPO, GRPO)将经验轨迹编码至模型参数

θ中。此方法虽能深度内化知识,但其对模型参数的侵入式修改,不可避免地导致了通用能力的衰减,即灾难性遗忘(Catastrophic Forgetting)。 -

• 基于检索的记忆:此范式将经验外化存储于数据库,在推理时通过上下文工程(Context Engineering)注入相关信息。它虽通过非侵入性设计规避了灾难性遗忘,但其执行流程通常是静态的:在任务初始阶段进行一次性检索,并将结果作为前缀附加于输入。这种机制未能捕捉到人类认知中,记忆与推理过程动态、实时、相互影响的流体特性。

现有范式的局限性揭示了两个核心科学问题:

-

记忆与推理的耦合:如何超越静态的上下文注入,实现记忆与推理过程在每一个思考步骤中的无缝交织与动态重塑?

-

记忆的生成性:如何从依赖基于相似性的“提取式”记忆,转向能够根据当前认知需求“生成式”重构新颖、连贯见解的记忆?

这些挑战促使我们探索智能体记忆的第三种实现可能,即动态生成式隐式记忆。

02. MemGen 框架解析

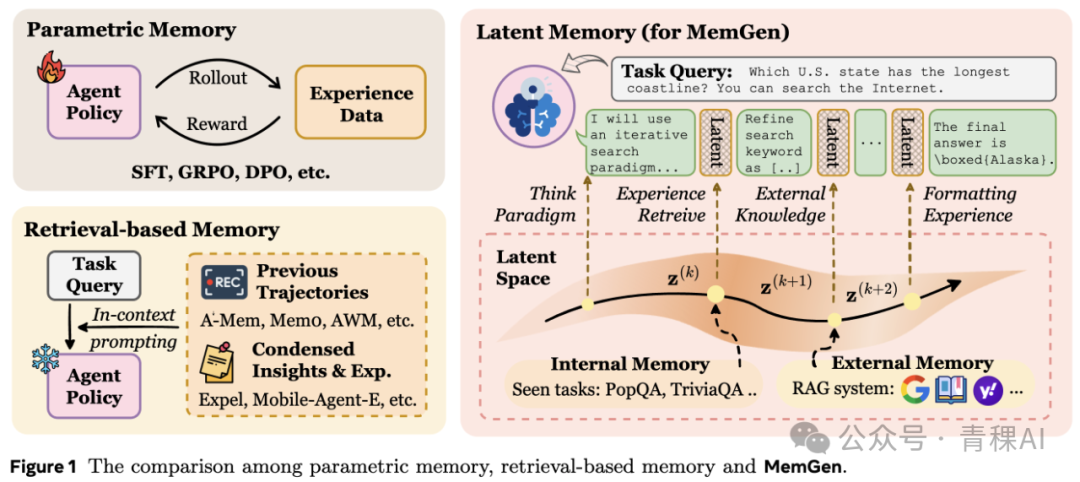

MemGen旨在构建一个动态、生成式的记忆框架,其核心由两个协同工作的轻量级模块构成:一个基于强化学习(RL)训练的记忆触发器(Memory Trigger)和一个记忆编织器(Memory Weaver)。

2.1 记忆触发器 (Memory Trigger):决策记忆调用的时机

记忆触发器在框架中扮演元认知决策单元的角色。对于一个由参数 表征的核心推理器 ,在进行自回归token生成时,其内部认知状态可由隐藏状态序列 来表征。记忆触发器的核心功能,便是在每个解码步骤 ,持续监控截至此刻的状态序列 ,并决策是否需要调用记忆。

该触发器被实现为一个低秩适配器(LoRA)。它将 映射为一个调用概率:

并从中采样一个二元决策:

其中 。为平衡计算效率与语义连贯性,我们引入了句子粒度的激活策略,仅在生成特定分隔符(如句号、逗号)时激活决策过程。触发器的训练基于强化学习,其目标函数旨在最大化任务回报的同时,通过一个自适应惩罚项来鼓励稀疏且高效的记忆调用。

2.2 记忆编织器 (Memory Weaver):合成并注入隐式记忆

一旦触发器发出 信号,推理过程将暂停,并激活记忆编织器。该模块接收与触发器相同的认知状态 作为输入,并执行一次生成性回忆。

编织器的任务是合成一段定制化的、机器原生的隐式记忆 。这是一个由 个Latent Token构成的序列:

其信息来源可以是编织器自身的参数化知识,也可以融合外部检索系统返回的文本线索。重要的是, 的生成过程是一种选择性的重构与整合 (selective reconstruction),而非对历史信息的简单复述。

记忆生成后,将被无缝地注入当前推理上下文。具体而言, 的隐藏状态表示会被后缀 到推理器当前的隐藏状态序列中,形成一个被记忆增强了的全新认知状态。随后,推理器 在此增强状态的基础上恢复自回归生成。

2.3 模块化训练与推理循环

通过上述机制,MemGen构建了一个 “生成-监控-调用-编织-再整合” 的迭代循环,将智能体的推理过程从线性的单向展开,提升为与记忆之间递归式的双向对话。

记忆编织器作为一个独立的、由参数 表征的模块,承载了所有经验的学习与内化。其更新过程可兼容多种优化策略,无论是基于专家轨迹的监督微调(SFT),还是基于奖励信号的强化学习算法(如GRPO),均可适用。在训练过程中,优化算法产生的梯度被严格约束在记忆编织器 内部,而核心推理器 的参数始终保持冻结。这种设计不仅从根本上规避了灾难性遗忘,更确保了核心LLM强大的通用能力得以完整保留。

03. 实验验证与分析

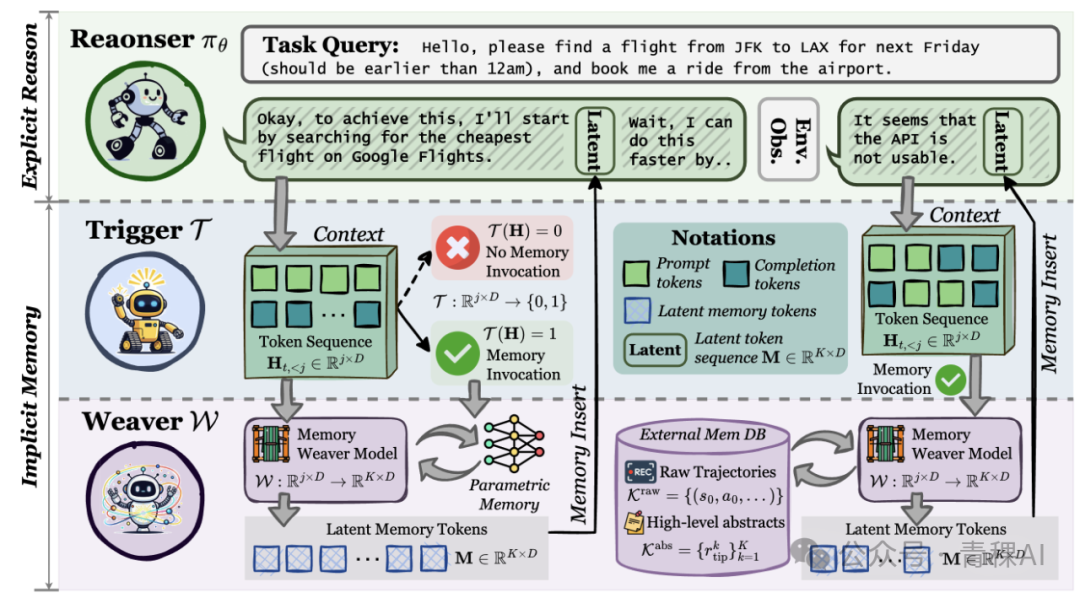

我们在涵盖五大领域(网页搜索、具身行动、数学推理、科学推理、代码生成)的九个基准数据集上进行了综合评估。

3.1 跨领域的性能表现 (RQ1)

实验结果表明,MemGen在所有评估领域中均展现出一致且卓越的效能。在ALFWorld+SmolLM3-3B基准上,MemGen相较于基线模型带来了最高达44.64%的性能提升。在更大规模的Qwen3-8B模型上,MemGen的效能同样显著超越了GRPO 和 REINFORCE++ 等微调方法,证明了其架构的优越性。

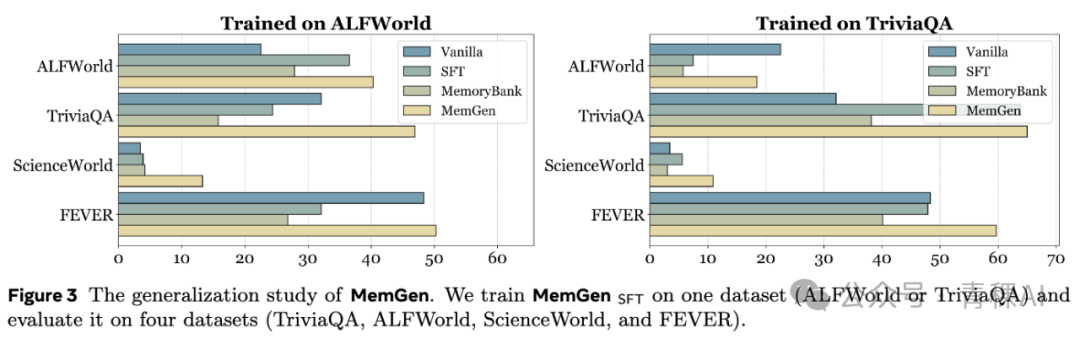

3.2 跨领域泛化能力 (RQ2)

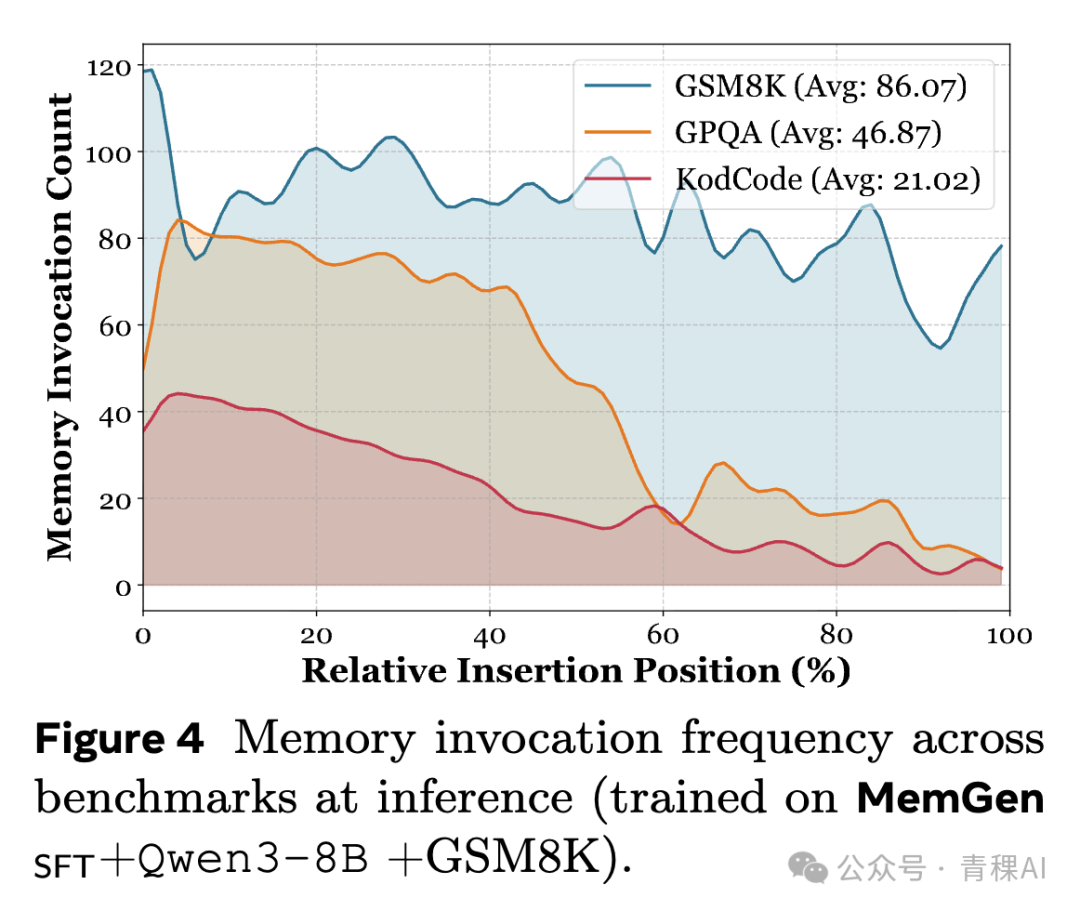

我们通过在单一任务域训练,并迁移至多个未见任务域进行评估,来考察模型的泛化能力。

实验显示,SFT等基线方法在跨领域迁移时性能出现显著衰减。与之相反,MemGen不仅在域内取得进步,更表现出有效的正向知识迁移。对调用门控的激活频率分析揭示,该模块形成了一种自适应调用策略,能够通过调节记忆注入的频率来主动缓解领域冲突带来的负迁移风险。

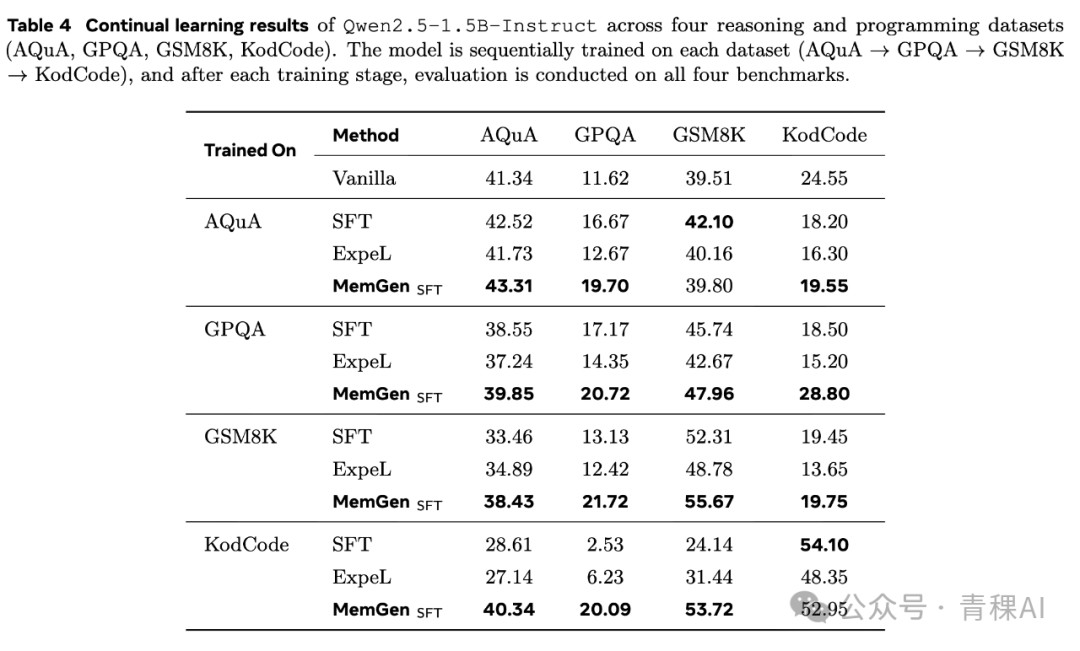

3.3 持续学习与灾难性遗忘 (RQ3)

我们通过在四个数据集上的顺序训练来评估模型的持续学习能力。

相较于基线方法,MemGen表现出更强的知识保留能力。在完成所有序列训练后,MemGen在早期任务上的性能保持率显著高于SFT(例如在AQuA任务上为40.34% vs 28.61%),证明了其架构在持续学习场景下的稳定性。

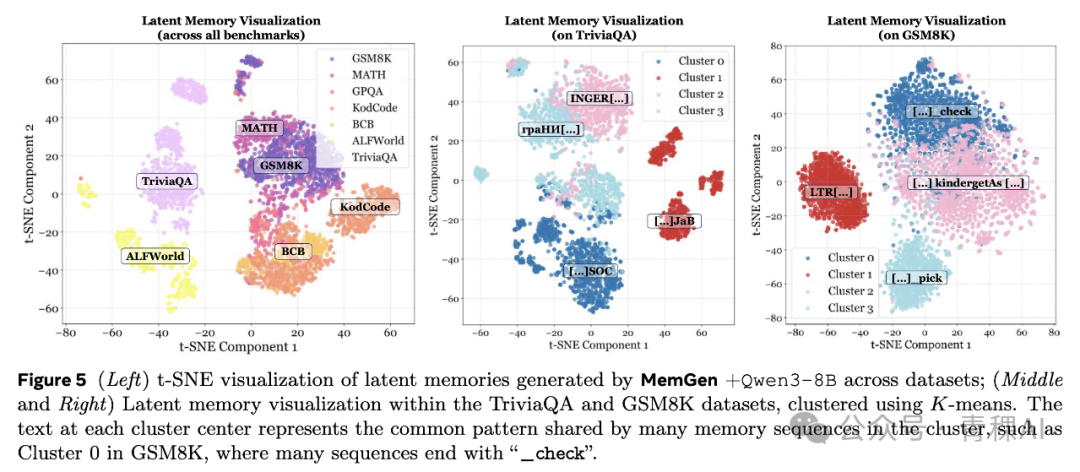

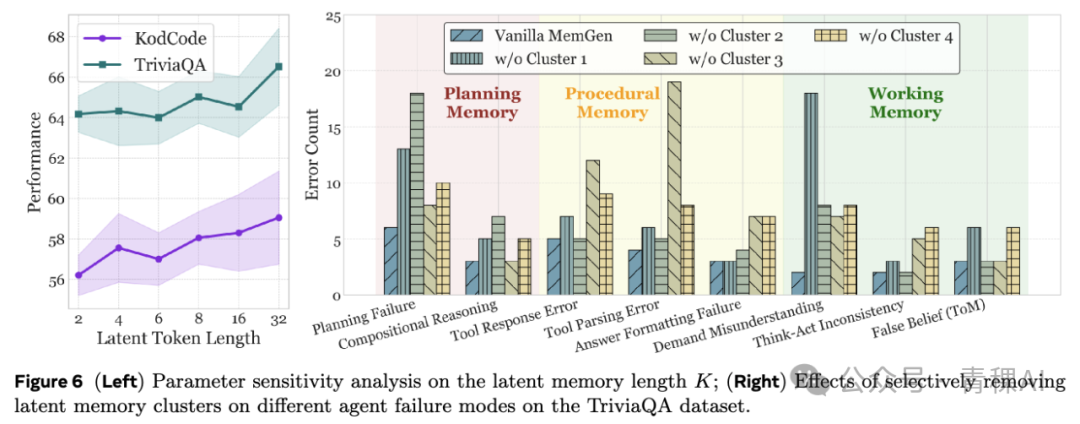

3.4 隐式记忆的层次化结构 (RQ4)

我们对MemGen学到的隐式记忆进行了t-SNE可视化与功能性分析。可视化结果显示,不同领域的记忆在隐空间中形成了清晰的簇结构。

通过一项功能性消融分析(Functional Ablation Analysis),我们进一步揭示了不同记忆簇的功能特化。通过在推理时选择性地屏蔽特定簇的记忆,并观察智能体失败模式的变化,我们发现MemGen自发地学习并组织出了一个类人的、功能分化的记忆体系结构:

-

• 规划记忆 (Planning Memory):支持高级任务规划与战略推理。移除该簇会显著增加规划失败的概率。

-

• 程序记忆 (Procedural Memory):编码操作性知识,如工具使用和答案格式化。移除该簇会导致工具调用及格式化错误的显著增加。

-

• 工作记忆 (Working Memory):负责维持上下文连贯性。移除该簇会导致更多的任务误解与推理不一致。

这一发现强有力地证明,MemGen不仅存储信息,更是以一种功能上专门化、有组织的方式来学习和利用记忆。

04. 结论

本文提出了MemGen,一个为LLM智能体设计的动态生成式记忆框架。通过memory trigger和生成式memory weaver的协同作用,MemGen在完全非侵入式的前提下,实现了推理与记忆合成的深度耦合。

广泛的实验证明,MemGen在运行效能、泛化能力及持续学习方面均取得了显著的优势。更重要的是,我们首次观察到智能体能够在隐式记忆空间中自发学习到功能明确的、层次化的认知结构。这些结果为构建能够实现更接近生物智能的、具备流体般重构能力的自进化计算智能体,提供了一条极具前景的架构路径。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)