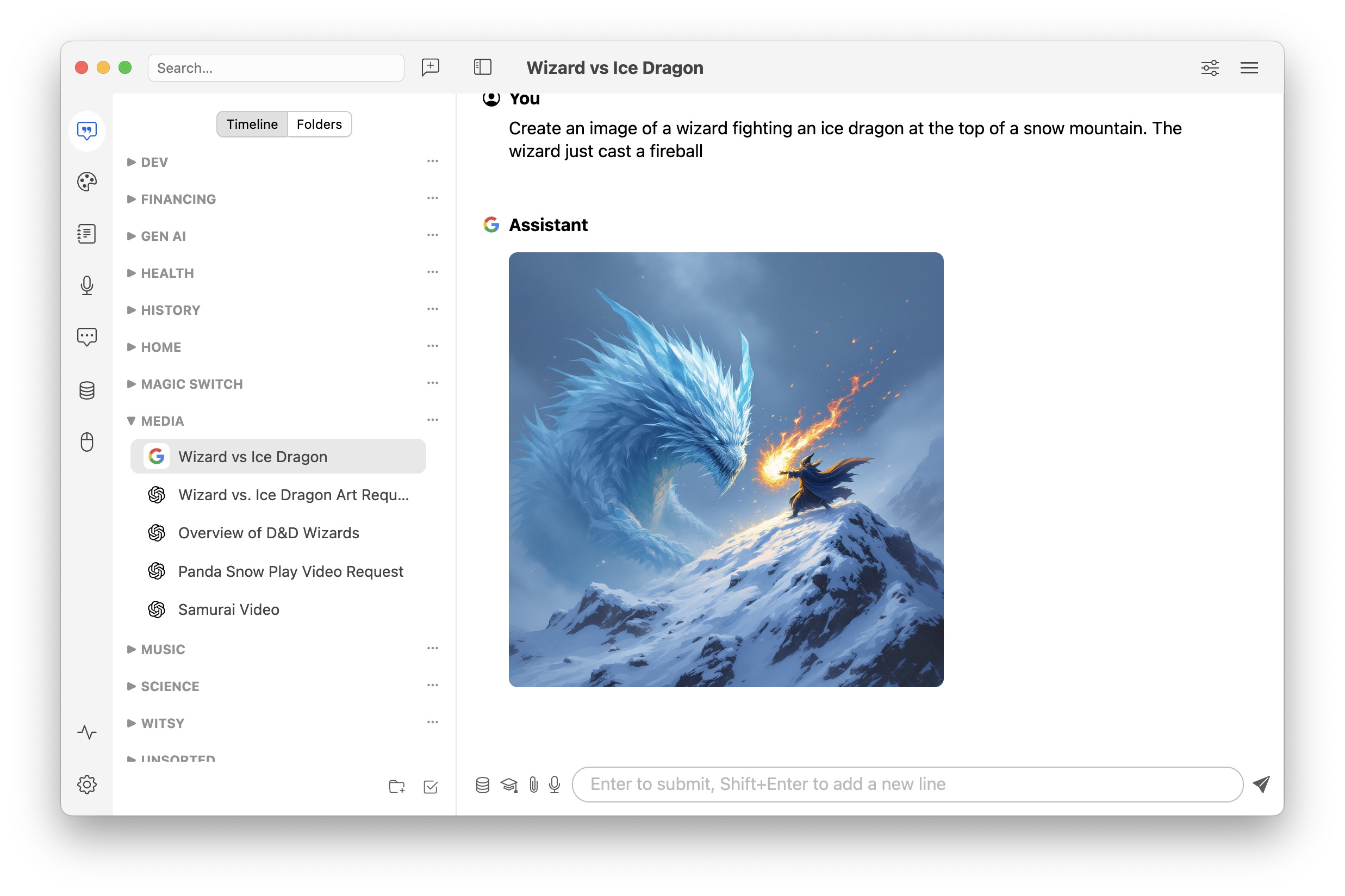

Witsy: 桌面 AI 助手 / 通用 MCP 客户端

Witsy 是一个 BYOK(自带密钥)AI 应用:这意味着你需要有你想使用的 LLM 提供者的 API 密钥。或者,你可以使用 Ollama 在本地机器上免费运行模型,并在 Witsy 中使用它们。它是极少数(仅?)通用 MCP 客户端中的第一个

一、软件介绍

文末提供程序和源码下载

Witsy 是一个 BYOK(自带密钥)AI 应用:这意味着你需要有你想使用的 LLM 提供者的 API 密钥。或者,你可以使用 Ollama 在本地机器上免费运行模型,并在 Witsy 中使用它们。

它是极少数(仅?)通用 MCP 客户端中的第一个:

二、支持的 AI 提供者

支持的 AI 提供者

| Capability 能力 | Providers 提供者 |

|---|---|

| Chat 聊天 | OpenAI, Anthropic, Google (Gemini), xAI (Grok), Meta (Llama), Ollama, LM Studio, MistralAI, DeepSeek, OpenRouter, Groq, Cerebras, Azure OpenAI, any provider who supports the OpenAI API standard OpenAI、Anthropic、Google(Gemini)、xAI(Grok)、Meta(Llama)、Ollama、LM Studio、MistralAI、DeepSeek、OpenRouter、Groq、Cerebras、Azure OpenAI,任何支持 OpenAI API 标准的供应商 |

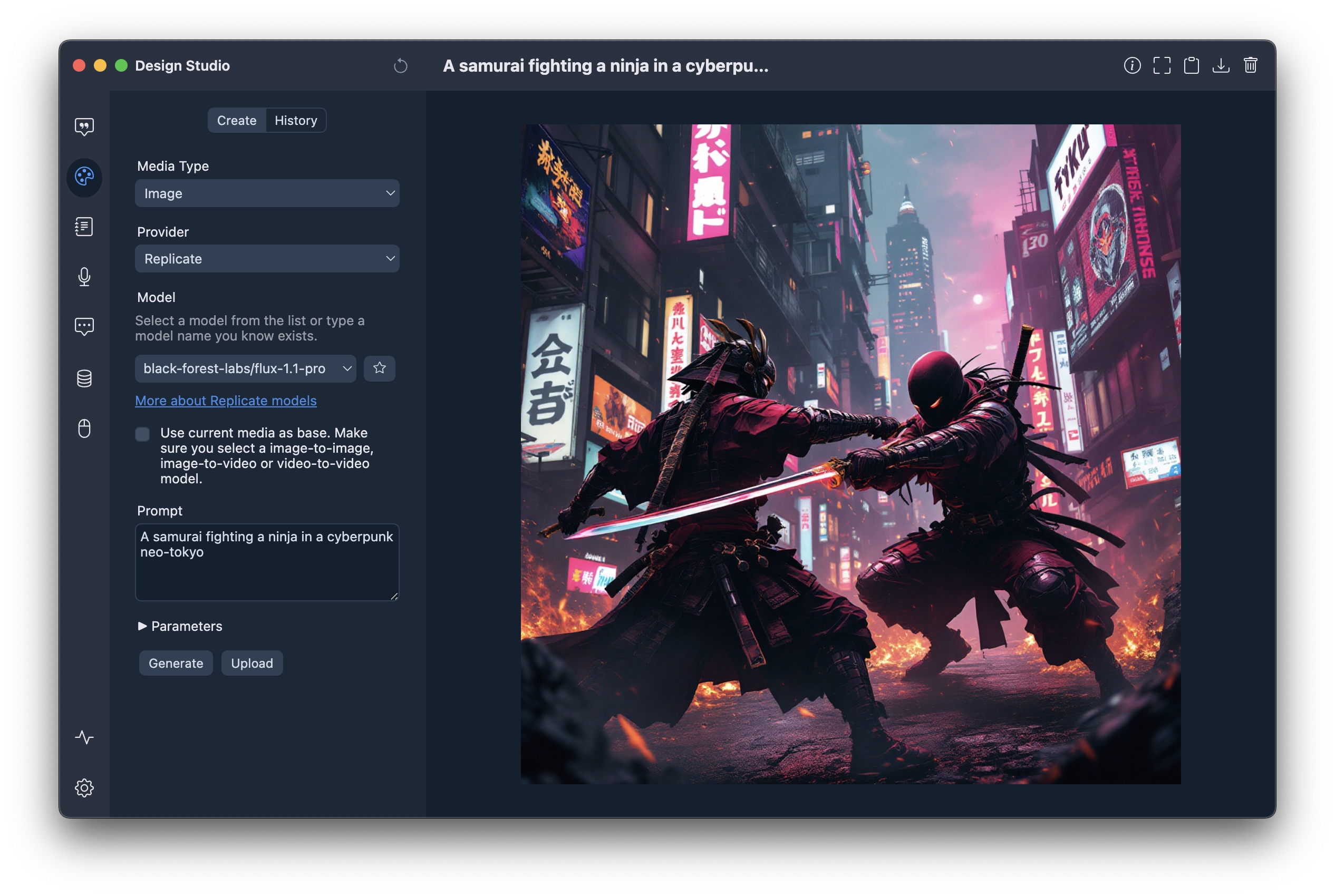

| Image Creation 图像创建 | OpenAI (DALL-E), Google (Imagen), xAI (Grok), Replicate, fal.ai, HuggingFace, Stable Diffusion WebUI |

| Video Creation 视频创建 | Replicate, fal.ai |

| Text-to-Speech 文本转语音 | OpenAI, ElevenLabs, Groq OpenAI、ElevenLabs、Groq |

| Speech-to-Text 语音转文本 | OpenAI (Whisper), fal.ai, Fireworks.ai, Gladia, Groq, nVidia, Speechmatics, Local Whisper, Soniox (realtime and async) any provider who supports the OpenAI API standard OpenAI (Whisper)、fal.ai、Fireworks.ai、Gladia、Groq、nVidia、Speechmatics、Local Whisper、Soniox (实时和异步) 任何支持 OpenAI API 标准的提供者 |

| Search Engines 搜索引擎 | Tavily, Brave, Exa, Local Google Search Tavily, Brave, Exa, 本地谷歌搜索 |

| MCP Repositories MCP 仓库 | Smithery.ai |

| Embeddings 嵌入 | OpenAI, Ollama |

Non-exhaustive feature list:

非详尽功能列表:

Chat completion with vision models support (describe an image)

支持视觉模型的聊天完成(描述图像)- Text-to-image and text-to video

文本到图像和文本到视频 - Image-to-image (image editing) and image-to-video

图像到图像(图像编辑)和图像到视频 - LLM plugins to augment LLM: execute python code, search the Internet...

LLM 插件增强 LLM:执行 Python 代码,搜索互联网... - Anthropic MCP server support

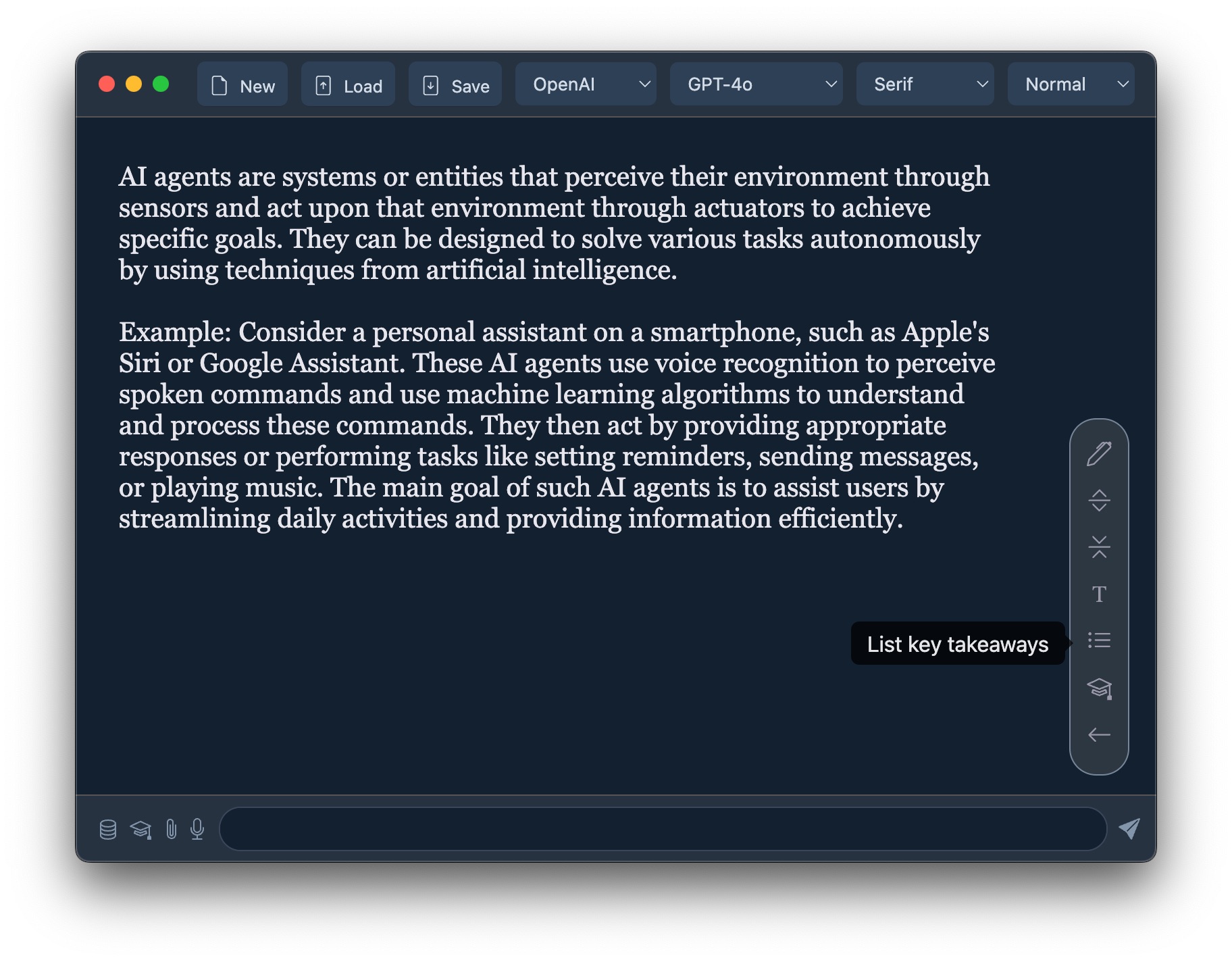

Anthropic MCP 服务器支持 - Scratchpad to interactively create the best content with any model!

交互式创建最佳内容,使用任何模型! - Prompt anywhere allows to generate content directly in any application

Prompt anywhere 允许在任何应用程序中直接生成内容 - AI commands runnable on highlighted text in almost any application

几乎在任何应用程序中,都可以在突出显示的文本上运行 AI 命令 - Experts prompts to specialize your bot on a specific topic

专家提示,使您的机器人专注于特定主题 - Long-term memory plugin to increase relevance of LLM answers

长期记忆插件,提高 LLM 回答的相关性 - Read aloud of assistant messages

朗读助手消息 - Read aloud of any text in other applications

朗读其他应用程序中的任何文本 - Chat with your local files and documents (RAG)

与您的本地文件和文档聊天(RAG) - Transcription/Dictation (Speech-to-Text)

语音转文字 - Realtime Chat aka Voice Mode

实时聊天(即语音模式) - Anthropic Computer Use support

Anthropic 计算机使用支持 - Local history of conversations (with automatic titles)

对话的本地历史记录(自动标题) - Formatting and copy to clipboard of generated code

生成代码的格式化和复制到剪贴板 - Conversation PDF export 对话的 PDF 导出

- Image copy and download

图片复制和下载

任何地方的提示

Generate content in any application:

在任何应用程序中生成内容:

- From any editable content in any application

从任何应用程序中的任何可编辑内容 - Hit the Prompt anywhere shortcut (Shift+Control+Space / ^⇧Space)

在任何地方点击提示快捷键(Shift+Control+Space / ^⇧Space) - Enter your prompt in the window that pops up

在弹出的窗口中输入您的提示 - Watch Witsy enter the text directly in your application!

观看 Witsy 直接在您的应用程序中输入文本!

On Mac, you can define an expert that will automatically be triggered depending on the foreground application. For instance, if you have an expert used to generate linux commands, you can have it selected if you trigger Prompt Anywhere from the Terminal application!

在 Mac 上,您可以定义一个专家,它将根据当前前景应用程序自动触发。例如,如果您有一个用于生成 Linux 命令的专家,当您从终端应用程序触发 Prompt Anywhere 时,它将被选中!

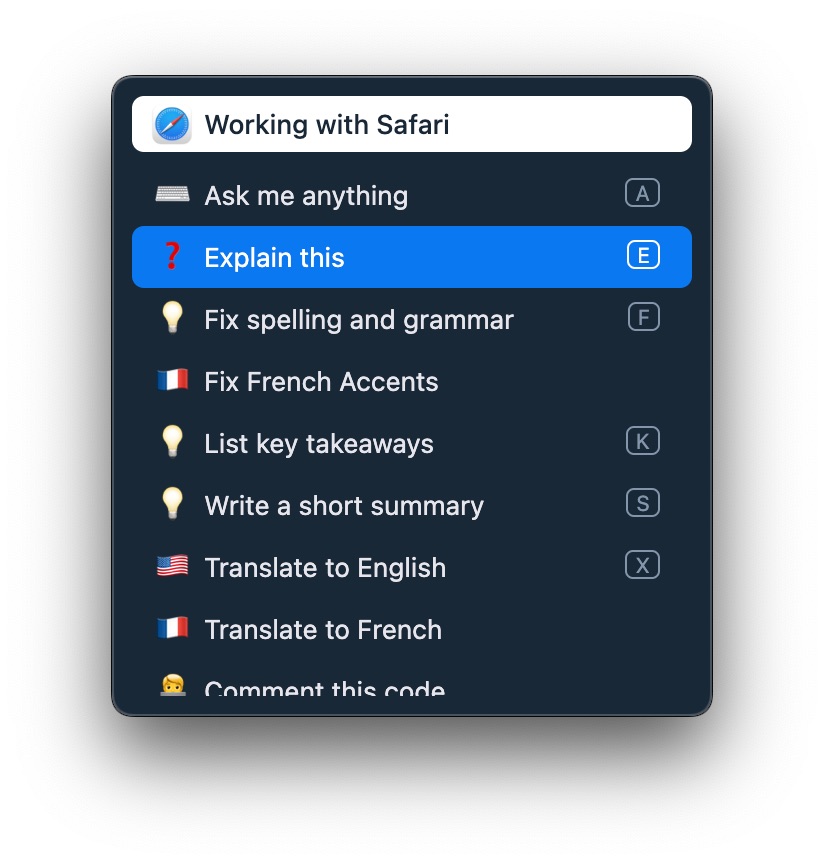

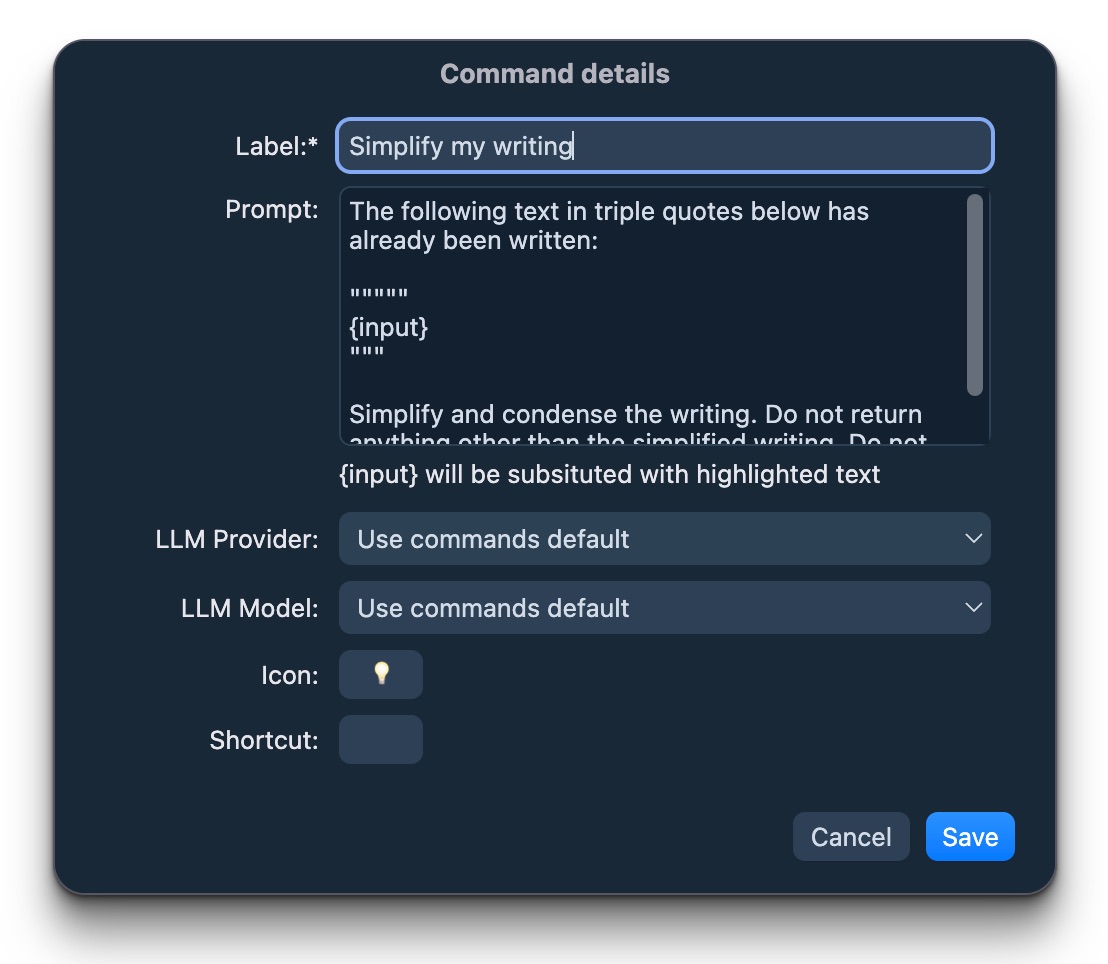

AI Commands AI 命令

AI commands are quick helpers accessible from a shortcut that leverage LLM to boost your productivity:

AI 命令是可通过快捷方式访问的快速助手,利用 LLM 来提升您的生产力:

- Select any text in any application

在任何应用程序中选择任何文本 - Hit the AI command shorcut (Alt+Control+Space / ⌃⌥Space)

按下 AI 命令快捷键(Alt+Control+Space / ⌃⌥Space) - Select one of the commands and let LLM do their magic!

选择一个命令,让 LLM 施展他们的魔法!

You can also create custom commands with the prompt of your liking!

你也可以使用自己喜欢的提示词创建自定义命令!

与你的文档聊天(RAG)

You can connect each chat with a document repository: Witsy will first search for relevant documents in your local files and provide this info to the LLM. To do so:

您可以将每个聊天与一个文档仓库连接:Witsy 会首先在您的本地文件中搜索相关文档,并将这些信息提供给 LLM。为此:

- Click on the database icon on the left of the prompt

点击提示左侧的数据库图标 - Click Manage and then create a document repository

点击管理,然后创建文档仓库 - OpenAI Embedding require on API key, Ollama requires an embedding model

OpenAI 嵌入需要 API 密钥,Ollama 需要嵌入模型 - Add documents by clicking the + button on the right hand side of the window

通过点击窗口右侧的 + 按钮添加文档 - Once your document repository is created, click on the database icon once more and select the document repository you want to use. The icon should turn blue

创建好文档仓库后,再次点击数据库图标,并选择您想要使用的文档仓库。该图标应变为蓝色。

Transcription / Dictation (Speech-to-Text)

转录/听写(语音转文本)

You can transcribe audio recorded on the microphone to text. Transcription can be done using a variety of state of the art speech to text models (which require API key) or using local Whisper model (requires download of large files).

你可以将麦克风录制的音频转录为文字。转录可以使用多种最先进的语音转文字模型(这些模型需要 API 密钥)或使用本地 Whisper 模型(需要下载大文件)。

Currently Witsy supports the following speech to text models:

目前 Witsy 支持以下语音转文字模型:

- GPT4o-Transcribe

- Gladia

- Speechmatics (Standards + Enhanced)

Speechmatics (标准版+增强版) - Groq Whisper V3

- Fireworks.ai Realtime Transcription

Fireworks.ai 实时转录 - fal.ai Wizper V3

- fal.ai ElevenLabs

- nVidia Microsoft Phi-4 Multimodal

Witsy supports quick shortcuts, so your transcript is always only one button press away.

Witsy 支持快速快捷键,因此您的文稿只需一键即可随时获取。

Once the text is transcribed you can:

文稿转录完成后,您可以:

- Copy it to your clipboard

复制到你的剪贴板 - Summarize it 总结它

- Translate it to any language

将其翻译成任何语言 - Insert it in the application that was running before you activated the dictation

将其插入您激活语音识别之前正在运行的应用程序

Setup 设置

文末下载安装包

或者自行构建:

<span style="background-color:var(--bgColor-muted, var(--color-canvas-subtle))"><span style="color:#1f2328"><span style="color:var(--fgColor-default, var(--color-fg-default))"><span style="background-color:var(--bgColor-muted, var(--color-canvas-subtle))"><code>npm ci

npm start

</code></span></span></span></span>Prerequisites 先决条件

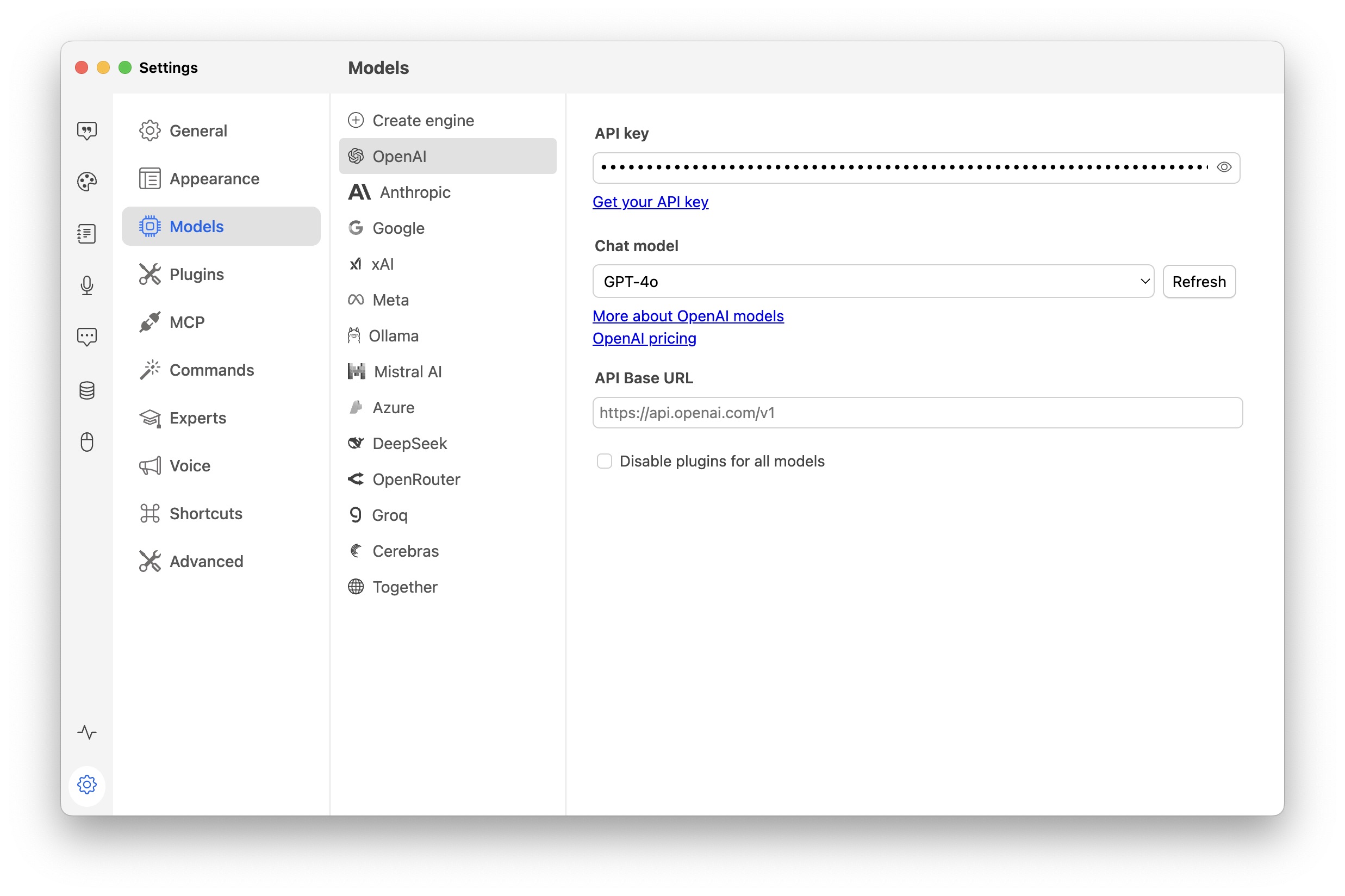

To use OpenAI, Anthropic, Google or Mistral AI models, you need to enter your API key:

To use Ollama models, you need to install Ollama and download some models.

To use text-to-speech, you need an

- OpenAI API key.

- Fal.ai API Key

- Fireworks.ai API Key

- Groq API Key

- Speechmatics API Key

- Gladia API Key

To use Internet search you need a Tavily API key.

三、软件下载

本文信息来源于GitHub作者地址:https://github.com/nbonamy/witsy

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)