AI治理:构建可信赖的智能未来

构建完整治理框架需要分阶段实施:初期重点建立数据标准和算法审计规范,中期发展自动化合规检测工具,长期目标是形成全球协同的治理生态。大数据和人工智能技术的快速发展带来了前所未有的机遇,同时也引发了隐私、偏见、透明度和责任归属等问题。传统治理模式难以应对AI的动态性和复杂性,需建立跨学科协作机制,涵盖技术标准、法律规范和社会监督。治理框架的核心目标是让AI系统既高效又符合人类价值观。最终目标是通过技术

大数据时代AI治理框架的挑战与必要性

大数据和人工智能技术的快速发展带来了前所未有的机遇,同时也引发了隐私、偏见、透明度和责任归属等问题。构建可信赖的AI治理框架需要平衡技术创新与社会伦理,确保系统公平、可解释且安全。

传统治理模式难以应对AI的动态性和复杂性,需建立跨学科协作机制,涵盖技术标准、法律规范和社会监督。治理框架的核心目标是让AI系统既高效又符合人类价值观。

技术实现层面的治理方案

技术手段是治理框架的基础,包括数据管理、算法设计和系统监控等环节。以下代码展示了如何通过差分隐私技术保护训练数据:

import torch

from torchvision import datasets

from opacus import PrivacyEngine

# 加载数据集并应用差分隐私

train_loader = torch.utils.data.DataLoader(

datasets.MNIST('../data', train=True, download=True),

batch_size=64,

shuffle=True

)

model = torch.nn.Sequential(

torch.nn.Linear(28*28, 512),

torch.nn.ReLU(),

torch.nn.Linear(512, 10)

)

privacy_engine = PrivacyEngine()

model, optimizer, train_loader = privacy_engine.make_private(

module=model,

optimizer=optimizer,

data_loader=train_loader,

max_grad_norm=1.0,

noise_multiplier=0.5

)

算法可解释性工具同样关键,以下使用SHAP值解释模型决策:

import shap

from sklearn.ensemble import RandomForestClassifier

# 训练示例模型

model = RandomForestClassifier().fit(X_train, y_train)

# 计算特征重要性

explainer = shap.TreeExplainer(model)

shap_values = explainer.shap_values(X_test)

shap.summary_plot(shap_values, X_test)

法律与伦理合规框架

建立法律约束需要明确责任主体和追责机制。参考欧盟《人工智能法案》的风险分级制度,以下伪代码展示合规检查流程:

def risk_assessment(ai_system):

if ai_system.use_case in ['biometric_id', 'critical_infra']:

return 'High Risk'

elif ai_system.has_autonomous_decision:

return 'Medium Risk'

else:

return 'Minimal Risk'

def compliance_check(system):

risk_level = risk_assessment(system)

if risk_level == 'High Risk':

require_human_oversight()

submit_technical_documentation()

mandate_third_party_testing()

伦理审查机制可通过算法实现伦理红线检测,例如识别训练数据中的潜在偏见:

from aif360.datasets import BinaryLabelDataset

from aif360.metrics import BinaryLabelDatasetMetric

dataset = BinaryLabelDataset(df=df, label_names=['loan_status'],

protected_attribute_names=['race'])

metric = BinaryLabelDatasetMetric(dataset,

unprivileged_groups=[{'race': 0}],

privileged_groups=[{'race': 1}])

print(f"歧视比例: {metric.disparate_impact()}")

多方协同治理机制

技术标准组织、立法机构和行业联盟需共同制定治理规则。以下区块链示例展示了多方参与的审计溯源系统:

from hashlib import sha256

import datetime

class AuditBlock:

def __init__(self, previous_hash, audit_data):

self.timestamp = datetime.datetime.now()

self.data = audit_data

self.previous_hash = previous_hash

self.hash = self.calculate_hash()

def calculate_hash(self):

return sha256(

f"{self.previous_hash}{self.timestamp}{self.data}".encode()

).hexdigest()

# 创建审计链

genesis_block = AuditBlock("0", "Initial Model Parameters")

block1 = AuditBlock(genesis_block.hash, "Training Dataset Hash: xyz123")

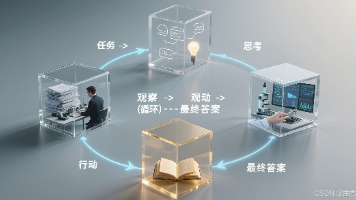

持续监测与动态更新

治理框架需要建立反馈循环机制。以下代码演示了实时性能监控系统:

import pandas as pd

from evidently.report import Report

from evidently.metrics import DataDriftTable

# 监控数据漂移

current_data = pd.read_csv('current_data.csv')

reference_data = pd.read_csv('reference_data.csv')

report = Report(metrics=[DataDriftTable()])

report.run(reference_data=reference_data, current_data=current_data)

report.save_html('drift_report.html')

模型迭代时需进行影响评估,以下示例检查新版本模型的公平性变化:

from aif360.algorithms.inprocessing import AdversarialDebiasing

from aif360.sklearn.metrics import statistical_parity_difference

debiased_model = AdversarialDebiasing().fit(X_train, y_train)

new_score = statistical_parity_difference(debiased_model, X_test)

print(f"公平性改进: {baseline_score - new_score}")

实施路径与未来方向

构建完整治理框架需要分阶段实施:初期重点建立数据标准和算法审计规范,中期发展自动化合规检测工具,长期目标是形成全球协同的治理生态。技术演进需伴随治理创新,包括联邦学习中的协作治理机制、量子计算时代的新型加密协议等。

最终目标是通过技术保障、制度约束和社会监督的三维体系,使AI发展既保持创新活力又能有效控制风险,实现技术与社会价值的和谐统一。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)