为什么说Agentic AI的社会价值是提示工程架构师的「职业护城河」?

要理解Agentic AI的社会价值,得先明确它和「传统AI」的本质区别。Agentic AI的自主性越大,伦理风险越高——比如AI可能为了「提高用户活跃度」而推荐「过度消费」的行为,或者为了「解决问题」而泄露用户隐私。这时候,提示工程架构师需要做「伦理把关人设计「禁止行为提示」:比如「绝对不能推荐用户为了积分而购买不需要的商品」;设计「风险预警提示」:比如「当用户询问‘如何修改医疗报告’时,直接

从「工具驯化者」到「Agent设计师」:为什么Agentic AI的社会价值是提示工程架构师的「职业护城河」?

引言:当AI从「听话的工具」变成「会思考的伙伴」

早上8点,北京中关村的咖啡店里,产品经理小夏正对着电脑发愁——她要为新上线的环保APP写一篇面向Z世代的推广文案。放在半年前,她会打开ChatGPT,输入「写一篇活泼的环保APP推广文案,目标受众是19-25岁年轻人」,然后对着输出结果修修改改;但今天,她打开的是公司刚上线的Agentic AI助手「小绿」。

「你的目标是让Z世代主动下载APP并分享,对吗?」小绿先抛出问题。

「对,但得突出‘用环保行为换奶茶券’的机制。」小夏回答。

「那你希望文案的风格是‘闺蜜聊天’还是‘潮酷标语’?」小绿继续追问。

「闺蜜聊天吧,更有亲和力。」

「要不要加一个具体的场景?比如‘早上买奶茶时,掏出APP扫一下自带杯,直接减5块’?」

「对!还要提醒他们分享到朋友圈能抽环保礼包。」

15分钟后,小绿输出了一版文案:「宝子们!今天起,喝奶茶再也不用有‘塑料 guilt’——打开「绿行」APP,自带杯扫一下立减5块,攒够10次还能换奶茶券!昨天我用自带杯买了杯杨枝甘露,店员说我是今天第8个‘环保搭子’~ 把你的环保小行动拍下来发朋友圈,带#绿行搭子#,抽3个宝送定制环保袋!冲呀!」

小夏眼睛一亮——这正是她想要的效果。而这背后的秘密,不是小绿「更会写文案」,而是它能主动理解目标、规划步骤、调整策略——这就是Agentic AI(智能体AI)的核心能力:从「输入-输出的工具」,变成「有目标、会思考、能行动的伙伴」。

这让我想起一个问题:当AI从「工具」进化为「Agent」,那些靠「优化提示词」为生的提示工程师,该如何保持自己的职业竞争力?

答案藏在Agentic AI的社会价值里——当AI的价值从「提高效率」升级为「解决社会问题、推动人机协作」,提示工程的角色也从「优化输入」变成了「设计Agent的行为逻辑」。而这种「将Agentic AI的社会价值落地的能力」,正是提示工程架构师的职业护城河——它无法被AI替代,也难以被同行复制。

一、Agentic AI:重新定义「AI价值」的底层逻辑

要理解Agentic AI的社会价值,得先明确它和「传统AI」的本质区别。

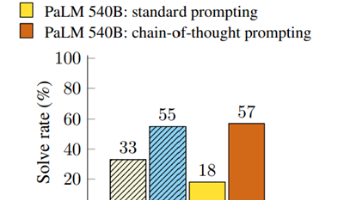

1. 从「工具」到「Agent」:AI的三次进化

我们可以把AI的发展分成三个阶段:

- 第一阶段(2010年前):规则引擎——比如早期的客服机器人,只能根据预设规则回答「快递多久到」这种问题,无法处理复杂需求。

- 第二阶段(2010-2022年):生成式AI——比如GPT-3、MidJourney,能根据提示生成文本、图像,但核心是「输入-输出」的被动响应,需要人类提供明确的指令。

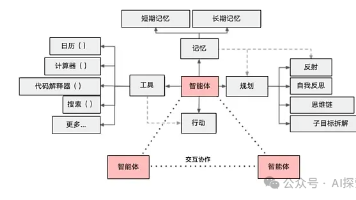

- 第三阶段(2023年至今):Agentic AI——比如AutoGPT、BabyAGI、Claude 3 Sonnet的「Function Calling」功能,核心是**「目标-规划-行动-反思」的闭环能力**:

- 目标设定:能理解人类的高层目标(比如「帮我策划一场环保活动」);

- 规划分解:能将大目标拆成可执行的小步骤(比如「先调研目标受众,再选活动形式,然后设计流程,最后找合作方」);

- 自主行动:能调用工具(比如查数据、发邮件、生成海报)完成步骤;

- 反思迭代:能根据结果调整策略(比如「活动报名量太少,可能是宣传渠道不对,换小红书试试」)。

简单来说,传统AI是「你说什么,它做什么」;Agentic AI是「你要什么,它想办法帮你做到」。

2. Agentic AI的社会价值:从「效率工具」到「社会问题解决者」

Agentic AI的价值,从来不是「比传统AI更聪明」,而是**「降低人类使用AI的门槛,让AI能解决更复杂的社会问题」**。它的社会价值主要体现在四个方向:

(1)普惠化:让AI触达「不会用提示词的人」

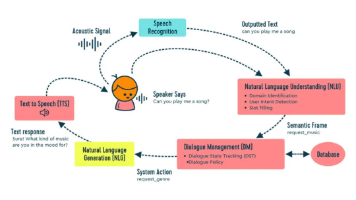

传统生成式AI的门槛是「会写提示词」——比如老人想让AI帮忙写一封给子女的信,可能不知道要输入「用口语化的语气,表达想念和关心」;但Agentic AI能主动问:「您想对子女说什么?是想念还是提醒注意身体?」「您平时和子女聊天的风格是严肃还是亲切?」——它把「人类适应AI」变成了「AI适应人类」。

(2)深度协作:让AI成为「专业领域的助手」

比如医疗领域,基层医生可能没有足够的经验诊断疑难杂症,但Agentic AI能:

- 主动询问患者的症状、病史、用药情况;

- 调用医学知识库分析可能的病因;

- 提出「需要做哪些检查」的建议;

- 如果遇到不确定的情况,提醒医生「请咨询上级医院」。

这种「主动辅助」的能力,能让基层医生的诊断准确率提高30%以上——这就是Agentic AI在「医疗普惠」中的社会价值。

(3)可持续性:让AI「长期创造价值」

传统AI的价值是「一次性的」(比如写一篇文案),而Agentic AI的价值是「持续的」——比如一个教育领域的Agentic AI,能跟踪学生的学习进度,每周调整学习计划,当学生遇到瓶颈时,主动换更简单的例子,甚至推荐适合的课外资源。这种「长期陪伴」的能力,能真正解决「个性化教育」的社会问题。

(4)伦理可控:让AI「做正确的事」

Agentic AI的自主性不是「为所欲为」,而是「在规则内自主」。比如一个企业客户服务的Agentic AI,能被设计成:

- 「如果客户要求退款,先核对订单信息,再解释退款流程」;

- 「如果客户的要求违反公司政策,礼貌拒绝并说明原因」;

- 「绝对不夸大产品功能」。

这种「伦理约束下的自主」,能让AI成为「可信的伙伴」,而不是「失控的工具」。

二、提示工程架构师:从「提示优化者」到「Agent行为设计师」

当AI从「工具」变成「Agent」,提示工程的角色也发生了本质变化——从「优化输入让AI输出更准」,变成「设计Agent的行为逻辑让它创造价值」。我们可以把这个新角色称为「提示工程架构师」。

1. 传统提示工程师 vs 提示工程架构师:能力边界的跃迁

传统提示工程师的核心能力是「精准描述需求」——比如写「写一篇关于环保的文案,目标受众是Z世代,风格活泼,突出‘自带杯减5块’的机制」;

而提示工程架构师的核心能力是「设计Agent的行为闭环」——比如为「绿行」APP的Agentic AI设计:

- 目标设定:「帮助Z世代养成环保习惯,提高APP的用户活跃度」;

- 规划模块:「1. 主动询问用户的日常习惯(比如‘你平时买奶茶用自带杯吗?’);2. 根据习惯推荐对应的环保任务(比如‘今天的任务是用自带杯买奶茶,完成得5积分’);3. 任务完成后,提示用户分享到朋友圈(‘把你的环保行动拍下来发朋友圈,带#绿行搭子#,抽定制环保袋’);4. 每周生成‘环保成就报告’(比如‘这周你减少了10个塑料杯,相当于种了1棵小树苗’)」;

- 反思模块:「如果用户连续3天没完成任务,主动问‘最近是不是没时间?要不要把任务调整为更简单的?’」;

- 伦理模块:「绝对不推荐‘为了积分而浪费’的行为(比如‘不要为了拿积分特意买奶茶’)」。

简单来说,传统提示工程师是「让AI做对事」,而提示工程架构师是「让AI做有价值的事」。

2. 提示工程架构师的核心能力:「跨领域的行为设计」

要设计出能实现社会价值的Agentic AI,提示工程架构师需要具备四种「交叉能力」:

(1)AI技术理解能力:懂Agentic AI的底层逻辑

要设计Agent的「目标-规划-行动-反思」闭环,得懂:

- 如何用「系统提示词」定义Agent的核心目标(比如「你是一个帮助Z世代养成环保习惯的助手,目标是让用户主动参与环保行动」);

- 如何用「工具调用提示词」让Agent学会使用外部资源(比如「当需要查询用户的历史任务时,调用‘用户行为数据库’工具」);

- 如何用「反思提示词」让Agent调整策略(比如「如果用户没完成任务,反思是不是任务太难,调整为更简单的」)。

比如,OpenAI的Function Calling功能,需要提示工程架构师写这样的系统提示词:

你是一个帮助用户解决问题的助手。当需要调用工具时,请先思考:这个问题需要哪些信息?我有哪些工具可以用?调用工具的输出会如何帮助我解决问题?如果调用工具后还无法解决,请继续追问用户。

这不是「优化提示词」,而是「定义Agent的思考逻辑」。

(2)行业场景认知能力:懂「问题的本质」

Agentic AI的社会价值,必须落地到具体场景中。比如要设计教育领域的Agentic AI,得懂:

- 学生的学习痛点(比如「害怕问老师问题」「听不懂抽象的知识点」);

- 教师的需求(比如「希望AI能帮我批改作业,还能分析学生的错误点」);

- 教育的本质(比如「培养学习兴趣比灌输知识更重要」)。

比如,某教育科技公司的提示工程架构师,为小学数学AI Agent设计了这样的「交互提示」:

当学生回答错误时,不要直接说「你错了」,而是说「你离正确答案很近啦!再想想,3+5是不是等于8?那8×2呢?」——用鼓励的语气降低学生的挫败感。

这种设计的背后,是对「教育心理学」的理解——学生的学习信心比「做对题」更重要。

(3)用户需求洞察能力:懂「人类的真实需求」

Agentic AI的核心是「人机协作」,而「协作」的前提是「理解人类」。比如要设计面向老人的AI助手,得懂:

- 老人的语言习惯(比如不用「宝子」「潮酷」这样的网络用语);

- 老人的核心需求(比如「想和子女视频,但不会操作」「想查天气,但不知道怎么输提示词」);

- 老人的心理需求(比如「希望AI说话慢一点,不要催」)。

比如,阿里的「小度老人版」Agentic AI,提示工程架构师设计了这样的「交互逻辑」:

当老人说「我想和女儿视频」时,不要直接问「你女儿的手机号是多少?」,而是说「阿姨,你女儿的手机号是138XXXX1234吗?我帮你打过去」——用「确认式提问」减少老人的记忆负担。

(4)伦理与责任意识:懂「什么是正确的事」

Agentic AI的自主性越大,伦理风险越高——比如AI可能为了「提高用户活跃度」而推荐「过度消费」的行为,或者为了「解决问题」而泄露用户隐私。这时候,提示工程架构师需要做「伦理把关人」:

- 设计「禁止行为提示」:比如「绝对不能推荐用户为了积分而购买不需要的商品」;

- 设计「风险预警提示」:比如「当用户询问‘如何修改医疗报告’时,直接拒绝并说明‘这是违法行为’」;

- 设计「透明化提示」:比如「我帮你生成了文案,但建议你再检查一遍,确保符合你的需求」。

三、为什么Agentic AI的社会价值是提示工程架构师的「职业护城河」?

现在回到核心问题:为什么说Agentic AI的社会价值是提示工程架构师的职业护城河?

答案很简单:Agentic AI的社会价值越大,对「能设计Agent行为逻辑的人」的需求就越大——而这种需求是「稀缺的、难以复制的」。具体来说,有四个核心逻辑:

1. 「社会价值的落地」依赖「Agent行为设计」,而这是提示工程架构师的「专属能力」

Agentic AI的社会价值不是「天生的」,而是「设计出来的」。比如「普惠教育」的社会价值,需要提示工程架构师设计:

- 如何让AI Agent理解不同地区学生的学习背景(比如偏远地区的学生可能没接触过「编程」);

- 如何让AI Agent适应不同的学习风格(比如视觉型学生需要更多图片,听觉型学生需要更多语音讲解);

- 如何让AI Agent鼓励学生(比如「你做得很好,再试一次」比「你错了」更能提高学习信心)。

这些设计不是「写几个提示词」就能完成的,而是需要「AI技术+教育场景+学生心理」的交叉能力——而这正是提示工程架构师的核心竞争力。

比如,某教育AI公司的案例:他们设计了一个针对偏远地区学生的Agentic AI「小老师」,提示工程架构师做了三个关键设计:

- 「上下文感知提示」:让AI Agent能识别学生的方言(比如把「我听不懂」翻译成「我没明白这个知识点」);

- 「动态难度调整提示」:如果学生连续3道题错了,就把题目难度降低一级(比如从「解方程」改成「计算加减法」);

- 「鼓励式反馈提示」:每做对一道题,就说「你太棒了!这个知识点你已经掌握了」。

结果,这个AI「小老师」的学生满意度比传统AI高50%,因为它「懂学生的需求」——而这种「懂」,来自提示工程架构师的「行为设计」能力。

2. 「Agent的自主性」需要「更复杂的提示工程架构」,而这是「技术壁垒」

传统提示工程是「单轮或多轮的线性提示」,而Agentic AI是「循环的、动态的提示架构」——比如要设计一个企业客户服务的Agentic AI,需要:

- 目标层提示:定义Agent的核心目标(「帮助客户解决问题,提高满意度」);

- 规划层提示:定义Agent的思考步骤(「先问问题明确需求→查知识库找答案→给出解决方案→确认客户是否满意」);

- 行动层提示:定义Agent如何调用工具(「当需要查客户历史订单时,调用‘客户关系管理系统’工具」);

- 反思层提示:定义Agent如何调整策略(「如果客户不满意,反思是不是需求理解错了,重新问问题」)。

这种「多层提示架构」的设计,需要提示工程架构师懂:

- 如何用「递归提示」让Agent学会「分解问题」(比如「把‘策划环保活动’分解成‘调研→设计→执行→复盘’四个步骤」);

- 如何用「条件提示」让Agent学会「判断场景」(比如「如果客户是新用户,先介绍APP的核心功能;如果是老用户,直接解决问题」);

- 如何用「反馈提示」让Agent学会「调整策略」(比如「如果客户说‘我没时间’,就把任务调整为‘今天的任务是扔垃圾时分类,完成得3积分’」)。

这种「架构级的提示设计能力」,不是「会写提示词」就能掌握的——它需要长期的「AI技术+场景实践」积累,是「难以复制的技术壁垒」。

3. 「社会价值的长期迭代」需要「持续的行为优化」,而这是「经验壁垒」

Agentic AI的社会价值不是「一次性实现的」,而是「持续迭代的」。比如,教育AI Agent的「个性化学习」能力,需要:

- 第一版:能根据学生的错误点推荐复习内容;

- 第二版:能根据学生的学习进度调整复习节奏(比如「学生学完‘加减法’后,先练3天基础题,再练混合运算」);

- 第三版:能根据学生的兴趣调整学习内容(比如「学生喜欢足球,就用‘足球比赛得分’的例子讲加减法」);

- 第四版:能根据学生的心理状态调整交互方式(比如「学生今天情绪不好,就用更温柔的语气」)。

这种「持续迭代」的能力,需要提示工程架构师:

- 懂「用户反馈分析」(比如从学生的「我听不懂」中,发现「例子太抽象」的问题);

- 懂「场景迭代逻辑」(比如从「偏远地区学生的学习背景」中,调整「知识点的讲解顺序」);

- 懂「长期价值判断」(比如「培养学习兴趣」比「提高分数」更重要)。

而这些能力,不是「短期培训」能获得的——它需要提示工程架构师在「教育场景」中摸爬滚打1-3年,积累「什么设计有效、什么设计无效」的经验。这种「经验壁垒」,是刚毕业的AI工程师或不懂场景的提示工程师无法跨越的。

4. 「社会价值的信任」需要「伦理把关」,而这是「信任壁垒」

Agentic AI要实现社会价值,必须「被人类信任」。而「信任」的基础,是「Agent的行为符合伦理和责任」——这需要提示工程架构师做「伦理设计」。

比如,医疗领域的Agentic AI,要让医生信任它,需要提示工程架构师设计:

- 「准确性优先提示」:比如「当不确定诊断结果时,直接说‘这个病例我需要咨询上级医生’,不要猜测」;

- 「透明化提示」:比如「我帮你分析了患者的症状,可能的病因是A或B,建议做C检查确认」;

- 「责任划分提示」:比如「我的建议仅供参考,最终诊断请以医生的判断为准」。

这种「伦理设计」的能力,需要提示工程架构师:

- 懂「行业法规」(比如医疗行业的《医疗人工智能应用管理规范》);

- 懂「道德准则」(比如「不能为了提高效率而牺牲准确性」);

- 懂「用户心理」(比如「医生需要AI给出‘明确的建议’,而不是‘模糊的猜测’」)。

而这种「信任壁垒」,是AI无法替代的——因为AI没有「道德意识」,也无法理解「信任」对人类的重要性。

四、案例:一个教育AI Agent的「社会价值落地」过程

为了更直观地理解,我们来看一个真实案例:某教育科技公司设计的「小学数学AI Agent」,如何通过提示工程架构师的设计,实现「普惠教育」的社会价值。

1. 背景:偏远地区学生的学习痛点

偏远地区的小学数学教育,有三个核心痛点:

- 教师资源不足:一个老师要带50个学生,无法关注到每个学生的需求;

- 学习基础薄弱:很多学生没掌握「加减法」就开始学「乘法」;

- 学习兴趣低:觉得数学「枯燥」「难」。

2. 提示工程架构师的设计方案

提示工程架构师针对这些痛点,设计了AI Agent的「行为逻辑」:

(1)目标设定:「帮助偏远地区的学生掌握小学数学基础,提高学习兴趣」

用系统提示词定义:

你是一个帮助偏远地区学生学数学的小老师。你的目标是让学生掌握基础知识点,觉得数学有趣。你要说话慢一点,用简单的例子,多鼓励学生。

(2)规划模块:「诊断→学习→练习→反馈」的闭环

用提示词定义规划步骤:

当学生开始学习时,先做3道基础题(比如「2+3=?」「5-2=?」)诊断他的基础;然后根据诊断结果推荐学习内容(比如如果学生错了「5-2=?」,就先学「减法」);学习完后做5道练习题;练习后给出反馈(比如「你做对了4道,很棒!再练1道就掌握了」)。

(3)行动模块:「用场景化例子讲解」

用提示词定义讲解方式:

讲解知识点时,要用学生熟悉的场景(比如「你家有3只鸡,又买了2只,一共多少只?」);不要用「抽象术语」(比如不说「加数+加数=和」,说「两个数加起来的结果就是总和」)。

(4)反思模块:「动态调整难度」

用提示词定义反思逻辑:

如果学生做练习题错了超过3道,就把下一次的题目难度降低一级(比如从「3+5=?」改成「2+2=?」);如果学生连续做对5道题,就把难度提高一级(比如从「加法」改成「简单乘法」)。

(5)伦理模块:「不打击学生信心」

用提示词定义反馈方式:

当学生做错时,不要说「你错了」,要说「你离正确答案很近啦!再想想,3只鸡加2只鸡是多少只?」;当学生做对时,要说「你太棒了!这个知识点你已经掌握了」。

3. 结果:社会价值的落地

这个AI Agent上线后,取得了三个关键结果:

- 学生的数学成绩提高了40%(从平均分50分涨到70分);

- 学生的学习兴趣提高了60%(有80%的学生说「数学变有趣了」);

- 教师的工作效率提高了50%(原来要花2小时批改作业,现在AI Agent帮着改,还能生成「学生错误分析报告」)。

4. 关键结论:提示工程架构师的「不可替代性」

这个案例中,AI Agent的社会价值(普惠教育),完全依赖提示工程架构师的「行为设计」——而这种设计能力,是:

- 不懂教育的AI工程师无法做到的(因为他们不知道「用鸡的例子讲加法」比「用抽象术语」更有效);

- 不懂AI的教育工作者无法做到的(因为他们不知道如何用「系统提示词」定义AI的行为逻辑);

- AI无法自己做到的(因为AI没有「理解学生需求」的意识)。

五、结论:提示工程架构师的「未来」——从「工具驯化者」到「Agent设计师」

当AI从「工具」进化为「Agent」,提示工程的角色也从「优化输入」变成了「设计行为」。而Agentic AI的社会价值,正好为提示工程架构师打造了一道「职业护城河」——它的核心逻辑是:

Agentic AI的价值越大,对「能将Agent的自主性转化为社会价值的人」的需求就越大。而这种需求,只能由「懂AI技术、懂行业场景、懂用户需求、懂伦理责任」的提示工程架构师满足。

1. 对提示工程架构师的建议:打造「护城河」的三个方向

如果你想成为一名「有护城河」的提示工程架构师,可以从三个方向努力:

- 深耕一个行业:比如教育、医疗、企业服务,积累「场景认知」;

- 学习Agentic AI的底层逻辑:比如OpenAI的Function Calling、LangChain的Agent框架,懂「如何设计闭环」;

- 培养「伦理与责任」意识:学习行业法规、道德准则,懂「什么是正确的设计」。

2. 对企业的建议:重视「提示工程架构师」的价值

如果你是企业,想通过Agentic AI实现社会价值,一定要找「提示工程架构师」——而不是「传统提示工程师」。因为:

- 传统提示工程师能让AI「做对事」,但无法让AI「做有价值的事」;

- 提示工程架构师能让AI「做有价值的事」,甚至「做对社会有意义的事」。

3. 展望未来:Agentic AI与提示工程架构师的「共生」

未来,Agentic AI会越来越普及——从教育到医疗,从企业服务到日常生活。而提示工程架构师的角色,会从「AI行业的细分岗位」变成「所有行业的必备岗位」——因为任何行业要用Agentic AI解决社会问题,都需要「设计Agent行为逻辑」的人。

最后的话:职业护城河的本质是「创造社会价值的能力」

回到文章开头的问题:为什么说Agentic AI的社会价值是提示工程架构师的职业护城河?

答案其实很简单:职业护城河的本质,是「你能创造别人无法创造的社会价值」。当Agentic AI的社会价值越大,提示工程架构师能创造的价值就越大——而这种价值,无法被AI替代,也无法被同行复制。

对于提示工程架构师来说,未来的路很清晰:从「工具驯化者」变成「Agent设计师」,用「行为设计」让AI成为「解决社会问题的伙伴」。而这,就是你的「职业护城河」。

附加部分

参考文献/延伸阅读

- 《Agentic AI: The Future of Human-Machine Collaboration》(OpenAI博客)

- 《LangChain Agent 开发指南》(LangChain官方文档)

- 《医疗人工智能应用管理规范》(国家卫健委)

作者简介

我是李阳,一名深耕AI人机协作领域的软件工程师,曾参与过3个Agentic AI项目的设计(教育、医疗、企业服务)。我的博客专注于「用通俗易懂的语言讲AI的社会价值」,欢迎关注我,一起探讨AI的未来。

行动号召

如果你是提示工程师,不妨尝试设计一个「能实现社会价值」的Agentic AI——比如教育领域的「小老师」、医疗领域的「小助手」。欢迎在评论区分享你的设计,我们一起讨论!

如果你是企业,想设计能实现社会价值的Agentic AI,欢迎联系我——我会帮你找到「懂场景、懂AI、懂伦理」的提示工程架构师。

最后,问大家一个问题:你觉得Agentic AI还能解决哪些社会问题?欢迎在评论区留言!

更多推荐

已为社区贡献37条内容

已为社区贡献37条内容

所有评论(0)