成为优秀AI系统架构师的关键要点,一文梳理

AI系统不是“数据→模型→服务”的线性叠加,而是一个相互影响的复杂系统。数据 pipeline 的延迟,会影响模型的更新频率(比如实时推荐需要“秒级”数据,而离线推荐可以接受“天级”);模型的大小,会影响推理的延迟(比如大模型需要更多的算力,导致延迟升高);服务的并发量,会影响模型的部署方式(比如高并发场景需要用“模型并行”或“多实例部署”)。从“用户需求”出发,反向设计系统的每一个组件,而不是孤

成为优秀AI系统架构师的关键要点:从思维到实践的全链路梳理

一、引言:为什么AI系统架构师是AI项目成功的“隐形基石”?

1. 一个扎心的问题:你做的AI模型,真的能上线吗?

去年,我遇到一位算法工程师朋友的吐槽:“我花了三个月调优的图像分类模型,accuracy达到了95%,结果上线后用户投诉延迟太高,根本没法用!” 更糟的是,当他们想优化延迟时,发现数据 pipeline 居然是“离线批量处理+手动同步”,导致模型用的还是一周前的数据——所谓的“高准确率”,其实是“过时的准确”。

这不是个例。根据Gartner的报告,85%的AI项目无法实现商业价值,其中最主要的原因不是算法不够好,而是系统架构设计的缺失:数据流程混乱、训练效率低下、推理性能瓶颈、缺乏监控反馈……这些“工程问题”,往往会让优秀的算法胎死腹中。

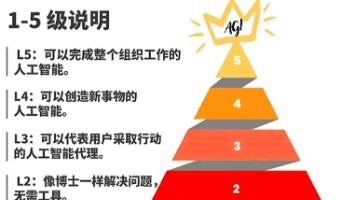

2. AI系统架构师:从“算法执行者”到“系统设计者”的跃迁

在传统软件架构中,架构师的核心是“解决高可用、可扩展、低延迟”问题;而在AI系统中,架构师的职责要复杂得多——他们需要设计一个“端到端的AI生态”:从数据的采集、存储、预处理,到模型的训练、优化、版本管理,再到服务的部署、推理、监控,甚至包括伦理安全与成本控制。

简单来说,AI系统架构师的使命是:让算法“落地”,让AI“有用”。他们不是“算法的搬运工”,而是“AI系统的总设计师”。

3. 本文目标:帮你建立AI架构师的“能力坐标系”

如果你是:

- 想转型AI架构的后端/算法工程师;

- 刚入门的AI架构师,想提升核心能力;

- 负责AI项目的管理者,想理解架构设计的关键;

这篇文章会帮你梳理:

- AI系统架构师的核心思维方式;

- 必须掌握的关键技术组件;

- 避免踩坑的最佳实践;

- 未来需要关注的技术趋势。

读完这篇文章,你会对“如何成为优秀AI系统架构师”有一个清晰的路线图。

二、基础铺垫:AI系统架构的核心组件与职责边界

在讲“关键要点”之前,我们需要先明确:AI系统的核心组件是什么?架构师的职责边界在哪里?

1. AI系统的“四层架构”模型

一个完整的AI系统,通常可以拆解为以下四层(从下到上):

| 层级 | 核心组件 | 主要职责 |

|---|---|---|

| 数据层 | 数据采集(SDK/埋点)、存储(Hive/Iceberg/Redis)、预处理(Flink/Spark)、质量监控(Great Expectations) | 提供“干净、及时、可扩展”的数据燃料,支撑模型训练与推理 |

| 模型层 | 训练框架(PyTorch/TensorFlow)、分布式训练(DDP/ZeRO)、模型优化(剪枝/量化/蒸馏)、版本管理(MLflow/DVC) | 实现“高效训练、高性能推理、可迭代”的模型生命周期管理 |

| 服务层 | 推理引擎(ONNX Runtime/TensorRT)、部署框架(K8s/Serverless)、服务网格(Istio)、API网关(Kong) | 让模型“可调用”,满足低延迟、高并发、动态扩缩容的需求 |

| 支撑层 | 算力(GPU/TPU/云服务器)、工具链(Kubeflow/MLflow)、安全(对抗样本检测/数据加密)、伦理(偏见检测/可解释性) | 为上层提供“可靠、安全、合规”的基础支撑 |

2. AI架构师与其他角色的区别

很多人会混淆“AI架构师”与“算法工程师”“传统架构师”的职责,这里用一张表说清楚:

| 角色 | 核心关注点 | 关键能力 |

|---|---|---|

| 算法工程师 | 模型的准确率、召回率等指标,聚焦“算法优化” | 深度学习理论、模型调参、论文复现 |

| 传统架构师 | 系统的高可用、可扩展、低延迟,聚焦“工程架构” | 分布式系统、微服务、数据库设计 |

| AI架构师 | 端到端的AI系统效能(数据-模型-服务的协同),聚焦“落地价值” | 系统思维、AI工程化、跨组件优化 |

简单来说,AI架构师是“算法与工程的桥梁”——他们既要懂算法的边界(比如“这个模型的计算复杂度能不能满足实时要求?”),也要懂工程的限制(比如“这个数据 pipeline 的延迟能不能支撑模型的实时更新?”)。

三、核心要点:成为优秀AI系统架构师的“五大关键能力”

要点一:建立“端到端”的系统思维——拒绝“局部最优”,追求“全局最优”

1. 什么是“端到端”思维?

AI系统不是“数据→模型→服务”的线性叠加,而是一个相互影响的复杂系统。比如:

- 数据 pipeline 的延迟,会影响模型的更新频率(比如实时推荐需要“秒级”数据,而离线推荐可以接受“天级”);

- 模型的大小,会影响推理的延迟(比如大模型需要更多的算力,导致延迟升高);

- 服务的并发量,会影响模型的部署方式(比如高并发场景需要用“模型并行”或“多实例部署”)。

“端到端”思维的核心是:从“用户需求”出发,反向设计系统的每一个组件,而不是孤立地优化某一个环节。

2. 如何培养“端到端”思维?

举个例子:假设你要设计一个实时推荐系统,用户需求是“在用户点击商品时,100ms内给出个性化推荐”。

按照“端到端”思维,你需要依次考虑:

- 数据层:用户的点击行为需要“秒级”采集(用SDK埋点),“秒级”处理(用Flink实时计算用户的兴趣向量),“秒级”存储(用Redis缓存);

- 模型层:推荐模型需要“轻量”(比如用TensorFlow Lite或ONNX优化),“可实时更新”(比如用在线学习算法,如FTRL);

- 服务层:推理服务需要“低延迟”(用TensorRT加速),“高并发”(用K8s部署多实例,用Istio做负载均衡);

- 监控层:需要监控数据延迟(比如Flink的 checkpoint 时间)、模型性能(比如推荐的点击率)、服务延迟(比如API的响应时间)。

如果没有“端到端”思维,你可能会犯这样的错误:为了提高模型准确率,用了一个复杂的Transformer模型,结果推理延迟达到500ms,无法满足用户需求——局部的“模型最优”,导致了全局的“系统失败”。

要点二:深度掌握AI核心组件的设计与优化——从“能用”到“好用”

AI系统的核心组件(数据、模型、服务)是架构师的“主战场”。只有深入掌握每个组件的设计原理与优化技巧,才能搭建出“高效、可靠、可扩展”的AI系统。

1. 数据层:设计“可扩展的数据 pipeline”——数据是AI的“燃料”

问题:很多AI项目的 data pipeline 是“一次性的”——比如用Python脚本处理数据,随着数据量增长,脚本变得越来越慢,甚至崩溃。

解决方案:设计“分层的数据 pipeline”,分为“离线处理”与“实时处理”两部分:

- 离线数据 pipeline:用于处理海量历史数据,支撑模型的离线训练。比如用Spark做数据清洗(比如去除重复数据、填充缺失值),用Hive或Iceberg做数据存储(支持ACID事务,方便数据回溯);

- 实时数据 pipeline:用于处理流式数据,支撑模型的实时推理或在线学习。比如用Flink做实时特征计算(比如用户最近10分钟的点击次数),用Kafka做数据缓冲(解耦数据生产者与消费者),用Redis做特征缓存(快速获取用户的实时兴趣)。

案例:某电商公司的推荐系统,数据 pipeline 用了“Flink+Kafka+Redis”的架构:

- 用户的点击、加购行为通过SDK埋点,发送到Kafka;

- Flink消费Kafka中的数据,实时计算用户的“实时兴趣向量”(比如最近10分钟点击的商品类别);

- 计算好的兴趣向量存储到Redis,供推荐模型实时调用;

- 同时,Kafka中的数据会同步到Hive,用于模型的离线 retrain。

这个架构既满足了实时推荐的低延迟需求(数据处理延迟<1秒),又支撑了离线模型的大规模训练(每天处理10TB数据)。

2. 模型层:优化“训练与推理效率”——让模型“跑起来”更高效

问题:随着模型规模的增长(比如大模型的参数达到千亿级),训练时间变得越来越长(比如几周甚至几个月),推理延迟变得越来越高(比如几秒甚至几十秒)。

解决方案:针对“训练”与“推理”分别优化:

- 训练优化:

- 分布式训练:用PyTorch Distributed或TensorFlow Distributed实现多节点多GPU训练,提高训练速度;

- 显存优化:用ZeRO(Zero Redundancy Optimizer)或FlashAttention等技术,减少显存占用(比如ZeRO可以让千亿参数模型在单GPU上训练);

- 混合精度训练:用FP16(半精度)代替FP32(单精度),提高计算效率(比如训练速度提升2-3倍,显存占用减少一半)。

- 推理优化:

- 模型压缩:用剪枝(去除不重要的权重)、量化(把FP32转成INT8)、蒸馏(用大模型教小模型)等技术,减小模型大小(比如BERT模型量化后,大小从400MB降到100MB);

- 推理引擎:用ONNX Runtime(支持多框架模型)或TensorRT(NVIDIA专属,优化GPU推理)加速推理(比如TensorRT可以让BERT模型的推理延迟从300ms降到100ms);

- 模型并行:对于超大规模模型(比如GPT-3),用模型并行(把模型的不同层分配到不同的GPU上)或流水线并行(把训练过程分成多个阶段,每个阶段用不同的GPU处理),提高推理效率。

案例:某公司的大模型训练项目,用了“ZeRO+混合精度训练+分布式训练”的架构:

- 模型参数:100亿;

- 算力:8台服务器,每台8张A100 GPU(共64张GPU);

- 训练时间:从原来的4周缩短到3天(训练速度提升10倍);

- 显存占用:每张GPU的显存占用从32GB降到16GB(减少一半)。

3. 服务层:搭建“高可用的推理服务”——让模型“可调用”

问题:很多AI模型部署后,会遇到“高并发时崩溃”“延迟波动大”“无法动态扩缩容”等问题。

解决方案:用“云原生+推理引擎”的架构,搭建高可用的推理服务:

- 部署方式:用Kubernetes(K8s)部署推理服务,支持动态扩缩容(比如根据请求量自动增加或减少pod数量);

- 服务网格:用Istio做服务网格,实现负载均衡(把请求分配到不同的pod)、熔断(当某个pod崩溃时,停止向它发送请求)、监控(收集服务的延迟、错误率等指标);

- API网关:用Kong或APISIX做API网关,实现身份认证(比如API密钥)、流量控制(比如每秒最多处理1000次请求)、日志记录(记录每个请求的详细信息)。

案例:某图像识别服务,用了“K8s+Istio+TensorRT”的架构:

- 推理服务部署在K8s集群中,每个pod运行一个TensorRT优化后的模型;

- Istio负责负载均衡,把用户的请求分配到空闲的pod;

- 当请求量增加时,K8s自动增加pod数量(比如从10个增加到20个),保证延迟稳定在100ms以内;

- 当请求量减少时,K8s自动减少pod数量,降低算力成本。

要点三:具备“工程化+算法”的双维能力——拒绝“偏科”

AI架构师不能只会“写代码”,也不能只会“调模型”,必须具备“工程化+算法”的双维能力。

1. 算法能力:懂算法的“边界”

AI架构师不需要像算法工程师那样“精通所有模型”,但需要懂算法的计算复杂度、数据需求、性能瓶颈:

- 比如,卷积神经网络(CNN)适合处理图像数据,但计算复杂度高(需要大量的矩阵乘法),不适合实时推理;

- 比如,循环神经网络(RNN)适合处理序列数据,但训练时容易出现“梯度消失”问题,不适合长序列;

- 比如,Transformer模型适合处理各种数据(文本、图像、音频),但模型大小大(需要大量的算力),不适合资源有限的场景。

案例:某公司要做一个“实时语音识别”服务,算法工程师提出用Transformer模型(准确率高),但架构师认为Transformer的计算复杂度太高(实时推理延迟会超过500ms),于是选择了更轻量的LSTM模型(准确率 slightly 低,但延迟<200ms),最终满足了用户的需求。

2. 工程能力:懂工程的“限制”

AI架构师不需要像后端工程师那样“精通所有框架”,但需要懂工程的资源限制、性能瓶颈、可维护性:

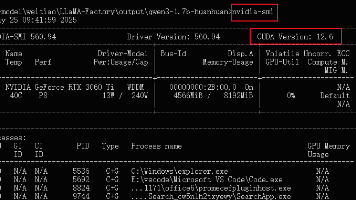

- 比如,GPU的显存是有限的(比如A100 GPU的显存是80GB),所以模型的大小不能超过显存限制;

- 比如,网络带宽是有限的(比如云服务器的带宽是1Gbps),所以数据传输的大小不能太大(比如实时数据 pipeline 的数据量不能超过100MB/s);

- 比如,系统的可维护性很重要(比如模型版本管理需要用MLflow,这样可以快速回滚到之前的版本)。

案例:某公司的模型训练项目,算法工程师用了一个“超深”的CNN模型(100层),但架构师发现这个模型的训练时间太长(需要2周),而且显存占用太高(需要32GB GPU),于是建议用“残差网络”(ResNet)代替(50层,训练时间1周,显存占用16GB),最终在准确率损失很小的情况下,提高了训练效率。

要点四:重视AI系统的“非功能性需求”——从“能用”到“可靠”

很多AI架构师会忽略“非功能性需求”(比如可靠性、可维护性、安全性、伦理),但这些需求往往是AI系统“能否长期运行”的关键。

1. 可靠性:让系统“不崩溃”

问题:数据 pipeline 中断、模型训练失败、推理服务崩溃,这些问题会导致AI系统无法正常运行。

解决方案:

- 数据 pipeline :用“重试机制”(比如Kafka的消息重试)、“容错机制”(比如Flink的 checkpoint 机制,当任务失败时,从 checkpoint 恢复);

- 模型训练:用“分布式训练”(比如多节点训练,当某个节点失败时,其他节点可以继续训练)、“模型 checkpoint”(比如每训练100步保存一次模型,当训练失败时,从最近的 checkpoint 恢复);

- 推理服务:用“健康检查”(比如K8s的liveness probe,定期检查pod是否正常运行)、“熔断机制”(比如Istio的熔断,当某个pod失败次数超过阈值时,停止向它发送请求)。

2. 可维护性:让系统“容易改”

问题:模型版本混乱(比如不知道当前线上用的是哪个版本的模型)、数据 pipeline 无法回溯(比如不知道某批数据是怎么处理的)、问题排查困难(比如不知道推理延迟高是因为模型还是因为网络)。

解决方案:

- 模型版本管理:用MLflow或DVC记录模型的版本(比如模型的参数、训练数据、评估指标),这样可以快速回滚到之前的版本;

- 数据 lineage :用Apache Atlas或AWS Glue记录数据的流转过程(比如数据从哪里来,经过了哪些处理,到哪里去),这样可以快速排查数据问题;

- 监控与日志:用Prometheus(监控)+ Grafana(可视化)+ ELK(日志) stack,收集系统的关键指标(比如数据延迟、模型准确率、服务延迟),这样可以快速定位问题。

3. 安全性:让系统“不被攻击”

问题:对抗样本(比如用微小的扰动修改图像,让模型把猫识别成狗)、数据泄露(比如用户的隐私数据被窃取)、模型篡改(比如黑客修改模型的权重,让推荐系统推荐恶意商品)。

解决方案:

- 对抗样本检测:用对抗样本检测模型(比如Feature Squeezing)识别恶意输入;

- 数据加密:用加密技术(比如AES)加密用户的隐私数据(比如身份证号、手机号),防止数据泄露;

- 模型安全:用模型签名(比如用哈希算法生成模型的签名,验证模型的完整性)、访问控制(比如用RBAC(基于角色的访问控制)限制模型的访问权限)。

4. 伦理:让系统“不伤人”

问题:模型偏见(比如推荐系统对女性用户推荐更多的化妆品,对男性用户推荐更多的电子产品)、可解释性差(比如模型拒绝了用户的贷款申请,但用户不知道为什么)。

解决方案:

- 偏见检测:用公平性工具(比如Fairlearn)检测模型的偏见(比如不同性别用户的推荐结果是否存在差异);

- 可解释性:用模型解释工具(比如SHAP、LIME)解释模型的决策过程(比如贷款申请被拒绝是因为用户的收入太低);

- 伦理审查:建立伦理审查委员会,评估AI系统的伦理风险(比如推荐系统是否会诱导用户过度消费)。

要点五:持续学习与技术迭代——跟上AI技术的“高速列车”

AI技术发展非常快,比如:

- 2021年,大模型(比如GPT-3)成为主流;

- 2022年,生成式AI(比如ChatGPT)爆发;

- 2023年,联邦学习(比如FedML)、边缘AI(比如Edge TPU)成为热点;

- 2024年,大模型的分布式训练(比如Megatron-LM)、推理优化(比如vLLM)成为重点。

作为AI架构师,必须保持持续学习,才能跟上技术的发展。

1. 如何持续学习?

- 读论文:关注顶级会议(比如NeurIPS、ICML、CVPR、ACL)的论文,了解最新的技术趋势;

- 学工具:学习开源工具(比如Hugging Face Transformers、Kubeflow、MLflow),提高开发效率;

- 参与社区:加入AI社区(比如GitHub、知乎、CSDN),与其他架构师交流经验;

- 做项目:通过项目实践(比如搭建一个大模型推理服务),巩固所学的技术。

2. 未来需要关注的技术趋势

- 大模型的分布式训练与推理:随着大模型的参数越来越大(比如万亿级),分布式训练与推理的技术(比如模型并行、流水线并行、张量并行)会成为重点;

- 联邦学习:联邦学习(Federated Learning)可以让多个机构在不共享数据的情况下共同训练模型,解决数据隐私问题,未来会在金融、医疗等领域广泛应用;

- 边缘AI:边缘AI(Edge AI)是指在边缘设备(比如手机、摄像头)上运行AI模型,减少数据传输的延迟,未来会在物联网(IoT)领域广泛应用;

- 生成式AI的工程化:生成式AI(比如ChatGPT、MidJourney)的工程化(比如 prompt 工程、模型微调、推理优化)会成为重点,因为生成式AI的应用场景(比如内容生成、代码生成)越来越广泛。

四、进阶探讨:AI架构师的“避坑指南”与“最佳实践”

1. 常见陷阱:不要踩这些“坑”

- 陷阱一:过度追求模型复杂度:为了提高一点准确率,用了非常大的模型,导致推理延迟太高,无法上线;

- 陷阱二:忽略数据 pipeline 的健壮性:数据采集中断,导致模型训练数据缺失,结果模型性能下降;

- 陷阱三:缺乏监控与反馈 loop:模型部署后,没有监控其性能变化(比如准确率下降、延迟上升),导致问题持续存在;

- 陷阱四:不考虑成本:用了太多的GPU,导致算力成本过高,超过了项目的预算;

- 陷阱五:忽略伦理与安全:模型存在偏见或安全漏洞,导致用户投诉或法律风险。

2. 最佳实践:这些经验能帮你少走弯路

- 实践一:从“最小可行系统”(MVP)开始:先搭建一个简单的端到端系统(比如用小数据集、简单模型),验证可行性,再逐步优化(比如换成大数据集、复杂模型);

- 实践二:建立“模型-数据-反馈”的闭环:比如推荐系统中,模型推荐的结果被用户点击,这些点击数据会被收集回来,用于模型的 retrain,形成闭环;

- 实践三:拥抱开源工具与生态:比如用Hugging Face的Transformers库做模型开发(减少重复造轮子),用Kubeflow做ML pipeline(提高开发效率),用Prometheus做监控(快速定位问题);

- 实践四:定期做“系统复盘”:比如每个项目结束后,复盘系统的优点与缺点(比如数据 pipeline 的延迟是否满足需求,模型的推理性能是否达标),总结经验教训;

- 实践五:关注用户需求:AI系统的最终目标是满足用户需求,所以要定期与用户沟通(比如产品经理、运营人员),了解用户的反馈(比如推荐结果是否准确,服务延迟是否可以接受)。

五、结论:成为优秀AI系统架构师的“终极密码”

1. 核心要点回顾

- 思维方式:建立“端到端”的系统思维,拒绝“局部最优”;

- 技术能力:深度掌握AI核心组件(数据、模型、服务)的设计与优化;

- 双维能力:具备“工程化+算法”的双维能力,拒绝“偏科”;

- 非功能性需求:重视可靠性、可维护性、安全性、伦理,让系统“长期可用”;

- 持续学习:跟上AI技术的发展,保持学习的热情。

2. 未来展望

AI技术的发展会越来越快,比如大模型、生成式AI、联邦学习、边缘AI等技术会越来越成熟。作为AI架构师,需要保持开放的心态,勇于尝试新技术,同时保持务实的态度,关注技术的落地价值。

3. 行动号召

如果你想成为优秀的AI系统架构师,现在就可以开始行动:

- 做一个小项目:比如搭建一个“实时图像分类系统”,覆盖数据采集、模型训练、推理服务、监控等环节;

- 学一个开源工具:比如学习Kubeflow,搭建一个ML pipeline;

- 参与社区讨论:比如在知乎或GitHub上分享你的项目经验,与其他架构师交流。

最后,送给所有AI架构师一句话:

AI系统的价值,不在于“用了多少先进的算法”,而在于“解决了多少实际的问题”。做一个“务实的架构师”,让AI真正为用户创造价值。

参考资料

- 《AI系统架构设计》(作者:李航);

- 《深度学习工程化实践》(作者:王健宗);

- Gartner《2024年AI技术趋势报告》;

- Hugging Face《Transformer模型优化指南》;

- Kubernetes《云原生AI部署最佳实践》。

(全文完)

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)