你的 AI 消息发出去后,到底经历了什么?一次 AI 对话的“黑盒”揭秘!

本文通过Cherry Studio工具揭秘AI对话背后的机制:当我们向大模型提问时,系统会将历史对话内容(用户提问+AI回答)与新问题拼接发送,使AI保持上下文理解。但对话轮数有限制(默认20轮),超过会影响效果、增加费用并降低响应速度。文章还解析了请求参数含义(如temperature控制随机性、top_p影响采样范围),并推荐开启新对话优化体验。通过开发者模式可直观观察请求过程,帮助用户理解A

1. 99% 的人不知道事

现在很多人都开始拥抱AI ,都在通过向大模型提问来解决问题。

不知道你是否曾经想过,我们输入完提示词,点击发送以后发生了啥?

为什么我们聊天时 AI 可以知道上一轮对话的信息?

本文借助 Cherry Studio 让你“看见”这个过程,彻底搞懂是怎么回事!

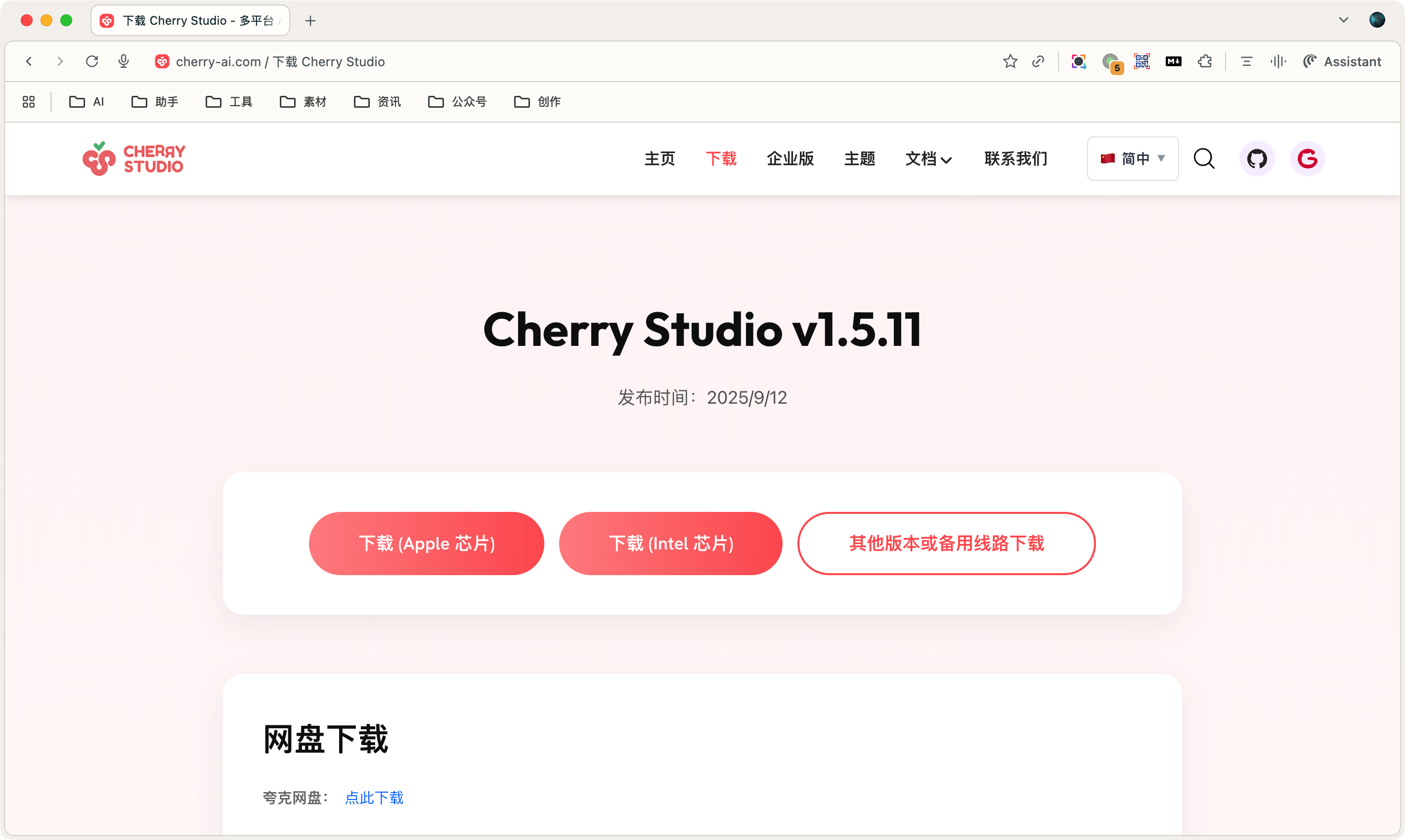

2. 工欲善其事,必先利其器

我们需要先从 Cherry Studio 官网(地址:https://www.cherry-ai.com/download) ,下载并安装软件。

有些同学可能会说为啥选这个软件?

- 它本身开源/免费

- 默认有几款免费的模型可以使用

- 可以通过本文介绍的技巧,看到执行过程

- 可以 Github 阅读源码,对照学习

3. 揭开神秘面纱

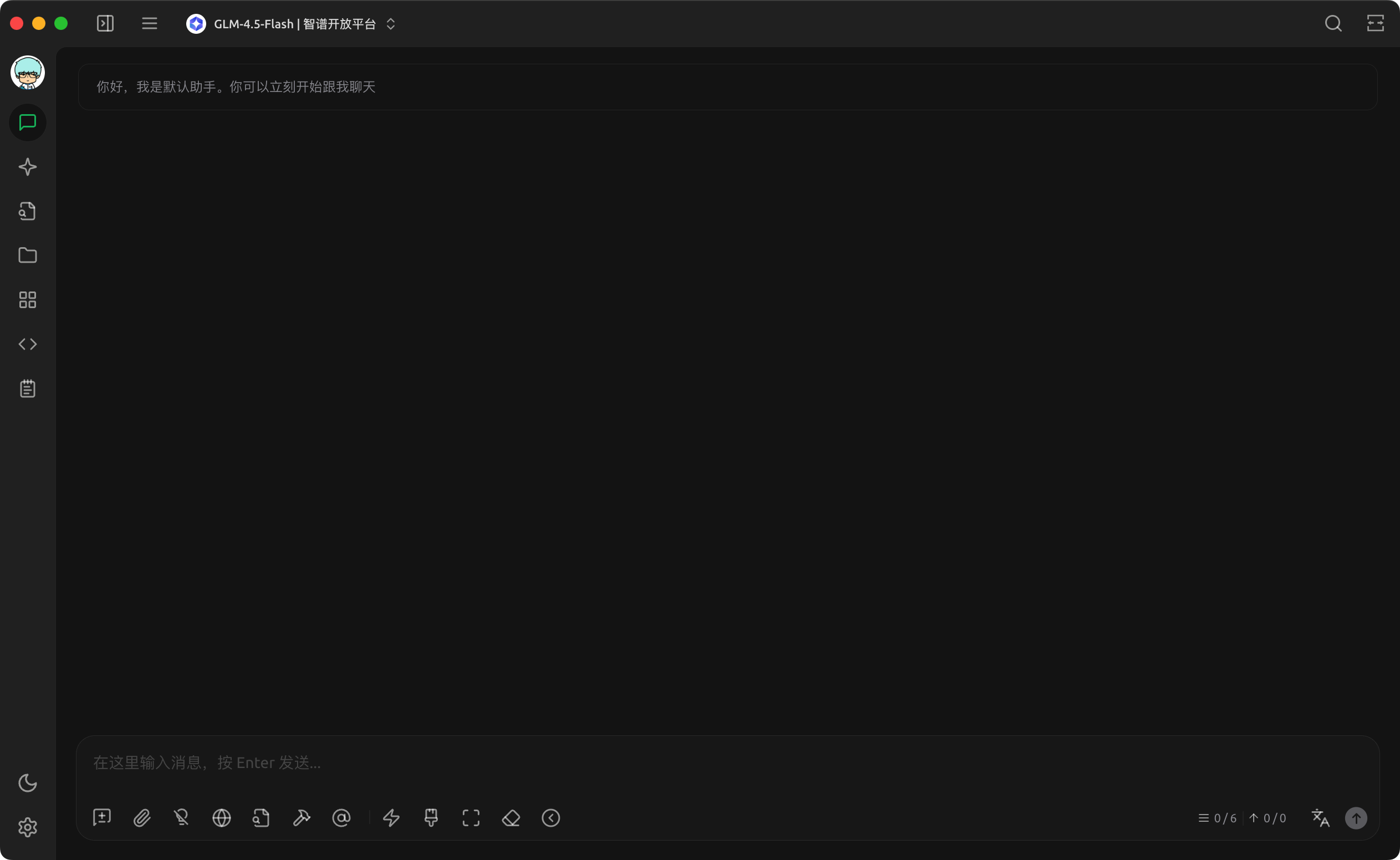

为了降低理解的难度,我们先不考虑知识库和/MCP / 全局记忆等场景,仅考虑最普通的对话场景。

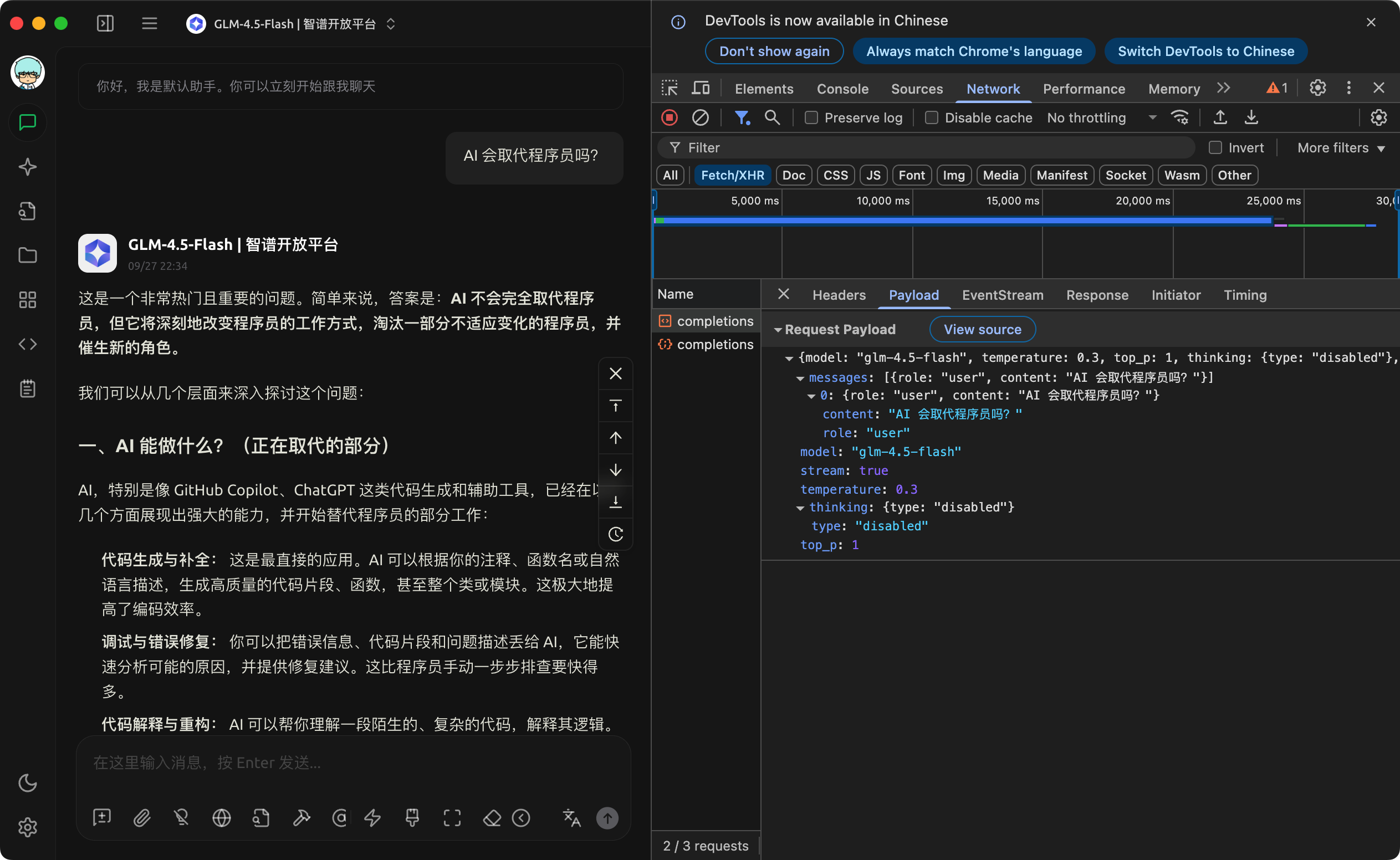

我们打开软件,可以看到类似上面的界面。

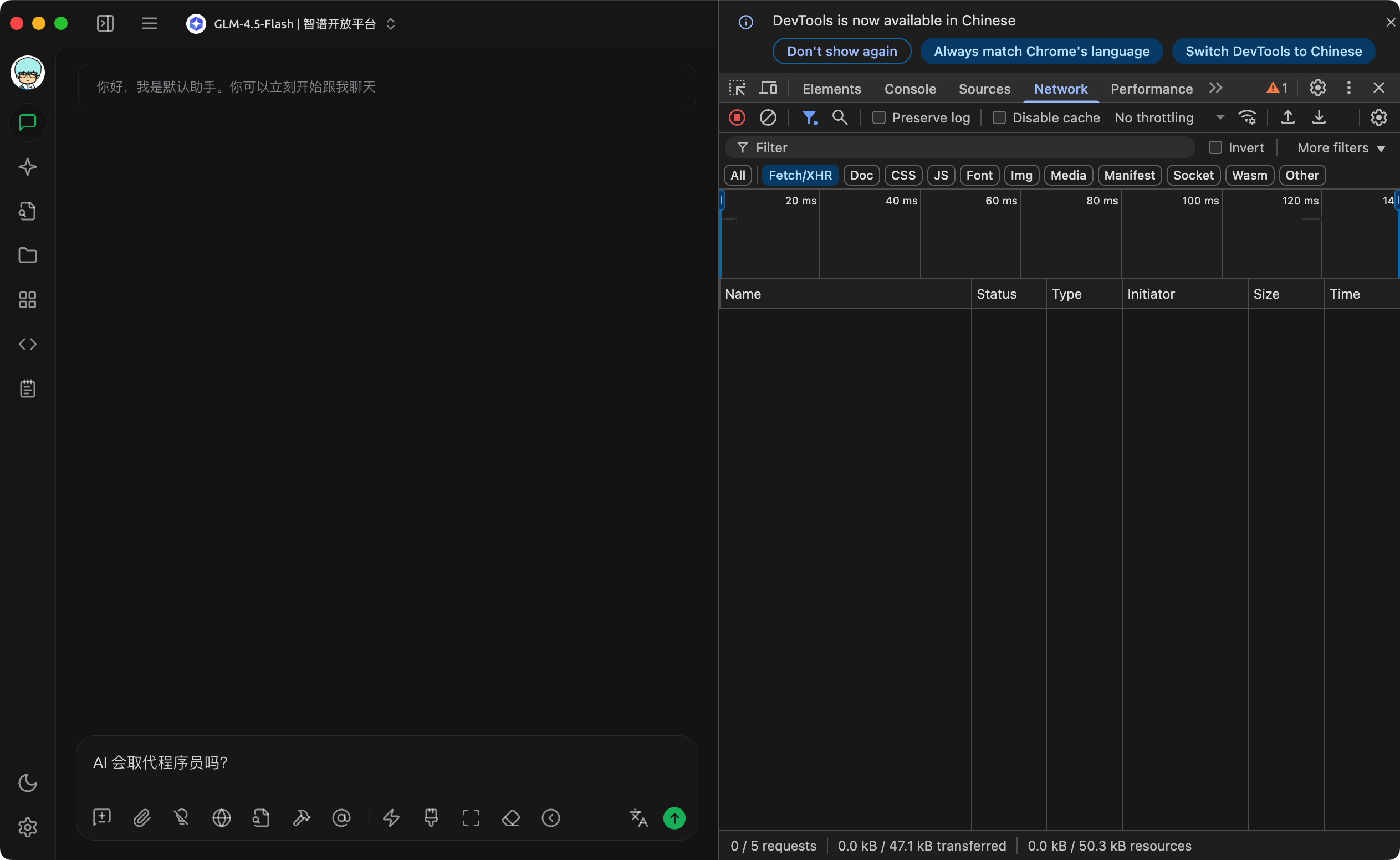

按下神秘的快捷键:

- Mac 电脑: command + option + i

- Windows 电脑:ctrl + shift + i

当我们发送第一个问题时,我们在 “Network” 选项卡中可以看到 Cherry Studio 发送了请求。

在 Playload 中,我们可以看到发送请求信息:

请求 URL : https://api.cherry-ai.com/chat/completions

请求的参数:

{

"model": "glm-4.5-flash",

"temperature": 0.3,

"top_p": 1,

"thinking": {

"type": "disabled"

},

"messages": [

{

"role": "user",

"content": "AI 会取代程序员吗?"

}

],

"stream": true

}

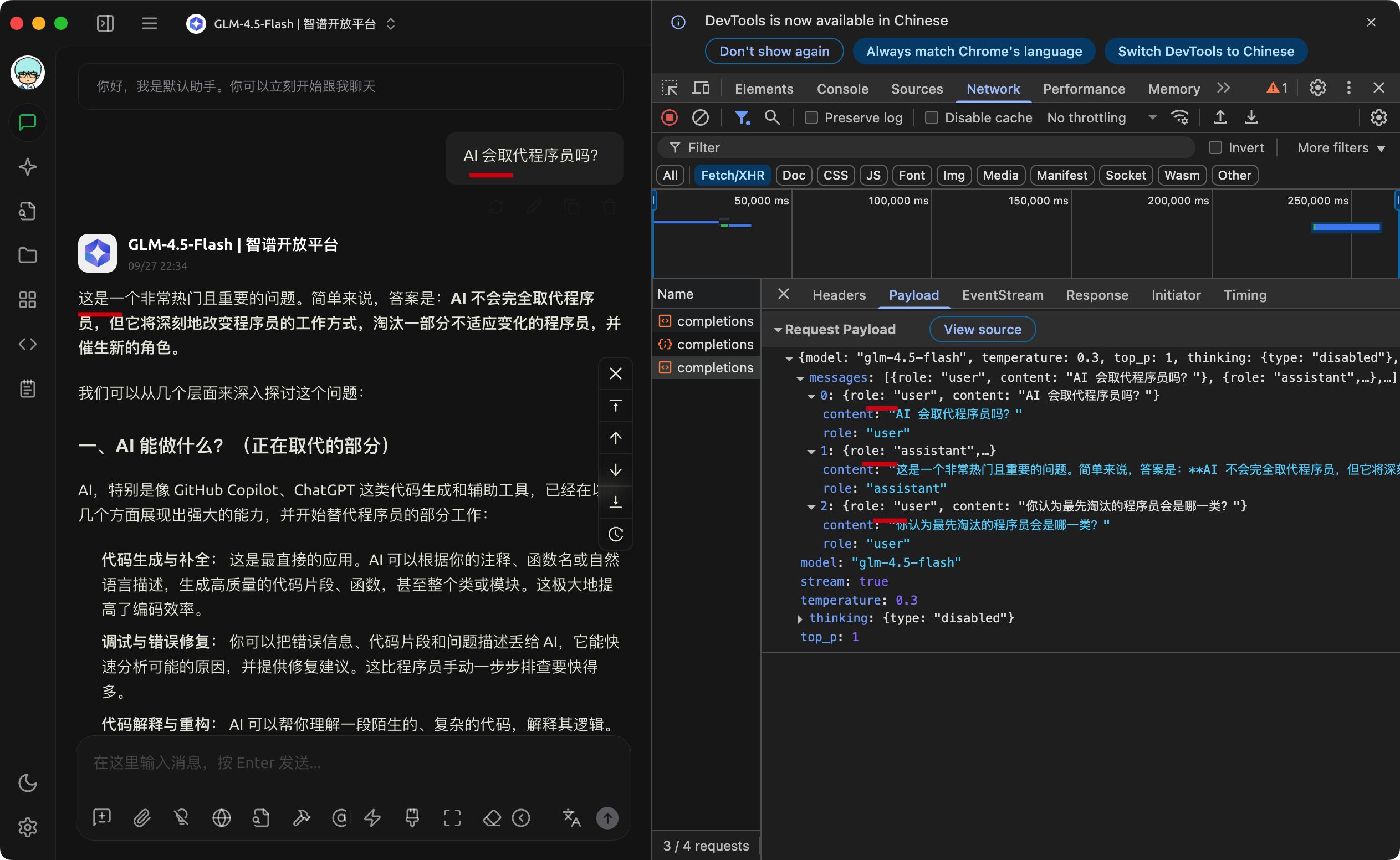

那么,当我们再发送一轮请求,又会是什么样的情况?

我们可以观察到,当我们发送新问题时:

Cherry Studio 会将我们发送的问题和 AI 的回答,加上当前新问题一起叠加发给大模型。

这也就可以解释了,为什么它知道上面的对话内容。

4. 可能的疑问

4.1 对话会一直叠加?

有些同学可能会问了,这个对话会一直叠加吗?

答案是一般不会!

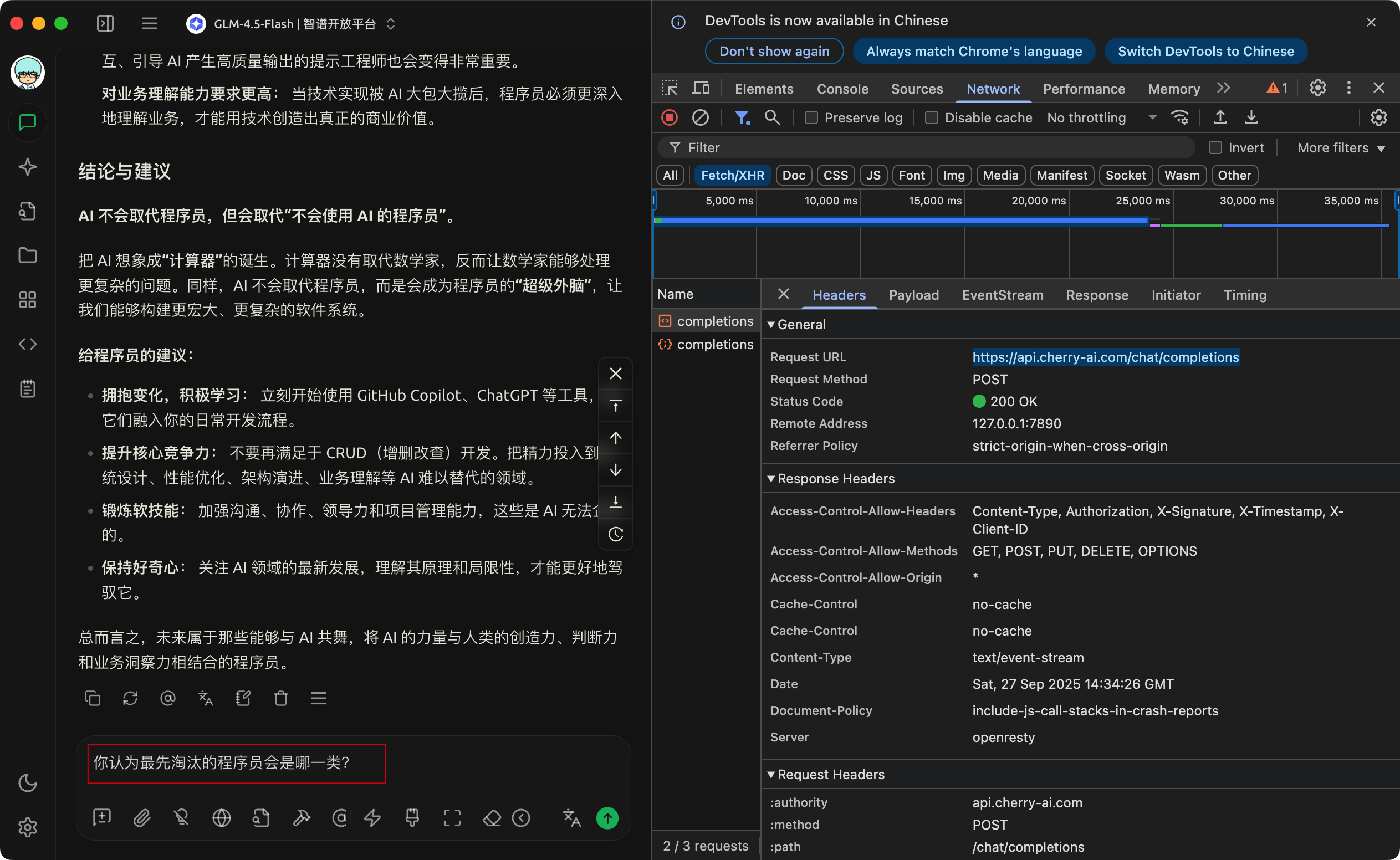

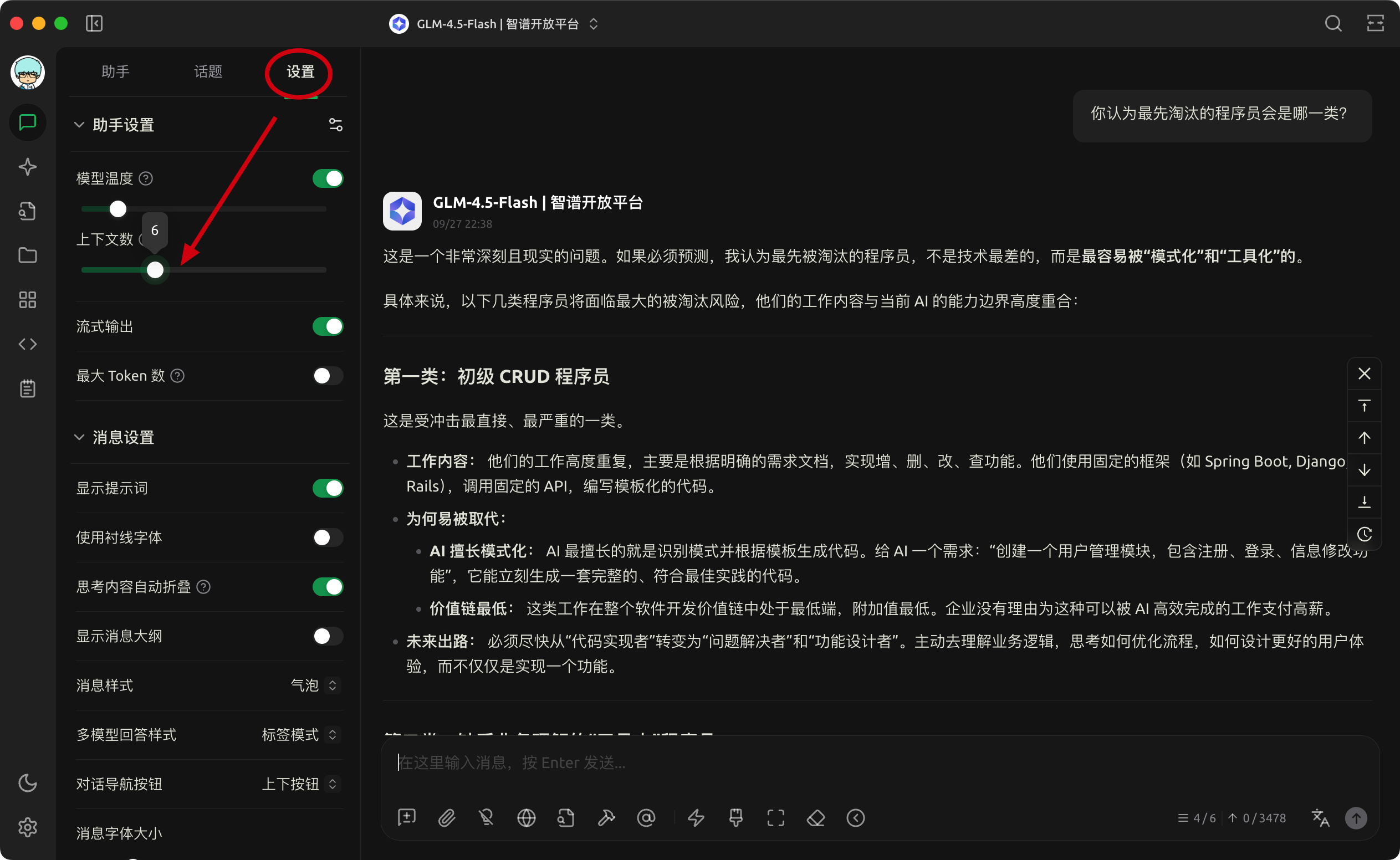

在 Cherry Studio 中,打开助手的【设置】,可以设置 【上下文数】。

这个数字就是叠加给大模型的最近多少消息数(Cherry Studio 中最大 20轮),超过则会丢弃或压缩!

那么,为什么要这么做?

因为,随着上下文的叠加。

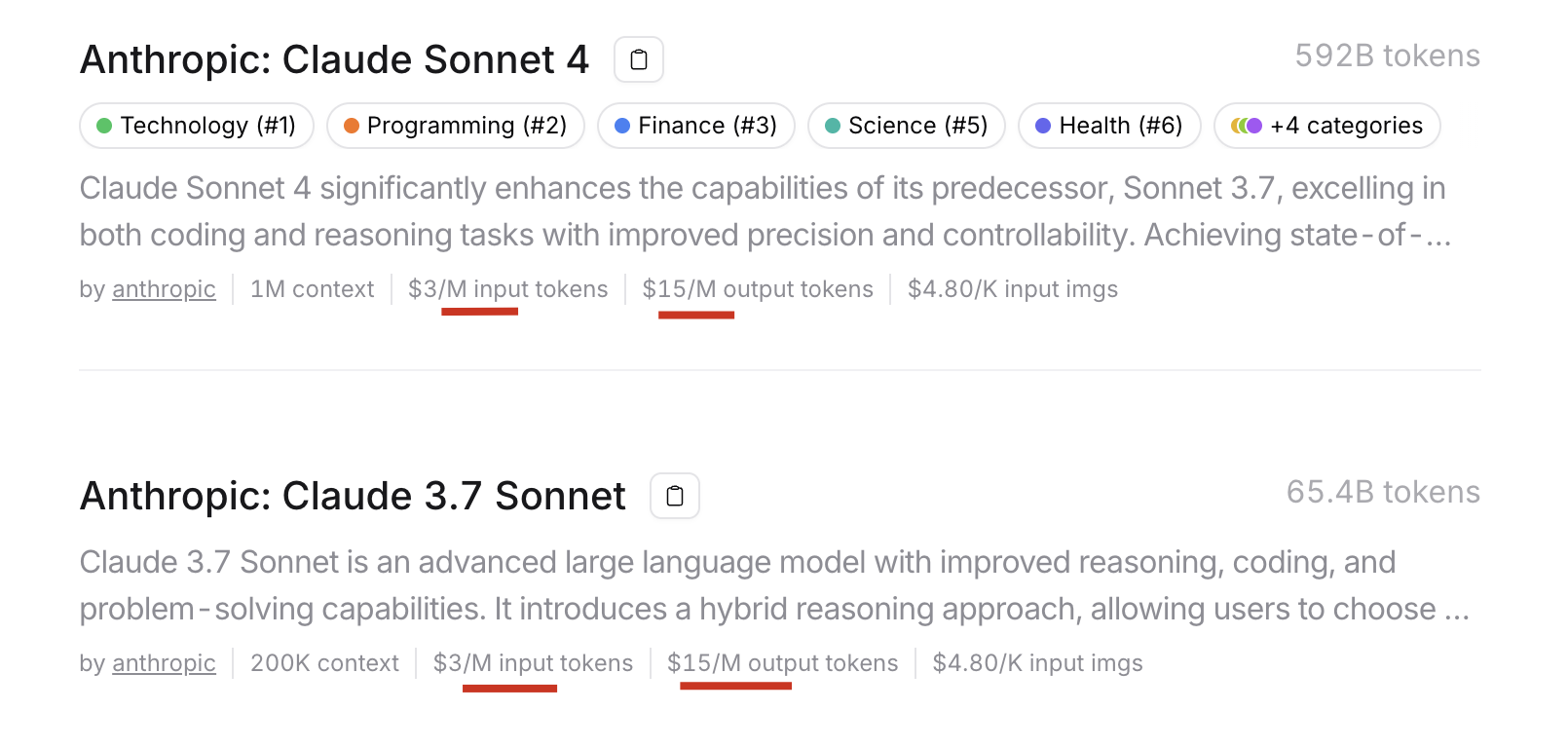

费用增加,模型厂商是根据输入和输出 Tokens 计费的!

不同服务商价格可能有差异,OpenRouter 参见:https://openrouter.ai/models

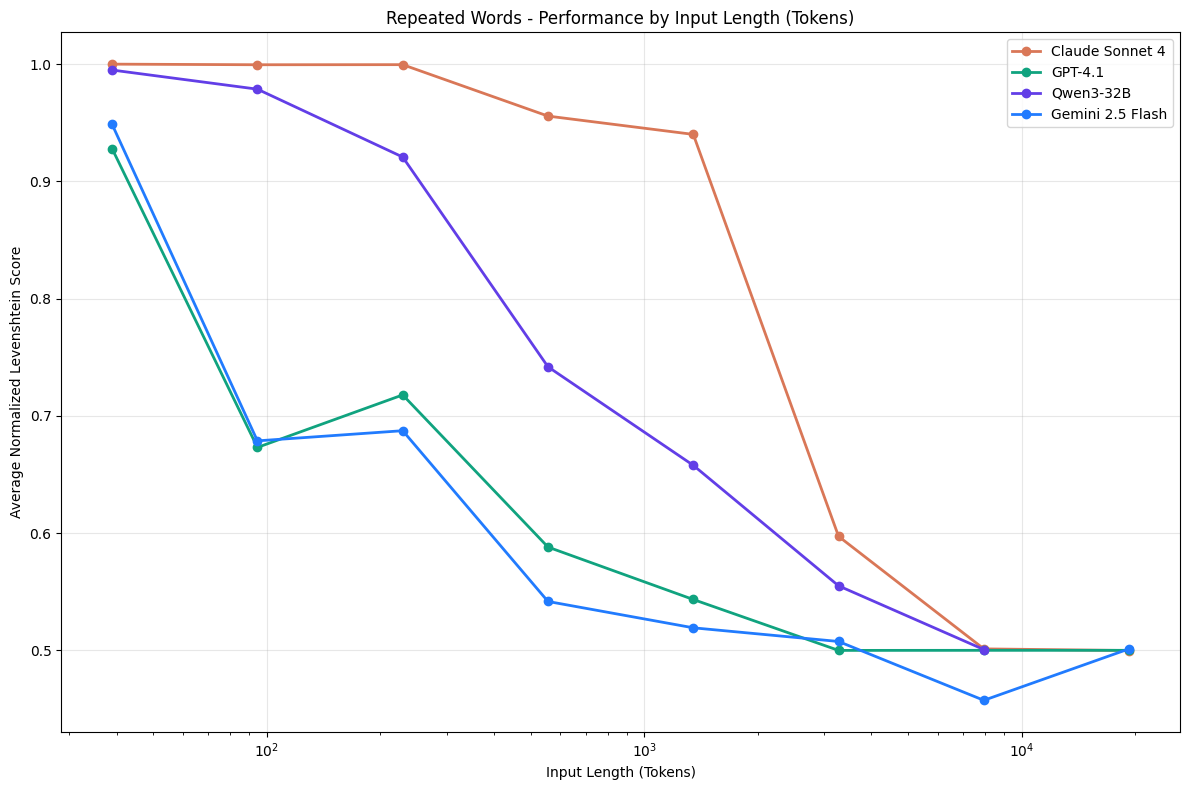

效果会下降(忽略部分内容,出现幻觉等)!!哪怕是非常先进的模型,当上下文超过 10的三次方都会下降!

详情参见:https://research.trychroma.com/context-rot

而且,通常来说输入过长,输出的速度也会变慢。

因此,新的内容我们最好果断开启新的对话!

4.2 其他参数具体含义是什么?

{

// 本次调用使用的模型名

"model": "glm-4.5-flash",

// 控制生成内容的随机性,取值范围通常是 0~1

// 值越低,输出越确定性和稳定,越高则更富有创造性和变化

"temperature": 0.3,

// nucleus sampling 截断概率累积阈值,取值 0~1

// 只从累积概率 ≤ top_p 的词中采样。常与 temperature 搭配使用

"top_p": 1,

// 是否启用思维链、深度推理等功能

// "disabled" 表示不在后台启用思维过程;默认只返回最终回答

"thinking": {

"type": "disabled"

},

// 输入消息列表,对话历史按照角色区分

// role 一般有 "system"(系统提示), "user"(用户输入), "assistant"(模型回复)

"messages": [

{

"role": "user",

// 用户提出的问题内容

"content": "AI 会取代程序员吗?"

}

],

// 是否启用流式输出

// true 表示模型会逐步返回内容片段,常用于实时对话显示

"stream": true

}

更多参数参见:https://openrouter.ai/docs/api-reference/completion

5. 总结

开启 Cherry Studio 的开发者模式,我们可以“看见”工具与模型的交互过程,更好地理解背后的机制。

希望本文对大家有帮助。

悟鸣,悟出人生真谛,方能一鸣惊人。

如果你认为文章对你有帮助,欢迎关注我的 CSDN 账号和公众号(见下方↓),一起跟上 AI 发展步伐。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)