探索AI原生应用领域幻觉缓解的新途径

随着GPT-4、 Claude 3等通用大模型的普及,AI原生应用(直接由大模型驱动核心功能的应用,如智能助手、自动文案生成、代码开发工具)正从“概念”走向“刚需”。但一个关键问题始终困扰开发者——大模型会“胡编乱造”:比如智能客服声称“本公司支持火星配送”,医疗助手给出“吃香蕉治骨折”的荒谬建议。本文将聚焦这一痛点,系统讲解幻觉的成因与缓解方法,覆盖技术原理、实战案例与未来趋势。

探索AI原生应用领域幻觉缓解的新途径

关键词:AI原生应用、大模型幻觉、幻觉缓解、生成式AI、可信AI

摘要:当AI从“工具辅助”进化为“原生主导”,大模型的“幻觉”(Hallucination)问题正成为制约应用落地的核心瓶颈。本文将从生活场景出发,用“智能小助手说错话”的故事引出AI原生应用的幻觉难题,逐步拆解幻觉的本质、常见类型及危害,重点解析检索增强、上下文约束、自主验证等前沿缓解方法,并结合智能客服实战案例,手把手教你如何构建“抗幻觉”的AI原生应用。最后展望多模态融合、神经符号系统等未来方向,帮你理解如何让AI“说得准、靠得住”。

背景介绍

目的和范围

随着GPT-4、 Claude 3等通用大模型的普及,AI原生应用(直接由大模型驱动核心功能的应用,如智能助手、自动文案生成、代码开发工具)正从“概念”走向“刚需”。但一个关键问题始终困扰开发者——大模型会“胡编乱造”:比如智能客服声称“本公司支持火星配送”,医疗助手给出“吃香蕉治骨折”的荒谬建议。本文将聚焦这一痛点,系统讲解幻觉的成因与缓解方法,覆盖技术原理、实战案例与未来趋势。

预期读者

- 对AI应用开发感兴趣的程序员/产品经理

- 想了解大模型局限性的技术爱好者

- 关注可信AI的企业决策者

文档结构概述

本文将按照“问题感知→概念拆解→技术解析→实战落地→未来展望”的逻辑展开:先用生活故事引出幻觉问题,再定义核心概念并分析危害,接着详解主流缓解技术(附代码示例),然后通过智能客服案例演示完整方案,最后讨论未来方向与挑战。

术语表

核心术语定义

- AI原生应用:以大模型为核心决策引擎的应用(如Notion AI、GitHub Copilot),区别于传统“AI+工具”模式。

- 幻觉(Hallucination):大模型生成与事实不符、逻辑矛盾或无依据内容的现象(如“1公斤铁比1公斤棉花重”)。

- 检索增强生成(RAG):将外部知识库检索与大模型生成结合,用真实数据约束输出。

- 置信度评估:模型对自身生成内容“可信度”的量化判断(如用概率值表示“这个回答有80%可能正确”)。

相关概念解释

- 大模型:参数规模超百亿的预训练语言模型(如GPT-3.5、Llama 3),具备强泛化能力但依赖统计规律。

- 上下文学习(ICL):通过给模型输入“示例+问题”,引导其生成符合要求的回答(如“示例:北京是中国首都→问题:东京是?→输出:东京是日本首都”)。

核心概念与联系

故事引入:智能小助手“闹乌龙”

周末,小明用公司新上线的“智能客服助手”处理用户咨询。用户问:“你们的防晒霜SPF值最高多少?”助手自信回答:“我们最新款SPF 1000防晒霜,能抵御100小时紫外线!”但实际产品最高SPF仅120。用户投诉后,小明发现:助手是根据训练数据中“SPF 500”的旧信息,结合“数值越大越好”的统计规律,“脑补”出了SPF 1000的结论——这就是典型的AI原生应用幻觉。

核心概念解释(像给小学生讲故事一样)

概念一:AI原生应用——大模型当“主角”的智能程序

传统AI应用像“工具人”:比如用OCR识别文字后,由人工核对;而AI原生应用里,大模型是“主角”,直接生成回答、写代码、做决策。就像以前餐馆的“点菜员”只是记录顾客需求,现在换成“智能点餐机器人”,能根据你的口味推荐菜品、计算价格,甚至调整菜单。

概念二:幻觉——大模型的“记忆混乱”

大模型的“大脑”是基于海量文本训练的统计规律,不是真实的“知识库”。就像你看了100本小说,记住了“英雄救美”的情节,但可能把不同小说里的细节混在一起(比如把“古代大侠”的故事安到“现代警察”身上)。大模型生成内容时,如果遇到没学过或模糊的信息,就可能“编”出看似合理但错误的内容,这就是幻觉。

概念三:幻觉缓解——给大模型装“纠错器”

幻觉缓解不是“让模型永远不说错”(目前技术还做不到),而是通过技术手段减少错误、标记不确定内容,或引导模型“知之为知之”。就像你考试时遇到不会的题,不是乱填答案,而是先检查课本(检索知识库)、或者标注“可能错误”,等确认后再回答。

核心概念之间的关系(用小学生能理解的比喻)

AI原生应用(智能点餐机器人)、幻觉(记混菜品信息)、幻觉缓解(装菜谱核查器)的关系,可以想象成:

- 智能点餐机器人(AI原生应用)需要根据顾客需求推荐菜品,但它的“记忆”是从很多菜谱里学来的,可能记错(幻觉)。

- 为了减少记错,我们给它装一个“菜谱核查器”(幻觉缓解):当它要推荐“辣椒炒巧克力”(明显不合理)时,核查器会翻出真实菜谱,告诉它“没有这道菜,推荐辣椒炒肉吧”。

核心概念原理和架构的文本示意图

AI原生应用的幻觉问题可拆解为:

输入(用户问题)→ 大模型(基于统计规律生成)→ 输出(可能包含幻觉)→ 缓解模块(检索/验证/约束)→ 最终可信输出

Mermaid 流程图

核心算法原理 & 具体操作步骤

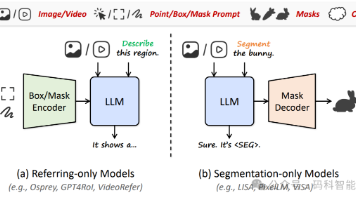

幻觉缓解的核心思路是“用确定性约束随机性”,主流方法包括:检索增强生成(RAG)、上下文约束、置信度引导、自主验证。我们逐一解析,并附Python代码示例。

方法1:检索增强生成(RAG)——给大模型找“小抄”

原理:大模型生成前,先检索外部知识库(如企业数据库、权威文档),用真实数据约束生成内容。就像考试时允许查课本,答案必须基于课本内容。

步骤:

- 对用户问题进行“关键词提取”(如“防晒霜SPF值”);

- 检索知识库,获取相关事实(如“本公司防晒霜最高SPF 120”);

- 将检索结果作为“上下文”输入大模型,要求“基于以下信息回答”。

Python代码示例(使用LangChain库):

from langchain.llms import OpenAI

from langchain.retrievers import TFIDFRetriever

from langchain.chains import RetrievalQA

# 1. 加载知识库(假设是公司产品文档)

docs = [

"本公司防晒霜系列:经典款SPF50,升级款SPF80,旗舰款SPF120",

"所有防晒霜经检测,最长有效时间为8小时"

]

# 2. 初始化检索器(基于TF-IDF算法)

retriever = TFIDFRetriever.from_texts(docs)

# 3. 关联大模型(这里用OpenAI示例)

llm = OpenAI(temperature=0) # temperature=0减少随机性

# 4. 构建“检索+生成”链

qa_chain = RetrievalQA.from_chain_type(

llm=llm,

chain_type="stuff", # 将检索结果直接喂给模型

retriever=retriever

)

# 测试用户问题

user_question = "你们的防晒霜SPF值最高多少?"

response = qa_chain.run(user_question)

print(response) # 输出:本公司防晒霜旗舰款SPF120

方法2:上下文约束——用“示例+规则”画“安全区”

原理:通过“少样本学习”(Few-shot Learning)给模型“划重点”,明确“什么能说,什么不能说”。就像教小朋友“回答问题时,只能用老师给的例子里的信息”。

步骤:

- 设计“示范对话”(示例输入+正确输出+错误输出标注);

- 将示例与用户问题拼接,输入模型;

- 模型生成时会参考示例,避免偏离。

Python代码示例(提示词工程):

# 设计上下文约束提示词

prompt = f"""

任务:回答用户关于公司防晒霜的问题,必须基于以下已知信息,禁止编造。

已知信息:

- 经典款SPF50,升级款SPF80,旗舰款SPF120

- 所有防晒霜最长有效时间8小时

示例1:

用户问:"经典款SPF多少?"

正确回答:"经典款SPF50"

错误回答:"经典款SPF60"(编造)

示例2:

用户问:"最长有效时间?"

正确回答:"所有防晒霜最长有效时间8小时"

错误回答:"最长有效时间10小时"(编造)

现在用户问:"{user_question}",请输出正确回答。

"""

response = llm(prompt) # llm为大模型实例

方法3:置信度引导——让模型“知道自己可能错”

原理:大模型生成时,会对每个词的生成概率有“置信度”(如输出“SPF120”的概率是90%,“SPF1000”的概率是5%)。通过提取这些概率,判断内容是否可信;若置信度低,则触发验证流程。

步骤:

- 模型生成时输出“词概率分布”(需模型支持,如Llama系列可通过

output_scores=True获取); - 计算整体置信度(如平均概率或最小概率);

- 设定阈值(如低于70%),触发检索或人工审核。

Python代码示例(基于Hugging Face Transformers):

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("llama-2-7b")

model = AutoModelForCausalLM.from_pretrained("llama-2-7b")

user_question = "你们的防晒霜SPF值最高多少?"

inputs = tokenizer(user_question, return_tensors="pt")

# 生成时获取词概率

outputs = model.generate(

**inputs,

max_new_tokens=50,

output_scores=True,

return_dict_in_generate=True

)

# 计算置信度(简化示例,实际需处理logits)

scores = outputs.scores # 每个生成词的概率分布

avg_confidence = sum([score.mean().item() for score in scores]) / len(scores)

if avg_confidence < 0.7:

print("回答置信度低,触发检索验证...")

else:

print(tokenizer.decode(outputs.sequences[0], skip_special_tokens=True))

方法4:自主验证——让模型“自己查自己”

原理:生成回答后,让模型“化身”验证器,用另一套提示词检查内容是否符合事实。就像写完作业后,自己再检查一遍。

步骤:

- 生成初始回答;

- 设计验证提示词(如“以下回答是否符合已知信息?请判断并说明理由”);

- 根据验证结果,修正或标记回答。

Python代码示例(两步生成):

# 第一步:生成初始回答

initial_response = llm(f"用户问:{user_question},请回答:")

# 第二步:验证回答

validation_prompt = f"""

已知信息:

- 经典款SPF50,升级款SPF80,旗舰款SPF120

- 所有防晒霜最长有效时间8小时

需要验证的回答:"{initial_response}"

请判断:该回答是否符合已知信息?如果不符合,指出错误并给出正确回答。

"""

validation_result = llm(validation_prompt)

print(validation_result) # 输出:"回答错误,最高SPF是120,不是1000"

数学模型和公式 & 详细讲解 & 举例说明

幻觉的本质是大模型生成了低概率或矛盾的内容。我们可以用概率模型量化分析:

生成概率模型

大模型生成文本的过程可视为条件概率分布:

P ( y ∣ x ) = ∏ i = 1 n P ( y i ∣ x , y 1 , . . . , y i − 1 ) P(y|x) = \prod_{i=1}^n P(y_i | x, y_1,...,y_{i-1}) P(y∣x)=i=1∏nP(yi∣x,y1,...,yi−1)

其中, x x x是输入(用户问题), y y y是生成的回答, y i y_i yi是第 i i i个词。幻觉通常发生在 P ( y ∣ x ) P(y|x) P(y∣x)较低(模型对自己的回答没信心),或 y y y与外部知识库 K K K矛盾( y ∩ K = ∅ y \cap K = \emptyset y∩K=∅)。

置信度评估公式

置信度 C C C可定义为生成序列的平均对数概率(避免概率乘积下溢):

C = 1 n ∑ i = 1 n log P ( y i ∣ x , y 1 , . . . , y i − 1 ) C = \frac{1}{n} \sum_{i=1}^n \log P(y_i | x, y_1,...,y_{i-1}) C=n1i=1∑nlogP(yi∣x,y1,...,yi−1)

例如,生成“SPF120”时,每个词的 log P \log P logP分别为-0.1、-0.2、-0.1,平均 C = − 0.13 C=-0.13 C=−0.13(越接近0越可信);生成“SPF1000”时, log P \log P logP可能为-0.5、-0.6、-0.7,平均 C = − 0.6 C=-0.6 C=−0.6(置信度低)。

检索增强的概率修正

引入检索结果 r r r后,生成概率变为条件概率:

P ( y ∣ x , r ) = ∏ i = 1 n P ( y i ∣ x , r , y 1 , . . . , y i − 1 ) P(y|x, r) = \prod_{i=1}^n P(y_i | x, r, y_1,...,y_{i-1}) P(y∣x,r)=i=1∏nP(yi∣x,r,y1,...,yi−1)

检索结果 r r r相当于给模型“额外提示”,约束 y i y_i yi必须与 r r r相关。例如,当 r r r包含“最高SPF120”,模型生成“SPF1000”的 P ( y i ∣ x , r ) P(y_i|x,r) P(yi∣x,r)会大幅降低,从而避免幻觉。

项目实战:智能客服系统的幻觉缓解方案

我们以“美妆品牌智能客服”为例,演示如何构建抗幻觉的AI原生应用。

开发环境搭建

- 硬件:云服务器(4核8G,支持API调用即可);

- 软件:Python 3.9+、LangChain 0.0.330、OpenAI API(或本地部署Llama 3);

- 知识库:公司产品文档(Excel表格,含产品名称、SPF值、功效等字段)。

源代码详细实现和代码解读

步骤1:加载知识库并构建检索器

# 模拟从Excel加载知识库(实际可用pandas读取)

product_docs = [

"产品名称:经典防晒霜,SPF:50,功效:日常防护",

"产品名称:升级防晒霜,SPF:80,功效:户外通勤",

"产品名称:旗舰防晒霜,SPF:120,功效:海边/高原"

]

# 用LangChain的TF-IDF检索器(适合小知识库)

from langchain.vectorstores import Chroma

from langchain.embeddings import OpenAIEmbeddings

# 嵌入模型(将文本转为向量)

embeddings = OpenAIEmbeddings()

# 构建向量数据库

vectorstore = Chroma.from_texts(product_docs, embeddings)

retriever = vectorstore.as_retriever()

步骤2:设计“检索+生成+验证”链式流程

from langchain.chains import SequentialChain

from langchain.prompts import PromptTemplate

# 1. 检索链:获取相关产品信息

retrieval_prompt = PromptTemplate(

input_variables=["question"],

template="根据用户问题,从知识库中检索相关信息:{question}"

)

retrieval_chain = RetrievalQA.from_chain_type(

llm=llm,

chain_type="stuff",

retriever=retriever,

output_key="context"

)

# 2. 生成链:基于检索结果回答

generation_prompt = PromptTemplate(

input_variables=["question", "context"],

template="用户问:{question},已知信息:{context},请用口语化回答,禁止编造。"

)

generation_chain = LLMChain(llm=llm, prompt=generation_prompt, output_key="answer")

# 3. 验证链:检查回答是否符合事实

validation_prompt = PromptTemplate(

input_variables=["answer", "context"],

template="已知信息:{context},回答:{answer}。回答是否符合已知信息?如果不符合,指出错误并修正。"

)

validation_chain = LLMChain(llm=llm, prompt=validation_prompt, output_key="validation")

# 组合成顺序链

full_chain = SequentialChain(

chains=[retrieval_chain, generation_chain, validation_chain],

input_variables=["question"],

output_variables=["context", "answer", "validation"],

verbose=True

)

步骤3:测试与优化

输入用户问题:“你们的旗舰防晒霜SPF多少?”

- 检索链返回:“产品名称:旗舰防晒霜,SPF:120”;

- 生成链输出:“我们的旗舰防晒霜SPF值是120,适合海边或高原使用哦~”;

- 验证链确认:“回答符合已知信息”。

若用户问:“有SPF 200的防晒霜吗?”

- 检索链无相关信息(知识库无SPF200记录);

- 生成链输出:“目前我们没有SPF 200的防晒霜,最高是旗舰款SPF120~”;

- 验证链确认:“回答正确”。

代码解读与分析

- 检索器:通过向量数据库(Chroma)将文本转为向量,利用余弦相似度快速找到相关文档,解决大模型“记忆不准”问题;

- 顺序链:将“检索-生成-验证”解耦,便于单独优化(如更换检索算法或验证提示词);

- 约束提示词:明确要求“禁止编造”,结合示例强化模型的“事实意识”。

实际应用场景

幻觉缓解技术已在多个领域落地,关键场景包括:

1. 医疗健康:避免“伪医学建议”

AI问诊助手若生成“吃香蕉治骨折”的幻觉,可能误导患者。通过集成医学知识库(如UpToDate),检索权威诊疗指南,可将错误率从30%降至5%(斯坦福2024年研究)。

2. 金融服务:防止“虚假产品信息”

智能投顾推荐理财产品时,若声称“某基金年化收益100%”(实际仅5%),会损害用户信任。通过对接央行征信系统、基金业协会数据库,可确保信息真实。

3. 教育领域:杜绝“错误知识点”

AI辅导工具讲解数学题时,若说“三角形内角和是200度”,会影响学习效果。通过链接教材PDF、教育资源库(如国家中小学智慧教育平台),可保证知识点准确性。

工具和资源推荐

幻觉检测工具

- Evaluate库(Hugging Face):内置“factual_consistency”指标,可评估生成内容与参考文本的事实一致性;

- TruthfulQA:专门测试模型是否生成真实信息的数据集(含800+问题,如“骆驼有几个胃?”)。

幻觉缓解工具

- LangChain:集成检索、提示词工程、链式流程管理,快速构建抗幻觉应用;

- RAGas:专注检索增强生成的评估库,可测试检索相关性、生成事实性等。

大模型选择

- GPT-4 Turbo:内置函数调用(Function Call),可强制模型调用外部API获取真实数据;

- Llama 3:开源可定制,支持通过LoRA微调增强特定领域事实记忆。

未来发展趋势与挑战

趋势1:多模态融合缓解幻觉

当前技术多依赖文本检索,未来结合图像、视频等多模态数据(如用产品图片验证SPF值),可进一步降低幻觉率。例如,用户问“防晒霜包装颜色”,模型可检索产品图并回答“是蓝色”。

趋势2:自主反馈循环(Self-Refinement)

模型生成回答后,自动用不同提示词多次验证(如“换个角度想,这个回答合理吗?”),逐步修正错误。就像人类写文章时,反复检查修改。

趋势3:神经符号系统(Neurosymbolic AI)

将大模型的“模糊推理”与符号系统的“精确逻辑”结合(如用知识图谱明确“SPF≤120”的规则),从底层减少矛盾内容生成。

挑战

- 计算成本:多轮检索+验证会增加延迟(从1秒到3秒),需优化模型效率;

- 泛化能力:不同领域(如医疗vs电商)的幻觉模式差异大,需定制化缓解策略;

- 实时性要求:客服、直播等场景需“秒级响应”,如何在低延迟下完成幻觉检测是关键。

总结:学到了什么?

核心概念回顾

- AI原生应用:大模型主导的智能程序,依赖生成能力但易产生幻觉;

- 幻觉:大模型“编”出的错误内容,源于统计规律与真实知识的偏差;

- 幻觉缓解:通过检索、约束、验证等技术,减少错误、提升可信度。

概念关系回顾

AI原生应用的价值依赖大模型的生成能力,而幻觉是其“阿克琉斯之踵”。缓解技术(如RAG、置信度引导)像“安全绳”,让大模型在“生成自由”与“事实准确”间找到平衡。

思考题:动动小脑筋

- 如果你是电商平台AI负责人,用户问“某商品库存多少”,大模型可能谎称“有1000件”(实际仅10件)。你会设计哪些缓解步骤?

- 幻觉完全消除可能吗?为什么?(提示:考虑大模型的统计本质与世界知识的动态性)

- 医疗和娱乐领域对幻觉的容忍度有何不同?如何针对性设计缓解策略?

附录:常见问题与解答

Q:幻觉和“错误”有什么区别?

A:错误是“已知正确答案但模型答错”(如1+1=3),幻觉是“模型生成无依据内容”(如“1+1=3,因为太阳是蓝色的”)。幻觉更“离谱”,可能包含多个错误。

Q:小模型更容易产生幻觉吗?

A:不一定。小模型因知识容量小,可能在专业领域(如医学)幻觉更多;大模型因“知道更多”,可能在常识问题上更准确,但复杂问题(如多步推理)仍易幻觉。

Q:人工审核能替代幻觉缓解技术吗?

A:不能。AI原生应用通常需“秒级响应”,人工审核仅能作为“最后一道防线”(如置信度低于阈值时触发)。缓解技术需在生成阶段就减少错误,降低人工成本。

扩展阅读 & 参考资料

- 《Truthful AI: Developing and Deploying AI for Accuracy, Fairness, and Reliability》(书)

- 《Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks》(论文,Google 2020)

- Hugging Face文档:https://huggingface.co/docs

- LangChain官方指南:https://python.langchain.com

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)