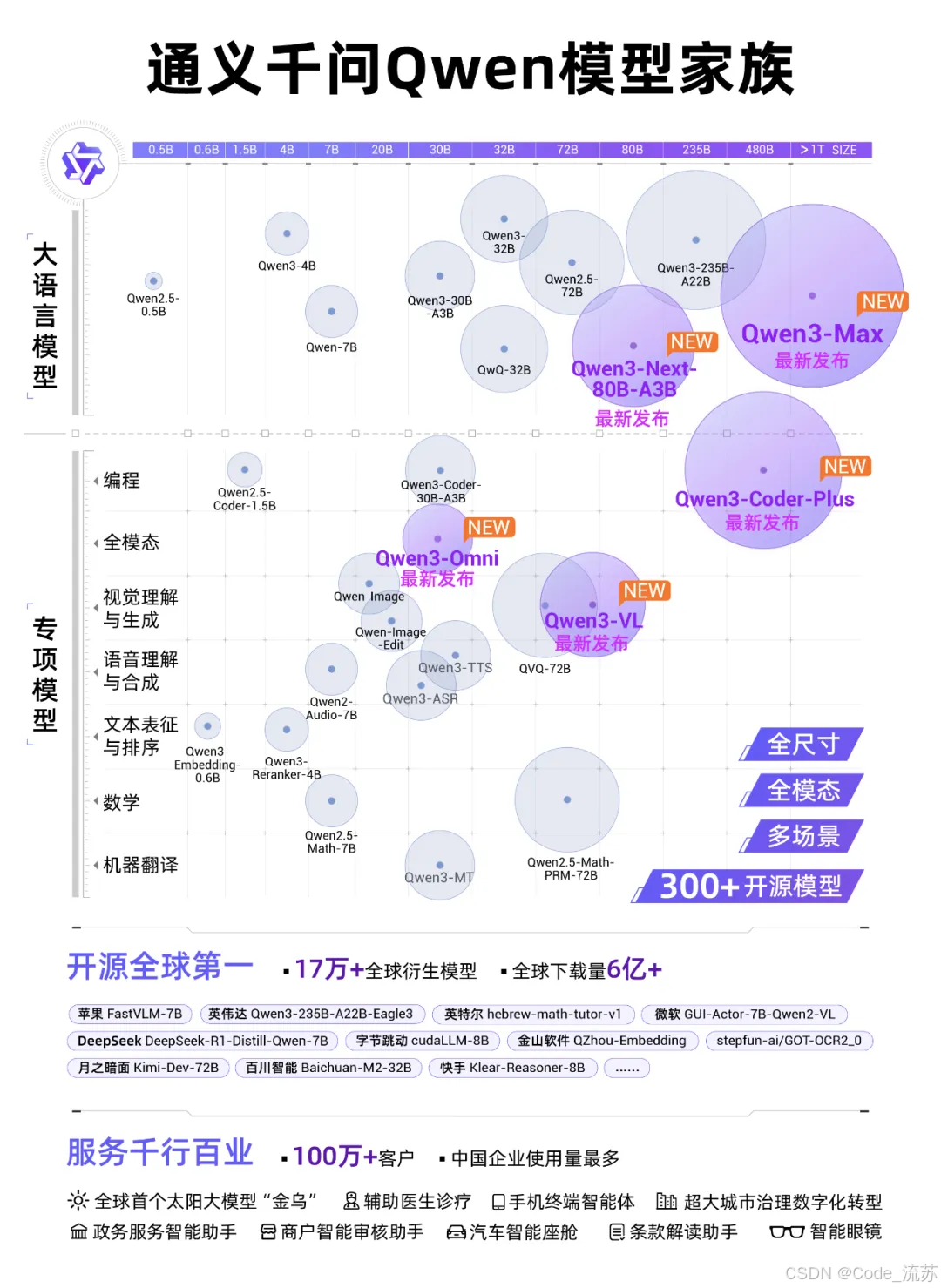

Qwen3-Max深度解析:阿里最强 AI 大模型全面升级,性能领先,Just Scale it!

嗨,我是流苏👋,今天我们来聊聊阿里最新的旗舰大模型Qwen3-Max,这是今年阿里云栖大会中亮相的重点模型,一起来看看!

名人说:博观而约取,厚积而薄发。——苏轼《稼说送张琥》

创作者:Code_流苏(CSDN)(一个喜欢古诗词和编程的Coder😊)目录

很高兴你打开了这篇博客,更多AI知识,请关注我、订阅专栏《AI知识图谱》,内容持续更新中…

嗨,我是流苏👋,今天我们来聊聊阿里最新的旗舰大模型 Qwen3-Max —— 一篇面向零基础读者的浅显解读,放在专栏《AI知识图谱》里,方便你收藏、转发、学习。

一、Qwen3-Max 是什么?为什么值得注意

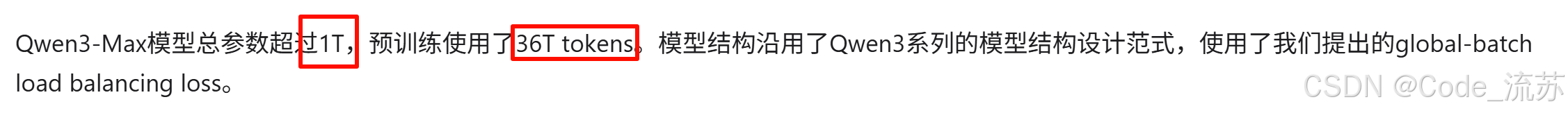

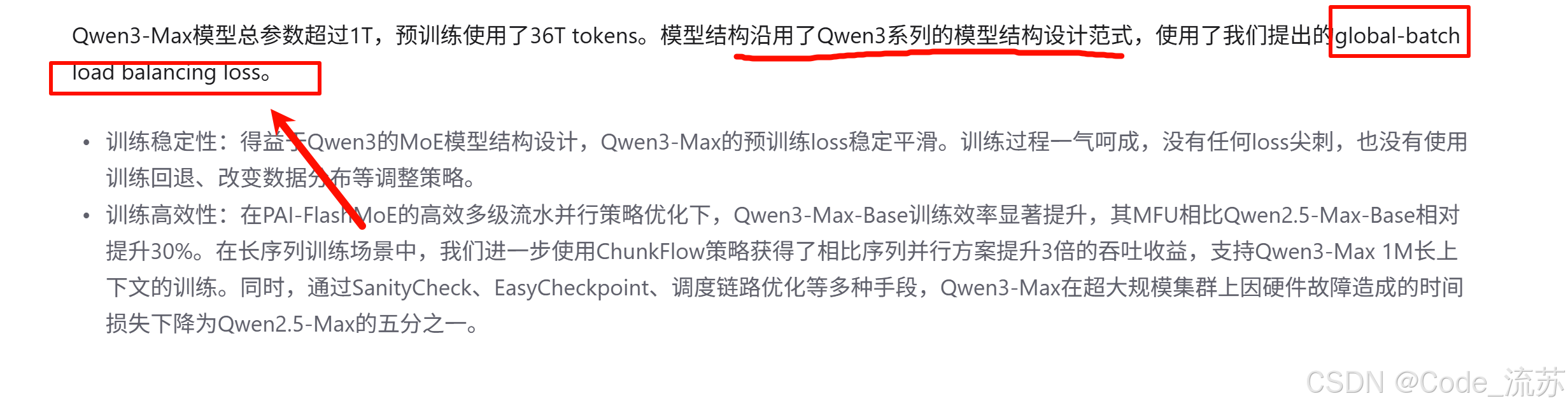

Qwen3-Max(通义千问 Qwen3-Max)是阿里巴巴 / 阿里云在 2025 年 9 月 24 日云栖大会发布的旗舰级语言模型。官方与多家媒体报道指出它参数规模超过 1 万亿(>1T),并用约 36 万亿 tokens(36T tokens) 进行预训练,因此在“规模”和“知识量”上都处于业内前列。

简单比喻:如果把小模型比作「熟练的手艺人」,那么 Qwen3-Max 更像“拥有海量经验的大师+工具箱”,既能回答问题,也能“调工具”、写代码、做较深的推理。

二、技术亮点(用通俗语言讲清楚)

1. 参数与数据(一眼看懂)

- 参数:> 1 万亿参数(超大)。

- 训练数据:约 36T tokens,涵盖编程文本、百科、对话、代码库等。

2. 架构上的两个关键点(为什么它能“更聪明”)

-

MoE(Mixture of Experts)混合专家架构:不是每一步都用全部“大脑”,而是按需激活部分“专家”,用于在规模和计算量之间取得折中,保持大规模带来的能力同时控制实时计算代价。

-

global-batch load balancing loss:让这些“专家”被更均匀地训练,不会出现某个专家常常被闲置或过载的情况,从而提升整体稳定性与性能。

3. 长上下文与效率优化

-

Qwen3-Max 在长文本处理上有明显投入,据报道可支持超长上下文(报道提到可达百万 token 级别的context),这对处理整本手册、长会议录像、代码库非常有帮助。

-

为了训练与部署,团队使用了多级流水并行、ChunkFlow 等优化手段,以提升吞吐和减少训练故障带来的时间损失。

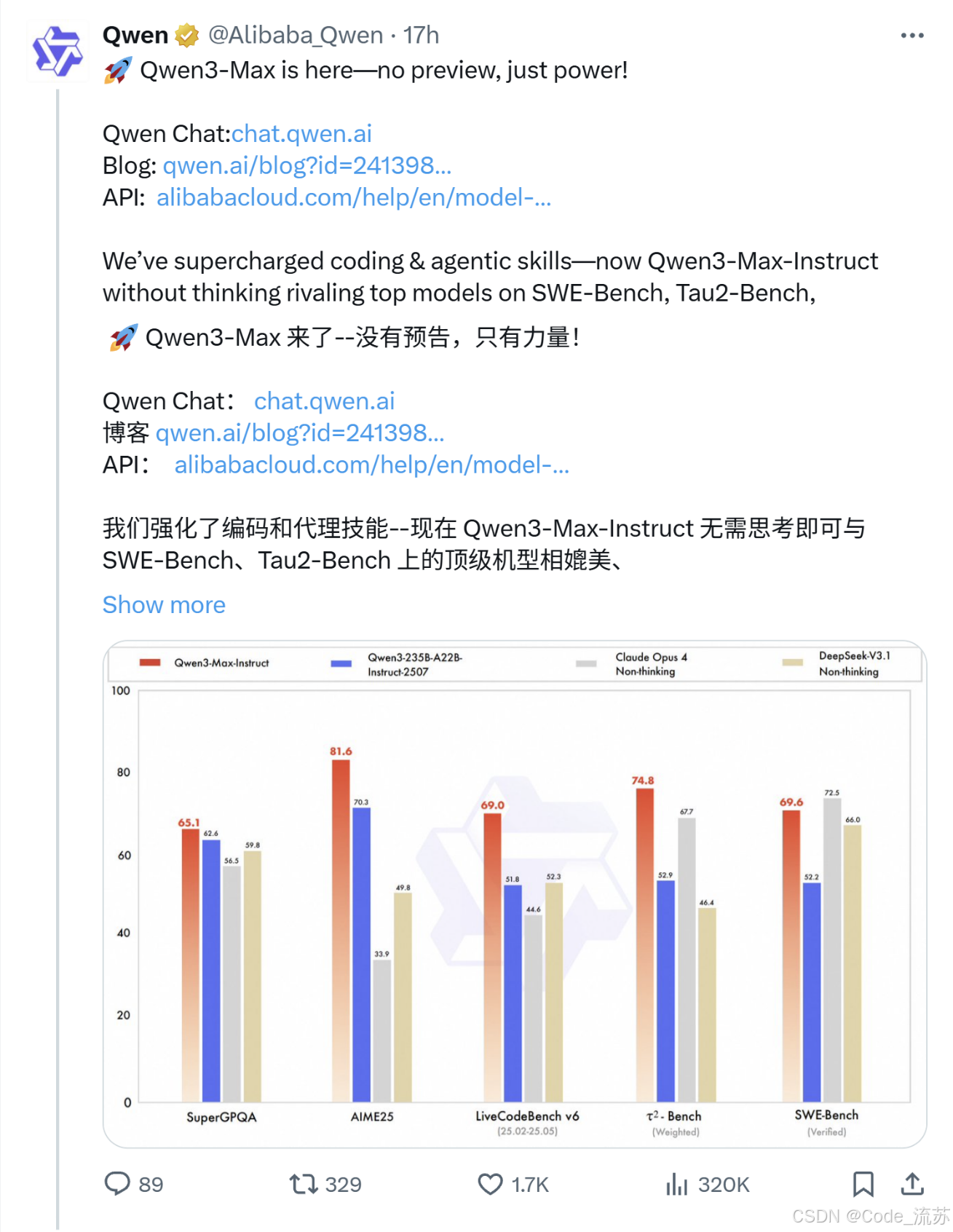

三、性能一览(数据说话,表格更直观)

下面把媒体与官方披露的 几个重要基准整理成表格,帮助你快速感受 Qwen3-Max 的强项:

| 基准 / 指标 | Qwen3-Max(报道) | 说明 / 来源 |

|---|---|---|

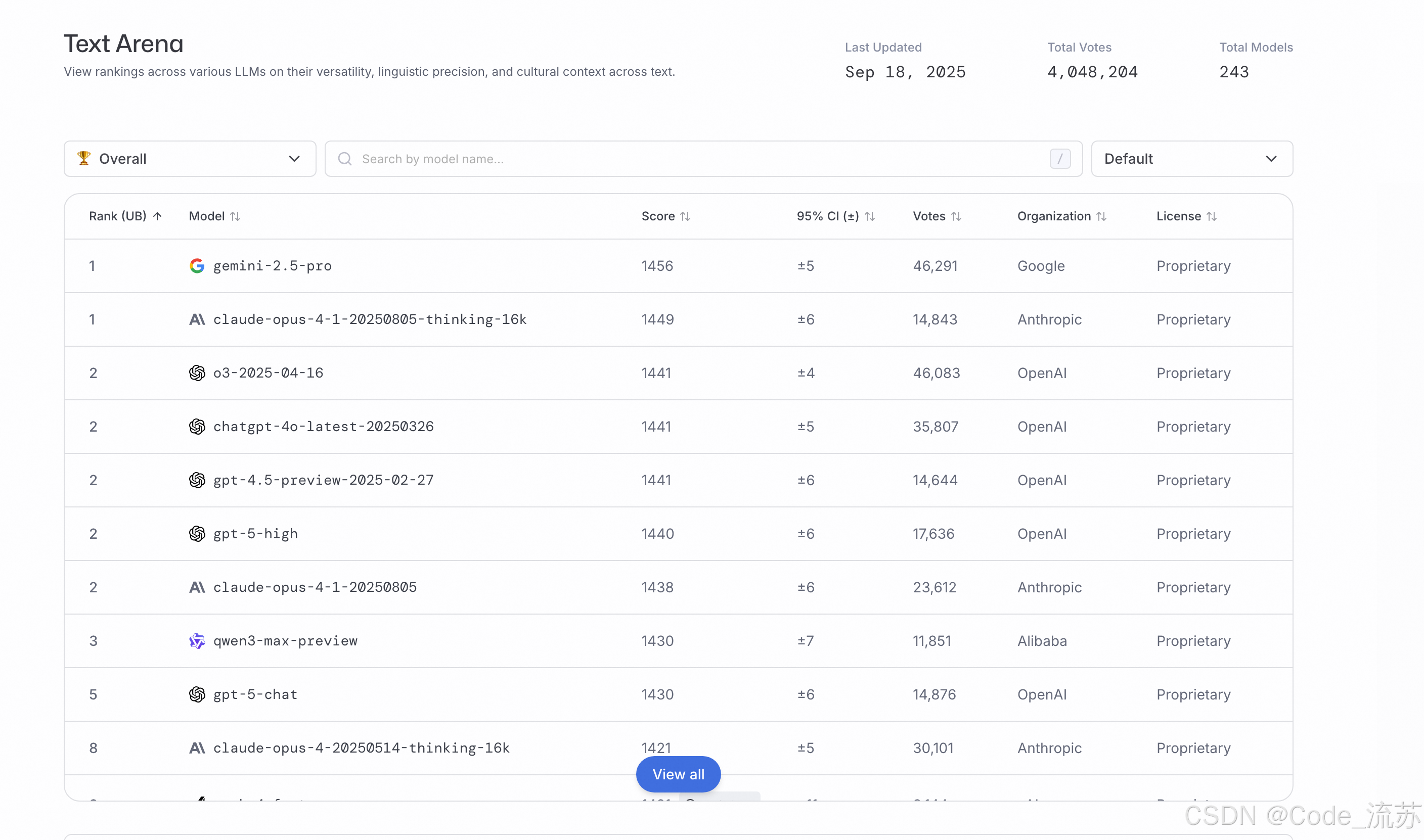

| LMArena 文本排行榜 | 预览版 位列全球前三 | 预览版表现强劲(媒体/分析转述)。(DEV Community) |

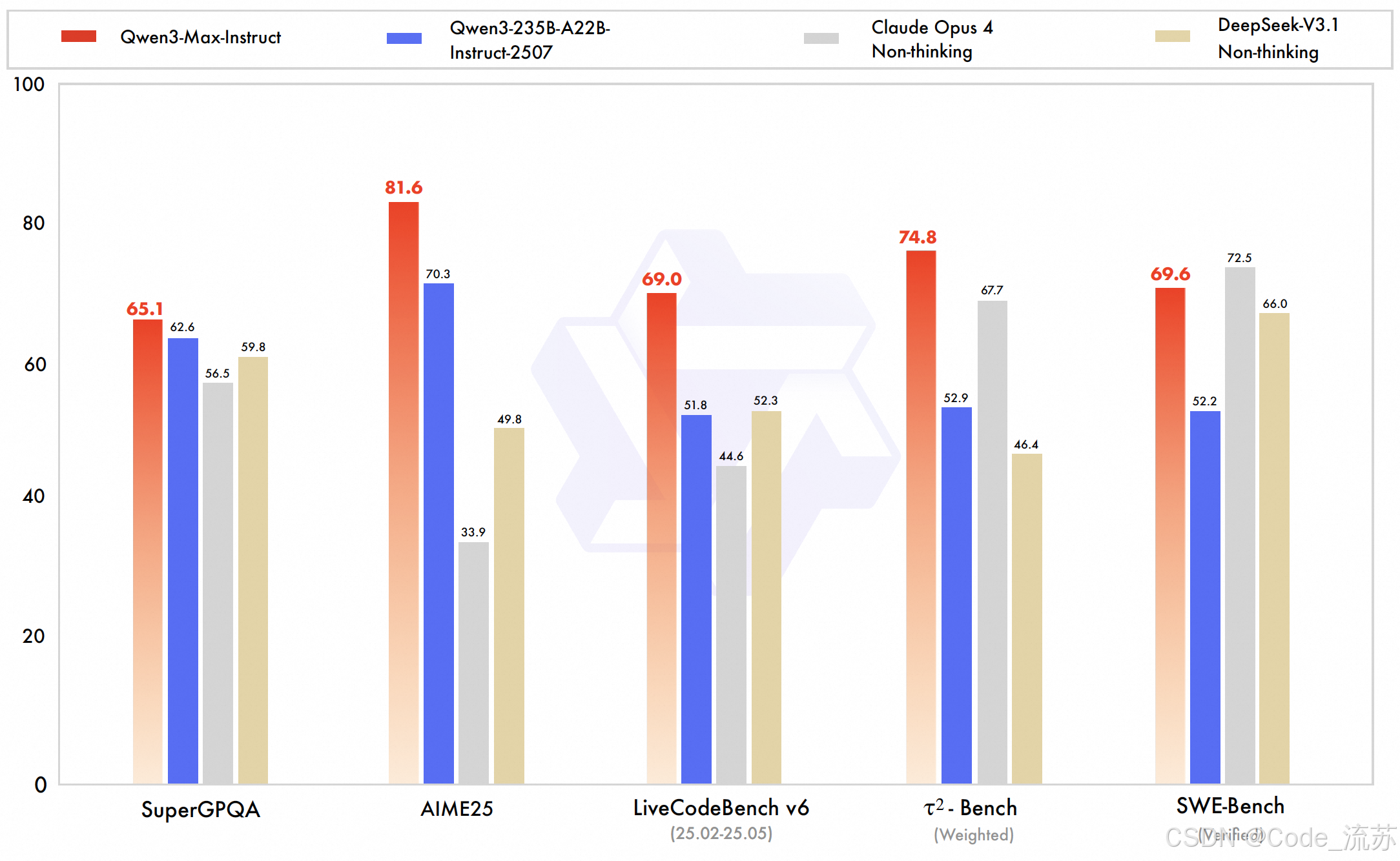

| SWE-Bench Verified(编程类) | 69.6 分 | 强于众多对手,在真实编程挑战上表现优秀。(KuCoin) |

| Tau2-Bench(Agent / 工具调用能力) | 74.8 分 | 工具调用能力显著,媒体称超越 Claude Opus4、DeepSeek-V3.1。(KuCoin) |

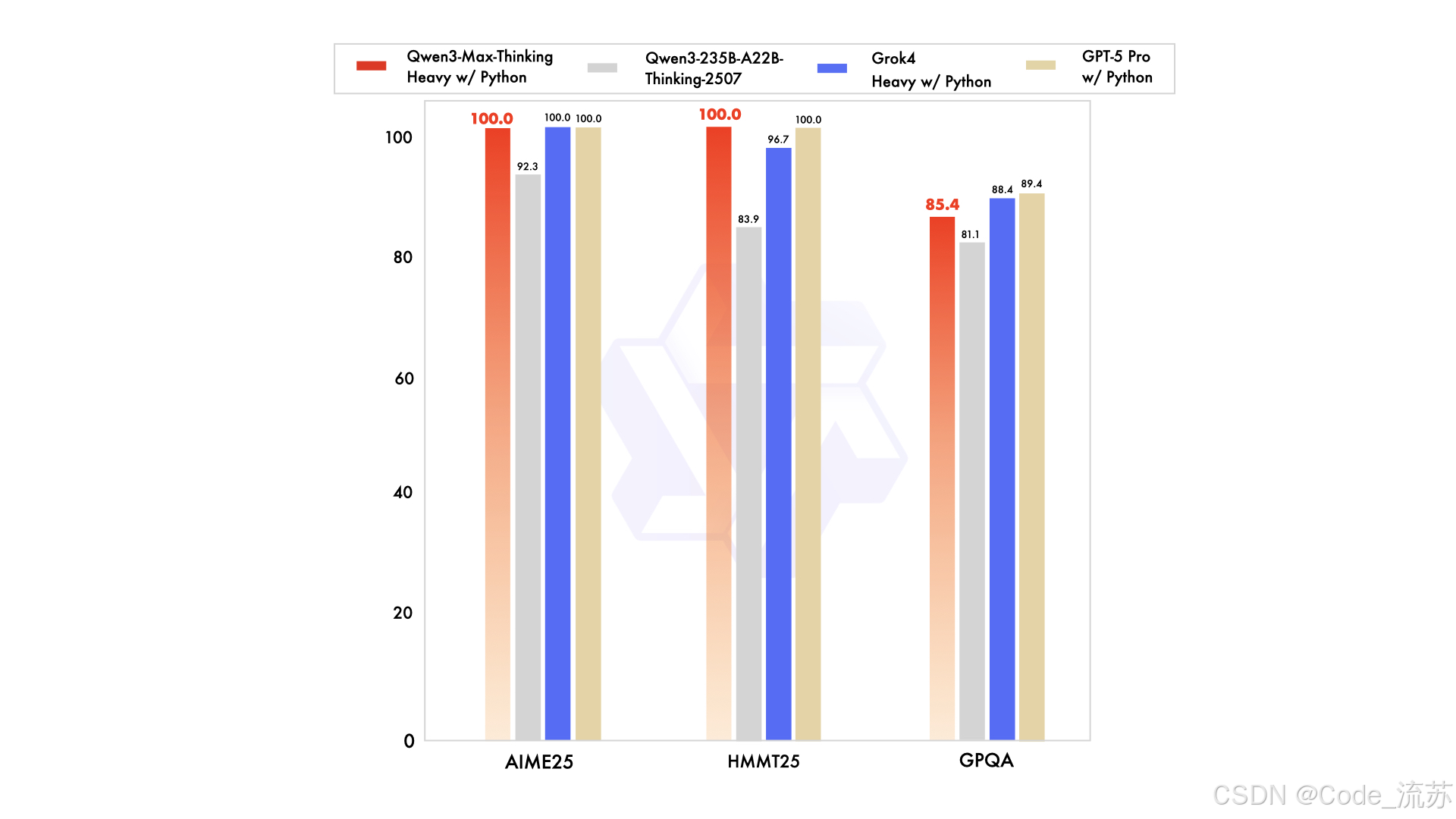

| 数学推理(AIME-25 / HMMT) | Thinking 版本在测试中取得满分/100%(已报道) | 表明推理增强版(Thinking/Heavy)潜力巨大,但该版本尚在训练/逐步开放。(KuCoin) |

1.Qwen3-Max-Instruct

据官方透露,Qwen3-Max-Instruct的预览版已在 LMArena 文本排行榜上稳居全球前三。正式发布版本进一步提升了其能力,尤其在代码生成与智能体表现方面表现卓越。

在专注于解决现实编程挑战的基准测试 SWE-Bench Verified 上,Qwen3-Max-Instruct 取得了高达69.6分的优异成绩,稳居全球顶尖模型之列。

此外,图中第四列,在评估智能体工具调用能力的严苛基准 Tau2-Bench 上,Qwen3-Max-Instruct 更是实现了突破性表现,以74.8分超越 Claude Opus 4与 DeepSeek-V3.1。

2.Qwen3-Max-Thinking (Heavy)

Qwen3-Max 的推理增强版本—— Qwen3-Max-Thinking,通过集成代码解释器并运用并行测试时计算技术,展现了前所未有的推理能力,尤其在极具挑战性的数学推理基准测试 AIME 25 和 HMMT 上,均取得了满分。目前,阿里团队正在全力推进 Qwen3-Max-Thinking 的训练,希望尽快能让用户体验。

小提示:这些成绩大多来自官方/媒体发布的 benchmark 报告或第三方榜单的“预览/对比”。不同模型在不同时间点、不同测试设定下对比会有差异,解读时建议关注“基准名称 + 测试条件 + 版本(preview/正式)”。

四、开发者如何接入(超实用示例)

1. 现在能用吗?

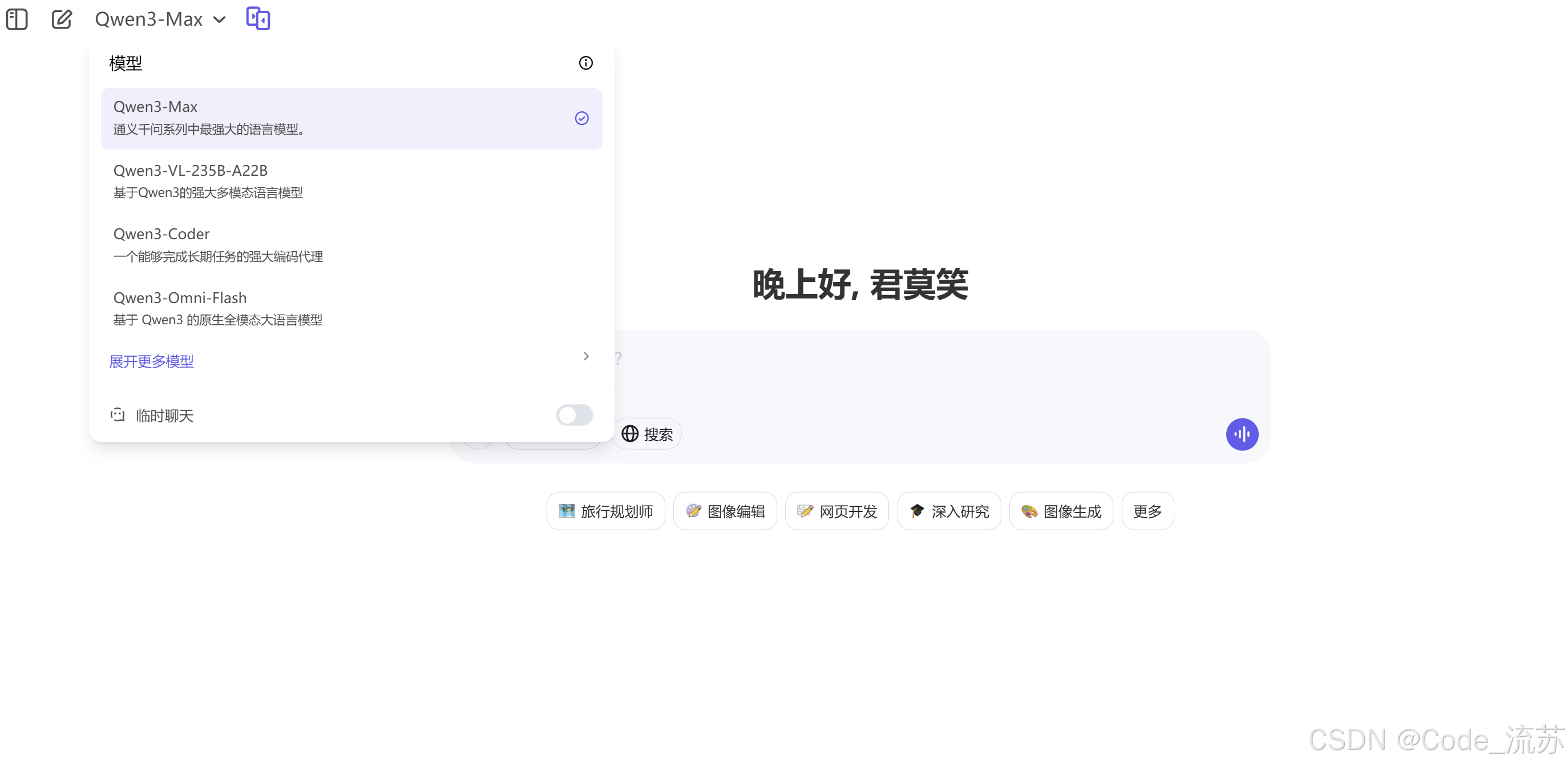

现在,可以在 Qwen Chat 官网 直接与强大的 Qwen3-Max-Instruct 模型对话,体验其卓越能力。

对话实例:

Q1:规划一个简洁的旅游规划,从深圳到长沙

以下是从深圳到长沙的简洁旅游规划(建议3天2晚):

---

### **行程概览**

- **交通方式**:高铁(推荐)

- 深圳北站 → 长沙南站

- 车程约3小时,票价约¥300-400(二等座)

- 每天多趟车次,建议选早班车(如G6012次 07:30出发,10:30抵达)

- **住宿建议**:五一广场/黄兴路步行街附近(市中心,交通便利,美食集中)

---

### **行程安排**

#### **Day 1:抵达 + 市区经典游**

- **上午**

- 抵达长沙南站 → 地铁2号线直达五一广场(约30分钟)

- 入住酒店,寄存行李

- **中午**

- 午餐:火宫殿(臭豆腐、糖油粑粑)或黑色经典小吃

- **下午**

- 游览【岳麓山】(东门进,步行或观光车)

- 参观【岳麓书院】(中国四大书院之一)

- 打卡【爱晚亭】(秋季红叶绝美)

- **晚上**

- 橘子洲头夜景(地铁2号线直达,看青年毛泽东雕像+湘江夜景)

- 晚餐:超级文和友(复古风+小龙虾,需排队)或茶颜悦色奶茶

#### **Day 2:文化深度游 + 美食体验**

- **上午**

- 【湖南省博物馆】(免费,需提前3天预约!看马王堆汉墓、辛追夫人)

- **中午**

- 午餐:博物馆附近鲁哥饭店(咸蛋黄茄子、酸萝卜牛百叶)

- **下午**

- 逛【IFS国金中心】(7楼KAWS雕塑打卡)

- 闲逛【黄兴路步行街】+【太平老街】(小吃:大香肠、捆鸡、茶颜悦色)

- **晚上**

- 湘江边散步,或体验湘菜馆(推荐:笨罗卜浏阳菜馆,平价辣味正宗)

#### **Day 3:轻松返程**

- **上午**

- 睡到自然醒 → 买伴手礼(茶颜悦色游园会店买茶包、酱板鸭)

- 可选:谢子龙影像馆/李自健美术馆(文艺拍照,免费需预约)

- **中午**

- 午餐后前往长沙南站,乘高铁返深

---

### **实用贴士**

1. **美食重点**:

- 必吃:茶颜悦色(幽兰拿铁)、黑色经典臭豆腐、口味虾、糖油粑粑

- 忌辣可提前说“微辣”或“免辣”(但部分店可能默认辣)

2. **交通**:

- 市内地铁+步行足够,下载“长沙地铁”APP扫码乘车

3. **预算参考**(人均):

- 交通:¥600(往返高铁)

- 住宿:¥200-400/晚(经济型酒店)

- 餐饮+门票:¥300-500/天

4. **注意事项**:

- 湖南省博物馆周一闭馆!

- 茶颜悦色几乎每500米一家,不用扎堆排队。

---

**一句话总结**:高铁快达,三天吃遍网红小吃,打卡岳麓山、橘子洲、省博三大核心,轻松不赶路!

Q2:以蓝图风格制作Q版哈利波特,吉祥物玩偶,毛茸茸的设计草图。马卡龙风格的颜色。包括尺寸和说明文字注释。应使用线条和尺寸来表示各部分的尺寸,使草图具有技术和细节感。除了主要设计外,还包括展示不同角度、3D景深的分散缩略图。

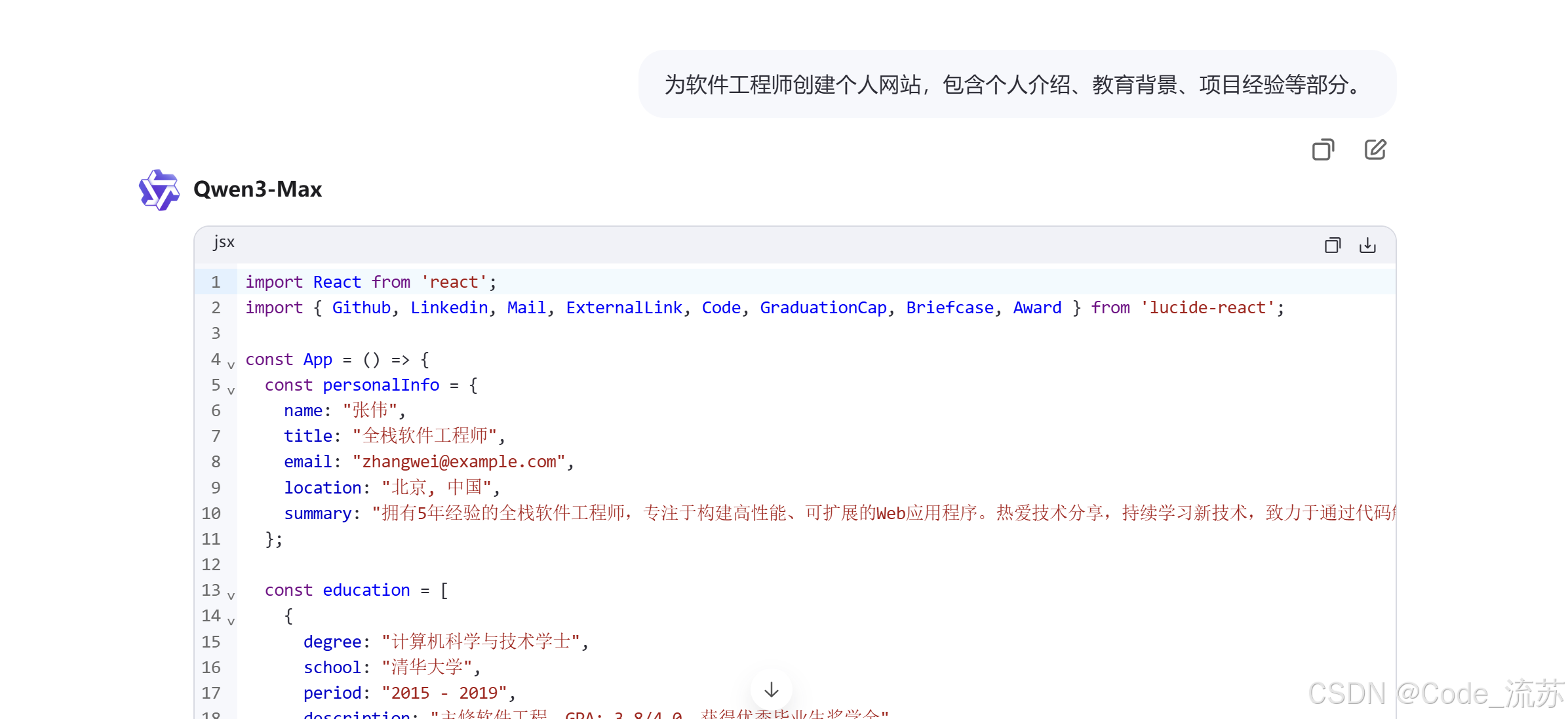

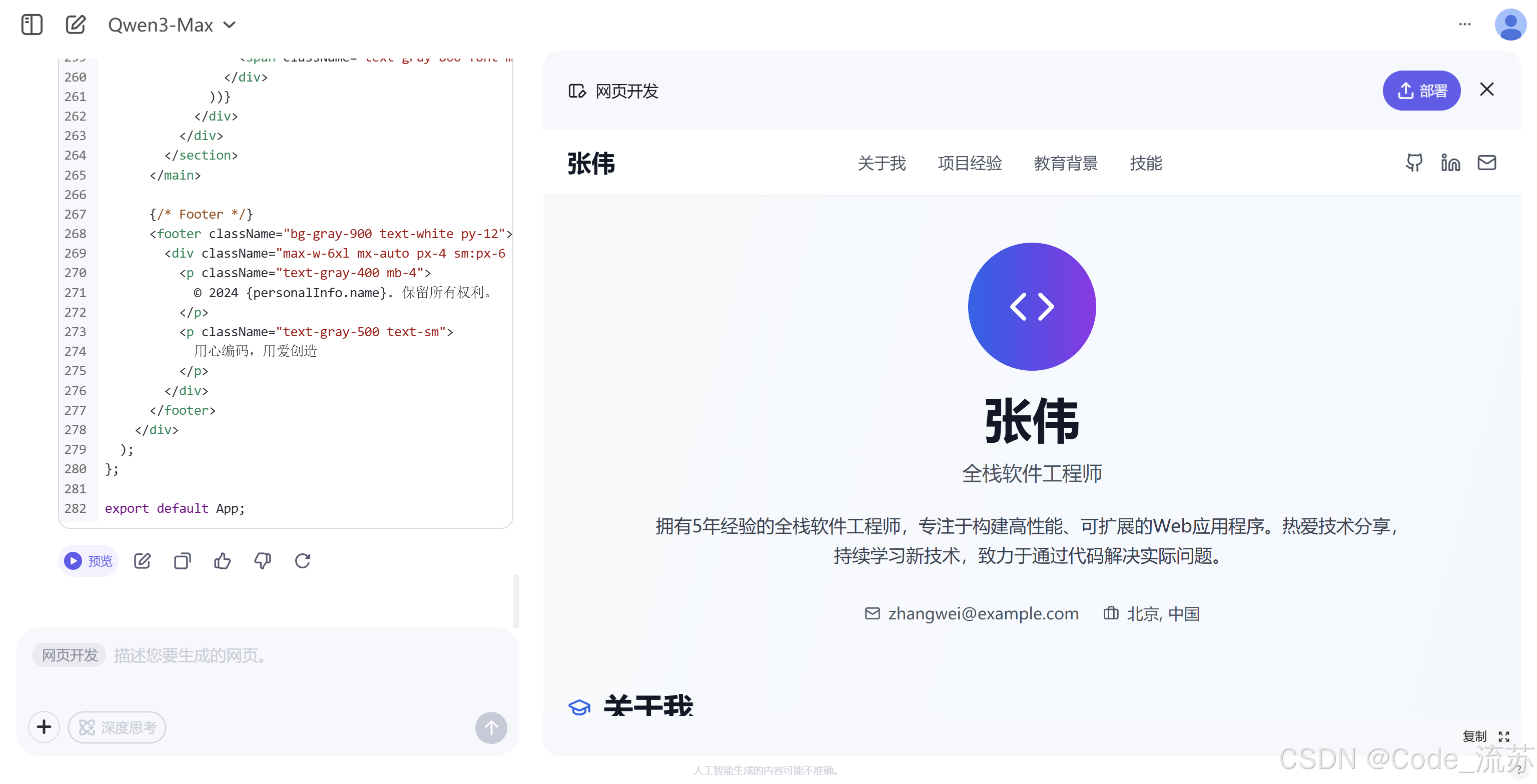

Q3: 为软件工程师创建个人网站,包含个人介绍、教育背景、项目经验等部分。

可以简单地看出,Qwen3-Max优点在于在日常对话中的能力是比较多维丰富的,大且全,缺点在于目前部分能力不够专精,仍需优化。

同时,该模型的 API(模型名称为 qwen3-max)也已开放使用。只需按以下步骤操作,即可快速接入API:

- 注册阿里云账号:点击此处注册国际版阿里云账号。

- 开通服务:激活阿里云 Model Studio。

- 获取密钥:登录控制台,创建您的专属 APIKey。

2. 快速示例(Python,OpenAI 风格兼容)

下面是一个 示例片段(伪示例,按阿里云提供的兼容方式书写),用于演示如何用 model="qwen3-max" 发起一次简单对话请求:

from openai import OpenAI

import os

client = OpenAI(

api_key=os.getenv("API_KEY"),

base_url="https://dashscope-intl.aliyuncs.com/compatible-mode/v1",

)

completion = client.chat.completions.create(

model="qwen3-max",

messages=[

{'role': 'user', 'content': 'Give me a short introduction to large language model.'}

]

)

print(completion.choices[0].message)

五、适合场景与注意点

1. 很适合做的事(强项)

- 大型文档理解:合同审阅、教材整合、长会议记录摘要(长上下文优势)。

- 编程助手 / 自动化脚本:能生成、修复代码并调用工具链(SWE-Bench 的高分说明了编码能力)。

- 高级 Agent 应用:自动化流程、工具链调用、多步任务执行(Tau2-Bench 高分体现)。

2. 你需要留心的地方(风险与现实)

- 成本:运行/推理这类超大模型消耗资源巨大,企业部署成本高;普通开发者主要通过云 API 使用会更现实。

- 开放性:并非所有版本都完全开源(尤其是 Thinking/Heavy 的全部权重),可用性依赖官方策略与 API 授权。

- “基准解读”要谨慎:媒体常报道“超越某某模型”或“满分”之类吸睛结论,实际表现受 prompt、测试环境、版本差异影响,请以具体基准与第三方复现为准。

六、总结:该如何看 Qwen3-Max?

Qwen3-Max 是阿里在大模型竞赛中一次“大步向前”的发布:巨大的参数规模、长上下文支持、优秀的编程与 agent 能力,使它在若干 benchmark 上取得亮眼成绩。

对企业和开发者来说,它提供了更强的能力边界,但与此同时也带来更高的成本与治理挑战。总的来说,值得关注但也需理性评估。期待AI变得更好,期待百家争鸣的时代!

附:

参考资料(部分)

- Reuters:Alibaba launches Qwen3-Max — 超过 1 万亿参数的报道。(Reuters)

- Qwen 官方博客:Qwen3-Max 发布说明。(qwen.ai)

- LiveMint:关于上下文长度、36T tokens 的说明。(mint)

- KuCoin / PANews 等技术媒体:SWE-Bench / Tau2-Bench 分数与 Thinking 版本表现的报道。(KuCoin)

- 社区与分析:dev.to 的发布分析(补充解读)。(DEV Community)

创作者:Code_流苏(CSDN)(一个喜欢古诗词和编程的Coder😊)

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)