大模型入门与本地部署实战

大型语言模型是通过在海量文本数据上训练而成的深度学习系统。它们能够理解、生成和处理人类语言,完成各种任务,包括问答、翻译、摘要和创意写作等。Ollama是一个开源的大型语言模型服务工具,专为本地运行而设计。它提供了简单的命令行界面,让模型部署变得极其简单。Open WebUI提供了友好的Web界面,让你可以通过浏览器与本地模型交互,无需使用命令行。模型微调让你可以用特定数据训练模型,使其在特定领域

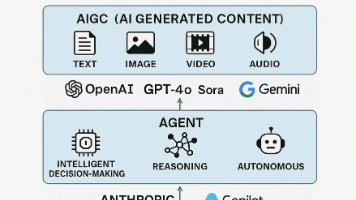

一、大模型基础:理解核心概念

1.1 什么是大模型?

大型语言模型是通过在海量文本数据上训练而成的深度学习系统。它们能够理解、生成和处理人类语言,完成各种任务,包括问答、翻译、摘要和创意写作等。

1.2 参数规模的意义

在大模型领域,我们常用"B"(Billion/十亿)来表示模型规模:

- 7B模型:70亿参数

- 13B模型:130亿参数

- 70B模型:700亿参数

参数数量决定了模型的复杂度和能力。一般来说,参数越多,模型能力越强,但同时也需要更多的计算资源。

1.3 模型能力与资源平衡

选择模型时需要权衡:

- 更大模型:能力更强,但需要更多GPU内存和计算资源

- 较小模型:响应更快,资源需求更低,但能力有限

二、本地部署准备:环境搭建

2.1 硬件要求

最低配置:

- CPU:支持AVX2指令集的现代处理器

- 内存:16GB RAM(7B模型)

- 存储:20GB可用空间

推荐配置:

- GPU:NVIDIA RTX 3060 12GB或更高

- 内存:32GB RAM

- 存储:50GB SSD空间

2.2 软件环境准备

安装Docker

Docker是容器化部署的理想工具,提供一致的环境体验。

Windows系统安装:

- 访问 Docker 官网(https://www.docker.com/)下载安装包

- 运行安装程序,按提示完成安装

- 启用WSL 2后端以获得更好性能

Hyper-V启用方法(如需要):

创建并运行以下批处理脚本:

@echo off

Pushd "%~dp0"

dir /b %SystemRoot%\servicing\Packages\*Hyper-V*.mum >hyper-v.txt

for /f %%i in ('findstr /i . hyper-v.txt 2^>nul') do dism /online /norestart /add-package:"%SystemRoot%\servicing\Packages\%%i"

del hyper-v.txt

Dism /online /enable-feature /featurename:Microsoft-Hyper-V -All /LimitAccess /ALL

pause

三、实战部署:使用Ollama运行本地模型

3.1 Ollama简介

Ollama是一个开源的大型语言模型服务工具,专为本地运行而设计。它提供了简单的命令行界面,让模型部署变得极其简单。

3.2 安装与配置

安装命令:

# Linux/macOS

curl -fsSL https://ollama.com/install.sh | sh

# Windows

下载并运行官方安装程序

3.3 基本操作命令

# 启动服务

ollama serve

# 拉取模型(以Llama 3 8B为例)

ollama pull llama3:8b

# 运行模型

ollama run llama3:8b

# 查看已安装模型

ollama list

# 删除模型

ollama rm <模型名称>

3.4 模型选择建议

对于初学者,推荐从以下模型开始:

llama3:8b:平衡性能与资源需求gemma:7b:Google开发,性能优秀qwen:7b:阿里通义千问,中文优化

四、图形化界面:Open WebUI部署

4.1 Open WebUI简介

Open WebUI提供了友好的Web界面,让你可以通过浏览器与本地模型交互,无需使用命令行。

4.2 Docker部署

一键部署命令:

docker run -d -p 3000:3000 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

4.3 初始设置

- 访问

http://localhost:3000 - 创建管理员账户

- 配置模型连接(通常自动检测Ollama)

- 开始聊天!

4.4 高级功能

- 多模型管理:同时连接多个模型

- 提示词模板:保存和重用有效提示词

- 聊天历史:保存和导出对话记录

- 用户管理:支持多用户使用

五、提示词工程:与模型有效沟通

5.1 基础原则

有效的提示词应包含:

- 明确指令:清晰表达你的需求

- 充足上下文:提供必要的背景信息

- 格式要求:指定输出的格式和结构

5.2 实用技巧

示例1:基础问答

请解释量子计算的基本原理,并用比喻帮助理解。

示例2:创意写作

写一篇关于人工智能助手的短篇故事,要求:

1. 包含转折情节

2. 500字左右

3. 以对话形式展开

示例3:代码生成

用Python编写一个函数,实现快速排序算法,要求:

1. 包含详细注释

2. 处理边缘情况

3. 提供使用示例

六、高级应用:模型微调入门

6.1 微调概述

模型微调让你可以用特定数据训练模型,使其在特定领域或任务上表现更好。

6.2 资源需求估算

| 微调类型 | 7B模型需求 | 13B模型需求 |

|---|---|---|

| 全量微调 | 约42GB显存 | 约78GB显存 |

| LoRA微调 | 约12GB显存 | 约20GB显存 |

| QLoRA微调 | 约6GB显存 | 约10GB显存 |

6.3 工具推荐

- Unsloth:训练加速框架,提升速度降低显存使用

- LLaMA-Factory:一站式微调解决方案

- Hugging Face Transformers:提供丰富微调示例

七、常见问题与解决方案

7.1 性能优化

问题:模型响应慢

解决方案:

- 使用量化版本模型(如4bit量化)

- 减少并发请求

- 升级硬件配置

7.2 内存不足

问题:显存或内存不足

解决方案:

- 选择更小模型

- 使用模型量化

- 增加虚拟内存(Windows)

7.3 中文支持

问题:英文模型中文能力弱

解决方案:

- 选择多语言优化模型(如Qwen系列)

- 明确要求模型使用中文回复

- 提供中文示例上下文

八、未来展望与发展趋势

8.1 技术发展方向

- 模型小型化:同等能力下参数更少

- 推理优化:响应速度更快

- 多模态支持:支持图像、音频等多类型输入

8.2 应用场景扩展

从目前的对话和文本生成,向更多领域扩展:

- 个性化教育:定制化学习助手

- 企业知识管理:内部知识库问答

- 创意产业:写作、设计辅助工具

结语:开始你的大模型之旅

本地大模型部署不再是一项高不可攀的技术。通过本文介绍的工具和方法,你现在完全可以在自己的设备上搭建和运行强大的AI助手。

无论你是开发者、研究者还是AI爱好者,本地大模型都为你提供了一个安全、可控、成本效益高的AI体验平台。现在就开始行动,探索大模型的无限可能吧!

下一步建议:

- 从一个小模型开始(如Llama 3 8B)

- 熟悉基本操作和提示词技巧

- 尝试不同的应用场景

- 加入社区交流学习经验

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)