大模型CI/CD管道构建学习笔记

大模型技术的快速发展对CI/CD管道提出了更高的要求(如支持多模态、提示词版本管理等),但以上述原则和工具为基础,可以构建出适应性强、稳健可靠的大模型交付体系。:模型的评估不再是简单的准确率,涉及众多维度(如毒性、真实性、逻辑性、指令跟随能力等)的综合评估。数据科学家将代码(模型架构、训练脚本)、配置文件(超参数)、评估脚本提交到Git仓库。:通过版本控制(代码、数据、模型)和自动化流程,确保每一

1. 引言:为什么大模型需要CI/CD?

传统的软件开发和运维(DevOps)通过CI/CD实现了自动化、快速、可靠的交付。大语言模型(LLM)的开发和运营(MLOps)同样面临类似甚至更复杂的挑战:

迭代频繁:模型架构、训练数据、超参数、提示词模板等都需要持续迭代和优化。

复现困难:训练一个模型涉及代码、数据、环境等多重因素,难以保证两次训练结果完全一致。

评估复杂:模型的评估不再是简单的准确率,涉及众多维度(如毒性、真实性、逻辑性、指令跟随能力等)的综合评估。

部署成本高:模型文件巨大(从几GB到上百GB),推理资源昂贵,部署和回滚策略至关重要。

协作需求:数据科学家、机器学习工程师、软件工程师、运维工程师需要协同工作。

构建大模型的CI/CD管道(或称MLOps管道)旨在解决上述问题,实现:

自动化与效率:自动化训练、评估和部署流程,减少人工干预,加速迭代周期。

可复现性与可靠性:通过版本控制(代码、数据、模型)和自动化流程,确保每一步都可追踪、可复现。

质量保障:通过自动化的、全面的评估体系,确保只有达到质量阈值的模型才能进入生产环境。

快速交付与回滚:能够安全、快速地将新模型部署上线,并在出现问题时迅速回滚到稳定版本。

2. CI/CD常用软件及工具介绍

大模型的CI/CD管道是传统CI/CD工具的扩展,集成了大量MLOps特有的工具。

2.1 传统CI/CD核心工具

|

工具类别 |

代表工具 |

说明 |

|

版本控制 |

Git, GitHub, GitLab, Gitea |

管理源代码、配置文件、评估脚本等。一切皆代码是基础。 |

|

CI/CD流水线引擎 |

Jenkins, GitLab CI/CD, GitHub Actions, CircleCI, Argo CD |

编排和执行自动化流程的核心。定义 pipeline 的各个阶段(如构建、测试、部署)。 |

|

容器化 |

Docker |

将应用及其依赖打包到一个可移植的镜像中,解决环境一致性问题。 |

|

容器编排 |

Kubernetes (K8s) |

自动化部署、扩展和管理容器化应用。是模型推理服务的基础平台。 |

2.2 MLOps特有工具

|

工具类别 |

代表工具 |

说明 |

|

数据版本控制 |

DVC, Pachyderm, Delta Lake |

像管理代码一样管理数据集和模型文件,与Git配合使用,跟踪数据集的版本。 |

|

实验跟踪 |

MLflow, Weights & Biases, Neptune.ai |

记录实验过程中的超参数、指标、输出文件(如模型)和代码状态,便于比较和复现。 |

|

模型注册中心 |

MLflow Model Registry, Weights & Biases Model Registry |

集中化管理模型版本、阶段(Staging, Production)、注释和转换。 |

|

特征存储 |

Feast, Tecton |

管理、共享和服务预处理后的特征数据,保证训练和推理时特征的一致性。 |

|

模型服务 |

KServe, Seldon Core, Triton Inference Server, TensorFlow Serving, TorchServe |

专门用于在高性能、高并发的环境下部署和服务机器学习模型。 |

|

监控与可观测性 |

Prometheus, Grafana, WhyLabs, Arize |

监控生产环境中模型的性能、数据偏移、概念偏移等。 |

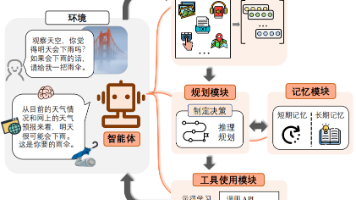

3. 大模型CI/CD管道的实现细节

一个完整的大模型CI/CD管道通常包含以下四个环境,模型像代码一样在不同环境间晋升。

开发环境:数据科学家进行探索性分析和实验。

训练环境:自动化训练和评估模型。

预生产环境:模拟生产环境进行最终验证。

生产环境:面向用户提供服务的线上环境。

以下是管道各个阶段的具体实现细节:

阶段一:持续集成(CI)与持续训练(CT)

代码与数据提交:

数据科学家将代码(模型架构、训练脚本)、配置文件(超参数)、评估脚本提交到Git仓库。

使用DVC将新的训练数据或数据预处理脚本的变更推送到远程存储(如S3),并更新Git中的dvc.yaml和.dvc文件。

触发流水线:

通过git push或合并请求(Merge Request)触发GitLab CI/CD或GitHub Actions等工具。

构建与测试:

构建阶段:构建一个包含所有依赖(Python, PyTorch, CUDA, 库等)的Docker镜像,并推送到镜像仓库(如Docker Hub)。

测试阶段:

代码质量检查:运行单元测试、代码风格检查(linter)。

数据验证:检查新数据的Schema、分布是否有巨大变化(避免数据污染)。

环境测试:验证镜像能否正确启动。

模型训练与评估:

在专用的GPU训练节点上启动容器,运行训练脚本。

训练脚本应集成MLflow等工具,自动记录参数、指标和生成的模型文件。

训练完成后,自动运行评估脚本,在保留测试集和特定评估集(如针对有害性的提示词集)上计算综合指标。

指标示例:准确率、困惑度、使用LLM-as-a-Judge的胜率、毒性分数等。

质量门禁:如果评估指标达到预设阈值(如胜率 > 75%),流水线自动将模型推送至模型注册中心(如MLflow),状态标记为Staging。否则,流水线失败并通知开发者。

阶段二:持续部署(CD)与持续监控(CM)

模型部署:

当模型在注册中心被手动或自动晋升为Production候选版本时,触发CD流水线。

CD流水线将模型从注册中心取出,并部署到Kubernetes集群中。

使用KServe或Seldon Core等工具定义推理服务。这些工具可以:

实现蓝绿部署或金丝雀发布,将一小部分流量导入新模型,逐步放大。

自动扩缩容(HPA)。

持续监控:

部署完成后,监控系统开始工作。

基础设施监控:使用Prometheus和Grafana监控GPU使用率、内存、延迟、吞吐量等。

模型性能监控:使用WhyLabs或Arize等工具监控:

数据偏移:输入的请求数据分布是否与训练数据分布差异过大。

概念偏移:模型的预测结果是否开始偏离预期(可通过用户反馈、点击率等代理指标判断)。

模型性能:在线计算的准确率等(如果能有真实标签)。

一旦监控系统检测到异常(如延迟飙升或数据偏移严重),会自动触发警报,甚至自动回滚到上一个稳定版本的模型服务。

4. 总结

构建大模型的CI/CD管道是一个系统工程,其核心思想是:

版本控制一切:代码、数据、模型、环境都必须有版本,且版本间可追溯。

自动化一切:从数据预处理、训练、评估到部署和监控,尽可能自动化,减少人工错误。

持续评估,质量门禁:评估不是一次性动作,而是嵌入到流程中的持续行为。只有高质量的模型才能流向下一阶段。

渐进式发布与监控:采用安全的部署策略,并通过强大的监控体系确保生产环境的稳定性。

大模型技术的快速发展对CI/CD管道提出了更高的要求(如支持多模态、提示词版本管理等),但以上述原则和工具为基础,可以构建出适应性强、稳健可靠的大模型交付体系。

5. 参考资料

传统CI/CD工具概述:

https://blog.csdn.net/qq_40649503/article/details/123586995

大模型CI/CD理论分析:

https://blog.csdn.net/charles666666/article/details/148400764

大模型CI/CD与模型监控平台集成实践:

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)