一文搞懂大模型三大核心概念:Agent、MCP与Function Call的区别与应用

文章解析了大模型三大核心概念:Agent(自主决策AI应用)、MCP(标准化连接外部数据的协议)和Function Call(大模型调用外部函数的机制)。通过对比三者的定位、功能、应用场景及协同工作方式,帮助读者理解它们如何相互配合增强大模型能力,并提供了具体使用示例和选择指南,帮助开发者根据需求选择合适的技术方案。

文章解析了大模型三大核心概念:Agent(自主决策AI应用)、MCP(标准化连接外部数据的协议)和Function Call(大模型调用外部函数的机制)。通过对比三者的定位、功能、应用场景及协同工作方式,帮助读者理解它们如何相互配合增强大模型能力,并提供了具体使用示例和选择指南,帮助开发者根据需求选择合适的技术方案。

一、Agent:自主决策的AI应用

Agent是一种AI应用,能感知环境、规划任务并调用服务(外部工具、数据库等)完成任务。从定义上看,Agent的范围可以很广泛:

- 可以调用外部服务 (工具、数据库等)

- 具备自主决策能力 ,完成复杂任务

- 可以调用**MCP、Function Call**等能力

目前市面上的Agent包括:

- Coze、Dify里的智能体

- Manus、Devin等AI开发助手

- Flowith的Oracle模式

- Cursor、Windsurf的Agent模式

但Agent开发面临的挑战也很明显:由于每家产品的API集成都千差万别,这意味着Agent的开发者需要做非常大量的定制集成工作。这就引出了MCP的重要性。

二、MCP:大模型的"HTTP协议"

MCP全称是Model Context Protocol,是Anthropic提出的一种标准化协议,目的是让AI应用可以更好地连接各种外部数据服务。它相当于大模型的"HTTP协议"。

我们可以打个比方:

- HTTP协议:使浏览器与服务器 交互标准化

- MCP:使大模型与外部服务 交互标准化

就像HTTP统一了"快递单格式",让"寄快递"变得非常方便,MCP也在AI世界做着类似的事。

MCP的应用场景很广泛:

- Fetch MCP:网页内容抓取

- Google Drive MCP:文件读取

- 兼容工具:Claude客户端、Cursor、Windsurf 等

需要特别注意的是:**MCP并不绑定任何大模型**,这意味着你可以在支持MCP的工具中,用任何大模型调用MCP服务。这点与Function Call有明显区别。

三、Function Call:模型的原生能力扩展

Function Call即函数调用,是大模型调用外部函数或API以获取信息、执行计算或与系统交互的机制。它的特点是:

- 大模型调用外部函数或API 的机制

- 增强大模型能力的直接方式

- 通常与大模型绑定 ,作为模型的一部分

以扣子中的DeepSeek-R1为例,它有原生DeepSeek R1和支持Function Call的版本。Function Call版本可以在Single-Agent模式下调用各类扣子工具(插件、工作流、知识库)。

但Function Call也面临挑战:由于它可以让开发者自由定义函数和API调用方式,不同开发者采用不同方式时,就会出现不通用的问题,导致普及困难且需要重复开发。这再次凸显出MCP标准化的重要性。

四、三者定位对比:工具箱、瑞士军刀与智能工人

MCP Server:被动的工具箱

- 被动服务,仅响应调用请求

- 为大模型提供外部数据和能力支持

- 不参与决策或推理 过程

- 像工具箱,等待别人挑选使用

Function Call:瑞士军刀

- 直接扩展模型能力 的机制

- 允许模型生成请求参数 并整合结果

- 与模型绑定部署 ,紧密集成

- 像瑞士军刀,小巧多功能 ,随身携带

Agent:智能工人

- 具备自主决策能力 的AI实体

- 能感知环境、规划任务 并执行

- 可调用各种工具 (包括MCP/Function Call)

- 像熟练工人,选择合适工具 完成复杂任务

五、功能对比:从单一到复杂

六、应用场景案例

Function Call:实时天气查询

适合简单、同步任务。例如,当用户询问"北京今天的天气如何"时,模型可以直接调用get_weather()函数获取结果。

MCP Server:跨平台数据整合

适合复杂、异步任务。例如,企业可以将内部系统(CRM、ERP)封装为MCP Server,供多个Agent安全调用。

Agent:自动化客服

适合端到端复杂任务。例如,在客户服务场景中,Agent可以自动监控用户反馈、分析问题并生成解决方案。

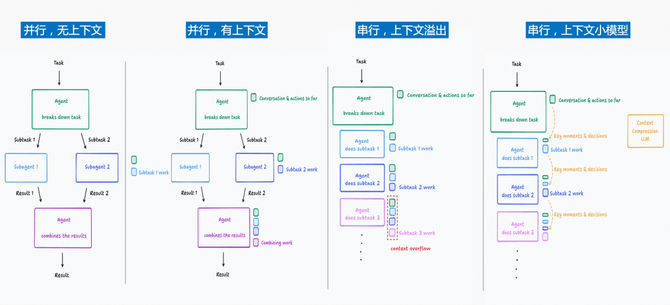

七、三者如何协同工作:知乎AI讨论总结案例

-

- 用户提问:"帮我总结知乎上关于AI的最新讨论 "

-

- LLM解析需求,调用Function Call检测平台类型

-

- Function Call返回"知乎",LLM通过MCP协议请求爬虫服务

-

- MCP Server抓取网页数据 后返回给LLM

-

- LLM生成摘要报告 并返回给用户

八、如何选择合适的技术方案

选择时应考虑以下因素:

任务复杂度

- 简单低延迟任务:Function Call

- 复杂数据整合任务:MCP Server

- 自主决策多步任务:Agent

部署灵活性

- Function Call:需与模型服务绑定 ,适合小型项目

- MCP Server:可独立扩展 ,适合企业级应用

- Agent:需要集成多种模块 ,适合大型复杂系统

协议标准化需求

- Function Call:无强制协议 ,实现方式因平台而异

- MCP Server:严格遵循标准 ,便于跨团队协作

- Agent:依赖底层工具 的协议规范

九、如何使用

Function Call 使用示例

# 定义函数

def get_weather(location):

# 实际实现会调用天气API

return {"city": location, "temperature": "22°C", "condition": "晴"}

# 注册函数到模型

functions = [

{

"name": "get_weather",

"description": "获取指定城市的当前天气",

"parameters": {

"type": "object",

"properties": {

"location": {"type": "string", "description": "城市名称"}

},

"required": ["location"]

}

}

]

# 使用模型调用函数

response = model.generate(

prompt="北京今天天气怎么样?",

functions=functions

)

# 如果模型决定调用函数

if response.function_call:

function_name = response.function_call.name

arguments = json.loads(response.function_call.arguments)

# 执行函数调用

result = get_weather(arguments["location"])

# 将结果返回给模型进行总结

final_response = model.generate(

prompt="北京今天天气怎么样?",

function_results=json.dumps(result)

)

MCP Server 使用示例

from fastapi import FastAPI

import httpx

app = FastAPI()

@app.post("/fetch")

asyncdeffetch_webpage(request: dict):

url = request.get("url")

asyncwith httpx.AsyncClient() as client:

response = await client.get(url)

content = response.text

# 返回MCP标准格式的响应

return {

"status": "success",

"content": content,

"metadata": {

"url": url,

"timestamp": str(datetime.now())

}

}

# 客户端使用MCP

asyncdefuse_mcp_client(url):

asyncwith httpx.AsyncClient() as client:

mcp_response = await client.post(

"http://localhost:8000/fetch",

json={"url": url}

)

return mcp_response.json()

Agent 使用示例

classSimpleAgent:

def__init__(self, llm, tools):

self.llm = llm

self.tools = tools

self.memory = []

defrun(self, user_input):

# 1. 添加用户输入到记忆

self.memory.append({"role": "user", "content": user_input})

# 2. 决策:分析需求并选择工具

planning_prompt = self._create_planning_prompt(user_input)

plan = self.llm.generate(planning_prompt)

# 3. 执行:调用工具获取结果

if"get_weather"in plan:

# 使用Function Call

weather_data = self.tools["function_call"].get_weather("北京")

self.memory.append({"role": "tool", "content": weather_data})

if"web_search"in plan:

# 使用MCP服务

search_results = self.tools["mcp"].fetch("https://news.com/ai")

self.memory.append({"role": "tool", "content": search_results})

# 4. 生成最终回复

final_prompt = self._create_response_prompt()

response = self.llm.generate(final_prompt)

return response

总结来说:

- Agent是一种AI应用,能感知环境、规划任务并调用服务(外部工具、数据库等,包括MCP Servers、Function Call)完成任务;如果Agent想要更好地完成任务,一般需要接入足够多的外部工具,而外部工具的接入千差万别;

- Function Call是大模型本身的一种能力,可以调用外部函数或API以增强大模型能力,但它同样面临着不同开发者自由定义导致的不标准问题;

prompt)

return response

总结来说:

- Agent是一种AI应用,能感知环境、规划任务并调用服务(外部工具、数据库等,包括MCP Servers、Function Call)完成任务;如果Agent想要更好地完成任务,一般需要接入足够多的外部工具,而外部工具的接入千差万别;

- Function Call是大模型本身的一种能力,可以调用外部函数或API以增强大模型能力,但它同样面临着不同开发者自由定义导致的不标准问题;

- MCP则是给AI应用提供了一套标准化协议,方便AI应用更好地访问外部工具,以提升大模型的响应能力

读者福利大放送:如果你对大模型感兴趣,想更加深入的学习大模型**,那么这份精心整理的大模型学习资料,绝对能帮你少走弯路、快速入门**

如果你是零基础小白,别担心——大模型入门真的没那么难,你完全可以学得会!

👉 不用你懂任何算法和数学知识,公式推导、复杂原理这些都不用操心;

👉 也不挑电脑配置,普通家用电脑完全能 hold 住,不用额外花钱升级设备;

👉 更不用你提前学 Python 之类的编程语言,零基础照样能上手。

你要做的特别简单:跟着我的讲解走,照着教程里的步骤一步步操作就行。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

现在这份资料免费分享给大家,有需要的小伙伴,直接VX扫描下方二维码就能领取啦😝↓↓↓

为什么要学习大模型?

数据显示,2023 年我国大模型相关人才缺口已突破百万,这一数字直接暴露了人才培养体系的严重滞后与供给不足。而随着人工智能技术的飞速迭代,产业对专业人才的需求将呈爆发式增长,据预测,到 2025 年这一缺口将急剧扩大至 400 万!!

大模型学习路线汇总

整体的学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战,跟着学习路线一步步打卡,小白也能轻松学会!

大模型实战项目&配套源码

光学理论可不够,这套学习资料还包含了丰富的实战案例,让你在实战中检验成果巩固所学知识

大模型学习必看书籍PDF

我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

大模型超全面试题汇总

在面试过程中可能遇到的问题,我都给大家汇总好了,能让你们在面试中游刃有余

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

👉获取方式:

😝有需要的小伙伴,可以保存图片到VX扫描下方二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最适合零基础的!!

更多推荐

已为社区贡献59条内容

已为社区贡献59条内容

所有评论(0)