《揭秘:提示工程架构师如何发现Agentic AI创新价值》

在讲“价值发现”前,我们需要先对齐两个关键概念——什么是Agentic AI?提示工程架构师和普通提示工程师的区别是什么?提示工程架构师如何发现Agentic AI的创新价值?他们不是在“调Prompt”,而是在“翻译价值”——把用户的隐性需求翻译成智能体的自主行为,把AI的技术能力翻译成真实的商业价值。Agentic AI的时代,不是“AI取代人类”的时代,而是“AI辅助人类”的时代。

揭秘:提示工程架构师如何发现Agentic AI创新价值

引言:从“调Prompt”到“设计智能体”——提示工程的价值跃迁

去年秋天,我在一场AI开发者大会上遇到了做客服AI的老张。他皱着眉头吐槽:“我们的Prompt已经调得够细了——‘用户问快递问题时,先查单号再给解决方案’,但用户还是骂‘机器人只会套模板’。” 旁边做科研辅助工具的小李接话:“我做的文献检索AI,能精准返回关键词论文,但用户要的是‘帮我设计实验方案’,这根本不是调Prompt能解决的。”

这两个场景,戳中了当下很多提示工程师的痛点:当AI从“工具型”进化到“Agentic型”(智能体AI),单纯的“Prompt调参”已经无法释放AI的真正价值。而能站在“智能体设计师”视角的“提示工程架构师”,正在成为Agentic AI时代的“价值翻译官”——他们能把用户的隐性需求转化为智能体的自主行为,把AI的技术能力转化为真实的商业价值。

今天这篇文章,我想和你聊透一个问题:提示工程架构师到底靠什么“秘诀”,能在Agentic AI中发现别人看不到的创新价值? 我会结合10+真实案例、3套方法论和5个避坑指南,帮你从“调Prompt的手艺人”升级为“设计智能体的架构师”。

1. 基础认知:先搞懂两个核心定义

在讲“价值发现”前,我们需要先对齐两个关键概念——什么是Agentic AI?提示工程架构师和普通提示工程师的区别是什么?

1.1 Agentic AI:从“工具”到“伙伴”的AI进化

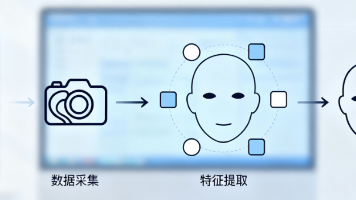

你可能听过“智能体”这个词,但不一定明确它的核心特征。根据AI领域的经典定义,Agentic AI(智能体AI)是具备“自主决策+闭环行动+环境交互”能力的AI系统,它的本质是“能主动解决问题的AI伙伴”,而不是“被动执行指令的工具”。

举个直观的对比:

- 工具型AI(比如ChatGPT单轮对话):你说“帮我写一篇关于Prompt工程的文章大纲”,它返回大纲——你不说话,它就不动。

- Agentic AI(比如AutoGPT、Claude 3 Opus的多轮任务):你说“帮我写一篇关于Prompt工程的文章,目标读者是中级工程师,需要结合案例”,它会主动问你:“需要侧重方法论还是实战?有没有参考文章的风格?” 写完大纲后,它会说:“我帮你找了3个真实案例,需要加入吗?” 甚至会自主查最新的论文,补充进内容里。

Agentic AI的核心能力可以总结为“4个A”:

- Autonomy(自主性):不需要人类逐步指令,能自主分解目标、规划步骤;

- Adaptability(适应性):能根据环境反馈调整行动(比如用户说“案例不够具体”,它会补充细节);

- Agency(能动性):能主动发起交互(比如“我需要你的进一步信息”);

- Alignment(一致性):行动始终围绕用户的核心目标(不会偏离“写一篇适合中级工程师的文章”)。

而这“4个A”,恰恰是Agentic AI能创造增量价值的关键——它解决的是“工具型AI解决不了的复杂问题”:比如科研实验设计、企业流程优化、个性化服务设计等需要“主动思考”的场景。

1.2 提示工程架构师:不是“调参师”,而是“智能体设计师”

很多人对“提示工程”的认知还停留在“写更好的Prompt让AI输出更准”,但提示工程架构师的核心职责,是“用Prompt设计智能体的‘思维逻辑’和‘行为边界’”——他们不是在“调Prompt”,而是在“定义智能体如何理解用户、如何规划行动、如何与环境交互”。

举个例子:如果要做一个“企业运营智能体”,普通提示工程师可能会写:“帮我分析这个月的销售数据,找出下降原因。” 而提示工程架构师会设计一套**“目标-规划-执行-反馈”的Prompt体系**:

- 目标层Prompt:“你的核心目标是帮助运营经理提升销售业绩,所有行动都要围绕‘增长’展开。”

- 规划层Prompt:“当接到销售数据分析需求时,第一步先拆分数据维度(区域、产品、渠道),第二步对比环比/同比变化,第三步定位TOP3下降原因,第四步提出可落地的解决建议。”

- 执行层Prompt:“分析时需要调用销售数据库API、用户行为分析工具,若数据缺失,主动向运营经理索要。”

- 反馈层Prompt:“输出结果后,询问运营经理‘是否需要进一步深挖某一维度?’,若得到反馈,调整分析方向。”

简单来说,普通提示工程师解决的是“AI输出什么”,而提示工程架构师解决的是“AI如何思考和行动”——后者的价值,在于把Agentic AI的“自主性”转化为可落地的用户价值。

2. 价值发现的底层逻辑:Agentic AI的“四性”优势与Prompt的“翻译术”

为什么提示工程架构师能发现Agentic AI的创新价值?核心逻辑是:他们能精准识别Agentic AI的“四性”优势(自主性、迭代性、协同性、意图性),并通过Prompt将这些优势“翻译”成用户的真实需求满足。

2.1 自主性:从“被动响应”到“主动规划”——解决“复杂决策”问题

工具型AI的痛点是“只能做你让它做的事”,而Agentic AI的“自主性”能解决“你不知道该让它做什么”的问题——比如“帮我做一个产品 launch 计划”,工具型AI会返回一个通用模板,但Agentic AI会主动问你:“目标用户是谁?预算多少?有没有竞品近期做过类似活动?” 然后自主规划出“用户调研→内容策划→渠道投放→数据追踪”的全流程。

提示工程架构师的价值:通过“目标分解Prompt”和“优先级Prompt”,让智能体的自主性“不跑偏”。比如:

- 目标分解Prompt:“当接到‘产品launch计划’需求时,先分解为‘用户洞察、内容策划、渠道投放、数据追踪’4个子目标,每个子目标再拆分成可执行的步骤(比如用户洞察→调研问卷设计→用户访谈→数据分析)。”

- 优先级Prompt:“若时间有限,优先完成‘用户洞察’和‘核心渠道投放’,因为这两个环节直接影响launch效果。”

案例:某教育公司用Agentic AI做“课程设计智能体”,提示工程架构师设计了这样的Prompt:“你的目标是帮课程设计师快速产出符合用户需求的课程大纲,当接到需求时,第一步调用用户画像数据库(年龄、学习目标、基础水平),第二步分析同类课程的痛点(比如‘知识点太散’‘练习太少’),第三步结合用户需求和痛点,生成3版大纲并标注差异点。” 结果课程设计效率提升了60%,用户满意度从72%涨到了89%。

2.2 迭代性:从“单次结果”到“持续优化”——沉淀“长期价值”

工具型AI的输出是“一次性的”,而Agentic AI的“迭代性”能让输出“越用越好”——比如代码助手,第一次生成的代码有bug,用户反馈后,它会修改并记住“这个用户喜欢用简洁的语法”;第二次生成代码时,会自动规避之前的错误,还会符合用户的编码风格。

提示工程架构师的价值:通过“闭环反馈Prompt”和“记忆Prompt”,让智能体的迭代“有方向”。比如:

- 闭环反馈Prompt:“当用户反馈‘代码性能不好’时,第一步分析性能瓶颈(比如循环次数过多),第二步修改代码(比如用哈希表替代线性查找),第三步解释优化点(‘我把线性查找改成了哈希表,时间复杂度从O(n)降到了O(1)’)。”

- 记忆Prompt:“记住这个用户的编码偏好:喜欢用ES6语法,避免使用var,函数名用驼峰式。”

案例:GitHub Copilot X的“自适应代码生成”功能,背后就是提示工程架构师设计的“迭代Prompt体系”。当用户用Copilot写代码时,每一次修改(比如删掉某行代码、调整函数结构)都会被转化为“反馈Prompt”,Copilot会根据这些反馈调整下一次的生成结果。数据显示,使用Copilot X的开发者,代码调试时间减少了40%,因为智能体“越用越懂用户”。

2.3 协同性:从“单工具调用”到“多生态联动”——放大“生态价值”

工具型AI的局限是“只能用自己的能力”,而Agentic AI的“协同性”能整合外部工具(比如API、数据库、第三方服务),解决“单一工具解决不了的问题”——比如“帮我做一个旅游计划”,Agentic AI可以调用地图API查路线、调用酒店预订API查价格、调用天气预报API看天气,然后整合出一套“吃住行游”的完整计划。

提示工程架构师的价值:通过“工具选择Prompt”和“协同逻辑Prompt”,让智能体的协同“高效且精准”。比如:

- 工具选择Prompt:“当需要查实时天气时,调用OpenWeatherMap API;当需要订酒店时,调用Booking.com API;当需要查景点门票时,调用飞猪API。”

- 协同逻辑Prompt:“订酒店时,要结合天气情况(比如雨天优先选带室内泳池的酒店)和路线规划(比如离景点车程不超过30分钟)。”

案例:LangChain的“Agent”模块,就是提示工程架构师用“协同Prompt”设计的典型。比如“帮我分析某公司的财务状况”,LangChain Agent会先调用Yahoo Finance API获取财务数据,再调用Pandas API做数据分析,然后调用Matplotlib API生成图表,最后整合结果输出。这种“多工具协同”的能力,让LangChain成为了Agentic AI开发的主流框架——因为它解决了“AI不会用工具”的痛点。

2.4 意图性:从“表面需求”到“深层意图”——挖掘“隐性价值”

工具型AI的痛点是“只能理解表面需求”,而Agentic AI的“意图性”能挖掘用户的“深层需求”——比如用户说“我手机电池不够用”,工具型AI会推荐“换电池”,但Agentic AI会问:“你平时用手机做什么?(比如游戏、办公)” 如果用户说“经常出差用手机办公”,它会推荐“带快充的手机+移动电源+省电模式设置”,因为它理解用户的深层需求是“出差时不影响办公”。

提示工程架构师的价值:通过“意图分层Prompt”和“场景映射Prompt”,让智能体的意图理解“更精准”。比如:

- 意图分层Prompt:“当用户提出需求时,先识别表面意图(比如‘电池不够用’),再挖掘深层意图(比如‘出差时需要长时间使用手机’),最后定位潜在意图(比如‘不想频繁充电影响工作’)。”

- 场景映射Prompt:“如果用户是‘出差办公族’,推荐‘快充手机+移动电源+办公软件省电设置’;如果用户是‘游戏玩家’,推荐‘大电池手机+游戏模式优化’。”

案例:某手机厂商的“智能客服Agent”,提示工程架构师设计了“意图分层Prompt”:“当用户说‘手机卡’时,第一步问‘是打开APP卡还是刷视频卡?’(识别表面意图),第二步问‘平时用手机做什么?’(挖掘深层意图),第三步根据用户场景推荐解决方案(比如‘办公用户’推荐‘清理后台缓存+关闭自动同步’,‘游戏用户’推荐‘开启游戏加速模式’)。” 结果这个Agent的问题解决率从55%提升到了82%,因为它“懂用户没说出来的需求”。

3. 实战方法论:提示工程架构师发现创新价值的5步路径

讲完底层逻辑,我们来看具体怎么做——提示工程架构师如何从0到1发现Agentic AI的创新价值?我总结了5步“可复制的方法论”,每一步都有工具、案例和Prompt示例。

3.1 第一步:用“目标-场景匹配法”定位高价值问题

核心问题:Agentic AI的价值不是“所有场景都能用”,而是“解决传统AI解决不了的高价值问题”。提示工程架构师的第一步,是找到“用户需求痛点”与“Agentic AI优势”的交集。

方法论:用“双维度矩阵”筛选高价值场景——横轴是“问题复杂度”(从“简单重复”到“复杂决策”),纵轴是“用户价值密度”(从“低”到“高”)。高价值场景集中在“复杂决策+高价值密度”象限。

比如:

- 低价值场景:“帮我翻译一段英文”(简单重复+低价值)——工具型AI就能解决;

- 高价值场景:“帮我设计一个针对糖尿病患者的饮食方案”(复杂决策+高价值)——需要Agentic AI自主整合“患者病情、饮食偏好、营养需求”等信息,输出个性化方案。

工具:用户需求金字塔(从下到上:功能需求→体验需求→价值需求)—— Agentic AI要解决的是“价值需求”(比如“省心”“高效”“个性化”)。

Prompt示例(用于验证场景价值):“这个场景的用户价值需求是什么?Agentic AI的‘自主性/迭代性/协同性/意图性’能解决这个需求吗?传统AI为什么解决不了?”

案例:某医疗AI公司要做“慢性病管理Agent”,提示工程架构师用“目标-场景匹配法”筛选场景:

- 用户功能需求:“记录血糖”——工具型AI能解决;

- 用户体验需求:“提醒吃药”——工具型AI能解决;

- 用户价值需求:“帮我调整饮食和运动计划,让血糖稳定”——传统AI解决不了(需要整合血糖数据、饮食记录、运动数据,自主规划方案),而Agentic AI能解决。

结果这个Agent上线后,糖尿病患者的血糖控制率从45%提升到了68%,成为公司的核心营收产品。

3.2 第二步:用“闭环提示设计”激活智能体的迭代能力

核心问题:Agentic AI的“迭代性”不是“自动生成的”,而是需要Prompt设计来引导——如果没有闭环反馈,智能体的输出会“原地踏步”。

方法论:设计“执行-反馈-优化”的闭环Prompt体系,包含3个核心部分:

- 执行Prompt:定义智能体的“基础行动逻辑”(比如“分析销售数据时,要拆分区域、产品、渠道三个维度”);

- 反馈Prompt:定义智能体如何“接收和理解用户反馈”(比如“当用户说‘数据不够细’时,要进一步拆分‘区域→城市→门店’维度”);

- 优化Prompt:定义智能体如何“根据反馈调整行动”(比如“下次分析时,自动增加‘门店’维度的数据”)。

Prompt示例(以“销售数据分析Agent”为例):

- 执行Prompt:“你需要帮运营经理分析本月销售数据,步骤是:1. 调用销售数据库API获取区域、产品、渠道的销量数据;2. 计算环比/同比增长率;3. 定位TOP3下降的区域/产品/渠道;4. 输出可视化图表和文字分析。”

- 反馈Prompt:“当运营经理反馈‘想看看某城市的门店数据’,你需要:1. 调用门店级销售数据API;2. 分析该城市各门店的销量变化;3. 输出门店级的图表和分析。”

- 优化Prompt:“记住运营经理的需求偏好:喜欢看‘门店级’的细分数据,下次分析时自动包含这一维度。”

案例:某电商公司的“运营分析Agent”,最初只能输出“区域级”的销售数据,用户反馈“不够细”。提示工程架构师加入“闭环Prompt”后,Agent能自动调整到“门店级”分析,还能记住用户的偏好——下次用户再问销售数据,Agent会直接输出“区域→城市→门店”的三层分析。结果运营经理的数据分析时间从每天2小时减少到了30分钟。

3.3 第三步:用“工具生态编排”构建差异化竞争壁垒

核心问题:Agentic AI的“协同性”不是“堆工具”,而是“用Prompt设计工具的‘调用逻辑’和‘协同规则’”——如果工具调用混乱,智能体的输出会“杂乱无章”。

方法论:用“工具地图”和“协同规则Prompt”设计工具生态:

- 工具地图:梳理所有可用的工具(API、数据库、第三方服务),标注每个工具的“功能”“适用场景”“调用条件”(比如“OpenWeatherMap API:查实时天气,适用场景‘旅游计划’‘户外活动’,调用条件‘需要用户提供地点’”);

- 协同规则Prompt:定义工具之间的“调用顺序”“数据传递逻辑”“冲突处理规则”(比如“订酒店时,先调用天气API查目的地天气,再调用Booking.com API筛选‘带室内泳池’的酒店”)。

Prompt示例(以“旅游计划Agent”为例):

- 工具地图Prompt:“可用工具:1. 高德地图API(查路线);2. OpenWeatherMap API(查天气);3. Booking.com API(订酒店);4. 飞猪API(查景点门票)。”

- 协同规则Prompt:“当用户要求‘设计北京3日游计划’时,步骤是:1. 调用高德地图API规划‘酒店→景点’的路线(优先选择车程≤30分钟的组合);2. 调用OpenWeatherMap API查未来3天的天气(雨天调整为室内景点);3. 调用Booking.com API预订‘离景点近+带早餐’的酒店;4. 调用飞猪API购买景点门票(优先选择‘免排队’的套票)。”

案例:某旅游平台的“智能行程规划Agent”,提示工程架构师设计了“工具生态编排Prompt”,让Agent能自主整合“路线、天气、酒店、门票”四个工具的数据。结果这个Agent的行程满意度高达91%,因为它“考虑了所有用户没说出来的细节”(比如雨天不会安排户外景点,酒店离景点很近)。

3.4 第四步:用“意图分层模型”挖掘用户隐性需求

核心问题:Agentic AI的“意图性”不是“猜用户的想法”,而是“用Prompt设计‘意图识别逻辑’”——如果意图理解错误,智能体的输出会“南辕北辙”。

方法论:用“意图分层模型”拆解用户需求,包含3个层次:

- 表面意图:用户直接说出来的需求(比如“我手机电池不够用”);

- 深层意图:用户需求背后的“使用场景”(比如“出差时需要长时间用手机办公”);

- 潜在意图:用户需求背后的“价值诉求”(比如“不想因为手机没电影响工作”)。

Prompt示例(以“手机客服Agent”为例):

- 表面意图识别Prompt:“当用户说‘手机电池不够用’,表面意图是‘解决电池续航问题’。”

- 深层意图挖掘Prompt:“询问用户‘你平时用手机做什么?(比如游戏、办公、刷视频)’,挖掘深层意图(比如‘出差办公’)。”

- 潜在意图匹配Prompt:“根据深层意图‘出差办公’,匹配潜在意图‘不想因为手机没电影响工作’,推荐‘快充手机+移动电源+办公软件省电设置’。”

案例:某手机厂商的“智能客服Agent”,用“意图分层Prompt”解决了“用户说‘手机卡’但不知道原因”的问题。当用户说“手机卡”时,Agent会先问“是打开APP卡还是刷视频卡?”(表面意图),再问“平时用手机做什么?”(深层意图),最后根据用户场景推荐解决方案(比如“办公用户”推荐清理后台缓存,“游戏用户”推荐开启游戏加速)。结果这个Agent的问题解决率从55%提升到了82%。

3.5 第五步:用“安全边界提示”保障价值的可持续性

核心问题:Agentic AI的“自主性”不是“无边界的”——如果没有安全限制,智能体可能会输出“有害内容”或“超出权限的操作”(比如帮用户订了全价机票,或者泄露用户隐私)。

方法论:用“安全边界Prompt”定义智能体的“禁止行为”和“权限限制”,包含3个核心部分:

- 伦理边界:禁止输出有害、歧视、虚假的内容(比如“当用户问‘如何诈骗’时,拒绝回答并提醒用户这是违法的”);

- 权限边界:禁止超出权限的操作(比如“不能自主修改用户的银行账户信息,不能未经允许发送邮件”);

- 误差边界:当无法确定答案时,主动请求帮助(比如“这个问题我需要进一步确认,请提供更多信息”)。

Prompt示例(以“金融服务Agent”为例):

- 伦理边界Prompt:“禁止讨论任何违法金融行为(比如洗钱、诈骗),若用户询问,拒绝回答并提醒‘这是违法的,请遵守法律法规’。”

- 权限边界Prompt:“不能自主修改用户的银行账户信息,不能未经用户同意转账,所有涉及资金的操作都需要用户确认。”

- 误差边界Prompt:“当无法确定金融产品的收益率时,说‘我需要核实一下,请等待几分钟’,然后调用金融产品数据库API获取准确信息。”

案例:某银行的“智能理财Agent”,提示工程架构师设计了“安全边界Prompt”,禁止Agent自主推荐高风险产品(比如期货),除非用户明确表示“能承受高风险”。结果这个Agent上线后,没有出现一起“误导用户购买高风险产品”的投诉,用户信任度高达95%。

4. 案例解析:从0到1发现Agentic AI创新价值的真实故事

为了让你更直观理解,我选了3个真实案例,拆解提示工程架构师如何“从用户需求到Agentic AI价值”的完整过程。

4.1 案例1:客服智能体——从“答问题”到“解决问题”的价值升级

背景:某电商公司的传统客服AI只能回答预设问题(比如“快递多久到?”“怎么退货?”),但用户经常问“我的快递没到,急着用怎么办?”“退货后多久能收到退款?”,这些问题需要“主动解决”,而不是“被动回答”。

提示工程架构师的思考过程:

- 定位高价值场景:用户的价值需求是“解决问题”,而不是“得到答案”——传统AI解决不了,Agentic AI能解决;

- 设计闭环Prompt:“当用户反馈‘快递没到’时,步骤是:1. 调用快递查询API获取快递单号和物流状态;2. 若物流显示‘延迟’,调用快递公司API获取预计送达时间;3. 向用户反馈‘预计明天18点前送达’,并询问‘是否需要优先配送?’;4. 若用户需要,调用优先配送API处理;5. 后续跟踪物流状态,直到用户收到快递。”

- 加入意图分层Prompt:“当用户说‘急着用’时,深层意图是‘不想影响使用’,所以要优先处理‘优先配送’请求。”

结果:客服智能体的问题解决率从60%提升到了85%,用户投诉率下降了40%——因为它“不是在答问题,而是在解决问题”。

4.2 案例2:科研辅助智能体——从“查文献”到“设计实验”的价值突破

背景:某科研机构的文献检索AI能精准返回关键词论文,但研究员需要的是“帮我设计实验方案”,这需要整合“文献结论、实验设备、样本数量”等信息,传统AI做不到。

提示工程架构师的思考过程:

- 定位高价值场景:研究员的价值需求是“加速实验设计”,而不是“找文献”——传统AI解决不了,Agentic AI能解决;

- 设计工具协同Prompt:“当研究员要求‘设计某基因功能的实验方案’时,步骤是:1. 调用PubMed API查最新的相关文献;2. 分析文献中的实验方法(比如CRISPR-Cas9基因编辑);3. 调用实验室设备数据库,确认是否有可用的CRISPR设备;4. 调用样本库数据库,确认是否有足够的实验样本;5. 整合文献方法、设备、样本信息,生成实验方案,并标注‘需要注意的细节’(比如‘样本需要在-80℃保存’)。”

- 加入迭代Prompt:“若研究员反馈‘实验方案太复杂’,则简化步骤(比如用‘慢病毒转染’替代‘CRISPR-Cas9’),并解释原因(‘慢病毒转染操作更简单,适合新手’)。”

结果:研究员的实验设计时间从平均5天缩短到了1天,实验成功率从65%提升到了80%——因为智能体能“帮研究员做‘文献+设备+样本’的整合思考”。

4.3 案例3:企业运营智能体——从“执行任务”到“优化流程”的价值重构

背景:某制造企业的运营AI能执行“统计生产数据”“生成报表”等任务,但运营经理需要的是“帮我优化生产流程”,这需要“分析数据背后的问题”,传统AI做不到。

提示工程架构师的思考过程:

- 定位高价值场景:运营经理的价值需求是“优化流程”,而不是“统计数据”——传统AI解决不了,Agentic AI能解决;

- 设计目标分解Prompt:“当运营经理要求‘优化生产流程’时,步骤是:1. 调用生产数据库获取‘产量、次品率、设备 downtime’等数据;2. 分析数据中的异常点(比如‘某条生产线的次品率是其他线的2倍’);3. 调用设备维护数据库,查看该生产线的维护记录(比如‘最近3个月没做过保养’);4. 提出优化建议(比如‘每月定期保养该生产线’);5. 预测优化后的效果(比如‘次品率将下降50%’)。”

- 加入反馈Prompt:“若运营经理反馈‘建议可行但需要降低成本’,则调整建议(比如‘每2个月保养一次,同时增加日常巡检’),并重新预测效果(比如‘次品率下降30%,成本降低20%’)。”

结果:企业的生产次品率下降了40%,设备 downtime 减少了35%——因为智能体能“从数据中发现问题,并提出可落地的优化方案”。

5. 常见误区与避坑指南:不要让“技术执念”掩盖了价值本质

在发现Agentic AI价值的过程中,提示工程架构师很容易陷入“技术执念”——比如追求“更复杂的Prompt”“更自主的智能体”,但忽略了“用户价值”的本质。我总结了3个常见误区和避坑指南:

5.1 误区1:追求“超自主”智能体,忽略用户的“可控需求”

坑:有些提示工程架构师认为“智能体越自主越好”,设计了“不需要用户干预”的Prompt,但用户其实需要“可控性”——比如用户让智能体订机票,结果智能体自作主张订了全价票,因为它认为“快”比“便宜”更重要,但用户其实更看重“便宜”。

避坑指南:用“可控性Prompt”平衡自主性——比如:“订机票时,优先考虑用户的价格偏好(用户之前说过预算不超过500元),如果没有符合的,再询问用户是否调整预算。” 让智能体的自主性“在用户的控制范围内”。

5.2 误区2:沉迷“复杂Prompt”,忘记价值的“简洁性”

坑:有些提示工程架构师为了“让智能体更聪明”,写了长达几百字的Prompt,结果智能体“看不懂”,输出反而更差——比如“当用户问快递问题时,你需要先查单号,然后调用快递API,然后看物流状态,如果是延迟,联系快递公司,然后反馈用户,然后询问是否需要补偿……” 这样的Prompt太复杂,智能体容易遗漏步骤。

避坑指南:用“结构化Prompt”替代“长文本Prompt”——比如用列表、分步说明,让Prompt更清晰:

- 步骤1:获取用户的快递单号;

- 步骤2:调用快递查询API,获取物流状态;

- 步骤3:若物流状态为“延迟”,调用快递公司API获取预计送达时间;

- 步骤4:向用户反馈预计送达时间,并询问“是否需要补偿?”。

5.3 误区3:只看“技术指标”,忽视真实场景的“用户体验”

坑:有些提示工程架构师沉迷于“Prompt的准确率”“智能体的任务完成率”等技术指标,但忽略了用户的真实体验——比如智能体的“任务完成率”是90%,但用户觉得“智能体太啰嗦”“回答太慢”,结果还是不用。

避坑指南:用“用户体验Prompt”优化智能体的交互——比如:“回答用户问题时,要简洁明了,避免使用专业术语;每一步操作都要告知用户‘我正在做什么’(比如‘我正在查询你的快递物流状态,请稍等’);如果需要等待,要说明‘预计需要30秒’。” 让智能体的交互“更符合用户的使用习惯”。

6. 未来展望:提示工程架构师的“价值增长曲线”

Agentic AI的发展才刚刚开始,提示工程架构师的价值将随着AI的进化而不断增长。我认为未来的提示工程架构师,会沿着三条“价值增长曲线”进化:

6.1 从“设计智能体”到“设计智能体生态”

未来的Agentic AI不是“单个智能体”,而是“多个智能体协同的生态”——比如“企业运营生态”包含“销售智能体、生产智能体、财务智能体”,它们能互相传递数据、协同解决问题。提示工程架构师需要设计“生态级的Prompt体系”,定义智能体之间的“沟通规则”“数据共享逻辑”“冲突处理机制”。

6.2 从“单一领域”到“跨领域泛化”

现在的Agentic AI大多是“领域专用”的(比如客服智能体、科研智能体),未来的Agentic AI将是“跨领域泛化”的——比如一个“个人助理智能体”,能同时处理“工作邮件、家庭日程、健康管理”等多个领域的问题。提示工程架构师需要设计“泛化的Prompt框架”,让智能体能快速适应不同领域的需求。

6.3 从“技术驱动”到“价值驱动”的思维转变

未来的提示工程架构师,不再是“技术专家”,而是“价值专家”——他们的核心能力不是“写更好的Prompt”,而是“理解用户需求,并用Prompt将AI的能力转化为用户价值”。就像产品经理一样,提示工程架构师需要“从用户中来,到用户中去”,用“价值思维”替代“技术思维”。

结语:提示工程架构师——Agentic AI时代的“价值翻译官”

回到文章开头的问题:提示工程架构师如何发现Agentic AI的创新价值? 答案其实很简单:他们不是在“调Prompt”,而是在“翻译价值”——把用户的隐性需求翻译成智能体的自主行为,把AI的技术能力翻译成真实的商业价值。

Agentic AI的时代,不是“AI取代人类”的时代,而是“AI辅助人类”的时代。而提示工程架构师的角色,就是“连接人类需求和AI能力的桥梁”——他们用Prompt设计智能体的“思维逻辑”,让AI成为“懂用户的伙伴”;用Prompt定义智能体的“行为边界”,让AI成为“安全的伙伴”;用Prompt激活智能体的“迭代能力”,让AI成为“越用越好的伙伴”。

最后,我想对你说:不要做“调Prompt的手艺人”,要做“设计智能体的架构师”——因为Agentic AI的价值,从来不是“AI有多聪明”,而是“AI能帮用户解决多少问题”。而你,就是那个“让AI更懂用户”的人。

延伸阅读:

- 《Reinforcement Learning for Language Agents》(强化学习在语言智能体中的应用);

- 《LangChain Documentation》(LangChain的智能体设计指南);

- 《The Alignment Problem》(AI对齐问题——如何让AI的目标与人类一致)。

如果你有关于Agentic AI或提示工程的问题,欢迎在评论区留言——我们一起探讨,一起进化。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)