AI智能体连载(6)工作流与编排(Orchestration)

LLM是“CEO”,负责决策方向;工具是“执行部门”(如市场部、技术部),负责落地动作;向量数据库是“档案室”,负责存储和检索历史资料;那么编排框架就是“总经理”——它不直接做决策或执行,但负责协调CEO、执行部门、档案室的工作,确保“公司”高效运转,完成客户(用户)的需求。从技术角度看,编排是“自动化管理多步骤任务流程”的能力流程协同:让“记忆检索→LLM决策→工具执行→结果反馈”形成闭环,避免

3.4 工作流与编排(Orchestration):LangChain和LlamaIndex的“胶水”艺术

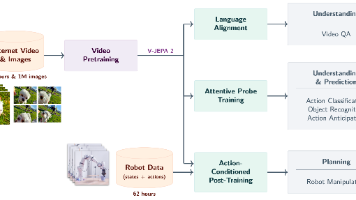

在前面三节中,我们已经拆解了智能体的“三大核心部件”:负责决策的大脑(LLM)、负责交互的手脚(Function Calling)、负责记忆的长期记忆(向量数据库)。但此时的部件仍是“零散的零件”——LLM不知道何时调用向量数据库的记忆,工具执行结果不知道如何反馈给LLM,整个系统缺乏“协同工作的中枢”。

要将这些零件组装成“能自主运行的智能体”,就需要编排(Orchestration)框架——它相当于智能体的“底盘与传动系统”,负责将大脑、手脚、记忆串联成一个有机整体,自动完成“接收需求→调用记忆→决策工具→执行反馈→存储记忆”的全流程。而LangChain和LlamaIndex,就是当前最主流的“智能体编排工具”。

一、什么是编排(Orchestration)?——智能体的“中枢调度系统”

如果把智能体比作“一家小型公司”:

- LLM是“CEO”,负责决策方向;

- 工具是“执行部门”(如市场部、技术部),负责落地动作;

- 向量数据库是“档案室”,负责存储和检索历史资料;

- 那么编排框架就是“总经理”——它不直接做决策或执行,但负责协调CEO、执行部门、档案室的工作,确保“公司”高效运转,完成客户(用户)的需求。

从技术角度看,编排是“自动化管理多步骤任务流程”的能力,核心要解决三个问题:

- 流程协同:让“记忆检索→LLM决策→工具执行→结果反馈”形成闭环,避免部件间“信息断层”;

- 动态决策:根据任务进展自动调整流程(如工具执行失败时,让LLM重新生成参数);

- 降低开发成本:无需手动编写“调用LLM→处理工具结果→存储记忆”的重复代码,框架已封装好标准化接口。

举个具体例子:用户要求“查上海明天的天气,生成出行建议,并同步到我的Notion日程”。编排框架需要自动完成以下步骤:

- 接收用户需求,先检索向量数据库(确认用户是否有“出行偏好”相关记忆,如“不喜欢雨天出行”);

- 将“需求+记忆”传给LLM,LLM决策“需要调用天气API查上海明天天气”;

- 框架自动调用天气API,获取结果(如“上海明天小雨,气温18-22℃”);

- 将天气结果传回LLM,LLM生成“带雨具、选择室内活动”的出行建议,并决策“需要调用Notion API同步日程”;

- 框架自动调用Notion API,将出行建议写入用户日程;

- 将最终结果反馈给用户,并将“用户需要同步Notion日程”的偏好存入向量数据库(更新长期记忆)。

整个过程中,用户只需输入需求,框架会自动协调所有部件完成任务——这就是编排的核心价值。

二、主流编排框架对比:LangChain与LlamaIndex

当前智能体开发领域,最常用的两个编排框架是LangChain和LlamaIndex。二者定位不同,但可互补,覆盖从“通用智能体”到“数据密集型智能体”的全场景。

2.1 LangChain:“万能胶水”——通用智能体的首选框架

LangChain的定位是**“连接LLM与外部世界的万能框架”**,它不局限于某一特定场景,而是提供了一套“模块化、可组合”的工具集,让开发者能快速搭建任何类型的智能体(如个人助手、客服机器人、数据分析工具)。

核心特点:

-

全组件覆盖,模块化设计

LangChain封装了智能体所需的所有核心组件接口,开发者可像“搭积木”一样组合:- 模型接口(Models):支持DeepSeek、智谱AI、GPT-4o等几乎所有主流LLM,切换模型只需修改配置;

- 工具集成(Tools):内置100+常用工具(如搜索、邮件、数据库、代码解释器),也支持自定义工具(如企业内部系统API);

- 记忆管理(Memory):无缝对接Chroma、Pinecone等向量数据库,自动处理“记忆存储与检索”;

- 链(Chains):将多个组件串联成“流程模板”,如“RetrievalQA Chain”(检索记忆→生成回答)、“Sequential Chain”(按顺序执行多步任务)。

-

灵活的工作流编排

LangChain支持从“简单线性流程”到“复杂条件分支流程”的全场景编排。例如:- 简单流程:“调用搜索工具→获取结果→LLM生成回答”;

- 复杂流程:“调用搜索工具→若结果不完整,则重新搜索→若结果完整,则调用计算器处理数据→LLM生成分析报告”。

开发者可通过“自定义Chain”或“Agent(智能体)”模块,实现高度个性化的流程逻辑。

-

庞大的生态与社区支持

LangChain是目前LLM框架中生态最成熟的:- 官方文档详细,提供大量中文教程;

- 社区贡献了数万个“现成的Chain模板”(如“电商客服智能体Chain”“财务分析Chain”);

- 与国内LLM(DeepSeek、智谱AI)、向量数据库(Chroma、Milvus)、工具(飞书API、企业微信API)深度适配,国内开发者无适配障碍。

适用场景:

- 通用型智能体(如个人助手、企业客服机器人);

- 需要多工具协同的复杂任务(如“市场调研→数据可视化→生成报告”);

- 高度定制化的智能体(如企业内部的“供应链管理智能体”“HR招聘智能体”)。

2.2 LlamaIndex:“数据专家”——聚焦检索增强的框架

LlamaIndex(前身为GPT Index)的定位是**“专注于数据检索与增强的框架”**,它的核心优势是“高效处理海量私有数据”,尤其适合构建“基于文档的问答智能体”(如企业知识库问答、PDF分析助手)。

核心特点:

-

强大的数据处理能力

LlamaIndex专门解决“LLM如何高效利用私有数据”的问题,提供了一套完整的“数据处理流水线”:- 数据接入(Data Connectors):支持直接读取PDF、Word、Excel、Notion、数据库、网页等200+数据源,自动提取文本内容;

- 数据拆分(Node Parsing):将长文档(如100页PDF)拆分为“语义连贯的小片段”(Node),避免LLM上下文窗口不足的问题;

- 索引构建(Indexing):自动将拆分后的文本转化为向量,存入向量数据库,并构建“分层索引”(如树形索引、列表索引),提升检索效率;

- 检索优化(Retrieval):支持“相似性检索”“关键词检索”“混合检索”,还能通过“Reranking(重排序)”优化检索结果(如排除无关片段)。

-

开箱即用的RAG能力

RAG(Retrieval-Augmented Generation,检索增强生成)是智能体利用私有数据的核心技术——先从数据中检索相关信息,再结合LLM生成回答。LlamaIndex将RAG的复杂度降到最低:

开发者只需3行代码,即可实现“上传PDF→构建索引→生成问答”的全流程,无需关心“数据拆分、向量生成、检索逻辑”等细节。 -

与LangChain互补协作

LlamaIndex不擅长“多工具编排”,但在“数据检索”上远超LangChain;而LangChain擅长“多工具编排”,但在“复杂数据处理”上不够深入。因此,二者常结合使用:- 用LlamaIndex处理“私有数据检索”(如从企业知识库中找产品信息);

- 用LangChain处理“多工具协同”(如将检索到的产品信息,通过邮件API发送给客户)。

适用场景:

- 基于私有文档的问答智能体(如“企业手册问答机器人”“PDF分析助手”);

- 知识库管理系统(如“学术文献库”“法律案例库”);

- 需要深度利用数据的智能体(如“基于历史销售数据的分析助手”)。

2.3 框架选型对比表

为了更直观地选择框架,我们将LangChain与LlamaIndex的核心差异整理如下:

| 对比维度 | LangChain | LlamaIndex |

|---|---|---|

| 核心定位 | 通用LLM应用编排框架(万能胶水) | 专注数据检索与RAG的框架(数据专家) |

| 核心优势 | 多组件、多工具的灵活编排 | 高效处理海量私有数据,RAG能力强 |

| 学习成本 | 中等(需理解Chain、Agent等概念) | 低(RAG功能开箱即用,无需复杂配置) |

| 国内适配 | 支持DeepSeek、智谱AI、Milvus等,适配良好 | 支持国内LLM和向量数据库,数据接入适配国内数据源(如飞书文档) |

| 典型场景 | 个人助手、多工具协同任务(如市场调研) | 文档问答、知识库管理、数据密集型任务 |

| 与其他框架协作 | 可集成LlamaIndex作为“数据检索模块” | 可作为LangChain的“检索组件”,专注数据处理 |

选型建议:

- 新手入门:若目标是“搭建能调用工具的通用智能体”(如查天气、发邮件),优先选LangChain;若目标是“搭建PDF问答助手”,优先选LlamaIndex;

- 企业应用:若需要“多工具+私有数据”(如“调用CRM数据→生成客户报告→同步至Notion”),建议LangChain+LlamaIndex结合使用;

- 快速验证原型:若需快速验证“工具协同”原型,用LangChain;若需快速验证“文档问答”原型,用LlamaIndex。

三、可视化流程:智能体的完整工作流(基于LangChain)

为了让你更清晰地理解编排框架如何协调各组件,我们以“用户要求查上海明天天气并生成Notion日程”为例,用Mermaid流程图展示智能体的完整工作流(基于LangChain编排):

flowchart TD

%% 定义节点样式

style A fill:#f9f,stroke:#333,stroke-width:2px

style B fill:#bbf,stroke:#333,stroke-width:2px

style C fill:#bfb,stroke:#333,stroke-width:2px

style D fill:#fbb,stroke:#333,stroke-width:2px

style E fill:#ffb,stroke:#333,stroke-width:2px

A[用户输入:"查上海明天天气, 生成出行建议并同步到Notion日程"] --> B[LangChain框架接收请求]

%% 第一步:检索长期记忆

B --> C[记忆模块:从Chroma向量数据库检索用户记忆]

C -->|检索结果:"用户不喜欢雨天出行"| D[上下文组装:用户需求+记忆信息]

%% 第二步:LLM决策是否调用工具

D --> E[LLMDeepSeek思考与决策]

E --> F{是否需要调用工具?}

%% 分支1:需要调用天气工具

F -- 是需查天气 --> G[工具模块:调用天气API参数:城市=上海, 日期=明天]

G --> H[获取工具结果:"上海明天小雨, 气温18-22℃"]

H --> I[上下文更新:加入天气结果]

I --> E[LLMDeepSeek重新思考与决策]

%% 分支2:需要调用Notion工具

F -- 是需同步Notion --> J[工具模块:调用Notion API参数:日程内容="上海明天小雨, 带雨具, 优先室内活动"]

J --> K[获取工具结果:"Notion日程同步成功"]

K --> L[上下文更新:加入Notion同步结果]

L --> E[LLMDeepSeek重新思考与决策]

%% 分支3:无需调用工具, 生成最终回答

F -- 否任务完成 --> M[LLM生成最终回答:"上海明天小雨, 气温18-22℃, 建议携带雨具, 优先选择室内活动, 已同步至您的Notion日程"]

M --> N[输出回答给用户]

%% 第三步:更新长期记忆

N --> O[记忆模块:判断是否存储新记忆]

O -- 是存储"用户需同步Notion日程"偏好 --> P[嵌入模型:将新记忆转化为向量]

P --> Q[存储至Chroma向量数据库, 更新长期记忆]

流程关键解读:

- 闭环协作:整个流程形成“接收需求→检索记忆→LLM决策→工具执行→结果反馈→更新记忆”的闭环,所有部件在LangChain的协调下自动运转;

- 动态决策:LLM会根据“当前上下文”动态调整决策——第一次决策“调用天气工具”,获取结果后重新决策“调用Notion工具”,直到任务完成;

- 记忆联动:记忆模块不仅在流程开始时提供历史信息,还在流程结束后更新新记忆(如“用户需同步Notion日程”),让智能体“越用越贴心”。

总结:编排框架——智能体的“灵魂纽带”

如果说大脑、手脚、记忆是智能体的“硬件”,那么编排框架就是智能体的“软件中枢”——它让零散的硬件部件拥有了“协同工作的能力”,从“零件堆”变成“能自主解决问题的智能体”。

- LangChain凭借“通用编排能力”,成为构建大多数智能体的“首选工具”,尤其适合需要多工具协同的场景;

- LlamaIndex凭借“数据检索专长”,成为处理私有数据的“最佳搭档”,尤其适合文档问答类场景;

- 二者结合,可覆盖从“通用助手”到“数据密集型智能体”的几乎所有需求。

至此,我们已完整掌握智能体的“技术架构蓝图”——从大脑(LLM)、手脚(Function Calling)、记忆(向量数据库)到中枢(编排框架)。下一章,我们将进入“实战环节”,学习如何用这些技术搭建一个属于自己的智能体。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)