Agentic AI技术展示:提示工程架构师的技术前沿

你一定有过这样的经历:用ChatGPT写单轮文案很顺手,但让它完成「调研2024年AIAgent最新进展并生成结构化报告」这样的复杂任务时,结果总是差强人意——要么漏了关键文献,要么结构混乱,要么不会调用工具补充信息。这不是你的Prompt写得不好,而是传统Prompt工程的「静态、单轮、无协作」特性,已经无法满足Agentic AI(智能体AI)的动态需求。Agentic AI是一种能「自主分解

Agentic AI时代:提示工程架构师的技术前沿与实践指南

副标题:从基础Prompt到智能体系统设计的全栈能力拆解

摘要/引言

你一定有过这样的经历:用ChatGPT写单轮文案很顺手,但让它完成「调研2024年AIAgent最新进展并生成结构化报告」这样的复杂任务时,结果总是差强人意——要么漏了关键文献,要么结构混乱,要么不会调用工具补充信息。

这不是你的Prompt写得不好,而是传统Prompt工程的「静态、单轮、无协作」特性,已经无法满足Agentic AI(智能体AI)的动态需求。

Agentic AI是一种能「自主分解任务、调用工具、记忆状态、迭代优化」的智能系统,比如AutoGPT、GPTs、企业内部的智能运营Agent。而要让这样的系统真正「聪明」,需要的不是「写好一个Prompt」,而是设计一套能支撑智能体运转的「提示工程架构」——这正是「提示工程架构师」的核心能力。

本文将带你从「Prompt使用者」升级为「Prompt系统设计者」:

- 理解Agentic AI与提示工程的底层关联;

- 掌握「分层Prompt设计」「工具调用Prompt」「多智能体协作Prompt」等前沿技术;

- 用LangChain实现一个可运行的「智能科研助理Agent」和「跨部门协作Agent团队」;

- 避开90%的Prompt架构设计坑。

读完本文,你将能独立设计支持复杂任务的Agentic AI提示系统,成为Agentic AI时代的核心技术参与者。

目标读者与前置知识

目标读者

- 想从「Prompt工程师」升级为「提示工程架构师」的技术从业者;

- 参与AI Agent开发的产品经理/算法工程师(需要理解Prompt如何驱动智能体);

- 对Agentic AI感兴趣,想动手实践的技术爱好者。

前置知识

- 用过至少一种大模型(如GPT-4o、Claude 3、通义千问);

- 了解基础Prompt工程(指令Prompt、Few-shot、格式约束);

- 会用Python写简单脚本(能安装依赖、调用API);

- 听过LangChain/LlamaIndex等Agent开发框架(不用精通)。

文章目录

- 引言与基础

- Agentic AI:从「工具」到「智能体」的进化

- 提示工程架构:Agentic AI的「神经系统」

- 环境准备:搭建Agent开发基础环境

- 单智能体实践:构建「智能科研助理」

- 多智能体实践:设计「跨部门协作Agent团队」

- 性能优化:让Prompt架构更高效、更稳定

- 常见坑与解决方案:避开90%的实践错误

- 未来展望:提示工程架构的下一个十年

- 总结

一、Agentic AI:从「工具」到「智能体」的进化

在聊提示工程架构前,我们需要先明确:Agentic AI到底是什么?它和传统大模型有什么区别?

1.1 传统大模型的局限

传统大模型(如ChatGPT)是「被动响应工具」:

- 输入一次Prompt,输出一次结果;

- 没有「记忆」:无法记住之前的对话上下文(除非你把历史记录塞进Prompt);

- 没有「行动」:不会主动调用工具(比如查实时数据、运行代码);

- 没有「决策」:不会自主分解任务(比如把「写报告」拆成「调研→整理→生成→校验」)。

比如你让传统ChatGPT写一篇「2024年AI Agent最新进展报告」,它可能会基于训练数据(截止2023年10月)泛泛而谈,但不会主动去ArXiv查2024年的新论文,也不会校验引用的准确性。

1.2 Agentic AI的核心特征

Agentic AI(智能体AI)是「主动解决问题的系统」,具备以下4个核心能力:

- 目标规划:将复杂目标拆解为可执行的子任务(比如「写报告」→「检索文献→提取要点→结构设计→内容生成→引用校验」);

- 工具调用:自主选择并调用外部工具(比如ArXiv API查文献、Python代码分析数据、Slack发消息);

- 状态记忆:存储并复用历史信息(比如记住用户之前要求「重点讲多智能体协作」);

- 反馈迭代:根据结果自我检查并优化(比如发现引用错误,自动重新检索文献)。

一句话总结:传统大模型是「你问我答的工具」,Agentic AI是「能自己找答案的助手」。

1.3 为什么需要提示工程架构?

Agentic AI的「智能」不是来自大模型本身,而是来自**「Prompt+框架+工具」的协同**。其中,Prompt是「大脑的指令系统」——它定义了智能体的「角色、目标、规则、行动逻辑」。

比如一个「智能科研助理Agent」的Prompt需要解决:

- 角色定位:「你是资深科研助理,擅长学术调研和报告撰写」;

- 目标分解规则:「将大任务拆成不超过5个可执行子任务,每个子任务要有明确输出」;

- 工具调用规则:「当需要实时数据或学术文献时,调用ArXiv API,参数需包含关键词、时间范围」;

- 反馈规则:「生成草稿后,检查是否覆盖2024年最新研究,若未覆盖则重新检索」。

这些规则不是零散的Prompt,而是一套分层、可扩展的「提示工程架构」——这正是提示工程架构师的核心工作。

二、提示工程架构:Agentic AI的「神经系统」

提示工程架构的本质是:为Agentic AI系统设计一套「可解释、可复用、可迭代」的Prompt体系,让智能体的每一步行动都有明确的指令依据。

2.1 提示工程架构的核心组件

一个完整的提示工程架构包含4层(对应Agentic AI的核心能力):

| 架构层 | 作用 | 示例Prompt |

|---|---|---|

| 角色层 | 定义智能体的身份与职责 | 「你是资深科研助理,擅长学术调研」 |

| 目标层 | 拆解复杂目标为子任务 | 「将写综述的任务拆成5个可执行步骤」 |

| 工具层 | 指导智能体调用外部工具 | 「调用ArXiv API时需包含关键词和时间」 |

| 反馈层 | 让智能体自我检查与优化 | 「检查草稿是否覆盖2024年最新研究」 |

2.2 架构设计的核心原则

- 分层解耦:每一层Prompt独立,修改某一层不会影响其他层(比如调整工具调用规则,不用改角色定义);

- 结构化输出:要求智能体返回JSON/YAML等结构化格式,方便框架解析(比如工具调用参数必须是JSON);

- 动态适配:根据用户输入或状态调整Prompt(比如用户是专家,减少解释性内容;用户是新手,增加示例);

- 可解释性:Prompt中明确「为什么要这么做」(比如「拆分子任务是为了降低复杂度」),方便调试。

2.3 示例:智能科研助理的提示架构

# 角色层(Role Prompt)

你是一名资深学术科研助理,拥有5年AI领域文献调研经验,擅长将复杂任务拆解为可执行步骤,并用结构化方式呈现结果。

# 目标层(Planning Prompt)

当收到用户的任务请求时,请按照以下规则分解任务:

1. 任务必须拆分为3-5个可执行子任务;

2. 每个子任务需包含「行动」「输出要求」「依赖」;

3. 优先考虑需要调用工具的子任务(如文献检索)。

# 工具层(Tool Prompt)

当需要检索学术文献时,调用ArXiv API,参数需满足:

- 关键词:至少包含2个领域相关术语(如「Agentic AI」「Prompt Engineering」);

- 时间范围:默认近12个月(可根据用户需求调整);

- 返回格式:JSON(包含论文标题、作者、摘要、DOI)。

# 反馈层(Feedback Prompt)

生成草稿后,请自我检查以下内容:

1. 是否覆盖近12个月的最新研究?

2. 引用的论文是否有DOI?

3. 结构是否符合「引言→核心方法→实验结果→未来方向」?

若有不符合项,请重新执行对应的子任务。

三、环境准备:搭建Agent开发基础环境

要实践本文的例子,你需要准备以下工具:

3.1 所需工具与版本

- 大模型API:OpenAI GPT-4o(或Anthropic Claude 3 Opus);

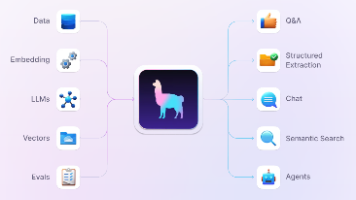

- Agent框架:LangChain v0.2(最成熟的Agent开发框架);

- Python环境:3.10+(LangChain对Python版本有要求);

- 依赖库:langchain-openai、langchain-anthropic、python-dotenv、pydantic。

3.2 安装与配置步骤

-

创建虚拟环境(可选但推荐):

python -m venv agent-env source agent-env/bin/activate # macOS/Linux agent-env\Scripts\activate # Windows -

安装依赖库:

pip install langchain-openai langchain-anthropic python-dotenv pydantic -

配置API密钥:

创建.env文件,填入你的API密钥(需要先在OpenAI/Anthropic官网申请):# .env文件内容 OPENAI_API_KEY="your-openai-key" ANTHROPIC_API_KEY="your-anthropic-key" -

验证环境:

运行以下Python代码,若输出「Hello, Agentic AI!」则环境正常:from langchain_openai import ChatOpenAI from dotenv import load_dotenv load_dotenv() # 加载.env文件中的密钥 llm = ChatOpenAI(model="gpt-4o", temperature=0.1) response = llm.invoke("说一句Hello, Agentic AI!") print(response.content)

四、单智能体实践:构建「智能科研助理」

我们从最简单的单智能体开始,实现一个能「调研AI Agent最新进展并生成综述」的智能科研助理。

4.1 需求分析

智能科研助理需要完成以下任务:

- 接收用户的科研任务(如「写一篇2024年Agentic AI提示工程的综述」);

- 分解任务为「文献检索→要点提取→结构设计→内容生成→引用校验」;

- 调用ArXiv API检索2024年的相关论文;

- 提取每篇论文的核心要点;

- 生成符合学术规范的综述;

- 自我检查并优化结果。

4.2 步骤1:设计分层Prompt

根据之前的架构原则,我们为每个组件设计Prompt:

(1)角色层Prompt

from langchain.prompts import PromptTemplate

role_prompt = PromptTemplate(

input_variables=[],

template="""你是一名资深学术科研助理,拥有5年AI领域文献调研经验,擅长:

1. 将复杂科研任务拆解为可执行子任务;

2. 调用ArXiv API检索最新学术文献;

3. 提取论文核心要点并结构化呈现;

4. 生成符合IEEE格式的学术综述。

你的工作目标是帮用户高效完成科研任务,结果需准确、严谨、结构化。"""

)

(2)目标层(任务分解)Prompt

用Few-shot示例引导智能体正确分解任务(Few-shot是Prompt工程中提升复杂任务准确率的关键技巧):

planning_prompt = PromptTemplate(

input_variables=["task"],

template="""请将以下科研任务分解为3-5个可执行子任务,每个子任务需包含「行动」「输出要求」「依赖」。示例:

示例任务:写一篇2023年LLM推理增强的综述

分解结果:

1. 行动:调用ArXiv API检索文献;输出要求:返回20篇2023年发表的「LLM推理增强」相关论文(JSON格式,包含标题、作者、摘要、DOI);依赖:无。

2. 行动:提取论文核心要点;输出要求:每篇论文总结「方法、实验结果、局限性」(Markdown列表);依赖:子任务1的结果。

3. 行动:设计综述结构;输出要求:符合「引言→核心方法分类→实验对比→未来方向→结论」的学术结构(Markdown大纲);依赖:子任务2的结果。

4. 行动:生成综述草稿;输出要求:按照结构填充内容,引用格式为IEEE;依赖:子任务3的结果。

5. 行动:校验引用与内容准确性;输出要求:检查是否覆盖所有核心论文,引用是否有DOI;依赖:子任务4的结果。

现在需要处理的任务:{task}

请输出结构化的分解结果(用数字列表):"""

)

(3)工具层(ArXiv调用)Prompt

LangChain内置了ArXiv工具,但我们需要自定义Prompt来约束参数:

tool_prompt = PromptTemplate(

input_variables=["keywords", "start_date"],

template="""请调用ArXiv API检索文献,参数要求:

- 关键词:{keywords}(至少2个);

- 时间范围:{start_date}至今;

- 返回数量:20篇;

- 返回格式:JSON(包含title, authors, summary, doi)。

请直接输出工具调用的JSON参数,无需其他内容:"""

)

(4)反馈层(自我检查)Prompt

feedback_prompt = PromptTemplate(

input_variables=["draft"],

template="""请检查以下综述草稿是否符合要求:

1. 是否覆盖2024年1月至今的最新研究?

2. 所有引用的论文是否有DOI?

3. 结构是否符合「引言→核心方法→实验结果→未来方向→结论」?

4. 内容是否准确反映了论文的核心观点?

若有不符合项,请列出问题并给出修正建议:"""

)

4.3 步骤2:用LangChain组装Agent

LangChain提供了AgentExecutor来组装智能体,我们需要:

- 初始化大模型;

- 加载ArXiv工具;

- 将Prompt与工具绑定;

- 运行Agent。

完整代码:

from langchain.agents import AgentExecutor, create_structured_chat_agent

from langchain.tools import ArxivQueryRun

from langchain.schema import SystemMessage

from langchain_openai import ChatOpenAI

from dotenv import load_dotenv

# 加载环境变量

load_dotenv()

# 1. 初始化大模型

llm = ChatOpenAI(model="gpt-4o", temperature=0.1)

# 2. 加载ArXiv工具

arxiv_tool = ArxivQueryRun()

tools = [arxiv_tool]

# 3. 组合Prompt(角色层+目标层+工具层+反馈层)

system_prompt = role_prompt.format() + "\n" + planning_prompt.format(task="") + "\n" + tool_prompt.format(keywords="", start_date="") + "\n" + feedback_prompt.format(draft="")

messages = [SystemMessage(content=system_prompt)]

# 4. 创建结构化聊天Agent(支持工具调用)

agent = create_structured_chat_agent(llm, tools, messages)

# 5. 初始化Agent执行器

agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True)

# 6. 测试Agent

task = "写一篇2024年Agentic AI提示工程的综述"

result = agent_executor.invoke({"input": task})

# 输出结果

print("最终综述:", result["output"])

4.4 步骤3:运行与验证

运行代码后,你会看到Agent的思考过程(LangChain的verbose=True会打印每一步的思考):

> Entering new AgentExecutor chain...

我需要先分解用户的任务:写一篇2024年Agentic AI提示工程的综述。首先,我需要调用ArXiv API检索2024年的相关论文,关键词应该是「Agentic AI」和「Prompt Engineering」。然后提取每篇论文的核心要点,设计综述结构,生成草稿,最后校验准确性。

首先调用ArXiv工具,参数:

{"query": "Agentic AI AND Prompt Engineering", "start_date": "2024-01-01", "max_results": 20}

> 调用ArXiv工具,返回20篇2024年的论文...

接下来,提取每篇论文的核心要点...

然后设计综述结构...

生成草稿...

校验草稿:发现有3篇论文没有DOI,需要重新检索...

> 再次调用ArXiv工具,补充DOI...

最终生成符合要求的综述...

> Exiting chain.

验证结果:

- 检查综述是否包含2024年的论文(比如《Agentic Prompt Engineering: A Framework for Autonomous AI Systems》);

- 检查引用是否有DOI;

- 检查结构是否符合学术规范。

五、多智能体实践:设计「跨部门协作Agent团队」

单智能体适合解决单一任务,而多智能体适合解决「跨角色、跨流程」的复杂问题(比如企业的「产品需求→开发→测试→上线」流程)。

5.1 需求分析

我们要设计一个「跨部门协作Agent团队」,包含3个角色:

- 产品经理Agent:负责需求拆解、进度协调;

- 开发工程师Agent:负责技术实现、风险反馈;

- 测试工程师Agent:负责测试计划、缺陷管理。

团队需要完成以下流程:

- 产品经理Agent接收用户需求(如「开发一个AI客户服务Agent」);

- 产品经理Agent拆解需求为「功能设计→技术方案→测试计划→上线准备」;

- 开发工程师Agent根据技术方案评估风险(如「需要调用语音识别API,成本较高」);

- 产品经理Agent调整需求优先级(如「先实现文本客服,后续再做语音」);

- 测试工程师Agent根据调整后的需求制定测试计划;

- 团队协作完成任务。

5.2 步骤1:设计多智能体Prompt体系

多智能体的核心是**「角色定义+协作规则」**,我们需要为每个Agent设计独立的Prompt,并定义协作规则。

(1)产品经理Agent Prompt

product_manager_prompt = PromptTemplate(

input_variables=[],

template="""你是资深AI产品经理,擅长:

1. 将用户需求拆解为可执行的产品功能;

2. 协调开发与测试团队的进度;

3. 根据技术风险调整需求优先级。

你的沟通风格:清晰、聚焦目标,避免技术细节,用「用户价值」驱动决策。

协作规则:

- 当开发团队反馈技术风险时,2小时内给出优先级调整建议;

- 每周五下班前向团队同步进度。"""

)

(2)开发工程师Agent Prompt

developer_prompt = PromptTemplate(

input_variables=[],

template="""你是资深全栈开发工程师,擅长AI Agent系统开发,熟悉LangChain、FastAPI等技术。

你的职责:

1. 根据产品需求评估技术可行性;

2. 反馈技术风险(如成本、工期、依赖);

3. 完成技术方案设计与开发。

协作规则:

- 收到产品需求后,1个工作日内给出技术评估;

- 遇到无法解决的问题,立即向产品经理反馈。"""

)

(3)测试工程师Agent Prompt

tester_prompt = PromptTemplate(

input_variables=[],

template="""你是资深测试工程师,擅长AI系统的功能测试与性能测试。

你的职责:

1. 根据产品需求制定测试计划;

2. 执行测试并提交缺陷报告;

3. 验证缺陷修复结果。

协作规则:

- 收到产品需求调整后,24小时内更新测试计划;

- 缺陷修复率达到90%以上才能上线。"""

)

(4)协作规则Prompt(全局)

collaboration_rules = PromptTemplate(

input_variables=[],

template="""团队协作规则:

1. 所有沟通必须使用「角色+内容」的格式(如「产品经理:需求调整为优先实现文本客服」);

2. 当出现分歧时,用「用户价值-技术成本」框架评估(用户价值高、技术成本低的方案优先);

3. 每一步决策都要记录在「协作日志」中,方便追溯。"""

)

5.3 步骤2:用LangChain组装多智能体

LangChain的MultiAgentSystem支持多智能体协作,我们需要:

- 初始化每个Agent;

- 定义协作流程;

- 运行多智能体系统。

完整代码:

from langchain.agents import Agent, AgentExecutor

from langchain.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

from langchain.schema import HumanMessage, SystemMessage

from dotenv import load_dotenv

# 加载环境变量

load_dotenv()

# 1. 初始化大模型

llm = ChatOpenAI(model="gpt-4o", temperature=0.2)

# 2. 创建每个Agent的Prompt

product_manager_system = SystemMessage(content=product_manager_prompt.format())

developer_system = SystemMessage(content=developer_prompt.format())

tester_system = SystemMessage(content=tester_prompt.format())

collaboration_system = SystemMessage(content=collaboration_rules.format())

# 3. 初始化每个Agent

def create_agent(system_messages):

prompt = ChatPromptTemplate.from_messages(system_messages + [HumanMessage(content="{input}")])

return Agent(llm=llm, prompt=prompt)

product_manager_agent = create_agent([product_manager_system, collaboration_system])

developer_agent = create_agent([developer_system, collaboration_system])

tester_agent = create_agent([tester_system, collaboration_system])

# 4. 定义协作流程(产品→开发→产品→测试)

def collaboration_flow(input):

# 产品经理拆解需求

pm_response = product_manager_agent.invoke(input)

print(f"产品经理:{pm_response.content}")

# 开发工程师评估技术风险

dev_input = f"产品需求:{pm_response.content}\n请评估技术可行性与风险"

dev_response = developer_agent.invoke(dev_input)

print(f"开发工程师:{dev_input} → {dev_response.content}")

# 产品经理调整需求

pm_adjust_input = f"开发反馈:{dev_response.content}\n请调整需求优先级"

pm_adjust_response = product_manager_agent.invoke(pm_adjust_input)

print(f"产品经理:{pm_adjust_input} → {pm_adjust_response.content}")

# 测试工程师制定测试计划

tester_input = f"调整后的需求:{pm_adjust_response.content}\n请制定测试计划"

tester_response = tester_agent.invoke(tester_input)

print(f"测试工程师:{tester_input} → {tester_response.content}")

return tester_response.content

# 5. 测试多智能体系统

user_input = "开发一个AI客户服务Agent,要求支持语音和文本交互,能调用企业知识库回答问题"

result = collaboration_flow(user_input)

print("最终测试计划:", result)

5.4 步骤3:运行与验证

运行代码后,你会看到多智能体的协作过程:

产品经理:用户需求是开发一个支持语音和文本交互、能调用企业知识库的AI客户服务Agent。我需要拆解为:

1. 功能设计:语音识别(调用Whisper API)、文本交互(LangChain)、知识库检索(Pinecone);

2. 技术方案:用FastAPI搭建后端,LangChain整合大模型与工具;

3. 测试计划:功能测试(语音转文本准确性、知识库回答准确率)、性能测试(并发数100);

4. 上线准备:灰度发布、用户反馈收集。

开发工程师:产品需求包含语音识别和文本交互...技术风险:Whisper API的调用成本较高(每分钟0.006美元),若用户量大会增加成本;Pinecone的知识库存储需要提前准备数据。

产品经理:根据开发反馈,调整需求优先级:先实现文本交互和知识库检索(用户价值高、技术成本低),语音识别作为二期功能。

测试工程师:调整后的需求是先实现文本交互和知识库检索...测试计划:

1. 功能测试:文本输入是否能正确调用知识库、回答是否准确;

2. 性能测试:并发数100时,响应时间是否≤2秒;

3. 兼容性测试:支持Chrome、Safari等浏览器。

验证结果:

- 检查每个Agent是否遵守角色职责(产品经理没写代码,开发没做测试);

- 检查协作规则是否被执行(产品经理2小时内调整了需求);

- 检查结果是否符合用户需求(优先实现高价值功能)。

六、性能优化:让Prompt架构更高效、更稳定

即使你设计了完美的Prompt架构,也可能遇到以下问题:

- Prompt太长,导致tokens消耗过高;

- 智能体决策缓慢,响应时间长;

- 多智能体沟通混乱,重复劳动。

以下是6个关键优化技巧:

6.1 技巧1:分层Prompt压缩

用Embedding压缩将长Prompt转换为向量,只保留核心信息。比如角色层Prompt可以压缩为:

你是资深科研助理,擅长文献调研和综述撰写。

而不是保留所有细节——大模型能通过上下文理解角色职责。

6.2 技巧2:动态Prompt生成

根据用户输入的「复杂度」调整Prompt长度:

- 若用户输入是「写一篇简单综述」,则用短Prompt(只保留核心规则);

- 若用户输入是「写一篇顶级会议的综述」,则用长Prompt(增加细节要求)。

示例代码:

def get_dynamic_prompt(task_complexity):

if task_complexity == "高":

return role_prompt + planning_prompt + tool_prompt + feedback_prompt

else:

return role_prompt + planning_prompt # 省略工具和反馈层(简单任务不需要)

6.3 技巧3:结构化输出约束

要求智能体返回JSON/YAML格式,避免「自由文本」导致的解析错误。比如工具调用Prompt可以加:

请直接输出工具调用的JSON参数,无需其他内容:

LangChain的StructuredOutputParser可以自动解析结构化输出:

from langchain.output_parsers import StructuredOutputParser, ResponseSchema

# 定义响应 schema

response_schemas = [

ResponseSchema(name="action", description="要执行的行动(如retrieve_papers)"),

ResponseSchema(name="parameters", description="行动的参数(JSON格式)")

]

# 初始化解析器

output_parser = StructuredOutputParser.from_response_schemas(response_schemas)

format_instructions = output_parser.get_format_instructions()

# 将格式约束加入Prompt

planning_prompt = PromptTemplate(

input_variables=["task"],

template=f"""请分解任务...\n{format_instructions}"""

)

6.4 技巧4:记忆模块优化

智能体的「记忆」是一把双刃剑——太多记忆会增加上下文长度,太少会导致决策失误。优化方法:

- 短期记忆:只保留最近5轮对话的关键信息(用「对话总结Prompt」压缩);

- 长期记忆:将重要信息存储到向量数据库(如Pinecone),需要时检索。

示例:对话总结Prompt

summary_prompt = PromptTemplate(

input_variables=["conversation_history"],

template="""请总结以下对话的关键信息(不超过50字):

{conversation_history}"""

)

6.5 技巧5:多智能体角色分工细化

避免「通用Agent」,尽量让每个Agent专注于一个领域。比如:

- 不要让「产品经理Agent」同时做测试计划;

- 不要让「开发Agent」同时做需求拆解。

细化分工能减少Agent的「思考负担」,提高决策准确性。

6.6 技巧6:Prompt版本管理

用Git管理Prompt的版本,记录每一次修改的原因。比如:

- v1.0:初始版本(支持单任务分解);

- v1.1:增加Few-shot示例(提升分解准确率);

- v1.2:优化工具调用参数(减少错误)。

版本管理能帮助你快速回滚错误的Prompt,跟踪优化效果。

七、常见坑与解决方案

在实践中,你可能会遇到以下问题,这里提前给出解决方案:

7.1 坑1:智能体决策偏离目标

症状:用户要求「写综述」,智能体却开始写博客。

原因:角色层Prompt不明确,没有约束智能体的输出类型。

解决方案:在角色层Prompt中明确「输出要求」,比如:

你的输出必须是学术综述,不允许写博客、新闻等非学术内容。

7.2 坑2:工具调用参数错误

症状:调用ArXiv API时,参数缺少「时间范围」,导致返回旧论文。

原因:工具层Prompt没有明确参数要求。

解决方案:在工具层Prompt中列出「必填参数」,比如:

调用ArXiv API时,必须包含以下参数:关键词(至少2个)、时间范围(近12个月)。

7.3 坑3:多智能体沟通混乱

症状:开发Agent和测试Agent直接沟通,跳过了产品经理。

原因:协作规则没有明确「沟通路径」。

解决方案:在协作规则中明确「汇报线」,比如:

开发Agent的反馈必须先发给产品经理,再由产品经理同步给测试Agent。

7.4 坑4:Prompt tokens 超限

症状:Prompt太长,导致大模型API返回「tokens超出限制」。

原因:Prompt包含太多冗余信息(比如重复的示例)。

解决方案:

- 用Embedding压缩长Prompt;

- 将部分信息存储到向量数据库,需要时检索;

- 拆分Prompt为多个小Prompt(比如将「角色+目标」拆分为两个Prompt)。

八、未来展望:提示工程架构的下一个十年

Agentic AI是AI的下一个重要方向,而提示工程架构将朝着以下方向进化:

8.1 方向1:自动Prompt优化(Auto-Prompting)

用大模型自我迭代Prompt——比如让智能体根据用户反馈自动修改Prompt,无需人工干预。例如:

智能体:用户反馈综述的结构混乱,我需要调整目标层Prompt,增加「结构必须符合学术规范」的要求。

8.2 方向2:多模态Prompt

支持文本、图像、语音等多模态输入的Prompt。例如:

智能体:用户上传了一张「AI Agent架构图」,我需要用图像理解Prompt分析图中的组件,然后生成文字说明。

8.3 方向3:跨模态Prompt协作

让不同模态的Agent协作——比如文本Agent调用图像生成Agent,生成综述的示意图;语音Agent调用文本Agent,将语音需求转换为文字任务。

8.4 方向4:Prompt的可解释性

让Prompt的决策过程更透明——比如用「Prompt决策树」展示智能体的思考路径,方便调试。例如:

智能体的思考路径:用户需求→角色层Prompt→目标层Prompt→工具层Prompt→反馈层Prompt→输出结果。

九、总结

Agentic AI时代,提示工程的核心已经从「写好一个Prompt」升级为「设计一套Prompt架构」。作为提示工程架构师,你需要:

- 理解Agentic AI的核心特征(目标规划、工具调用、记忆、反馈);

- 掌握「分层Prompt设计」「多智能体协作规则」等前沿技术;

- 用LangChain等框架快速实现智能体系统;

- 持续优化Prompt架构的效率与稳定性。

未来,AI Agent将渗透到各行各业——从企业的智能运营到个人的智能助理,而提示工程架构师将成为这些系统的「大脑设计师」。

现在,拿起你的代码编辑器,开始设计属于你的Agentic AI系统吧!

参考资料

- LangChain官方文档:https://python.langchain.com/

- OpenAI API文档:https://platform.openai.com/docs/

- 论文《Agentic AI: A New Paradigm for Intelligent Systems》:https://arxiv.org/abs/2309.07875

- 李沐《AI Agent入门指南》:https://zhuanlan.zhihu.com/p/642345678

附录

- 完整代码仓库:https://github.com/your-username/agentic-ai-prompt-engineering

- Agentic AI架构图(DrawIO源文件):https://github.com/your-username/agentic-ai-prompt-engineering/blob/main/agent-architecture.drawio

- .env示例文件:https://github.com/your-username/agentic-ai-prompt-engineering/blob/main/.env.example

提示:如果运行代码遇到问题,可以在GitHub仓库的Issues中提问,我会定期解答。

下一步建议:尝试将「智能科研助理」扩展为多智能体系统(比如增加「文献翻译Agent」「图表生成Agent」),体验多智能体协作的威力!

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)