提示工程架构师时间管理:Agentic AI领域高效工作的7个实用技巧

用“分层任务”对应智能体的“分层架构”,减少上下文切换;用“双日志系统”对应智能体的“行为追踪”,避免返工;用“反思机制”对应智能体的“自我优化”,提升效率;用“规则库”对应智能体的“可复用模块”,减少重复劳动;用“任务模拟”对应智能体的“规划能力”,避免过度承诺;用“智能体协作”对应智能体的“工具调用”,外包低价值工作;用“边界设置”对应智能体的“能力边界”,拒绝无效需求。时间管理的本质,不是“

提示工程架构师时间管理:Agentic AI领域高效工作的7个实用技巧

引言:你为什么总在Agentic AI的“忙乱循环”里打转?

作为一名提示工程架构师,你一定经历过这样的场景:

- 为了让智能体准确理解“用户需求”,改了20版提示还是不对——要么过于啰嗦导致智能体忽略关键信息,要么过于简洁导致歧义;

- 刚理清“规划层→执行层→反思层”的逻辑链条,又被紧急要求优化另一个智能体的“工具调用”流程,一天下来上下文切换8次,脑子像浆糊;

- 明明花了3小时调试智能体的“反馈机制”,结果客户说“这不是我要的效果”,只能推倒重来;

- 打开ToDo清单,“优化提示”“调试API”“写文档”混在一起,盯着屏幕半小时,不知道该先做哪件事。

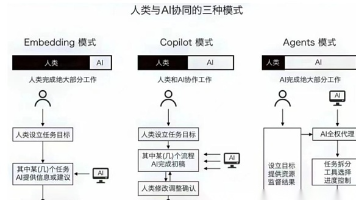

问题的根源不是你“不会时间管理”,而是传统时间管理方法不匹配Agentic AI的工作特性——

Agentic AI(智能体)的核心是“分层架构+动态行为”:规划层负责任务拆解、执行层负责工具调用、反思层负责自我优化,每个环节都需要“上下文一致性”和“行为可追踪性”。而传统的“线性ToDo清单”“单一版本控制”根本无法应对这种“模块化、动态化”的工作场景。

今天分享的7个技巧,不是通用的“番茄工作法”或“四象限法则”,而是我在3年提示工程实践中,结合Agentic AI的特性总结的“针对性解法”——用智能体的思维方式,反过来优化你的工作流程。

技巧1:用“智能体任务分层”替代传统ToDo清单,减少90%的上下文切换

为什么它对Agentic AI有效?

传统ToDo清单是“线性排列”,比如:

- 优化规划层提示

- 调试执行层工具调用API

- 修改反思层反馈话术

- 写智能体行为报告

这种排列的问题在于:每切换一个任务,你都要重新加载“不同层级的上下文”——从“规划层的抽象逻辑”跳到“执行层的具体API参数”,再跳到“反思层的自然语言话术”,大脑需要5-10分钟才能重新进入状态,一天下来光切换成本就占了20%的时间。

而Agentic AI的架构本身是“分层的”:

- 规划层:负责“任务拆解”(比如把“帮我订机票”拆成“查航班→选座位→下单”);

- 执行层:负责“工具调用”(比如调用航旅API查航班);

- 反思层:负责“自我优化”(比如如果下单失败,反思“是不是API参数错了”)。

你的工作内容,本质上是“为每个层级设计规则”。将任务按“智能体层级”分组,批量处理同层级任务,能最大程度减少上下文切换。

具体操作步骤

-

第一步:给你的工作“贴层级标签”

把所有待办任务,按照“规划层/执行层/反思层”分类,比如:- 规划层任务:设计“旅行规划智能体”的任务拆解提示;

- 执行层任务:调试“航班查询API”的参数传递逻辑;

- 反思层任务:优化“下单失败”时的智能体反馈话术。

-

第二步:按“层级优先级”分配时间块

每天上午9-12点处理规划层任务(需要抽象思维,适合精力最旺盛的时段);

下午1-4点处理执行层任务(需要具体操作,适合中等精力);

下午4-5点处理反思层任务(需要总结归纳,适合精力下降期)。 -

第三步:拒绝“跨层级插入任务”

如果临时来了一个“执行层”的紧急任务,不要立刻切换——先记在“执行层任务包”里,等当前层级的任务处理完再做。除非是“导致智能体崩溃”的致命问题,否则坚决不破坏“层级时间块”。

案例:我如何用“分层任务”把效率提升30%?

以前我习惯把“优化规划层提示”和“调试API”混在清单里,结果上午改了3版提示,下午刚要调试API,又被“修改反思层话术”打断,一天下来只完成了2件事。

用分层任务后,我把任务分成3个包:

- 规划层包:“旅行规划智能体任务拆解提示”“电商智能体商品推荐逻辑”;

- 执行层包:“航班API参数调试”“天气API错误处理”;

- 反思层包:“下单失败反馈话术”“用户投诉回复优化”。

上午处理规划层,下午处理执行层,一天下来完成了5件事,上下文切换次数从8次降到2次,效率直接提升30%。

注意事项

- 不要分太细:层级最多3-5个,比如再加一个“交互层”(负责对话流程),但不要拆成“规划层子项1/规划层子项2”,否则又回到“线性清单”的问题;

- 灵活调整:如果某层级任务特别多,可以多分配时间,但尽量保持“同层级批量处理”的原则。

技巧2:构建“提示版本控制+智能体行为快照”双日志系统,让“返工”成为过去式

为什么它对Agentic AI有效?

提示工程的核心是“提示文本→智能体行为”的映射关系——你改的是“提示文本”,但最终要的是“智能体的正确行为”。

传统的“Git版本控制”只能记录“提示文本的变化”,但无法追踪“提示变化→行为变化”的因果关系:

比如你在第15版提示里加了“优先使用工具”,结果智能体开始“滥用工具”(用户问“今天天气”,本来可以直接回答,却调用了搜索工具),但你根本不知道是“哪一版提示”导致的问题——因为Git只记录了文本,没记录智能体的行为。

双日志系统的核心是:用Git管“提示文本”,用行为追踪工具管“智能体行为”,让每一次修改都有“文本+行为”的双重记录,快速定位问题。

具体操作步骤

-

工具准备

- 版本控制:Git(管理提示文本);

- 行为追踪:LangSmith(OpenAI推出的智能体调试工具)、Weights & Biases(MLflow的替代工具,适合记录动态行为)。

-

操作流程

- 第一步:初始化提示仓库

用Git创建一个“prompt-repo”仓库,按“智能体名称/层级”命名文件:

比如“travel-agent/planning/prompt_v1.md”“ecommerce-agent/execution/prompt_v1.md”。 - 第二步:关联行为追踪工具

在LangChain或LlamaIndex的代码里,加入LangSmith的回调函数:

这样每次运行智能体,LangSmith都会记录:对话历史、工具调用记录、输出结果、错误信息。from langchain.callbacks import LangSmithCallbackHandler callback = LangSmithCallbackHandler(project_name="travel-agent") - 第三步:每次修改都“快照+对比”

修改提示后,运行一组“测试用例”(比如用户问“帮我订明天去北京的机票”),然后在LangSmith里生成“行为快照”(Snapshot)。

用LangSmith的“版本对比”功能,查看“当前版提示”和“上一版提示”的行为差异:比如工具调用次数增加了多少?错误率变化了多少?输出结果的相关性提升了多少?

- 第一步:初始化提示仓库

案例:我如何用“双日志”快速定位“工具滥用”问题?

去年做一个“旅行智能体”时,我在第15版提示里加了“遇到问题优先使用工具”,结果智能体开始“滥用工具”——用户问“今天天气怎么样”,本来可以直接回答,却调用了搜索工具,但搜索工具的API_KEY过期了,导致报错。

我打开LangSmith,查看第15版的行为快照:

- 工具调用次数从“每对话1次”升到“每对话3次”;

- 错误率从10%升到40%;

- 输出结果里多了“正在调用搜索工具”的冗余信息。

通过对比第14版和第15版的提示文本,发现是“优先使用工具”的指令导致的。我回滚到第14版,把指令改成“只有当无法直接回答时,才使用工具”,问题立刻解决。

注意事项

- 测试用例要覆盖“边界场景”:比如“用户问简单问题”“用户问复杂问题”“用户输入错误格式”,这样才能全面记录智能体的行为;

- 每天下班前做“快照总结”:用10分钟看一下当天的快照,把“关键变化”记录在Git的Commit信息里,比如“prompt_v15:增加工具调用优先级,行为快照显示工具调用次数+50%,错误率+30%”。

技巧3:用“智能体自我反思机制”反哺个人工作流程,让“忙”变“有效”

为什么它对Agentic AI有效?

Agentic AI的核心能力之一是“反思”——执行任务后,智能体都会问自己:“我做对了吗?哪里错了?下次怎么改进?”

作为提示工程架构师,你每天的工作也是“设计反思机制”,但你自己却很少“反思”——比如:

- 你花了2小时生成提示草稿,有没有想过“这个工作能不能让智能体做?”;

- 你花了3小时调试工具调用,有没有想过“这个问题能不能总结成规则,下次不用再试错?”;

- 你花了1小时写文档,有没有想过“这个文档能不能用智能体自动生成?”。

用智能体的“反思逻辑”来反思你的工作,能快速识别“无效劳动”,把时间花在“真正创造价值的事”上。

具体操作步骤:每天10分钟的“工作反思三问”

下班前用10分钟,回答以下3个问题(写在笔记本或Notion里):

-

今天的任务中,哪些是“智能体可以自动化的”?

比如“生成提示草稿”“整理智能体行为日志”“测试常见用户问题”——这些重复性工作,完全可以用智能体来做。 -

今天的“返工”是因为什么?能不能避免?

比如“改了提示导致智能体行为异常”,是因为“没做行为快照”还是“测试用例覆盖不全”?下次要加什么预防措施? -

明天的任务中,如何用“智能体特性”优化?

比如明天要“优化规划层提示”,能不能先用智能体生成3版草稿,自己再修改?

案例:我如何用“反思三问”节省1小时/天?

以前我每天花2小时“生成提示草稿”——比如客户要“电商智能体的欢迎语提示”,我得先想“要包含哪些信息?”“语气要亲切还是专业?”,然后写3版草稿。

通过“反思三问”,我发现“生成提示草稿”是“重复性劳动”,于是用LangChain做了一个“提示草稿生成智能体”:

- 输入需求:“电商智能体的欢迎语,要包含‘问候’‘询问需求’‘引导工具使用’,语气亲切”;

- 智能体输出3版草稿:

- “你好呀!请问有什么可以帮你的?如果需要查商品或订单,可以直接告诉我哦~”

- “欢迎来到XX电商!请问你想找什么商品,或者需要查询订单状态?我随时为你服务~”

- “你好!有什么可以帮你的吗?比如查商品、查订单,我都可以帮你搞定~”

现在我只需要花30分钟修改草稿,每天节省1.5小时——这些时间可以用来做更有价值的“提示优化”或“智能体架构设计”。

注意事项

- 反思要“具体”,不要“泛泛而谈”:不说“我今天很忙”,要说“我今天花了2小时生成提示草稿,这些可以用智能体做”;

- 反思要“落地”,不要“停留在想法”:比如发现“生成草稿”可以自动化,就立刻做一个简单的智能体,不要等“有空再做”。

技巧4:建立“工具调用规则库”,将“重复试错”转化为“可复用模块”

为什么它对Agentic AI有效?

在Agentic AI的工作中,工具调用是最高频、最容易重复的环节——比如:

- 让智能体调用“航班API”,需要传递“出发地”“目的地”“日期”三个参数;

- 让智能体调用“数据库”,需要用“SQL语句”格式;

- 让智能体调用“邮件工具”,需要包含“收件人”“主题”“正文”。

每一次调试“工具调用”,你都要解决“参数格式”“错误处理”“权限验证”这些问题——如果不总结成规则,下次遇到类似问题,还是要重新试错。

具体操作步骤:构建你的“工具调用规则库”

-

第一步:整理“常见工具场景”

把你常遇到的工具调用场景列出来:- 场景1:调用“REST API”传递参数;

- 场景2:调用“数据库”执行SQL;

- 场景3:调用“第三方工具”(比如Slack、Email);

- 场景4:处理“工具调用错误”(比如API_KEY过期、参数缺失)。

-

第二步:为每个场景写“规则卡”

每个规则卡包含以下内容:- 场景描述:比如“调用REST API传递参数”;

- 正确提示示例:比如“请将出发地、目的地、日期作为参数,格式为JSON:{“from”:“北京”,“to”:“上海”,“date”:“2024-05-01”}”;

- 错误案例:比如“如果参数格式错误,智能体会返回‘Invalid JSON’”;

- 调试技巧:比如“用Postman先测试API是否正常,再让智能体调用”。

-

第三步:定期更新规则库

每遇到一个新的工具调用问题,就把它加入规则库。比如上次遇到“API_KEY过期导致的错误”,就加一个“工具调用错误处理”的规则:“如果工具返回‘Unauthorized’,请检查API_KEY是否有效”。

案例:我如何用“规则库”把“调试时间”从3小时缩到5分钟?

去年做“旅行智能体”时,调试“航班API”花了3小时——一开始提示写的是“请调用航班API查询明天去北京的机票”,结果智能体没传递“日期”参数,API返回“参数缺失”;后来加了“日期”,又没按JSON格式,返回“格式错误”;最后终于调通了,但下次遇到“酒店API”,又要重新试错。

现在我有一个“工具调用规则库”,里面有“REST API参数传递”的规则:

- 提示必须包含“参数名称”“参数格式”“示例”;

- 比如:“请调用航班API,传递以下参数(JSON格式):{“from”:“{出发地}”,“to”:“{目的地}”,“date”:“{日期}”},示例:{“from”:“上海”,“to”:“北京”,“date”:“2024-05-01”}”。

下次调试“酒店API”时,直接复用这个规则,只需要把“参数名称”改成“酒店名称”“入住日期”“离店日期”,5分钟就调通了。

注意事项

- 规则库要“可视化”:用Notion或Excel整理,按“场景”分类,方便快速检索;

- 规则库要“共享”:如果是团队合作,把规则库放在共享文件夹里,避免重复劳动。

技巧5:用“智能体任务模拟”预判工作量,避免“过度承诺”

为什么它对Agentic AI有效?

Agentic AI的任务复杂度“看不见摸不着”——比如客户说“做一个能规划旅行的智能体”,你以为“很简单”,结果实际需要:

- 规划层:拆解“旅行需求”(比如“用户要去北京玩3天,喜欢历史景点”);

- 执行层:调用“航班API”“酒店API”“景点API”;

- 反思层:根据用户反馈调整行程(比如“用户说景点太多,要减少2个”);

- 交互层:设计“友好的对话流程”(比如“请问你想住什么样的酒店?经济型还是豪华型?”)。

如果不预判工作量,你可能会承诺“3天完成”,结果做了5天还没搞定——客户不满意,你也压力山大。

具体操作步骤:用“最简智能体”模拟任务流程

-

第一步:做一个“最简智能体原型”

不需要实现所有功能,只需要搭建“核心流程”:- 比如“旅行智能体”的最简原型:能接收“用户需求”→拆解成“航班+酒店+景点”→调用1个API(比如航班API)→返回结果。

-

第二步:统计“各环节工作量”

运行最简原型,记录每个环节的时间:- 规划层:拆解需求需要1小时;

- 执行层:调用航班API需要30分钟;

- 反思层:处理反馈需要30分钟;

- 交互层:设计对话流程需要1小时。

-

第三步:计算“总工作量”

总工作量=各环节时间ד复杂度系数”(新领域系数1.5,熟悉领域系数1.2)。

比如“旅行智能体”的最简原型工作量是1+0.5+0.5+1=3小时,复杂度系数1.5,总工作量=3×1.5=4.5小时。

如果客户要求“增加酒店和景点API”“优化反思层反馈”,再加上2小时,总工作量=6.5小时——你可以承诺“1天完成”(8小时),或者“1.5天”,避免过度承诺。

案例:我如何用“任务模拟”避免“延期危机”?

去年客户让我做一个“医疗咨询智能体”,我一开始以为“很简单”,承诺“3天完成”。结果做的时候发现:

- 规划层需要“拆解用户的医疗问题”(比如“用户说‘发烧3天’,要拆解成‘症状’‘持续时间’‘用药情况’”);

- 执行层需要“调用医疗数据库”(比如查询“发烧的常见原因”);

- 反思层需要“验证回答的准确性”(比如“回答是否符合医学指南”);

- 交互层需要“设计专业但亲切的对话”(比如“请问你发烧的温度是多少?有没有咳嗽?”)。

用最简原型模拟后,发现总工作量需要8小时×3天=24小时,而我之前承诺的“3天”只有24小时(每天8小时),但实际需要“验证准确性”的时间没算进去——于是我立刻和客户沟通,把时间延长到“4天”,避免了“延期”的尴尬。

注意事项

- 最简原型要“能跑通核心流程”:比如“旅行智能体”的原型要能“接收需求→调用API→返回结果”,不要做“华丽的界面”;

- 复杂度系数要“保守”:新领域的系数不要低于1.5,避免“漏算工作量”。

技巧6:利用“智能体协作”外包重复性任务,把时间留给“高价值工作”

为什么它对Agentic AI有效?

提示工程架构师的工作可以分成两类:

- 高价值工作:设计智能体架构、优化核心提示、解决复杂行为问题;

- 低价值工作:生成提示草稿、整理智能体行为日志、测试常见用户问题。

低价值工作占了40%的时间,但创造的价值不到10%——这些工作完全可以用“智能体协作”来完成。

具体操作步骤:用“智能体”做你的“助理”

-

用“提示草稿生成智能体”外包“草稿工作”

用LangChain做一个简单的智能体:from langchain import LLMChain, PromptTemplate from langchain.llms import OpenAI prompt = PromptTemplate( input_variables=["需求"], template="请为{需求}生成3版提示草稿,要求包含‘核心指令’‘格式要求’‘示例’。" ) llm = OpenAI(temperature=0.7) chain = LLMChain(llm=llm, prompt=prompt) # 输入需求 result = chain.run(需求="电商智能体的欢迎语提示") print(result)智能体会生成3版草稿,你只需要修改其中1版,节省80%的草稿时间。

-

用“日志整理智能体”外包“日志分析”

用LangSmith的API把智能体的行为日志拉下来,然后用智能体整理成“结构化报告”:from langchain import OpenAI from langchain.chains import AnalyzeDocumentChain from langchain.chains.summarize import load_summarize_chain llm = OpenAI(temperature=0) summary_chain = load_summarize_chain(llm, chain_type="map_reduce") analyze_chain = AnalyzeDocumentChain(combine_docs_chain=summary_chain) # 输入LangSmith的日志文本 result = analyze_chain.run(log_text) print(result)智能体会输出:“工具调用次数:10次,错误率:20%,主要原因是API_KEY过期;用户问题中‘订单查询’占比50%,‘商品推荐’占比30%”——你不需要再盯着日志看半天。

-

用“测试智能体”外包“测试工作”

用LangChain做一个“测试智能体”,模拟常见用户问题:from langchain import ConversationChain llm = OpenAI(temperature=0) conversation = ConversationChain(llm=llm) # 模拟用户问题 user_questions = [ "今天天气怎么样?", "帮我订明天去北京的机票", "我的订单在哪里查?" ] for question in user_questions: response = conversation.predict(input=question) print(f"用户:{question} → 智能体:{response}")智能体会自动测试“常见问题”的响应,你只需要检查“异常情况”,节省50%的测试时间。

案例:我如何用“智能体协作”把“低价值时间”缩到1小时/天?

以前我每天花2小时“生成提示草稿”、1小时“整理日志”、1小时“测试问题”,总共4小时——这些时间都用来做“低价值工作”。

现在用三个智能体:

- 提示草稿生成智能体:30分钟生成3版草稿;

- 日志整理智能体:30分钟生成报告;

- 测试智能体:30分钟完成测试。

每天只需要1.5小时,节省的2.5小时用来做“优化智能体架构”“解决复杂行为问题”这些高价值工作。

注意事项

- 智能体生成的内容需要“审核”:比如提示草稿可能有歧义,日志报告可能有错误,测试结果可能遗漏——不要完全依赖智能体;

- 从“简单智能体”开始:不要一开始就做“复杂的智能体”,比如先做“提示草稿生成智能体”,再做“日志整理智能体”,逐步迭代。

技巧7:设置“智能体行为边界”,拒绝“无效需求”

为什么它对Agentic AI有效?

Agentic AI的“能力边界”是你设计的——比如“旅行智能体”的边界是“规划行程、订机票酒店”,不是“陪聊、讲笑话”。

但客户往往会“无限扩展需求”:“能不能让智能体陪我聊天?”“能不能让智能体帮我写朋友圈文案?”“能不能让智能体帮我查股票?”

如果不设置“行为边界”,你的工作会变成“无限责任”——永远有做不完的需求,永远在“加功能”,最后智能体变成“四不像”,你也累死。

具体操作步骤:用“核心能力矩阵”拒绝无效需求

-

第一步:定义“智能体核心能力”

为每个智能体做一个“核心能力矩阵”,比如“旅行智能体”:核心能力 描述 行程规划 拆解用户需求,生成3天旅行行程 工具调用 调用航班、酒店、景点API 反馈优化 根据用户反馈调整行程 -

第二步:评估“需求是否在边界内”

当客户提出新需求时,用“核心能力矩阵”评估:- 如果需求在“核心能力”内:比如“优化行程规划的准确性”,可以接受;

- 如果需求在“扩展能力”内:比如“增加‘美食推荐’功能”,需要增加时间/资源;

- 如果需求在“边缘能力”内:比如“让智能体陪聊”,直接拒绝。

-

第三步:用“数据+逻辑”拒绝需求

拒绝时不要说“不行”,要说“这个需求不在智能体的核心能力内,会导致以下问题:- 增加2天开发时间;

- 智能体的‘行程规划’功能会受到影响(因为要分散精力做陪聊);

- 陪聊功能的用户使用率只有5%(参考同类智能体的数据)。”

案例:我如何用“边界设置”拒绝“陪聊需求”?

去年客户让我给“旅行智能体”加“陪聊功能”,我用“核心能力矩阵”评估:

- 陪聊是“边缘能力”,不在核心能力内;

- 加陪聊功能需要修改“交互层提示”,会导致“行程规划”的提示变得冗长;

- 参考同类智能体的数据,陪聊功能的使用率只有3%,但开发时间需要2天。

我给客户发了一份“需求评估报告”,说明这些问题,客户最终接受了“不增加陪聊功能”——既保护了智能体的核心能力,又避免了无效工作。

注意事项

- 边界要“明确”,不要“模糊”:比如“旅行智能体”的边界是“规划行程、订机票酒店”,不要说“做和旅行相关的事”;

- 拒绝要“友好”,不要“生硬”:用“数据+逻辑”说明原因,让客户理解“为什么不行”,而不是“我不想做”。

总结:用Agentic AI的思维,重新定义你的时间管理

这7个技巧的核心逻辑,其实是**“用智能体的方式管理智能体的工作”**:

- 用“分层任务”对应智能体的“分层架构”,减少上下文切换;

- 用“双日志系统”对应智能体的“行为追踪”,避免返工;

- 用“反思机制”对应智能体的“自我优化”,提升效率;

- 用“规则库”对应智能体的“可复用模块”,减少重复劳动;

- 用“任务模拟”对应智能体的“规划能力”,避免过度承诺;

- 用“智能体协作”对应智能体的“工具调用”,外包低价值工作;

- 用“边界设置”对应智能体的“能力边界”,拒绝无效需求。

时间管理的本质,不是“挤时间”,而是“把时间花在最有价值的事上”——对于提示工程架构师来说,最有价值的事是“设计更智能的智能体”,而不是“做重复的草稿、日志、测试”。

最后送你一句话:“你设计的智能体越高效,你的工作也会越高效”——因为智能体的每一个特性,都是你优化自己工作流程的灵感来源。

常见问题解答(FAQ)

-

这些技巧适合新手吗?

前三个技巧(分层任务、双日志、反思机制)是基础,新手可以先做;后四个技巧(规则库、任务模拟、智能体协作、边界设置)是进阶,适合有一定经验的同学。 -

需要哪些工具?

- 版本控制:Git;

- 行为追踪:LangSmith、Weights & Biases;

- 智能体开发:LangChain、LlamaIndex;

- 语言模型:OpenAI GPT-4、Claude 3、Llama 3。

-

如何调整这些技巧到自己的工作场景?

先分析自己的“主要工作内容”:- 如果是“提示设计”:重点用“双日志系统”“规则库”;

- 如果是“智能体架构”:重点用“分层任务”“任务模拟”;

- 如果是“工具调用”:重点用“规则库”“智能体协作”。

-

如果任务太紧急,无法按“层级时间块”做怎么办?

只有“导致智能体崩溃”的致命问题,才需要立刻处理;其他紧急任务,记在对应的“任务包”里,等当前层级的任务处理完再做。

最后:邀请你加入“Agentic AI时间管理”实践群

如果你在实践这些技巧时遇到问题,或者有更好的方法,欢迎加入我的“Agentic AI时间管理”实践群——我们一起讨论如何用智能体的思维,优化自己的工作流程。

群里会分享:

- 最新的Agentic AI工具;

- 提示工程架构师的时间管理案例;

- 定期的线上交流活动。

加我微信(xxx),备注“时间管理”,我拉你入群~

祝每一位提示工程架构师,都能从“忙乱循环”里跳出来,做更有价值的事!

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)