告别低效编程!我用RAGflow+MCP半天打造专属AI编程助手

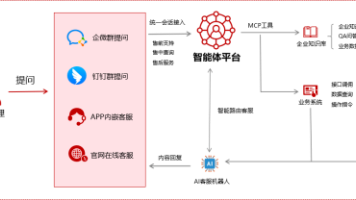

还在为低效编程头疼?AI 编程工具正改变开发节奏。我用 RAGflow搭建了个人专属知识库,通过MCP实现AI编程工具和个人专属知识库链接,半天就打造出专属 AI 编程助手,轻松告别繁琐检索,效率飙升,这就给大家分享秘诀。在本篇文章中,将讨论以下几个问题:• 如何部署RAGflow服务,并开启MCP服务• 开发RAGFlow知识库检索MCP服务• 安装AI编程助手(continue),接入RAGF

还在为低效编程头疼?AI 编程工具正改变开发节奏。我用 RAGflow搭建了个人专属知识库,通过MCP实现AI编程工具和个人专属知识库链接,半天就打造出专属 AI 编程助手,轻松告别繁琐检索,效率飙升,这就给大家分享秘诀。

在本篇文章中,将讨论以下几个问题:

• 如何部署RAGflow服务,并开启MCP服务

• 开发RAGFlow知识库检索MCP服务

• 安装AI编程助手(continue),接入RAGFlow MCP服务

• RAGflow+MCP效果评测

1. 部署RAGflow,开启MCP服务

1.1 前提条件

硬件配置要求

• CPU >= 4 核

• RAM >= 16 GB

• Disk >= 50 GB

软件配置要求

# 安装uvx

pip install uvx

# 查看uvx版本

uvx --versio

# 输出: uvx 0.7.21 (77c771c7f 2025-07-14)

# 安装docker desktop,参考https://docs.docker.com/desktop/,根据系统差异选择

# 查看docker desktop版本

docker --version

# 输出: Docker version 28.1.1, build 4eba377

1.2 部署RAGFlow

启动服务器

# 克隆仓库

git clone https://github.com/infiniflow/ragflow.git

# 进入 docker 文件夹,利用提前编译好的 Docker 镜像启动服务器

cd ragflow/docker

# Use CPU for embedding and DeepDoc tasks:

docker compose -f docker-compose.yml up -d

# To use GPU to accelerate embedding and DeepDoc tasks:

# docker compose -f docker-compose-gpu.yml up -d

# 服务器启动成功后再次确认服务器状态

docker logs -f ragflow-server

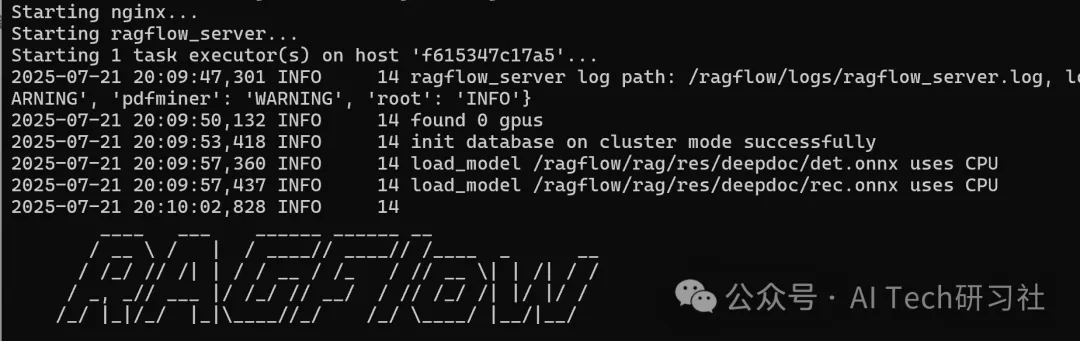

出现以下界面提示说明服务器启动成功:

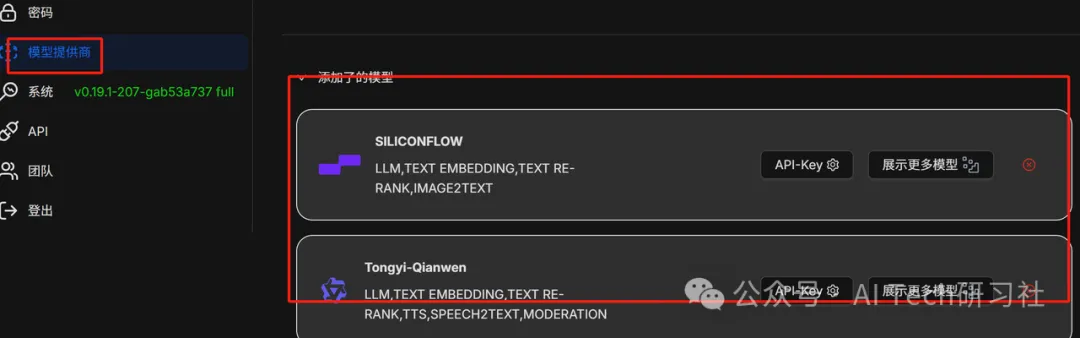

添加模型

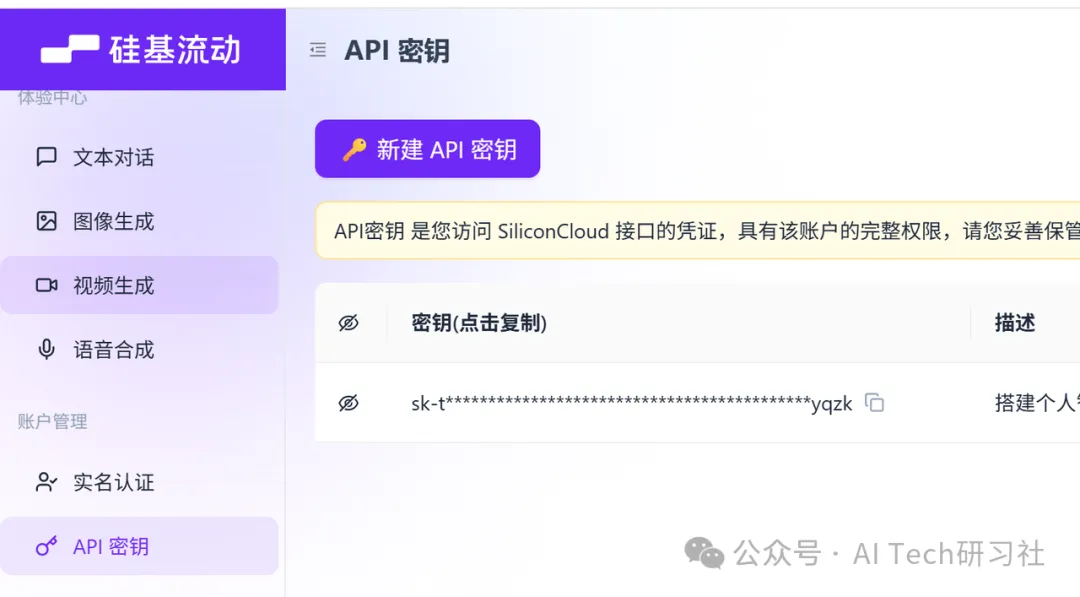

这里选择的是硅基流动平台的模型,可从网址https://cloud.siliconflow.cn注册、获取API Key,也可以从魔塔社区、阿里云百炼等平台获取。

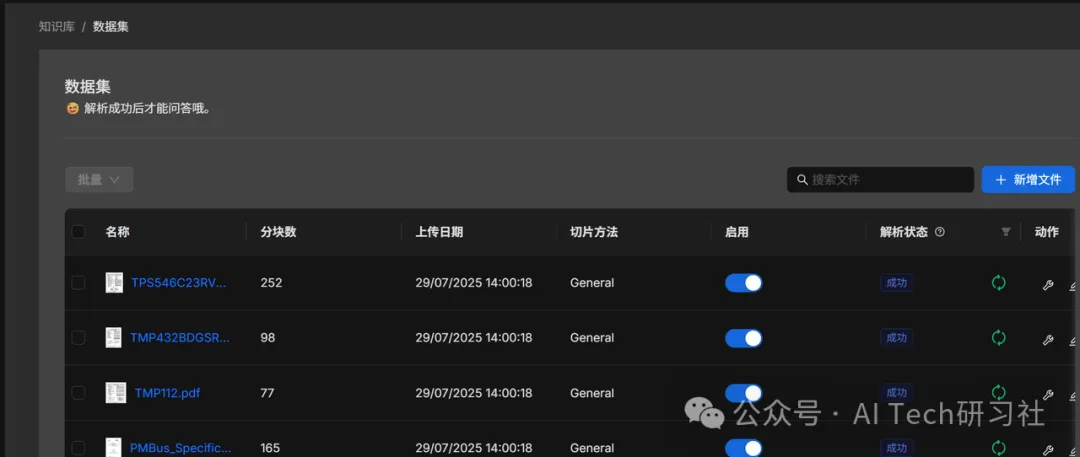

创建知识库

1.3 获取RAGFlow的BASE-URL和API Key

分别点击下图中的步骤1~步骤3, 获取RAGFlow的BASE-URL(对应步骤3中的API服务器)和API Key,为开启MCP Server作准备

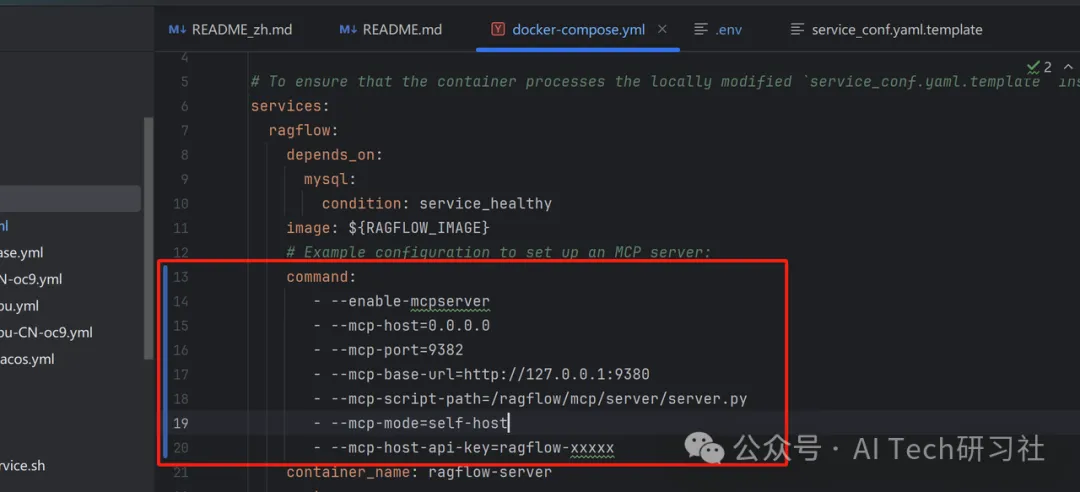

1.4 开启MCP服务

代码默认MCP server是不生效的,需要进行配置。 要启用它,先找到docker/docker-compose.yml文件,取消注释services.ragflow.command部分。其中的- --mcp-host-api-key=ragflow-xxxxx,即前文获取的API Key

# 先关闭已启动的服务

docker compose down

# 重启修改配置后的服务

docker compose -f docker-compose.yml up -d

2. 开发RAGFlow知识库检索MCP服务

2.1 开发RAGFlow知识库检索MCP服务

创建 RAGFlow MCP Server 项目

uvx create-mcp-server --path ragflow-mcp-server-continue --name ragflow-mcp-server-continue --version 0.1.0 --description "RAGFlow MCP Server Continue" --no-claudeapp

cd ragflow-mcp-server-continue

uv sync --dev --all-extras

uv add ragflow-sdk

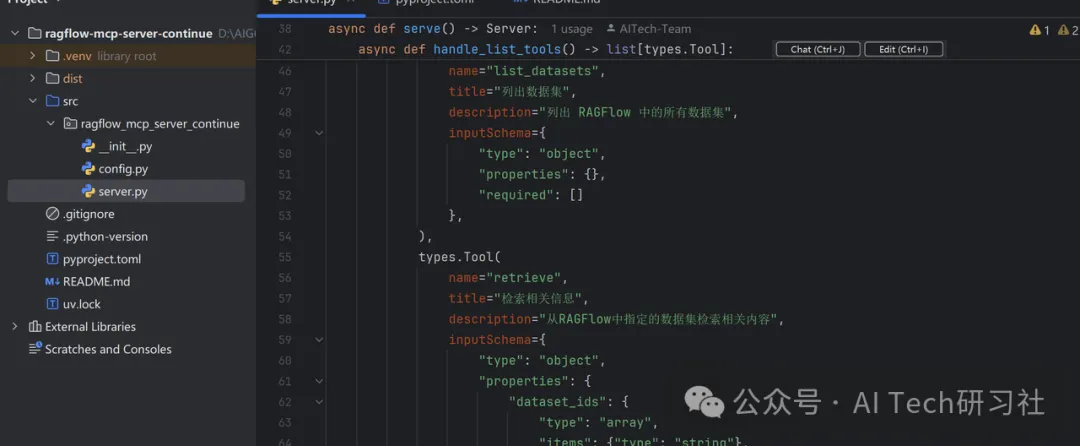

开发的MCP Server功能

- list_datasets

- 列出所有数据集

- 返回数据集的 ID 和名称

- create_chat

- 创建一个新的聊天助手

- 输入:

- name: 聊天助手的名称

- dataset_id: 数据集的 ID

- 返回创建的聊天助手的 ID、名称和会话 ID

- chat

- 与聊天助手进行对话

- 输入:

- session_id: 聊天助手的会话 ID

- question: 提问内容

- 返回聊天助手的回答

- retrieve

- 检索相关信息

- 输入:

- dataset_ids: 数据集的 ID

- question: 提问内容

- 返回从知识库检索到的内容

源码链接:https://github.com/AITech-Team/ragflow-mcp-server-continue

构建 & 发布

同步依赖并更新锁定文件

uv sync

构建软件包分发文件

uv build

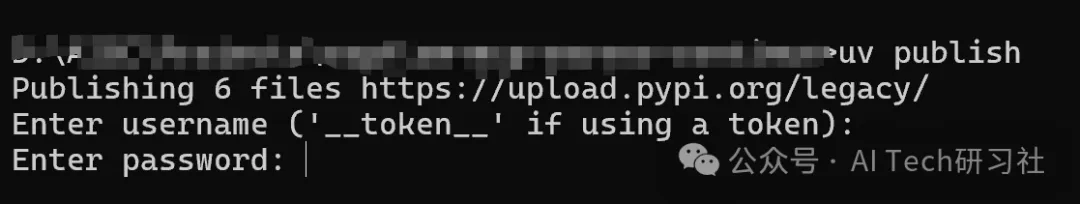

发布软件包到 PyPI

uv publish

发布软件包到PyPI注意事项

• 注册账号 https://pypi.org/

• 添加2FA与身份验证应用程序

import pyotp

key = 'SC5GNDMEV2FPHHLZQW7IZ6UCFXFBNBVI' # 二维下方的一串字符串密钥

totp = pyotp.TOTP(key)

print(totp.now()) # 输出内容输入到下方的验证申请

• 生成API Token,输入对应的用户名和密码

• 软件包发布成功

关于如何上传python包到pypi,推荐阅读

1.pypi 上传python包

2.python项目模块打包本地发布并上传到到PyPI官网(最清楚,最详细)

3. 安装AI编程助手(continue),接入RAGFlow MCP服务

关于AI编程助手的更多介绍,可前往阅读前期文章程序员必备的 14 款 AI 编程助手,有几个你还没用过?

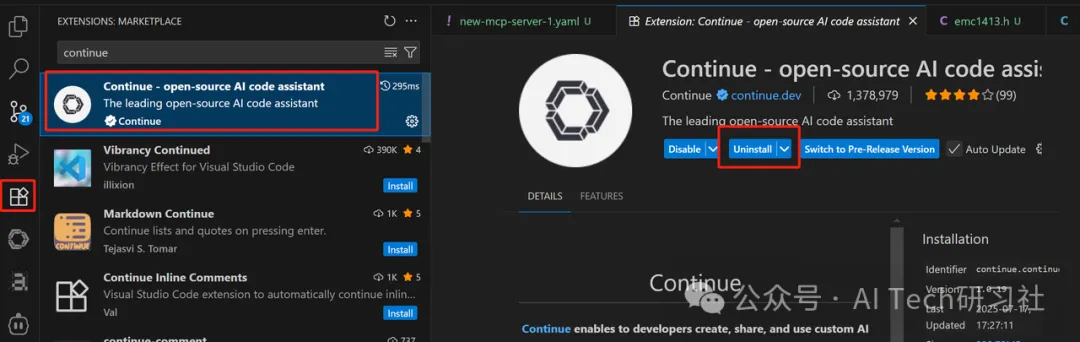

3.1 VS Code安装AI编程助手(continue)

点击VS Code中的Extensions, 在搜索框中输入continue,并点击右侧的install(图中是系统已经安装了,显示为uninstall)。

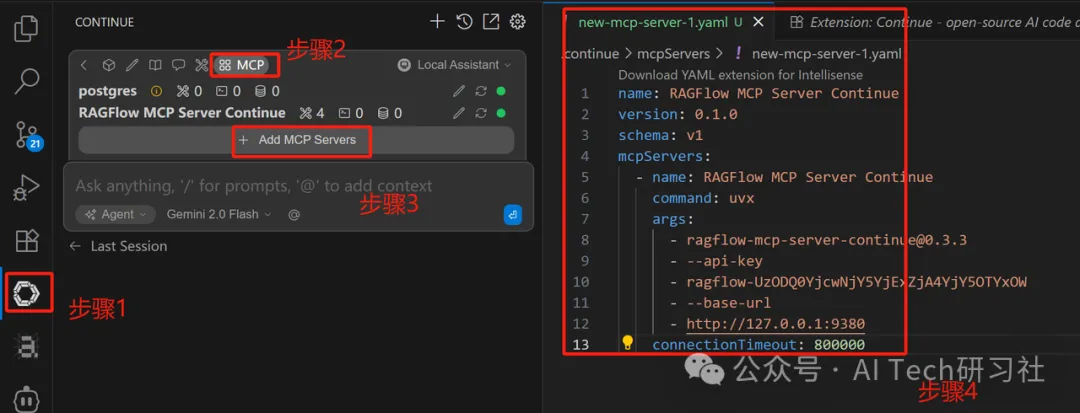

3.2 continue配置MCP server yaml文件

按图中显示的步骤顺序添加RAGFlow MCP服务

配置文件内容如下:

name: RAGFlow MCP Server Continue

version: 0.1.0

schema: v1

mcpServers:

- name: RAGFlow MCP Server Continue

command: uvx

args:

- ragflow-mcp-server-continue@0.3.3 #@0.3.3对应软件包的版本号

- --api-key

- ragflow-UzODQ0YjcwNjY5YjExZjA4YjY5OTYxOW

- --base-url

- http://127.0.0.1:9380

connectionTimeout: 800000 # 避免网路延迟对软件包加载影响

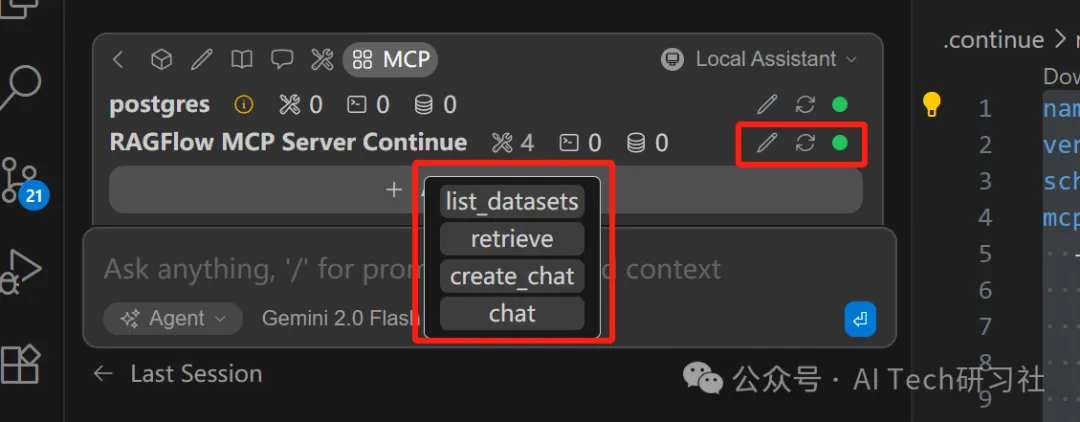

添加完配置后,当看到continue的MCP选项下的MCP服务状态显示为绿色、功能显示与开发的一致,说明MCP Server已经加载成功。

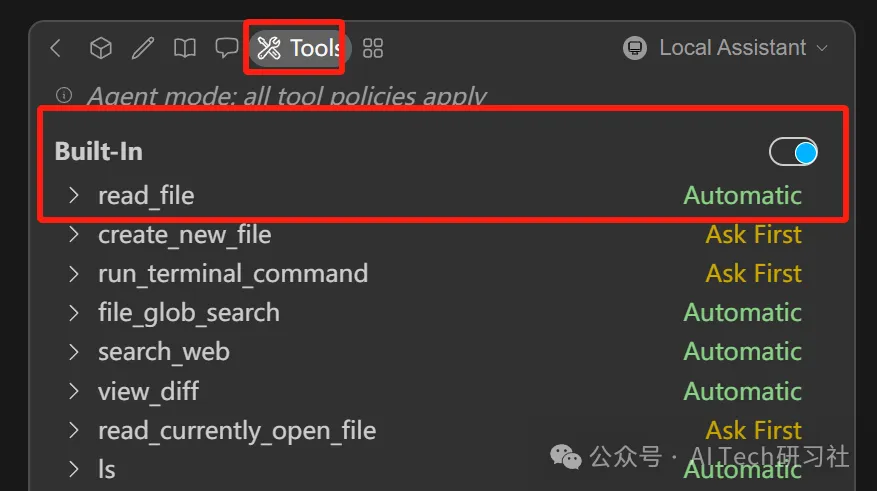

距离成功配置MCP Server还差最后一步了,点击Tools选项,打开Built-In按钮

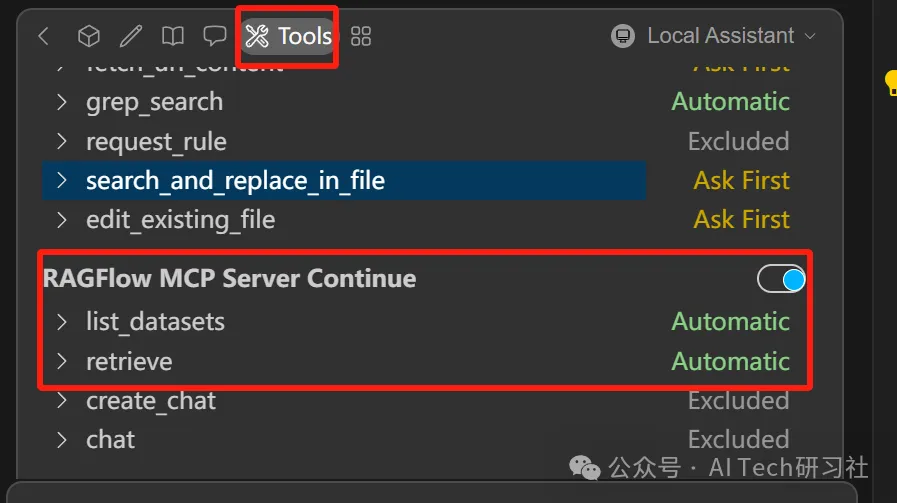

同时,打开提供的MCP服务,根据自身需求选择对应的服务功能

接下来,可以在continue对话窗口愉快的进行知识问题、代码编写啦!注意哦,这里的模型上下文可以直接从刚刚搭建的知识库获取。

4. RAGflow+MCP效果评测

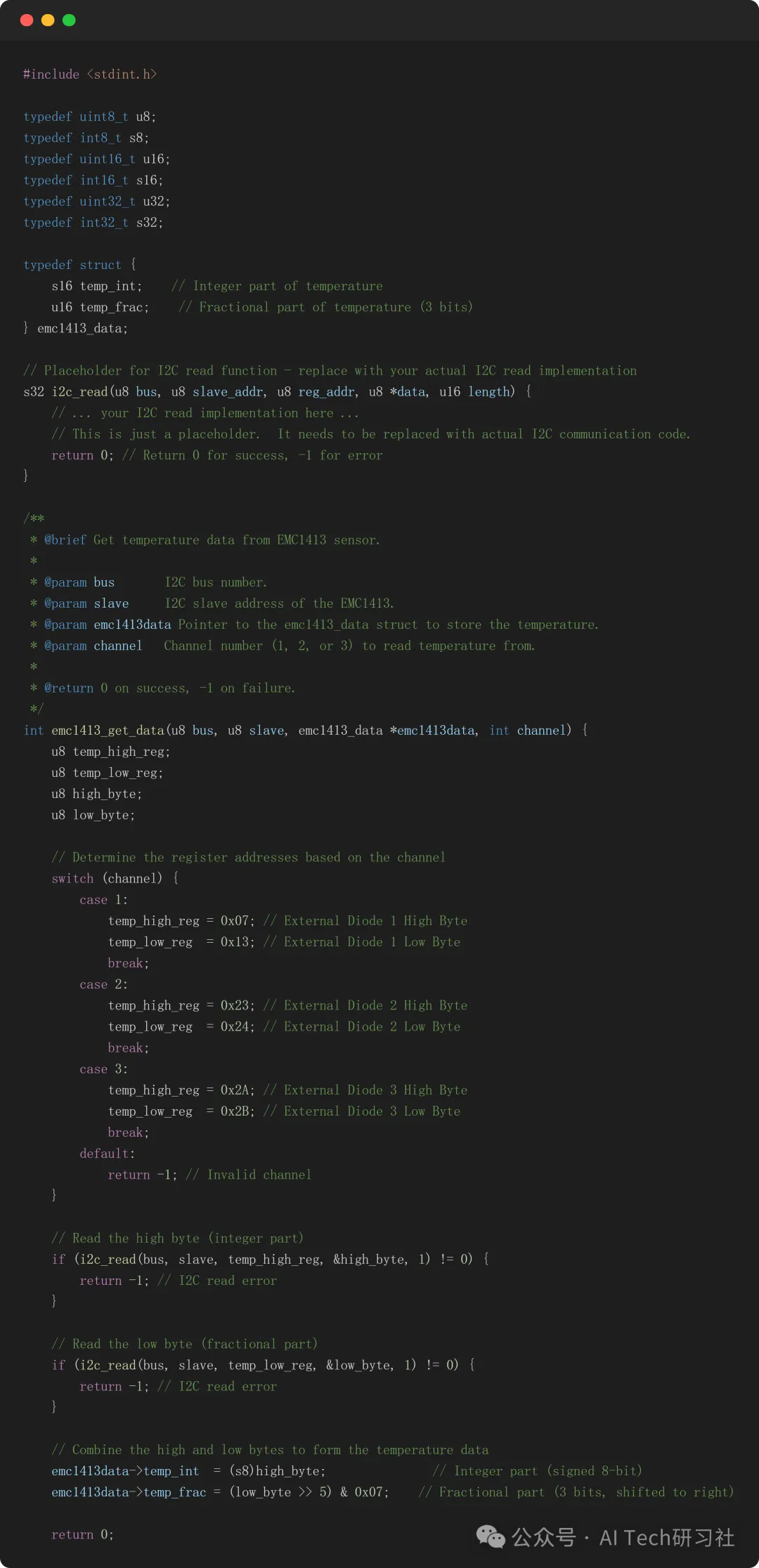

4.1根据知识库检索内容,生成代码

提示词内容

# 你是一位研发专家,需要根据用户的文字描述用C语言编写代码模块,代码应满足以下要求:

- 对于行业相关的知识,优先从知识库中获取,并将获取的内容作为模型上下文使用

- 不需要写main()函数模块

- 代码尽量采用位运算

- 编写过程要符合代码编写规范,包括代码编写风格、常用的函数库调用

- 编写的c代码文件放在test_continue目录下

## 用户需求如下:

- 功能:通过I2C协议访问芯片温度寄存器地址,读取原始寄存器数据,按照芯片要求的格式解析将数据转换为十进制。

- 输入:从知识库中获取EMC1413规格书,根据手册中的7.2章节获取三组温度寄存器中读取温度的整数位和小数位,生成温度信息。

- 输出:EMC1413获取温度接口函数。参考附件中以下函数定义: int emc1413_get_data(u8 bus, u8 slave

代码生成如下:

具体的回答效果,建议各位老板在自己的知识库下尝试。

多唠叨一句,continue只有在Agent模式下才能提供MCP服务,还需要模型支持Agent调用,示例中使用的是Google Gemini 2.0 Flash,API Key申请链接 https://aistudio.google.com/app/apikey

以上是通过本地知识库提升AI编程工具continue检索效率的全流程,希望为广大研发人员提供便利。

推荐阅读

程序员必备的 14 款 AI 编程助手,有几个你还没用过?

GPT-5 震撼发布:要点速览

用两天搭出GitHub智能搜索工具:从构思到实现

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)