小米放大招!陈龙博士领衔,罗福莉技术加持,全球首个跨域统一模型 MiMo-Embodied,17+12 项任务登顶,开启智能新纪元!

在发布多款自研大模型后,小米具身智能团队发布首篇论文,推出统一具身智能与自动驾驶的新模型MiMo-Embodied。该模型以罗福莉团队此前发布的MiMo-VL为基座持续训练,在17项具身任务和12项自动驾驶任务中表现领先,从工程层面实现了两大分离技术领域的统一建模。这是小米智驾团队首席科学家陈龙博士担任项目负责人、郝孝帅为核心第一作者的团队首个重大成果,此前曾有媒体误解为罗福莉的首个小米成果,当事

在发布多款自研大模型后,小米具身智能团队发布首篇论文,推出统一具身智能与自动驾驶的新模型MiMo-Embodied。该模型以罗福莉团队此前发布的MiMo-VL为基座持续训练,在17项具身任务和12项自动驾驶任务中表现领先,从工程层面实现了两大分离技术领域的统一建模。这是小米智驾团队首席科学家陈龙博士担任项目负责人、郝孝帅为核心第一作者的团队首个重大成果,此前曾有媒体误解为罗福莉的首个小米成果,当事人已发朋友圈澄清。

郝孝帅于今年8月加入小米智驾团队,现任自动驾驶与具身智能算法专家,博士毕业于中国科学院大学信息工程研究所,研究方向聚焦自动驾驶感知与具身智能基座大模型,曾在亚马逊师从李沐老师实习,在北京人工智能研究院担任研究员期间深度参与Robobrain 1.0和2.0等重大项目。

加入小米后,他以第一核心成员身份主导研发了首个自动驾驶与具身智能统一基座大模型MiMo-Embodied,其科研背景扎实,已在Information Fusion、NeurIPS、CVPR等顶级会议与期刊发表论文五十余篇,还多次在CVPR、ICCV等国际竞赛中获前三成绩。

而项目负责人陈龙博士今年加入小米,任汽车Principal Scientist、自动驾驶与机器人部VLA负责人,此前任职Wayve并担任Staff Scientist,带领团队研发部署全球首个上车视觉语言自动驾驶系统Lingo,获多家国际媒体报导。

1. 【导读】

论文标题:MiMo-Embodied: X-Embodied Foundation Model Technical Report

作者:Xiaomi Embodied Intelligence Team(核心贡献者:Xiaoshuai Hao、Lei Zhou、Zhijian Huang 等)

作者机构:小米(Xiaomi)

论文链接:https://arxiv.org/abs/2511.16518

项目链接:https://github.com/XiaomiMiMo/MiMo-Embodied

2. 【论文速读】

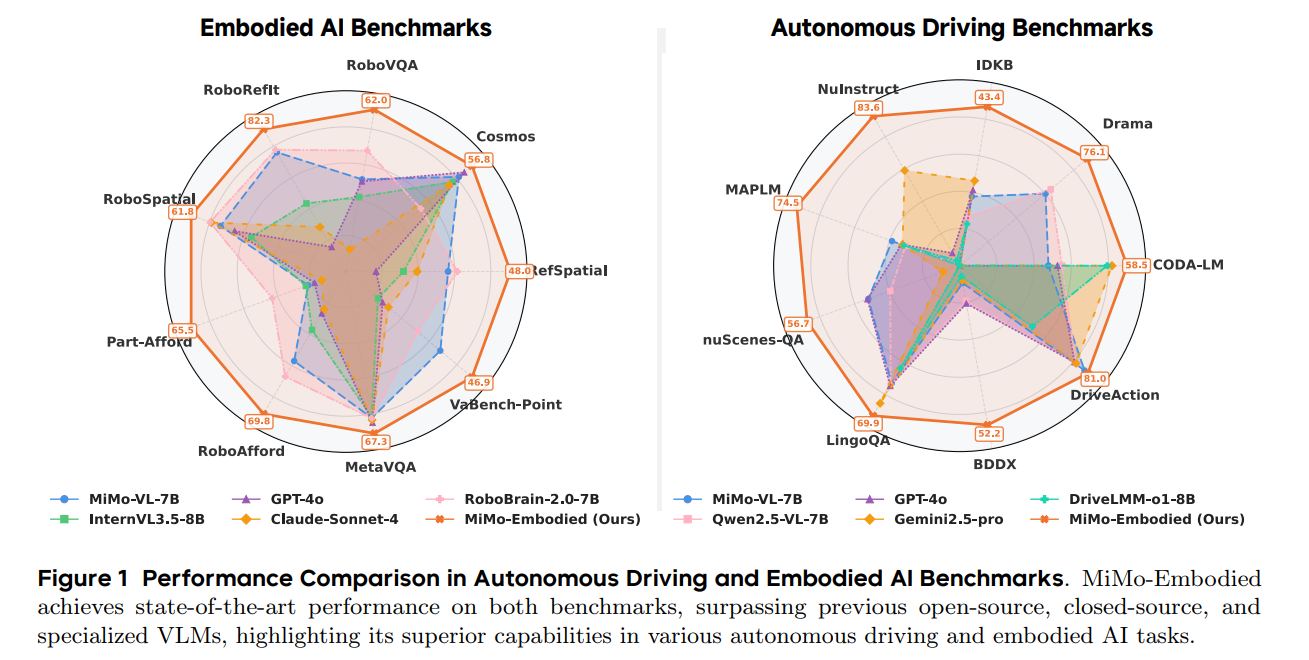

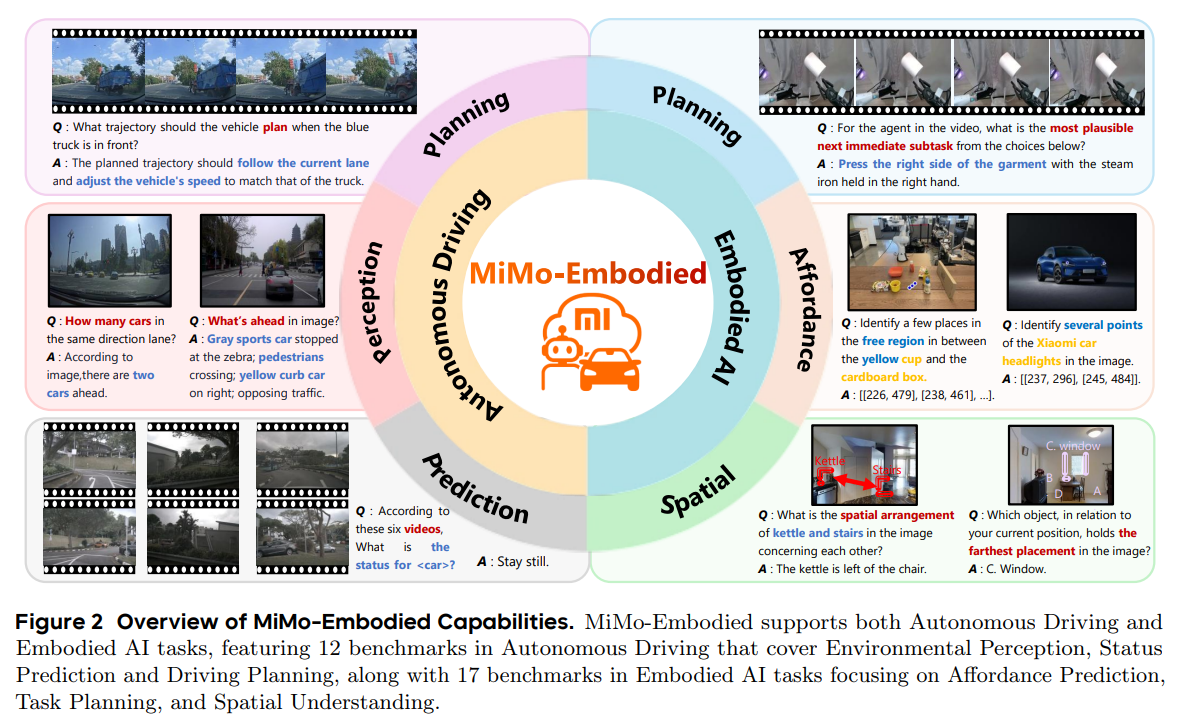

小米具身智能团队开源了MiMo-Embodied,它是首个成功整合自动驾驶与具身AI领域的跨具身基础模型,在17个具身AI基准(含任务规划、可用性预测、空间理解)和12个自动驾驶基准(含环境感知、状态预测、驾驶规划)中均取得state-of-the-art性能,显著超越现有开源、闭源及专用基线。研究表明,通过多阶段学习、精选数据构建及CoT/RL微调,两领域呈现强正迁移并相互强化,团队还详细分析了模型设计与训练方法以助力后续研究,相关代码和模型已开源。

3.【“各立门户”的困境:具身智能与自动驾驶的融合难题】

3.1 研究背景

- 技术基础:视觉语言模型(VLMs)在多模态感知、理解与推理领域潜力显著,近年出现聚焦自动驾驶、具身AI等领域的专用具身VLMs,可与物理世界交互。

- 领域局限:专用VLMs存在场景限制——具身AI侧重室内任务,自动驾驶聚焦室外道路,二者存在显著领域鸿沟,阻碍能力跨域泛化。

- 核心挑战:一是缺乏能连接自动驾驶与具身AI的统一VLMs,现有模型单域聚焦,碎片化限制动态环境中与物理世界的有效交互;二是缺乏全面的跨具身能力评估,现有评估仅覆盖单域部分能力,无法衡量模型整体性能。

3.2 相关工作

- 具身AI专用VLMs:如RoboBrain、VeBrain,侧重任务规划、空间理解等单一能力,为机器人物理交互提供关键信息,但仅针对具身AI场景,无自动驾驶适配能力。

- 自动驾驶专用VLMs:如RoboTron-Drive、DriveLMM-01,聚焦环境感知、状态预测、驾驶规划等驾驶性能优化,为自动驾驶系统提供信息支持,但仅限自动驾驶领域,无法处理具身AI任务。

- 现有局限总结:两类专用模型虽在各自领域取得进展,但均受限于单一场景,无法实现跨域能力迁移与融合,难以应对复杂现实中多场景交互需求。

4.【三层架构+四类数据+四阶训练:MiMo-Embodied的“炼成手册”】

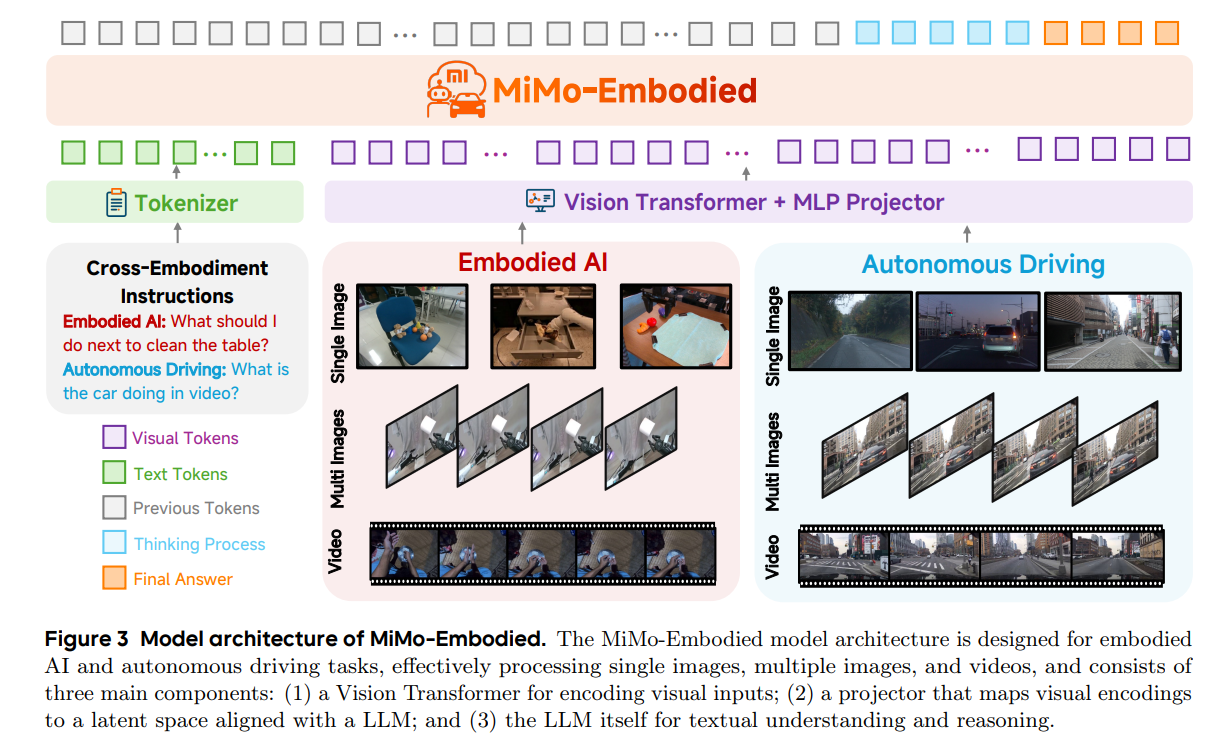

4.1 模型架构:三大核心组件构建跨域基础

MiMo-Embodied采用“视觉编码-特征对齐-语言推理”三层架构,实现对自动驾驶与具身AI任务的统一处理:

- 视觉输入编码器(Vision Transformer, ViT)

采用MiMo-VL的视觉编码器,支持单图像、多图像、视频等多种视觉输入,通过自注意力机制提取复杂特征,生成可后续处理的视觉 tokens,为精准场景理解奠定基础。 - 特征投影器(Projector)

基于多层感知机(MLP)实现,将ViT输出的高维视觉编码映射至与大语言模型(LLM)对齐的 latent 空间,确保视觉与文本模态的语义一致性,解决跨模态特征适配问题。 - 大语言模型(LLM)

沿用MiMo-VL的预训练LLM骨干网络,负责文本理解与逻辑推理,接收投影后的视觉 tokens 与文本 tokens,通过“思考过程(Thinking Process)”生成符合任务需求的连贯输出,支撑自动驾驶决策与具身交互推理。

4.2 训练数据集:三类数据打造多域能力底座

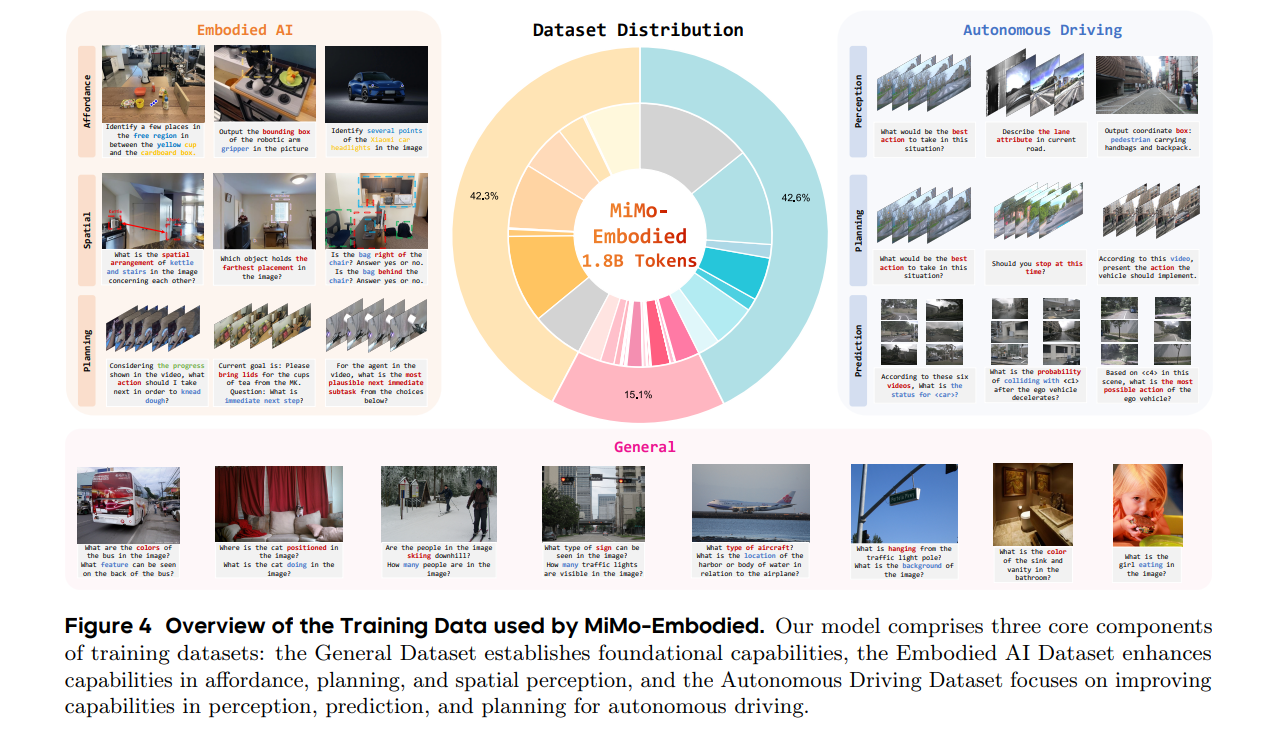

为覆盖自动驾驶与具身AI的核心需求,构建包含“通用-专用”两层结构的训练数据集,总规模达1.8B tokens:

- 通用数据集(General Dataset)

基于MiMo-VL训练语料,涵盖高分辨率图像、视频、长文本、合成推理数据等,细分为视觉定位(Visual Grounding)、文档图表理解、视频理解、多模态推理4类子数据,构建通用视觉语言能力基础。 - 具身AI数据集(Embodied AI Dataset)

按核心能力分为三类:- 可用性预测(Affordance Prediction):整合PixMo-Points、RoboAfford、RoboRefIt等数据,覆盖物体计数、视觉解释、功能部位定位等任务;

- 高阶任务规划(High-level Task Planning):基于Cosmos-Reason1、EgoPlan-IT、RoboVQA构建,包含长时序视频理解、多步动作预测等数据;

- 空间理解(Spatial Understanding):融合SQA3D、VLM-3R、RefSpatial等数据集,支撑3D场景问答、空间关系推理、导航路径规划等能力。

- 自动驾驶数据集(Autonomous Driving Dataset)

按系统模块分为三类:- 环境感知(Environmental Perception):含CODA-LM、DRAMA、MAPLM等数据,覆盖全景场景理解、区域物体识别与定位;

- 状态预测(Status Prediction):基于DriveLM、MME-RealWorld,聚焦交通参与者行为意图预测与多智能体交互建模;

- 驾驶规划(Driving Planning):整合LingoQA、NuInstruct、IDKB等,包含驾驶动作决策、推理逻辑生成等数据。

4.3 训练策略:四阶递进式优化实现跨域协同

采用“基础构建-领域专精-推理强化-精度提升”的四阶段训练策略,各阶段关键参数与目标如下(核心配置见表1):

-

阶段1:具身AI监督微调(Embodied AI Supervised Fine-tuning)

- 数据:通用数据集 + 具身AI数据集(可用性预测、任务规划、空间理解);

- 目标:构建基础视觉语言能力与具身推理能力,掌握物体交互、空间关系解析等核心技能;

- 关键参数:批次大小(Batch Size)=512,学习率(Learning Rate)= 2 × 1 0 − 6 2\times10^{-6} 2×10−6,优化器=AdamW,权重衰减(Weight Decay)=0.05。

-

阶段2:自动驾驶监督微调(Autonomous Driving Supervised Fine-tuning)

- 数据:阶段1训练数据 + 自动驾驶数据集(环境感知、状态预测、驾驶规划);

- 目标:在具身能力基础上,专精自动驾驶场景理解,提升多视角空间推理、交通场景分析能力;

- 关键参数:与阶段1一致(Batch Size=512,Learning Rate= 2 × 1 0 − 6 2\times10^{-6} 2×10−6等),确保训练稳定性。

-

阶段3:思维链推理微调(Chain-of-Thought, CoT Supervised Fine-tuning)

- 数据:阶段2训练数据 + 生成的CoT推理样本;

- 目标:通过拆解多步问题、生成显式推理链,提升模型逻辑连贯性,增强自动驾驶风险评估、具身任务分步规划的可解释性;

- 关键参数:保持批次大小与优化器不变,学习率仍为 2 × 1 0 − 6 2\times10^{-6} 2×10−6,聚焦推理能力强化。

-

阶段4:强化学习微调(Reinforcement Learning, RL Fine-tuning)

- 数据:精选RL样本(覆盖两类任务的边缘案例与失效模式);

- 目标:基于Group Relative Policy Optimization(GRPO)算法,通过多响应采样与组归一化计算优势函数,优化输出精度与可靠性;

- 关键参数:Batch Size=32,Learning Rate= 1 × 1 0 − 6 1\times10^{-6} 1×10−6,Weight Decay=0.0,按任务类型设计差异化奖励(如多选择任务用精确匹配,空间定位用IoU评估)。

表1 MiMo-Embodied各训练阶段详细配置

| 阶段(Stages) | 阶段1 | 阶段2 | 阶段3 | 阶段4 |

|---|---|---|---|---|

| 数据集(Dataset) | 通用数据+具身AI数据 | 阶段1数据+自动驾驶数据 | 阶段2数据+CoT数据 | RL数据 |

| 批次大小(Batch Size) | 512 | 512 | 512 | 32 |

| 学习率(Learning Rate) | 2 × 1 0 − 6 2\times10^{-6} 2×10−6 | 2 × 1 0 − 6 2\times10^{-6} 2×10−6 | 2 × 1 0 − 6 2\times10^{-6} 2×10−6 | 1 × 1 0 − 6 1\times10^{-6} 1×10−6 |

| 优化器(Optimizer) | AdamW | AdamW | AdamW | AdamW |

| 权重衰减(Weight Decay) | 0.05 | 0.05 | 0.05 | 0.0 |

| 学习率调度(LR Schedule) | Cosine | Cosine | Cosine | Cosine |

| 最大序列长度(Max Sequence Length) | 32768 | 32768 | 32768 | 32768 |

| 可训练组件(Trainable Components) | 全部(All) | 全部(All) | 全部(All) | 全部(All) |

5.【29项基准“大满贯”:MiMo-Embodied的实力证明】

5.1 定量评估:跨领域基准均达SOTA水平

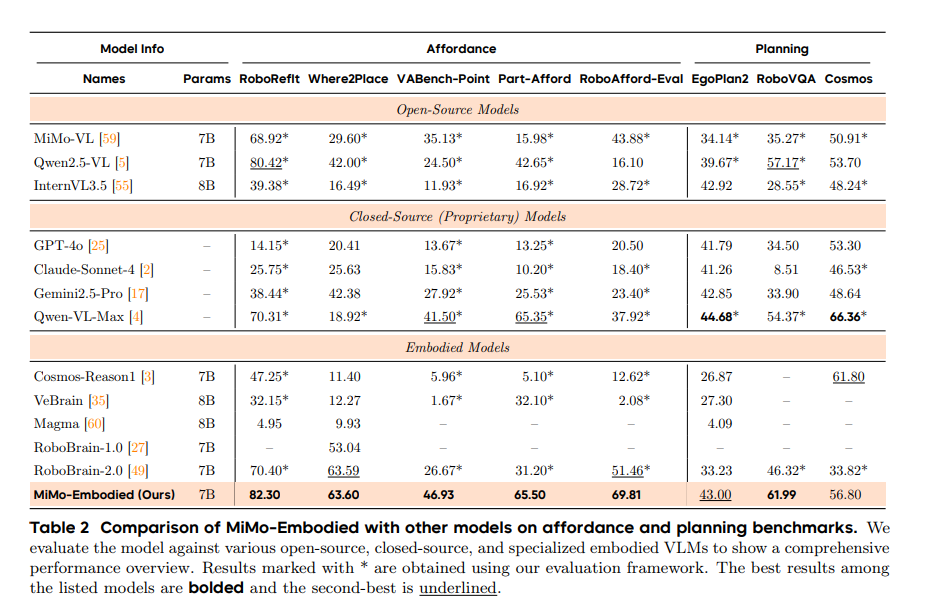

- 具身AI基准(17项)

-

可用性预测:在VABench-Point、Part-Afford、RoboAfford-Eval等5项基准中排名第一,7B参数模型得分(如RoboAfford-Eval 69.81)显著超越RoboBrain-2.0(51.46)、GPT-4o(20.50)等开源/闭源模型;

-

任务规划:RoboVQA基准得分61.99,优于Qwen2.5-VL(57.17)、Gemini2.5-Pro(33.90),EgoPlan2基准(43.00)接近专用模型水平;

-

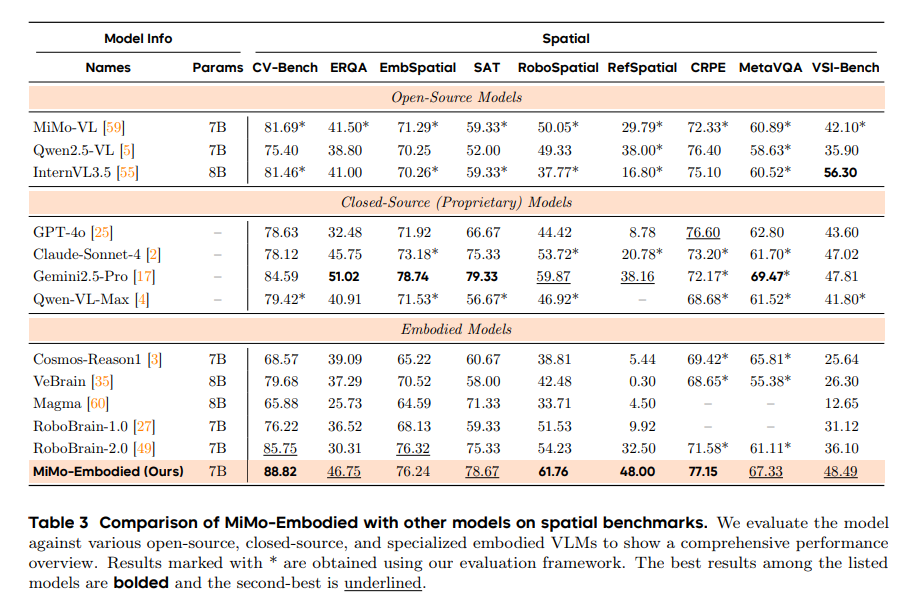

空间理解:CV-Bench(88.82)、RoboSpatial(61.76)等9项基准中,多项指标刷新纪录,较基础模型MiMo-VL提升超10个百分点。

-

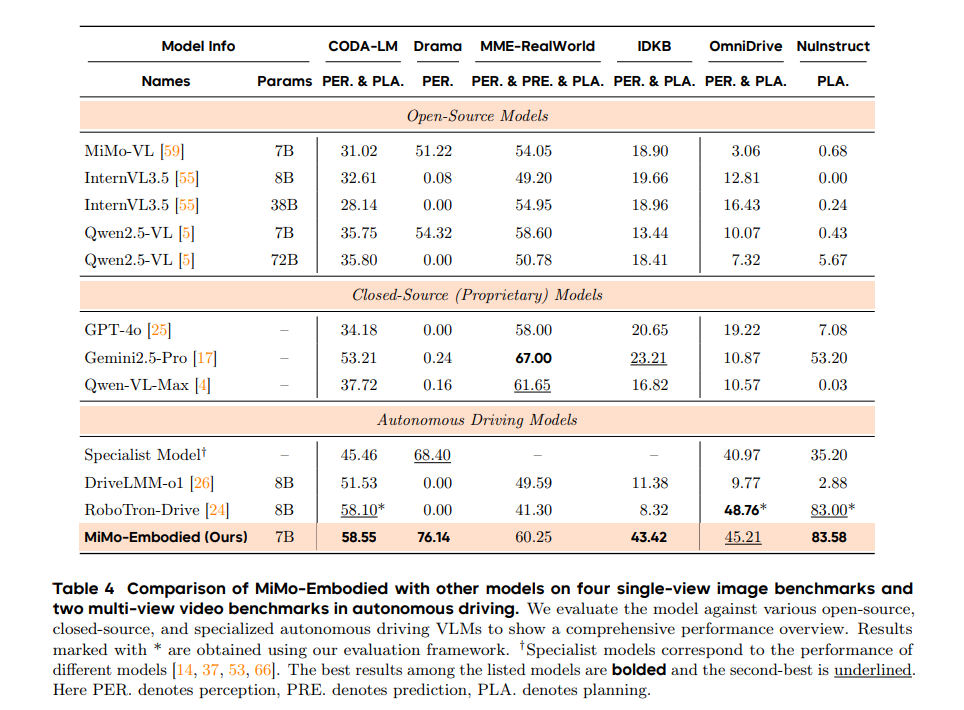

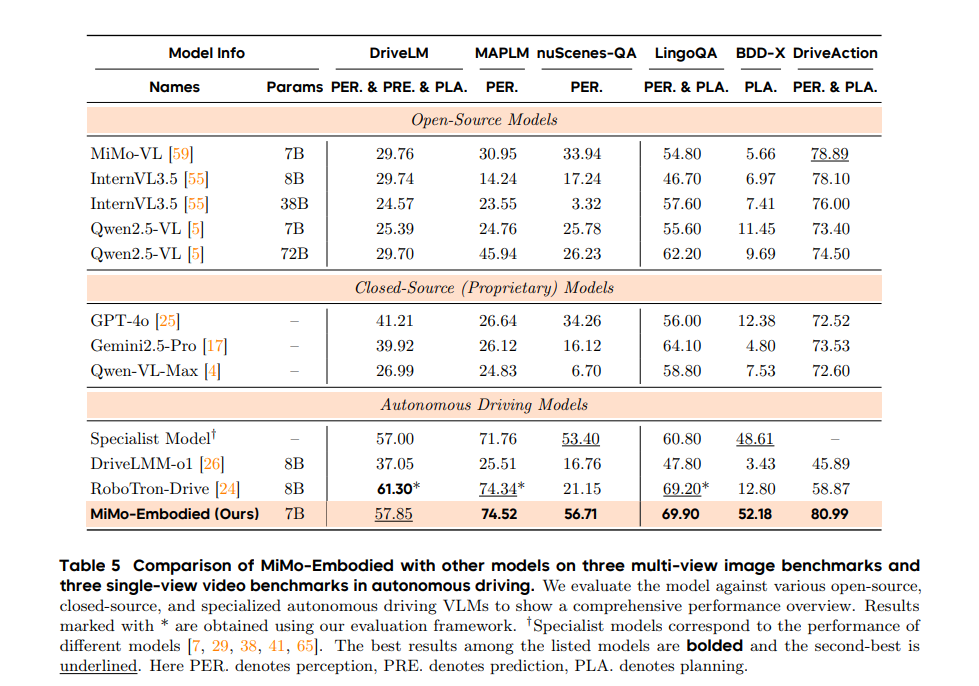

- 自动驾驶基准(12项)

- 环境感知:CODA-LM(58.55)、DRAMA(76.14)等基准得分超DriveLMM-01(CODA-LM 51.53)、RoboTron-Drive(DRAMA 0.00);

- 状态预测:MME-RealWorld、DriveLM基准中,精准捕捉交通参与者意图与多智能体交互,性能优于InternVL3.5、Qwen2.5-VL;

- 驾驶规划:LingoQA(52.18)、BDD-X(80.99)等基准得分第一,较GPT-4o(LingoQA 12.38)、Gemini2.5-Pro(BDD-X 73.53)优势显著。

5.2 定性评估:真实场景任务表现优异

-

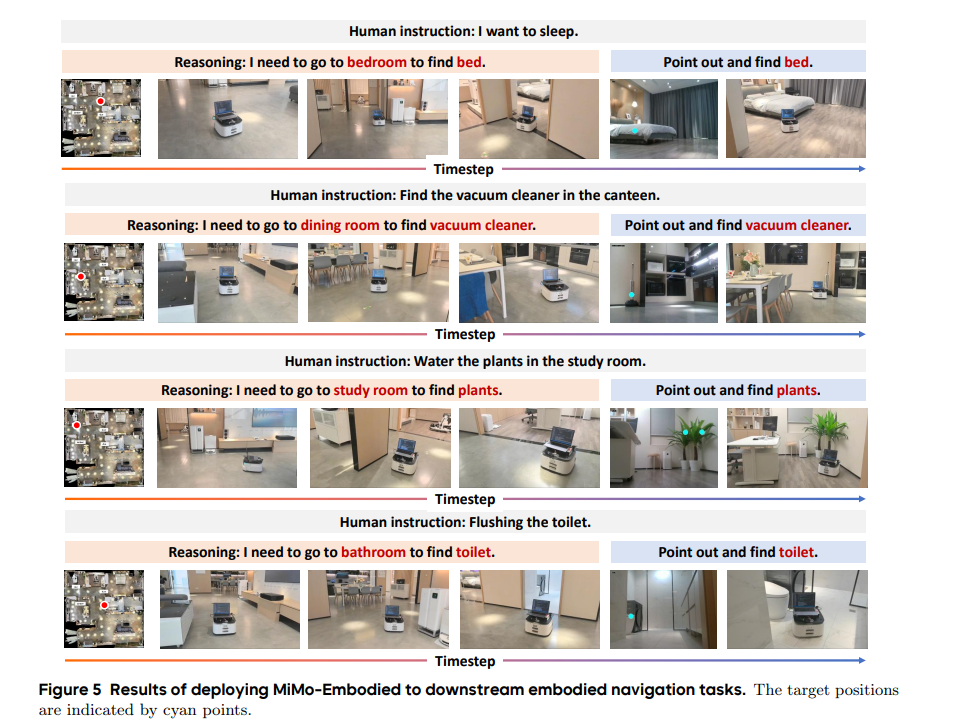

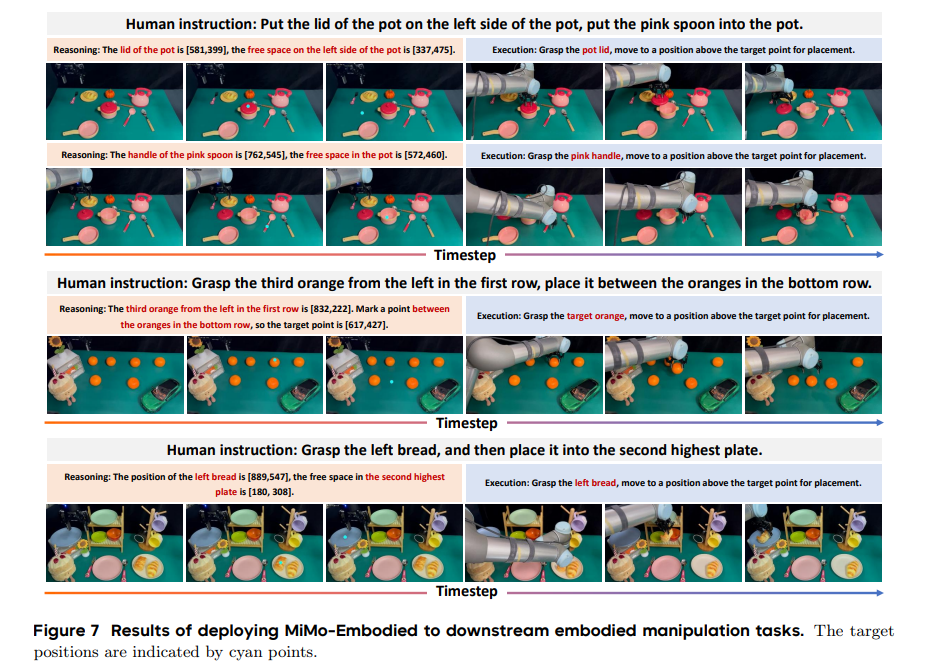

具身导航与操控

-

导航任务:在“卧室找床”“餐厅找吸尘器”等4类家庭场景中,精准定位目标区域(地图标注)与物体(第一视角定位),点定位精度超GPT-4o、RoboBrain-2.0,可处理多物体(如多盆植物)定位需求;

-

操控任务:完成“锅盖放置”“橙子转移”等分层拾取-放置任务,能识别物体功能部位(如粉色勺子手柄)、解析空间关系(如“两橙子之间”),功能推理准确性优于对比模型。

-

-

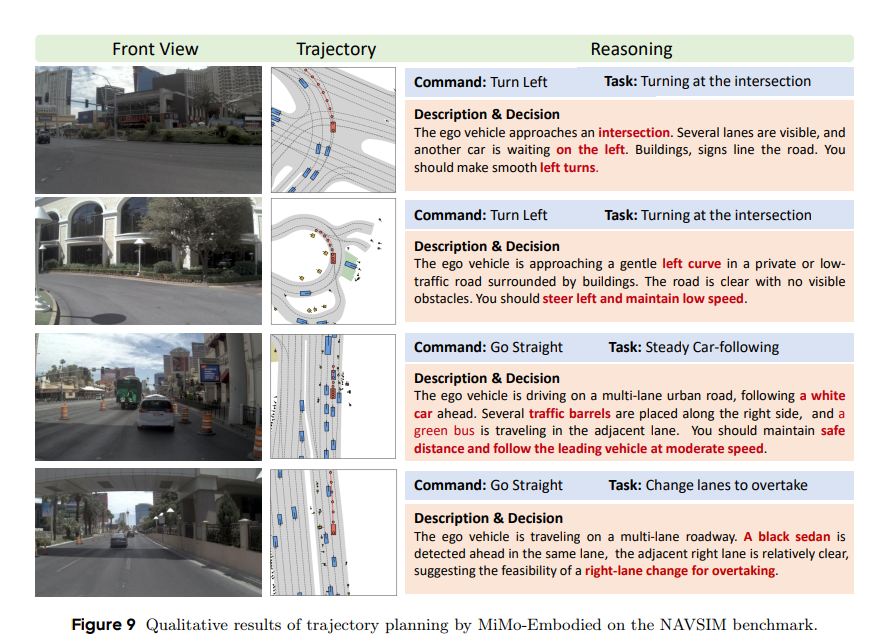

自动驾驶轨迹规划

-

公开基准NAVSIM:7B参数模型在No At-Fault Collision(98.3)、PDMS(91.0)等指标上,超InternVL3(PDMS 86.0)、ReCogDrive-RL(PDMS 90.4);

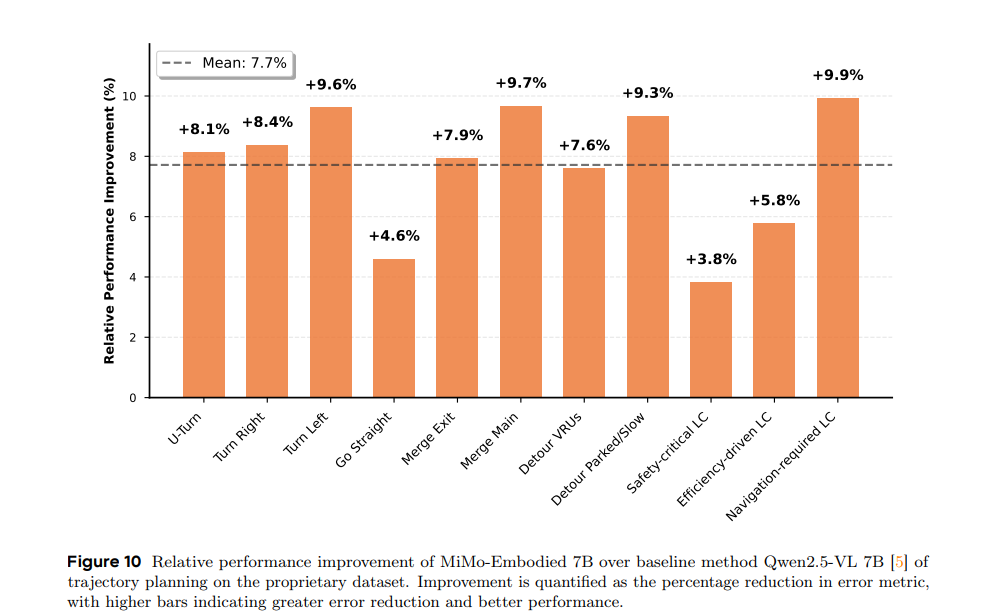

-

私有数据集:3秒轨迹预测L2误差较Qwen2.5-VL降低3.8%-9.9%,复杂场景(如绕障、变道)性能提升更显著,轨迹与人类专家驾驶行为更贴合。

-

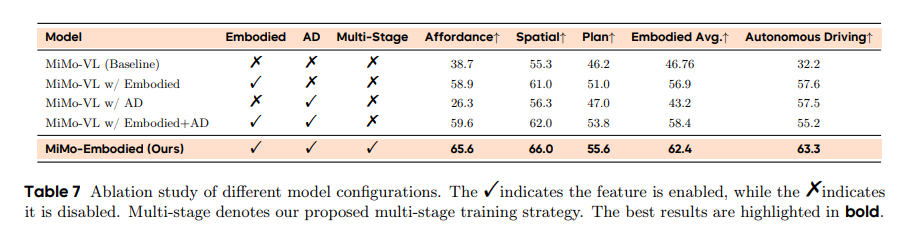

5.3 消融实验:验证多阶段训练有效性

- 单域训练局限:仅用具身数据训练的模型(MiMo-VL w/ Embodied)在自动驾驶任务得分57.6,仅用自动驾驶数据训练的模型(MiMo-VL w/ AD)在具身任务得分43.2,均存在跨域性能短板;

- 直接融合不足:具身+自动驾驶数据直接训练(MiMo-VL w/ Embodied+AD),具身任务平均得分58.4,但自动驾驶得分降至55.2,存在任务干扰;

- 多阶段优势:MiMo-Embodied通过四阶段训练,具身任务平均得分62.4(较直接融合+4%)、自动驾驶得分63.3(较直接融合+8.1%),实现跨域能力协同提升。

6.【跨域融合新标杆:从技术突破到未来探索】

MiMo-Embodied作为首个开源跨具身基础模型,成功整合自动驾驶与具身AI两大领域,在29项核心基准中均达成SOTA性能,其“三层架构+三类数据+四阶训练”的技术方案,验证了两领域的强正迁移效应与协同强化潜力。未来,团队将进一步探索具身AI与自动驾驶领域的视觉-语言-动作(VLA)模型,融合3D点云等多模态数据提升长程规划与决策能力,并推进人机交互技术革新,为复杂现实场景中的智能系统升级提供新方向。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)