从 Demo 到生产:基于ModelEngine的智能体全流程工程实践与方法论!

本文探讨了智能体工程化落地的关键挑战与方法,以企业级“智能工单运营助手”为例,通过ModelEngine平台系统化演示了从知识库构建到多智能体协作的全流程解决方案。 核心内容: 工程化路径:提出需求建模→知识工程→智能体设计→工作流编排→评测迭代的五阶段方法论,强调从“能跑通”到“可运维”的转化; 关键技术: 知识库自动生成(文档结构化→QA对生成→分层检索验证) 提示词半自动化开发(角色边界定义

关键词:智能体工程、ModelEngine、知识库自动生成、提示词自动生成、可视化编排、多智能体协作、MCP、工作流调试、对比 Dify/Coze/Versatile

一、引言:从「能跑通」到「能落地」

过去两年里,大模型相关的讨论从「能不能写诗」已经迅速转向「能不能帮我把业务流程自动跑完」。越来越多团队发现:

- 做一个能回答几个问题的 Chatbot 很容易;

- 但要做一个稳定可用、可解释、可运维、能接入真实系统的智能体,却远远不是“多写点 Prompt”那么简单。

这中间的鸿沟,本质上是工程化能力的鸿沟:

如何管理知识、如何编排工具、如何调试工作流、如何评测与迭代。

ModelEngine 这类平台的出现,就是在试图把这条从「数据 → 模型 → 应用」的链路真正打通:它既提供数据处理和知识生成能力,又提供模型管理与应用编排的一体化工具链,强调低代码/可视化、插件化扩展和端到端监控。

这篇文章会以一个完整的实践为主线,从开发者视角,系统性拆解:

- 如何在 ModelEngine 上完成知识库总结自动生成与提示词自动生成;

- 如何搭建并调试一个多智能体协作、可视化编排的复杂工作流;

- 如何通过 MCP 接入真实业务系统;

- 并与 Dify、Coze、Versatile 等平台进行横向对比,帮助开发者建立一套可迁移的「智能体工程方法论」。

为了让内容更接近真实落地场景,我们设定一个具体案例:

目标应用:企业内部「智能工单运营助手」

它需要支持:知识问答、工单查询与处理流转、数据分析报告生成、运营策略建议等一系列任务。

下文所有设计和实践,都围绕这个场景展开。

我们可以先看下ModelEngine的整体架构图:

官网地址如下:https://modelengine-ai.com/#/home

二、总体架构与方法论:智能体工程的五个阶段

在实际项目中,如果一开始就直接拉开平台开始“拖节点”,很容易变成「面向画布编程」,最后的结果是:流程能跑,但没人敢改,也不知道哪里出了问题。

我建议把智能体工程拆成五个阶段,每一阶段都有清晰产物:

- 需求建模:把“想做什么”拆成明确的任务与责任边界;

- 知识工程:围绕任务构建、清洗、验证知识库;

- 智能体设计与提示词工程:确定角色、工具和记忆机制;

- 工作流编排与多智能体协作:把“能力”串成可观测的链路;

- 评测、监控与迭代:用数据驱动持续优化。

在 ModelEngine 上,这五个阶段对应到平台的几个核心子系统:数据/知识处理、模型与智能体管理、应用编排与插件、评测与监控等。

下面我们就以「智能工单运营助手」为例,从头走一遍完整过程。

先了解下基本的全流程:

三、场景设定:一个可落地的「智能工单运营助手」

3.1 业务背景

假设你所在的公司有一个在线 SaaS 产品,每天会产生大量工单和客服对话:

- 用户提问产品使用问题;

- 提交 Bug 工单;

- 咨询账单、续费、退款等问题;

- 希望得到配置优化建议。

以往的痛点大致有:

- 知识分散:FAQ 文档、内部 Wiki、历史工单回复、IM 群聊经验分散在不同系统;

- 人工重复劳动多:大量问题是重复、可模板化的;

- 运营分析滞后:每月花数天做「工单问题分类与统计」,才能提炼出产品改进点。

我们希望构建的智能体不是一个「会闲聊的机器人」,而是一个具备以下能力的「智能助手」:

- 能基于最新知识准确回答大部分工单问题;

- 能主动调用工单系统 API 做查询/更新;

- 能周期性生成问题分类、趋势分析报告;

- 能给运营同学提供「知识缺口与产品改进建议」。

3.2 目标拆解与智能体角色划分

为了让后续设计更清晰,我们先拆解目标任务,并顺带预设多智能体的角色:

-

对话前台 Agent(SupportAgent)

- 接收用户问题;

- 判断是纯知识问答还是需要调用工具;

- 协调其他 Agent 给出最终答复。

-

工单执行 Agent(TicketAgent)

- 专注处理工单系统相关操作:查询、创建、更新状态;

- 通过 MCP 接入工单服务。

-

分析与报告 Agent(InsightAgent)

- 负责从历史数据生成报告、分析趋势;

- 借助数据查询工具和大模型总结能力。

-

评审 Agent(ReviewerAgent,可选)

- 对核心操作(如修改账单、退款)进行附加审阅;

- 提供风险提示和可解释性说明。

接下来我们按工程阶段逐步推进。

四、知识库自动生成与管理:从分散信息到「可检索的企业记忆」

4.1 数据源盘点与分层

在 ModelEngine 这样的平台上做知识库,一定要先想清楚「我们有哪些知识」,而不是一股脑全部拖进来。

实践中,我们会把知识按稳定性与用途做粗分层:

-

一级稳定知识(长期不变)

- 产品文档、使用手册;

- 官方 FAQ;

- 部分制度、条款。

-

二级可变知识(版本相关)

- 版本更新说明;

- 配置操作指南;

- 部分计费策略。

-

三级高频动态知识

- 工单问答对;

- 客服 IM 群优秀回复;

- 热门问题清单。

在 ModelEngine 中,你一般会为每层知识建立不同的知识库或「数据集」,

这样在检索阶段可以精细控制:比如优先查“官方 FAQ”,其次再回退到“历史工单”。

4.2 清洗与结构化:为自动总结打基础

现实中的原始数据往往质量很一般:格式不统一、内容冗余、甚至有过时信息。

如果不做预处理,把一堆 PDF 和工单原文直接丢给向量索引,得到的只是“会一本正经胡说八道的机器人”。

一个实用的处理流程是:

-

规范文档结构

- 将 Word / PDF 文档尽量标准化:统一标题层级(H1/H2/H3)、表格格式;

- 对扫描件进行 OCR,避免乱码。

-

工单对话结构化

- 抽取「问题文本」「客服最终答复」「标签/分类」「满意度」等字段;

- 去除敏感信息(邮箱、手机号、订单号等)。

-

噪声过滤与去重

- 过滤掉明显无意义的对话(如“在吗”“你好还在吗”);

- 对高度相似的问题和回复进行聚合。

-

元信息(Metadata)补充

- 每条知识切片添加来源(文档名/工单 ID)、时间戳、版本号等;

- 为后续评估与可解释性提供基础。

在 ModelEngine 提供的数据处理工具链中,通常可以通过内置算子或自定义算子完成上述步骤,并在流水线中组合起来执行。

4.3 知识库总结自动生成:从文档到 QA 对

平台的一个关键能力是:基于原始文档自动生成「问答对」或「摘要知识点」,用来增强检索与回答质量。

我们在实践中会采用分两层的策略:

-

文档级总结(Document-Level)

- 对每份文档生成一个「结构化摘要」:包含该文档涉及的功能模块、关键概念、常见问题;

- 摘要本身也作为知识条目入库,用于「先检索摘要再跳原文」。

-

片段级问答对(Chunk-Level QA)

- 针对每个知识切片调用大模型,按照模板生成 n 个「用户问题 + 标准回答」;

- 问题部分侧重对真实用户意图的改写,而不仅是原文复述。

一个简单的 QA 生成 Prompt 示例(在平台中通常以「节点」或「策略」形式存在):

你是一名产品客服专家。给你一段产品文档内容,请你:

- 先理解内容要点;

- 生成 3–5 个用户可能会提出的问题;

- 为每个问题给出简洁、准确、易懂的标准答复;

- 问题要多样化,覆盖不同表述方式。

在 ModelEngine 中,可以通过管道任务批量对文档执行上述生成,并提供自动化的评估与留用机制:

- 对生成的问答对进行自动评分(如一致性、覆盖度);

- 人工抽检高风险知识(政策、计费类);

- 只把通过审核的结果写入正式知识库。

4.4 知识库效果验证:不要只看「感觉」

知识库做完之后,需要有一套客观度量。

常见做法是构造一个包含「问题 + 标准答案 + 关联文档」的测试集,使用平台的评测工具自动跑一次:

-

指标示例:

- Top-k 召回中是否包含正确文档;

- 生成回答与标准答案的一致性(可用大模型做语义比对);

- 是否出现幻觉(引用不存在的政策或参数)。

我们在实际项目中,会把这套评测流程做成可重复执行的评测任务:每次知识库重大变更或大模型版本升级,都自动跑一次,避免「上线之后才发现答案全歪了」。

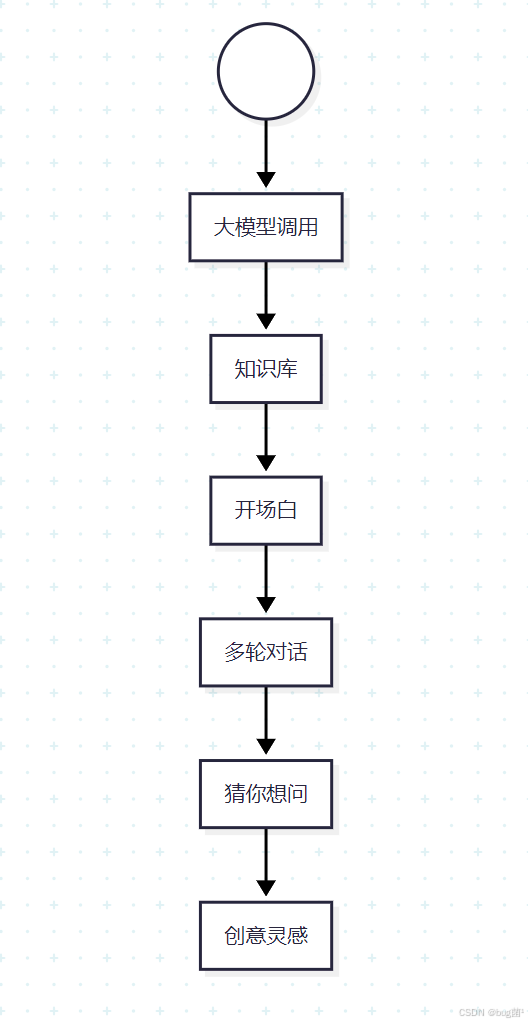

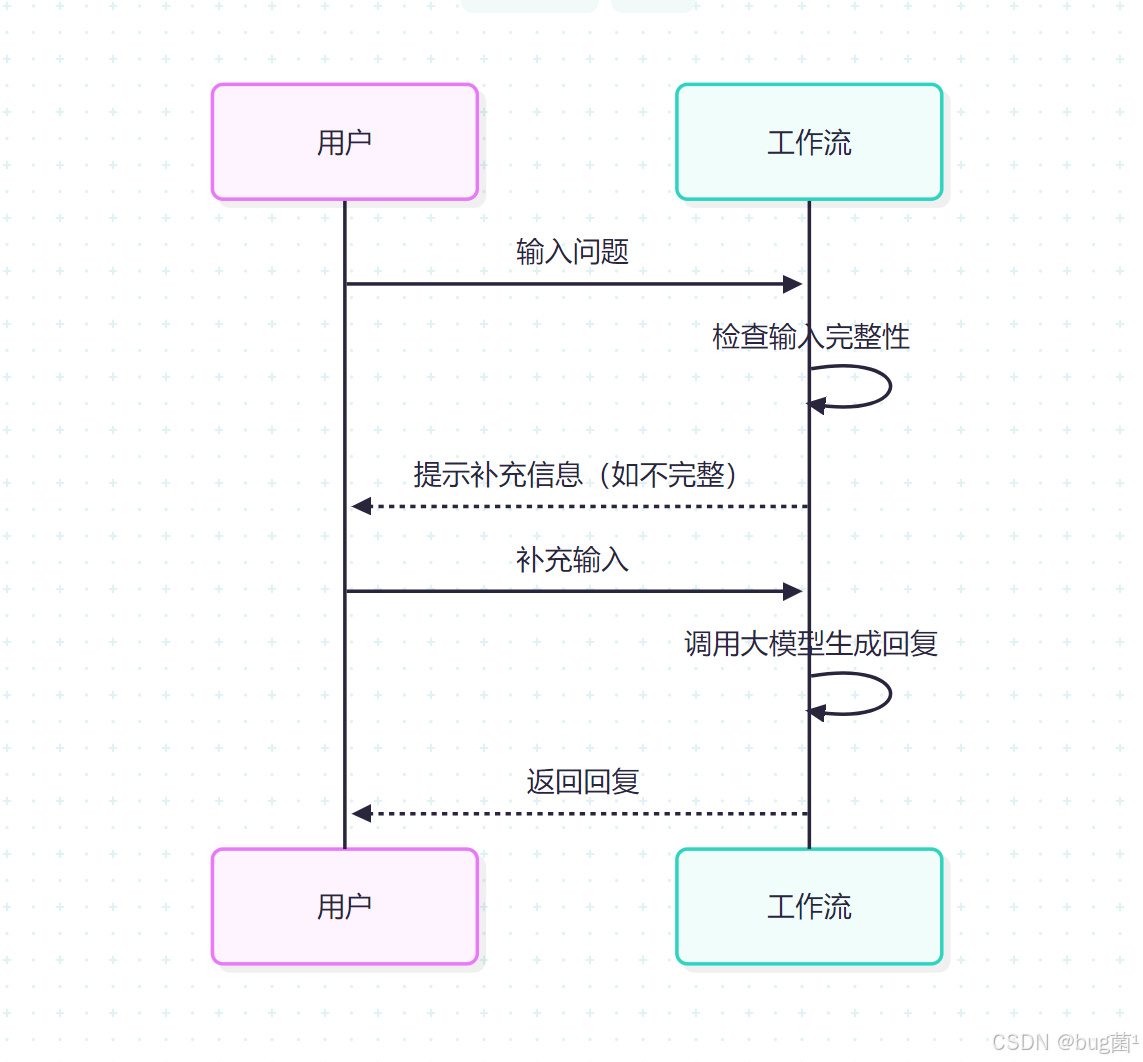

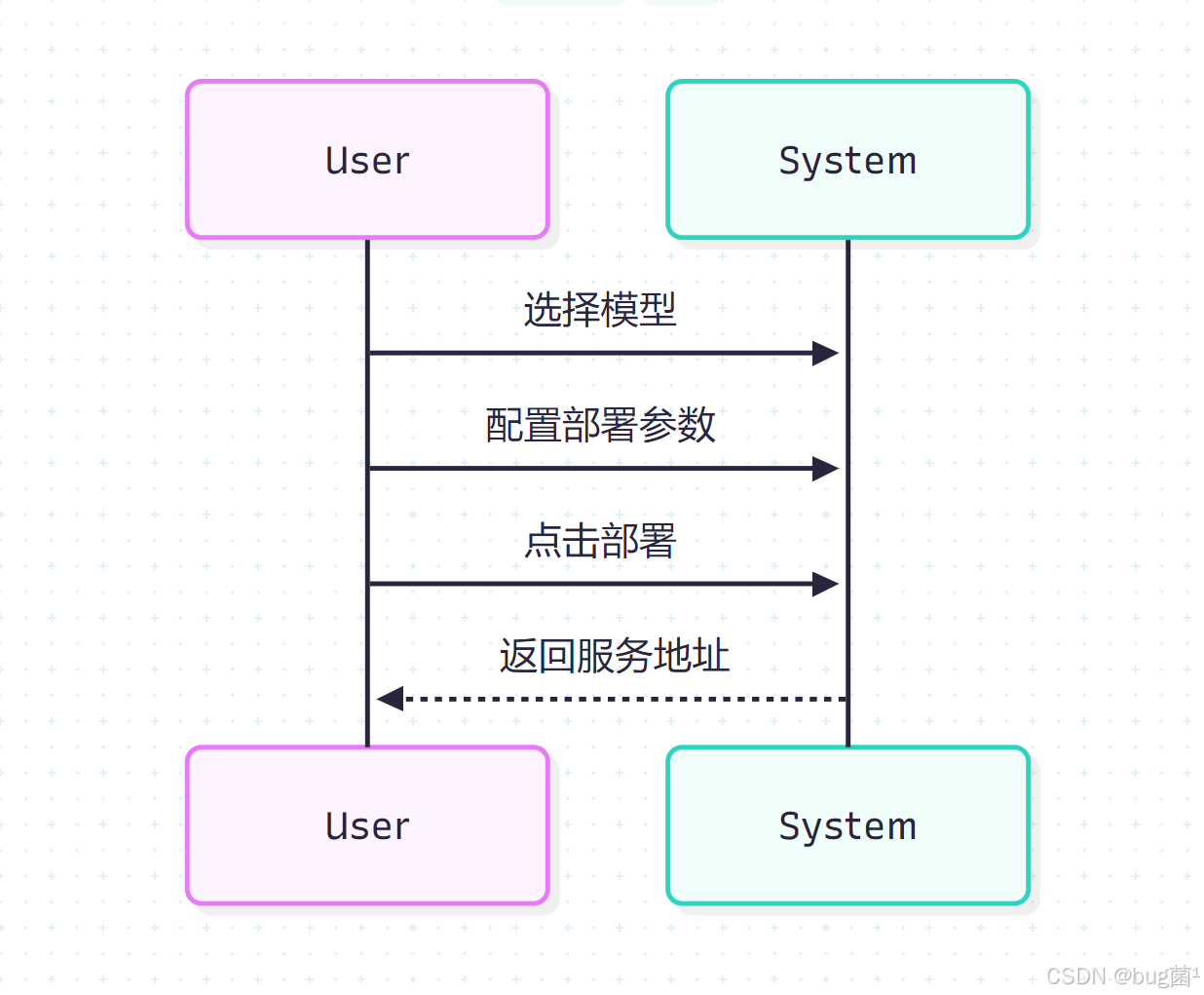

当然,我们要了解其智能体本身逻辑原理,大家请看:

相关流程图绘制如下:

五、提示词自动生成与智能体开发/调试:让「工程化的 Prompt」取代玄学

5.1 智能体角色设计与提示词结构化

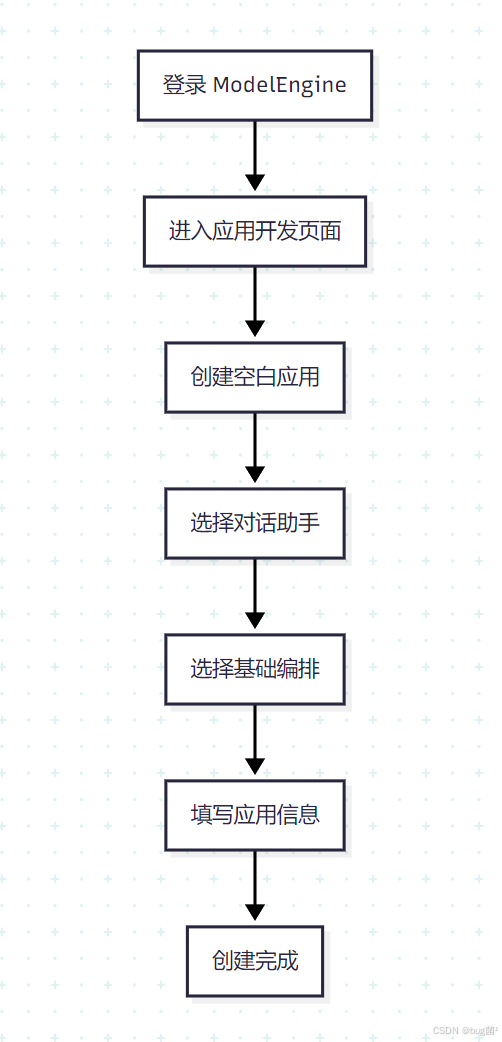

在 ModelEngine 中创建一个智能体,一般会配置以下要素:([CSDN博客][2])

- 角色描述(Role)

- 能调用的工具列表(Tools)

- 可访问的知识库范围(Knowledge)

- 记忆或会话状态(Memory)

- 系统级提示词(System Prompt)

与其手写一大坨自然语言 Prompt,我们在实践中更倾向于结构化提示词:

-

职责边界

- 你只负责工单相关问题,不回答与产品无关的闲聊;

- 涉及财务、退款的操作要调用工具,不要直接承诺。

-

知识使用策略

- 先尝试检索知识库;

- 知识库命中低时提醒用户可能不准确;

- 对敏感问题要求引用知识来源。

-

工具调用原则

- 遇到订单号、工单号等结构化信息时优先调用对应工具;

- 工具调用失败时要给出友好错误提示。

5.2 提示词自动生成:从「全靠手写」到「人机协同」

随着业务复杂度上升,靠纯手工编写和维护提示词很难持续。

ModelEngine 在智能体层面提供了提示词自动生成与优化能力,可以结合对话日志和评测结果进行建议或自动更新。([CSDN博客][2])

我们实践中的使用方式是「半自动」:

-

基于模板的初始系统 Prompt 生成

- 填入场景信息、角色职责、可用工具、合规限制;

- 让系统生成一版标准化 System Prompt 作为起点。

-

基于失败案例的局部优化

- 把评测中表现不佳的对话样本喂给系统;

- 让系统生成针对性的 few-shot 示例或补充规则;

- 人工审核后合入主 Prompt。

-

自动生成多变体做 A/B 测试

- 针对某些关键策略(例如「工具调用保守 vs 激进」)生成多种版本;

- 在流量较大的场景中做在线 A/B,对比用户满意度和任务成功率。

通过这种方式,提示词的演化不再是模糊的「感觉」,而是可以纳入整个工程体系中的一部分:有版本、有评测、有回滚。

5.3 智能体调试:从「黑盒」到「可回放的链路」

在 ModelEngine 的智能体开发界面中,调试体验的关键在于两点:([CSDN博客][3])

-

可视化对话链路

- 每轮对话中,模型做了哪些中间思考(Chain-of-Thought 可选展示)、调用了哪些工具、检索了哪些知识;

- 通过时间线或节点视图展示出来,支持单步回放。

-

可编辑重放

- 能够选择某一轮对话,修改部分配置(比如换模型、改 Prompt、换知识库版本),重新执行并对比前后差异;

- 支持把调试好的样本一键加入评测集。

以一个具体的失败案例为例:

用户:帮我查一下工单 #123456 的处理进度

模型:直接回答「工单已完成」,但实际上该工单还在处理中。

调试过程可能是这样的:

- 在调试面板中打开这轮对话;

- 发现模型没有调用工单查询工具,而是凭经验胡乱回答;

- 检查 System Prompt,发现对「遇到工单号必须调用工具」的约束不够明确;

- 在提示词生成模块中补充这一条规则,或基于这条样本让系统生成更强约束的 Prompt;

- 再次回放该对话,确认现在会调用工具并返回真实结果;

- 把这条样本加入“重要场景评测集”。

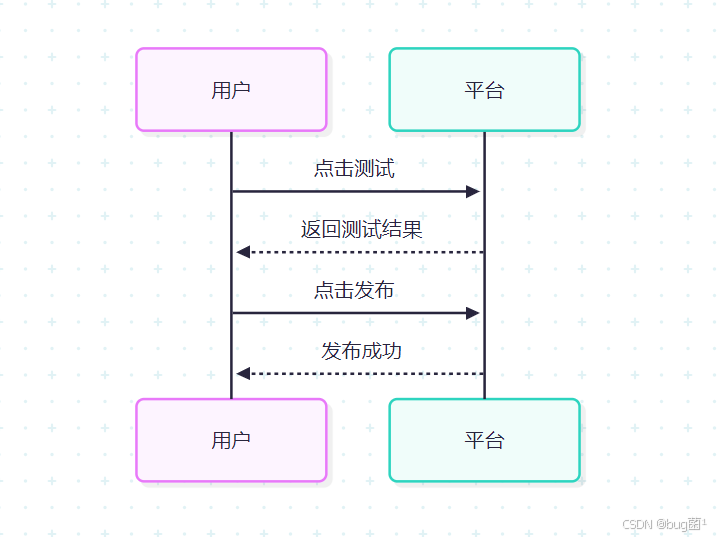

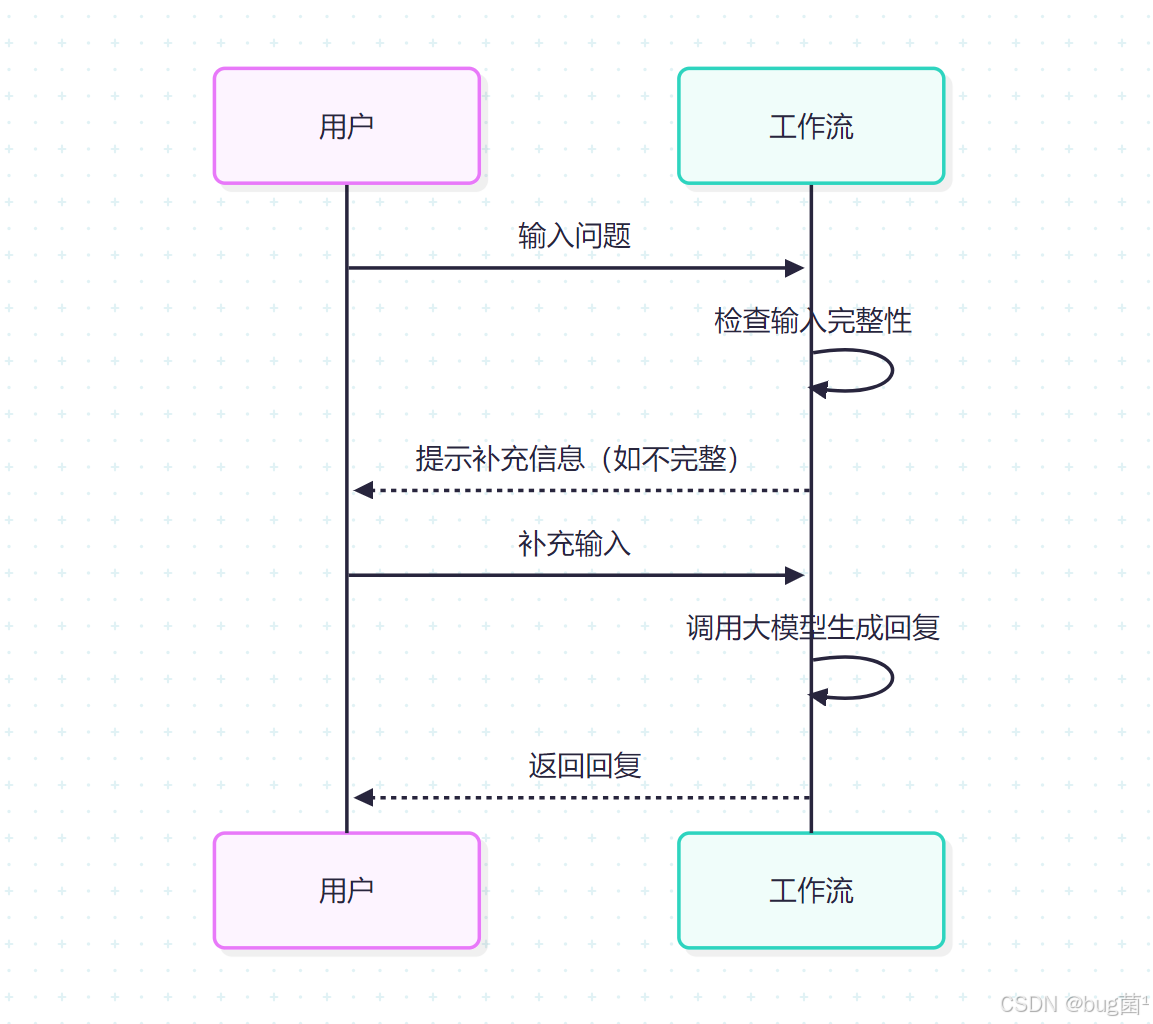

相关流程图绘制如下:

六、MCP 服务接入与多智能体协作:让智能体「长出手脚」

6.1 MCP 简介与应用场景

MCP(Model Context Protocol)可以理解为一种统一的“模型调工具”协议:

它把各种外部能力(数据库查询、HTTP API 调用、微服务等)封装成标准的「工具」,让大模型可以在一个统一的语义空间里调用它们。([CSDN博客][4])

在我们的工单助手场景中,常见 MCP 工具包括:

get_ticket_status(ticket_id)create_ticket(payload)update_ticket_status(ticket_id, status)list_recent_tickets(user_id)query_metrics(metric_name, time_range)(用于数据分析)

6.2 在 ModelEngine 中接入 MCP 工具

在平台中接入 MCP 的工程步骤通常包括:

-

定义工具 Schema

- 描述工具名称、参数类型、返回结构;

- 指定调用方式(HTTP、gRPC、自定义适配器等)。

-

编写适配层代码

- 负责参数校验、权限控制、错误处理;

- 将底层系统的复杂接口隐藏在 MCP 规范后。

-

在智能体配置中挂载工具

- 对不同智能体授予不同的工具使用权限;

- 并在 Prompt 中明确说明各工具的用途与边界。

-

在应用编排中使用工具节点

- 在可视化工作流里,把 MCP 工具当作「工具调用节点」进行编排;

- 支持条件判断(例如:只有当用户已登录时才允许调用某些工具)。

这种设计的好处是:工具与智能体解耦。

你可以在不改动业务系统的情况下,替换大模型、调整工作流,甚至新增多个 Agent 一起用这些工具。

6.3 多智能体协作模式设计

在 ModelEngine 提供的多智能体能力基础上,我们设计了一个适合「工单运营助手」的协作模式:

-

Planner-Worker 模式

- 对话前台 Agent 充当 Planner,根据用户问题规划任务;

- 决定是自己解决还是转交给 TicketAgent/InsightAgent;

- 对 Worker 的结果进行整合和润色。

-

评审 Agent 介入高风险流程

-

当涉及退款、重要配置变更时,增加 ReviewerAgent:

- 审查 Worker 的建议;

- 如果不通过,要求重新规划或改写答复。

-

-

分工明确但共享知识

- 多个智能体可以访问同一个基础知识库;

- 但在 Prompt 中强调各自职责,避免互相“越界”。

-

协作可视化

- 在平台的对话追踪界面中,可以看到每一轮由哪个 Agent 接管、调用了哪些工具;

- 便于排查「到底是哪一步出错」。

通过多智能体协作,我们可以把复杂任务拆分给适合的 Agent,实现:

- 对话逻辑更加清晰;

- 工具调用更可控;

- 未来维护与扩展更容易(例如新增“财务 Agent”“合规 Agent”)。

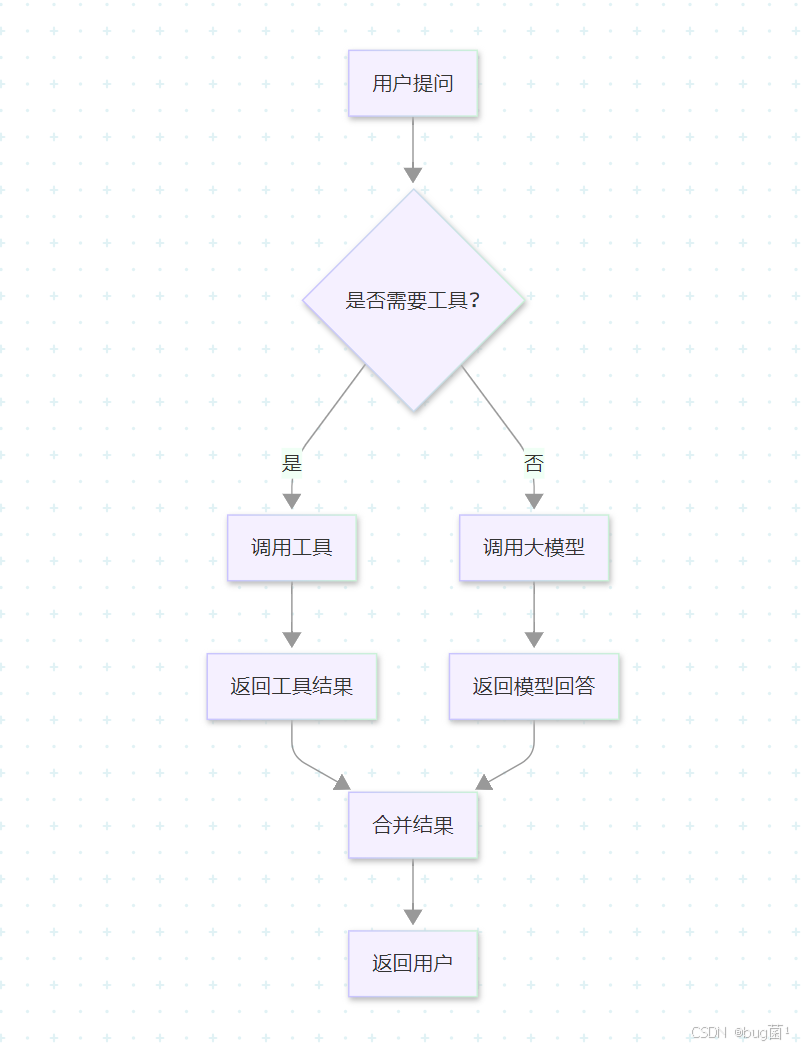

相关流程图绘制如下:

七、可视化工作流编排:从「能力」到「端到端业务流程」

如果说智能体定义了「会什么」,那工作流编排定义的就是「在什么条件下以什么顺序做什么」。

ModelEngine 的应用编排模块提供了可视化节点编辑+声明式配置的双模体验,支持在画布上拖拽节点,构建从简单对话到复杂业务流程的完整链路。

7.1 基础节点:构建业务的「乐高积木」

在实践中,最常用的基础节点类型包括:

-

LLM 节点

- 调用大模型完成文本理解、生成、分类、规划等任务;

- 支持配置模型类型、温度、最大 Token 等参数。

-

知识检索节点

- 从指定知识库中检索相关文档;

- 可配置检索 Top-K、相似度阈值、过滤条件(如标签、时间范围)。

-

条件判断节点(If/Else)

- 基于上游节点输出做分支选择;

- 常用于「是否需要人工接入」「是否满足自动处理条件」等场景。

-

工具调用节点

- 封装 MCP 工具调用;

- 支持参数映射、错误回退路径等。

-

循环与聚合节点

- 处理列表数据,如对多个工单逐个处理并聚合结果;

- 防止逻辑写死在 Prompt 中。

-

输入/输出节点

- 定义工作流的入参结构(如用户 ID、问题文本)和最终输出形式;

- 便于对接前端、其他系统或 API。

7.2 从「查询工单进度」到「闭环处理投诉」——一个完整工作流示例

以“查询并处理用户投诉工单”为例,工作流可以这样设计:

-

入口节点

- 入参:

user_id、query_text; - 调用一个 LLM 节点进行意图识别,判断是否为「工单相关」。

- 入参:

-

意图分类节点(LLM)

- 输出意图类别:

ticket_status_query、ticket_create、complaint_handling等; - 如果不是工单相关,回退到通用问答流程。

- 输出意图类别:

-

信息抽取节点(LLM)

- 从用户问题中抽取

ticket_id或其他关键字段; - 若缺失,则通过「智能表单节点」向用户补充询问信息。

- 从用户问题中抽取

-

工单查询节点(工具调用)

- 调用 MCP 工具

get_ticket_status(ticket_id); - 如果调用失败,走错误处理分支(记录日志+友好提示)。

- 调用 MCP 工具

-

策略判断节点(Condition)

-

根据工单状态与投诉类型决定下一步:

- 若状态为

open且符合自动处理条件,则进入自动回复或自动升级流程; - 若为

closed,则解释处理结果并提供补充方案。

- 若状态为

-

-

回复生成节点(LLM + 知识检索)

- 结合工单信息、知识库中的政策文档、过往处理经验,生成自然语言答复;

- 对敏感内容附加“此结果基于某文档第 X 版”。

-

反馈记录节点

- 将对话结果与用户反馈写回日志或工单系统;

- 作为后续评测与知识迭代的依据。

整个流程在可视化编排界面中是一张清晰的 DAG 图,任何一个节点出问题都可以单独调试与替换,而不用推倒重来。

7.3 工作流调试与性能优化

为了让工作流真正能够“跑得稳”,调试与性能优化同样重要:

-

节点级日志

- 每个节点的输入、输出、耗时都可记录和查看;

- 便于分析是大模型太慢还是外部工具响应慢。

-

参数试验

- 针对关键 LLM 节点,尝试不同的模型、温度参数,比较对整个流程耗时和成功率的影响;

- 可以配合平台的评测功能做 batch 测试。

-

超时与重试策略

- 工具调用节点设置合理的超时和重试次数;

- 对失败情况给出备用分支,而不是直接让整个工作流崩溃。

-

缓存机制

- 对高频静态查询(如某类政策说明、热门问题回答)增加缓存节点;

- 实测可以显著降低请求延迟和成本。([CSDN博客][4])

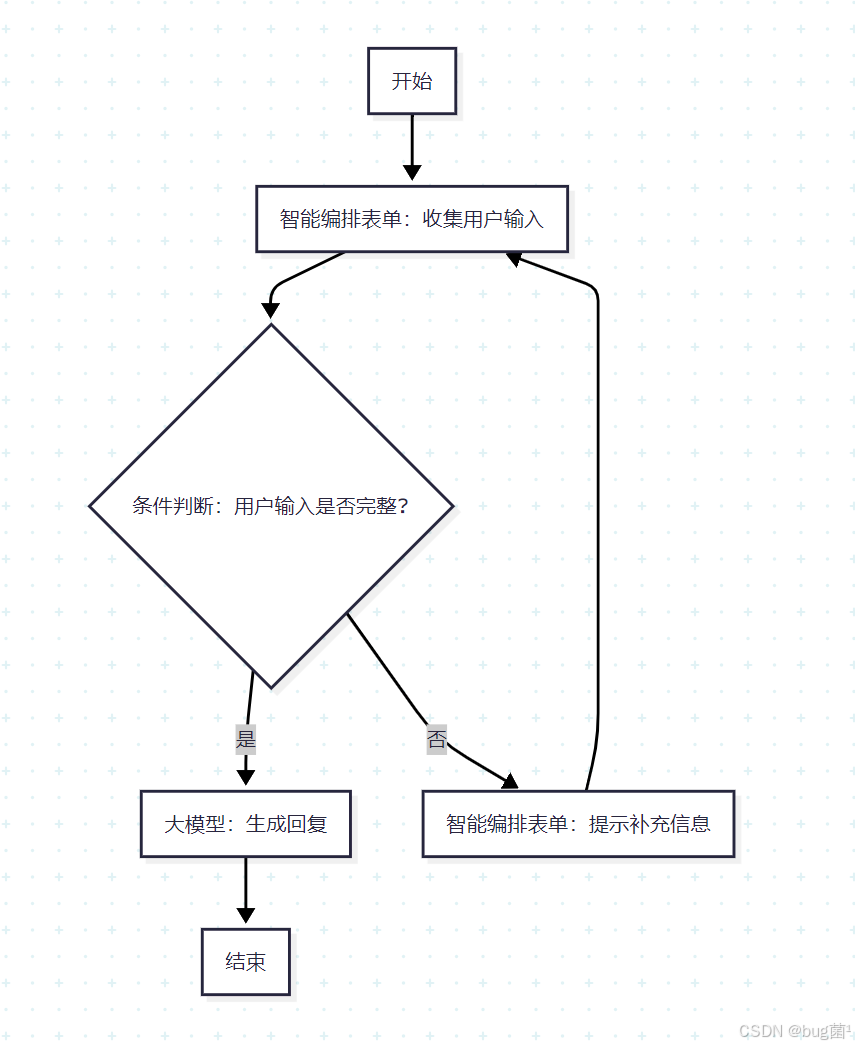

相关流程图绘制如下:

八、自定义插件与智能表单:让应用真正「接触用户」

8.1 自定义插件:扩展平台原生能力

即便平台内置了大量节点和工具,真实商业场景里总会遇到一些“非标需求”:

例如调用一个公司内部的风控服务、对接自研推荐系统、或者用某个特定算法处理文本。

在 ModelEngine 中,这类需求可以通过自定义插件来实现:

-

定义插件接口

- 确定输入参数和输出结构;

- 选择开发语言(通常支持 Java / Python)。

-

实现插件逻辑

- 在代码中对接外部系统;

- 确保对错误、超时、幂等性做充分处理。

-

注册与热插拔

- 将插件打包并注册到平台;

- 在可视化工作流中把插件当作普通节点使用。

优势在于:业务工程师可以在熟悉的语言体系中编写插件,而应用开发工程师通过画布就能调用这些能力,两类角色之间用平台规定的接口契约协同。

8.2 智能表单:把复杂输入变成结构化数据

很多场景下,用户的输入并不是一句话,而是一组复杂参数,比如:

- 提交一个故障工单需要:问题类型、影响范围、紧急程度、复现步骤;

- 提交一个数据分析请求需要:业务线、时间范围、指标列表、维度。

如果完全靠大模型从自然语言中“猜”,不仅不稳定,还容易出错。

智能表单就是介于传统表单和纯自然语言之间的一种折中方式:

- 在前端或平台中定义一个结构化表单(带字段、校验规则、默认值);

- 由大模型负责根据对话引导用户填写;

- 表单提交后生成结构化 JSON,作为工作流的输入。

这种方式的好处是:

- 用户体验上仍然很“智能”,不需要面对一堆枯燥字段;

- 工程上输入却是高度结构化的,工具调用更安全可靠。

在 ModelEngine 的可视化编排中,可以通过「表单节点」收集这些信息,然后与后续 LLM/工具节点串联起来。

九、系统特性与工程亮点:从「功能」到「工程体系」

从开发者视角看,ModelEngine 之类的平台之所以有差异,不仅在于「有多少功能」,更在于能否提供一个完整、可持续演进的工程体系。

结合前面的实践,可以归纳出几个我认为比较关键的技术亮点:

-

插件化扩展机制

- 底座与插件解耦;

- 支持多语言插件开发;

- 工具、算子、工作流节点都可以通过插件扩展。

-

可视化编排与声明式框架双模

- 编排层面支持画布拖拽;

- 底层又有声明式定义(YAML/JSON/DSL),便于版本控制与 DevOps 流程接入。

-

多智能体原生支持

- 支持在一个应用中配置多个智能体角色;

- 提供协作模式和可视化链路追踪。

-

多源工具与知识集成

- 同时管理模型、知识库、工具;

- 在工作流和智能体中统一引用。

-

评测与监控一体化

- 不仅关注「模型指标」,还关注「业务任务完成率」;

- 自动采集日志与用户反馈,反哺到评测与优化流程。

十、与 Dify / Coze / Versatile 的横向对比:开发者视角

征文要求中提到可以从开发者视角,对主流 AI 平台做对比评测。这里我们挑 Dify、Coze、Versatile 三个常被提到的产品,从几个关键维度做一个简要对比(以下为个人体验总结,非官方结论):

说明:以下对比重点从「智能体工程」视角,而不是「产品好坏」。不同平台有各自定位,选型应结合自身场景。

10.1 上手门槛与目标用户

-

Dify

- 上手非常快,适合从「知识库问答 + 简单工作流」入门;

- 场景覆盖广,社区活跃,中文支持出色。

-

Coze

- 更偏「Bot 平台」,在多渠道发布、Bot 模板生态方面优势明显;

- 适合快速搭建应用型/社区型 Bot。

-

Versatile

- 更强调「Agent+工具」的组合;

- 适合希望在一个平台内快速集成多工具、多模型的团队。

-

ModelEngine

- 定位更偏向完整 AI 工程平台,强调数据-模型-应用一体化;

- 对有一定工程能力、需要企业级落地的团队更有吸引力。([菜鸟-创作你的创作][5])

10.2 工作流编排与多智能体支持

- Dify 的工作流编排对初学者非常友好,但在复杂长链路、多 Agent 协作方面需要一定设计技巧;

- Coze 更偏 Bot 流程与插件生态,工作流粒度与可视化相对高层;

- Versatile 在多工具集成和 Agent 配置上灵活,但完整业务流程通常需要自定义较多。

- ModelEngine 则在多智能体原生支持、插件化工作流节点及可视化调试方面更强调工程化一致性:你可以在同一个平台中,从数据处理、模型管理到智能体应用编排全链打通。

10.3 企业级需求:部署、监控与治理

- 对企业来说,数据安全、权限管理、可观测性、私有化部署是关键;

- Dify/Coze 均有一定支持,但侧重点不同;

- ModelEngine 由于一开始就以「数据与模型工程化」为核心设计理念,在模型管理、任务调度、运维监控等方面更接近传统大数据/ML 工程平台的风格,对已有工程体系的团队更容易集成。

总体来说,如果你的目标是:

- 快速做一个 Demo 或 MVP:可以优先考虑 Dify/Coze;

- 构建长生命周期、深度集成企业系统的智能体应用:ModelEngine 这类全链路平台更适合作为「工程底座」。

十一、实践效果与踩坑经验:哪些是真正有价值的?

11.1 落地收益:从数字看变化

在「智能工单运营助手」的实践中,我们曾粗略统计过上线前后的指标变化(以一个中型团队为例):

- 常见问题通过智能体自动解答比例:从约 40% 提升到 75%+;

- 工单平均处理时长:缩短约 30–40%;

- 运营数据分析报告的出具频率:从「按月」变为「按周甚至按日」;

- 一线客服平均工作量下降,开始参与知识维护和运营策略共建。

这里的关键不在于绝对数字,而在于:

智能体真正融入了日常工作流,而不是一个孤立的“玩具”页面。

11.2 典型踩坑与经验教训

-

知识库过度依赖自动生成

- 自动生成 QA 对很爽,但一定要设立人工审核与高风险知识单独走流程;

- 对「计费、合同、隐私政策」等内容建议单独维护标准答复,避免模型自由发挥。

-

工具调用幂等性与错误处理不足

- 一些敏感操作(如退款、批量变更)必须设计成幂等,或者要求人工确认;

- 工具调用失败要有「人类可读」的错误信息,方便运营与开发排查。

-

多智能体之间职责边界模糊

- 如果多个 Agent 的职责描述太相似,会导致频繁“踢皮球”甚至死循环;

- 建议用「权限 + Prompt」双重手段明确边界:谁可以调用哪些工具、谁负责最终裁决。

-

工作流画布失控

- 随着需求增长,画布容易变成一堆线,完全看不懂;

- 解决方案是:模块化拆分多个子工作流,通过「子流程节点」组合;

同时,为每个工作流做好文档、版本管理与变更记录。

-

缺乏系统化评测与回归机制

- 只凭感觉迭代,很容易改着改着「原来好的地方变坏了」;

- 建议尽早构建一套包含核心业务场景的评测集,并把评测任务自动化,类似传统软件的单元测试与集成测试。

十二、可迁移的方法论:不仅是工单助手,而是一套「智能体工程模板」

虽然本文围绕「智能工单运营助手」展开,但其中的工程方法论是高度可迁移的,几乎所有大模型应用都可以用类似思路来设计:

-

先做任务拆解,再定智能体角色

不要一上来就给模型写一堆 Prompt,而是先明确「有哪些任务」「需要几个角色」「各自责任边界」。 -

把知识工程当成一等公民

没有高质量知识库,再好的大模型也只是“会编故事”。

投入时间去做数据清洗、自动总结、评测,是极其划算的。 -

用可视化编排落地业务流程

把原本写在后端代码里的业务逻辑,拆成可视化工作流:- 更利于跨角色协作(产品/运营也能看懂);

- 更利于调试和迭代。

-

坚持评测与监控闭环

对每一个重要功能点构建评测集与监控指标:- 评测保障「改了不要变差」;

- 监控保障「线上发生异常能快速发现」。

-

拥抱多智能体与 MCP 工具生态

把智能体当作「可组合的服务组件」:- 一边是统一的工具生态(MCP);

- 一边是分工明确的 Agent 角色;

中间由可视化工作流和评测体系把它们粘合起来。

十三、结语:用工程化实践,为大模型落地铺路 ✨

智能体不是一个新的 buzzword,而是一种连接大模型能力与业务场景的工程范式。

ModelEngine 这类平台之所以重要,是因为它把从「数据、模型」到「应用、运维」的链路真正拉通,让开发者可以在一个统一的环境中,实践智能体工程的全流程。

如果要用一句话来概括本文想表达的核心观点,那就是:

大模型应用的竞争,不再是“谁的 Prompt 写得更玄学”,而是“谁的工程体系更完整、更可持续”。

希望这篇从 0 到 1 的实战与方法论分享,能帮助你更系统地思考智能体落地,也祝你在 ModelEngine「AI 应用开发实践计划」征文中拿到一个不错的成绩 🏆。

-End-

更多推荐

已为社区贡献76条内容

已为社区贡献76条内容

所有评论(0)