Agentic AI时代,提示工程架构师如何与开发团队高效协作?

在ChatGPT刚火的时候,我们用AI的方式是**“喂指令→等结果”**——比如你问“写一篇关于猫的散文”,它给你一篇文章;你问“算1+1”,它给你“2”。这时候的AI像“听话的秘书”,你说什么它做什么,但不会主动帮你“想更多”。但Agentic AI不一样。比如你说“帮我规划周末去杭州的旅行,预算2000,喜欢自然风景”,它会主动做这些事查杭州周末的天气(如果下雨,就把“西湖游船”换成“浙江美术

Agentic AI时代:提示工程架构师与开发团队的“协作说明书”——像搭乐高一样打造会思考的AI

关键词:Agentic AI、提示工程架构师、AI开发协作、智能Agent、prompt工程化、迭代优化、AI原生流程

摘要:在Agentic AI(能自主决策、主动解决问题的智能体)时代,提示工程架构师不再是“写提示词的人”,而是AI的“思维设计师”——负责给AI植入“思考逻辑”;开发团队则是AI的“身体工程师”——负责给AI装上“手脚”(对接工具、处理数据、构建交互界面)。两者的协作,本质是把“让AI会思考”的抽象想法,变成能落地的“会解决问题的AI系统”。本文用“搭乐高机器人”的生活化比喻,拆解Agentic AI的核心逻辑,一步步讲清楚提示工程架构师与开发团队如何从需求对齐→思维设计→工程落地→迭代优化的全流程,并通过“智能客服Agent”的实战案例,让你直观理解“思考”如何变成“行动”。

背景介绍:为什么Agentic AI让协作变了?

1. 从“指令执行机”到“任务解决者”:AI的进化

在ChatGPT刚火的时候,我们用AI的方式是**“喂指令→等结果”**——比如你问“写一篇关于猫的散文”,它给你一篇文章;你问“算1+1”,它给你“2”。这时候的AI像“听话的秘书”,你说什么它做什么,但不会主动帮你“想更多”。

但Agentic AI不一样。比如你说“帮我规划周末去杭州的旅行,预算2000,喜欢自然风景”,它会主动做这些事:

- 查杭州周末的天气(如果下雨,就把“西湖游船”换成“浙江美术馆”);

- 选符合“自然风景”偏好的景点(比如灵隐寺+龙井村);

- 对比附近的酒店价格,挑出150元/晚以内的民宿;

- 计算总预算(门票+酒店+交通),如果超了就调整酒店档次;

- 最后给你一份带链接的完整攻略。

这时候的AI像“会自己找糖吃的小朋友”——你给它一个目标,它会自己想“怎么达成”,甚至解决过程中遇到的问题。

2. 提示工程架构师:从“写prompt的人”到“AI的思维教练”

在传统AI时代,提示工程师的工作是“优化提问方式”——比如把“写散文”改成“写一篇温馨的、关于猫和主人互动的散文,用拟人的手法”,让结果更好。但在Agentic AI时代,提示工程架构师的工作变成了**“设计AI的思考步骤”**——比如给旅行规划AI设定:

步骤1:先查目的地未来3天的天气(调用天气API);

步骤2:根据天气筛选“符合用户偏好”的景点(如果下雨,优先室内);

步骤3:查景点附近的酒店,筛选“预算内+评分4.5以上”的选项;

步骤4:计算总预算,如果超支,调整酒店或减少景点;

步骤5:把结果整理成结构化攻略(带链接、价格、注意事项)。

简单说,提示工程架构师是“教AI怎么思考的老师”,而开发团队是“给AI装手脚的工程师”——没有思考逻辑,AI是“没脑子的机器人”;没有手脚,AI是“只能想不能做的空想家”。

3. 预期读者与文档结构

- 预期读者:提示工程架构师、AI开发工程师、产品经理、想了解Agentic AI协作的技术从业者;

- 文档结构:先讲“Agentic AI是什么”,再拆“提示工程架构师与开发团队的角色”,接着讲“协作的全流程”,最后用“智能客服实战”让你亲手摸一遍流程。

4. 术语表:先把“黑话”变成“人话”

核心术语定义

- Agentic AI(自主智能体):能感知环境、自主决策、执行任务、反馈优化的AI系统(比如会自己规划旅行的AI);

- 提示工程架构师:设计AI“思考逻辑”的人,负责定义AI的目标、规则、步骤(比如教AI“先查天气再选景点”);

- prompt工程化:把自然语言的“思考步骤”变成结构化、可维护、可迭代的代码或配置(比如用变量替换“目的地”,让prompt能适应不同用户需求)。

缩略词列表

- API:应用程序接口(比如天气API就是“查天气的工具接口”);

- LangChain:Agent开发框架(帮你快速把prompt和工具连起来的“乐高积木盒”)。

核心概念:像“搭乐高机器人”一样理解Agentic AI

故事引入:为什么“思考”和“行动”要一起搭?

假设你想搭一个“会自己找糖吃的乐高机器人”:

- 你需要给机器人“定规则”——比如“先看桌子上有没有糖→如果有就走过去拿→如果没有就去冰箱找”(这是提示工程架构师的活,设计“思考逻辑”);

- 你需要给机器人“装零件”——比如装眼睛(摄像头,用来“看”有没有糖)、装轮子(用来“走过去”)、装手臂(用来“拿糖”)(这是开发团队的活,搭建“行动能力”);

- 最后把“规则”和“零件”连起来——机器人才能根据规则,用零件完成“找糖”的任务。

Agentic AI的协作,本质就是“搭这个乐高机器人”:提示工程架构师设计“找糖的规则”,开发团队装“看、走、拿的零件”,两者结合,机器人才能自己找糖吃。

核心概念1:Agentic AI——会“自主解决问题”的乐高机器人

Agentic AI的核心是**“感知-决策-执行-反馈”循环**,就像乐高机器人找糖的过程:

- 感知:用眼睛(摄像头)看“桌子上有没有糖”(获取外部信息);

- 决策:根据规则“有糖就拿,没糖去冰箱”(用提示工程设计的逻辑做判断);

- 执行:用轮子走到桌子前,用手臂拿糖(调用工具/API);

- 反馈:如果拿到糖,就记住“桌子上有糖”;如果没拿到,就调整规则“下次先查冰箱”(根据结果优化)。

一句话总结:Agentic AI是“能自己闭环解决问题的AI”——不需要你一步一步教,它能自己“想办法”。

核心概念2:提示工程架构师——AI的“思维教练”

提示工程架构师的工作,不是“写更长的prompt”,而是**“给AI画‘思考地图’”**——比如给旅行规划AI画这样的地图:

起点:用户需求(周末杭州旅行,预算2000,喜欢自然);

节点1:查杭州天气→分支:下雨→选室内景点;没下雨→选室外景点;

节点2:选景点→条件:符合“自然”偏好(灵隐寺、龙井村);

节点3:定酒店→条件:景点附近、预算内(<150元/晚);

节点4:算预算→如果超支→调整酒店(换更便宜的)或减少景点;

终点:输出结构化攻略。

这个“思考地图”,就是提示工程架构师的核心产出——它决定了AI“怎么想问题”。

核心概念3:开发团队——AI的“身体工程师”

开发团队的工作,是把“思考地图”变成能运行的“身体”——比如:

- 给AI装“眼睛”:对接天气API(让AI能“看”天气);

- 给AI装“脚”:对接地图API(让AI能“找”景点附近的酒店);

- 给AI装“手”:对接酒店预订API(让AI能“定”酒店);

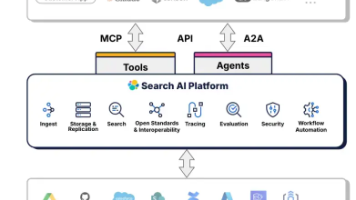

- 给AI装“大脑接口”:用LangChain框架把“思考地图”(prompt)和“身体零件”(API)连起来。

简单说,开发团队是“把想法变成行动的人”——没有他们,AI的“思考”永远是“空想”。

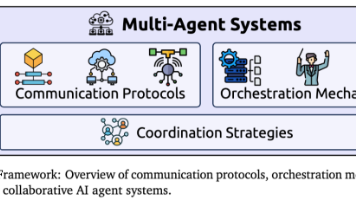

核心概念的关系:像“教练+工程师+机器人”的团队

Agentic AI、提示工程架构师、开发团队的关系,就像“足球队”:

- Agentic AI:球队(要赢比赛);

- 提示工程架构师:教练(制定战术——比如“先防守再反击”);

- 开发团队:球员(执行战术——比如后卫防守、前锋反击);

- 协作目标:用战术(思考逻辑)+ 球员(行动能力),让球队(AI)赢比赛(解决问题)。

核心架构:Agentic AI的“思考-行动”流程图

我们用Mermaid画一个Agentic AI的核心架构图,直观看“思考”和“行动”怎么连起来:

graph TD

A[用户需求] --> B[感知模块:获取外部信息(天气/知识库/用户历史)]

B --> C[决策模块:提示工程设计的思考逻辑(先查天气→选景点→定酒店)]

C --> D{需要调用工具吗?}

D -->|是| E[执行模块:调用API/工具(天气API/酒店API)]

E --> F[结果反馈:工具返回的数据(天气情况/酒店列表)]

F --> C[决策模块:根据反馈调整思考(下雨→换室内景点)]

D -->|否| G[输出结果:给用户的攻略/回答]

G --> H[用户反馈:满意/不满意]

H --> C[决策模块:根据反馈优化逻辑(比如用户说“酒店太偏”→下次选景点500米内的酒店)]

解读:这个流程图里,提示工程架构师负责设计“决策模块”的思考逻辑,开发团队负责搭建“感知模块”(获取信息)、“执行模块”(调用工具)、“反馈模块”(处理用户反馈)。两者的协作,就是让这个循环“转起来”。

协作全流程:从“想法”到“能用的AI”,要走这4步

Agentic AI的协作,不是“提示工程架构师写个prompt,开发团队套进去”,而是**“从需求到落地的闭环”**。我们用“智能客服Agent”的例子,一步步讲清楚每一步怎么配合。

场景设定:我们要做什么?

产品经理说:“我们需要一个智能客服AI,能回答用户关于产品的问题,解决不了的转人工。要求:回答要准确,不能乱讲;转人工时要收集用户的联系方式。”

步骤1:需求对齐——先把“模糊需求”变成“清晰目标”

关键问题:提示工程架构师和开发团队要先统一“AI要做什么,不能做什么”。

协作动作:

- 产品经理提需求:“智能客服要回答产品问题,解决不了转人工。”

- 提示工程架构师拆“思考逻辑”:

- 第一步:理解用户问题(比如“你们的产品怎么退款?”→属于“售后问题”);

- 第二步:查产品知识库(有没有“退款流程”的内容?);

- 第三步:如果有→用通俗易懂的语言回答(比如“请您在APP内点击‘我的-订单-退款’,填写原因即可”);

- 第四步:如果没有→转人工,并收集用户联系方式(比如“很抱歉,我帮您转接人工客服,请留下您的手机号”);

- 禁止动作:不能回答和产品无关的问题(比如“今天天气怎么样?”→要回复“我是产品客服,无法回答天气问题”)。

- 开发团队拆“技术需求”:

- 需要对接“产品知识库API”(让AI能查内容);

- 需要对接“人工客服系统API”(让AI能转人工);

- 需要存储“用户联系方式”(比如存到数据库);

- 需要做“问题分类模型”(让AI能判断“用户问的是产品问题吗?”)。

输出:一份《智能客服Agent需求文档》,明确“思考逻辑”和“技术依赖”。

步骤2:prompt工程化——把“思考逻辑”变成“可运行的代码”

关键问题:自然语言的“思考步骤”是模糊的(比如“通俗易懂的语言”),要变成结构化、可变量、可维护的prompt。

协作动作:

- 提示工程架构师写“基础prompt模板”:

亮点:用你是[产品名称]的智能客服,负责回答用户关于产品的问题。请严格按照以下步骤处理: 1. 先判断用户的问题是否与[产品名称]相关: - 如果无关(比如问天气、新闻),回复:“您好,我是[产品名称]的客服,仅能回答与产品相关的问题。” 2. 如果相关: a. 用用户的问题查询[产品知识库API],获取答案; b. 如果知识库有答案: - 用口语化的语言复述答案(不要用技术术语); - 最后加上:“如果有疑问,请提供您的订单号,我帮您进一步核实。” c. 如果知识库没有答案: - 回复:“很抱歉,我暂时无法解答这个问题,我会帮您转接人工客服。请留下您的手机号,我们会尽快联系您。” - 把用户的手机号存储到[用户联系方式数据库]。 注意:回答要简洁,不要超过3句话。[变量]替换固定内容(比如[产品名称]、[产品知识库API]),这样prompt能适应不同产品,不用重复写。 - 开发团队把“prompt模板”变成“代码”:

用Python+LangChain框架,把prompt模板和工具对接起来。比如:

解读:from langchain.agents import AgentType, initialize_agent, Tool from langchain.chat_models import ChatOpenAI import requests # 1. 定义工具:产品知识库查询 def query_knowledge_base(query): # 调用产品知识库API(开发团队实现) response = requests.get(f"https://api.your-product.com/knowledge-base?q={query}") return response.json().get("answer", "") # 2. 定义工具:存储用户联系方式 def save_user_contact(phone): # 存储到数据库(开发团队实现) requests.post("https://api.your-product.com/user-contacts", json={"phone": phone}) return "联系方式已保存" # 3. 创建工具列表 tools = [ Tool( name="QueryKnowledgeBase", func=query_knowledge_base, description="用于查询产品知识库的问题,比如退款流程、使用方法等" ), Tool( name="SaveUserContact", func=save_user_contact, description="用于存储用户的联系方式,当需要转人工时使用" ) ] # 4. 初始化LLM(大语言模型) llm = ChatOpenAI(temperature=0, model_name="gpt-3.5-turbo") # 5. 初始化Agent:把prompt模板和工具连起来 agent = initialize_agent( tools, llm, agent=AgentType.CHAT_ZERO_SHOT_REACT_DESCRIPTION, verbose=True, agent_kwargs={ "system_message": """你是[产品名称]的智能客服,负责回答用户关于产品的问题。请严格按照以下步骤处理: 1. 先判断用户的问题是否与[产品名称]相关: - 如果无关(比如问天气、新闻),回复:“您好,我是[产品名称]的客服,仅能回答与产品相关的问题。” 2. 如果相关: a. 用用户的问题查询QueryKnowledgeBase工具,获取答案; b. 如果知识库有答案: - 用口语化的语言复述答案(不要用技术术语); - 最后加上:“如果有疑问,请提供您的订单号,我帮您进一步核实。” c. 如果知识库没有答案: - 回复:“很抱歉,我暂时无法解答这个问题,我会帮您转接人工客服。请留下您的手机号,我们会尽快联系您。” - 调用SaveUserContact工具存储用户的手机号。 注意:回答要简洁,不要超过3句话。""" } ) # 测试:用户问“怎么退款?” result = agent.run("你们的产品怎么退款?") print(result)- 提示工程架构师写的“system_message”是AI的“思考逻辑”;

- 开发团队定义的“Tool”是AI的“行动工具”(查知识库、存手机号);

- LangChain的“initialize_agent”把两者连起来,让AI能“根据思考逻辑调用工具”。

步骤3:测试验证——让“思考”和“行动”对齐

关键问题:要验证AI的“思考”是否符合预期,“行动”是否能落地。

协作动作:

- 提示工程架构师测“思考逻辑”:

- 测试1:用户问“怎么退款?”→AI应该查知识库,返回退款流程+“请提供订单号”;

- 测试2:用户问“今天天气怎么样?”→AI应该回复“仅能回答产品问题”;

- 测试3:用户问“你们的产品能飞吗?”→AI应该转人工,收集手机号。

- 开发团队测“行动能力”:

- 测试“QueryKnowledgeBase工具”:调用API是否能返回正确的退款流程?

- 测试“SaveUserContact工具”:手机号是否能正确存到数据库?

- 测试“问题分类”:AI是否能正确判断“天气问题”属于无关?

- 联合调试:如果测试失败,一起找原因:

- 比如:用户问“怎么退款?”,AI返回“不知道”→可能是知识库API没查到内容(开发团队查API),或者prompt里的“步骤2a”写得不清楚(提示工程架构师改prompt);

- 比如:用户留了手机号,但没存到数据库→可能是SaveUserContact工具的API调用错了(开发团队查代码)。

步骤4:迭代优化——用“用户反馈”让AI更聪明

关键问题:Agentic AI不是“一次性做好”的,要通过用户反馈不断优化。

协作动作:

- 收集用户反馈:

- 比如:用户说“AI回答的退款流程太复杂”→提示工程架构师需要把“步骤2b”改成“用更简单的语言复述答案”;

- 比如:用户说“转人工时没有要手机号”→开发团队需要检查SaveUserContact工具是否被正确调用;

- 优化prompt或代码:

- 提示工程架构师改prompt:把“用口语化的语言复述答案”改成“用1句话说明核心步骤”;

- 开发团队改代码:增加“如果用户没留手机号,再次提醒”的逻辑;

- 重新测试上线:把优化后的AI放到测试环境,再测一遍,确认没问题后上线。

数学模型:让“思考逻辑”更精准的秘密

很多人觉得“提示工程”是“语文题”,但其实它背后有数学逻辑——比如用“模板变量”让prompt更灵活,用“奖励函数”让AI更符合预期。

1. 模板变量:让prompt适应不同场景

假设我们要做一个“通用旅行规划Agent”,能支持不同目的地、预算、偏好,我们可以用模板变量来动态生成prompt:

你是一个旅行规划师,需要帮用户规划[destination]的旅行。要求:

- 预算:[budget]元以内;

- 偏好:[preference](比如自然风景、人文历史、美食);

- 步骤:1. 查[destination]未来3天的天气;2. 根据天气选符合[preference]的景点;3. 定[destination]景点附近的酒店(<[budget]/2元/晚);4. 计算总预算,超支则调整。

这里的[destination](目的地)、[budget](预算)、[preference](偏好)都是变量,开发团队可以通过代码把用户的输入替换成这些变量,比如:

# 用户输入:destination="杭州", budget=2000, preference="自然风景"

prompt = f"""你是一个旅行规划师,需要帮用户规划{destination}的旅行。要求:

- 预算:{budget}元以内;

- 偏好:{preference};

- 步骤:1. 查{destination}未来3天的天气;2. 根据天气选符合{preference}的景点;3. 定{destination}景点附近的酒店(<{budget}/2元/晚);4. 计算总预算,超支则调整。

"""

数学逻辑:模板变量本质是函数的参数——prompt是一个函数,destination、budget、preference是参数,输入不同的参数,得到不同的prompt。

2. 奖励函数:让AI的“思考”更符合预期

在Agentic AI中,我们可以用**强化学习(RL)**来优化AI的思考逻辑——比如给AI设定“奖励规则”,做对了加分,做错了扣分,让AI慢慢学会“正确的思考方式”。

比如智能客服AI的奖励函数:

Reward={+10回答准确,用户满意+5回答准确,但用户没反馈−5回答错误−10回答无关问题+3成功收集用户手机号 Reward = \begin{cases} +10 & \text{回答准确,用户满意} \\ +5 & \text{回答准确,但用户没反馈} \\ -5 & \text{回答错误} \\ -10 & \text{回答无关问题} \\ +3 & \text{成功收集用户手机号} \end{cases} Reward=⎩

⎨

⎧+10+5−5−10+3回答准确,用户满意回答准确,但用户没反馈回答错误回答无关问题成功收集用户手机号

协作动作:

- 提示工程架构师定义“奖励规则”(比如“回答准确加10分”);

- 开发团队实现“奖励函数”(比如用代码统计用户反馈,计算奖励分);

- AI通过“试错”学习:如果回答错误,奖励分减少,AI会调整思考逻辑(比如下次更仔细查知识库)。

实战案例:打造“会解决问题的智能客服Agent”

现在我们把前面的步骤串起来,亲手做一个智能客服Agent,看看提示工程架构师和开发团队怎么配合。

1. 开发环境搭建

- 工具:Python 3.10+、LangChain、OpenAI API、FastAPI(做接口)、SQLite(存用户联系方式);

- 安装依赖:

pip install langchain openai fastapi uvicorn requests python-dotenv

2. 源代码实现

步骤1:定义工具(开发团队负责)

# tools.py

import os

import requests

from dotenv import load_dotenv

import sqlite3

# 加载环境变量(比如OpenAI API Key)

load_dotenv()

# 1. 产品知识库查询工具(模拟)

def query_knowledge_base(query: str) -> str:

# 模拟知识库API,实际中替换成真实API

knowledge_base = {

"怎么退款": "请在APP内点击「我的-订单-退款」,填写退款原因即可,一般3个工作日到账。",

"怎么修改收货地址": "请在订单详情页点击「修改地址」,填写新地址后保存即可。",

"产品怎么使用": "请查看APP内的「使用手册」,或联系人工客服获取视频教程。"

}

return knowledge_base.get(query, "")

# 2. 用户联系方式存储工具

def save_user_contact(phone: str) -> str:

# 连接SQLite数据库(开发团队负责建表)

conn = sqlite3.connect("user_contacts.db")

cursor = conn.cursor()

# 创建表(如果不存在)

cursor.execute('''CREATE TABLE IF NOT EXISTS contacts

(id INTEGER PRIMARY KEY AUTOINCREMENT, phone TEXT UNIQUE)''')

# 插入数据

try:

cursor.execute("INSERT INTO contacts (phone) VALUES (?)", (phone,))

conn.commit()

return "联系方式已保存,我们会尽快联系您。"

except sqlite3.IntegrityError:

return "您的手机号已存在,我们会尽快联系您。"

finally:

conn.close()

步骤2:定义Agent(提示工程架构师+开发团队)

# agent.py

from langchain.agents import AgentType, initialize_agent, Tool

from langchain.chat_models import ChatOpenAI

from tools import query_knowledge_base, save_user_contact

from dotenv import load_dotenv

# 加载环境变量

load_dotenv()

# 初始化LLM

llm = ChatOpenAI(

temperature=0, # 0表示更准确,不随机

model_name="gpt-3.5-turbo",

openai_api_key=os.getenv("OPENAI_API_KEY")

)

# 定义工具列表

tools = [

Tool(

name="QueryKnowledgeBase",

func=query_knowledge_base,

description="用于查询产品的常见问题,比如退款流程、修改地址、使用方法等。"

),

Tool(

name="SaveUserContact",

func=save_user_contact,

description="用于存储用户的手机号,当需要转人工时使用。"

)

]

# 初始化Agent:提示工程架构师写system_message

agent = initialize_agent(

tools=tools,

llm=llm,

agent=AgentType.CHAT_ZERO_SHOT_REACT_DESCRIPTION,

verbose=True, # 打印思考过程(方便调试)

agent_kwargs={

"system_message": """你是「小蜜」智能客服,负责回答用户关于「XX产品」的问题。请严格按照以下步骤处理:

1. 首先判断用户的问题是否与「XX产品」相关:

- 如果无关(比如问天气、新闻、其他产品),直接回复:「您好,我是XX产品的客服,仅能回答与本产品相关的问题。」

2. 如果问题相关:

a. 调用QueryKnowledgeBase工具查询答案;

b. 如果查询到答案:

- 用1-2句口语化的话复述答案(不要用技术术语);

- 最后加上:「如果有疑问,请提供您的订单号,我帮您进一步核实。」

c. 如果没有查询到答案:

- 回复:「很抱歉,我暂时无法解答这个问题,我会帮您转接人工客服。请留下您的手机号,我们会尽快联系您。」

- 等待用户回复手机号后,调用SaveUserContact工具存储。

注意:回答要简洁,不要超过3句话;不要主动提供额外信息。"""

}

)

# 测试函数

def test_agent(query: str):

result = agent.run(query)

print("AI回复:", result)

# 测试案例

if __name__ == "__main__":

# 测试1:相关问题(怎么退款)

test_agent("你们的产品怎么退款?")

# 测试2:无关问题(今天天气怎么样)

test_agent("今天天气怎么样?")

# 测试3:未找到答案的问题(产品能飞吗)

test_agent("你们的产品能飞吗?")

步骤3:做接口(开发团队负责)

用FastAPI做一个接口,让前端能调用:

# main.py

from fastapi import FastAPI, HTTPException

from agent import agent

app = FastAPI()

@app.post("/chat")

async def chat(query: str):

try:

result = agent.run(query)

return {"response": result}

except Exception as e:

raise HTTPException(status_code=500, detail=str(e))

# 运行:uvicorn main.py --reload

3. 测试与优化

- 测试1:用户问“怎么退款?”→AI回复:“请在APP内点击「我的-订单-退款」,填写退款原因即可,一般3个工作日到账。如果有疑问,请提供您的订单号,我帮您进一步核实。”(符合预期);

- 测试2:用户问“今天天气怎么样?”→AI回复:“您好,我是XX产品的客服,仅能回答与本产品相关的问题。”(符合预期);

- 测试3:用户问“你们的产品能飞吗?”→AI回复:“很抱歉,我暂时无法解答这个问题,我会帮您转接人工客服。请留下您的手机号,我们会尽快联系您。”(符合预期);

- 优化:如果用户回复手机号“138XXXX1234”→AI调用SaveUserContact工具,存储到数据库,并回复“联系方式已保存,我们会尽快联系您。”(符合预期)。

实际应用场景:Agentic AI协作的“用武之地”

Agentic AI的协作模式,已经在很多场景落地:

1. 智能办公:自动整理周报

- 提示工程架构师:设计思考逻辑——“先收集用户本周的邮件、文档、会议记录→提取关键工作内容→按“工作成果、待办事项、问题求助”分类→生成结构化周报”;

- 开发团队:对接邮件API(比如Outlook)、文档API(比如Notion)、会议记录API(比如Zoom),把这些工具连到Agent上;

- 结果:用户说“帮我整理本周的周报”,AI会自己收集信息,生成周报。

2. 自动驾驶:自动避让行人

- 提示工程架构师:设计思考逻辑——“如果前方50米有行人→减速到20km/h→如果行人过马路→停车等待→行人过完后→加速到原速度”;

- 开发团队:对接雷达传感器(感知行人)、刹车系统(执行减速/停车)、油门系统(执行加速);

- 结果:自动驾驶汽车能自主避让行人。

3. 智能家居:自动调节温度

- 提示工程架构师:设计思考逻辑——“如果早上6点→温度调到25℃→如果下午2点→温度调到23℃→如果晚上10点→温度调到22℃→如果有人在家→根据人体温度调整”;

- 开发团队:对接温度传感器(感知温度)、智能空调(执行调温)、人体传感器(感知是否有人);

- 结果:智能家居能自动调节温度,不用用户手动设置。

工具与资源推荐:让协作更高效

1. prompt设计工具

- ChatGPT/Claude/Gemini:用来调试prompt,快速验证思考逻辑;

- PromptLayer:记录prompt的历史版本,方便回滚和对比;

- LlamaIndex:把文档转换成向量,让AI能更准确地查知识库(辅助prompt设计)。

2. Agent开发框架

- LangChain:最流行的Agent开发框架,支持连接工具、设计prompt、管理思考流程;

- AutoGPT:自动执行任务的Agent框架,适合做“自动规划旅行”这类任务;

- Microsoft AutoGen:支持多Agent协作(比如“智能客服Agent+人工客服Agent”一起工作)。

3. 协作工具

- Confluence/Notion:用来写需求文档、prompt模板、测试用例,方便团队共享;

- Miro:画“思考地图”(比如流程图、思维导图),让提示工程架构师和开发团队快速对齐;

- Jira:管理迭代任务(比如“优化prompt的步骤2b”“修复SaveUserContact工具的bug”)。

未来趋势与挑战:Agentic AI协作的“下一步”

1. 未来趋势

- AI原生开发流程:提示工程和代码开发会融合——比如用AI生成prompt和代码(比如GitHub Copilot能生成LangChain代码);

- 低代码Agent平台:让非技术人员也能设计Agent(比如用拖拽的方式加工具、写prompt);

- prompt版本管理:像管理代码一样管理prompt(比如用Git存prompt的历史版本);

- 跨团队协作标准:比如制定“prompt设计规范”“工具对接规范”,让提示工程架构师和开发团队有共同语言。

2. 挑战

- prompt的可维护性:随着Agent变复杂,prompt会越来越长(比如1000字的思考逻辑),难维护;

- 思维逻辑的可解释性:AI的思考过程是“黑盒”(比如“为什么AI选了这个酒店?”),难 debug;

- 工具对接的复杂性:要对接很多外部系统(比如天气API、酒店API、知识库API),容易出问题;

- 迭代速度:用户需求变化快(比如“智能客服要加‘查快递’功能”),需要快速调整prompt和代码。

总结:Agentic AI协作的“核心密码”

Agentic AI时代,提示工程架构师与开发团队的协作,本质是**“思维与行动的结合”**:

- 提示工程架构师:给AI“装脑子”——设计思考逻辑;

- 开发团队:给AI“装手脚”——搭建行动能力;

- 协作目标:让AI能“自主解决问题”。

关键的协作步骤是:

- 需求对齐:把模糊需求变成清晰的“思考逻辑”和“技术依赖”;

- prompt工程化:把思考逻辑变成可运行的代码;

- 测试验证:让思考和行动对齐;

- 迭代优化:用用户反馈让AI更聪明。

思考题:动动小脑筋

- 如果你是提示工程架构师,要设计一个“帮学生写作业的Agent”,你会设计哪些思考步骤?(提示:比如“先理解题目→查课本知识点→写草稿→检查错误”);

- 开发团队在对接工具时,遇到“API调用超时”的问题,你会怎么和提示工程架构师配合解决?(提示:比如提示工程架构师修改prompt,让AI“如果API超时,重试一次”);

- 未来的AI开发流程中,提示工程和代码开发会融合成什么样子?(提示:比如用AI生成prompt和代码,开发者只需要“确认”)。

附录:常见问题与解答

Q1:提示工程架构师需要会写代码吗?

A:最好会——因为要和开发团队沟通,理解代码的限制(比如“这个工具需要1秒响应,所以prompt里的步骤不能太多”)。如果不会写代码,至少要能看懂基础的Python代码。

Q2:开发团队需要懂提示工程吗?

A:需要——因为要把prompt的逻辑变成代码(比如“prompt里说‘查知识库’,开发团队要知道怎么调用知识库API”)。懂提示工程的开发团队,能更准确地实现思考逻辑。

Q3:Agentic AI和传统AI的区别是什么?

A:传统AI是“指令执行机”(你说什么它做什么),Agentic AI是“任务解决者”(你给目标,它自己想办法)。比如传统AI需要你说“查杭州天气→选景点→定酒店”,而Agentic AI只需要你说“帮我规划杭州旅行”。

扩展阅读 & 参考资料

- 《Agentic AI: The Future of Intelligent Systems》(Agentic AI的经典书籍);

- LangChain官方文档(https://python.langchain.com/)(学习Agent开发的最佳资源);

- 《Prompt Engineering for AI》(提示工程的入门书籍);

- Microsoft AutoGen文档(https://microsoft.github.io/autogen/)(多Agent协作的参考)。

最后:Agentic AI的协作,就像“搭乐高机器人”——没有“正确的方式”,只有“适合的方式”。提示工程架构师和开发团队要像“好朋友”一样,互相理解、互相配合,才能搭出“会思考、会行动”的AI。希望这篇文章能帮你找到“协作的说明书”,一起打造更聪明的AI!

更多推荐

已为社区贡献54条内容

已为社区贡献54条内容

所有评论(0)