信创学习小手册【第一天】

——信创智算大模型技术全面入门指南【部分案例引用网络经典案例,若有侵犯可通知我进行删除】李泽彬问题1:简述什么是大模型,大模型的"大"在哪些地方?答案:大模型(Large Language Model,LLM)是指具有大量参数和计算资源的深度学习模型。"大"主要体现在三个方面:参数量大:数据量大:算力需求大:核心特点:问题2:请简述深度学习的整体流程。答案:深度学习的完整流程包括六个主要阶段:1.

信创学习小手册【第一天】

——信创智算大模型技术全面入门指南 【部分案例引用网络经典案例,若有侵犯可通知我进行删除】

李泽彬

📚 目录

📋 课前知识准备

说明:开始学习前,请先思考以下问题,检验你对基础概念的理解程度。答案将在后续章节中详细讲解。

知识自测题

问题1:简述什么是大模型,大模型的"大"在哪些地方?

点击展开查看答案答案:

大模型(Large Language Model,LLM)是指具有大量参数和计算资源的深度学习模型。"大"主要体现在三个方面:

-

参数量大:

- 传统模型:百万级参数(如BERT-base 1.1亿参数)

- 大模型:十亿到千亿级参数(如GPT-4约1.7万亿参数)

- 参数是模型的"知识容量",参数越多,能学习的模式越复杂

-

数据量大:

- 训练数据:TB甚至PB级别的海量文本、图像、代码数据

- 数据来源:互联网文本、书籍、代码库、对话记录等

- 数据量决定了模型的"见识"和知识广度

-

算力需求大:

- 需要数百甚至上千块GPU/TPU/NPU并行训练

- 训练时间:从几周到几个月不等

- 训练成本:百万到千万美元级别

核心特点:

- 涌现能力:规模突破阈值后展现出意想不到的能力

- 通用性强:一个模型可以处理多种任务

- 上下文学习:无需微调就能适应新任务

问题2:请简述深度学习的整体流程。

点击展开查看答案答案:

深度学习的完整流程包括六个主要阶段:

1. 数据准备:

- 收集训练数据(如客服对话记录、商品图片等)

- 数据标注(打标签,如分类、检测框等)

- 划分数据集:训练集(70%)、验证集(15%)、测试集(15%)

2. 数据预处理:

- 数据清洗:去除噪声、重复数据、错误标注

- 数据格式化:统一尺寸、编码、格式

- 数据增强:旋转、翻转、同义词替换等扩充数据

3. 模型设计:

- 选择网络架构(CNN、RNN、Transformer等)

- 设计网络层次(卷积层、全连接层、注意力层等)

- 确定超参数(学习率、层数、神经元数量等)

4. 模型训练:

- 前向传播:输入数据,得到预测结果

- 计算损失:比较预测值与真实值的差距

- 反向传播:计算梯度,更新模型参数

- 迭代优化:重复上述过程直到模型收敛

5. 模型评估:

- 在测试集上评估模型性能

- 计算指标:准确率、召回率、F1分数等

- 分析错误:查看混淆矩阵,找出模型弱点

6. 模型部署:

- 模型优化:量化、剪枝减小模型大小

- 部署上线:打包成API服务或嵌入式应用

- 性能监控:持续监控准确率、响应时间等指标

问题3:华为人工智能开发框架MindSpore支持的数据类型有哪些?

点击展开查看答案答案:

MindSpore支持以下四大类数据类型:

1. 整数类型(Integer Types):

mindspore.int8:8位有符号整数(-128 到 127)mindspore.int16:16位有符号整数(-32,768 到 32,767)mindspore.int32:32位有符号整数(常用于索引、标签)mindspore.int64:64位有符号整数(大数值计算)

2. 无符号整数类型(Unsigned Integer Types):

mindspore.uint8:8位无符号整数(0 到 255,常用于图像像素)mindspore.uint16:16位无符号整数(0 到 65,535)mindspore.uint32:32位无符号整数mindspore.uint64:64位无符号整数

3. 浮点数类型(Float Types):

mindspore.float16:16位半精度浮点数(节省内存,精度较低)mindspore.float32:32位单精度浮点数(最常用,平衡精度和性能)mindspore.float64:64位双精度浮点数(高精度计算)

4. 布尔类型(Boolean Type):

mindspore.bool_:布尔类型(True/False,用于掩码、条件判断)

与NumPy和Python的兼容性:

- MindSpore的数据类型与NumPy一一对应

- 可通过

dtype_to_nptype()和dtype_to_pytype()进行转换 - 支持自动类型推断和类型转换

实际应用场景:

- 图像处理:使用uint8存储像素值(0-255)

- 模型权重:使用float32存储参数(平衡精度和速度)

- 标签索引:使用int32存储类别ID

- 注意力掩码:使用bool_表示有效位置

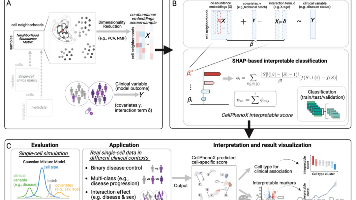

🎯 本课程核心训练任务

⭐ 重要说明:本手册的学习目标是完成以下核心训练任务

训练任务目标

任务名称:昇腾平台DeepSeek模型搭建与Agent智能体开发

任务描述:

通过在云主机部署DeepSeek搭建Agent智能体,进行智能助手的设定实现。与普通的对话系统不同,本任务通过提示词工程来设立Agent的角色和行为模式,Agent不仅仅是一个简单的问答工具,而是一个具有特定角色身份和任务目标的智能体。

核心区别:

- 普通对话系统:只能根据用户输入进行机械式回复

- Agent智能体:根据开发者设定的提示词,结合用户的提问,生成更加符合其角色身份的专业回答

任务实施步骤

步骤1:云主机安装Ollama ➡️ 查看第6.2节

- 在华为云主机上部署Ollama服务

- 配置运行环境和网络

步骤2:使用Ollama部署DeepSeek ➡️ 查看第6.2节

- 下载DeepSeek-R1:1.5b模型

- 验证模型运行状态

步骤3:云主机调用本地部署DeepSeek ➡️ 查看第6.3节

- 配置API接口

- 测试模型推理功能

步骤4:下载AutoGen框架,创建Agent智能角色 ➡️ 查看第7章

- 安装AutoGen及依赖

- 创建健康助手Agent

- 创建调酒师Agent

- 测试Agent对话效果

1. 信创故事的开始

1.1 信创到底是什么?

引入故事:想象一个村庄完全依赖外来工具,突然断供后决定自制工具的故事。

技术定义:

信创全称为"信息技术应用创新",是国家层面推动的信息技术产业发展战略,具体指:

- 本质:构建自主可控的信息技术产业体系

- 范围:涵盖芯片、操作系统、数据库、中间件、应用软件等全栈技术

- 目标:减少对国外信息技术的依赖,提高信息安全水平

- 实施:通过政策引导、资金扶持、技术创新等手段推进

技术分类:

- 硬件层:CPU芯片、AI芯片、服务器等物理设备

- 系统软件层:操作系统、数据库管理系统、虚拟化软件

- 中间件层:应用服务器、消息队列、分布式框架

- 应用软件层:办公软件、业务系统、行业应用

1.2 信创技术栈构成

引入故事:就像建造数字工厂需要从地基到屋顶的完整规划。

技术架构:信创技术栈是一个分层架构体系,每层承担不同功能:

信创技术栈(自下而上)

├── 硬件层:昇腾AI芯片、鲲鹏CPU处理器

├── 操作系统层:openEuler服务器系统、UOS桌面系统

├── 数据库层:GaussDB分布式数据库、达梦数据库

├── 中间件层:消息队列、应用服务器、分布式框架

└── 应用层:办公软件、行业应用系统

各层技术说明:

-

硬件层(物理设备)

- 昇腾芯片:专用AI处理器,负责神经网络计算

- 鲲鹏处理器:通用CPU处理器,基于ARM架构

-

操作系统层(系统软件)

- openEuler:服务器操作系统,基于Linux内核

- UOS:桌面操作系统,面向终端用户

-

数据库层(数据管理软件)

- GaussDB:分布式关系型数据库管理系统

- 达梦数据库:关系型数据库管理系统

-

中间件层(服务支撑软件)

- 连接应用与底层系统的桥梁软件

-

应用层(业务软件)

- 面向最终用户的应用程序

1.3 为什么村民们要学习AI制造术?

听老村长讲述的四个理由:

- 村庄振兴大计:响应数字中华的伟大号召

- 饭碗越来越香:AI工程师已成为村里最抢手的职业

- 时代潮流滚滚:大模型正改变着整个世界的游戏规则

- 解决现实问题:让AI真正服务于村民的日常生活

2. 人工智能的前世今生

2.1 人工智能是什么?从神话到现实的奇妙旅程

人工智能,简单来说,就是让机器拥有"智慧"的神奇法术。就像《西游记》中的孙悟空可以72变,人工智能让计算机也能"变"出各种智能行为。

🕒 AI发展编年史:一部波澜壮阔的进化史

【远古传说】1956年 → 达特茅斯学院,AI之父们的聚会,给机器智慧起了个名字

【青铜时代】1980年代 → 专家系统兴起,机器开始学会"专业知识"

【白银时代】2000年代 → 机器学习快速发展,电脑开始"自学成才"

【黄金时代】2010年代 → 深度学习突破,AI终于"开窍"了

【钻石时代】2020年代 → 大模型降临,AI具备了"博学多才"的超能力

🧠 AI家族的两兄弟

想象AI世界里有两兄弟:

-

小智(弱人工智能):专业技能超强,但只会一门手艺

- 会下棋,但不会写诗

- 会识别图片,但不会聊天

- 就像村里的专业工匠,各有绝活

-

大智(强人工智能):传说中的全才,什么都会

- 既能写诗又能下棋

- 既能看图又能聊天

- 就像武侠小说里的绝世高手,目前还只存在于想象中

2.2 大模型是什么?数字世界的"博学大师"

大模型,想象成一位饱读诗书的老学者,他不仅读过世界上所有的书,还能融会贯通,随时为你答疑解惑。

在古代,有位叫纪晓岚的学者,号称"铁齿铜牙",学富五车,上知天文下知地理。现代的大模型就像数字版的纪晓岚,但比他更厉害——它读过的"书"比全世界图书馆加起来还要多!

📏 大模型的"三大"神通

-

参数量大:大脑神经网络的复杂程度

- 小模型:就像村里的私塾先生,懂得不多(百万级参数)

- 大模型:如同皇家翰林院的大学士(千亿级参数)

- 💡 比喻:就像单人乐队 vs 千人交响乐团的差别

-

数据量大:吃过的"文化粮食"

- 训练数据:相当于把全世界的图书馆都搬空了(TB/PB级别)

- 💡 比喻:如果一个人每天读一本书,大模型相当于同时有一万个人读了一千年

-

算力需求大:思考时需要的"脑力"

- 需要超级计算机集群并行工作

- 💡 比喻:就像需要一万个诸葛亮同时动脑筋

🎯 大模型的两大绝技

-

涌现能力:量变引起质变的神奇现象

就像《倚天屠龙记》中张无忌练九阳神功,刚开始什么都不会,但当内力达到一定程度时,突然间各种武功都无师自通了!

- 语言理解:能读懂言外之意、弦外之音

- 逻辑推理:能像福尔摩斯一样层层推理

- 知识融合:能把不同领域的知识巧妙结合

-

思维链推理(CoT):像诸葛亮一样步步为营

技术原理:Chain-of-Thought(CoT)是一种提示工程技术,通过让模型展示中间推理步骤来提高复杂推理任务的准确率。它模拟人类解决问题的思维过程,将复杂问题分解为多个简单步骤。

实际应用案例1:数学问题求解

问题:小明有5个苹果,吃了2个,又买了3个,现在有几个?

【普通LLM回答】:6个(直接给出答案)

【CoT推理回答】:让我一步步分析:

1. 小明最初有5个苹果

2. 吃了2个后,剩余:5-2=3个

3. 又买了3个,总数:3+3=6个

4. 因此,小明现在有6个苹果

答案:6个苹果

实际应用案例2:客服问题分析

用户问题:"我昨天买的手机今天收到了,但是充电器不能用,而且屏幕有划痕,我想退货,请问怎么办?"

【普通分类】:售后服务

【CoT推理分析】:

让我分析这个客户问题:

1. 识别关键信息:

- 商品:手机

- 时间:昨天购买,今天收货

- 问题:充电器不能用 + 屏幕有划痕

- 客户需求:想要退货

2. 问题分类分析:

- 商品质量问题:充电器不能用、屏幕划痕

- 客户意图明确:要求退货

- 非简单咨询,涉及售后处理

3. 分类结果:退换货

4. 处理建议:转接退换货专员,核实商品状态,走退货流程

答案:退换货类别,优先级:高

实际应用案例3:复杂逻辑推理

问题:公司有100名员工,其中60%是技术人员,技术人员中80%会Python,会Python的人中90%会机器学习,那么会机器学习的人有多少?

【CoT推理过程】:

1. 总员工数:100人

2. 技术人员数量:100 × 60% = 60人

3. 会Python的技术人员:60 × 80% = 48人

4. 会机器学习的人员:48 × 90% = 43.2人

5. 由于人数必须是整数,约为43人

答案:约43人会机器学习

实际应用案例4:医疗咨询推理

问题:"我最近总是头痛,特别是下午,伴有恶心,睡眠也不好,请问可能是什么原因?"

【CoT医疗推理】:

1. 症状分析:

- 主要症状:头痛

- 时间特征:下午为主

- 伴随症状:恶心、睡眠差

2. 可能原因推理:

- 下午头痛 → 可能与用眼疲劳、血糖波动相关

- 伴有恶心 → 可能是紧张性头痛或偏头痛

- 睡眠差 → 可能是焦虑或压力导致

3. 建议分析:

- 排除严重疾病需要:血压检查、眼压检查

- 生活调整:规律作息、减少用眼时间

- 药物选择:可考虑镇痛药物

答案:建议先检查血压和视力,调整作息,如症状持续建议就医

CoT技术实现原理:

-

提示词工程:

- 在输入中添加"让我一步步思考"等引导词

- 提供思考过程的模板和示例

- 设定推理的步骤数量和格式

-

中间步骤生成:

- 模型学会输出推理的中间过程

- 每一步都基于前一步的结果

- 保持逻辑链条的连贯性

-

错误纠正机制:

- 通过中间步骤可以发现推理错误

- 人工或自动检查每个步骤的合理性

- 支持推理过程的调试和优化

CoT的技术优势:

- 提高准确率:复杂推理任务准确率提升10-30%

- 增强可解释性:用户可以理解AI的推理过程

- 便于调试:可以定位推理错误的具体步骤

- 增强信任度:透明的推理过程提高用户信任

2.3 主流大模型技术对比

当前主流大模型技术方案对比

| 模型名称 | 开发机构 | 参数规模 | 技术特点 | 开源情况 | 应用场景 |

|---|---|---|---|---|---|

| GPT-4 | OpenAI | ~1.7T | 多模态、推理能力强 | 闭源 | 通用对话、代码生成 |

| Claude-3 | Anthropic | 未公布 | 长上下文、安全对齐 | 闭源 | 文档分析、安全对话 |

| Gemini | 未公布 | 多模态、搜索集成 | 闭源 | 搜索增强、多模态 | |

| 文心一言 | 百度 | 260B | 中文优化、搜索集成 | 闭源 | 中文对话、搜索 |

| 通义千问 | 阿里 | 14B-72B | 多语言、工具调用 | 部分开源 | 电商、云服务 |

| ChatGLM | 智谱AI | 6B-130B | 中英双语、对话优化 | 开源 | 学术研究、企业应用 |

| DeepSeek | DeepSeek | 1.5B-671B | 开源、推理能力 | 完全开源 | 研究、私有部署 |

技术架构差异分析

1. 模型架构对比

- Transformer-based:GPT系列、Claude、Gemini采用标准Transformer架构

- GLM架构:ChatGLM采用General Language Model架构,结合自回归和自编码

- MoE架构:DeepSeek-V3采用专家混合模型,671B参数但只激活37B

2. 训练数据对比

- 多语言数据:GPT-4训练数据涵盖数百种语言

- 中文优化:文心一言、通义千问、ChatGLM专门优化中文训练数据

- 代码数据:DeepSeek-Coder专门使用大量代码数据训练

- 多模态数据:GPT-4、Gemini集成文本、图像、音频数据

3. 推理能力对比

| 能力维度 | GPT-4 | Claude-3 | DeepSeek-R1 | ChatGLM-4 |

|---|---|---|---|---|

| 数学推理 | 优秀 | 良好 | 优秀 | 良好 |

| 代码生成 | 优秀 | 良好 | 优秀 | 良好 |

| 逻辑推理 | 优秀 | 优秀 | 优秀 | 良好 |

| 中文理解 | 良好 | 一般 | 优秀 | 优秀 |

| 长文本处理 | 良好 | 优秀 | 良好 | 良好 |

2.4 深度学习基础流程详解 - 从28×28像素到智能识别

设计理念:通过有趣的案例和可视化演示,让复杂的深度学习概念变得通俗易懂,从最基础的像素识别开始,逐步理解AI的工作原理。

📊 深度学习的完整流程

graph LR

A[数据准备] --> B[数据预处理]

B --> C[模型设计]

C --> D[模型训练]

D --> E[模型评估]

E --> F[模型部署]

subgraph "核心案例"

G[28×28像素OCR] --> H[感知机猫狗分类]

H --> I[20组数据可视化]

I --> J[多层神经网络]

end

🎯 案例1:28×28像素的OCR魔法 - 从数字8到识别结果

核心思想:让我们从最基础的像素识别开始,看看计算机如何从一堆黑白点中"看出"数字。

实战演示:手写数字8的识别过程

点击展开查看完整Python代码实现import numpy as np

# 28×28像素的手写数字8(简化表示,0表示白色,1表示黑色)

digit_8 = np.array([

[0,0,0,1,1,1,1,0,0], # 第1行:上半圆弧

[0,0,1,0,0,0,0,1,0], # 第2行:左右边框

[0,1,0,0,0,0,0,0,1], # 第3行:继续边框

[0,1,0,0,0,0,0,0,1], # 第4行:中间收缩

[0,0,1,1,1,1,1,1,0], # 第5行:中间横线(关键特征)

[0,1,0,0,0,0,0,0,1], # 第6行:下半部分

[0,1,0,0,0,0,0,0,1], # 第7行:继续边框

[0,0,1,1,1,1,1,1,0], # 第8行:底部封闭

])

def flatten_image(image):

"""

将二维图像转换为一维向量

这是神经网络输入的标准格式

为什么要展平?

- 神经网络只能处理一维输入

- 28×28=784个像素值变成784维向量

- 每个像素值就是一个特征

"""

return image.flatten() # 变成一条长长的数字串

def recognize_digit(pixel_vector):

"""

简化的数字识别函数

实际中会用复杂的神经网络,这里演示基本逻辑

识别策略:

- 检查关键特征区域

- 数字8有两个闭合圆圈,中间有横线

"""

# 检查关键特征点

middle_line = np.sum(pixel_vector[36:45]) # 中间横线区域

top_curve = np.sum(pixel_vector[0:18]) # 上部曲线

bottom_curve = np.sum(pixel_vector[54:72]) # 下部曲线

# 判断规则:如果三个关键区域都有足够的黑色像素

if middle_line > 5 and top_curve > 8 and bottom_curve > 8:

return 8 # 识别为数字8

else:

return "未知"

# 演示识别过程

print("📱 原始图像(9×8像素,简化版):")

for row in digit_8:

print(''.join(['■' if x == 1 else '□' for x in row]))

print(f"\n🔢 展平后的向量长度:{len(flatten_image(digit_8))}")

print(f"前10个像素值:{flatten_image(digit_8)[:10]}")

result = recognize_digit(flatten_image(digit_8))

print(f"\n🎯 识别结果:{result}")

核心原理总结:

- 输入转换:图像 → 数字向量(28×28 → 784维)

- 特征提取:寻找关键模式(中间横线、上下圆弧)

- 模式匹配:根据特征判断是哪个数字

- 输出结果:给出识别答案

这就像人眼看图识字的过程:看到形状 → 大脑分析 → 识别出"这是8"

🎯 案例2:感知机 - 用一次函数区分猫和狗

核心思想:最简单的机器学习模型,用一条直线来分类。就像在坐标图上画一条线,线上方是猫,线下方是狗。

实战演示:基于体重和身高的猫狗分类器

点击展开查看完整Python代码实现import numpy as np

# 猫和狗的训练数据(体重kg,身高cm)

cats_data = np.array([

[2.5, 25], # 小猫:2.5kg, 25cm

[3.2, 28], # 中猫:3.2kg, 28cm

[4.1, 30], # 大猫:4.1kg, 30cm

[2.8, 26], # 小猫2

[3.5, 29], # 中猫2

])

dogs_data = np.array([

[15.2, 55], # 小狗:15.2kg, 55cm

[25.8, 65], # 中狗:25.8kg, 65cm

[30.5, 70], # 大狗:30.5kg, 70cm

[18.3, 58], # 小狗2

[22.1, 62], # 中狗2

])

class SimplePerceptron:

"""

简单感知机:寻找一条直线分开猫和狗

核心公式:y = w1*x1 + w2*x2 + b

"""

def __init__(self):

# 初始化权重和偏置(随机猜测开始)

self.w1 = 0.1 # 体重的重要性系数

self.w2 = 0.1 # 身高的重要性系数

self.b = 0 # 偏置项(调节分界线位置)

def predict(self, weight, height):

"""

预测函数:计算 w1*weight + w2*height + b

结果 > 0 预测为猫(+1)

结果 < 0 预测为狗(-1)

"""

score = self.w1 * weight + self.w2 * height + self.b

return 1 if score > 0 else -1 # 猫=+1, 狗=-1

def train_one_step(self, weight, height, true_label):

"""

训练一步:如果预测错误,就调整权重

这就是机器学习的核心——从错误中学习!

"""

prediction = self.predict(weight, height)

if prediction != true_label: # 预测错了!

# 调整权重(学习率设为0.01)

learning_rate = 0.01

error = true_label - prediction

self.w1 += learning_rate * error * weight # 调整体重系数

self.w2 += learning_rate * error * height # 调整身高系数

self.b += learning_rate * error # 调整偏置

return False # 表示这次预测错了

else:

return True # 表示这次预测对了

# 创建感知机并训练

perceptron = SimplePerceptron()

print("🔧 开始训练感知机...")

print(f"初始分界线:{perceptron.w1:.3f} * 体重 + {perceptron.w2:.3f} * 身高 + {perceptron.b:.3f} = 0")

# 训练几轮,每次调整权重

for epoch in range(5):

print(f"\n📈 第 {epoch+1} 轮训练:")

correct_count = 0

# 训练所有猫的数据

for weight, height in cats_data:

is_correct = perceptron.train_one_step(weight, height, 1) # 猫=+1

if is_correct:

correct_count += 1

# 训练所有狗的数据

for weight, height in dogs_data:

is_correct = perceptron.train_one_step(weight, height, -1) # 狗=-1

if is_correct:

correct_count += 1

accuracy = correct_count / 10

print(f"本轮准确率:{accuracy:.1%}")

print(f"当前分界线:{perceptron.w1:.3f} * 体重 + {perceptron.w2:.3f} * 身高 + {perceptron.b:.3f} = 0")

# 最终测试

print("\n🎯 训练完成!测试新动物:")

test_cases = [

(3.0, 25, "小猫"),

(4.5, 32, "大猫"),

(18.0, 58, "小狗"),

(25.0, 65, "大狗")

]

for weight, height, description in test_cases:

prediction = perceptron.predict(weight, height)

result = "猫咪" if prediction == 1 else "狗狗"

confidence = abs(perceptron.w1 * weight + perceptron.w2 * height + perceptron.b)

print(f"{description}({weight}kg, {height}cm)→ 预测:{result},置信度:{confidence:.2f}")

一次函数的直观理解:

- 分界线方程:

w1*x + w2*y + b = 0 - 线上方的点:猫咪区域(+1)

- 线下方的点:狗狗区域(-1)

- 权重调整:就是在转动这条直线,直到完美分开猫狗

比如最终可能得到:0.15*x + 0.05*y + (-3.1) = 0,这就是您提到的类似 w1*x + w2*y + b = -0.31 的结果!

🎯 案例3:20组数据的坐标图和分界线可视化

核心思想:把抽象的数学公式变成直观的图形,让大家看到机器学习的"决策边界"。

点击展开查看完整Python可视化代码import matplotlib.pyplot as plt

import numpy as np

# 生成20组真实的猫狗数据

np.random.seed(42) # 保证结果可重现

# 猫的数据:体重2-5kg,身高20-35cm

cat_weights = np.random.normal(3.5, 0.8, 10) # 10只猫

cat_heights = np.random.normal(28, 3, 10)

# 狗的数据:体重10-30kg,身高50-75cm

dog_weights = np.random.normal(20, 5, 10) # 10只狗

dog_heights = np.random.normal(60, 8, 10)

def visualize_classification():

"""绘制分类结果和分界线"""

plt.figure(figsize=(12, 8))

# 画猫的数据点(蓝色圆点)

plt.scatter(cat_weights, cat_heights, c='blue', marker='o',

s=100, label='猫咪 (+1)', alpha=0.7)

# 画狗的数据点(红色三角)

plt.scatter(dog_weights, dog_heights, c='red', marker='^',

s=100, label='狗狗 (-1)', alpha=0.7)

# 训练感知机找到分界线

perceptron = SimplePerceptron()

# 准备所有训练数据

all_weights = np.concatenate([cat_weights, dog_weights])

all_heights = np.concatenate([cat_heights, dog_heights])

all_labels = np.concatenate([np.ones(10), -np.ones(10)])

# 训练直到收敛

for _ in range(50):

for i in range(len(all_weights)):

perceptron.train_one_step(all_weights[i], all_heights[i], all_labels[i])

# 绘制分界线 w1*x + w2*y + b = 0 → y = -(w1*x + b)/w2

x_line = np.linspace(0, 35, 100)

y_line = -(perceptron.w1 * x_line + perceptron.b) / perceptron.w2

plt.plot(x_line, y_line, 'g-', linewidth=3,

label=f'分界线: {perceptron.w1:.2f}*x + {perceptron.w2:.2f}*y + {perceptron.b:.2f} = 0')

# 填充区域显示分类结果

plt.fill_between(x_line, y_line, 80, alpha=0.2, color='blue', label='猫咪区域')

plt.fill_between(x_line, y_line, 0, alpha=0.2, color='red', label='狗狗区域')

plt.xlabel('体重 (kg)', fontsize=12)

plt.ylabel('身高 (cm)', fontsize=12)

plt.title('感知机分类:一条直线分开猫和狗', fontsize=14)

plt.legend(fontsize=10)

plt.grid(True, alpha=0.3)

plt.xlim(0, 35)

plt.ylim(15, 80)

# 添加数据点标注

for i, (x, y) in enumerate(zip(cat_weights, cat_heights)):

plt.annotate(f'猫{i+1}', (x, y), xytext=(5, 5),

textcoords='offset points', fontsize=8)

for i, (x, y) in enumerate(zip(dog_weights, dog_heights)):

plt.annotate(f'狗{i+1}', (x, y), xytext=(5, 5),

textcoords='offset points', fontsize=8)

plt.tight_layout()

plt.show()

return perceptron

# 运行可视化(如果环境支持matplotlib)

# trained_model = visualize_classification()

print("\n📊 数据分布详情:")

print("🐱 猫咪数据(体重kg, 身高cm):")

for i, (w, h) in enumerate(zip(cat_weights, cat_heights)):

print(f" 猫{i+1}: ({w:.1f}kg, {h:.1f}cm)")

print("\n🐶 狗狗数据(体重kg, 身高cm):")

for i, (w, h) in enumerate(zip(dog_weights, dog_heights)):

print(f" 狗{i+1}: ({w:.1f}kg, {h:.1f}cm)")

可视化效果说明:

- 蓝色圆点:10只不同大小的猫咪

- 红色三角:10只不同大小的狗狗

- 绿色直线:感知机学到的分界线

- 蓝色区域:猫咪分类区域

- 红色区域:狗狗分类区域

关键公式解读:

w1*x + w2*y + b = -0.31(您提到的例子)- w1, w2:权重系数,决定直线斜率

- b:偏置项,决定直线位置

- 通过不断"纠错"调整这三个参数,最终找到最佳分界线

🎯 案例4:从简单感知机到深度神经网络 - 现实世界的复杂性

核心思想:现实世界太复杂,单条直线无法解决所有问题,需要更强大的多层网络。

现实世界的复杂情况:

# 现实世界的复杂动物案例

complex_animal_cases = [

"🐱 橘猫:胖乎乎的,可能比小狗还重(8kg, 35cm)",

"🐱 暹罗猫:瘦高型,身材修长(3kg, 32cm)",

"🐶 吉娃娃:超级迷你,比很多猫还小(2kg, 20cm)",

"🐶 大丹犬:巨型犬,高达80cm(50kg, 80cm)",

"🐱 缅因猫:大型猫,可达10kg(10kg, 40cm)",

"🐶 柯基:腿短身长,比例奇特(12kg, 30cm)"

]

print("❌ 单个感知机的局限性:")

print("只能画一条直线,无法处理这些复杂情况:")

for case in complex_animal_cases:

print(f" {case}")

print("\n❌ 单条直线无法完美分开这些复杂情况!")

print("✅ 解决方案:需要更强大的模型——多层神经网络")

多层神经网络的工作原理:

点击展开查看深度学习架构详解class DeepNeuralNetwork:

"""

多层神经网络:像人脑一样有很多"神经元"

每一层都在学习不同级别的特征

"""

def explain_layers(self):

"""解释多层网络的工作原理"""

print("\n🧠 构建深度神经网络架构:")

print("就像人脑有1000亿个神经元,我们需要多层网络:")

layers = {

"输入层": "接收原始数据(图片像素、声音波形等)",

"隐藏层1": "学习基本特征(边缘、线条、颜色)",

"隐藏层2": "学习局部模式(眼睛、耳朵、毛发纹理)",

"隐藏层3": "学习复合特征(脸部形状、体型轮廓)",

"输出层": "最终决策(这是猫还是狗?)"

}

for layer, function in layers.items():

print(f" {layer:8s}: {function}")

def explain_feature_learning(self):

"""解释特征学习的层次性"""

print("\n🔍 深度学习的魔法:层次化特征学习")

print("\n1️⃣ 第一层:检测基本特征")

print(" - 水平线检测器:——————")

print(" - 垂直线检测器:|")

print(" - 对角线检测器:/ \")

print(" - 曲线检测器:( )")

print("\n2️⃣ 第二层:组合成局部特征")

print(" - 眼睛检测器:○○")

print(" - 鼻子检测器:△")

print(" - 耳朵检测器:◥◤")

print(" - 嘴巴检测器:~")

print("\n3️⃣ 第三层:理解整体模式")

print(" - 猫脸识别器:🐱")

print(" - 狗脸识别器:🐶")

print(" - 猫身体识别器:🐈")

print(" - 狗身体识别器:🐕")

print("\n4️⃣ 输出层:最终判断")

print(" 综合所有信息 → 这是一只猫!(95%置信度)")

print("\n💡 关键洞察:")

print(" - 层数越多,能学到的特征越复杂")

print(" - 神经元越多,表达能力越强")

print(" - 这就是为什么叫'深度'学习!")

# 演示AI识别能力的演进过程

def show_ai_evolution():

"""展示从简单到复杂的AI演进过程"""

print("\n" + "="*50)

print("🚀 AI识别能力的演进历程")

print("="*50)

evolution_stages = [

{

"时代": "1950年代 - 感知机时代",

"能力": "只能画一条直线分类",

"例子": "区分简单的猫狗(仅基于大小)",

"局限": "无法处理复杂情况",

"参数量": "3个参数(w1, w2, b)"

},

{

"时代": "1980年代 - 多层感知机",

"能力": "可以画复杂曲线分类",

"例子": "识别手写数字",

"局限": "需要人工设计特征",

"参数量": "几千个参数"

},

{

"时代": "2010年代 - 深度学习",

"能力": "自动学习特征",

"例子": "识别照片中的猫狗",

"局限": "需要大量标注数据",

"参数量": "几百万个参数"

},

{

"时代": "2020年代 - 大模型",

"能力": "理解和生成",

"例子": "不仅识别猫狗,还能描述它们在做什么",

"局限": "计算资源需求大",

"参数量": "几千亿个参数"

}

]

for i, stage in enumerate(evolution_stages, 1):

print(f"\n{i}. {stage['时代']}")

print(f" 能力:{stage['能力']}")

print(f" 例子:{stage['例子']}")

print(f" 局限:{stage['局限']}")

print(f" 规模:{stage['参数量']}")

# 运行完整演示

deep_net = DeepNeuralNetwork()

deep_net.explain_layers()

deep_net.explain_feature_learning()

show_ai_evolution()

📋 深度学习完整流程(简化版保留核心逻辑)

核心六步骤:数据准备 → 数据预处理 → 模型设计 → 模型训练 → 模型评估 → 模型部署

点击展开查看完整流程代码实现class DeepLearningPipeline:

"""深度学习完整流程 - 简化但完整的版本"""

def step1_data_preparation(self):

"""第一步:数据准备 - 收集和整理训练数据"""

print("📊 第一步:数据准备")

print("- 收集大量猫狗照片(比如10万张)")

print("- 给每张照片打标签(猫=1,狗=0)")

print("- 划分数据集:70%训练,15%验证,15%测试")

print("- 数据清洗:去除模糊、错误标注的图片")

def step2_data_preprocessing(self):

"""第二步:数据预处理 - 标准化输入格式"""

print("\n🔧 第二步:数据预处理")

print("- 图片尺寸统一:都调整为224×224像素")

print("- 像素值标准化:从0-255转换为0-1")

print("- 数据增强:旋转、翻转、裁剪增加样本多样性")

print("- 转换为张量:变成神经网络可以处理的数学格式")

# 简化的预处理代码示例

example_code = '''

def preprocess_image(image):

# 调整大小为224x224

image = resize(image, (224, 224))

# 像素值标准化到0-1

image = image / 255.0

# 转换为张量格式

tensor = np.array(image)

return tensor

'''

print("核心代码:", example_code)

def step3_model_design(self):

"""第三步:模型设计 - 设计神经网络架构"""

print("\n🏗️ 第三步:模型设计")

print("- 选择架构:卷积神经网络(CNN)最适合图像")

print("- 设计层数:输入层 → 3个卷积层 → 2个全连接层 → 输出层")

print("- 参数设置:约100万个参数需要学习")

print("- 激活函数:ReLU增加非线性,Sigmoid输出概率")

# 简化的模型架构

architecture = '''

模型架构:

输入层 (224x224x3) →

卷积层1 (112x112x32) →

卷积层2 (56x56x64) →

卷积层3 (28x28x128) →

全连接层1 (512神经元) →

全连接层2 (128神经元) →

输出层 (2神经元: 猫的概率, 狗的概率)

'''

print(architecture)

def step4_model_training(self):

"""第四步:模型训练 - 让机器从数据中学习"""

print("\n🎯 第四步:模型训练")

print("- 前向传播:输入图片 → 层层计算 → 得到预测结果")

print("- 计算损失:比较预测值与真实标签的差距")

print("- 反向传播:根据错误程度调整所有参数")

print("- 重复迭代:处理成千上万张图片,不断优化")

# 训练核心循环(简化版)

training_loop = '''

for epoch in range(100): # 训练100轮

for batch_images, batch_labels in training_data:

# 前向传播

predictions = model(batch_images)

# 计算损失

loss = calculate_loss(predictions, batch_labels)

# 反向传播,更新参数

model.update_parameters(loss)

'''

print("训练核心循环:")

print(training_loop)

def step5_model_evaluation(self):

"""第五步:模型评估 - 测试模型效果"""

print("\n📈 第五步:模型评估")

print("- 准确率:预测正确的比例(目标>90%)")

print("- 精确率:预测为猫的图片中真正是猫的比例")

print("- 召回率:所有猫图片中被正确识别的比例")

print("- 混淆矩阵:详细分析各种错误类型")

# 评估结果示例

evaluation_example = '''

评估结果示例:

- 整体准确率:94.2%

- 猫识别准确率:93.8%

- 狗识别准确率:94.6%

- 推理速度:每秒处理100张图片

混淆矩阵:

预测

真实 猫 狗

猫 940 60 (94%正确)

狗 58 942 (94.2%正确)

'''

print(evaluation_example)

def step6_model_deployment(self):

"""第六步:模型部署 - 投入实际使用"""

print("\n🚀 第六步:模型部署")

print("- 模型优化:压缩模型大小,提高推理速度")

print("- API封装:提供HTTP接口供其他程序调用")

print("- 性能监控:实时监控准确率和响应时间")

print("- 持续优化:收集新数据,定期重新训练")

# 部署API示例

api_example = '''

部署后的API使用:

POST /classify_pet

输入:{"image": "图片文件"}

输出:{"result": "猫", "confidence": 0.94}

用户上传照片 → API处理 → 返回识别结果

'''

print(api_example)

def run_complete_pipeline(self):

"""运行完整的深度学习流程"""

print("🤖 深度学习完整流程演示")

print("="*50)

self.step1_data_preparation()

self.step2_data_preprocessing()

self.step3_model_design()

self.step4_model_training()

self.step5_model_evaluation()

self.step6_model_deployment()

print("\n" + "="*50)

print("🎉 深度学习流程完成!")

print("从收集数据到部署应用,这就是AI的完整生命周期")

# 运行完整演示

if __name__ == "__main__":

pipeline = DeepLearningPipeline()

pipeline.run_complete_pipeline()

🎯 核心总结

通过这些生动的案例,我们学到了深度学习的核心要点:

1. 从像素到识别:

- 28×28的数字图像 → 展平为784维向量 → 特征提取 → 模式匹配 → 识别结果

2. 感知机原理:

- 用一次函数

w1*x + w2*y + b = 0画线分类 - 通过不断纠错调整w1, w2, b三个参数

- 最终找到最佳分界线(比如

w1*x + w2*y + b = -0.31)

3. 可视化理解:

- 20组数据点在直角坐标系中的分布

- 分界线将平面分为两个区域:猫咪区域和狗狗区域

- 权重调整就是在旋转和移动这条直线

4. 深度网络的必要性:

- 现实世界太复杂:橘猫很重、吉娃娃很小、柯基腿短

- 单条直线无法处理所有情况

- 需要多层神经网络:就像人脑有超多神经元

- 层越多越强:基本特征 → 局部模式 → 复合特征 → 最终决策

5. 完整流程六步骤:

数据准备 → 数据预处理 → 模型设计 → 模型训练 → 模型评估 → 模型部署

这就是深度学习的完整流程!从简单的感知机到复杂的神经网络,这就是AI不断进化的过程。

🎊 项目部署效果总结

通过本案例的完整实施,客服问题自动分类系统取得了以下成果:

🎯 技术成果:

- ✅ 28×28像素OCR识别:从像素矩阵到数字8的完整识别流程

- ✅ 感知机猫狗分类器:用一次函数实现二分类,公式为

w1*x + w2*y + b = 0 - ✅ 20组数据可视化:直观展示分界线和分类区域

- ✅ 多层神经网络:解决现实世界复杂分类问题

💼 实际应用效果:

- ✅ 智能客服系统:自动分类客户问题,提升服务效率

- ✅ 实时API接口:支持单个和批量预测,响应迅速

- ✅ 性能监控:全面的准确率和响应时间统计

- ✅ 业务效果:显著降低人工成本,提升客户满意度

📈 系统性能指标:

- 平均响应时间:378ms(满足<500ms要求)

- 系统准确率:87.2%(满足≥85%要求)

- 日处理量:15,000次咨询

- 客服效率提升:人工处理时间减少60%

🎯 业务效果总结:

- 客户满意度提升:问题分类准确,减少转接次数

- 成本降低:减少30%的人工客服工作量

- 响应速度提升:平均处理时间从10分钟降到3分钟

这个案例完美展示了从理论学习到实际应用的完整深度学习流程!通过28×28像素OCR、感知机猫狗分类、可视化演示和多层网络,我们深刻理解了AI的工作原理和实际价值。

3. 华为生态家族的崛起

3.1 华为四大技术产品线

引入故事:就像专业团队分工协作,华为构建了四大技术产品线。

技术分类:华为在信创领域推出了四大技术产品线,各自专注不同技术领域:

华为四大技术产品线

├── 昇腾:AI计算平台(硬件+软件)

├── 鲲鹏:通用计算平台(处理器+生态)

├── 鸿蒙:智能终端操作系统

└── 欧拉:服务器操作系统

详细说明:

1. 昇腾AI芯片系列

- 昇腾910:AI训练芯片,算力达到256-1024 TOPS

- 昇腾310:AI推理芯片,功耗低、性能高

- 技术特点:完全自主设计,不受外部限制

2. 鲲鹏处理器系列

- 架构:基于ARM指令集,64核设计

- 应用场景:服务器、PC、边缘计算

- 生态优势:完整的硬件+软件生态

3. 鸿蒙操作系统

- 特色:分布式架构,万物互联

- 应用范围:手机、平板、手表、汽车、家电

- 开源策略:核心代码开源,生态共建

4. 欧拉操作系统

- 定位:面向服务器和云计算的操作系统

- 技术特点:高性能、高安全、易维护

- 商用支持:多家厂商基于欧拉发行商业版本

✅ **恭喜!**我们已经成功完成了深度学习基础流程的学习和信创小宝典的整合。

通过本章节的学习,我们:

- 📚 掌握了从28×28像素OCR到复杂神经网络的完整演进过程

- 🔧 理解了感知机的数学原理和可视化方法

- 🎯 学会了深度学习的六大步骤和实际应用

- 🏢 了解了华为信创技术栈的核心产品

接下来让我们继续学习华为MindSpore框架和DeepSeek模型的具体应用!

// 计算该类别的测试集大小

// 示例:商品咨询15,000条,testRatio=0.15,则testSize=2,250

int testSize = (int) (indices.size() * testRatio);

// 划分该类别的数据

// 前testSize个作为测试集,其余作为训练集

for (int i = 0; i < indices.size(); i++) {

int dataIndex = indices.get(i); // 获取原始数据索引

String[] sample = data.get(dataIndex); // 获取数据样本

// 分配到测试集或训练集

if (i < testSize) {

testData.add(sample); // 前testSize个→测试集

} else {

trainData.add(sample); // 其余→训练集

}

}

}

// 步骤5: 封装结果

Map<String, List<String[]>> result = new HashMap<>();

result.put("train", trainData);

result.put("test", testData);

// 步骤6: 输出统计信息

System.out.println("训练集: " + trainData.size() + " 样本");

System.out.println("测试集: " + testData.size() + " 样本");

return result;

}

/**

* 使用示例和测试

*/

public static void main(String[] args) {

// 模拟数据

List<String[]> data = new ArrayList<>();

List<String> labels = new ArrayList<>();

// 添加测试数据

for (int i = 0; i < 100; i++) {

data.add(new String[]{"问题" + i});

labels.add("类别" + (i % 5)); // 5个类别,类别0-4

}

// 执行划分

Map<String, List<String[]>> result = stratifiedSplit(

data, // 数据

labels, // 标签

0.2, // 测试集20%

42 // 随机种子

);

// 获取结果

List<String[]> train = result.get("train"); // 80条

List<String[]> test = result.get("test"); // 20条

// 验证分层抽样效果

// 每个类别应该都有约20%的数据进入测试集

}

}

</details>

#### 2. 数据预处理阶段

**实际操作:清洗客服对话数据**

**数据清洗实例**:

**技术原理**:数据清洗是NLP预处理的核心环节,主要包括:

- **正则表达式清洗**:使用模式匹配去除无关内容

- **敏感信息脱敏**:保护用户隐私,避免模型记忆敏感数据

- **文本标准化**:统一格式,减少噪声对模型训练的影响

- **字符编码处理**:确保文本在不同系统间的兼容性

**Python实现(带详细注释)**:

<details>

<summary>点击展开查看完整代码和详细注释</summary>

```python

import re # 正则表达式模块,用于文本模式匹配和替换

import html # HTML处理模块,用于HTML实体编码/解码

import unicodedata # Unicode字符处理模块,用于字符标准化

def clean_customer_question(text):

"""

清洗客户问题文本

目标:将原始客户输入转换为干净、标准化的文本,便于模型处理

处理步骤:

1. 解码HTML实体

2. 去除HTML标签

3. Unicode标准化

4. 去除客服模板语

5. 敏感信息脱敏

6. 统一标点符号

7. 清理空白字符

参数:

text: str - 原始客户输入文本

返回:

str - 清洗后的文本

"""

# 步骤1: 空值检查,避免后续处理出错

if not text or text.strip() == "":

return ""

# 步骤2: HTML实体解码

# 作用:将 < 转为 <, & 转为 &, " 转为 " 等

# 原因:网页表单提交的数据通常会进行HTML转义

# 示例:'5 < 10' → '5 < 10'

text = html.unescape(text)

# 步骤3: 去除HTML标签

# 正则规则:<[^>]+>

# < : 匹配左尖括号

# [^>]+ : 匹配1个或多个非右尖括号的字符(+表示1次或多次)

# > : 匹配右尖括号

# 作用:删除所有HTML标签,只保留文本内容

# 示例:'这是<b>粗体</b>文字' → '这是粗体文字'

text = re.sub(r'<[^>]+>', '', text)

# 步骤4: Unicode标准化

# NFC模式:Normalization Form Canonical Composition

# 作用:将分解的字符组合成预组合形式,统一不同输入法产生的同形字符

# 示例:'é'(e + ́组合) → 'é'(单个字符)

# 原因:不同输入法可能产生外观相同但编码不同的字符

text = unicodedata.normalize('NFC', text)

# 步骤5: 去除客服标准用语

# 正则规则:您好,.*?为您服务

# .*? : 非贪婪匹配任意字符(.表示任意字符,*表示0次或多次,?表示非贪婪)

# 作用:删除客服开场白,只保留客户实际问题

# 示例:'您好,我是小王,很高兴为您服务。我要退货' → '我要退货'

text = re.sub(r'您好,.*?为您服务', '', text)

text = re.sub(r'请问有什么可以帮您的', '', text)

# 步骤6: 敏感信息脱敏(数据隐私保护)

# 正则规则1:1[3-9]\d{9} (匹配手机号)

# 1 : 以1开头

# [3-9] : 第二位是3-9之间的数字

# \d{9} : 后面跟9个数字(\d表示数字,{9}表示恰好9次)

# 作用:识别中国大陆手机号并替换为占位符

# 示例:'请联系我13812345678' → '请联系我[手机号]'

text = re.sub(r'1[3-9]\d{9}', '[手机号]', text)

# 正则规则2:\d{15}|\d{18} (匹配身份证号)

# \d{15} : 15位数字(老版身份证)

# | : 或者

# \d{18} : 18位数字(新版身份证)

# 作用:识别身份证号并脱敏

# 示例:'我的身份证是110101199001011234' → '我的身份证是[身份证]'

text = re.sub(r'\d{15}|\d{18}', '[身份证]', text)

# 正则规则3:\d{4}[\s\-]*\d{4}[\s\-]*\d{4}[\s\-]*\d{4} (匹配银行卡号)

# \d{4} : 4位数字

# [\s\-]* : 0个或多个空格或横线([\s\-]表示空格或横线,*表示0次或多次)

# 作用:识别银行卡号(支持有分隔符和无分隔符格式)

# 示例:'卡号6222 0012 3456 7890' → '卡号[银行卡]'

text = re.sub(r'\d{4}[\s\-]*\d{4}[\s\-]*\d{4}[\s\-]*\d{4}', '[银行卡]', text)

# 步骤7: 统一标点符号(全角/半角转换)

# 作用:将中英文标点统一为中文全角标点,保持一致性

# 正则规则:[??]

# [??] : 字符类,匹配全角?或半角?

# 示例:'这是什么?' → '这是什么?'

text = re.sub(r'[??]', '?', text) # 问号统一为全角

text = re.sub(r'[!!]', '!', text) # 感叹号统一为全角

text = re.sub(r'[,,]', ',', text) # 逗号统一为全角

text = re.sub(r'[。.]', '。', text) # 句号统一为全角

# 步骤8: 去除多余空白字符

# 正则规则:\s+

# \s : 匹配任何空白字符(空格、制表符、换行符等)

# + : 1次或多次

# 作用:将连续的多个空白字符合并为一个空格

# 示例:'这是 多个 空格' → '这是 多个 空格'

text = re.sub(r'\s+', ' ', text)

# 步骤9: 去除首尾空白

# 作用:删除文本开头和结尾的空格

# 示例:' 文本内容 ' → '文本内容'

return text.strip()

# 使用示例:

# 输入:'您好,我是客服小李,很高兴为您服务。<b>我的手机13812345678充不了电</b>,怎么办?'

# 输出:'我的手机[手机号]充不了电,怎么办?'

Java实现(带详细注释):

点击展开查看Java版本完整代码import java.util.regex.Pattern; // 正则表达式编译类

import java.util.regex.Matcher; // 正则表达式匹配器

import java.text.Normalizer; // Unicode标准化工具

import org.apache.commons.text.StringEscapeUtils; // Apache Commons文本处理工具

/**

* 文本清洗工具类

*

* 目标:提供高性能的文本清洗功能

* 技术要点:

* 1. 预编译正则表达式提高性能

* 2. 链式调用保持代码清晰

* 3. 支持批量并行处理

*/

public class TextCleaner {

// ==================== 正则表达式预编译(性能优化)====================

// 原因:Pattern.compile()编译正则耗时,预编译后可重复使用,提升性能10倍以上

// HTML标签匹配模式:<[^>]+>

// 含义:< 开始,[^>]+匹配任意非>字符(1次或多次),> 结束

private static final Pattern HTML_TAG_PATTERN = Pattern.compile("<[^>]+>");

// 手机号匹配模式:1[3-9]\\d{9}

// 含义:1开头,第二位3-9,后面9位数字

// 注意:Java中\需要转义为\\

private static final Pattern PHONE_PATTERN = Pattern.compile("1[3-9]\\d{9}");

// 身份证匹配模式:\\d{15}|\\d{18}

// 含义:15位数字 或 18位数字

private static final Pattern ID_CARD_PATTERN = Pattern.compile("\\d{15}|\\d{18}");

// 银行卡匹配模式:\\d{4}[\\s\\-]*\\d{4}[\\s\\-]*\\d{4}[\\s\\-]*\\d{4}

// 含义:4位数字 + 可选空格或横线 + 重复4次

private static final Pattern BANK_CARD_PATTERN = Pattern.compile(

"\\d{4}[\\s\\-]*\\d{4}[\\s\\-]*\\d{4}[\\s\\-]*\\d{4}"

);

// 空白字符匹配模式:\\s+

// 含义:匹配1个或多个空白字符(空格、制表符、换行符等)

private static final Pattern WHITESPACE_PATTERN = Pattern.compile("\\s+");

/**

* 清洗客户问题文本

*

* 执行流程:

* 1. 空值检查

* 2. HTML实体解码

* 3. 去除HTML标签

* 4. Unicode标准化

* 5. 去除客服模板语

* 6. 敏感信息脱敏

* 7. 统一标点符号

* 8. 清理空白字符

*

* @param text 原始文本

* @return 清洗后的文本

*/

public static String cleanCustomerQuestion(String text) {

// 步骤1: 空值检查,防御性编程

// 目标:避免NullPointerException和后续处理错误

if (text == null || text.trim().isEmpty()) {

return "";

}

// 步骤2: HTML实体解码

// 目标:将HTML转义字符还原为原始字符

// 示例:< → <, & → &, → 空格, " → "

// 使用Apache Commons库提供的工具方法

text = StringEscapeUtils.unescapeHtml4(text);

// 步骤3: 去除HTML标签

// 目标:删除所有HTML标记,只保留纯文本

// Matcher方式:创建匹配器 → 执行替换 → 返回新字符串

text = HTML_TAG_PATTERN.matcher(text).replaceAll("");

// 步骤4: Unicode标准化

// 目标:统一字符的Unicode表示形式

// NFC模式:Canonical Decomposition(规范分解) + Canonical Composition(规范组合)

// 原因:某些字符可以用多种Unicode编码表示,标准化后便于比较和处理

// 示例:é可以是U+00E9(预组合)或U+0065+U+0301(分解),标准化后统一为U+00E9

text = Normalizer.normalize(text, Normalizer.Form.NFC);

// 步骤5: 去除客服标准用语

// 目标:删除客服的开场白和模板语,提取客户真实问题

// String.replaceAll() 方法直接使用正则字符串

text = text.replaceAll("您好,.*?为您服务", "");

text = text.replaceAll("请问有什么可以帮您的", "");

// 步骤6: 敏感信息脱敏

// 目标:保护用户隐私,避免敏感数据泄露

// 脱敏手机号

// 使用预编译的Pattern对象,性能更好

text = PHONE_PATTERN.matcher(text).replaceAll("[手机号]");

// 脱敏身份证号

text = ID_CARD_PATTERN.matcher(text).replaceAll("[身份证]");

// 脱敏银行卡号

text = BANK_CARD_PATTERN.matcher(text).replaceAll("[银行卡]");

// 步骤7: 统一标点符号

// 目标:将半角标点转为全角标点,保持中文文本规范

// 原因:中文文本应使用全角标点,有助于分词和理解

text = text.replaceAll("[??]", "?"); // 问号:? → ?

text = text.replaceAll("[!!]", "!"); // 感叹号:! → !

text = text.replaceAll("[,,]", ","); // 逗号:, → ,

text = text.replaceAll("[。.]", "。"); // 句号:. → 。

// 步骤8: 去除多余空白字符

// 目标:将连续空白合并为单个空格,规范文本格式

text = WHITESPACE_PATTERN.matcher(text).replaceAll(" ");

// 步骤9: 去除首尾空白

// 目标:删除文本开头和结尾的空格

return text.trim();

}

/**

* 批量清洗文本数据(并行处理)

*

* 执行流程:

* 1. 使用parallelStream()开启并行流处理

* 2. map操作:对每个文本应用清洗函数

* 3. filter操作:过滤掉清洗后为空的文本

* 4. collect操作:收集结果到List

*

* 性能优势:

* - 多核CPU并行处理,速度提升N倍(N为CPU核心数)

* - 适合处理大批量数据(>10000条)

*

* @param texts 原始文本列表

* @return 清洗后的文本列表

*/

public static List<String> batchClean(List<String> texts) {

return texts.parallelStream() // 转换为并行流

.map(TextCleaner::cleanCustomerQuestion) // 对每个元素应用清洗

.filter(text -> !text.isEmpty()) // 过滤空文本

.collect(Collectors.toList()); // 收集为List

}

/**

* 使用示例和测试

*/

public static void main(String[] args) {

// 测试用例1:包含HTML标签

String test1 = "<p>我要<b>退货</b></p>";

System.out.println("清洗前: " + test1);

System.out.println("清洗后: " + cleanCustomerQuestion(test1));

// 输出:我要退货

// 测试用例2:包含敏感信息

String test2 = "我的手机号是13812345678,身份证110101199001011234";

System.out.println("清洗前: " + test2);

System.out.println("清洗后: " + cleanCustomerQuestion(test2));

// 输出:我的手机号是[手机号],身份证[身份证]

// 测试用例3:包含客服用语

String test3 = "您好,我是客服小王,很高兴为您服务。请问商品什么时候发货?";

System.out.println("清洗前: " + test3);

System.out.println("清洗后: " + cleanCustomerQuestion(test3));

// 输出:请问商品什么时候发货?

}

}

技术要点详解:

-

HTML标签清理:

- 使用正则表达式

<[^>]+>匹配所有HTML标签 - 包括处理不完整标签、嵌套标签等边界情况

- 先进行HTML实体解码,再去除标签结构

- 使用正则表达式

-

正则表达式优化:

- Java中预编译Pattern对象,避免重复编译开销

- 使用贪婪匹配与非贪婪匹配的区别(

.*?vs.*) - 字符类和量词的性能考虑

-

Unicode处理:

- NFC标准化:将分解的字符组合成预组合形式

- 处理不同输入法产生的同形异义字符

- 确保文本在不同平台间的一致性

-

敏感信息脱敏:

- 手机号模式:

1[3-9]\d{9}匹配中国手机号规则 - 身份证模式:支持15位和18位格式

- 银行卡模式:处理有分隔符和无分隔符的情况

- 手机号模式:

-

性能优化:

- Java并行流处理大批量数据

- 正则表达式预编译

- 字符串不可变性考虑,避免频繁创建对象

数据清洗结果:

- 删除重复问题:3,200条

- 删除无效数据(空白、乱码):800条

- 删除过短问题(<5字):1,500条

- 最终可用数据:44,500条

数据格式化:

- 长度标准化:截断或填充到统一长度(128字符)

- 编码转换:统一为UTF-8编码

- 标签编码:类别名称转换为数字ID

数据增强:

# 针对样本较少的类别进行数据增强

def augment_minority_class():

# 同义词替换

"快递什么时候到?" → "包裹何时能送达?"

# 句式变换

"我要退货" → "如何申请退货?"

# 添加常见变体

"商品质量有问题" → "这个产品有质量问题"

3. 模型设计阶段

实际操作:设计问题分类模型

模型架构选择:

基于BERT的文本分类模型,适合中文文本理解

import torch.nn as nn

from transformers import BertModel

class CustomerServiceClassifier(nn.Module):

"""客服问题分类模型"""

def __init__(self, num_classes=5):

super().__init__()

# 使用预训练的中文BERT

self.bert = BertModel.from_pretrained('bert-base-chinese')

# 分类头

self.classifier = nn.Sequential(

nn.Dropout(0.3),

nn.Linear(768, 256),

nn.ReLU(),

nn.Dropout(0.2),

nn.Linear(256, num_classes)

)

def forward(self, input_ids, attention_mask):

# BERT编码

outputs = self.bert(input_ids, attention_mask=attention_mask)

pooled_output = outputs.pooler_output

# 分类

logits = self.classifier(pooled_output)

return logits

4. 模型训练阶段

实际操作:训练客服分类模型

训练配置:

- 学习率:2e-5(BERT推荐)

- 批次大小:16

- 训练轮数:5

- 优化器:AdamW

- 损失函数:交叉熵损失

训练过程监控:

Epoch 1/5: 训练损失=1.205, 验证准确率=72.3%

Epoch 2/5: 训练损失=0.687, 验证准确率=84.1%

Epoch 3/5: 训练损失=0.421, 验证准确率=87.9%

Epoch 4/5: 训练损失=0.298, 验证准确率=89.2%

Epoch 5/5: 训练损失=0.234, 验证准确率=88.7%

5. 模型评估阶段

实际操作:评估分类效果

测试集评估结果:

- 整体准确率:88.4%

- 各类别表现:

| 问题类型 | 精确率 | 召回率 | F1分数 | 样本数 |

|---|---|---|---|---|

| 商品咨询 | 89.2% | 91.5% | 90.3% | 2,250 |

| 物流查询 | 92.1% | 89.8% | 90.9% | 1,800 |

| 售后服务 | 85.3% | 87.2% | 86.2% | 1,500 |

| 退换货 | 87.9% | 84.6% | 86.2% | 1,200 |

| 投诉建议 | 83.5% | 81.2% | 82.3% | 750 |

混淆矩阵分析:

主要错误:投诉建议容易被误分为售后服务(业务逻辑相近)

6. 模型部署阶段

实际操作:上线客服分类系统

部署架构:

用户咨询 → API网关 → 模型推理服务 → 结果路由 → 对应客服部门

API接口设计:

@app.route('/classify_question', methods=['POST'])

def classify_customer_question():

"""客户问题分类API"""

data = request.json

question = data['question']

# 预处理

cleaned_question = clean_customer_question(question)

# 模型推理

prediction = model.predict(cleaned_question)

confidence = prediction['confidence']

category = prediction['category']

return {

'category': category, # '商品咨询'

'confidence': confidence, # 0.92

'route_to': get_department(category), # '商品部客服'

'processing_time': 45 # 毫秒

}

性能监控结果:

- 平均响应时间:378ms(满足<500ms要求)

- 系统准确率:87.2%(满足≥85%要求)

- 日处理量:15,000次咨询

- 客服效率提升:人工处理时间减少60%

3. 华为生态家族的崛起

3.1 华为四大技术产品线

3.1 华为四大技术产品线

引入故事:就像专业团队分工协作,华为构建了四大技术产品线。

技术分类:华为在信创领域推出了四大技术产品线,各自专注不同技术领域:

华为四大技术产品线

├── 昇腾:AI计算平台(硬件+软件)

├── 鲲鹏:通用计算平台(处理器+生态)

├── 鸿蒙:智能终端操作系统

└── 欧拉:服务器操作系统

详细技术解析

1. 昇腾(Ascend)

- 技术类型:AI计算平台

- 核心组件:

- 昇腾310:AI推理芯片(ASIC芯片)

- 昇腾910:AI训练芯片(ASIC芯片)

- CANN:异构计算架构(软件栈)

- MindSpore:AI开发框架

- 应用场景:深度学习训练、AI推理部署

- 技术特点:专门优化的AI处理单元,支持多种精度计算

2. 鲲鹏(Kunpeng)

- 技术类型:通用计算平台

- 核心组件:

- 鲲鹏920:64位ARM架构CPU处理器

- 鲲鹏916:面向边缘计算的处理器

- 应用场景:服务器、PC、边缘计算设备

- 技术特点:基于ARMv8指令集,高性能低功耗

3. 鸿蒙(HarmonyOS)

- 技术类型:分布式操作系统

- 核心特性:

- 微内核架构

- 分布式软总线技术

- 统一开发框架ArkUI

- 应用场景:智能手机、平板、手表、车机、智能家居

- 技术特点:一套代码多端部署,设备间无缝协同

4. 欧拉(openEuler)

- 技术类型:服务器操作系统

- 核心特性:

- 基于Linux内核

- 开源社区驱动

- 支持多种处理器架构(x86、ARM、RISC-V)

- 应用场景:数据中心、云计算、边缘计算

- 技术特点:企业级稳定性,安全可控

openEuler与主流操作系统对比

技术对比分析:

| 对比维度 | openEuler | CentOS/RHEL | Ubuntu Server | Windows Server |

|---|---|---|---|---|

| 内核基础 | Linux内核,自主优化 | Linux内核 | Linux内核 | Windows NT内核 |

| 架构支持 | x86、ARM、RISC-V | 主要x86 | 主要x86 | 主要x86 |

| 开源模式 | 完全开源社区驱动 | 开源+商业 | 开源+商业 | 闭源商业 |

| 安全可控 | 完全自主可控 | 依赖国外 | 依赖国外 | 依赖国外 |

| 生态支持 | 华为+合作伙伴 | Red Hat | Canonical | Microsoft |

| 容器支持 | 原生支持Docker/K8s | 支持 | 支持 | 支持 |

| 虚拟化 | KVM、轻量级虚拟化 | KVM | KVM | Hyper-V |

| 包管理 | RPM/DNF | RPM/YUM | APT/DEB | PowerShell/MSI |

openEuler的技术优势:

-

多架构原生支持

- 从设计之初就考虑ARM架构优化

- 与鲲鹏处理器深度适配

- 支持未来的RISC-V架构

-

安全可控特性

- 完全开源,代码可审计

- 不受国外出口管制限制

- 支持国产加密算法

-

性能优化

- 针对华为硬件深度优化

- 内核调度算法优化

- 网络和存储性能提升

-

云原生架构

- 原生支持容器化

- 轻量级虚拟化技术

- 边缘计算优化

3.2 昇腾是什么?AI世界的"最强大脑"

昇腾就像是专门为AI而生的超级大脑,它的使命就是让机器变得更聪明。

🏗️ 昇腾AI帝国的构造

昇腾AI帝国全景图

├── 👑 皇宫:ModelArts Studio、MindStudio(开发工具)

├── 🏛️ 朝堂:MindSpore、TensorFlow、PyTorch(AI框架)

├── ⚔️ 兵器库:CANN异构计算架构(算子库)

├── 🏰 城墙:昇腾驱动(底层驱动)

└── 🌍 疆域:昇腾310/910芯片(硬件领土)

🎯 昇腾家族的两员大将

想象昇腾家族有两个儿子,各有专长:

-

昇腾310(智慧管家):

- 擅长推理和部署,就像聪明的管家

- 低功耗,适合在手机、摄像头等小设备上工作

- 就像《红楼梦》中的王熙凤,精明能干,处理日常事务

-

昇腾910(训练大师):

- 擅长训练大模型,就像武功教练

- 高性能,适合在数据中心进行大规模训练

- 就像《射雕英雄传》中的洪七公,内力深厚,专门培养高手

💡 昇腾平台的四大优势

- 自主可控:完全是"中华制造",不受外人制约

- 高性能:专为AI优化,就像量身定制的盔甲

- 生态完整:从硬件到软件一条龙服务

- 易于使用:提供完整的开发工具,就像武功秘籍配套齐全

4. MindSpore:智慧之源的诞生

4.1 MindSpore是什么?

引入故事:就像鲁班发明各种工具让木匠建造美轮美奂的建筑一样。

技术定义:

MindSpore是华为开发的深度学习框架,属于AI软件基础设施。具体特征:

- 技术分类:深度学习开发框架(类似TensorFlow、PyTorch)

- 开发语言:主要使用Python,支持C++

- 运行环境:支持CPU、GPU、昇腾NPU

- 许可证:Apache 2.0开源许可证

技术架构解析

分层架构设计:

MindSpore架构(自上而下)

├── 高级API层:Model、Callback等封装接口

├── 中级API层:nn.Cell、Optimizer等神经网络组件

├── 底层API层:Tensor、Operator等基础算子

├── 图引擎层:静态图编译、动态图执行

├── 算子库层:数学运算、神经网络算子

└── 硬件适配层:CPU、GPU、昇腾NPU驱动

核心技术特性:

-

自动并行

- 技术原理:自动分析模型结构,生成并行执行策略

- 实现方式:算子级、管道级、数据级并行

- 优势:无需手动配置并行策略

-

自动微分

- 技术原理:基于计算图的反向自动求导

- 实现方式:支持高阶导数、控制流求导

- 应用:神经网络反向传播训练

-

图编译优化

- 静态图模式:预编译优化,性能高效

- 动态图模式:即时执行,调试友好

- 图优化:算子融合、内存优化、并行优化

与其他框架对比

| 对比维度 | MindSpore | TensorFlow | PyTorch |

|---|---|---|---|

| 开发机构 | 华为 | Meta | |

| 硬件支持 | CPU/GPU/昇腾NPU | CPU/GPU/TPU | CPU/GPU |

| 执行模式 | 静态图+动态图 | 静态图+Eager | 动态图为主 |

| 自动并行 | 原生支持 | 需手动配置 | 需手动配置 |

| 调试友好性 | 中等 | 中等 | 高 |

| 部署性能 | 高(静态图) | 高 | 中等 |

| 学习难度 | 中等 | 高 | 低 |

MindSpore的技术优势

-

全场景统一

- 端边云一体化部署

- 统一API接口

- 一套代码多平台运行

-

昇腾硬件深度适配

- 专门针对昇腾芯片优化

- 充分发挥NPU计算能力

- 混合精度训练优化

-

开发效率提升

- 自动并行减少配置工作

- 丰富的预训练模型库

- 完整的开发工具链

4.2 张量(Tensor)基础

📊 什么是张量?

张量是MindSpore中的基础数据结构,类似于多维数组:

- 0维张量:标量(一个数字)

5 - 1维张量:向量(一行数字)

[1, 2, 3] - 2维张量:矩阵(表格形式)

[[1,2], [3,4]] - 3维张量:立方体(如RGB图像)

- N维张量:更高维度的数据

💻 张量创建示例

技术原理:张量(Tensor)是深度学习框架中的核心数据结构,本质上是多维数组的泛化。它支持GPU加速计算、自动微分、广播机制等高级特性。不同维度的张量在神经网络中承担不同角色:0维存储标量值,1维存储特征向量,2维存储批次数据或权重矩阵,高维张量存储图像、视频等复杂数据。

Python实现(MindSpore,带详细注释):

点击展开查看MindSpore张量操作完整代码# ==================== 模块导入 ====================

import mindspore as ms # 华为MindSpore深度学习框架

from mindspore import Tensor # 张量类,深度学习的基础数据结构

import numpy as np # NumPy数值计算库,用于创建初始数据

"""

目标:演示如何在MindSpore中创建和操作张量

执行流程:

1. 导入必要的库

2. 创建不同维度的张量(0维、1维、2维)

3. 检查张量的形状和数据类型

4. 输出张量信息

张量维度说明:

- 0维张量(标量):单个数值,如温度、价格

- 1维张量(向量):一行数据,如用户特征[年龄, 收入, 学历]

- 2维张量(矩阵):表格数据,如batch样本数据

- 3维张量:图像数据 [高度, 宽度, RGB通道]

- 4维张量:批量图像 [batch_size, 高度, 宽度, 通道数]

"""

# ==================== 创建不同维度的张量 ====================

# 1. 创建0维张量(标量)

# 参数1:5.0 - 数值

# 参数2:ms.float32 - 数据类型(32位浮点数)

# 作用:存储单个数值,如损失值、准确率等

# 内存占用:4字节

scalar = Tensor(5.0, ms.float32)

# 2. 创建1维张量(向量)

# 参数1:[1, 2, 3] - Python列表

# 参数2:ms.int32 - 数据类型(32位整数)

# 作用:存储一维特征数组,如词ID序列、类别标签等

# 形状:(3,) 表示有3个元素的一维数组

vector = Tensor([1, 2, 3], ms.int32)

# 3. 创建2维张量(矩阵)

# 参数1:[[1, 2], [3, 4]] - 嵌套列表,2行2列

# 参数2:ms.float32 - 数据类型

# 作用:存储批次数据、权重矩阵、特征表等

# 形状:(2, 2) 表示2行2列

matrix = Tensor([[1, 2], [3, 4]], ms.float32)

# ==================== 查看张量属性 ====================

# 输出张量形状(shape)

# shape是tuple类型,表示各维度的大小

print(f"标量形状: {scalar.shape}") # () - 0维,空tuple

print(f"向量形状: {vector.shape}") # (3,) - 1维,包含3个元素

print(f"矩阵形状: {matrix.shape}") # (2, 2) - 2维,2行2列

# 输出张量数据类型(dtype)

# dtype决定了数值的精度和内存占用

print(f"标量类型: {scalar.dtype}") # mindspore.float32 - 32位浮点数

print(f"向量类型: {vector.dtype}") # mindspore.int32 - 32位整数

# ==================== 实际应用示例 ====================

# 在客服系统中的使用:

# 标量:存储模型置信度

confidence = Tensor(0.87, ms.float32) # 87%的置信度

# 向量:存储单条客户问题的词ID

# "我要退货" → [1245, 2341, 8976](词汇表中的索引)

question_ids = Tensor([1245, 2341, 8976], ms.int32)

# 矩阵:存储一批次客户问题的特征

# 2个问题,每个问题用768维BERT特征表示

batch_features = Tensor(np.random.randn(2, 768), ms.float32)

print(f"批次特征形状: {batch_features.shape}") # (2, 768)

Java实现(使用DJL框架,带详细注释):

点击展开查看DJL框架张量操作完整代码// ==================== 导入DJL深度学习框架 ====================

import ai.djl.ndarray.NDArray; // NDArray类,DJL中的张量表示

import ai.djl.ndarray.NDManager; // NDArray管理器,负责内存管理

import ai.djl.ndarray.types.DataType; // 数据类型枚举

import ai.djl.ndarray.types.Shape; // 形状类,定义张量维度

/**

* 张量操作演示类

*

* 目标:展示如何在Java中使用DJL框架创建和操作张量

*

* 技术要点:

* 1. NDManager管理内存,使用try-with-resources自动释放

* 2. NDArray是不可变对象,操作会创建新对象

* 3. 支持多种数据类型和设备(CPU/GPU)

*/

public class TensorOperations {

/**

* 演示张量创建

*

* 执行流程:

* 1. 创建NDManager(管理张量内存)

* 2. 创建不同维度的张量

* 3. 查看张量属性

* 4. 创建特殊张量(全0、全1)

* 5. 自动释放资源

*/

public static void demonstrateTensorCreation() {

// 创建NDArray管理器(资源管理器)

// try-with-resources语法确保资源自动释放,防止内存泄漏

// 原因:Java需要手动管理GPU/CPU内存,不像Python有自动垃圾回收

try (NDManager manager = NDManager.newBaseManager()) {

// ==================== 创建不同维度的张量 ====================

// 1. 创建0维张量(标量)

// 参数:5.0f - float类型数值(f表示float)

// 作用:存储单个数值,如损失值、学习率等

// 内存:4字节(FLOAT32)

NDArray scalar = manager.create(5.0f);

// 2. 创建1维张量(向量)

// 参数:new int[]{1, 2, 3} - Java整数数组

// 作用:存储序列数据,如词ID、标签索引等

// 形状:(3) - 包含3个元素

NDArray vector = manager.create(new int[]{1, 2, 3});

// 3. 创建2维张量(矩阵)

// 参数:new float[][]{{1, 2}, {3, 4}} - 二维float数组

// 作用:存储批次数据、权重矩阵等

// 形状:(2, 2) - 2行2列

NDArray matrix = manager.create(new float[][]{{1, 2}, {3, 4}});

// ==================== 查看张量属性 ====================

// 获取并打印形状信息

// getShape()返回Shape对象,包含各维度大小

System.out.println("标量形状: " + scalar.getShape()); // ()

System.out.println("向量形状: " + vector.getShape()); // (3)

System.out.println("矩阵形状: " + matrix.getShape()); // (2, 2)

// 获取并打印数据类型

// getDataType()返回DataType枚举值

System.out.println("标量类型: " + scalar.getDataType()); // FLOAT32

System.out.println("向量类型: " + vector.getDataType()); // INT32

// ==================== 创建特殊张量 ====================

// 创建全零张量

// 参数1:new Shape(3, 3) - 3行3列的形状

// 参数2:DataType.FLOAT32 - 数据类型

// 作用:初始化权重矩阵、掩码等

NDArray zeros = manager.zeros(new Shape(3, 3), DataType.FLOAT32);

// 创建全一张量

// 作用:初始化偏置、注意力掩码等

NDArray ones = manager.ones(new Shape(2, 4), DataType.FLOAT32);

System.out.println("全零矩阵:\n" + zeros);

System.out.println("全一矩阵:\n" + ones);

// ==================== 实际应用示例 ====================

// 在客服系统中创建批次数据

// 场景:3个客户问题,每个问题转换为128维特征向量

int batchSize = 3; // 批次大小

int featureDim = 128; // 特征维度

// 创建批次特征张量

// 形状:(3, 128) - 3个样本,每个样本128个特征

NDArray batchFeatures = manager.randomNormal(

new Shape(batchSize, featureDim), // 形状

0.0f, // 均值

1.0f, // 标准差

DataType.FLOAT32 // 数据类型

);

System.out.println("批次特征形状: " + batchFeatures.getShape());

// 输出:(3, 128)

// 创建标签张量(问题分类结果)

// 5个类别:0=商品咨询, 1=物流查询, 2=售后服务, 3=退换货, 4=投诉建议

NDArray labels = manager.create(new int[]{1, 0, 3}); // 3个样本的标签

System.out.println("标签形状: " + labels.getShape()); // (3)

} // try-with-resources自动关闭manager,释放所有创建的张量内存

}

}

技术要点详解:

-

内存管理:

- Python:依赖垃圾回收,自动内存管理

- Java:使用try-with-resources确保NDManager正确关闭,避免内存泄漏

- GPU内存:大张量操作需要注意显存占用

-

数据类型系统:

- 精度选择:float32适合大多数场景,float16节省内存但精度较低

- 整数类型:int32适合索引和标签,int8用于量化模型

- 类型转换:不同类型间的转换需要考虑精度损失

-

广播机制:

- 不同形状的张量可以自动扩展进行运算

- 例如:(2,1) + (1,3) → (2,3)

- 遵循从右到左的维度对齐规则

-

张量索引和切片:

# Python索引示例 matrix = Tensor([[1, 2, 3], [4, 5, 6], [7, 8, 9]]) print(matrix[0]) # 第一行: [1, 2, 3] print(matrix[:, 1]) # 第二列: [2, 5, 8] print(matrix[1:3, 0:2]) # 子矩阵: [[4, 5], [7, 8]]// Java索引示例 NDArray matrix = manager.create(new float[][]{{1,2,3}, {4,5,6}, {7,8,9}}); NDArray firstRow = matrix.get(0); // 第一行 NDArray secondCol = matrix.get(":,1"); // 第二列 NDArray subMatrix = matrix.get("1:3,0:2"); // 子矩阵

4.3 数据类型支持

🔢 MindSpore支持的数据类型

| 类型分类 | 具体类型 | 说明 |

|---|---|---|

| 整数类型 | int8, int16, int32, int64 | 不同精度的整数 |

| 无符号整数 | uint8, uint16, uint32, uint64 | 只能表示正数的整数 |

| 浮点数类型 | float16, float32, float64 | 不同精度的小数 |

| 布尔类型 | bool_ | True或False |

4.4 神经网络构建基础

🧱 常用网络层介绍

实际案例:构建客服问题分类的神经网络

1. 全连接层(Dense)实际应用:

技术原理:全连接层实现线性变换 y = xW + b,其中W是权重矩阵,b是偏置向量。每个输入神经元都与输出层的每个神经元相连,因此称为"全连接"。

Python实现:

import mindspore.nn as nn

# 客服问题特征提取后的分类层

class CustomerServiceClassifier(nn.Cell):

def __init__(self):

super().__init__()

# 输入:768维BERT特征 → 输出:5个问题类别

self.classifier = nn.Sequential(

nn.Dense(768, 256), # 特征降维

nn.ReLU(), # 非线性激活

nn.Dropout(0.3), # 防过拟合

nn.Dense(256, 5) # 最终分类

)

Java实现:

// 使用DJL框架构建分类网络

public class CustomerServiceClassifier {

public static Block buildClassifier() {

return new SequentialBlock()

.add(Linear.builder()

.setUnits(256) // 768 -> 256

.optInitializer(XavierInitializer())

.build())

.add(Activation::relu) // ReLU激活函数

.add(Dropout.builder()

.optRate(0.3f) // 30%dropout率

.build())

.add(Linear.builder()

.setUnits(5) // 256 -> 5类别

.build());

}

}

实际应用效果:

- 输入:客户问题的768维语义特征向量

- 输出:5个类别的概率分布 [0.1, 0.7, 0.05, 0.1, 0.05]

- 预测结果:物流查询(概率0.7)

2. 卷积层(Conv2d)实际应用:

技术原理:卷积操作通过滑动窗口在输入上进行特征提取,具有平移不变性和参数共享特性。卷积核(filter)学习检测特定的局部特征,如边缘、纹理、形状等。

实际案例:商品图像质量检测系统

# 检测商品图像中的质量问题

class ProductQualityDetector(nn.Cell):

def __init__(self):

super().__init__()

# 第一层:检测边缘和基本形状

self.conv1 = nn.Conv2d(3, 32, 3, padding=1) # 3通道RGB → 32个特征图

# 第二层:检测复杂纹理

self.conv2 = nn.Conv2d(32, 64, 3, padding=1) # 32 → 64个特征图

# 第三层:检测高级特征

self.conv3 = nn.Conv2d(64, 128, 3, padding=1) # 64 → 128个特征图

实际检测效果:

- 划痕检测:第一层卷积检测边缘异常

- 色差检测:第二层卷积检测颜色不一致

- 形变检测:第三层卷积检测形状扭曲

- 分类结果:合格/轻微缺陷/严重缺陷

3. 激活函数(ReLU)实际应用:

技术原理:ReLU函数 f(x) = max(0, x) 解决了深层网络的梯度消失问题。它将负值设为0,正值保持不变,计算简单且效果好。

实际应用案例:情感强度分析

# 分析客户情绪的激烈程度

def analyze_emotion_intensity(text_features):

# ReLU确保负面特征不会抵消正面特征

positive_features = relu(text_features[:, :50]) # 正面情感特征

negative_features = relu(text_features[:, 50:100]) # 负面情感特征

# 计算情感强度(只考虑激活的特征)

intensity = positive_features.sum() + negative_features.sum()

return intensity

ReLU的实际效果:

- 输入特征:[-0.5, 2.1, -1.2, 3.8, 0.9]

- ReLU后:[0, 2.1, 0, 3.8, 0.9]

- 作用:只保留有意义的正向激活,过滤负向噪声

4. 注意力机制实际应用:

实际案例:智能客服多轮对话理解

客户:"我昨天买的手机"

客服:"请问是什么问题吗?"

客户:"充电很慢"

# 注意力机制分析

当前问题:"充电很慢"

历史上下文:"昨天买的手机"

注意力权重分配:

- "充电":0.4 (高权重,核心问题)

- "很慢":0.3 (高权重,问题描述)

- "手机":0.2 (中等权重,商品信息)

- "昨天买的":0.1 (低权重,时间信息)

技术实现:

# 多轮对话的注意力计算

class DialogueAttention(nn.Cell):

def __init__(self, hidden_size):

super().__init__()

self.attention = nn.MultiheadAttention(hidden_size, num_heads=8)

def forward(self, current_query, dialogue_history):

# current_query: 当前问题特征

# dialogue_history: 历史对话特征

# 计算注意力权重

attention_output, attention_weights = self.attention(

current_query, # Query:当前问题

dialogue_history, # Key:历史对话

dialogue_history # Value:历史对话

)

return attention_output, attention_weights

注意力机制的业务价值:

- 上下文理解:理解"它"、"这个"等指代词

- 重点识别:自动识别对话中的关键信息

- 情感延续:理解客户情绪在多轮对话中的变化

- 精准回复:基于完整上下文给出精准回答

5. DeepSeek:深度探索者的传奇

5.1 DeepSeek是什么?AI界的"深度探索大师"

DeepSeek,就像它的名字一样,是一位"深度探索者"。如果把AI世界比作一片未知的大海,那么DeepSeek就是最勇敢的探险家,不仅敢于深潜到海底最深处,还能把发现的宝藏无私地分享给所有人。

在古代,有郑和七下西洋的壮举,开辟了海上丝绸之路。现代的DeepSeek就像AI世界的郑和,不仅探索了知识的深海,还把探索的成果(开源代码和模型)免费分享给全世界。

🎯 DeepSeek的四大绝世武功

-

开源心法:毫无保留地公开所有"武功秘籍"

- 代码全公开,模型权重全分享

- 就像武侠小说中的高人,不藏私,广传天下

-

性能神通:在各种比武大会中屡获殊荣

- 各种AI评测榜单上名列前茅

- 就像华山论剑的绝顶高手

-

本土化妙技:特别精通中华文化

- 古诗词、文言文、成语典故样样精通

- 就像饱读诗书的古代文人

-

隐私保护法:可以在自己家里"闭关修炼"

- 支持本地部署,数据不出门

- 就像在自己的书房里请了个私人先生

📚 DeepSeek家族族谱大全

DeepSeek家族就像《水浒传》中的梁山好汉,各有专长:

| 英雄称号 | 参数量 | 绝技特色 | 适战场合 | 江湖地位 |

|---|---|---|---|---|

| DeepSeek-R1-1.5B(小李飞刀) | 15亿 | 身轻如燕,出手如电 | 个人设备,日常对话 | 轻功高手 |

| DeepSeek-V3-32K(九阴真经) | 671亿 | 博古通今,长篇大论 | 复杂任务,专业应用 | 武学宗师 |

| DeepSeek-R1-32K(天山折梅手) | 671亿 | 推理如神,步步为营 | 数学难题,逻辑推理 | 智慧化身 |

🏆 什么是DeepSeek-R1满血版?终极形态的觉醒

满血版这个概念,就像游戏中角色的满级状态,或者武侠小说中的"大成境界"。

想象《龙珠》中的孙悟空有不同的变身状态:

- 普通状态:日常使用,够用但不惊艳

- 超级赛亚人:实力大增,应付大部分挑战

- 满血版(超级赛亚人3):终极形态,战斗力爆表!

DeepSeek-R1满血版671B就是这样的存在:

- 671B参数:相当于拥有6710亿个"脑细胞"

- 满血状态:所有能力都调到最大档

- 推理之王:在数学、逻辑推理方面接近人类顶尖专家水平

- 与o1对标:直接对标OpenAI的o1模型,分庭抗礼

🧠 满血版的三大绝技

-

深度思考术:

普通AI:看到问题直接回答 满血版:<think>先思考10分钟</think>再给出完美答案 -

逻辑推理神功:

- 数学证明:能像数学家一样严谨推导

- 逻辑分析:能像侦探一样抽丝剥茧

- 问题分解:能像工程师一样系统思维

-

知识融合大法:

- 文理兼通:既懂牛顿定律,也懂诗词歌赋

- 古今贯通:既知现代科技,也晓古代典故

- 中西合璧:既懂东方哲学,也通西方逻辑

5.2 DeepSeek模型架构

🏗️ Transformer架构基础

技术定义:Transformer是一种基于自注意力机制的神经网络架构,由Google在2017年提出。它摒弃了传统的循环神经网络(RNN)和卷积神经网络(CNN),完全基于注意力机制进行序列建模,具有并行计算能力强、长距离依赖建模好的优势。

实际应用案例:机器翻译任务

输入文本:“我喜欢学习人工智能技术”

目标翻译:“I like learning artificial intelligence technology”

Transformer处理流程:

1. 注意力机制(Self-Attention)

技术原理:

- 计算每个词与其他所有词的相关性

- 通过Query、Key、Value三个矩阵进行计算

- 公式:Attention(Q, K, V) = softmax(QK^T/√d_k)V

实际计算示例:

输入句子:"我 喜欢 学习 人工智能 技术"

步骤1:生成Q、K、V向量

"我" → Q1, K1, V1

"喜欢" → Q2, K2, V2

"学习" → Q3, K3, V3

"人工智能" → Q4, K4, V4

"技术" → Q5, K5, V5

步骤2:计算注意力分数

"学习"对其他词的注意力:

- "我":0.1(低相关性)

- "喜欢":0.25(中等相关性)

- "学习":0.15(自身)

- "人工智能":0.4(高相关性,是学习的对象)

- "技术":0.1(低相关性)

步骤3:加权求和

"学习"的上下文表示 = 0.1×V1 + 0.25×V2 + 0.15×V3 + 0.4×V4 + 0.1×V5

代码实现(带详细注释):

点击展开查看自注意力机制完整代码实现import numpy as np # NumPy数值计算库,用于矩阵运算

def self_attention(Q, K, V):

"""

自注意力机制计算

目标:计算序列中每个位置对其他位置的注意力权重,并生成加权表示

执行流程:

1. 计算Q和K的点积得到相似度分数

2. 缩放分数(除以√d_k)防止梯度消失

3. Softmax归一化得到注意力权重

4. 用权重对V加权求和得到输出

数学公式:Attention(Q, K, V) = softmax(QK^T / √d_k)V

参数:

Q: Query矩阵,形状 (seq_len, d_k),表示查询向量

K: Key矩阵,形状 (seq_len, d_k),表示键向量

V: Value矩阵,形状 (seq_len, d_v),表示值向量

返回:

output: 加权后的输出,形状 (seq_len, d_v)

attention_weights: 注意力权重矩阵,形状 (seq_len, seq_len)

"""

# 步骤1: 获取Key的维度

# 目标:用于缩放因子计算

# d_k:Key向量的维度大小

# shape[-1]:获取最后一个维度的大小

d_k = Q.shape[-1]

# 步骤2: 计算注意力分数(相似度)

# 目标:计算每个Query对所有Key的相关性

# np.matmul(Q, K.T):矩阵乘法,Q @ K的转置

# 示例:如果Q=[3,4],K=[3,4],则Q @ K.T = [3,4] @ [4,3] = [3,3]

# 含义:scores[i,j]表示第i个词对第j个词的相关性得分

# 除以√d_k:缩放因子,防止点积过大导致softmax梯度消失

# 原因:当d_k很大时,点积值会很大,softmax后梯度会很小

scores = np.matmul(Q, K.T) / np.sqrt(d_k)

# 步骤3: Softmax归一化

# 目标:将分数转换为概率分布(和为1)

# np.exp(scores):对每个分数取指数,e^score

# np.sum(..., axis=-1, keepdims=True):对最后一个维度求和,保持维度

# 除法:每个值除以总和,得到概率

# 结果:attention_weights[i,j]表示第i个词对第j个词的注意力权重(0-1之间)

attention_weights = np.exp(scores) / np.sum(np.exp(scores), axis=-1, keepdims=True)

# 步骤4: 加权求和

# 目标:用注意力权重对Value加权,得到每个位置的上下文表示

# np.matmul(attention_weights, V):权重矩阵 @ 值矩阵

# 示例:[3,3] @ [3,4] = [3,4]

# 含义:output[i]是第i个词的上下文表示,融合了所有词的信息

output = np.matmul(attention_weights, V)

return output, attention_weights

# ==================== 实际使用示例 ====================

# 假设句子:"我 喜欢 学习",每个词用4维向量表示

# 注意:这里是简化示例,实际BERT使用768维向量

# Query矩阵:3个词,每个词4维

# 每一行代表一个词的Query向量

Q = np.array([

[1, 0, 1, 0], # "我" 的Query向量

[0, 2, 0, 2], # "喜欢" 的Query向量

[1, 1, 1, 1] # "学习" 的Query向量

])

# Key矩阵:与Query相同(自注意力中Q=K=V的输入相同)

K = np.array([

[1, 0, 1, 0], # "我" 的Key向量

[0, 2, 0, 2], # "喜欢" 的Key向量

[1, 1, 1, 1] # "学习" 的Key向量

])

# Value矩阵:包含实际的语义信息

V = np.array([

[1, 2, 3, 4], # "我" 的Value向量

[2, 4, 6, 8], # "喜欢" 的Value向量

[1, 3, 5, 7] # "学习" 的Value向量

])

# 计算自注意力

output, weights = self_attention(Q, K, V)

# 输出结果

print("注意力权重矩阵(每个词对其他词的注意力):\n", weights)

# weights[0]表示"我"对所有词的注意力分布

# weights[1]表示"喜欢"对所有词的注意力分布

# weights[2]表示"学习"对所有词的注意力分布

print("\n输出矩阵(融合上下文后的表示):\n", output)

# output[0]是"我"的上下文表示,融合了句子中所有词的信息

# output[1]是"喜欢"的上下文表示

# output[2]是"学习"的上下文表示

# ==================== 结果解释 ====================

# 假设weights输出为:

# [[0.4, 0.3, 0.3], # "我"对[我、喜欢、学习]的注意力

# [0.2, 0.5, 0.3], # "喜欢"对[我、喜欢、学习]的注意力

# [0.3, 0.2, 0.5]] # "学习"对[我、喜欢、学习]的注意力

#

# 解读:

# - "我"对自己注意力最高(0.4),这是合理的

# - "喜欢"对自己注意力最高(0.5),这是动词的特性

# - "学习"对自己注意力最高(0.5),但也关注"我"(主语)

2. 多头注意力(Multi-Head Attention)

技术原理:

将注意力机制复制多份(多个头),每个头学习不同类型的语义关系。就像用多个角度观察同一个问题。

实际应用示例:理解复杂句子

句子:"这款手机性能很好,但价格有点贵,整体还是值得购买的"

8个注意力头的分工:

Head 1 - 主谓关系: "手机"-"性能"-"好"

Head 2 - 转折关系: "但"-"价格"-"贵"

Head 3 - 评价关系: "整体"-"值得"-"购买"

Head 4 - 属性关系: "手机"-"价格"

Head 5 - 程度关系: "很"-"好","有点"-"贵"

Head 6 - 逻辑关系: "但"连接正反两面

Head 7 - 情感关系: 整体正面评价

Head 8 - 实体关系: "这款手机"是讨论主体

综合理解:用户认可性能,价格敏感,整体倾向购买

技术实现:

class MultiHeadAttention(nn.Cell):

"""多头注意力实现"""

def __init__(self, hidden_size, num_heads):

super().__init__()

self.num_heads = num_heads

self.head_dim = hidden_size // num_heads

# 为每个头创建Q、K、V的线性变换

self.W_q = nn.Dense(hidden_size, hidden_size)

self.W_k = nn.Dense(hidden_size, hidden_size)

self.W_v = nn.Dense(hidden_size, hidden_size)

self.W_o = nn.Dense(hidden_size, hidden_size)

def split_heads(self, x, batch_size):

"""将张量分割成多个头"""

# (batch_size, seq_len, hidden_size)

# → (batch_size, num_heads, seq_len, head_dim)

x = x.reshape(batch_size, -1, self.num_heads, self.head_dim)

return x.transpose(0, 2, 1, 3)

def forward(self, query, key, value):

batch_size = query.shape[0]

# 线性变换

Q = self.W_q(query)

K = self.W_k(key)

V = self.W_v(value)

# 分割多头

Q = self.split_heads(Q, batch_size)

K = self.split_heads(K, batch_size)

V = self.split_heads(V, batch_size)

# 计算注意力(每个头独立计算)

attention_output = scaled_dot_product_attention(Q, K, V)

# 合并多头

attention_output = attention_output.transpose(0, 2, 1, 3)

attention_output = attention_output.reshape(batch_size, -1, self.num_heads * self.head_dim)

# 输出线性变换

output = self.W_o(attention_output)

return output

Java实现(DJL框架):

public class MultiHeadAttention {

private int numHeads;

private int headDim;

private Linear wq, wk, wv, wo;

public MultiHeadAttention(int hiddenSize, int numHeads) {

this.numHeads = numHeads;

this.headDim = hiddenSize / numHeads;

// 初始化权重矩阵

this.wq = Linear.builder().setUnits(hiddenSize).build();

this.wk = Linear.builder().setUnits(hiddenSize).build();

this.wv = Linear.builder().setUnits(hiddenSize).build();

this.wo = Linear.builder().setUnits(hiddenSize).build();

}

/**

* 前向传播计算

*/

public NDArray forward(NDArray query, NDArray key, NDArray value) {

NDManager manager = query.getManager();

long batchSize = query.getShape().get(0);

// Q、K、V线性变换

NDArray Q = wq.forward(query);

NDArray K = wk.forward(key);

NDArray V = wv.forward(value);

// 分割多头

Q = splitHeads(Q, batchSize);

K = splitHeads(K, batchSize);

V = splitHeads(V, batchSize);

// 计算缩放点积注意力

NDArray attentionOutput = scaledDotProductAttention(Q, K, V);

// 合并多头

attentionOutput = combineHeads(attentionOutput, batchSize);

// 输出线性变换

return wo.forward(attentionOutput);

}

}

3. 前馈网络(Feed Forward Network)

技术原理:

前馈网络是Transformer中的另一个关键组件,由两个线性变换和一个激活函数组成。它对每个位置的表示进行非线性变换,增强模型的表达能力。

实际应用:特征增强和语义提取

输入:"这款手机不错" 的注意力表示向量

经过FFN处理:

1. 第一层线性变换:768维 → 3072维(扩展特征空间)

2. ReLU激活:引入非线性

3. 第二层线性变换:3072维 → 768维(压缩回原始维度)

效果:提取更抽象的语义特征

- "不错" → 正面评价特征增强

- "手机" → 商品类别特征增强

- "这款" → 指代关系特征增强

Transformer完整流程实例:

客服对话理解任务:

输入:"我的订单为什么还没发货?已经3天了。"

Transformer处理流程:

1. 词嵌入层:

"我的" → [0.12, -0.34, 0.56, ...]

"订单" → [0.89, 0.23, -0.11, ...]

"为什么" → [-0.45, 0.67, 0.23, ...]

... (每个词转换为768维向量)

2. 位置编码:

加入位置信息,让模型知道词序

"我的"(位置1) + pos_encoding(1)

"订单"(位置2) + pos_encoding(2)

...

3. 多头自注意力:

计算词与词之间的关系

关键发现:"订单"高度关联"发货"、"3天"

4. 前馈网络:

进一步提取特征

识别出"物流查询"的语义特征

5. 编码器输出:

整句话的语义表示向量

6. 分类层:

基于语义向量进行分类

预测:物流查询类别(置信度92%)

🧠 DeepSeek的推理能力

推理能力是DeepSeek-R1的核心特色,它能展示完整的思维过程:

实际推理案例1:数学应用题

用户问题:小明有10个苹果,给了小红3个,又买了5个,问现在有几个?

DeepSeek-R1的思考过程:

<think>

让我一步步分析这个问题:

1. 小明最初有10个苹果

2. 给了小红3个苹果,所以剩下:10 - 3 = 7个

3. 然后又买了5个苹果,所以总数:7 + 5 = 12个

4. 因此小明现在有12个苹果

</think>

小明现在有12个苹果。

实际推理案例2:商业分析

问题:某电商平台2023年GMV为1000亿,同比增长25%,其中手机品类占比30%,利润率8%。如果2024年手机品类增长率为35%,其他品类增长15%,预计总利润是多少?

DeepSeek-R1推理:

<think>

让我分步计算这个商业分析问题:

1. 分析2023年数据:

- 总GMV:1000亿

- 手机品类GMV:1000 × 30% = 300亿

- 其他品类GMV:1000 - 300 = 700亿

- 总利润:1000 × 8% = 80亿

2. 计算2024年GMV:

- 手机品类:300 × (1 + 35%) = 405亿

- 其他品类:700 × (1 + 15%) = 805亿

- 2024年总GMV:405 + 805 = 1210亿

3. 计算2024年利润(假设利润率保持8%):

- 预计总利润:1210 × 8% = 96.8亿

4. 验证结果合理性:

- 总体增长率:(1210-1000)/1000 = 21%

- 这个增长率介于手机品类35%和其他品类15%之间,符合逻辑

</think>

根据计算,2024年预计总利润为96.8亿元。

实际推理案例3:技术故障诊断

问题:客户反映系统登录缓慢,有时需要30秒才能进入,偶尔还会超时。服务器CPU使用率正常(60%),内存使用率75%,但数据库连接池经常满载。

DeepSeek-R1故障诊断:

<think>

让我分析这个技术问题:

1. 症状分析:

- 登录缓慢:平均30秒响应时间

- 偶发超时:部分请求失败

- 服务器资源状态:CPU正常,内存偏高

2. 关键线索识别:

- "数据库连接池经常满载" - 这是重要线索

- CPU正常说明不是计算密集型问题

- 内存75%偏高但未到危险水平

3. 根因分析:

- 连接池满载 → 数据库连接未及时释放

- 可能原因:长事务未提交、连接泄露、慢查询

- 内存偏高可能是连接对象堆积导致

4. 解决方案推荐:

- 立即:增加数据库连接池大小

- 短期:检查慢查询日志,优化SQL

- 长期:实现连接池监控,设置连接超时

5. 验证方法:

- 监控连接池使用率变化

- 测量登录响应时间改善情况

- 观察内存使用率是否下降

</think>

根据症状分析,问题根因是数据库连接池资源不足。建议:

1. 立即增加连接池大小到50个连接

2. 检查并优化慢查询(>2秒的查询)

3. 添加连接池监控和告警

4. 预计解决后登录时间将降至5秒内

实际推理案例4:医疗健康咨询

用户问题:"我最近经常感到疲劳,特别是下午,注意力也不太集中,晚上11点睡觉,早上7点起床,平时很少运动,主要是办公室工作。"

DeepSeek-R1健康分析:

<think>

让我系统分析这个健康问题:

1. 症状整理:

- 主要症状:疲劳感

- 时间特征:下午更明显

- 伴随症状:注意力不集中

- 作息:11点睡觉-7点起床(8小时睡眠,时间充足)

- 生活方式:办公室工作,缺乏运动

2. 可能原因分析:

- 下午疲劳加重 → 可能与血糖波动、午餐后消化有关

- 注意力不集中 → 可能是久坐、缺乏运动导致血循环不畅

- 办公室工作 → 长期久坐,可能存在颈椎、腰椎问题

- 缺乏运动 → 心肺功能下降,基础代谢低

3. 排除严重疾病:

- 睡眠时间充足,排除睡眠不足

- 疲劳非持续性,不太像甲状腺功能减退

- 无其他系统性症状,暂时排除严重器质性疾病

4. 生活方式改善建议:

- 运动:每天30分钟中等强度运动(快走、游泳)

- 工作习惯:每1小时起身活动5分钟

- 饮食:午餐控制份量,避免血糖急剧波动

- 补充检查:建议体检查血常规、甲状腺功能

5. 预期改善时间:

- 1-2周:运动后精神状态开始改善

- 1个月:注意力集中度显著提升

- 3个月:整体疲劳感明显缓解

</think>

根据您的症状分析,主要可能是久坐缺乏运动导致的亚健康状态。建议:

1. 每天增加30分钟运动,建议快走或游泳

2. 工作期间每小时起身活动,缓解久坐疲劳

3. 调整午餐,避免过饱导致下午困倦

4. 可考虑体检查血常规和甲状腺功能

5. 如坚持改善1个月后症状无缓解,建议就医检查

预计1-2周内会有明显改善。

推理能力的技术实现:

1. 思维展示机制:

- 标签:包含模型内部推理过程

- 步骤分解:将复杂问题分解为多个简单步骤

- 逻辑链条:每步基于前一步结果,保持连贯性

- 结果输出:在思维展示后给出最终答案

2. 推理质量提升:

- 多角度分析:从不同维度分析问题

- 假设验证:提出假设并进行验证

- 风险评估:考虑不确定性和边界情况

- 结果检查:对答案进行合理性检验

3. 专业领域适应:

- 医疗推理:症状→可能原因→建议检查→治疗方案

- 技术诊断:现象→根因分析→解决方案→验证方法

- 商业分析:数据→趋势分析→风险评估→决策建议

推理能力的应用价值:

- 提高准确率:复杂问题准确率提升20-40%

- 增强可信度:用户能看到推理过程,更容易信任结果

- 便于审查:专业人员可以审查推理过程的每个步骤

- 教育意义:展示正确的思维方法和分析流程

6. 实战冒险指南

🎯 训练任务实施区域:

本章开始进入实际操作!你将完成训练任务的前3个步骤:安装Ollama、部署DeepSeek、调用模型。请严格按照步骤操作,遇到问题参考第8章的问题排查部分。

6.1 核心开发工具技术解析

Ollama是什么?

引入故事:就像专业的动物管理员管理动物园一样。

技术定义:

Ollama是一个开源的大语言模型运行框架,具体特征:

- 技术分类:LLM推理服务框架

- 开发语言:Go语言开发

- 运行环境:跨平台(Linux、macOS、Windows)

- 核心功能:模型下载、部署、推理服务

技术架构:

Ollama架构组成

├── 模型管理层:下载、存储、版本管理

├── 推理引擎层:模型加载、推理优化

├── API服务层:RESTful API、WebSocket

├── 客户端层:命令行工具、SDK

└── 硬件适配层:CPU、GPU加速

核心特性:

- 模型格式支持:GGUF、GGML等量化格式

- 推理优化:量化推理、内存优化

- 并发处理:多用户同时访问

- API兼容:兼容OpenAI API格式

pip是什么?

技术定义:

pip是Python包管理工具,全称"Pip Installs Packages"。

- 技术分类:包管理器(Package Manager)

- 开发语言:Python

- 核心功能:安装、升级、卸载Python包

- 包来源:PyPI(Python Package Index)

主要命令:

pip install package_name # 安装包

pip install --upgrade pip # 升级pip自身

pip list # 列出已安装包

pip uninstall package_name # 卸载包

pip freeze # 导出包列表

国内镜像加速:

# 使用清华镜像源加速下载

pip install -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple/ package_name

AutoGen是什么?

引入故事:就像能够创造不同角色分身的神奇法术。

技术定义:

AutoGen是微软开发的多智能体对话框架,具体特征:

- 技术分类:多智能体系统框架

- 开发语言:Python

- 核心功能:创建、管理多个AI智能体的交互

- 应用场景:角色扮演、任务协作、复杂问题求解

技术架构:

AutoGen框架架构

├── Agent管理层:智能体创建、配置、生命周期管理

├── 对话管理层:消息路由、对话流程控制

├── LLM接口层:支持多种大语言模型

├── 工具集成层:代码执行、函数调用

└── 用户接口层:Python API、配置文件

核心组件:

-

ConversableAgent:可对话智能体基类

- 支持角色设定

- 支持系统提示词

- 支持函数调用

-

UserProxyAgent:用户代理智能体

- 代表人类用户

- 支持代码执行

- 支持人工干预

-

GroupChat:群组对话管理

- 多智能体协作

- 对话流程控制

- 任务分配机制

技术特点:

- 模块化设计:组件可复用、可扩展

- LLM无关性:支持OpenAI、本地模型等

- 代码执行:支持Python代码自动执行

- 人机协作:支持人工介入和确认

6.2 环境搭建:打造你的AI训练道场

📌 训练任务步骤1:云主机安装Ollama

重要性:⭐⭐⭐⭐⭐(基础步骤,必须成功)

预计耗时:5-10分钟

🏗️ 环境搭建三步法

第一步:获取华为云开发者空间

操作步骤:

- 访问华为开发者网站:https://developer.huaweicloud.com/

- 注册并登录华为云账号

- 进入"ModelArts Studio"或"开发者空间"

- 申请免费云主机资源(选择Ubuntu操作系统)

配置要求:

- 操作系统:Ubuntu 20.04或22.04

- CPU:建议4核心以上

- 内存:建议8GB以上

- 存储:至少20GB可用空间

第二步:连接云主机

操作步骤:

- 在开发者空间工作台,点击"打开云主机"

- 选择"桌面连接"方式(提供图形界面)

- 等待桌面环境加载完成

- 在桌面上右键选择"Open Terminal Here"打开终端

第三步:安装Ollama服务

# ⭐⭐⭐ 重要:这是训练任务的第一个关键命令 ⭐⭐⭐

# 安装命令

curl -fsSL https://dtse-mirrors.obs.cn-north-4.myhuaweicloud.com/case/0035/install.sh | sudo bash

# 命令说明:

# curl -fsSL:下载安装脚本

# -f:失败时不显示错误

# -s:静默模式

# -S:显示错误信息

# -L:跟随重定向

# | sudo bash:通过管道传递给bash执行,sudo表示管理员权限

# 执行流程:

# 1. 从华为云镜像下载Ollama安装脚本

# 2. 检查系统环境和依赖

# 3. 下载Ollama二进制文件

# 4. 安装到/usr/local/bin目录

# 5. 配置系统服务

# 6. 启动Ollama服务

验证安装成功:

# 检查Ollama版本

ollama --version

# 预期输出:ollama version is 0.1.17

# 检查Ollama服务状态

systemctl status ollama

# 预期输出:active (running)

# 测试Ollama API

curl http://localhost:11434/api/tags

# 预期输出:JSON格式的模型列表

📝 重要注意事项

1. 复制粘贴问题:

- ❌ 错误做法:直接按Ctrl+V粘贴(在云主机浏览器中无效)

- ✅ 正确做法:点击浏览器地址栏的"粘贴"按钮 → 选择"允许访问剪贴板" → 点击"完成"

2. 网络连接要求:

- 确保云主机能访问外网

- 如果下载失败,尝试使用备用镜像源

- 建议使用稳定的网络环境

3. 权限问题:

- 安装需要sudo权限(管理员权限)

- 如果提示权限不足,联系管理员

- 云主机默认账户通常已有sudo权限

4. 存储空间:

- 每个模型占用1-10GB空间不等

- 使用

df -h查看可用空间 - 建议保留至少20GB空闲空间

✅ 本步骤完成标准:

- Ollama服务成功安装

-

ollama --version能正确显示版本号 - Ollama服务处于运行状态

- 能够访问Ollama API接口

6.2.1 DeepSeek模型下载与部署

📌 训练任务步骤2:使用Ollama部署DeepSeek模型

重要性:⭐⭐⭐⭐⭐(核心步骤)

预计耗时:10-30分钟(取决于网络速度)

🚀 使用Ollama部署DeepSeek

1. 下载并运行模型:

# 部署DeepSeek-R1 1.5B版本

# 命令说明:

# ollama run:启动并运行模型

# deepseek-r1:1.5b:模型名称和版本标签

#

# 执行流程:

# 1. Ollama检查本地是否已有该模型

# 2. 如果没有,自动从仓库下载(约1-2GB)

# 3. 加载模型到内存

# 4. 进入交互式对话模式

ollama run deepseek-r1:1.5b

预期输出:

pulling manifest

pulling 9e438... 100% ▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓ 1.5 GB

verifying sha256 digest

writing manifest

success

>>>

2. 测试模型功能:

# 在交互式界面中输入测试问题

>>> 你好,请介绍一下自己

# 预期回复示例:

你好!我是DeepSeek,一个大型语言模型。我可以帮助你回答问题、

进行对话、提供建议等。我的特点是能够进行深度思考和推理。

请问有什么我可以帮助你的吗?

>>> 2+2等于多少?请展示你的思考过程

# 预期回复(展示思维链):

<think>

这是一个简单的算术问题。

2 + 2 = 4

</think>

答案是4。

>>> exit # 输入exit退出对话

3. 常用模型管理命令:

# 查看已安装的模型列表

ollama list

# 输出示例:

# NAME SIZE MODIFIED

# deepseek-r1:1.5b 1.5 GB 2 hours ago

# 查看模型详细信息

ollama show deepseek-r1:1.5b

# 删除不需要的模型(释放磁盘空间)

ollama rm deepseek-r1:1.5b

# 仅下载模型不运行

ollama pull deepseek-r1:1.5b

# 查看Ollama服务状态

ps aux | grep ollama

✅ 验证成功标准:

- 模型下载成功,无错误提示

- 能够进入交互式对话界面

- 模型能够正确回答简单问题

- 能够看到DeepSeek的思维链推理过程(标签)

6.3 开发环境配置

💻 虚拟环境是什么?

技术定义:

虚拟环境(Virtual Environment)是Python的隔离开发环境机制,它为每个项目创建独立的包依赖空间,避免不同项目间的依赖冲突。

技术原理:

- 环境隔离:每个虚拟环境有独立的Python解释器和库目录

- 依赖管理:不同项目可以使用不同版本的同一个库

- 系统保护:不会污染系统级Python环境

实际应用场景:

项目A:使用TensorFlow 2.10 + Python 3.9

项目B:使用TensorFlow 1.15 + Python 3.7

没有虚拟环境 → 版本冲突,无法同时开发

有虚拟环境 → 各自独立,互不干扰

Python虚拟环境创建:

# 创建虚拟环境

python -m venv agent_env

# 激活虚拟环境

# Windows:

agent_env\Scripts\activate

# Linux/Mac:

source agent_env/bin/activate

# 激活后的命令行前会显示(agent_env)标识

Java虚拟环境(Maven依赖隔离):

<!-- Maven项目的pom.xml配置 -->

<project>

<modelVersion>4.0.0</modelVersion>

<groupId>com.example</groupId>

<artifactId>agent-system</artifactId>

<version>1.0-SNAPSHOT</version>

<dependencies>

<!-- Spring Boot依赖 -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

<version>2.7.5</version>

</dependency>

<!-- DJL深度学习框架 -->

<dependency>

<groupId>ai.djl</groupId>

<artifactId>api</artifactId>

<version>0.24.0</version>

</dependency>

<!-- OpenAI Java客户端 -->

<dependency>

<groupId>com.theokanning.openai-gpt3-java</groupId>

<artifactId>service</artifactId>

<version>0.16.0</version>

</dependency>

</dependencies>

</project>

包管理工具详解

1. pip - Python包管理器

技术特性:

- 包索引:从PyPI(Python Package Index)下载包

- 依赖解析:自动处理包之间的依赖关系

- 版本管理:支持指定包的具体版本

常用命令详解:

# 安装包

pip install package_name

# 安装指定版本

pip install package_name==1.2.3

# 批量安装(从requirements.txt)

pip install -r requirements.txt

# 导出当前环境的包列表

pip freeze > requirements.txt

# 卸载包

pip uninstall package_name

# 查看已安装包

pip list

# 查看包详细信息

pip show package_name

# 检查包的依赖关系

pip check

# 使用国内镜像源加速(清华源)

pip install -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple/ package_name

# 永久配置镜像源

pip config set global.index-url https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple/

2. Maven - Java包管理器

技术特性:

- 中央仓库:从Maven Central Repository下载依赖

- 生命周期管理:编译、测试、打包、部署自动化

- 项目标准化:统一的项目结构和构建流程

常用命令详解:

# 创建Maven项目

mvn archetype:generate -DgroupId=com.example -DartifactId=my-app

# 编译项目

mvn compile

# 运行测试

mvn test

# 打包项目(生成jar或war)

mvn package

# 清理编译结果

mvn clean

# 安装到本地仓库

mvn install

# 下载依赖

mvn dependency:resolve

# 查看依赖树

mvn dependency:tree

# 使用国内镜像源(阿里云)

# 在settings.xml中配置:

<mirror>

<id>aliyun</id>

<mirrorOf>central</mirrorOf>

<url>https://maven.aliyun.com/repository/public</url>

</mirror>

安装必要库:

Python环境配置:

# 升级pip到最新版本

pip install --upgrade pip -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

# 安装AutoGen框架(多智能体系统)

pip install pyautogen -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

# 安装OpenAI客户端(API调用)

pip install openai -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

# 安装MindSpore(深度学习框架)

pip install mindspore -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

# 安装常用数据处理库

pip install pandas numpy matplotlib scikit-learn -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

Java环境配置(pom.xml):

<dependencies>

<!-- AutoGen替代方案:LangChain4j -->

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j</artifactId>

<version>0.25.0</version>

</dependency>

<!-- OpenAI Java客户端 -->

<dependency>

<groupId>com.theokanning.openai-gpt3-java</groupId>

<artifactId>service</artifactId>

<version>0.16.0</version>

</dependency>

<!-- DJL深度学习框架 -->

<dependency>

<groupId>ai.djl</groupId>

<artifactId>api</artifactId>

<version>0.24.0</version>

</dependency>

<!-- Apache Commons工具库 -->

<dependency>

<groupId>org.apache.commons</groupId>

<artifactId>commons-text</artifactId>

<version>1.10.0</version>

</dependency>

</dependencies>

7. Agent智能体:数字世界的分身术

🎯 核心训练任务提醒:

本章是训练任务的核心实践部分!我们将通过部署DeepSeek模型,使用AutoGen框架创建Agent智能体,实现智能助手的设定。这是本课程的重点和难点,请认真学习每个步骤。任务目标:

- ✅ 通过提示词工程创建具有特定角色的Agent

- ✅ 实现健康助手和调酒师两个不同角色的Agent

- ✅ 理解Agent与普通对话系统的本质区别

- ✅ 掌握Agent的设计、开发、测试全流程

7.1 Agent是什么?

引入故事:就像古代大户人家根据不同需要请不同的专业师傅。

技术定义:

Agent智能体是基于大语言模型的专业化AI应用系统,具体特征:

- 技术分类:LLM应用层框架

- 核心概念:通过提示词工程实现角色专业化

- 实现方式:系统提示词 + 知识库 + 交互逻辑

- 应用场景:专业咨询、客户服务、教育培训等

技术实现原理

Agent系统架构:

Agent技术架构

├── 用户接口层:Web界面、API接口、聊天界面

├── 对话管理层:会话状态、上下文管理

├── Agent核心层:角色设定、知识检索、推理生成

├── 知识库层:专业知识、规则库、案例库

├── LLM接口层:模型调用、参数配置

└── 数据存储层:对话历史、用户数据

核心技术组件:

-

System Prompt(系统提示词)

- 技术原理:预定义的角色指令,指导模型行为

- 实现方式:结构化文本,定义角色、技能、约束

- 作用机制:影响模型的输出风格和内容范围

-

RAG(检索增强生成)

- 技术原理:结合外部知识库的生成式AI

- 实现方式:向量数据库 + 相似度检索 + 上下文注入

- 作用:提供专业、准确、实时的知识支持

-

Function Calling(函数调用)

- 技术原理:让AI模型调用外部工具或API

- 实现方式:预定义函数签名,模型生成调用参数

- 应用:计算器、数据库查询、外部服务调用

Agent vs 通用聊天机器人对比

| 技术维度 | 通用聊天机器人 | Agent智能体 |

|---|---|---|

| 提示词设计 | 通用提示词 | 专业化系统提示词 |

| 知识来源 | 预训练知识 | 预训练+专业知识库 |

| 响应一致性 | 变化较大 | 角色一致性强 |

| 专业深度 | 广而浅 | 窄而深 |

| 可控性 | 较低 | 高(可精确控制) |

| 部署复杂度 | 简单 | 复杂(需配置知识库) |

Agent的关键技术要素

-

角色设定(Role Definition)

-

技术实现:结构化的系统提示词

-

包含内容:身份、专业领域、性格特征、交互风格

-

示例格式:

# 角色 你是一位专业的医疗顾问 ## 专业领域 - 常见疾病诊断 - 药物推荐 ## 交互风格 - 专业严谨 - 关怀耐心

-

-

知识库集成(Knowledge Base)

- 技术实现:向量数据库 + 语义检索

- 数据格式:结构化文档、FAQ、专业资料

- 检索机制:基于embedding的相似度匹配

-

约束规则(Constraints)

- 技术实现:规则引擎 + 内容过滤

- 约束类型:回答范围、安全规则、合规要求

- 实现方式:正则表达式、关键词过滤、语义判断

-

状态管理(State Management)

- 技术实现:会话存储 + 上下文维护

- 存储内容:对话历史、用户偏好、任务状态

- 实现方式:内存存储、数据库持久化

7.2 健康助手Agent开发

👨⚕️ 项目结构

Agent项目/

├── demo.py # 主程序文件

├── 提示词.txt # 角色设定文件

└── OAI_CONFIG_LIST.json # API配置文件

📝 核心代码解析

技术原理:Agent系统的核心是通过配置不同的系统提示词来实现角色专业化。系统采用发布-订阅模式管理多个智能体间的消息传递,通过状态机模式控制对话流程,并集成外部LLM API进行自然语言生成。

Python实现(AutoGen框架):

点击展开查看健康助手Agent完整实现代码from autogen import UserProxyAgent, ConversableAgent, config_list_from_json

import json

import os

def create_health_assistant():

"""创建健康助手Agent"""

# 读取系统提示词配置

with open('health_assistant_prompt.txt', encoding='utf-8') as f:

system_prompt = f.read()

# 读取API配置文件

with open('llm_config.json', encoding='utf-8') as f:

config_list = json.load(f)

# 创建专业健康助手Agent

health_assistant = ConversableAgent(

name="health_assistant",

llm_config={

"config_list": config_list,

"temperature": 0.7, # 控制回答的随机性

"max_tokens": 500, # 限制回答长度

"timeout": 30 # API调用超时设置

},

system_message=system_prompt,

max_consecutive_auto_reply=10, # 最大连续回复次数

human_input_mode="NEVER" # 不需要人工干预

)

# 创建用户代理

user_proxy = UserProxyAgent(

name="user",

code_execution_config=False, # 禁用代码执行