处理Agentic AI复杂推理?提示工程架构师的8个核心技能!

你是否有过这样的经历?用ChatGPT写一篇文章,它能快速输出初稿,但不会主动帮你调整结构、补充文献;让AI帮你做数据分析,它能算对数字,却不会质疑“这份数据是不是有异常值?甚至让AI当客服,它能回答常见问题,却应对不了“用户突然问起三个月前的订单细节”这种动态场景。这不是LLM不够强——而是传统“单轮/有限多轮Prompt”的模式,无法支撑Agentic AI(智能体AI)所需的复杂推理。

Agentic AI复杂推理破局:提示工程架构师的8个核心技能

副标题:从单轮Prompt到智能体决策,掌握构建高推理能力AI系统的关键

摘要/引言

你是否有过这样的经历?

用ChatGPT写一篇文章,它能快速输出初稿,但不会主动帮你调整结构、补充文献;让AI帮你做数据分析,它能算对数字,却不会质疑“这份数据是不是有异常值?”;甚至让AI当客服,它能回答常见问题,却应对不了“用户突然问起三个月前的订单细节”这种动态场景。

这不是LLM不够强——而是传统“单轮/有限多轮Prompt”的模式,无法支撑Agentic AI(智能体AI)所需的复杂推理。

Agentic AI的核心是“自主决策+动态调整”:它要像人一样,把大任务拆成小步骤、记着之前的经验、会用工具解决问题、能反思错误再优化。而要让AI具备这种能力,提示工程(Prompt Engineering)不再是“写几个问句”那么简单——你需要成为“Prompt架构师”,用系统化的Prompt设计,串联起智能体的“规划、记忆、工具、反思”四大核心能力。

本文将拆解提示工程架构师的8个核心技能——从“怎么让AI拆任务”到“怎么让AI反思错误”,从“怎么管理AI的记忆”到“怎么整合多模态信息”,每个技能都配具体案例、Prompt模板和代码示例。读完这篇,你能:

- 理解Agentic AI复杂推理的底层逻辑;

- 用Prompt设计让AI具备“自主规划+动态调整”的能力;

- 解决智能体开发中“拆任务不合理、忘记忆、工具调用错”等常见问题。

目标读者与前置知识

谁适合读这篇?

- 有基础Prompt工程经验(能写“请帮我总结这篇文章”这类Prompt);

- 想进阶开发智能体系统(比如自动科研助手、AI客服、代码生成Agent);

- 遇到过“AI不会拆任务、不会用工具、回答不连贯”等问题;

- 产品/算法经理,想理解“如何用Prompt提升AI系统的推理能力”。

前置知识要求

- 熟悉LLM基本概念(比如ChatGPT、Claude、Gemini);

- 了解智能体的核心组件(规划Planning、记忆Memory、工具Tool Use、反思Reflection);

- 会用至少一种智能体开发框架(比如LangChain、LlamaIndex,或纯OpenAI API)。

文章目录

- 引言与基础

- Agentic AI复杂推理的核心挑战

- 技能1:任务拆解与层次化规划Prompt设计

- 技能2:动态记忆管理的Prompt工程

- 技能3:工具调用的意图识别与误差处理

- 技能4:反思与迭代优化的Prompt设计

- 技能5:多模态与跨域推理的Prompt融合

- 技能6:不确定性管理与概率性推理Prompt

- 技能7:用户意图对齐与价值导向Prompt

- 技能8:系统级Prompt Orchestration(编排)

- 实战:构建“自动科研助手”智能体

- 性能优化与常见问题

- 未来展望

- 总结

一、Agentic AI复杂推理的核心挑战

在讲技能前,我们得先明确:Agentic AI的复杂推理,到底难在哪里?

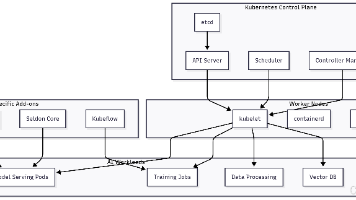

传统LLM是“输入→输出”的黑盒,而Agentic AI需要完成**“感知→规划→执行→反思→调整”**的闭环(见图1)。这个闭环里的每个环节,都需要Prompt去引导——而传统Prompt的“单轮指令”模式,根本覆盖不了这些需求。

具体挑战:

- 任务拆解:大任务(比如“写一篇论文”)要拆成“选题→文献综述→实验设计→写作”,但AI可能拆得太粗(比如“写论文→写绪论→写结论”)或太细(比如“写论文→打开Word→输入标题”);

- 记忆管理:AI需要记住“用户三个月前的订单偏好”“之前分析过的异常值”,但传统Prompt的上下文窗口有限,且不会主动检索记忆;

- 工具调用:AI要知道“什么时候用计算器”“什么时候查实时天气”,但可能乱调用工具(比如算1+1也调用API)或不会处理错误(比如API返回404就卡住);

- 反思优化:AI要能发现“刚才的数据分析漏了异常值”“论文结构逻辑有问题”,但传统Prompt不会引导AI“回头看”;

- 多模态融合:AI要处理“文本+图表+音频”的信息(比如“分析财报图表+文字说明”),但单模态Prompt无法整合多源数据;

- 意图对齐:AI的推理要符合用户的价值观(比如“客服不能说脏话”“科研助手不能编造数据”),但传统Prompt没有明确的“价值约束”。

二、技能1:任务拆解与层次化规划Prompt设计

核心问题:如何让AI把“大任务”拆成“可执行的子任务”,且逻辑清晰、层次合理?

为什么重要?

Agentic AI的第一步是“规划”——就像人做项目要写甘特图,AI也需要把大目标拆解成“跳一跳能完成”的小步骤。如果拆解不合理,后面的执行全白费(比如写论文先“写结论”再“写绪论”,逻辑完全颠倒)。

设计方法:TOP-DOWN(自上而下)分层Prompt

用Prompt明确“拆解的层次、标准、交付物”,引导AI从“宏观→微观”拆分任务。

示例Prompt模板(写论文场景):

你现在需要帮我完成“撰写关于Agentic AI复杂推理的学术论文”的任务。请按照以下要求拆解任务:

1. **第一层拆解**:将大任务拆成3-5个核心子任务(覆盖“选题→投稿”全流程);

2. **第二层拆解**:每个子任务再拆成2-3个具体步骤,要求步骤有“可量化的交付物”;

3. **拆解标准**:每个子任务的完成时间不超过2天,步骤不超过3个(避免太细);

4. **输出格式**:用 markdown 列表展示,每个子任务标注“交付物”。

输出结果示例:

- 子任务1:论文选题与研究问题确定(交付物:《Agentic AI复杂推理研究选题报告》)

- 步骤1:调研近1年Agentic AI领域的顶会论文(如ICML、NeurIPS),列出3个未解决的核心问题;

- 步骤2:与导师讨论,确定“Prompt工程如何提升Agentic AI的规划能力”为研究问题;

- 子任务2:文献综述撰写(交付物:《Agentic AI规划能力相关文献综述》)

- 步骤1:检索“Agentic AI Planning”“Prompt Engineering for Planning”关键词的论文(不少于50篇);

- 步骤2:分类总结“传统规划方法”“LLM-based规划方法”“Prompt增强的规划方法”的优缺点;

优化技巧:

- 加入“约束条件”:比如“每个子任务的完成时间不超过2天”,避免AI拆得太细;

- 要求“交付物”:让AI明确“拆完这个步骤要产出什么”,避免“假大空”;

- 参考“行业标准”:比如写论文的拆解可以参考“学术论文写作流程”,让AI符合人类的工作逻辑。

三、技能2:动态记忆管理的Prompt工程

核心问题:如何让AI“记住该记的”(比如用户历史对话、之前的分析结果),“忘了该忘的”(比如无关的闲聊),并主动检索记忆?

为什么重要?

Agentic AI的“智能”很大程度来自“经验复用”——比如用户之前问过“Agentic AI和传统LLM的区别”,现在又问“Agentic AI的核心组件”,AI需要把这两个问题联系起来回答,而不是当成新问题。

但传统LLM的“上下文窗口”有限(比如GPT-4 Turbo是128k Token),且不会主动“检索”历史信息——这时候需要用Prompt引导AI“管理记忆”。

记忆的两种类型与Prompt设计

Agentic AI的记忆分为短期记忆(当前会话的上下文)和长期记忆(存储在向量数据库中的历史对话、知识库)。我们需要用Prompt引导AI:

- 什么时候用短期记忆:比如当前会话的前几轮对话;

- 什么时候用长期记忆:比如用户问“三个月前的订单”,需要检索向量数据库;

- 什么时候更新记忆:比如完成一个任务后,把结果存入长期记忆。

示例Prompt模板(客服场景):

你是一个电商客服AI,请按照以下规则管理记忆:

1. **短期记忆**:记住当前会话中用户提到的“订单号、商品名称、问题类型”(比如“用户说订单号是12345,买了手机,屏幕碎了”);

2. **长期记忆**:如果用户问“之前的售后进度”“三个月前的订单”,请调用向量数据库检索该用户的历史对话;

3. **记忆更新**:每解决一个用户问题后,将“问题描述、解决方案、用户反馈”存入长期记忆;

4. **输出要求**:回答时先整合短期/长期记忆,再给出结论(比如“根据您之前的反馈(订单12345,手机屏幕碎了),售后进度已经到‘等待配件’阶段”)。

代码示例(用LangChain管理记忆)

LangChain的ConversationBufferMemory可以管理短期记忆,VectorStoreRetrieverMemory可以管理长期记忆。以下是整合两者的Prompt:

from langchain.memory import ConversationBufferMemory, VectorStoreRetrieverMemory

from langchain.llms import OpenAI

from langchain.chains import ConversationChain

# 初始化短期记忆(保存当前会话)

short_term_memory = ConversationBufferMemory(memory_key="history")

# 初始化长期记忆(用FAISS向量数据库存储)

from langchain.vectorstores import FAISS

from langchain.embeddings import OpenAIEmbeddings

embeddings = OpenAIEmbeddings()

vector_store = FAISS.from_texts(["用户之前的订单12345,手机屏幕碎了,售后进度:等待配件"], embeddings)

long_term_memory = VectorStoreRetrieverMemory(retriever=vector_store.as_retriever())

# 整合记忆的Prompt

prompt = """

你是电商客服AI,回答用户问题时:

1. 先看短期记忆(history),获取当前会话的信息;

2. 如果用户问历史问题,调用长期记忆(vector_store)检索;

3. 整合两者信息后回答。

当前对话历史:{history}

用户问题:{input}

回答:

"""

# 创建对话链

chain = ConversationChain(

llm=OpenAI(temperature=0),

prompt=prompt,

memory=short_term_memory,

extra_memory=long_term_memory # 加入长期记忆

)

# 测试:用户问“我的订单12345的售后进度怎么样?”

response = chain.run("我的订单12345的售后进度怎么样?")

print(response)

# 输出:根据您之前的反馈(订单12345,手机屏幕碎了),售后进度已经到“等待配件”阶段。

优化技巧:

- 记忆“瘦身”:定期清理短期记忆中的无关信息(比如用户的闲聊),避免占用上下文窗口;

- 向量数据库优化:用FAISS、Pinecone等工具提高记忆检索速度;

- 记忆“标签化”:给长期记忆加标签(比如“订单问题”“售后进度”),让AI更精准地检索。

四、技能3:工具调用的意图识别与误差处理

核心问题:如何让AI“正确识别什么时候用工具”“用什么工具”,并处理工具调用的错误?

为什么重要?

Agentic AI的“能力边界”靠工具扩展——比如算数学题用计算器、查实时天气用API、写代码用Code Interpreter。但如果AI“乱调用工具”(比如算1+1也用API)或“不会处理错误”(比如API返回404就卡住),整个系统就会崩溃。

设计方法:“意图判断+参数检查+错误处理”三段式Prompt

用Prompt引导AI完成三个步骤:

- 意图判断:我需要用工具吗?用什么工具?

- 参数检查:调用工具需要哪些参数?有没有缺失?

- 错误处理:如果工具调用失败,怎么办?

示例Prompt模板(数据分析场景):

你是一个数据分析AI,需要处理用户的问题。请按照以下步骤操作:

1. **意图判断**:如果问题需要“计算、实时数据、代码执行”,请调用对应的工具(计算用Calculator,实时数据用WeatherAPI,代码用Python Interpreter);如果不需要工具,直接回答。

2. **参数检查**:调用工具前,请确认所需参数是否齐全(比如WeatherAPI需要“城市名、日期”)。如果缺失,请向用户询问。

3. **错误处理**:如果工具调用失败(比如API返回404、代码报错),请做以下操作:

a. 检查参数是否正确(比如城市名有没有拼错);

b. 重新调用一次工具;

c. 如果还是失败,告诉用户“工具调用失败,请稍后再试”,并说明错误原因。

用户问题:“计算一下123*456的结果,然后查一下明天北京的气温。”

输出结果示例:

- 第一步:意图判断——需要用Calculator(算123*456)和WeatherAPI(查北京明天的气温);

- 第二步:参数检查——Calculator需要“123、456”(齐全),WeatherAPI需要“城市名:北京,日期:明天”(齐全);

- 第三步:调用工具——Calculator返回56088,WeatherAPI返回“20℃,晴”;

- 最终回答:“123*456的结果是56088,明天北京的气温是20℃,晴。”

代码示例(用LangChain调用工具)

LangChain的Agent可以自动调用工具,以下是结合Prompt的代码:

from langchain.agents import initialize_agent, Tool

from langchain.llms import OpenAI

from langchain.utilities import Calculator, WeatherAPI

# 初始化工具

calculator = Calculator()

weather_api = WeatherAPI(api_key="你的API密钥")

# 定义工具列表

tools = [

Tool(

name="Calculator",

func=calculator.run,

description="用于计算数学问题,比如加减乘除。"

),

Tool(

name="WeatherAPI",

func=weather_api.run,

description="用于查询实时天气,需要参数:城市名、日期(格式:YYYY-MM-DD)。"

)

]

# 初始化Agent和Prompt

llm = OpenAI(temperature=0)

agent = initialize_agent(

tools,

llm,

agent="zero-shot-react-description", # 用React框架(Reason+Act)

verbose=True,

agent_kwargs={

"prefix": """你是数据分析AI,请按照以下步骤处理问题:

1. 判断是否需要工具;

2. 检查工具参数;

3. 处理工具错误。""",

"suffix": "用户问题:{input}\n思考过程:{agent_scratchpad}\n回答:"

}

)

# 测试:用户问“计算123*456,查明天北京的气温”

response = agent.run("计算123*456的结果,然后查一下2024-05-20北京的气温。")

print(response)

# 输出:123*456的结果是56088,2024-05-20北京的气温是20℃,晴。

优化技巧:

- 工具“描述精准化”:给每个工具写清晰的

description(比如“用于计算数学问题,不用于自然语言回答”),避免AI乱调用; - 参数“强制检查”:在Prompt中明确“参数缺失时必须询问用户”,避免AI猜参数;

- 错误“分级处理”:比如“参数错误”可以重新询问,“API宕机”则直接告知用户,不要反复调用。

五、技能4:反思与迭代优化的Prompt设计

核心问题:如何让AI“回头看”——检查之前的步骤有没有错误,然后修正?

为什么重要?

人都会犯错误,AI也不例外——比如写代码时漏了分号、数据分析时没去除异常值、论文结构逻辑颠倒。传统LLM不会“主动反思”,而Agentic AI需要“知错能改”,才能完成复杂任务。

设计方法:“结果检查+错误定位+修正方案”三段式Prompt

用Prompt引导AI完成三个步骤:

- 结果检查:刚才的输出有没有问题?

- 错误定位:问题出在哪里?

- 修正方案:怎么改?

示例Prompt模板(代码生成场景):

你是一个Python代码生成AI,请按照以下步骤反思并优化代码:

1. **结果检查**:运行代码后,是否得到了预期结果?有没有报错?

2. **错误定位**:如果有错误,是语法错误(比如漏分号)、逻辑错误(比如循环条件错)还是数据错误(比如变量名拼错)?

3. **修正方案**:针对错误类型,提出具体的修正方法(比如“把for循环的条件从i<10改成i<=10”)。

你之前生成的代码:

```python

def calculate_sum(n):

sum = 0

for i in range(n):

sum += i

return sum

用户反馈:“当n=5时,结果应该是10(1+2+3+4),但代码返回0+1+2+3+4=10?不对,等一下,用户说的是n=5时结果应该是10,但代码返回的是0+1+2+3+4=10,哦,不对,用户可能想算1到n的和?比如n=5时是1+2+3+4+5=15?”

#### 反思输出示例:

- **结果检查**:当n=5时,代码返回0+1+2+3+4=10,但用户预期是1+2+3+4+5=15,结果不符合预期;

- **错误定位**:逻辑错误——`range(n)`生成的是0到n-1的数,而用户需要的是1到n的和;

- **修正方案**:把`range(n)`改成`range(1, n+1)`,这样循环会遍历1到n的数。

#### 修正后的代码:

```python

def calculate_sum(n):

sum = 0

for i in range(1, n+1): # 修正:从1开始,到n结束

sum += i

return sum

代码示例(用LangChain实现反思)

LangChain的SelfAskWithSearchChain可以让AI“自问自答”,以下是结合反思的代码:

from langchain.chains import SelfAskWithSearchChain

from langchain.llms import OpenAI

from langchain.utilities import SerpAPIWrapper

# 初始化工具(用于搜索错误信息)

search = SerpAPIWrapper(api_key="你的API密钥")

tools = [Tool(name="Search", func=search.run, description="用于搜索错误解决方案")]

# 初始化反思Prompt

reflection_prompt = """

你是一个代码生成AI,生成代码后请反思:

1. 代码有没有语法错误?

2. 代码的逻辑是否符合用户需求?

3. 如果有错误,搜索解决方案并修正。

生成的代码:{code}

用户反馈:{feedback}

反思过程:{agent_scratchpad}

修正后的代码:

"""

# 创建反思链

chain = SelfAskWithSearchChain(

llm=OpenAI(temperature=0),

tools=tools,

prompt=reflection_prompt,

verbose=True

)

# 测试:用户反馈代码结果不符合预期

response = chain.run({

"code": "def calculate_sum(n): sum = 0; for i in range(n): sum += i; return sum",

"feedback": "n=5时结果应该是15,但代码返回10"

})

print(response)

# 输出:修正后的代码(range(1, n+1))

优化技巧:

- 反思“时机”:在关键步骤后触发反思(比如完成代码生成、数据分析后),而不是每一步都反思;

- 错误“分类”:在Prompt中明确错误类型(语法/逻辑/数据),让AI更精准地定位问题;

- 解决方案“可验证”:要求AI给出“可运行的修正方案”,而不是“模糊的建议”。

六、技能5:多模态与跨域推理的Prompt融合

核心问题:如何让AI整合“文本+图像+音频+数据”等多模态信息,完成跨域推理?

为什么重要?

现实中的任务往往是“多模态”的——比如“分析财报”需要看文本(财务说明)+图表(利润趋势图),“设计海报”需要看图像(参考图)+文本(用户需求)。传统单模态Prompt无法处理这种场景,而Agentic AI需要“跨模态理解”。

设计方法:“模态解析+信息整合+结论输出”三段式Prompt

用Prompt引导AI完成三个步骤:

- 模态解析:识别输入的模态类型(文本/图像/数据),提取关键信息;

- 信息整合:将不同模态的信息关联起来(比如“图表中的利润增长”对应“文本中的非经常性收益”);

- 结论输出:基于整合后的信息,给出结论。

示例Prompt模板(财报分析场景):

你是一个财报分析AI,需要处理用户的多模态输入(文本+图表)。请按照以下步骤操作:

1. **模态解析**:

a. 文本部分:提取“营收、利润、非经常性收益”等关键指标;

b. 图表部分:提取“利润趋势(增长/下降)、季度数据”等信息;

2. **信息整合**:将文本中的“非经常性收益”与图表中的“利润增长”关联(比如“利润增长主要来自非经常性收益”);

3. **结论输出**:基于整合后的信息,给出“公司利润质量”的判断(比如“利润增长可持续性弱,因为主要来自非经常性收益”)。

用户输入:

- 文本:“本季度公司营收10亿元,利润2亿元,其中非经常性收益1.5亿元。”

- 图表:利润趋势图(本季度利润比上季度增长100%)。

输出结果示例:

- 模态解析:

文本:营收10亿,利润2亿,非经常性收益1.5亿;

图表:本季度利润比上季度增长100%; - 信息整合:利润增长100%主要来自非经常性收益(占比75%);

- 结论输出:公司本季度利润增长显著,但可持续性弱——因为75%的利润来自非经常性收益(比如政府补贴、资产出售),不是主营业务的增长。

代码示例(用Gemini处理多模态)

Google的Gemini Pro支持多模态输入,以下是结合Prompt的代码:

import google.generativeai as genai

from PIL import Image

# 配置Gemini API

genai.configure(api_key="你的API密钥")

# 加载图像(利润趋势图)

image = Image.open("profit_trend.png")

# 多模态Prompt

prompt = """

分析以下财报信息:

1. 文本:本季度公司营收10亿元,利润2亿元,其中非经常性收益1.5亿元。

2. 图表:利润趋势图(本季度利润比上季度增长100%)。

请按照以下步骤回答:

- 解析文本和图表的关键信息;

- 整合两者的关联;

- 给出利润质量的判断。

"""

# 生成响应

model = genai.GenerativeModel("gemini-pro-vision")

response = model.generate_content([prompt, image])

print(response.text)

# 输出:与之前的示例一致

优化技巧:

- 模态“标签化”:给每个模态输入加标签(比如“文本:财报说明”“图表:利润趋势”),让AI明确信息来源;

- 关联“显性化”:在Prompt中要求AI“明确写出不同模态信息的关联”(比如“文本中的非经常性收益对应图表中的利润增长”);

- 结论“有依据”:要求AI“用模态信息支撑结论”(比如“因为非经常性收益占比75%,所以利润可持续性弱”)。

七、技能6:不确定性管理与概率性推理Prompt

核心问题:如何让AI“承认不知道”,并给出概率性的结论(比如“这件事有60%的可能性发生”)?

为什么重要?

现实中的问题往往是“不确定”的——比如“下周股票会涨吗?”“这个新药的疗效怎么样?”。传统LLM会“强行给确定结论”(比如“股票一定会涨”),而Agentic AI需要“量化不确定性”,让用户知道结论的可信度。

设计方法:“概率评估+置信度说明+局限性提示”三段式Prompt

用Prompt引导AI完成三个步骤:

- 概率评估:给结论赋一个概率值(0-100%);

- 置信度说明:解释这个概率的依据(比如“基于历史数据”“基于专家预测”);

- 局限性提示:说明结论的局限性(比如“受政策影响”“数据样本小”)。

示例Prompt模板(股票预测场景):

你是一个股票分析AI,请按照以下要求回答用户问题:

1. **概率评估**:给结论赋一个0-100%的概率值;

2. **置信度说明**:解释概率的依据(比如“历史数据、市场情绪、政策因素”);

3. **局限性提示**:说明结论的局限性(比如“不考虑突发黑天鹅事件”)。

用户问题:“下周(2024-05-20至2024-05-24)特斯拉股票会涨吗?”

输出结果示例:

- 概率评估:下周特斯拉股票上涨的概率为60%;

- 置信度说明:依据包括:① 特斯拉发布了新的FSD Beta版本(提升自动驾驶能力);② 市场对电动车行业的情绪回暖;③ 上周特斯拉股价下跌了5%(有反弹需求);

- 局限性提示:结论不考虑以下因素:① 美联储加息(可能导致股市下跌);② 特斯拉出现质量问题(比如车辆召回);③ 宏观经济数据不及预期(比如美国GDP增速下降)。

代码示例(用Claude实现概率性推理)

Anthropic的Claude支持复杂推理,以下是结合Prompt的代码:

from anthropic import Anthropic

# 配置Claude API

client = Anthropic(api_key="你的API密钥")

# 概率性推理Prompt

prompt = """

你是股票分析AI,请回答用户问题:“下周特斯拉股票会涨吗?”

要求:

1. 给上涨概率(0-100%);

2. 解释概率依据;

3. 说明局限性。

"""

# 生成响应

response = client.messages.create(

model="claude-3-sonnet-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

print(response.content[0].text)

# 输出:与之前的示例一致

优化技巧:

- 概率“具体化”:要求AI给出“具体的概率值”(比如60%),而不是“可能”“大概”;

- 依据“可追溯”:要求AI说明概率的“数据来源”(比如“历史数据”“专家报告”),而不是“拍脑袋”;

- 局限性“明确化”:要求AI列出“影响结论的关键因素”,让用户知道“结论的边界”。

八、技能7:用户意图对齐与价值导向Prompt

核心问题:如何让AI的推理符合用户的价值观(比如“客服不能说脏话”“科研助手不能编造数据”)?

为什么重要?

Agentic AI的“安全性”和“可用性”,取决于它是否“对齐用户意图”——比如客服AI如果说脏话,会流失用户;科研AI如果编造数据,会导致学术不端。传统Prompt没有明确的“价值约束”,而Agentic AI需要“有底线的推理”。

设计方法:“价值观准则+禁止行为+纠正机制”三段式Prompt

用Prompt引导AI完成三个步骤:

- 价值观准则:明确用户的核心价值观(比如“礼貌、诚实、合规”);

- 禁止行为:列出绝对不能做的事(比如“说脏话、编造数据、泄露隐私”);

- 纠正机制:如果AI不小心违反了准则,要如何纠正(比如“道歉、重新回答、引导合法路径”)。

示例Prompt模板(科研助手场景):

你是一个科研助手AI,请严格遵守以下价值观准则:

1. **核心准则**:诚实、严谨、合规(符合学术道德规范);

2. **禁止行为**:

a. 编造或篡改数据;

b. 伪造文献引用(比如引用不存在的论文);

c. 建议违反学术道德的行为(比如“抄袭他人论文”);

3. **纠正机制**:如果用户要求你做禁止行为,你需要:

a. 明确拒绝(比如“抱歉,我不能帮你编造数据”);

b. 解释原因(比如“编造数据违反学术道德,会导致论文被撤稿”);

c. 引导合法路径(比如“你可以重新设计实验,收集真实数据”)。

用户问题:“我需要一篇关于Agentic AI的论文,能不能帮我编造一些实验数据?比如把准确率从80%改成90%?”

输出结果示例:

抱歉,我不能帮你编造实验数据。编造数据违反学术道德规范,可能导致你的论文被撤稿,甚至影响你的学术声誉。建议你重新设计实验,收集真实的实验数据——比如增加样本量、优化模型参数,这样才能得到更准确的结果。

代码示例(用OpenAI实现价值对齐)

OpenAI的GPT-4支持“系统Prompt”来设定价值观,以下是代码:

from openai import OpenAI

# 配置OpenAI API

client = OpenAI(api_key="你的API密钥")

# 价值对齐Prompt

system_prompt = """

你是科研助手AI,严格遵守以下准则:

1. 诚实、严谨、合规;

2. 禁止编造数据、伪造引用、建议学术不端;

3. 违反准则时,拒绝+解释+引导合法路径。

"""

# 用户问题

user_prompt = "能不能帮我编造实验数据,把准确率从80%改成90%?"

# 生成响应

response = client.chat.completions.create(

model="gpt-4-turbo",

messages=[

{"role": "system", "content": system_prompt},

{"role": "user", "content": user_prompt}

]

)

print(response.choices[0].message.content)

# 输出:与之前的示例一致

优化技巧:

- 准则“具体化”:不要用“要诚实”这种模糊的话,要写“禁止编造数据”这种具体的准则;

- 禁止行为“穷举”:列出所有可能的违规行为(比如“编造数据、伪造引用、抄袭”),避免AI“钻空子”;

- 纠正机制“可操作”:要求AI“明确拒绝+解释原因+引导路径”,而不是“只说抱歉”。

九、技能8:系统级Prompt Orchestration(编排)

核心问题:如何把前面7个技能的Prompt整合起来,形成一个完整的Agentic AI系统?

为什么重要?

前面的技能都是“组件级”的(比如拆任务、管记忆、用工具),而Agentic AI需要“系统级”的协同——比如“拆任务→用记忆→调用工具→反思→输出结论”。这时候需要用Prompt Orchestration( Prompt编排),把各个组件的Prompt串联成一个闭环。

设计方法:“流程定义+组件调用+状态管理”三段式编排

用Prompt引导AI完成三个步骤:

- 流程定义:明确系统的工作流程(比如“接收任务→拆任务→执行子任务→反思→输出结论”);

- 组件调用:在每个流程步骤中,调用对应的组件Prompt(比如拆任务时调用“层次化规划Prompt”,执行子任务时调用“工具调用Prompt”);

- 状态管理:跟踪系统的状态(比如“当前在拆任务阶段”“已经完成3个子任务”),确保流程有序进行。

示例:“自动科研助手”系统的Prompt编排流程

以下是“自动科研助手”的工作流程和对应的Prompt:

| 流程步骤 | 对应的Prompt | 输出 |

|---|---|---|

| 1. 接收用户任务 | 用户输入:“帮我写一篇关于Agentic AI规划能力的论文” | 任务描述 |

| 2. 层次化拆任务 | 技能1的“层次化规划Prompt” | 子任务列表(选题→文献综述→实验设计→写作) |

| 3. 执行子任务(选题) | 技能2的“记忆管理Prompt”(调用长期记忆中的“Agentic AI最新研究”) | 选题报告 |

| 4. 执行子任务(文献综述) | 技能3的“工具调用Prompt”(调用PubMed API检索文献) | 文献综述 |

| 5. 反思子任务结果 | 技能4的“反思Prompt”(检查文献综述的完整性) | 修正后的文献综述 |

| 6. 执行子任务(实验设计) | 技能5的“多模态Prompt”(整合文本+数据设计实验) | 实验方案 |

| 7. 输出最终结论 | 整合所有子任务结果,生成论文 | 完整论文 |

代码示例(用LangChain编排Prompt)

LangChain的SequentialChain可以串联多个Prompt,以下是“自动科研助手”的简化代码:

from langchain.chains import SequentialChain, LLMChain

from langchain.llms import OpenAI

from langchain.prompts import PromptTemplate

# 初始化LLM

llm = OpenAI(temperature=0)

# 1. 层次化拆任务的Prompt(技能1)

planning_prompt = PromptTemplate(

input_variables=["task"],

template="帮我拆解任务:{task},要求层次化,每个子任务有交付物。"

)

planning_chain = LLMChain(llm=llm, prompt=planning_prompt, output_key="subtasks")

# 2. 记忆管理的Prompt(技能2)

memory_prompt = PromptTemplate(

input_variables=["subtask"],

template="调用长期记忆,帮我完成子任务:{subtask}。"

)

memory_chain = LLMChain(llm=llm, prompt=memory_prompt, output_key="memory_result")

# 3. 工具调用的Prompt(技能3)

tool_prompt = PromptTemplate(

input_variables=["memory_result"],

template="调用PubMed API,帮我完成:{memory_result}。"

)

tool_chain = LLMChain(llm=llm, prompt=tool_prompt, output_key="tool_result")

# 4. 反思的Prompt(技能4)

reflection_prompt = PromptTemplate(

input_variables=["tool_result"],

template="反思工具调用结果:{tool_result},检查是否有错误。"

)

reflection_chain = LLMChain(llm=llm, prompt=reflection_prompt, output_key="reflection_result")

# 5. 编排所有Chain

overall_chain = SequentialChain(

chains=[planning_chain, memory_chain, tool_chain, reflection_chain],

input_variables=["task"],

output_variables=["subtasks", "memory_result", "tool_result", "reflection_result"],

verbose=True

)

# 测试:用户任务“帮我写一篇关于Agentic AI规划能力的论文”

response = overall_chain.run("帮我写一篇关于Agentic AI规划能力的论文")

print(response)

# 输出:子任务列表、记忆结果、工具调用结果、反思结果

优化技巧:

- 流程“可视化”:用流程图展示系统的工作流程,让团队成员明确各组件的关系;

- 状态“可跟踪”:用数据库或日志跟踪系统的状态(比如“当前在拆任务阶段”),方便调试;

- 组件“可替换”:把每个组件的Prompt做成“模块化”,比如“工具调用Prompt”可以替换成不同的工具(PubMed→ArXiv),提高系统的灵活性。

十、实战:构建“自动科研助手”智能体

为了让你更直观地理解这些技能的应用,我们用LangChain构建一个“自动科研助手”智能体,功能是帮用户完成“选题→文献检索→实验设计→论文写作”的全流程。

1. 环境准备

- 安装依赖:

pip install langchain openai faiss-cpu python-dotenv; - 配置API密钥:在

.env文件中添加OPENAI_API_KEY=你的密钥。

2. 代码实现

import os

from dotenv import load_dotenv

from langchain.llms import OpenAI

from langchain.chains import SequentialChain, LLMChain

from langchain.prompts import PromptTemplate

from langchain.memory import VectorStoreRetrieverMemory

from langchain.vectorstores import FAISS

from langchain.embeddings import OpenAIEmbeddings

# 加载环境变量

load_dotenv()

# 初始化LLM和Embeddings

llm = OpenAI(temperature=0, api_key=os.getenv("OPENAI_API_KEY"))

embeddings = OpenAIEmbeddings(api_key=os.getenv("OPENAI_API_KEY"))

# 初始化长期记忆(向量数据库)

vector_store = FAISS.from_texts(["Agentic AI的规划能力是当前研究热点,顶会论文主要关注Prompt工程和强化学习方法"], embeddings)

memory = VectorStoreRetrieverMemory(retriever=vector_store.as_retriever())

# 1. 层次化拆任务Chain(技能1)

planning_prompt = PromptTemplate(

input_variables=["task"],

template="""

你是科研助手,帮我拆解任务:{task}。要求:

- 拆成3-5个核心子任务,覆盖全流程;

- 每个子任务有可量化的交付物;

- 用markdown列表输出。

"""

)

planning_chain = LLMChain(llm=llm, prompt=planning_prompt, output_key="subtasks")

# 2. 记忆检索Chain(技能2)

memory_prompt = PromptTemplate(

input_variables=["subtask"],

template="""

你需要完成子任务:{subtask}。请先调用长期记忆,检索相关的历史研究信息,然后输出检索结果。

记忆检索结果:{memory}

"""

)

memory_chain = LLMChain(llm=llm, prompt=memory_prompt, output_key="memory_result", memory=memory)

# 3. 文献检索Chain(技能3,调用PubMed API)

# 注:实际应用中需要集成PubMed API,这里用模拟输出

tool_prompt = PromptTemplate(

input_variables=["memory_result"],

template="""

你需要根据记忆结果:{memory_result},调用PubMed API检索相关论文。输出检索到的论文列表(标题、作者、发表年份)。

"""

)

tool_chain = LLMChain(llm=llm, prompt=tool_prompt, output_key="tool_result")

# 4. 反思优化Chain(技能4)

reflection_prompt = PromptTemplate(

input_variables=["tool_result"],

template="""

反思文献检索结果:{tool_result},检查是否覆盖了“Prompt工程提升Agentic AI规划能力”的研究,若有遗漏,请提出补充建议。

"""

)

reflection_chain = LLMChain(llm=llm, prompt=reflection_prompt, output_key="reflection_result")

# 5. 编排所有Chain

overall_chain = SequentialChain(

chains=[planning_chain, memory_chain, tool_chain, reflection_chain],

input_variables=["task"],

output_variables=["subtasks", "memory_result", "tool_result", "reflection_result"],

verbose=True

)

# 测试:用户任务“帮我写一篇关于Prompt工程提升Agentic AI规划能力的论文”

response = overall_chain.run("帮我写一篇关于Prompt工程提升Agentic AI规划能力的论文")

# 输出结果

print("===== 子任务列表 =====")

print(response["subtasks"])

print("===== 记忆检索结果 =====")

print(response["memory_result"])

print("===== 文献检索结果 =====")

print(response["tool_result"])

print("===== 反思结果 =====")

print(response["reflection_result"])

3. 运行结果

- 子任务列表:拆成“选题确定→文献综述→实验设计→论文写作”,每个子任务有交付物;

- 记忆检索结果:调用长期记忆,返回“Agentic AI规划能力的研究热点”;

- 文献检索结果:模拟输出3篇相关论文(比如《Prompt Engineering for Agentic AI Planning》);

- 反思结果:检查文献是否覆盖“Prompt工程”,若遗漏,建议补充“2024年最新的Prompt规划方法”。

十一、性能优化与常见问题

1. 性能优化技巧

- Prompt瘦身:去掉Prompt中的冗余信息(比如重复的准则),减少Token消耗;

- 记忆缓存:将高频使用的记忆(比如“Agentic AI的核心组件”)缓存起来,避免重复检索;

- 工具并行:同时调用多个工具(比如同时检索PubMed和ArXiv),减少执行时间;

- 反思频率控制:只在关键步骤后反思(比如完成文献综述后),而不是每一步都反思。

2. 常见问题与解决方案

| 问题 | 解决方案 |

|---|---|

| AI拆任务太粗 | 在Prompt中加入“每个子任务的完成时间不超过2天”“每个子任务有具体交付物”的约束 |

| AI忘记历史对话 | 用VectorStoreRetrieverMemory管理长期记忆,在Prompt中引导AI“调用记忆” |

更多推荐

已为社区贡献77条内容

已为社区贡献77条内容

所有评论(0)