告别 Claude 依赖!智谱 GLM-4.6 横空出世,国产编程大模型迎来真正 “王炸“

回顾这段从依赖Claude到转向GLM-4.6的经历,不难发现,国产大模型已经完成了从"替代选择"到"首选工具"的转变。Claude的受限虽然给国内开发者带来了短暂的困扰,但也让我们有机会重新审视国产大模型的发展现状——如今的国产模型,早已不是"只能勉强使用"的水平,而是在性能、体验、性价比等多个维度上,实现了对国际主流模型的追赶甚至超越。GLM-4.6的出现,不仅是智谱AI技术实力的体现,更是国

告别Claude依赖!智谱GLM-4.6横空出世,国产编程大模型迎来真正"王炸"

在国内开发者圈子里,前段时间Anthropic旗下Claude的突然受限,让不少习惯用它做代码开发的人陷入手足无措的境地。曾经顺手的编程助手突然"断联",项目进度被迫搁置,寻找替代工具成了当时的紧急需求。也就是在这个"空窗期",我抱着试试看的心态,开启了与智谱GLM系列大模型的缘分,从最初的GLM Coding Lite包月套餐,到如今最新发布的GLM-4.6,短短时间内,这款国产大模型带来的惊喜不断升级,彻底改变了我对国产编程模型的认知。

最开始选择GLM Coding Lite,一方面是因为它首月仅20元的优惠价格足够亲民,另一方面更关键的是,它无缝兼容Claude Code等主流编程工具,不需要额外学习新的操作逻辑,迁移过程几乎零成本。对于习惯了Claude Code的开发者来说,这种"即插即用"的兼容性太重要了,不需要重新适应新工具,就能快速投入到项目开发中。当时我还对国产模型的代码能力存有疑虑,毕竟之前长期依赖国际主流模型,但实际使用后发现,GLM-4.5的表现已经足够惊艳,无论是日常的代码编写、bug修复,还是简单的项目模块开发,都能高效完成。本以为GLM-4.5已经是国产编程模型的高水平代表,没想到智谱AI很快就推出了新一代旗舰产品——GLM-4.6,直接将国产编程大模型的能力推向了新高度。

一、性能跑分亮眼,国产编程模型首次比肩国际顶尖水平

评判一款大模型的实力,客观的基准测试数据是重要参考。GLM-4.6在多项主流能力测试中,交出了一份堪称"满分"的答卷,尤其是在编程相关的核心基准测试里,不仅远超其他国产模型,更实现了与国际顶尖模型Claude Sonnet系列的比肩。

在涵盖Agentic、推理和编程三大维度的8项关键基准测试(AIME 25、GPQA、LiveCodeBench V6、HLE、BrowseComp、SWE-bench Verified、Terminal-Bench、τ²-Bench)中,GLM-4.6在128K上下文长度下的表现尤为突出。其中,在AIME 25测试中,GLM-4.6获得98.6的高分,远超GLM-4.5的93.9和DeepSeek-V3.2-Exp的85.4,甚至与Claude Sonnet 4的89.3、Claude Sonnet 4.5的87.0相比也毫不逊色;在GPQA测试里,GLM-4.6以84.5的成绩领先,大幅超越GLM-4.5的82.8、DeepSeek-V3.2-Exp的74.3,以及Claude Sonnet系列的79.9;LiveCodeBench V6测试中,GLM-4.6的30.4分更是断层领先,将GLM-4.5的17.2、DeepSeek-V3.2-Exp的19.8和Claude Sonnet系列的17.3远远甩在身后。

这些数据并非单纯的"纸面实力",而是对模型综合能力的直接体现。特别是在开发者最关注的编程领域,GLM-4.6在SWE-bench Verified(软件工程师基准测试)中表现出色,成功完成了大量真实世界的软件工程项目任务,证明其具备解决实际开发问题的能力。根据智谱官方技术报告,GLM-4.6在这8项基准测试中的部分核心成绩,已经达到了Claude Sonnet 4和Claude Sonnet 4.5的水平,在所有国产大模型中稳居首位,即便是最新发布的DeepSeek-V3.2-Exp,也难以与之抗衡。

当然,对于实际开发而言,跑分只是参考,真实场景下的编码能力才是关键。为了验证GLM-4.6的实战水平,智谱团队在Claude Code环境中设计了74个真实编程任务进行测试,结果令人惊喜。在与不同模型的对比中,GLM-4.6展现出压倒性优势:与Claude Sonnet 4相比,GLM-4.6的胜率达到48.6%,平局率9.5%,败率仅41.9%,基本实现追平;与上一代GLM-4.5相比,胜率提升至50.0%,败率降至36.5%;面对Kimi-K2-0905,GLM-4.6的胜率更是高达56.8%,败率仅14.9%;而在与DeepSeek-V3.1-Terminus的对抗中,GLM-4.6以64.9%的胜率、8.1%的平局率和27.0%的败率,展现出绝对的领先地位。

这一系列测试结果彻底打破了"国产模型不如国际模型"的固有认知,"Claude替代"不再是停留在口号层面的愿景,GLM-4.6用实际表现证明,国产编程大模型已经具备与国际主流产品并肩的实力,甚至在部分场景下实现了超越。

二、实战项目开发:从模糊想法到完整功能,GLM-4.6全程可控

为了更深入地体验GLM-4.6的实际开发能力,我以HelloGitHub社区的"学习路径"板块开发为例,全程采用自然语言驱动模型进行编码,模拟真实的项目开发流程。这个板块的核心需求是构建一个前端开发学习路径图,清晰展示从零基础到高级前端工程师的学习节点,每个节点对应具体的知识点和开源项目,帮助社区用户系统学习前端开发。

项目初期,我只有一个模糊的想法,没有具体的设计方案和技术框架规划。首先,我通过自然语言向GLM-4.6描述核心需求:“需要一个前端开发学习路径页面,包含4个主要学习节点,总学习时长约305小时,10个实践项目,支持节点点击查看详情和画布拖拽浏览,同时关联相关开源项目推荐”。短短几分钟后,GLM-4.6就给出了初步的技术方案,包括基于Next.js框架开发、使用Tailwind CSS进行样式设计、采用React组件化构建页面结构等,并生成了基础的项目目录和核心文件代码。

在后续的开发过程中,我通过逐步细化需求,不断向GLM-4.6下达优化指令。比如,当需要为"Web基础"节点添加具体的HTML/CSS项目案例时,我只需描述:“在Web基础节点下增加HTML/CSS基础项目和JavaScript 30项目,项目名称分别为’HTML/CSS基础项目’和’JavaScript 30’,并显示项目对应的技术栈”,GLM-4.6就能快速生成对应的组件代码,并自动关联到学习路径图中。

更值得一提的是,GLM-4.6具备出色的代码文档生成能力。每当完成一个模块的开发,我都会让模型为当前代码生成详细的文档,包括功能说明、参数解释、代码结构分析等。通过阅读这些文档,我能快速掌握代码逻辑,避免因AI生成代码导致的"理解断层",进而更精准地提出优化需求。例如,在生成学习路径图的交互逻辑代码后,GLM-4.6自动生成的文档详细说明了拖拽功能的实现原理、事件监听机制和兼容性处理方案,让我能清晰判断是否需要调整交互体验,大大提升了开发效率。

最终,经过多轮迭代优化,HelloGitHub社区"学习路径"板块成功落地。页面不仅实现了最初设想的所有功能,还具备了良好的响应式设计,在不同设备上都能正常显示。页面顶部展示学习路径标题和总时长,中间是可拖拽的学习路径图,每个节点点击后能显示详细知识点和实践项目,底部则关联了相关开源项目推荐,如Gitmoji-Cli(4.7k星,JavaScript)、Navidrome/Navidro(14.9k星,Go)等,完全满足社区用户的学习需求。

整个开发过程中,最让我印象深刻的是GLM-4.6的"可控性"。以往使用部分AI编程工具时,模型很容易生成逻辑混乱、难以维护的"屎山代码",导致后续优化难度极大。但GLM-4.6生成的代码结构清晰、命名规范,且严格遵循前端开发的最佳实践,即使是复杂的交互逻辑,也能拆分成多个简洁的组件,便于后续修改和扩展。这种"高质量且可控"的编码能力,正是实际项目开发中最需要的核心素质。

三、性价比再升级:性能飙升的同时,成本大幅降低

对于开发者而言,工具的性价比是长期使用的重要考量因素。GLM-4.6在性能全面提升的同时,还实现了使用成本的大幅降低,让"高性能+低价格"的编程体验成为可能。

此前,我使用GLM Coding Lite包月套餐(20元/月)进行高强度开发测试,在连续使用约5小时后,系统提示配额耗尽,此时累计完成的代码修改量为新增4096行、删除2107行,平均每小时的代码处理量约1240行。而升级到GLM-4.6后,同样的套餐额度下,开发时长和代码处理量都有了显著提升。根据官方数据,GLM-4.6的平均token消耗比上一代GLM-4.5节省了30%以上,这意味着在相同的token配额下,开发者可以完成更多的编码任务,或者用更低的成本完成同等规模的项目。

从具体的token消耗对比来看,在多工具调用且无缓存的场景下,GLM-4.6单次交互的平均token用量(输入+输出)远低于其他同类模型:GLM-4.6为651,525 token,GLM-4.5为762,817 token,Kimi-K2-0905为821,759 token,DeepSeek-V3.1-Terminus则高达947,454 token。token消耗的降低直接转化为使用成本的减少,尤其是对于长期依赖AI编程的开发者来说,累计节省的成本相当可观。

与此同时,智谱AI还对Coding Plan套餐进行了全面升级,让不同需求的开发者都能找到适合自己的方案。目前,GLM Coding套餐分为三个档次,且首购首月均享受5折优惠:

- GLM Coding Lite:面向个人开发者的轻量化日常使用,价格为20元/月(首月10元),支持Claude Code等10+编程工具,满足基础的编码需求;

- GLM Coding Pro:针对使用规模较大的高阶用户,价格为40元/月(首月20元),在Lite套餐的基础上,提供5倍用量、40%-60%的生成速度提升,还支持图像视频理解和联网搜索功能;

- GLM Coding Max:为构建复杂项目的重度用户设计,价格为200元/月(首月100元),包含Pro套餐的所有权益,同时提供4倍于Pro套餐的用量、用量高峰优先保障和新功能抢先体验服务。

更具吸引力的是,此前订阅GLM Coding套餐的老用户,无需额外付费,即可自动升级至GLM-4.6版本,相当于用原来的价格享受更强大的性能。对比国际同类产品,GLM-4.6的价格仅为Claude相关套餐的1/7左右,但性能却能达到其90%的水平,这种性价比优势,让越来越多的开发者选择转向国产模型。

四、零迁移成本:从Claude Code到GLM-4.6,只需3步操作

对于习惯使用Claude Code的开发者来说,切换新工具时最担心的就是迁移成本——重新学习操作流程、适配现有项目、调整开发习惯,这些都会耗费大量时间和精力。而GLM-4.6通过对Claude Code的无缝兼容,彻底解决了这一痛点,整个迁移过程只需3步简单操作,几分钟内就能完成。

具体的迁移步骤如下:

- 安装原版Claude Code(已安装可跳过):通过npm命令全局安装Claude Code工具,代码为

npm install -g @anthropic-ai/claude-code; - 配置智谱API参数:首先需要在智谱MaaS平台(bigmodel.cn)开通GLM Coding套餐,获取专属API Key,然后在终端中执行两条命令配置环境变量:

export ANTHROPIC_BASE_URL="https://open.bigmodel.cn/api/anthropic"(指定智谱API的基础地址)export ANTHROPIC_AUTH_TOKEN="你的智谱API Key"(填入个人API Key)

- 启动工具:在终端中输入

claude命令,即可启动Claude Code工具,此时工具已自动接入GLM-4.6模型,无需其他额外设置。

完成以上步骤后,开发者可以继续使用熟悉的Claude Code操作方式进行编程,无论是命令行指令、代码生成逻辑还是交互体验,都与之前完全一致,甚至在生成速度和代码质量上还有所提升。这种"零学习成本"的迁移体验,让开发者可以快速适应新模型,无需因为工具切换而中断项目进度。

为什么选择在命令行中使用Claude Code,而不是主流的AI IDE(如Cursor)?这其实与实际开发场景中的操作习惯密切相关。在日常开发中,我通常会采用"双屏工作流":副屏打开终端,用于执行重启服务、连接远程服务器、Git命令操作等任务;主屏则使用PyCharm或VSCode等常用IDE进行代码编写。此时,终端中的Claude Code就成为了副屏工作流的一部分,不需要额外切换窗口,也不会占用主屏IDE的界面空间,既能保持IDE操作的连贯性,又能随时调用AI编程功能。

相比之下,AI IDE虽然集成了AI功能,但往往需要在IDE内部开辟专门的界面区域,压缩了代码编辑的空间,而且部分操作逻辑与传统IDE存在差异,需要重新适应。对于习惯了传统IDE操作的开发者来说,Claude Code这种"命令行+AI"的模式,更能融入现有的工作流,实现"无缝衔接"的编程体验,而GLM-4.6的兼容能力,恰好保留了这种高效的工作模式。

五、不止于编程:GLM-4.6的全方位能力进化

GLM-4.6的升级不仅体现在编程能力上,更是一次覆盖模型核心功能的全方位进化,在上下文长度、推理能力、内容生成、生态兼容性等多个维度都有显著提升,使其成为一款"全能型"大模型,能够满足更多场景下的开发需求。

(一)超长上下文窗口:轻松处理大型项目与长文档

上下文窗口的大小直接决定了模型能够处理的文本长度,对于大型代码库分析、长文档理解等场景至关重要。GLM-4.6将上下文窗口从GLM-4.5的128K提升至200K,意味着模型一次可以处理约15万字的文本内容(按每个token对应0.75个中文字符计算),足以容纳整个中小型项目的代码库或长篇技术文档。

在实际应用中,超长上下文窗口带来的优势十分明显。例如,在分析一个包含多个模块的前端项目时,GLM-4.6可以一次性读取所有组件代码、配置文件和依赖列表,准确理解项目的整体架构和各模块之间的关联关系,避免因上下文截断导致的逻辑理解偏差。此外,在处理技术文档时,模型能够连贯分析文档中的章节关联、技术原理和操作步骤,生成更全面、准确的总结或实践指南,大幅提升文档处理效率。

(二)更强的推理能力:复杂问题解决与工具调用

推理能力是大模型应对复杂任务的核心素质,GLM-4.6在逻辑推理、数学计算、问题拆解等方面的能力均有显著提升,并且能够在推理过程中自动调用工具,进一步增强问题解决能力。

在编程场景中,推理能力的提升主要体现在复杂bug排查和算法设计上。例如,当遇到一个涉及多模块交互的逻辑bug时,GLM-4.6能够通过逐步分析代码执行流程、变量传递路径和条件判断逻辑,精准定位问题所在,并给出针对性的修复方案;在设计复杂算法(如动态规划、图论相关算法)时,模型能够先拆解问题目标,梳理核心逻辑,再逐步推导算法步骤,确保算法的正确性和高效性。

同时,GLM-4.6支持在推理过程中自动调用搜索工具、数学计算工具等外部资源。例如,当需要使用某个不熟悉的API时,模型会自动调用联网搜索工具,获取最新的API文档和使用案例,并结合项目需求生成正确的调用代码;在处理涉及复杂计算的任务时,模型会调用数学计算工具,确保计算结果的准确性,避免手动计算导致的误差。

(三)更优的内容生成:符合人类偏好,角色扮演更自然

除了编程能力,GLM-4.6在信息检索、文案写作、角色扮演等内容生成场景中也有显著提升,生成的内容更符合人类的阅读习惯和表达偏好,角色定位也更加精准。

在信息检索方面,GLM-4.6能够更准确地理解用户的检索需求,通过联网搜索获取最新、最相关的信息,并对信息进行筛选、整理和归纳,生成结构清晰、重点突出的总结报告。例如,当需要了解"2025年前端框架发展趋势"时,模型会搜索最新的行业报告、技术论坛讨论和框架更新日志,提炼出React、Vue、Svelte等主流框架的发展方向,以及新兴框架的特点和应用场景,为开发者提供有价值的参考。

在文案写作方面,GLM-4.6能够根据不同的场景和需求,调整文案的风格和语气。无论是技术文档、产品介绍、博客文章还是社交媒体文案,模型都能生成符合场景特点的内容,并且语言流畅、逻辑严谨。例如,撰写技术博客时,模型会采用通俗易懂的语言解释复杂的技术概念,搭配代码示例和实践步骤,让读者更容易理解;而撰写产品介绍时,模型会突出产品的核心优势和使用场景,吸引目标用户的关注。

在角色扮演方面,GLM-4.6能够更精准地把握角色的身份定位和语言风格。例如,当要求模型扮演"前端技术面试官"时,模型会根据面试者的技术水平,提出针对性的问题,从基础知识点到项目实战经验,再到技术难点解决方案,层层递进,同时还能对面试者的回答进行点评和补充;而扮演"技术导师"时,模型会耐心解答开发者的疑问,用循序渐进的方式引导开发者解决问题,培养其独立思考能力。

(四)国产化生态兼容:支持国产芯片部署

作为国产大模型的代表,GLM-4.6在生态兼容性上充分考虑了国内开发者的需求,支持在寒武纪、摩尔线程等国产芯片上完成部署,打破了国外芯片对大模型部署的垄断,为国内企业和开发者提供了更安全、可控的部署选择。

对于需要本地化部署大模型的企业来说,国产芯片部署不仅能够降低对国外技术的依赖,还能减少数据跨境传输带来的安全风险,同时在硬件成本和维护服务上也更具优势。GLM-4.6对国产芯片的支持,进一步推动了国产大模型生态的完善,为国内AI技术的自主可控发展提供了有力支撑。

六、开放与普及:多平台上线,降低使用门槛

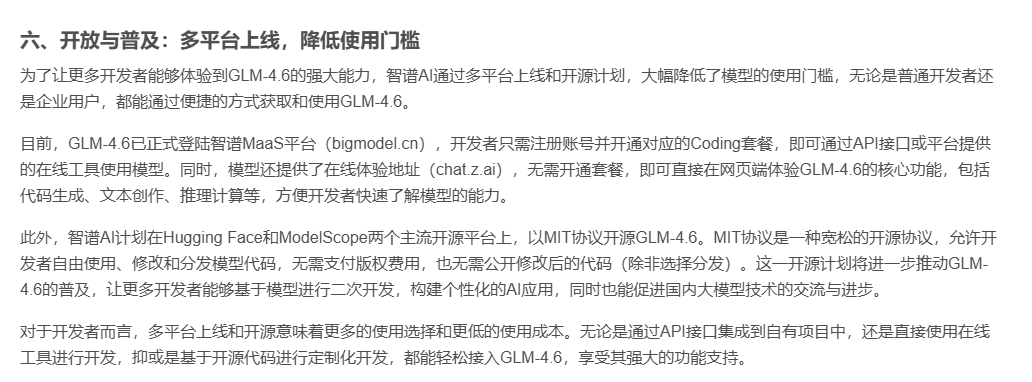

为了让更多开发者能够体验到GLM-4.6的强大能力,智谱AI通过多平台上线和开源计划,大幅降低了模型的使用门槛,无论是普通开发者还是企业用户,都能通过便捷的方式获取和使用GLM-4.6。

目前,GLM-4.6已正式登陆智谱MaaS平台(bigmodel.cn),开发者只需注册账号并开通对应的Coding套餐,即可通过API接口或平台提供的在线工具使用模型。同时,模型还提供了在线体验地址(chat.z.ai),无需开通套餐,即可直接在网页端体验GLM-4.6的核心功能,包括代码生成、文本创作、推理计算等,方便开发者快速了解模型的能力。

此外,智谱AI计划在Hugging Face和ModelScope两个主流开源平台上,以MIT协议开源GLM-4.6。MIT协议是一种宽松的开源协议,允许开发者自由使用、修改和分发模型代码,无需支付版权费用,也无需公开修改后的代码(除非选择分发)。这一开源计划将进一步推动GLM-4.6的普及,让更多开发者能够基于模型进行二次开发,构建个性化的AI应用,同时也能促进国内大模型技术的交流与进步。

对于开发者而言,多平台上线和开源意味着更多的使用选择和更低的使用成本。无论是通过API接口集成到自有项目中,还是直接使用在线工具进行开发,抑或是基于开源代码进行定制化开发,都能轻松接入GLM-4.6,享受其强大的功能支持。

七、结语:从"替代选择"到"首选工具",国产大模型的崛起

回顾这段从依赖Claude到转向GLM-4.6的经历,不难发现,国产大模型已经完成了从"替代选择"到"首选工具"的转变。Claude的受限虽然给国内开发者带来了短暂的困扰,但也让我们有机会重新审视国产大模型的发展现状——如今的国产模型,早已不是"只能勉强使用"的水平,而是在性能、体验、性价比等多个维度上,实现了对国际主流模型的追赶甚至超越。

GLM-4.6的出现,不仅是智谱AI技术实力的体现,更是国产大模型行业发展的一个缩影。从GLM-4.5的"惊喜平替",到GLM-4.6的"全面领先",国产大模型用实际表现证明,只要坚持技术创新和用户需求导向,就能在激烈的国际竞争中占据一席之地。对于国内开发者来说,选择国产模型,不仅意味着更低的使用成本、更稳定的服务和更便捷的迁移体验,更意味着对国产AI技术发展的支持,为国内AI生态的完善贡献一份力量。

未来,随着技术的不断进步和生态的持续完善,国产大模型必将在更多领域实现突破,为开发者带来更强大、更便捷、更具性价比的工具支持。而GLM-4.6,无疑是这场国产大模型崛起浪潮中的一个重要里程碑,它让我们看到了国产AI技术的无限可能,也让我们对未来的开发体验充满期待。如果你还在为寻找合适的编程AI工具而烦恼,不妨试试GLM-4.6,相信它会给你带来意想不到的惊喜。

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)