阅读:Agent AI:Surveying the Horizons of Multimodal Interaction (2.3-3)

本文提出了一种利用通用基础模型(如ChatGPT、GPT-4等)构建具备涌现能力的交互式AI智能体新范式,旨在解决传统AI系统在未知环境中泛化性能不足的问题。核心创新是提出"知识推理交互混合现实"(MR-KII)机制,使智能体能够通过跨模态的微观反应(整合显式网络搜索和隐式模型推理)和现实无关的宏观行为(动态调整交互模式)来适应新环境。该框架利用预训练模型作为基础,支持长期任务

2.3 用于涌现能力的 AI 智能体

尽管交互式 AI 智能体系统日益普及,但大多数已提出的方法在未曾见过的环境或场景中的泛化性能仍然面临挑战。当前的建模实践要求开发者为每个领域准备大型数据集来微调/预训练模型;然而,这个过程成本高昂,如果领域是全新的,甚至是不可能的。为了解决这个问题,我们构建了能够利用通用基础模型(如 ChatGPT、Dall-E、GPT-4 等)的知识记忆库来应对新颖场景的交互式智能体,特别是为了在人类和智能体之间生成一个协作空间。我们发现了一种涌现机制——我们称之为知识推理交互混合现实(Mixed Reality with Knowledge Inference Interaction)——它促进了与人类的协作,以解决复杂现实世界环境中的挑战性任务,并使得探索未见环境以适应虚拟现实成为可能。

对于这种机制,智能体学习: i) 跨模态的微观反应:通过从明确的网络来源以及从预训练模型的输出中进行隐式推断,为每个交互任务(例如,理解未见过的场景)收集相关的个体知识。 ii) 现实无关的宏观行为:改善语言和多模态领域的交互维度和模式,并根据特定角色、某个目标变量以及混合现实和大型语言模型中协作信息多样化的影响来做出改变。

我们研究了知识引导的交互式协同效应对协作式场景生成任务的影响,通过结合各种 OpenAI 模型,并展示了在我们的设定下,交互式智能体系统如何能进一步增强大型基础模型的潜力,这令人鼓舞。它整合并提升了一个复杂自适应 AI 系统的泛化深度、意识和可解释性。

导读与解释

这一节是论文中非常核心和具有前瞻性的部分。作者不再仅仅讨论现有 AI 的问题,而是提出了他们自己的创新性解决方案和概念。

1. 核心挑战:泛化能力差

- 问题:当前的 AI 智能体很“娇贵”,通常只能在它们被专门训练过的特定环境(领域)中表现良好。一旦把它们扔到一个全新的、没见过的环境里,它们往往会“水土不服”,表现很差。

- 传统方法的困境:要想让 AI 适应一个新环境,传统方法是重新收集海量数据进行训练或微调。这既烧钱又费时,对于一个全新的领域来说几乎是不可能的。

2. 作者的破局思路:借力打力

- 核心思想:别再为每个新场景都从零开始“造轮子”了。我们应该利用那些已经非常强大的通用大模型(如 GPT-4)所拥有的庞大“知识记忆库”。让智能体学会调用这些通用知识来解决新问题。

- 目标:创建一个“人机协作空间”,让 AI 和人类可以一起解决那些非常复杂的现实世界任务。

3. 关键创新:知识推理交互混合现实 (MR-KII)

这是作者提出的一个全新机制,名字很长,我们拆开来看:

- 混合现实 (Mixed Reality):意味着这个系统不仅仅是纯虚拟的,它连接了现实世界和虚拟世界。

- 知识推理 (Knowledge Inference):意味着 AI 不仅仅是执行命令,它还能主动地去获取知识并进行推理。

- 交互 (Interaction):强调了 AI 与人类之间的双向沟通和协作。

简单来说,MR-KII 是一种让 AI 在混合现实环境中,通过主动获取知识、进行推理,并与人类紧密协作来完成复杂任务的新范式。

4. AI 在这个新机制下要学什么?

作者把 AI 的学习分成了两个层面:

-

微观反应 (Micro-reactions):针对具体任务的知识获取能力。

- 显式获取:像人一样,去网上(明确的网络来源)搜索信息。

- 隐式推断:利用大模型(如 GPT-4)的内部知识,通过巧妙的提问让模型输出有用的信息,即使这些信息不是直接存储的。

- 例子:当智能体需要理解一个它从未见过的物体时,它会去网上搜索这个物体的资料(显式),同时也会向 GPT-4 提问“这个东西可能是什么?”来获得推断(隐式)。

-

宏观行为 (Macro-behavior):超越具体任务的通用交互策略。

- 现实无关 (Reality-agnostic):AI 的行为模式不应该被某个特定的现实环境锁死,而是要更通用。

- 动态调整:AI 需要学会根据自己的角色(比如是助手还是领导者)、任务目标以及与人类协作中信息的多样性,来动态调整自己的交互方式和行为模式。

- 例子:当 AI 扮演“创意伙伴”时,它会提供更多发散性的建议;当它扮演“执行者”时,它会更关注任务的细节和步骤。

5. 实验与展望

- 作者通过结合多个 OpenAI 模型(文本、图像等)进行了一个“协作式场景生成”的实验,初步验证了他们的想法是可行的。

- 他们认为,这种交互式智能体系统能够反过来“增强(boost)”大模型本身的能力。

- 最终,这种方法有望提升 AI 系统的泛化深度(适应更多未知场景)、意识(对环境和任务有更深层次的感知和理解)和可解释性(其行为和决策过程更容易被人类理解)。

好的,我们来阅读和分析论文的第三章,作者在这里开始正式提出他们构想的全新 AI 智能体范式。

原文翻译

3 AI 智能体范式

在本节中,我们讨论一个用于训练 AI 智能体的全新范式和框架。我们旨在通过我们提出的框架实现以下几个目标:

- 利用现有的预训练模型和预训练策略,来有效地“引导”(bootstrap)我们的智能体,使其具备对重要模态(如文本或视觉输入)的有效理解能力。

- 支持充分的长期任务规划能力。

- 整合一个记忆框架,允许将学到的知识进行编码并在之后进行检索。

- 允许利用环境反馈来有效地训练智能体,使其学会采取何种行动。

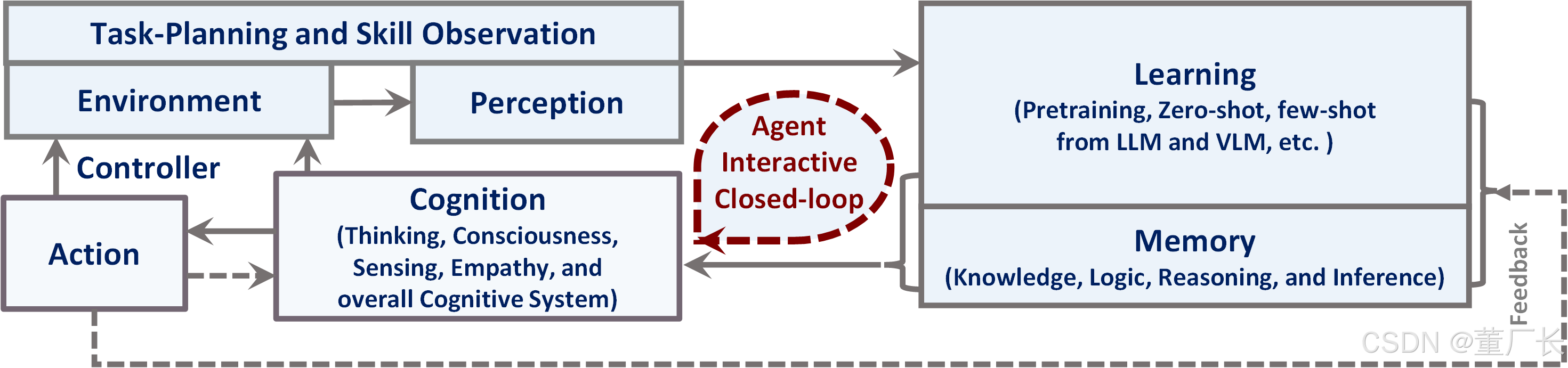

我们在图 5 中展示了一个高级别的新智能体图表,概述了这样一个系统的重要子模块。

导读与解释

这一章是论文的纲领性部分,作者在这里描绘了他们心目中下一代 AI 智能体应该具备的核心能力和基本框架。这不再是对现有问题的分析,而是对未来方向的构想。

作者明确提出了他们设计的 AI 智能体框架需要达成的四大核心目标,这四大目标共同构成了一个能够自主学习、规划和适应的智能系统蓝图。

1. 目标一:站在巨人的肩膀上 (利用预训练模型)

- 核心思想:不从零开始。直接利用像 GPT-4 这样强大的预训练模型作为智能体的“大脑内核”。

- 为什么重要:这些大模型已经学习了海量的文本和图像知识,具备了对世界的基本理解能力。让智能体直接拥有这些能力,就像给一个新生儿直接灌输了人类积累至今的所有常识,大大缩短了学习过程。这个过程在文中被称为“引导”(bootstrap),意为借助现有资源快速启动。

2. 目标二:深谋远虑 (长期任务规划)

- 核心思想:智能体不能只看眼前一步,必须具备“下大棋”的能力。

- 为什么重要:现实世界的任务往往是复杂的,需要一系列连贯的步骤才能完成。例如,“帮我策划一次为期一周的东京旅行”,这需要智能体分解任务(订机票、订酒店、规划行程、预估预算等),并按逻辑顺序执行。这就要求智能体具备长期规划的能力。

3. 目标三:拥有记忆,不断成长 (记忆框架)

- 核心思想:好记性不如烂笔头。智能体需要一个专门的“记忆系统”来存储和调用它学到的知识。

- 为什么重要:一个没有记忆的智能体每次遇到同样的问题都得重新解决,无法进步。记忆框架允许智能体:

- 编码:将新的经验、成功的策略、失败的教训转化成知识并储存起来。

- 检索:在未来遇到相似情况时,能迅速从“记忆库”中找到相关知识来指导行动。

- 这是实现智能体个性化和持续进化的关键。

4. 目标四:从实践中学习 (环境反馈)

- 核心思想:实践是检验真理的唯一标准。智能体必须能在与真实世界的互动中学习。

- 为什么重要:这借鉴了强化学习的核心思想。智能体在环境中做出一个动作后,环境会给它一个“反馈”(比如任务成功了、失败了、或者得到了某个具体结果)。智能体需要利用这个反馈来调整自己的策略,让成功的行为模式得到加强,失败的行为模式得到修正。这使得智能体能够适应特定环境的独特规则,而不仅仅依赖预训练的通用知识。

总结

作者在这里勾勒出了一个理想 AI 智能体的四个基本支柱:

- 强大的初始知识 (来自预训练模型)

- 长远的目标规划能力

- 可累积的经验记忆

- 从互动中自我完善的学习机制

最后,作者预告了接下来的图 5 将会把这个抽象的框架具象化,展示出构成这个系统的各个组件(子模块)以及它们之间的关系。

Q:看上去这个描述很像现在的subagent模式?

A:

“subagent 模式”和论文中描述的这个 AI 智能体范式确实有非常高的相似性,甚至可以说,论文提出的这个框架是实现复杂 subagent 模式的一种理论基础和蓝图。

我们可以从以下几个方面来理解它们的联系:

-

任务分解与规划 (Task Decomposition & Planning):

- Subagent 模式:核心思想就是一个“总管” Agent(Orchestrator)接收一个复杂任务,然后将其分解成多个子任务,分配给不同的、专门的 Subagent(例如,一个负责上网搜索,一个负责编写代码,一个负责总结报告)。

- 论文范式:明确提出了要支持“充分的长期任务规划能力”。这正是那个“总管” Agent 需要具备的核心能力。它必须能够理解最终目标,并规划出达成目标所需的步骤。

-

专业化的模块/工具 (Specialized Modules/Tools):

- Subagent 模式:每个 Subagent 都是一个专家,拥有特定的技能或工具。

- 论文范式:虽然没有直接用 "Subagent" 这个词,但它提到的“重要的子模块 (important submodules)”实际上扮演了同样的角色。我们可以想象:

- 一个“记忆模块”专门负责知识的存储和检索,就像一个“记忆 Subagent”。

- 一个与“环境反馈”交互的模块,就像一个“执行与观察 Subagent”。

- 利用“预训练模型”进行推理和生成的核心,就像一个“思考与规划 Subagent”。

-

整合与协作 (Integration & Collaboration):

- Subagent 模式:“总管” Agent 需要整合所有 Subagent 的工作成果,最终形成完整的解决方案。

- 论文范式:这个框架本身就是一个整合体,它将规划、记忆、环境互动和预训练模型的知识无缝地结合在一起,形成一个能够自主学习和适应的闭环系统。

总结一下:

您可以将论文中描述的这个范式看作是构建一个高级、自主的“单体 Agent”的设计图。而这个“单体 Agent”内部的各个功能模块(规划、记忆、感知、执行),其工作方式和协同模式,与外部的 "Subagent" 协同工作的模式在逻辑上是高度一致的。

所以,您的感觉是正确的。这篇论文正在从更基础的层面,为如何构建一个功能强大、能够像 subagent 系统一样协同工作的智能体,提供一个理论框架和核心组件的定义。它更关注于如何让一个 Agent 内在地拥有这些分解、规划、记忆和学习的能力。

3.1 大语言模型 (LLM) 与视觉语言模型 (VLM)

我们可以使用大语言模型(LLM)或视觉语言模型(VLM)来“引导”(bootstrap)图 5 中所示的智能体的各个组件。特别是,LLM 已被证明在任务规划方面表现出色(Gong et al., 2023a),包含大量的世界知识(Yu et al., 2023b),并展现出令人印象深刻的逻辑推理能力(Creswell et al., 2022)。此外,像 CLIP(Radford et al., 2021)这样的 VLM 提供了一个与语言对齐的通用视觉编码器,并具备零样本(zero-shot)视觉识别能力。例如,像 LLaVA(Liu et al., 2023c)和 InstructBLIP(Dai et al., 2023)这样最先进的开源多模态模型,都依赖于冻结的 CLIP 模型作为其视觉编码器。

导读与解释

这一节详细解释了如何实现上一章提出的四大目标中的第一个——“站在巨人的肩膀上”。作者明确指出,LLM 和 VLM 是构建新一代 AI 智能体的基石。

1. LLM:智能体的“大脑”

论文首先强调了 LLM(大语言模型,如 GPT-4)的核心作用。它被用作智能体的“中央处理器”或“大脑”,主要因为它天生具备三种关键能力:

- 任务规划 (Task-planning):你给它一个复杂的目标,比如“帮我组织一次团队建设活动”,它能像一个项目经理一样,把任务分解成一系列逻辑清晰的子步骤(确定预算、统计人数、选择地点、预订交通等)。这是实现智能体“深谋远虑”能力的基础。

- 世界知识 (World knowledge):LLM 在训练过程中已经“阅读”了半个互联网,拥有海量的常识和事实性知识。这使得智能体在面对新问题时,不必从零开始学习,而是可以直接调用这些背景知识。

- 逻辑推理 (Logical reasoning):LLM 具备一定的推理能力,可以根据已知信息进行演绎、归纳和决策。这对于智能体在复杂环境中做出合理判断至关重要。

2. VLM:智能体的“眼睛”

如果说 LLM 是大脑,那么 VLM(视觉语言模型)就是连接大脑和物理世界的“眼睛”。它解决了让 AI “看懂”世界的问题。

- 核心模型 CLIP:论文提到了一个里程碑式的模型——CLIP。你可以把它理解成一个“翻译器”,它能把图像和文本翻译到同一个“语言空间”里。这样一来,模型就可以计算一张图片和一句话之间的“相似度”。

- 例子:给模型一张“狗的照片”,再给它三句话:“一只猫”、“一辆车”、“一条狗”。模型通过 CLIP 就能知道,“狗的照片”和“一条狗”这句话在语义上是最接近的。

- 语言对齐 (Language-aligned):这就是上面说的,让视觉信息和语言信息能够相互理解、相互“对齐”。

- 零样本识别 (Zero-shot visual recognition):这是 VLM 最强大的能力之一。意味着模型可以识别出它在训练时从未被明确告知过的物体。

- 例子:即使你从未用“斑马”这个标签训练过模型,但只要模型在训练时学过“马”、“条纹”这些词,当你给它一张斑马的图片并问“这是一匹带条纹的马吗?”,它有很大概率能正确识别。因为它理解了语言描述和视觉特征的关联。

- 构建更强模型的基础:像 LLaVA 和 InstructBLIP 这样的新模型,都是把 CLIP 作为一个“冻结”的(即不需再训练的)视觉模块,然后在它的基础上搭建更复杂的语言交互能力。这再次印证了“站在巨人肩膀上”的思路。

总结

这一节的核心思想是:我们不需要为智能体从头开发感知和思考能力。我们可以直接将强大的 LLM 作为“大脑”,负责思考、规划和推理;将强大的 VLM 作为“眼睛”,负责理解视觉世界。通过组合这两个预训练好的模块,我们就能快速“引导”(bootstrap)出一个具备基本认知能力的智能体雏形,然后在此基础上构建更高级的记忆和学习能力。

3.2 智能体转换器(Agent Transformer)的定义

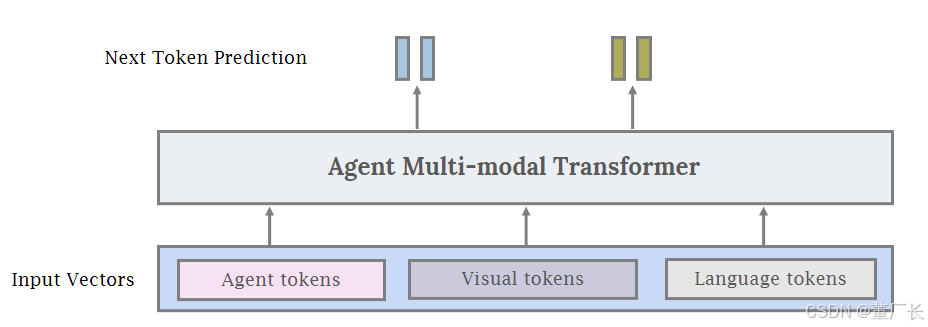

除了使用冻结的 LLM 和 VLM 来构建 AI 智能体之外,另一种可能的方法是使用一个单一的智能体转换器模型,该模型接收视觉令牌(visual tokens)和语言令牌(language tokens)作为输入,类似于 Gato 模型(Reed et al., 2022)。除了视觉和语言,我们还增加了第三种通用的输入类型,我们称之为智能体令牌(agent tokens)。从概念上讲,智能体令牌用于为模型的“智能体行为”(agentic behaviors)在输入和输出空间中保留一个特定的子空间。对于机器人或游戏操作,这可以表现为控制器的输入动作空间。当训练智能体使用特定工具时,例如图像生成或图像编辑模型,或者用于其他 API 调用时,也可以使用智能体令牌。

如图 7 所示,我们可以将智能体令牌与视觉和语言令牌结合起来,为训练多模态 AI 智能体生成一个统一的接口。与使用大型、专有的 LLM 作为智能体相比,使用智能体转换器有几个优势。首先,该模型可以轻松地为那些可能难以用自然语言表示的非常具体的智能体任务进行定制(例如,控制器输入或其他特定动作)。因此,智能体可以从环境交互和领域特定数据中学习以提高性能。其次,通过访问智能体令牌的概率,可以更容易地理解模型为什么会或不会采取特定行动。第三,某些领域如医疗保健和法律有严格的数据隐私要求。最后,一个相对较小的智能体转换器可能比一个大型的专有语言模型便宜得多。

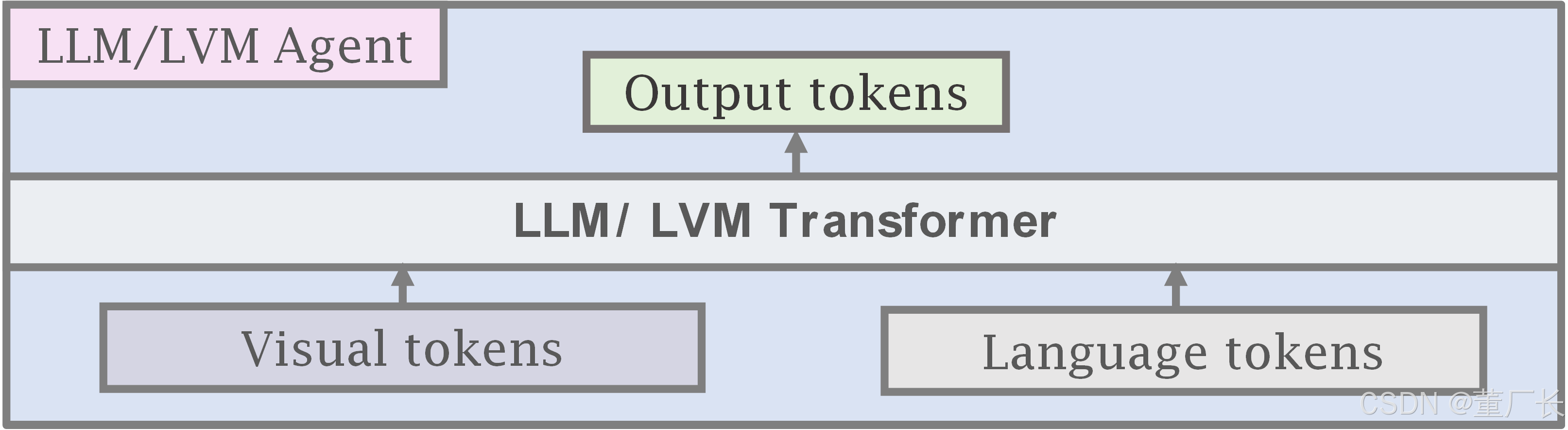

图 6:我们展示了当前通过将大语言模型(LLM)与大视觉模型(LVM)结合来创建多模态 AI 智能体的范式。通常,这些模型接收视觉或语言输入,并使用预训练且冻结的视觉和语言模型,学习连接和桥接不同模态的较小子网络。例子包括 Flamingo、BLIP-2、InstructBLIP 和 LLaVA。

图 7:统一的智能体多模态转换器模型。我们提出了一种用于智能体系统的统一的、端到端的训练范式,而不是连接冻结的子模块并将现有基础模型用作构建块。我们仍然可以像图 6 那样用 LLM 和 LVM 初始化子模块,但同时利用智能体令牌——一种专门用于训练模型在特定领域(例如,机器人技术)执行智能体行为的特殊令牌。有关智能体令牌的更多详细信息,请参见 3.2 节。

导读与解释

这一节提出了一个非常重要的概念转变。如果说 3.1 节的方法是“组装电脑”(把现成的 CPU(LLM)、显卡(VLM) 组装起来用),那么 3.2 节提出的方法就是“设计和制造一块全新的整合主板”(打造一个统一的、端到端可训练的模型)。

1. 从“冻结”到“统一”

- 上一节的思路 (图 6):使用现成的、强大的、但冻结的(frozen,即训练过程中其参数固定不变)LLM 和 VLM。我们只训练它们之间的“连接器”部分,让它们能协同工作。这很高效,但灵活性有限,因为核心部件无法改变。

- 本节的新思路 (图 7):构建一个单一的、统一的转换器(Transformer)模型。这个模型从一开始就被设计为能够同时处理多种信息。虽然它的部分组件可以用 LLM 和 VLM 的权重来初始化(相当于有个好的起点),但关键在于整个模型是端到端可训练的,所有部分都可以根据新任务进行微调和优化,实现了更深层次的融合。

2. 核心创新:智能体令牌 (Agent Tokens)

这是本节最核心的创新点。除了能理解语言(语言令牌)和图像(视觉令牌),作者为模型引入了第三种“感官”——行动能力,并用“智能体令牌”来表示。

- 它是什么:一种特殊的、非自然语言的令牌,专门用来表示动作或API 调用。

- 它的作用:

- 表示非语言动作:对于机器人来说,一个动作可能是

move_forward(10cm)或rotate_arm(30deg)。用自然语言“向前移动10厘米”来描述既啰嗦又不精确。使用一个专门的agent_token来代表这个动作,对模型来说更直接、更高效。 - 表示工具使用:当智能体需要调用一个外部工具(比如一个天气查询 API 或一个代码解释器)时,它可以直接生成一个代表该 API 调用的

agent_token,例如call_weather_api("北京")。

- 表示非语言动作:对于机器人来说,一个动作可能是

- 为什么重要:它为模型开辟了一个专门的“动作空间”。模型在做决策时,输出的就不再仅仅是描述性的自然语言,而可以直接是可执行的动作令牌。

3. “智能体转换器”的四大优势

论文明确指出了这种新范式相比直接使用大型闭源 LLM(如 GPT-4 API)的优势:

- 更强的定制性:对于机器人控制这类难以用语言精确描述的任务,Agent Transformer 可以通过直接学习“环境反馈 -> 动作令牌”的映射来优化自身,学习效果更好。

- 更好的可解释性:当模型做出决策时,我们可以直接查看它生成的不同“动作令牌”的概率。比如,如果

turn_left令牌的概率是 95%,而turn_right是 5%,我们就很清楚模型为什么选择左转。这比分析一大段自然语言的理由要直观得多。 - 保障数据隐私:在医疗、法律等高度敏感的领域,将数据发送给第三方专有模型(如 OpenAI)是不可接受的。使用这种方法,机构可以在自己的服务器上,用自己的私有数据训练一个相对较小的、完全属于自己的 Agent Transformer,数据无需离开本地,安全性大大提高。

- 成本更低:训练和运行一个针对特定任务、规模相对较小的 Agent Transformer,其成本远低于调用通用但极其庞大的专有大模型。

总而言之,Agent Transformer 范式通过引入智能体令牌和端到端训练,旨在打造一个更灵活、更可控、更安全、更经济的 AI 智能体,特别适合于需要与物理世界或特定软件工具深度交互的专业领域。

Q:智能体令牌 (Agent Tokens) 我不太理解,现在市面上有具体一些的应用吗

您提的这个问题非常核心,也是理解这类新一代 AI 智能体(Agent)模型的关键。

简单来说,您可以将 智能体令牌 (Agent Tokens) 理解为一种特殊的、非自然语言的“指令”或“函数调用”,AI 模型可以直接生成这种指令来执行一个动作,而不是用自然语言去描述这个动作。

我们用一个生活化的例子来对比一下:

-

没有 Agent Tokens 的模型 (传统 LLM):

- 你对它说:“帮我查一下上海今天的天气。”

- 它可能会输出一段文本:“好的,您应该使用天气查询工具,输入‘上海’作为城市来获取今天的天气信息。”

- 它只告诉你该怎么做,但它自己不动手。 你需要另外的程序去解析这段话,然后才能真正执行查询。

-

有 Agent Tokens 的模型 (Agent Transformer):

- 你对它说:“帮我查一下上海今天的天气。”

- 它内部可能会生成这样的输出:

[TEXT_START] 好的,正在为您查询... [TEXT_END] [AGENT_TOKEN_START] call_weather_api(city="上海") [AGENT_TOKEN_END] - 它不仅用自然语言回应你,还直接生成了一个可被系统直接执行的“动作指令”(即 Agent Token)。 系统看到这个

call_weather_api(...)的令牌,就会立刻去调用对应的天气查询函数,然后把结果返回给模型。

现在市面上有具体的应用吗?

是的,虽然“Agent Transformer”这个词本身比较学术,但其核心思想——让大模型学会使用工具(Tool Use)或调用函数(Function Calling)——已经成为了当前所有主流大模型平台的核心能力,并且有大量的实际应用。

OpenAI 的 Function Calling / Tool Use:

- 这是最典型的例子。开发者在调用 GPT-4 等模型时,可以定义一系列可用的“工具”(比如您代码中的 GetSimOrderListAsync、CreatePatientInfoFromPmsAsync 等函数)。

- 当用户提出请求时,GPT-4 如果判断需要使用这些工具,它不会自己编造结果,而是会生成一个特定格式的 JSON 对象,这个 JSON 就相当于“Agent Token”。

- 例如,它会返回:

{

"tool_calls": [{

"id": "call_abc123",

"type": "function",

"function": {

"name": "GetSimOrderListAsync",

"arguments": "{\"orderIds\":[\"guid1\",\"guid2\"]}"

}

}]

}- 您的应用程序收到这个 JSON 后,就知道应该去执行 GetSimOrderListAsync 函数,并将结果返回给 GPT-4,让它继续完成任务。

-

Google Gemini 的 Function Calling:

- 与 OpenAI 非常类似,Gemini 模型也具备强大的工具使用能力,允许开发者定义函数,模型在需要时会生成调用指令。

-

开源模型中的工具使用(如 Llama, Mistral):

- 通过特定的微调技术(Fine-tuning),开源社区也让 Llama 等模型具备了类似 Function Calling 的能力。它们被训练成在需要时能生成特定格式的文本或 JSON,来代表一个工具调用。

-

更深度的应用:机器人控制 (如 Google RT-2)

- 这更接近论文中提到的原始概念。Google 的 RT-2 (Robotic Transformer 2) 模型就是一个典型的例子。

- 它将机器人的动作(如

移动手臂到坐标(x,y,z)、抓取、放下)也编码成了特殊的“令牌”。 - 模型接收语言指令(“把桌上的苹果递给我”)和摄像头图像,然后直接输出一系列动作令牌,这些令牌被机器人控制器直接翻译成电机的运动。这比生成自然语言描述再转成动作要直接和高效得多。

您完全可以把当前主流大模型的 Function Calling / Tool Use 功能,看作是“智能体令牌”这个学术概念在实际产品中的成功落地和应用。它赋予了模型“动手”的能力,是实现真正智能体(Agent)的关键一步。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)