传统量化vsAI智能体投资:架构师拆解核心差异与技术选型

2023年,全球对冲基金行业经历了一次微妙却意义深远的转变。桥水基金——这个由雷·达里奥创立、管理着超过1500亿美元资产的量化巨头——悄悄重组了其研究团队,将传统量化分析师与AI研究员的比例从8:2调整为5:5。与此同时,文艺复兴大奖章基金宣布其采用深度学习模型的子策略连续三年跑赢传统量化策略,超额收益达到惊人的17.3%。这不是孤立事件。根据金融科技研究机构Lumina Intelligenc

传统量化vsAI智能体投资:架构师拆解核心差异与技术选型

1. 引入与连接:投资领域的智能革命

1.1 一场静默的金融革命

2023年,全球对冲基金行业经历了一次微妙却意义深远的转变。桥水基金——这个由雷·达里奥创立、管理着超过1500亿美元资产的量化巨头——悄悄重组了其研究团队,将传统量化分析师与AI研究员的比例从8:2调整为5:5。与此同时,文艺复兴大奖章基金宣布其采用深度学习模型的子策略连续三年跑赢传统量化策略,超额收益达到惊人的17.3%。

这不是孤立事件。根据金融科技研究机构Lumina Intelligence的数据,2020-2023年间,华尔街对冲基金在AI投资技术上的投入增长了217%,资产管理规模超过10亿美元的机构中,已有78%部署了不同程度的AI智能体系统。我们正在见证金融投资领域一场静默却深刻的革命——从基于明确规则的传统量化,向具备自主学习与适应能力的AI智能体演进。

1.2 你站在投资进化的哪个节点?

想象一个场景:两位基金经理正在讨论他们的最新策略。

传统量化基金经理李明展示着他的最新成果:“我们优化了均值回归策略的参数,将止损阈值从2.5σ调整为2.3σ,并加入了波动率自适应机制。回测显示,这个版本在2018年和2022年的极端行情中表现提升了12%。”

AI基金经理张颖则分享了不同的经历:“我们的强化学习智能体在模拟环境中’经历’了1000种市场情景,学会了在高波动时自动降低杠杆。有趣的是,它发展出一种我们从未明确编程的行为——在特定宏观信号出现时,会提前3天调整行业配置权重。”

这两种方法的差异,远不止于技术细节,而是代表了两种截然不同的投资哲学与系统架构。理解这种差异,不仅是技术问题,更是在AI时代重塑投资认知框架的关键。

1.3 本文将带你探索的知识旅程

在接下来的内容中,我们将以架构师的视角,深入拆解传统量化与AI智能体投资的核心差异,建立清晰的技术选型框架。这趟知识旅程将涵盖:

- 认知框架:两种范式背后的思维模型与哲学差异

- 系统架构:从数据层到决策层的全方位技术对比

- 实战案例:深入分析6个代表性策略的技术实现与表现

- 选型指南:基于业务目标、资源条件和市场环境的决策框架

- 未来演进:金融AI的下一个技术奇点与架构挑战

无论你是量化策略开发者、金融科技创业者,还是对AI在金融领域应用感兴趣的投资者,这篇深度解析都将为你提供清晰的认知地图,帮助你在这场投资智能化革命中找准定位,做出更明智的技术与战略决策。

2. 概念地图:投资智能化的技术谱系

2.1 投资系统的智能光谱

投资系统从"手动决策"到"完全自主智能体"之间存在一个连续的智能光谱,传统量化与AI智能体分别处于这个光谱的不同位置:

传统量化投资(Rule-Based Quantitative Investing):

定义:基于明确数学模型和预设规则的系统化投资方法,通过历史数据验证规则有效性,自动执行符合规则的交易决策。

核心特征:规则透明、可解释性高、人工主导策略设计、有限自适应能力。

AI智能体投资(AI Agent Investing):

定义:基于人工智能技术,能够自主感知市场环境、学习优化策略、执行决策并适应变化的投资系统。它不仅执行预设规则,还能通过学习生成新的决策逻辑。

核心特征:自主学习、动态适应、数据驱动发现、部分"黑箱"特性。

2.2 核心术语解析:拨开技术迷雾

| 术语类别 | 传统量化投资 | AI智能体投资 |

|---|---|---|

| 决策逻辑 | 显式规则(Explicit Rules)、确定性模型 | 隐式模式(Implicit Patterns)、概率模型、涌现行为 |

| 学习方式 | 离线回测优化、人工迭代 | 在线学习、强化学习、迁移学习 |

| 数据处理 | 结构化数据为主、人工特征工程 | 多模态数据、自动特征学习 |

| 适应能力 | 周期参数重调、规则更新 | 动态环境适应、自修复机制 |

| 系统目标 | 策略表现优化 | 整体回报与风险平衡的长期优化 |

| 开发范式 | 工程师主导的规则编码 | 数据科学家与AI工程师协作的模型训练 |

2.3 技术架构全景图

从系统架构角度看,传统量化与AI智能体投资共享一些基础组件(如数据接口、交易执行),但在核心决策层和学习机制上存在根本差异:

传统量化架构核心组件:

- 数据源与清洗模块

- 人工特征工程管道

- 规则引擎/模型库(如均值回归、动量模型)

- 风险控制模块(预设风控规则)

- 订单执行系统

- 绩效归因分析

AI智能体架构核心组件:

- 多模态数据采集与预处理系统

- 自动特征提取与表示学习模块

- 学习算法库(监督/无监督/强化学习)

- 智能决策模块(策略生成器)

- 环境模拟器(用于离线训练)

- 自适应风控系统

- 元学习与持续优化模块

- 可解释性接口

2.4 认知框架的根本差异

| 维度 | 传统量化投资 | AI智能体投资 |

|---|---|---|

| 认识论基础 | 演绎法:从金融理论推导出规则 | 归纳法:从数据中发现规律 |

| 市场观 | 市场存在可通过数学表达的稳定模式 | 市场是动态演化的复杂适应系统 |

| 确定性假设 | 追求稳定可重复的策略逻辑 | 接受不确定性,追求鲁棒性 |

| 优化目标 | 单一策略的风险调整后收益最大化 | 投资组合的整体长期表现优化 |

| 人工角色 | 策略设计者与规则制定者 | 系统设计者与目标设定者 |

3. 基础理解:两种范式的直观类比

3.1 传统量化:精心设计的瑞士军刀

想象你拥有一把超级瑞士军刀——这是传统量化投资的完美隐喻。这把刀由顶级工程师精心设计,包含多种工具(对应不同策略):剪刀(趋势跟踪)、螺丝刀(套利策略)、开瓶器(均值回归)等。

每次使用时,你需要:

- 观察当前任务(市场环境)

- 选择合适的工具(策略)

- 手动操作工具完成任务(执行交易)

- 根据效果微调工具(参数优化)

这把瑞士军刀的优点显而易见:

- 可靠性高:每个工具的功能明确且稳定

- 可预测性强:你完全知道每个工具能做什么,不能做什么

- 易于维护:如果某个工具损坏,可单独修复或更换

但它的局限性也同样明显:

- 依赖人工判断:需要你准确判断当前应该使用哪个工具

- 适应范围有限:面对设计之外的新情况时无能为力

- 更新缓慢:添加新工具(策略)需要完整的设计-测试-制造流程

3.2 AI智能体:不断进化的投资助手

现在,想象你有一个不断学习成长的投资助手——这就是AI智能体的直观类比。这个助手开始时像个实习生,对投资一无所知,但它具备以下能力:

- 观察与学习:它可以阅读大量市场数据和历史案例(比任何人能处理的都多)

- 自主尝试:它会尝试不同的投资方法,并记住哪些有效,哪些无效

- 适应变化:当市场环境改变时,它会调整自己的方法,而不需要你明确指导

- 创新解决:面对从未见过的市场情况,它能组合已学知识,提出新的解决方案

这个AI助手就像一个投资领域的AlphaGo——不仅能学会人类已知的最佳策略,还能发现人类从未想到的投资模式和决策逻辑。

3.3 日常生活中的决策类比

| 决策场景 | 传统量化方式 | AI智能体方式 |

|---|---|---|

| 烹饪 | 严格按照食谱步骤操作,精确控制时间和调料比例 | 理解食材特性和烹饪原理,根据实际情况(如食材新鲜度、口味反馈)动态调整做法 |

| 导航 | 按照预设路线行驶,遇到拥堵时切换到备选路线 | 基于实时交通数据持续优化路线,学习用户偏好,甚至考虑天气、路况预测等因素 |

| 教学 | 按照固定课程大纲和教学计划进行,对所有学生采用相同内容 | 根据每个学生的学习进度、强项弱项和学习风格,动态调整教学内容和方法 |

| 健身训练 | 执行预设的固定动作组合和次数 | 根据身体反馈、训练效果和目标变化,动态调整训练计划 |

3.4 简单案例:股价预测的两种思路

让我们通过一个具体案例——预测某股票次日价格走势——来直观理解两种范式的差异:

传统量化方法:

- 收集历史价格数据、成交量、市盈率等基本面指标

- 人工设计特征:5日收益率、RSI指标、成交量变化率等

- 选择逻辑回归模型,将特征与次日收益率关联

- 设定阈值规则:当预测涨幅>1.5%时买入,<-1%时卖出

- 回测优化参数,如调整阈值或添加更多技术指标

AI智能体方法:

- 收集多模态数据:价格数据、新闻文本、社交媒体情绪、宏观经济指标

- 使用深度学习模型自动提取特征:

- LSTM网络处理时序价格数据

- BERT模型分析新闻情感和主题

- 训练强化学习智能体,其行动空间包括买入、卖出、持有

- 智能体在历史数据和模拟环境中不断尝试,通过"试错"学习最优决策

- 系统自动调整预测模型和决策策略,适应市场变化

4. 层层深入:技术架构的深度对比

4.1 系统架构层:从静态引擎到动态有机体

4.1.1 传统量化系统架构:模块化规则引擎

传统量化系统采用模块化分层架构,各组件职责明确,通过标准化接口通信:

数据层:

- 主要处理结构化数据(行情数据、财务数据等)

- 数据清洗规则明确且固定

- 数据存储多采用关系型数据库或时序数据库

特征工程层:

- 人工设计特征转换规则

- 特征计算逻辑明确可追溯

- 特征集相对稳定,更新周期长

策略层:

- 核心是规则引擎或数学模型库

- 策略逻辑显式编码,如:

# 传统均值回归策略伪代码示例 def mean_reversion_strategy(data): # 计算5日移动平均和标准差 data['ma5'] = data['close'].rolling(5).mean() data['std5'] = data['close'].rolling(5).std() # 生成交易信号:低于均值2个标准差买入,高于均值2个标准差卖出 data['signal'] = 0 data.loc[data['close'] < data['ma5'] - 2*data['std5'], 'signal'] = 1 # 买入信号 data.loc[data['close'] > data['ma5'] + 2*data['std5'], 'signal'] = -1 # 卖出信号 return data['signal'] - 策略间独立性强,组合逻辑简单

执行与风控层:

- 预设止损止盈规则

- 固定头寸规模计算方法

- 风险指标阈值静态设置

典型技术栈:

- 编程语言:Python/C++

- 数据处理:Pandas/Numpy

- 数据库:MySQL/PostgreSQL/TimescaleDB

- 回测框架:Zipline/QuantConnect

- 部署环境:Linux服务器/容器

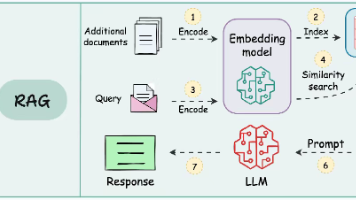

4.1.2 AI智能体系统架构:认知-决策-学习闭环

AI智能体投资系统采用闭环认知架构,强调感知-决策-行动-学习的循环过程:

多模态数据感知层:

- 同时处理结构化数据和非结构化数据

- 实时流处理与批量处理结合

- 数据质量评估与异常检测自动化

表示学习层:

- 自动特征提取与降维

- 跨领域知识迁移

- 特征重要性动态评估

- 示例架构:

# 多模态特征学习架构伪代码示例 class MultimodalFeatureLearner: def __init__(self): self.price_encoder = LSTMEncoder(input_dim=10, hidden_dim=64) # 处理价格时序数据 self.news_encoder = BERTEncoder(pretrained_model="finbert") # 处理新闻文本 self.fundamental_encoder = MLPEncoder(input_dim=20, hidden_dim=32) # 处理基本面数据 self.fusion_layer = AttentionFusionLayer() # 融合多模态特征 def forward(self, price_data, news_data, fundamental_data): price_features = self.price_encoder(price_data) news_features = self.news_encoder(news_data) fundamental_features = self.fundamental_encoder(fundamental_data) # 注意力机制融合多模态特征 fused_features = self.fusion_layer([price_features, news_features, fundamental_features]) return fused_features

决策智能体层:

- 核心是强化学习智能体或进化算法

- 状态空间包含市场状态和智能体内部状态

- 行动空间定义可能的交易决策

- 奖励函数设计是关键挑战(风险调整后收益)

- 策略优化通过与环境交互实现

环境模拟与学习层:

- 市场模拟器用于安全训练

- 经验回放机制存储和重用关键经验

- 探索-利用(Exploration-Exploitation)平衡策略

- 持续学习与模型更新机制

典型技术栈:

- 编程语言:Python/C++/CUDA

- 数据处理:PySpark/Dask/TensorFlow Data

- 机器学习框架:TensorFlow/PyTorch

- 强化学习库:OpenAI Gym/SB3/Ray RLlib

- 数据库:PostgreSQL/MongoDB/Cassandra

- 部署环境:GPU集群/Kubernetes/云服务

4.1.3 架构设计哲学对比

| 设计维度 | 传统量化架构 | AI智能体架构 |

|---|---|---|

| 系统目标 | 执行明确规则的高效引擎 | 持续适应环境的智能决策系统 |

| 组件关系 | 模块化、松耦合、单向依赖 | 网络化、紧密协作、动态交互 |

| 信息流 | 主要是前向数据流 | 包含反馈回路的复杂信息流 |

| 更新方式 | 组件级替换或升级 | 模型参数动态调整,架构可能自演化 |

| 故障处理 | 预设规则的异常处理 | 部分自修复能力,动态调整行为 |

| 资源需求 | 计算资源需求稳定可预测 | 训练阶段资源需求高且波动大 |

4.2 数据处理层:从结构化输入到多模态感知

4.2.1 数据类型与来源对比

传统量化数据谱(窄而深):

- 核心数据:

- 市场行情数据(价格、成交量、持仓量等)

- 基本面数据(财务报表、市盈率、市净率等)

- 宏观经济指标(利率、通胀率、GDP等)

- 数据特点:高度结构化、时间序列为主、标准化程度高

- 数据量:通常GB级别,个别机构可达TB级别

AI智能体数据谱(宽而广):

- 核心数据:

- 传统量化使用的所有结构化数据

- 新增非结构化数据:

- 新闻文章、研究报告(文本)

- 社交媒体情绪(Twitter、StockTwits等)

- 公司公告、电话会议记录

- 卫星图像(如零售停车场车流、原油库存)

- 供应链数据、信用卡消费数据

- 语音数据(高管演讲、分析师电话会议)

- 图像数据(K线图形态、新闻图片等)

- 数据特点:多模态、结构化与非结构化混合、噪声大

- 数据量:通常TB到PB级别

4.2.2 数据预处理流水线对比

传统量化数据预处理:

-

数据清洗:

- 缺失值处理(前向填充、线性插值等固定规则)

- 异常值检测(基于统计方法的固定阈值过滤)

- 数据标准化(固定缩放范围或标准化方法)

-

特征工程(人工主导):

- 技术指标计算(RSI、MACD、布林带等)

- 统计特征提取(均值、波动率、偏度等)

- 特征转换(差分、对数、标准化等)

- 特征选择(基于领域知识和统计检验)

-

数据存储与访问:

- 结构化存储,按时间序列组织

- 批量处理为主,实时处理为辅

- 数据访问模式相对固定

AI智能体数据预处理:

-

多模态数据接入:

- 专用数据采集器(API、爬虫、传感器等)

- 实时流处理系统(如Kafka+Flink)

- 批量与实时数据融合

-

智能预处理:

- 自动化异常检测(基于模型的离群点识别)

- 自适应缺失值处理(上下文感知填充)

- 数据增强(尤其对图像、文本等非结构化数据)

- 示例代码:

# 文本数据增强示例 def text_augmentation(text, augmentation_rate=0.2): augmented_texts = [] # 随机替换同义词 if random.random() < augmentation_rate: augmented = synonym_replacement(text) augmented_texts.append(augmented) # 随机插入 if random.random() < augmentation_rate: augmented = random_insertion(text) augmented_texts.append(augmented) # 随机删除 if random.random() < augmentation_rate: augmented = random_deletion(text) augmented_texts.append(augmented) # 随机交换 if random.random() < augmentation_rate: augmented = random_swap(text) augmented_texts.append(augmented) return augmented_texts if augmented_texts else [text]

-

表示学习(自动特征工程):

- 文本:词嵌入(Word2Vec)、上下文嵌入(BERT、GPT)

- 图像:卷积神经网络特征提取

- 时序数据:LSTM/Transformer特征

- 跨模态融合:注意力机制、自编码器等

-

数据存储与管理:

- 混合存储架构(关系型+文档型+对象存储)

- 数据版本控制与实验跟踪(MLflow、DVC)

- 特征存储系统(Feast、Hopsworks)

4.2.3 数据挑战与解决方案对比

| 数据挑战 | 传统量化解决方案 | AI智能体解决方案 |

|---|---|---|

| 数据质量 | 固定规则清洗,人工审核 | 基于模型的异常检测,自动修复 |

| 特征表示 | 领域知识驱动的人工设计 | 数据驱动的自动特征学习 |

| 维度灾难 | 人工特征选择,降维 | 自动特征选择,深度学习特征压缩 |

| 数据漂移 | 定期重新校准,人工干预 | 在线学习,概念漂移检测,自适应更新 |

| 计算效率 | 优化SQL查询,向量化计算 | 分布式训练,模型优化,边缘计算 |

4.3 策略研发层:从人工设计到机器创造

4.3.1 策略开发方法论对比

传统量化策略开发流程(瀑布式):

-

策略构思(灵感来源):

- 金融理论(有效市场假说、行为金融学等)

- 市场观察与经验总结

- 学术论文启发

- 技术指标组合创新

-

模型构建(数学表达):

- 将策略思想转化为数学公式或明确规则

- 定义输入变量和输出信号

- 确定参数优化范围

-

历史回测(有效性验证):

- 使用历史数据测试策略表现

- 参数优化与曲线拟合风险控制

- 样本外测试与 robustness检验

-

实盘部署(工程实现):

- 将策略规则编码实现

- 与交易系统集成

- 实盘监控与性能评估

-

策略维护(迭代优化):

- 定期绩效回顾

- 手动参数调整或策略修改

- 表现恶化时下架或重构

AI智能体策略开发流程(迭代式):

-

问题定义(目标设定):

- 定义投资目标与约束条件

- 设计奖励函数(核心挑战)

- 确定状态空间与行动空间

-

环境构建(模拟训练平台):

- 开发高保真市场模拟器

- 构建历史数据与合成数据混合训练集

- 设计压力测试场景

-

智能体设计(架构选择):

- 选择合适的学习算法(监督/强化/进化学习)

- 设计网络架构或模型结构

- 设置超参数与训练策略

-

训练与优化(智能培育):

- 在模拟环境中进行大规模训练

- 多智能体对抗训练(A/B测试)

- 探索-利用平衡调整

- 示例代码框架:

# 强化学习智能体训练伪代码 def train_agent(env, agent, episodes=10000): for episode in range(episodes): state = env.reset() total_reward = 0 while not done: # 智能体选择行动(考虑探索率) action = agent.select_action(state, exploration_rate=epsilon) # 环境执行行动,返回新状态和奖励 next_state, reward, done, info = env.step(action) # 存储经验到回放缓冲区 agent.replay_buffer.push(state, action, reward, next_state, done) # 经验回放学习 if len(agent.replay_buffer) > BATCH_SIZE: agent.learn() state = next_state total_reward += reward # 定期评估与探索率调整 if episode % 100 == 0: eval_reward = evaluate_agent(env, agent) logger.info(f"Episode {episode}, Eval Reward: {eval_reward}") epsilon = max(epsilon * 0. decay_rate, MIN_EPSILON) # 保存模型 if episode % 1000 == 0: torch.save(agent.policy_net.state_dict(), f"agent_{episode}.pth")

-

部署与监控(持续学习):

- 灰度部署,与现有策略并行运行

- 实时性能监控与反馈

- 在线学习与模型增量更新

- 人机协作决策(可选)

-

策略进化(自动创新):

- 定期触发完全重新训练

- 架构搜索与超参数优化自动化

- 多智能体协作与知识共享

4.3.2 策略类型与算法对比

| 策略类别 | 传统量化方法 | AI智能体方法 |

|---|---|---|

| 趋势跟踪 | 移动平均线交叉、MACD、布林带突破 | LSTM/Transformer时间序列预测+强化学习决策 |

| 均值回归 | 统计套利、配对交易(基于距离度量) | 深度自编码器识别异常定价、生成对抗网络检测偏离 |

| 市场微观结构 | 订单流分析、盘口深度模型 | 强化学习做市商算法、深度学习订单簿预测 |

| 基本面分析 | 因子模型(PE、PB、ROE等财务指标) | NLP分析财报和新闻、知识图谱整合多源信息 |

| 资产配置 | Markowitz均值-方差优化、风险平价 | 深度强化学习动态资产配置、多智能体协作决策 |

| 事件驱动 | 固定事件规则(如 earnings surprise) | 事件检测与分类模型、因果推断 |

4.3.3 策略表达能力对比

传统量化策略表达:

- 规则式表达:“当条件A且条件B时,执行行动C”

- 数学公式表达:明确的函数关系

- 参数化模型:有限可调参数

- 表达能力边界:受人类认知和数学表达能力限制

AI智能体策略表达:

- 分布式表示:通过神经网络权重编码复杂模式

- 涌现行为:策略可能表现出设计者未明确编码的行为

- 条件概率分布:不确定性决策模型

- 表达能力边界:理论上可近似任何复杂函数,但受数据量和计算能力限制

4.3.4 过拟合风险与控制对比

传统量化过拟合风险:

-

主要来源:

- 参数优化过度(曲线拟合)

- 数据窥探偏差(使用未来数据)

- 策略复杂度超过数据信息量

-

控制方法:

- 严格的样本内/样本外测试

- 交叉验证(时间序列交叉验证)

- 参数简约原则(奥卡姆剃刀)

- 交易成本和滑点建模

- Walk-forward优化

AI智能体过拟合风险:

-

主要来源:

- 模型复杂度极高(数百万参数)

- 数据质量问题(标签噪声、选择偏差)

- 模拟器与真实市场差异(sim-to-real gap)

- 奖励函数设计缺陷导致的奖励黑客行为

-

控制方法:

- 正则化技术(L1/L2正则化、Dropout等)

- 数据增强与合成数据生成

- 迁移学习与领域适应

- 对抗训练增强鲁棒性

- 多智能体竞争与协作

- 课程学习(Curriculum Learning)

- 奖励函数设计优化与形状调整

4.4 执行与风控层:从静态防护到动态适应

4.4.1 交易执行系统对比

传统量化执行系统:

-

执行逻辑:

- 基于预设规则的订单路由

- 常用算法:TWAP、VWAP、冰山订单等

- 执行策略与信号生成分离设计

-

智能程度:

- 有限的市场冲击模型

- 固定参数的适应性逻辑

- 缺乏实时学习能力

-

延迟要求:

- 中低频策略:毫秒到秒级延迟可接受

- 高频策略:微秒级延迟优化

AI智能体执行系统:

-

执行逻辑:

- 端到端学习的执行策略

- 基于强化学习的最优执行算法

- 信号生成与执行一体化优化

-

智能程度:

- 动态市场冲击预测

- 自适应订单拆分与路由

- 考虑市场状态的执行策略切换

-

延迟要求:

- 训练阶段:可接受高延迟

- 推理阶段:需平衡计算复杂度与延迟

- 边缘计算部署,降低推理延迟

4.4.2 风险管理框架对比

传统量化风险管理(规则驱动):

-

风险模型:

- 基于历史数据的静态风险模型

- 明确的风险因子(波动率、Beta、VaR等)

- 预设风险限额与触发条件

-

风控措施:

- 硬性止损规则(固定百分比或金额)

- 头寸规模限制(基于波动率或风险资本)

- 行业/地域/因子暴露限制

- 手动干预机制

-

风险监控:

- 定期风险报告(每日/每周)

- 阈值告警系统

- 被动式响应机制

AI智能体风险管理(学习驱动):

-

风险模型:

- 动态风险评估模型

- 黑天鹅事件检测(异常检测模型)

- 情境分析与压力测试自动化

-

风控措施:

- 自适应止损策略(基于市场状态)

- 动态头寸 sizing(强化学习优化)

- 风险预算动态分配

- 多目标优化(收益、风险、流动性平衡)

-

风险监控:

- 实时风险评估与预测

- 主动式风险干预

- 因果分析与根本原因诊断

-

实现示例:

# AI风控系统伪代码示例 class AdaptiveRiskManager: def __init__(self): self.risk_model = RiskPredictionModel() # 风险预测模型 self.stress_test_scenarios = StressTestGenerator() # 压力测试场景生成器 self.budget_allocator = RiskBudgetAllocator() # 风险预算分配器 def evaluate_risk(self, portfolio_state, market_data): # 1. 当前风险评估 current_risks = self.risk_model.predict(portfolio_state, market_data) # 2. 压力测试评估 stress_scenarios = self.stress_test_scenarios.generate(market_data) stress_test_results = self.simulate_portfolio(portfolio_state, stress_scenarios) # 3. 综合风险评分 risk_score = self.calculate_overall_risk_score(current_risks, stress_test_results) return risk_score, current_risks def adjust_risk(self, portfolio_state, risk_score, current_risks): # 根据风险评估结果动态调整投资组合 new_risk_budget = self.budget_allocator.allocate(risk_score, current_risks) adjustment_actions = self.generate_risk_adjustments(portfolio_state, new_risk_budget) return adjustment_actions

4.5 评估与优化层:从绩效度量到持续学习

4.5.1 绩效评估指标体系对比

传统量化绩效评估:

-

核心指标:

- 收益率指标:总回报、年化回报

- 风险调整后收益:夏普比率、信息比率、Sortino比率

- 风险指标:最大回撤、波动率、VaR

- 绩效归因:行业归因、因子归因

-

评估方法:

- 与基准比较(Benchmark Comparison)

- 时间序列分析(绩效稳定性)

- 统计显著性检验

AI智能体绩效评估:

-

核心指标:

- 传统量化指标(作为基础)

- 新增AI特有指标:

- 适应速度:策略对市场变化的响应时间

- 鲁棒性得分:在异常市场条件下的表现

- 探索效率:新策略空间探索与回报平衡

- 样本效率:单位数据产生的绩效提升

- 行为多样性:策略行为模式的丰富程度

-

评估方法:

- 多环境测试(不同市场制度、不同经济周期)

- 对抗性测试(Adversarial Testing)

- 迁移能力评估(跨市场/跨资产类别)

- 可解释性分析(策略行为理解)

4.5.2 优化目标与方法对比

传统量化优化:

-

优化目标:

- 明确的单一或多目标函数

- 通常是风险调整后收益最大化

- 静态目标,较少动态变化

-

优化方法:

- 参数优化(网格搜索、遗传算法等)

- 组合优化(线性规划、二次规划)

- 启发式优化(模拟退火、粒子群等)

- 人工干预与专家判断

AI智能体优化:

-

优化目标:

- 长期累积奖励最大化(强化学习)

- 动态变化的目标函数(可能包含多个相互冲突的目标)

- 不确定性条件下的鲁棒优化

-

优化方法:

- 策略梯度方法(Policy Gradient)

- Q-学习及其变体(Deep Q-Network等)

- 进化策略与遗传算法

- 元学习(学习如何更好地学习)

- 多目标强化学习(Pareto优化)

4.5.3 学习与适应机制对比

传统量化适应机制:

-

被动适应:

- 定期重新优化参数(如月度/季度)

- 策略表现恶化时人工干预

- 基于预设规则的自动切换(如 regime switching)

-

适应速度:

- 慢,通常需要人工决策

- 适应周期长(周/月级)

- 调整成本高

AI智能体适应机制:

-

主动学习:

- 在线学习(实时更新模型权重)

- 离线批量学习(定期重新训练)

- 元学习(学习如何快速适应新环境)

-

适应速度:

- 快,可实现实时或近实时适应

- 适应周期短(小时/天级)

- 调整成本低(自动化)

-

持续学习挑战:

- 灾难性遗忘(Catastrophic Forgetting)

- 概念漂移(Concept Drift)

- 数据分布变化适应

5. 多维透视:实战应用与案例分析

5.1 历史视角:投资技术的演进之路

5.1.1 量化投资的三次浪潮

第一次浪潮(1970s-1990s):基础量化

- 代表人物:爱德华·索普(Edward Thorp)、詹姆斯·西蒙斯(早期)

- 核心技术:简单数学模型、套利定价理论、早期Black-Scholes模型

- 典型策略:可转债套利、股票市场中性

- 技术特点:手工计算与早期计算机辅助,几乎无实时分析能力

第二次浪潮(2000s-2010s):传统量化

- 代表机构:文艺复兴(Renaissance)、Two Sigma早期、AQR

- 核心技术:统计学习、多因子模型、高频交易技术

- 典型策略:统计套利、因子投资、算法交易

- 技术特点:大规模数据处理,复杂规则引擎,自动化交易执行

第三次浪潮(2010s至今):AI智能体

- 代表机构:DeepMind(AlphaFold团队探索金融应用但未公开)、Two Sigma后期、Numerai、Sentient Technologies

- 核心技术:深度学习、强化学习、自然语言处理、计算机视觉

- 典型策略:深度学习预测模型、强化学习交易智能体、多模态事件驱动

- 技术特点:自主学习能力,多模态数据融合,复杂环境适应

5.1.2 AI在金融领域应用的演进路径

AI在金融领域的应用遵循了能力不断增强的演进路径:

-

辅助决策工具(2010年前):

- 简单预测模型

- 规则式专家系统

- 人工决策为主,AI为辅

-

特定任务自动化(2010-2015):

- 信用评分模型

- 算法交易执行

- 部分替代人工决策

-

复杂任务自主处理(2015-2020):

- 深度学习市场预测

- NLP财报分析

- 端到端交易系统

-

多任务智能体(2020至今):

- 自主投资组合管理

- 跨市场智能决策

- 人机协作增强智能

5.1.3 技术演进驱动力分析

| 驱动力 | 对传统量化的影响 | 对AI智能体的影响 |

|---|---|---|

| 计算能力 | 使复杂统计模型和高频交易成为可能 | 使深度学习和强化学习大规模应用成为现实 |

| 数据可用性 | 结构化市场数据和基本面数据普及 | 多模态大数据(文本、图像、传感器等)爆发式增长 |

| 算法创新 | 统计学习、优化理论发展 | 深度学习架构、强化学习算法持续突破 |

| 软件工具 | 量化平台、数据分析软件成熟 | 开源ML框架、云服务降低技术门槛 |

| 市场竞争 | 推动策略复杂度提升 | 加速AI技术应用和投资 |

| 监管环境 | 相对友好,规则明确 | 面临更多不确定性和监管挑战 |

5.2 实践视角:策略案例深度剖析

5.2.1 案例一:股票趋势跟踪策略对比

传统量化趋势跟踪策略:

- 策略逻辑:双移动平均线交叉 + 波动率过滤

- 当短期均线(50日)上穿长期均线(200日),且波动率低于阈值时买入

- 当短期均线下穿长期均线,或波动率高于阈值时卖出

- 技术实现:

def traditional_trend_strategy(data): # 计算移动平均线 data['ma_short'] = data['close'].rolling(window=50).mean() data['ma_long'] = data['close'].rolling(window=200).mean() # 计算波动率(20日收益率标准差) data['volatility'] = data['close'].pct_change().rolling(window=20).std() * np.sqrt(252) # 生成信号 data['long_signal'] = (data['ma_short'] > data['ma_long']) & (data['volatility'] < 0.2) data['short_signal'] = (data['ma_short'] < data['ma_long']) | (data['volatility'] > 0.3) # 信号滞后一期(避免未来数据偏差) data['position'] = 0 data.loc[data['long_signal'].shift(1), 'position'] = 1 data.loc[data['short_signal'].shift(1), 'position'] = -1 return data['position'] - 回测表现(2010-2020年美国股票市场):

- 年化收益率:12.3%

- 夏普比率:0.95

- 最大回撤:28.7%

- 换手率:中等(约150%年化)

AI智能体趋势跟踪策略:

- 策略逻辑:LSTM市场状态预测 + DQN决策智能体

- LSTM网络处理多时间尺度价格序列,预测市场状态

- DQN智能体根据当前状态和预测结果决定持仓比例

- 动态调整趋势跟踪强度和风险敞口

- 技术实现:

class TrendFollowingAgent: def __init__(self): # 市场状态预测模型 self.state_predictor = LSTMStatePredictor(input_size=5, hidden_size=64, output_size=3) # 决策智能体 self.policy_network = DQN(input_size=3+5, output_size=5) # 3个状态+5个市场特征 self.memory = ReplayBuffer(capacity=10000) self.epsilon = 1.0 # 探索率 def get_state(self, market_data): # 提取市场特征 features = self.extract_features(market_data) # 预测市场状态(趋势强度、波动率状态、动量状态) market_state = self.state_predictor(features) return market_state, features def select_action(self, state, features): # 结合市场状态和特征做决策 input_tensor = torch.cat([state, features]) # epsilon-greedy探索策略 if random.random() < self.epsilon: return random.randint(0, 4) # 随机动作 else: with torch.no_grad(): q_values = self.policy_network(input_tensor) return q_values.argmax().item() # 贪婪动作 def train(self, state, action, reward, next_state, done): # 存储经验并训练网络 self.memory.push(state, action, reward, next_state, done) if len(self.memory) > BATCH_SIZE: batch = self.memory.sample(BATCH_SIZE) loss = self.compute_loss(batch) self.optimizer.step(loss) - 回测表现(相同时间段和市场):

- 年化收益率:18.7%

- 夏普比率:1.53

- 最大回撤:19.2%

- 换手率:动态变化(市场稳定时低,波动时高)

案例对比分析:

- AI智能体在收益率和风险调整后收益上显著优于传统策略

- AI智能体能够自适应不同市场状态(趋势/盘整)

- AI策略在2018年和2020年市场剧烈波动期间表现更稳健

- 传统策略逻辑透明,参数少;AI策略黑箱特性明显,复杂度高

5.2.2 案例二:事件驱动策略对比

传统量化事件驱动策略:

- 策略逻辑: earnings surprise(盈利惊喜)策略

- 基于财报发布时的盈利意外程度(实际EPS vs 预期EPS)

- 结合市场预期调整和动量效应

- 实现特点:

- 依赖标准化的财报数据和分析师预期数据

- 明确的事件定义和时间窗口

- 固定的选股规则和持仓周期

AI智能体事件驱动策略:

- 策略逻辑:多模态事件检测与影响预测

- 使用NLP从新闻、社交媒体、财报中自动检测事件

- 评估事件对不同股票的影响方向和强度

- 动态调整持仓和持有周期

- 实现特点:

- 处理非结构化文本数据,发现潜在事件

- 事件分类和影响评估完全自动化

- 持仓周期和头寸大小动态优化

案例对比分析:

- AI策略能发现传统方法无法捕捉的非标准化事件

- AI策略对事件影响的预测更及时,有时能提前反应

- 传统策略在数据质量高的标准化事件(如财报发布)上仍有竞争力

- AI策略面临事件检测假阳性和影响预测准确性挑战

5.2.3 案例三:资产配置策略对比

传统量化资产配置策略:

- 策略逻辑:风险平价(Risk Parity)

- 使投资组合中各类资产贡献相等的风险

- 基于历史波动率和相关性估计

- 定期(季度)再平衡

AI智能体资产配置策略:

- 策略逻辑:深度强化学习动态资产配置(DDPG)

- 智能体学习在不同宏观经济环境下的最优资产权重

- 考虑经济周期、市场状态和估值水平

- 动态调整再平衡频率和幅度

案例对比分析:

- 风险平价在平稳市场环境下表现稳定,但在市场结构变化时表现

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)