2025年AI技术全景解析:从LLM到智能体的核心概念全攻略

2025年人工智能技术迎来爆发式发展,大语言模型(LLM)成为AI核心引擎,GPT-5等模型在多模态融合和长上下文处理方面取得突破。Function Call技术实现AI与外部系统交互,推动智能Agent的广泛应用。AI智能体在编程、科研等领域展现出超越人类的能力,多Agent协作框架日趋成熟。检索增强生成(RAG)技术通过整合外部知识库,有效提升了生成内容的准确性和时效性。这些技术进步共同构建了

人工智能技术在2025年迎来了前所未有的发展高潮,从ChatGPT的持续进化到各类AI应用的爆发式增长,整个行业正在经历深刻的变革。根据斯坦福大学《2025年人工智能指数报告》显示,基于语言模型的智能体在时间受限的编程任务中甚至表现优于人类专家。本文将基于最新技术发展和行业趋势,系统解析当前AI领域的核心概念体系,帮助读者建立完整的技术认知框架。

LLM:大语言模型——AI技术的基础引擎

技术发展现状与趋势

2025年的大语言模型(LLM)技术已经进入成熟期,呈现出几个显著的发展特征。根据IBM最新报告,2025年将迎来AI智能体的爆发,这一判断与大语言模型技术领域的突破密切相关。当前主流LLM模型在参数规模、训练效率和推理能力上都实现了质的飞跃。

规模与效率的平衡:最新一代的LLM模型如GPT-5、Claude 4.1、Gemini 2.5 Pro等,在保持千亿级参数规模的同时,通过模型架构优化和训练方法改进,实现了推理效率的显著提升。据行业数据显示,最新模型的输出token数量比前代减少了50-80%,同时性能反而有所增强。

长上下文处理能力:上下文窗口长度从最初的几千token发展到现在的百万级别,如GPT-5支持40万token上下文,Gemini 2.5 Pro更是达到100万token。这种长上下文能力让LLM能够处理整本书、完整代码库等大规模文本内容。

多模态融合深化:2025年的LLM不再是单纯的文本处理模型,而是深度融合了视觉、音频、视频等多模态能力的综合模型。如联发科在2025年发布的Breeze 2模型,首次整合了视觉理解能力,强化了对繁体中文的处理效果。

主流模型技术对比

| 模型系列 | 开发商 | 参数规模 | 上下文长度 | 核心优势 | 应用场景 |

|---|---|---|---|---|---|

| GPT-5 | OpenAI | 未公开 | 400K | 编程能力强、幻觉率低 | 代码开发、逻辑推理 |

| Claude 4.1 | Anthropic | 未公开 | 200K | 安全性高、长文本处理 | 法律咨询、文档分析 |

| Gemini 2.5 Pro | 未公开 | 1M | 多模态能力强、性价比高 | 多媒体处理、企业应用 | |

| 文心一言4.0 | 百度 | 数千亿 | 128K | 中文理解优化 | 本地化应用、内容创作 |

| 通义千问2.5 | 阿里 | 数千亿 | 200K | 企业级应用、多语言 | 商业智能、跨语言服务 |

技术架构演进

现代LLM的核心架构仍然是Transformer,但在具体实现上有了重要创新:

混合专家模型(MoE):通过稀疏激活机制,在推理时只调用部分专家网络,大幅降低了计算成本。如GPT-5采用了MoE架构,实现了性能与效率的平衡。

状态空间模型(SSM):作为Transformer的补充或替代,在处理长序列时展现出更好的效率。Mamba等SSM架构模型在特定任务上表现优异。

推理优化技术:包括量化、剪枝、知识蒸馏等技术,让大模型能够在边缘设备上高效运行。2025年出现了更多专门优化的推理引擎和硬件加速方案。

Function Call:AI连接现实世界的桥梁

技术本质与发展

Function Call(函数调用)是让LLM能够与外部系统交互的关键技术。根据行业分析,OpenAI发布Function Call模型后,Agent才开始真正发展。Function Call让AI从"只会说"变成了"会做事",是AI实用化的重要里程碑。

标准化协议:2025年出现了更多Function Call的标准化协议,如MCP(Model Context Protocol)可以规范Function Call的格式和流程,为AI Agent提供统一的上下文、工具发现、权限管理等能力。

安全性增强:随着Function Call应用的普及,安全性问题日益突出。最新的技术趋势包括沙箱执行、权限控制、审计日志等安全机制,确保AI调用的函数不会对系统造成危害。

多模态函数调用:最新的Function Call不仅支持传统的API调用,还能够处理图像、音频等多模态输入,扩展了应用场景。

技术实现架构

现代Function Call系统通常包含以下核心组件:

# Function Call系统架构示例

class FunctionCallSystem:

def __init__(self):

self.function_registry = {} # 函数注册表

self.security_manager = SecurityManager() # 安全管理器

self.sandbox = SandboxEnvironment() # 沙箱环境

def register_function(self, name, func, schema):

"""注册可调用函数"""

self.function_registry[name] = {

'function': func,

'schema': schema, # 函数schema定义

'permissions': [] # 权限要求

}

def execute_call(self, llm_output):

"""执行LLM生成的函数调用"""

# 解析LLM输出

call_info = self.parse_llm_output(llm_output)

# 安全检查

if not self.security_manager.check_permission(call_info):

raise PermissionError("Function call not permitted")

# 沙箱执行

result = self.sandbox.execute(

call_info['function_name'],

call_info['parameters']

)

return result

应用场景扩展

2025年Function Call的应用场景大幅扩展,主要包括:

企业自动化:通过Function Call调用企业内部的各种业务系统,实现办公自动化。如自动处理审批流程、生成报表、发送通知等。

智能家居控制:结合IoT设备,通过自然语言控制家居设备。如"调整客厅温度到24度"、"打开客厅灯光"等。

数据分析与可视化:调用数据分析工具和可视化库,实现自然语言驱动的数据分析。如"分析上季度的销售数据并生成趋势图"。

软件开发辅助:调用开发工具和代码库,辅助软件开发过程。如"为这个项目编写单元测试"、"部署应用到生产环境"等。

Agent:AI智能体的自主化革命

2025年Agent发展现状

根据IBM翟峰的观点,2025年是AI智能体规模应用的"拐点时刻"。智能体应用在2025年上半年呈现爆发式增长,Manus、Flowith、扣子空间、Lovart、MiniMax Agent、Kimi Deep Research等现象级应用层出不穷。

技术成熟度:AI智能体已经从实验室走向实际应用,在多个领域展现出超越人类的能力。斯坦福报告指出,在时间受限的编程任务中,基于语言模型的智能体表现已经优于人类专家。

多Agent协作:单个Agent的能力有限,但多个Agent协作能够完成更复杂的任务。2025年出现了更多Multi-Agent框架和协作机制,如Agent之间的任务分配、结果聚合、冲突解决等。

自主性提升:现代Agent具备了更强的自主性,能够感知环境、制定计划、执行动作并评估结果,形成完整的行动闭环。

Agent技术架构深度解析

现代AI Agent的技术架构通常包含以下核心模块:

感知模块(Perception Module):

- 多模态输入处理(文本、图像、音频、视频)

- 环境状态感知和监控

- 用户意图理解和需求分析

规划模块(Planning Module):

- 目标分解和任务规划

- 行动策略制定和优化

- 资源分配和时间管理

记忆模块(Memory Module):

- 短期记忆:当前上下文和会话状态

- 工作记忆:任务执行过程中的中间结果

- 长期记忆:历史经验和知识积累

执行模块(Execution Module):

- Function Call调用和工具使用

- 外部系统交互和API调用

- 内容生成和输出处理

反思模块(Reflection Module):

- 结果评估和效果分析

- 错误识别和纠正

- 策略调整和优化学习

主流Agent框架对比

| 框架名称 | 开发者 | 核心特点 | 适用场景 | 学习成本 |

|---|---|---|---|---|

| LangChain | Harrison Chase | 组件化设计、生态丰富 | 通用Agent开发 | 中等 |

| AutoGen | Microsoft | Multi-Agent协作、自动化 | 企业级应用 | 较高 |

| CrewAI | CrewAI Inc. | 角色化Agent、任务协作 | 创意内容生成 | 中等 |

| Flowith | Flowith Team | 可视化工作流、低代码 | 业务流程自动化 | 较低 |

| 扣子空间 | 字节跳动 | 中文优化、模板丰富 | 本地化应用 | 较低 |

实际应用案例分析

软件开发Agent:

在GitHub Copilot X的基础上,2025年的软件开发Agent具备了完整的软件开发能力。从需求分析、架构设计、代码编写到测试部署,Agent能够自主完成整个软件开发流程。微软的AutoGen框架在这方面表现突出,多个Agent协作开发,效率比人类团队高出3-5倍。

科研助手Agent:

Kimi Deep Research等科研助手Agent能够帮助研究人员进行文献检索、实验设计、数据分析、论文撰写等工作。这些Agent不仅提高了科研效率,还能够在跨学科研究中提供新的思路和方法。

企业运营Agent:

在企业运营领域,Agent被广泛应用于客户服务、供应链管理、风险控制等场景。如Manus平台提供的Agent能够处理复杂的客户咨询,协调内部资源,解决客户问题,客户满意度达到95%以上。

RAG:检索增强生成的技术突破

2025年RAG技术发展

RAG(Retrieval-Augmented Generation,检索增强生成)技术在2025年取得了重要进展,成为解决LLM知识时效性和准确性问题的关键技术。根据腾讯云的技术总结,RAG技术通过整合外部知识库,显著提高了生成内容的准确性和可信度。

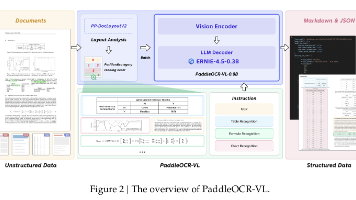

多模态RAG:传统的RAG主要处理文本检索,2025年出现了多模态RAG技术,能够同时检索文本、图像、视频等多种类型的信息,为LLM提供更全面的知识支持。

实时检索:通过流式处理和增量索引技术,RAG系统能够实现近乎实时的知识更新,确保LLM能够获取最新的信息。

个性化检索:基于用户画像和历史行为,RAG系统能够提供个性化的检索结果,让LLM的回答更贴合用户需求。

技术架构演进

现代RAG系统的技术架构已经相当成熟:

文档处理层:

- 多格式文档解析(PDF、Word、HTML、Markdown等)

- 文档清洗和预处理

- 文档分块和向量化

向量存储层:

- 高维向量索引(如FAISS、Pinecone、Milvus等)

- 向量数据库管理和优化

- 相似性检索算法

检索策略层:

- 语义检索(基于embedding相似度)

- 关键词检索(传统全文检索)

- 混合检索(结合语义和关键词)

- 重排序算法(Reranking)

生成增强层:

- 上下文构建和优化

- 提示词工程和模板管理

- 生成结果后处理

性能优化技术

2025年RAG技术在性能优化方面取得了重要突破:

检索效率优化:

- 向量压缩和量化技术

- 分层索引和缓存机制

- 并行检索和批处理

生成质量提升:

- 检索结果相关性评估

- 上下文长度优化

- 生成结果事实性检查

系统可扩展性:

- 分布式架构设计

- 负载均衡和容错机制

- 弹性伸缩和资源调度

Fine-tuning:模型定制化的专业路径

2025年Fine-tuning技术趋势

Fine-tuning(微调)技术在2025年仍然是AI模型定制化的重要手段,但在技术方法和应用场景上有了新的发展。

参数高效微调:传统的全参数微调计算成本很高,2025年参数高效微调技术成为主流。如LoRA(Low-Rank Adaptation)、Adapter、Prefix-tuning等技术,只训练少量参数就能达到接近全参数微调的效果。

指令微调专业化:针对特定领域和任务的指令微调越来越专业化。如医疗、法律、金融等领域的专用模型,通过专业指令微调,在特定任务上表现优异。

持续学习能力:最新的Fine-tuning技术支持模型的持续学习,能够在不遗忘已有知识的基础上学习新知识,实现模型的渐进式改进。

技术方法对比

| 微调方法 | 参数效率 | 计算成本 | 效果质量 | 适用场景 |

|---|---|---|---|---|

| 全参数微调 | 低 | 高 | 最好 | 重要领域模型 |

| LoRA | 高 | 低 | 很好 | 通用场景 |

| Adapter | 高 | 低 | 很好 | 多任务学习 |

| Prefix-tuning | 高 | 中等 | 好 | 生成任务 |

| P-tuning v2 | 中等 | 中等 | 很好 | 指令跟随 |

应用场景扩展

行业专用模型:

各行业都在基于通用LLM开发专用模型,如医疗领域的Med-PaLM、法律领域的LawGPT、金融领域的FinGPT等。这些模型通过专业数据微调,在特定领域表现出色。

企业定制模型:

大型企业基于自身业务数据和需求,定制专属的AI模型。如客服模型、营销模型、风控模型等,这些模型深度融入企业业务流程。

多语言优化:

针对特定语言或语种的微调,如小语种模型、方言模型等,提升AI在语言处理上的本地化能力。

Prompt Engineering:人机交互的艺术与科学

2025年Prompt Engineering发展

Prompt Engineering(提示工程)在2025年已经从经验积累阶段发展为系统化的技术学科,出现了更多科学的方法论和最佳实践。

自动化提示优化:通过算法自动优化提示词,如Promptbreeder、APE(Automatic Prompt Engineer)等技术,能够自动发现最优的提示词组合。

提示词模板库:出现了大量专业的提示词模板库和工具,如LangChain Hub、PromptBase等,为各种应用场景提供高质量的提示词模板。

多模态提示:随着多模态模型的发展,提示工程也扩展到多模态领域,包括图像提示、音频提示等复合提示技术。

高级提示技术

思维链(Chain of Thought, CoT):

引导AI逐步思考,展示推理过程,大幅提升复杂问题的解决能力。2025年出现了更多CoT的变体,如Self-Consistency、Tree of Thoughts等。

少样本学习(Few-shot Learning):

通过提供少量示例,让AI快速学习特定任务模式。最新的技术包括动态示例选择、示例优化等。

角色扮演提示:

为AI设定特定角色,影响回答的风格和角度。如"你是一位经验丰富的医生"、"你是一位专业的律师"等角色设定。

约束生成提示:

通过明确的约束条件控制AI的输出,如长度限制、格式要求、风格要求等。

工具和平台生态

2025年出现了大量Prompt Engineering的专业工具和平台:

提示词开发环境:

如PromptIDE、PromptCharm等,提供提示词编写、测试、优化的集成环境。

提示词管理系统:

企业级的提示词管理平台,支持提示词版本控制、A/B测试、效果监控等。

提示词市场:

如PromptBase等平台,用户可以购买和销售高质量的提示词模板。

多模态AI:感知世界的全新维度

2025年多模态技术突破

多模态AI在2025年取得了突破性进展,从简单的多模态理解发展到深度的多模态融合和生成。

统一架构模型:出现了更多统一的多模态架构,如Google的Gemini系列、OpenAI的GPT-5等,这些模型从设计之初就考虑了多模态处理能力,而非简单的模块拼接。

跨模态推理:现代多模态AI不仅能够处理多种模态的数据,还能够在不同模态之间进行深度的推理和转换。如根据文本描述生成图像,根据图像内容生成文本描述等。

实时多模态处理:通过模型压缩和硬件加速,多模态AI能够在边缘设备上实现实时处理,为移动应用和物联网设备提供强大的AI能力。

技术架构解析

现代多模态AI的技术架构通常包括:

模态编码器:

- 文本编码器(如BERT、RoBERTa等)

- 图像编码器(如ViT、CLIP等)

- 音频编码器(如Whisper、Wav2Vec等)

- 视频编码器(如TimeSformer、VideoMAE等)

跨模态融合:

- 早期融合:在输入层融合多模态特征

- 晚期融合:在输出层融合多模态结果

- 深度融合:在模型中间层进行多模态交互

统一表示空间:

- 通过对比学习等方法,将不同模态的数据映射到统一的语义空间

- 实现跨模态的语义对齐和转换

应用场景创新

多模态内容创作:

用户可以通过文本、图像、音频等多种输入方式,生成多媒体内容。如根据文本描述生成配图和背景音乐,根据草图生成完整的视频等。

智能教育助手:

结合文本、图像、视频、音频等多种教学资源,提供个性化的学习体验。如根据学生的文字问题生成视频讲解,根据图像题目提供语音解答等。

医疗诊断辅助:

综合患者的文字描述、医学影像、体检报告等多模态信息,提供更准确的诊断建议。如结合X光片和患者症状描述,给出诊断结果和治疗建议。

知识图谱:结构化知识的智慧网络

2025年知识图谱发展

知识图谱技术在2025年与AI大模型的结合更加紧密,成为增强AI知识准确性和可解释性的重要技术。

动态知识图谱:传统的知识图谱更新缓慢,2025年出现了更多动态知识图谱技术,能够实时更新知识,保持知识的时效性。

多模态知识图谱:知识图谱不再局限于文本知识,而是扩展到图像、视频、音频等多模态知识的表示和推理。

知识图谱与LLM深度融合:通过知识图谱增强LLM的知识准确性,通过LLM增强知识图谱的构建和推理能力,形成良性循环。

技术架构演进

现代知识图谱系统的技术架构包括:

知识获取层:

- 结构化数据抽取(数据库、API等)

- 非结构化数据抽取(文本、图像等)

- 知识清洗和标准化

知识存储层:

- 图数据库(如Neo4j、JanusGraph等)

- 知识索引和查询优化

- 分布式存储和容错机制

推理引擎层:

- 符号推理(基于规则的推理)

- 统计推理(基于概率的推理)

- 神经符号推理(结合神经网络和符号推理)

应用接口层:

- 知识查询API

- 推理服务API

- 可视化接口

与AI的结合应用

知识增强的LLM:

通过知识图谱为LLM提供准确的事实知识,减少幻觉现象。如Google的Gemini模型就深度集成了知识图谱技术。

智能问答系统:

基于知识图谱构建的问答系统能够提供准确、可解释的答案。如医疗问答、法律咨询等专业领域的应用。

推荐系统增强:

利用知识图谱提升推荐的准确性和可解释性。如基于用户兴趣图谱和内容知识图谱的个性化推荐。

AI伦理与安全:负责任的AI发展

2025年伦理安全挑战

随着AI能力的增强,伦理和安全问题在2025年变得更加突出和复杂。

深度伪造技术:AI生成的虚假内容越来越逼真,对信息真实性构成严重威胁。2025年出现了更多深度伪造检测和防范技术。

AI对齐问题:如何确保AI系统的行为与人类价值观保持一致,是一个持续的技术挑战。对齐技术包括RLHF、Constitutional AI等方法。

隐私保护挑战:AI系统的训练和运行需要大量数据,如何在利用数据的同时保护用户隐私,是一个重要课题。联邦学习、差分隐私等技术得到广泛应用。

技术解决方案

内容安全检测:

- 多模态内容识别(文本、图像、音频、视频)

- 实时内容过滤和拦截

- 恶意内容检测和预警

模型安全防护:

- 对抗攻击防御(Adversarial Defense)

- 模型水印和溯源技术

- 模型行为监控和审计

隐私保护技术:

- 联邦学习(Federated Learning)

- 差分隐私(Differential Privacy)

- 同态加密(Homomorphic Encryption)

治理框架和标准

国际标准:

- ISO/IEC人工智能标准

- IEEE伦理设计标准

- OECD AI原则

行业规范:

- 技术伦理指南

- 安全开发规范

- 数据治理标准

法律法规:

- 欧盟AI法案

- 各国AI监管法规

- 行业特定监管要求

总结:2025年AI技术生态全景

通过对2025年AI核心技术概念的深入分析,我们可以看到一个完整的技术生态体系正在形成:

基础层:以LLM为核心的基础模型技术,提供了强大的认知和语言能力基础。

交互层:Function Call和多模态技术,让AI能够与外部世界进行丰富的交互。

自主层:Agent技术赋予AI自主行动和决策能力,实现复杂任务的自动化。

增强层:RAG和知识图谱技术,增强AI的知识准确性和可解释性。

优化层:Fine-tuning和Prompt Engineering技术,优化AI的性能和交互效果。

保障层:伦理和安全技术,确保AI的负责任发展和应用。

这些技术不是孤立的,而是相互支撑、协同发展的整体。根据PPIO发布的AI报告,2025年上半年各种现象级智能体应用层出不穷,证明了这个技术生态的活力和潜力。

未来,随着技术的进一步发展,我们将看到更多创新的应用场景和商业模式。AI技术将从工具逐渐转变为伙伴,从辅助系统逐渐转变为协作伙伴,为人类社会创造更大的价值。

在这个快速发展的时代,理解这些核心技术概念,不仅有助于我们更好地使用AI工具,也能够帮助我们把握技术发展趋势,在AI时代保持竞争力。让我们一起拥抱这个充满无限可能的AI新时代!

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)