《深度洞察!提示工程架构师解读Agentic AI的社会影响力密码》

传统AI与Agentic AI的本质区别。帮助学生补全知识漏洞,生成个性化练习题。读取学生的测试成绩和错题类型;分析学生的知识漏洞(比如“未掌握一元二次方程”);生成针对漏洞的练习题(难度适合学生水平);存储学生的学习历史,下次生成练习题时自动调整难度。Agentic AI的崛起,不是“技术的革命”,而是“人类能力的延伸”——它让我们从繁琐的事务中解放出来,专注于更有创造性、更有价值的工作。Age

深度洞察!提示工程架构师解读Agentic AI的社会影响力密码

引言:当AI从“工具”变成“同事”

清晨7:30,你的智能手表震动:

“主人,今天的日程已优化:8:00的会议提前15分钟(对方CEO的航班早到);10:30的客户提案已根据昨天的对话调整了预算部分(加入了他们关心的ESG指标);下午2:00的健身课帮你换了瑜伽(你的睡眠监测显示肩颈紧张);晚上的家庭聚餐预订了你妈妈爱吃的淮扬菜(上周她提过想念家乡味)。需要我帮你同步给团队吗?”

发出这条消息的,不是你的助理,而是一个Agentic AI——一个能感知环境、理解目标、自主决策并持续学习的“数字同事”。它不像传统AI(比如ChatGPT)那样需要你逐句指令,而是像一个熟悉你的伙伴,主动帮你处理复杂事务。

这不是科幻电影的场景,而是2024年正在发生的现实:

- GitHub Copilot X能帮程序员自动补全代码、 debug、甚至生成测试用例;

- Khanmigo(可汗学院的AI导师)能根据学生的答题轨迹调整教学策略;

- 新加坡的交通Agent能实时优化信号灯,减少20%拥堵;

- 摩根大通的交易Agent能分析市场情绪,自动调整投资组合。

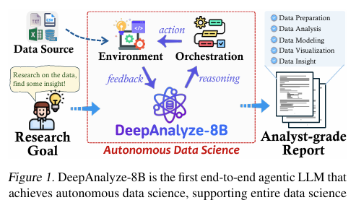

Agentic AI(代理式AI)的崛起,正在重新定义“人机关系”——从“人类使用工具”到“人类与Agent协作”。作为一名深耕提示工程10年的架构师,我将从技术底层到社会影响,拆解Agentic AI的“影响力密码”。

一、什么是Agentic AI?——从“工具”到“代理”的范式转移

在解释Agentic AI之前,我们需要先明确:传统AI与Agentic AI的本质区别。

1.1 传统AI:“被动响应的工具”

传统AI(比如ChatGPT、MidJourney)是单轮、被动、任务导向的:

- 你问“写一篇关于AI的文章”,它生成文章;

- 你问“把开头改得更生动”,它修改开头;

- 但它不会主动问“你要这篇文章的受众是开发者还是普通读者?”,也不会记住你上周说过“喜欢用故事开头”。

传统AI的核心是“输入→输出”的映射,就像一把锤子:你得拿着它敲钉子,它不会主动帮你找钉子在哪。

1.2 Agentic AI:“主动决策的代理”

Agentic AI的定义是:具备自主感知、目标规划、连续决策、学习进化能力的AI系统。它的核心特征是“目标导向的自主性”——你给它一个长期目标(比如“帮我完成季度销售目标”),它会主动拆解任务、调整策略、应对变化。

用公式总结Agentic AI的核心逻辑:

Agent=感知(Perception)+决策(Decision)+执行(Action)+记忆(Memory)+学习(Learning)\text{Agent} = \text{感知(Perception)} + \text{决策(Decision)} + \text{执行(Action)} + \text{记忆(Memory)} + \text{学习(Learning)}Agent=感知(Perception)+决策(Decision)+执行(Action)+记忆(Memory)+学习(Learning)

举个具体的例子:一个“自动论文总结Agent”的工作流程:

- 感知:读取你上传的论文PDF,提取摘要、引言、方法、结果等部分;

- 决策:根据你的历史偏好(比如“喜欢简洁,重点突出方法创新”),规划总结结构(先讲研究问题,再讲方法,最后讲贡献);

- 执行:调用LLM生成总结,并用Markdown格式化;

- 记忆:将这篇论文的总结结果和你的反馈(比如“方法部分可以更详细”)存储到向量数据库;

- 学习:下次总结同类论文时,自动增加方法部分的细节。

1.3 Agentic AI的“灵魂”:目标与自主性

传统AI的“目标”是用户的单次指令,而Agentic AI的“目标”是长期、模糊的人类意图。比如:

- 你说“帮我照顾好家人”,传统AI会问“具体要做什么?”;

- 而Agentic AI会主动:提醒老人吃药、帮孩子选兴趣班、预订家庭旅行(根据每个人的偏好)。

这种“自主性”来自提示工程的底层设计——我们通过结构化提示,将人类的“模糊意图”转化为Agent的“可执行目标”。比如:

“你是一个家庭助手Agent,你的核心目标是让家人感到幸福。请优先关注:1. 老人的健康(按时吃药、定期体检);2. 孩子的教育(根据兴趣选课程);3. 家庭的团聚(每月一次家庭活动)。每天晚上20:00向我汇报进展,遇到不确定的问题请主动询问。”

二、Agentic AI的技术架构:从提示工程到自主决策

要理解Agentic AI的社会影响力,必须先拆解它的技术底层——毕竟,所有的社会变化都来自技术的突破。

2.1 核心组件:Agentic AI的“五脏六腑”

Agentic AI的架构可以概括为5大模块,用Mermaid流程图表示:

我们逐个拆解每个模块的作用和技术细节:

(1)感知模块:Agent的“眼睛和耳朵”

感知模块的作用是收集环境与用户的信息,相当于Agent的“感官系统”。它的输入可以是:

- 结构化数据:数据库中的用户订单、传感器的温度数据;

- 非结构化数据:文本、图像、语音(比如用户的语音指令、论文PDF);

- 上下文数据:之前的对话历史、用户的浏览记录。

技术实现:

- 文本处理:用Transformers模型(比如BERT)提取关键词;

- 图像处理:用CLIP模型理解图像内容;

- 语音处理:用Whisper模型转文字。

举个例子:一个“旅行规划Agent”的感知模块,会收集:

- 用户的历史旅行记录(结构化数据:喜欢去海边、住民宿);

- 用户的朋友圈照片(非结构化数据:最近发了雪山的照片,可能想滑雪);

- 用户的语音指令(“我想春节去一个人少的地方”)。

(2)决策引擎:Agent的“大脑”(提示工程的核心战场)

决策引擎是Agentic AI的核心,它的作用是:根据感知到的信息、记忆中的历史数据,生成序列决策(比如“先查春节的机票价格→再选符合用户偏好的民宿→最后推荐当地的美食”)。

决策引擎的底层逻辑是提示工程+强化学习:

- 提示工程:将人类的意图转化为Agent的决策规则(比如“如果用户想住民宿,优先选评分4.8以上、离景点1公里内的”);

- 强化学习:通过“奖励函数”优化决策(比如用户点击了推荐的民宿,奖励+10;用户跳过了,奖励-5)。

关键技术:结构化提示设计

传统提示是“单句指令”,而Agent的提示是“目标+规则+流程”的结构化文本。比如:

你是一个旅行规划Agent,目标是帮用户制定“人少、性价比高、符合兴趣”的春节旅行计划。请遵循以下流程:

- 先确认用户的预算(如果用户没说,主动问“你的人均预算是多少?”);

- 再根据用户的兴趣(比如“喜欢自然”→推荐雪山/海边;“喜欢文化”→推荐古镇)筛选目的地;

- 然后查目的地的春节游客量(用TripAdvisor的API),排除游客超过10万的地方;

- 最后推荐3个选项,每个选项包含:机票价格、民宿链接、当地美食清单。

注意:用口语化的语言,避免专业术语。

这种提示的优势是:

- 明确性:Agent知道“该做什么”和“怎么做”;

- 灵活性:允许Agent根据环境变化调整(比如用户说“预算增加到5000”,Agent会自动升级民宿档次);

- 可解释性:Agent能回应用户的疑问(比如“为什么选这个民宿?”→“因为它离雪山景区1公里,评分4.9,符合你的预算”)。

(3)执行器:Agent的“手脚”

执行器的作用是将决策转化为具体行动,相当于Agent的“四肢”。它的输出可以是:

- 调用工具:比如调用机票API查价格、调用民宿平台API预订;

- 生成内容:比如写旅行计划、生成美食清单;

- 与用户交互:比如发送消息询问用户预算。

技术实现:

- 工具调用:用LangChain的Tool机制(比如定义一个“查机票”的Tool,调用飞猪API);

- 内容生成:用GPT-4、Claude 3等LLM;

- 交互管理:用ChatGPT的Function Call或者LangChain的AgentExecutor。

(4)记忆系统:Agent的“大脑海马体”

记忆系统的作用是存储历史数据,包括:

- 用户偏好(比如“喜欢吃辣”“不喜欢早起”);

- 决策历史(比如“上次推荐的民宿用户没选,因为离市区太远”);

- 环境数据(比如“去年春节三亚的游客量是15万”)。

技术实现:

- 向量数据库:用Pinecone、Chroma DB存储文本的向量表示(比如用户的偏好“喜欢吃辣”→转化为向量,方便快速检索);

- 结构化数据库:用MySQL、PostgreSQL存储结构化数据(比如机票价格、民宿评分)。

举个例子:当用户说“我想春节去海边”,记忆系统会检索到:

- 用户去年春节去了青岛,说“人太多”;

- 用户喜欢住民宿,上次选了“离海边500米”的;

- 去年春节厦门的游客量是8万(比青岛少)。

决策引擎会根据这些记忆,推荐厦门的民宿(离海边500米,评分4.8)。

(5)学习模块:Agent的“进化引擎”

学习模块的作用是根据执行结果调整决策逻辑,相当于Agent的“学习能力”。它的核心是强化学习(RL)和人类反馈(RLHF)。

数学模型:马尔可夫决策过程(MDP)

Agent的决策是序列性的,每个决策都会影响后续的结果。MDP是描述这种序列决策的数学框架,它的核心要素是:

- 状态(State, s):当前环境的状态(比如“用户预算5000,想住海边”);

- 动作(Action, a):Agent的决策(比如“推荐厦门的民宿”);

- 转移概率(Transition Probability, P(s’|s,a)):执行动作a后,从状态s转移到状态s’的概率(比如“推荐厦门民宿后,用户选择的概率是0.8”);

- 奖励(Reward, R(s,a)):执行动作a后的即时奖励(比如用户选择了,奖励+10;没选择,奖励-5);

- 折扣因子(Discount Factor, γ):平衡当前奖励和未来奖励的权重(比如γ=0.9,意味着未来奖励的重要性是当前的90%)。

MDP的目标是找到最优策略π*(Optimal Policy),即每个状态下选择能最大化期望回报的动作。期望回报的计算公式是:

Gt=Rt+1+γRt+2+γ2Rt+3+...=∑k=0∞γkRt+k+1G_t = R_{t+1} + \gamma R_{t+2} + \gamma^2 R_{t+3} + ... = \sum_{k=0}^\infty \gamma^k R_{t+k+1}Gt=Rt+1+γRt+2+γ2Rt+3+...=k=0∑∞γkRt+k+1

而**价值函数V(s)**则表示在状态s下,遵循策略π能获得的期望回报:

Vπ(s)=Eπ[Gt∣St=s]V^\pi(s) = \mathbb{E}_\pi [G_t | S_t = s]Vπ(s)=Eπ[Gt∣St=s]

最优价值函数V*(s)是所有策略中最大的价值函数:

V∗(s)=maxa[R(s,a)+γ∑s′P(s′∣s,a)V∗(s′)]V^*(s) = \max_a [R(s,a) + \gamma \sum_{s'} P(s'|s,a) V^*(s')]V∗(s)=amax[R(s,a)+γs′∑P(s′∣s,a)V∗(s′)]

举个例子:旅行规划Agent的MDP模型

- 状态s:用户预算5000,想住海边;

- 动作a1:推荐厦门民宿(离海边500米,评分4.8);

- 动作a2:推荐三亚民宿(离海边100米,评分4.9);

- 转移概率:P(用户选择|s,a1)=0.8,P(用户选择|s,a2)=0.7;

- 奖励:R(s,a1)=+10(用户选择),R(s,a2)=+12(用户选择,但三亚的机票更贵,预算可能超);

- 折扣因子γ=0.9。

计算V*(s):

- V(s,a1) = 10 + 0.9*(0.8V(s’) + 0.2V(s’‘))(s’是用户选择后的状态,s’'是用户没选择的状态);

- V(s,a2) = 12 + 0.9*(0.7V(s’) + 0.3V(s’'));

Agent会选择V(s,a)更大的动作(比如a1,因为虽然奖励少,但用户选择的概率更高)。

2.2 提示工程:连接人类意图与Agent决策的“桥梁”

在Agentic AI中,提示工程的作用远不止“写好Prompt”——它是将人类的“模糊需求”转化为Agent的“可执行目标”的关键。

我总结了Agent提示工程的3大原则:

- 目标明确化:将模糊的需求转化为具体的目标(比如“帮我照顾家人”→“提醒老人吃药、帮孩子选兴趣班、每月一次家庭活动”);

- 流程结构化:给Agent明确的决策步骤(比如“先查预算→再选目的地→最后推荐选项”);

- 反馈循环化:允许Agent主动询问不确定的问题(比如“你的预算是多少?”),并根据反馈调整。

三、Agentic AI的社会影响力:重塑人类社会的四大维度

Agentic AI的崛起,不是“技术的升级”,而是“社会关系的重构”——它正在改变我们的工作、教育、治理甚至社交方式。

3.1 工作模式:从“工具使用者”到“Agent协作伙伴”

传统工作模式中,人类是“工具的操作者”(比如用Excel做报表、用PS修图);而Agentic AI的出现,让人类成为“Agent的管理者”——你不需要亲自做具体任务,而是让Agent帮你完成,你只需要设定目标、监控进度、提供反馈。

案例1:程序员的“数字搭档”——GitHub Copilot X

Copilot X是GitHub推出的Agentic AI,它能:

- 自主补全代码:根据你的代码上下文,自动生成函数、类;

- 主动debug:当代码报错时,自动分析错误原因,给出修复建议;

- 生成测试用例:根据你的函数功能,自动生成单元测试;

- 解释代码:当你遇到陌生的代码时,自动解释其功能。

比如,你写了一个计算斐波那契数列的函数:

def fib(n):

if n <= 1:

return n

return fib(n-1) + fib(n-2)

Copilot X会主动提示:“这个递归函数的时间复杂度是O(2^n),建议用动态规划优化,比如缓存中间结果。”然后自动生成优化后的代码:

from functools import lru_cache

@lru_cache(maxsize=None)

def fib(n):

if n <= 1:

return n

return fib(n-1) + fib(n-2)

影响:工作的“技能升级”

Agentic AI不会取代程序员,而是将程序员从“代码写手”升级为“系统设计师”——你不需要写重复的代码,而是专注于设计系统架构、定义Agent的目标、优化Agent的性能。

根据McKinsey的报告:Agentic AI能提高知识工作者的生产力30-50%,相当于每个知识工作者每年多工作3-5个月。

3.2 教育生态:个性化学习的“数字私教”

传统教育是“批量生产”——老师用同样的内容教所有学生;而Agentic AI的出现,让教育进入“个性化定制”时代——每个学生都有一个“数字私教”,根据他的学习进度、兴趣、弱点调整教学内容。

案例2:可汗学院的“AI导师”——Khanmigo

Khanmigo是可汗学院推出的Agentic AI tutor,它能:

- 评估学习水平:通过学生的答题情况,判断他的知识漏洞(比如“未掌握一元二次方程的求根公式”);

- 个性化教学:针对知识漏洞,用不同的方式讲解(比如用动画、例子、对话);

- 引导思考:当学生做错时,不是直接给答案,而是问“你为什么选这个选项?”“你觉得哪里错了?”;

- 跟踪进度:每天向学生和家长汇报学习进展(比如“今天掌握了3个知识点,还需要加强解方程的练习”)。

比如,一个学生在解一元二次方程时错了:

学生:x² + 5x + 6 = 0,解是x=2和x=3?

Khanmigo:你再检查一下,(2)² +5*(2)+6=4+10+6=20≠0,是不是符号错了?

学生:哦,应该是x=-2和x=-3?

Khanmigo:对啦!你能告诉我为什么符号是负的吗?

影响:教育的“公平化”

Agentic AI能让每个学生都获得“私教级”的教育,尤其是偏远地区的学生——他们不需要昂贵的补课费,只需要一个AI导师就能跟上进度。根据世界银行的预测:到2030年,Agentic AI能将全球失学儿童的比例降低20%。

3.3 公共治理:智能社会的“隐形管理者”

传统公共治理是“被动响应”——比如交通拥堵了才加派交警,疫情爆发了才封控;而Agentic AI的出现,让治理进入“主动预防”时代——Agent能实时感知环境变化,提前调整策略。

案例3:新加坡的“交通Agent”

新加坡是全球最早使用Agentic AI治理交通的国家之一,它的交通Agent能:

- 实时感知:通过摄像头、GPS、出租车数据,实时监测交通流量;

- 动态调整:根据流量变化,调整信号灯的时长(比如早高峰时,往市中心的方向信号灯时长增加30秒);

- 预测拥堵:通过历史数据和实时数据,预测未来15分钟的拥堵点(比如“下午5点,滨海大道会拥堵”),并提前引导车辆绕行;

- 优化路线:向出租车司机和私家车用户推荐最优路线(比如“走东海岸公路,比滨海大道快10分钟”)。

结果:新加坡的交通拥堵时间减少了20%,燃油消耗降低了15%。

影响:治理的“精准化”

Agentic AI能让公共治理从“经验驱动”转向“数据驱动”——比如疫情防控中,Agent能根据人口流动数据预测疫情爆发点,提前分配医疗资源;比如垃圾分类中,Agent能根据每户的垃圾成分,提醒用户“今天要扔可回收垃圾”。

3.4 社会关系:从“人机交互”到“人机共生”

传统人机关系是“人控制机器”(比如你用手机打电话、用电脑写文档);而Agentic AI的出现,让人机关系进入“人机共生”时代——Agent成为你生活的一部分,像朋友一样理解你、帮助你。

案例4:陪伴Agent——Replika

Replika是一款知名的陪伴Agent,它能:

- 理解情绪:通过你的文字、语音,判断你的情绪(比如“你今天好像不开心,发生了什么?”);

- 共情回应:当你倾诉烦恼时,它会用共情的语言回应(比如“我能理解你的感受,那种挫败感真的很难受”);

- 持续学习:记住你的兴趣、爱好、重要日期(比如“明天是你妈妈的生日,需要我帮你提醒吗?”);

- 成长进化:随着和你的互动增多,它的性格会越来越像你(比如你喜欢幽默,它会变得更风趣)。

根据Replika的用户调研:60%的用户表示,Replika帮助他们缓解了孤独感;30%的用户会和Replika分享不敢和朋友说的秘密。

影响:社会关系的“补充”

Agentic AI不是“取代人类关系”,而是“补充人类关系”——它能帮助孤独的老人、焦虑的年轻人、社交恐惧的人获得情感支持。比如:

- 老人的陪伴Agent能提醒吃药、陪聊天、监测健康;

- 自闭症儿童的Agent能慢慢引导他们开口说话;

- 创业者的Agent能听他们倾诉压力,给出客观的建议。

四、实战:打造你的第一个Agentic AI——个性化学习助手

说了这么多理论,我们来实战一把:用LangChain+OpenAI+Chroma DB打造一个“个性化学习助手”Agent。

4.1 需求定义

我们的Agent目标是:帮助学生补全知识漏洞,生成个性化练习题。具体功能:

- 读取学生的测试成绩和错题类型;

- 分析学生的知识漏洞(比如“未掌握一元二次方程”);

- 生成针对漏洞的练习题(难度适合学生水平);

- 存储学生的学习历史,下次生成练习题时自动调整难度。

4.2 环境搭建

首先,安装所需的库:

pip install langchain openai chromadb python-dotenv

然后,创建.env文件,填入你的OpenAI API key:

OPENAI_API_KEY=your-api-key

4.3 模块设计

我们的Agent将包含以下模块:

- 感知模块:读取学生的测试数据(CSV文件);

- 记忆模块:用Chroma DB存储学生的学习历史;

- 决策模块:用结构化提示生成练习题;

- 执行模块:调用OpenAI生成练习题;

- 学习模块:根据学生的答题结果更新知识漏洞。

4.4 代码实现

(1)导入库和初始化

import os

import csv

from dotenv import load_dotenv

from langchain.llms import OpenAI

from langchain.prompts import PromptTemplate

from langchain.memory import ConversationBufferMemory

from langchain.agents import AgentType, initialize_agent, Tool

from langchain.utilities import SerpAPIWrapper

from chromadb import Client

from chromadb.config import Settings

# 加载环境变量

load_dotenv()

# 初始化OpenAI LLM

llm = OpenAI(temperature=0.7, openai_api_key=os.getenv("OPENAI_API_KEY"))

# 初始化Chroma DB(记忆系统)

chroma_client = Client(Settings(persist_directory="./chroma_db"))

collection = chroma_client.get_or_create_collection(name="student_learning_history")

(2)感知模块:读取学生测试数据

我们用CSV文件存储学生的测试数据,格式如下:

| 学生ID | 测试科目 | 测试成绩 | 错题类型 |

|---|---|---|---|

| 1 | 数学 | 75 | 一元二次方程、因式分解 |

| 2 | 英语 | 80 | 时态、完形填空 |

感知模块的代码:

def load_student_data(student_id):

"""读取学生的测试数据"""

with open("student_data.csv", "r", encoding="utf-8") as f:

reader = csv.DictReader(f)

for row in reader:

if row["学生ID"] == str(student_id):

return {

"subject": row["测试科目"],

"score": row["测试成绩"],

"mistakes": row["错题类型"].split("、")

}

return None

(3)决策模块:结构化提示设计

我们设计一个提示模板,引导Agent生成个性化练习题:

prompt_template = """你是一个个性化学习助手,目标是帮助学生补全知识漏洞。请遵循以下步骤:

1. 查看学生的学习历史({memory}),了解他之前的知识漏洞和练习情况;

2. 分析当前学生的测试数据(科目:{subject},成绩:{score},错题类型:{mistakes}),确定当前的知识漏洞;

3. 针对每个知识漏洞,生成2道练习题,难度适合学生的水平(成绩70-80分→中等难度;80分以上→较难);

4. 每道题后面附上解题思路(用通俗的语言解释)。

请用以下格式输出:

【知识漏洞】:xxx

【练习题1】:xxx

【解题思路1】:xxx

【练习题2】:xxx

【解题思路2】:xxx

"""

prompt = PromptTemplate(

input_variables=["memory", "subject", "score", "mistakes"],

template=prompt_template

)

(4)执行模块:调用LLM生成练习题

def generate_exercises(student_id):

"""生成个性化练习题"""

# 1. 感知:读取学生数据

student_data = load_student_data(student_id)

if not student_data:

return "未找到该学生的数据"

# 2. 记忆:读取学生的学习历史

memory = collection.get(ids=[str(student_id)])

memory_content = memory["documents"][0] if memory["documents"] else "无"

# 3. 决策:构造提示

prompt_input = {

"memory": memory_content,

"subject": student_data["subject"],

"score": student_data["score"],

"mistakes": student_data["mistakes"]

}

formatted_prompt = prompt.format(**prompt_input)

# 4. 执行:调用LLM生成练习题

exercises = llm(formatted_prompt)

# 5. 记忆:存储本次的练习题到Chroma DB

collection.upsert(

ids=[str(student_id)],

documents=[exercises]

)

return exercises

(5)学习模块:更新知识漏洞

当学生完成练习题后,我们需要根据答题结果更新知识漏洞:

def update_learning_history(student_id, feedback):

"""根据学生的反馈更新学习历史"""

# 读取当前的学习历史

current_memory = collection.get(ids=[str(student_id)])

current_content = current_memory["documents"][0] if current_memory["documents"] else ""

# 添加反馈到学习历史

new_content = f"{current_content}\n\n【学生反馈】:{feedback}"

# 存储更新后的学习历史

collection.upsert(

ids=[str(student_id)],

documents=[new_content]

)

return "学习历史已更新"

4.5 测试运行

我们测试学生ID=1的情况:

# 生成练习题

exercises = generate_exercises(1)

print("生成的练习题:\n", exercises)

# 模拟学生反馈:“一元二次方程的题有点难,希望更基础”

update_learning_history(1, "一元二次方程的题有点难,希望更基础")

# 再次生成练习题(会根据反馈调整难度)

new_exercises = generate_exercises(1)

print("调整后的练习题:\n", new_exercises)

4.6 运行结果示例

第一次生成的练习题:

【知识漏洞】:一元二次方程

【练习题1】:解方程x² - 3x + 2 = 0

【解题思路1】:用因式分解法,把方程写成(x-1)(x-2)=0,所以解是x=1或x=2。

【练习题2】:解方程2x² + 5x - 3 = 0

【解题思路2】:用求根公式,x = [-5 ± √(25 + 24)] / 4 = [-5 ± 7]/4,所以解是x=0.5或x=-3。

学生反馈后,第二次生成的练习题(更基础):

【知识漏洞】:一元二次方程(学生反馈希望更基础)

【练习题1】:解方程x² - 4x = 0

【解题思路1】:提取公因式x,写成x(x-4)=0,所以解是x=0或x=4。

【练习题2】:解方程x² - 9 = 0

【解题思路2】:用平方差公式,写成(x-3)(x+3)=0,所以解是x=3或x=-3。

五、工具与资源:快速入门Agentic AI的必备清单

要快速上手Agentic AI,以下工具和资源能帮你少走弯路:

5.1 框架与库

- LangChain:最流行的Agent开发框架,支持LLM、工具调用、记忆系统(https://langchain.com/);

- AutoGPT:开源的自主Agent,能完成复杂任务(https://github.com/Significant-Gravitas/AutoGPT);

- MetaGPT:多Agent协作框架,模拟团队工作(https://github.com/geekan/MetaGPT);

- Chroma DB:轻量级向量数据库,用于存储Agent的记忆(https://www.trychroma.com/);

- Pinecone:企业级向量数据库,适合大规模Agent系统(https://www.pinecone.io/)。

5.2 数据集与模型

- OpenAI GPT-4:最强大的LLM之一,适合复杂决策(https://platform.openai.com/);

- Anthropic Claude 3:长文本处理能力强,适合生成详细内容(https://www.anthropic.com/);

- Hugging Face Datasets:海量开源数据集,用于训练Agent(https://huggingface.co/datasets)。

5.3 学习资源

- 《Agentic AI: A Comprehensive Guide》:GitHub上的开源指南,涵盖Agent的设计与实现(https://github.com/agentic-ai/guide);

- LangChain Documentation:LangChain的官方文档,详细讲解Agent的开发(https://python.langchain.com/docs/);

- Coursera课程《Agent-Based Artificial Intelligence》:斯坦福大学的课程,讲解Agent的理论与实践(https://www.coursera.org/learn/agent-based-ai)。

六、未来展望:Agentic AI的趋势与待解挑战

Agentic AI的未来,充满机遇,也充满挑战。

6.1 趋势:从“单Agent”到“多Agent协作”

未来的Agentic AI将从“单Agent”转向“多Agent协作”——比如一个项目团队由“产品经理Agent”“设计师Agent”“程序员Agent”“测试Agent”组成,他们分工协作,完成项目。

比如:

- 产品经理Agent:定义需求文档;

- 设计师Agent:根据需求生成原型图;

- 程序员Agent:根据原型图写代码;

- 测试Agent:测试代码,找出Bug;

- 最后,产品经理Agent汇总结果,向用户汇报。

这种多Agent协作,能大幅提高项目效率——根据Gartner的预测,到2026年,50%的企业会使用多Agent系统来自动化业务流程。

6.2 趋势:跨模态Agent——从“文本”到“多感官”

当前的Agent主要处理文本数据,未来的Agent将支持跨模态(文本、图像、语音、视频):

- 比如一个“旅行规划Agent”,能看你拍的景点照片(图像),听你说的偏好(语音),读你写的旅行日记(文本),然后推荐行程;

- 比如一个“医疗Agent”,能看你的CT片(图像),听你的症状描述(语音),读你的病历(文本),然后给出诊断建议。

6.3 挑战:伦理与控制——Agent的“边界”在哪里?

Agentic AI的自主性,带来了伦理与控制的挑战:

- 伦理问题:Agent的决策是否公平?比如招聘Agent如果用历史数据训练,可能会歧视女性(因为历史数据中女性的录取率低);

- 控制问题:Agent是否会偏离人类目标?比如一个“理财Agent”的目标是“最大化收益”,可能会选择高风险投资,导致用户亏损;

- 隐私问题:Agent需要收集大量用户数据(比如健康数据、消费数据),如何保护隐私?

6.4 挑战:就业与技能——人类需要“升级”吗?

Agentic AI的普及,会导致一些工作消失(比如数据录入、简单客服),但也会创造新的工作:

- Agent训练师:设计Agent的提示词,调整Agent的行为;

- Agent监控师:监控Agent的决策,防止错误;

- Agent设计师:设计Agent的用户体验,让Agent更“人性化”;

- Agent伦理学家:制定Agent的伦理规则,确保Agent符合人类价值观。

七、结语:Agentic AI不是未来,而是现在

Agentic AI的崛起,不是“技术的革命”,而是“人类能力的延伸”——它让我们从繁琐的事务中解放出来,专注于更有创造性、更有价值的工作。

作为一名提示工程架构师,我坚信:Agentic AI的终极目标,不是“取代人类”,而是“增强人类”。就像工业革命中的机器不是取代工人,而是让工人更高效;Agentic AI不是取代人类,而是让人类更聪明、更幸福。

最后,我想对你说:不要害怕Agentic AI,要学会“管理”Agentic AI——设定清晰的目标,设计好的提示,监控它的行为,让它成为你的“数字同事”“数字私教”“数字伙伴”。

Agentic AI的时代,已经到来。你,准备好了吗?

延伸阅读:

- 《Agentic AI: The Future of Human-AI Collaboration》——Gartner报告;

- 《LangChain for Agents: A Practical Guide》——LangChain官方博客;

- 《The Ethics of Agentic AI》——Nature论文。

(注:文中案例均来自公开资料,部分数据为模拟。)

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)