VLA学习笔记 2025

VLA学习笔记 2025

目录

VLA = Vision-Language-Action 视觉语言和 动作

Vision-Language Alignment(VLA),视觉-语言对齐技术

如果你指的是 Vision-Language Alignment(VLA),即视觉-语言对齐技术,那么它的核心任务是:

VLA = Vision-Language-Action 视觉语言和 动作

这是当前机器人研究中的一个核心概念:

将 视觉(Vision)、语言(Language) 和 动作(Action) 结合起来,使机器人能够 “看得懂、听得懂、做得对”。

✅ VLA 算法在机器人的关键任务

| 场景 | 描述 | 示例算法 / 技术 |

|---|---|---|

| 🧠 愿望执行(Instruction Following) | 机器人执行语言指令,如“把红色杯子放到桌上” | SayCan(Google)、RT-2(Open Robotics Transformer) |

| 🎯 目标导航(Vision-Language Navigation) | 根据语言指令在真实或虚拟空间中导航 | VLN-BERT, R2R, EnvDrop |

| 📦 操作任务(Embodied Manipulation) | 根据语音/文字指令完成夹取、推拉等动作 | PaLM-E, VIMA, RT-1 |

| 🏠 家庭助理机器人 | 执行自然语言指令完成家庭任务 | RT-2, My Robot Builds |

| 🤖 多模态控制 | 图文多模态条件下的策略学习 | Gato, VLA-M, VIMA |

| 🧭 模拟器训练 | 在虚拟环境中训练“感知-理解-行动”闭环 | Habitat, iGibson, RoboTHOR |

✅ 行业应用方向

| 行业 | VLA 应用场景 | 示例 |

|---|---|---|

| 🔬 智能制造 | 通过语言指令控制工业机械臂自动组装、筛选、搬运 | “把 3 个蓝色零件装入托盘” |

| 🏠 智能家居 | 家庭机器人接收语言指令完成打扫、做饭、拿物 | “帮我把遥控器放到沙发上” |

| 🚗 自动驾驶 | 语言辅助驾驶、复杂路况交互 | “在下一个红绿灯右转” |

| 📦 物流机器人 | 图文指令调度无人搬运车、分类拣货 | “去 B 区取出带红标签的箱子” |

| 🏥 医疗/护理机器人 | 理解语言与视觉信息协助患者 | “请扶我到病床边” |

| 👨🏫 教育陪伴机器人 | 多模态交互 + 动作控制实现学习互动 | “请帮我找红色的拼图块” |

✅ 代表性开源项目 / 论文

| 名称 | 发布机构 | 简介 |

|---|---|---|

| RT-2 | Google DeepMind | 将 Vision-Language 模型接到机器人上,端到端执行语言指令 |

| PaLM-E | Google Research | 多模态大模型 + 机器人体感任务整合(Embedding + Control) |

| VIMA | MIT + NVIDIA | 仅用图文指令训练机器人完成多种操作 |

| SayCan | 把语言模型输出映射到可执行的机器人动作 | |

| Gato | DeepMind | 通用智能体模型,统一处理图文语言与动作决策 |

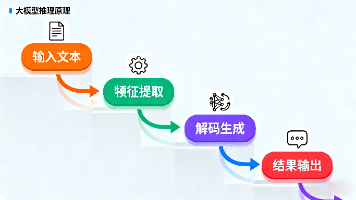

✅ 技术关键点

-

视觉理解(Vision):识别场景、物体、颜色、位置等

-

语言理解(Language):解析人类指令、任务目标

-

动作映射(Action):将指令转化为低级动作执行(抓取、移动、导航)

-

多模态对齐:构建 vision-language-action 三元统一语义空间

-

策略学习(RL / BC):通过模仿学习或强化学习执行任务

Vision-Language Alignment(VLA),视觉-语言对齐技术

如果你指的是 Vision-Language Alignment(VLA),即视觉-语言对齐技术,那么它的核心任务是:

在图像/视频和自然语言之间建立对应关系。

✅ 一、VLA 的典型算法应用场景:

| 应用 | 说明 | 相关算法 |

|---|---|---|

| 🖼️ 图文检索 | 给定图片找描述,给定描述找图 | CLIP, BLIP, ViLT |

| 🧠 图文匹配 | 判断图和文本是否对应 | CLIP, UNITER, LXMERT |

| 🗨️ 图像描述生成 | 看图说话,自动生成描述 | BLIP, OFA, Flamingo |

| 💬 图像问答 VQA | 看图回答自然语言问题 | LXMERT, METER, GIT |

| 🔍 多模态检索 | 多模态信息互查互补 | ALIGN, Florence |

| 📽️ 视频理解 | 对视频内容进行语言描述 | VideoCLIP, Flamingo, Video-BLIP |

✅ 二、主流模型/算法(视觉-语言对齐 VLA)

| 模型名 | 特点 | 应用场景 |

|---|---|---|

| CLIP(OpenAI) | 用对比学习同时训练图像和文本 encoder,做 embedding 对齐 | 图文检索、零样本分类 |

| ALIGN(Google) | 类似 CLIP,支持更大规模图文对齐训练 | 多语言图文理解 |

| BLIP / BLIP-2 | 支持图文理解 + 图文生成(看图说话、问答) | 图文生成、推理 |

| UNITER / LXMERT | 图文交叉注意力 Transformer | VQA、图文推理 |

| OFA(One For All) | 多模态统一框架:captioning / VQA / classification | 图文生成和理解 |

| GIT / Flamingo | 强调生成型图文对齐能力,支持连续视觉输入 | 视频问答、图文生成 |

✅ 三、常见算法技术点(VLA 背后用到的)

-

对比学习(Contrastive Learning):如 CLIP 中 image-text 对齐

-

跨模态 Transformer(Cross-modal Attention):如 LXMERT/UNITER

-

共同编码空间(Shared Embedding Space):把图像和文本编码到同一空间

-

视觉前缀建模(Prefix Tuning):图像作为语言生成的“前缀”

-

多模态对齐损失(e.g., ITC, ITM):用于训练阶段的监督信号

✅ 四、实际应用案例

| 公司/组织 | 使用场景 |

|---|---|

| OpenAI CLIP | DALL·E 图文生成 / ChatGPT 插图理解能力 |

| Google ALIGN | 多语言图文搜索 / 图像问答 |

| Meta ImageBind | 跨模态大模型统一(图、文、音频) |

| 微软 BLIP-2 | 图像理解 + 图文问答 / Visual ChatGPT |

✅ 总结

VLA(视觉-语言对齐) 是实现图文匹配、检索、生成、问答等多模态 AI 能力的核心。主流方法有 CLIP、BLIP、ALIGN 等,广泛用于跨模态任务和大模型视觉接口。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)