实时流式数字人,代码开源

实现实时流式数字人,可以实时对话,代码已经开源

·

目前数字人模型效果最好的是ernerf,其借鉴了nerf体渲染的思路,在输入维度上添加了音频特征,通过音频来影响渲染效果(控制嘴型)。

本文基于ernerf模型实现了实时流式数字人,代码已经开源https://github.com/lipku/metahuman-stream

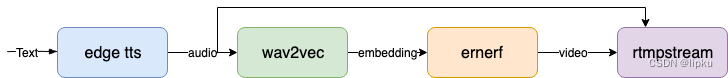

总体流程如下

- text输入可以来自websocket,实现数字人播报输入文字。

也可以接入chatgpt,将chatgpt的回答做为text输入,这样就实现了数字人实时对话效果。 - tts采用的免费edge tts,这个延时有点大。可以换成商用的tts模块,并且加入声音克隆,这样数字人效果更逼真。

- 提取音频特征(音频转embedding)用的wav2vec模型,相应的ernerf模型训练时也要用wav2vec来提取音频特征

- ernerf模型在这里面用的推理流程,根据输入的音频特征输出对应嘴型的image

- 用python做rtmp推流网上没什么现成的库,大部分都是启动ffmpeg命令行进程来实现,但在有音视频同时推流时这种方式行不通。这块卡了比较长时间,最后还是用c++调用ffmpeg api函数来实现rtmp推流,相关介绍在这篇文章https://zhuanlan.zhihu.com/p/675035586。

在没有text输入时,通过输入全0的音频来控制嘴型不动,并且保持视频的连续。

安装时遇到的一些问题

-

pytorch3d安装不成功

下载源码编译

git clone https://github.com/facebookresearch/pytorch3d.git

python setup.py install -

websocket报错

修改python/site-packages/werkzeug/routing/matcher.py,注释websocket_mismatch = True

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)