注意力机制Attention(一)-李沐动手学深度学习

非参数的Nadaraya-Watson核回归具有一致性(consistency)的优点:如果有足够的数据,此模型会收敛到最优结果。K是(核kernel)衡量x(查询)与xi(候选物)距离的函数,将距离归一化作为权重,表示xi的相对重要性。卷积、全连接、池化层基本只考虑非自主性提示,选择都偏向于感官输入,以池化为例:池化只考虑把窗口中最大的值抽取出来,只要是最大的值就行。自主性的与非自主性的注意力提

注意力机制

一、注意力提示

1.生物学中的注意力提示

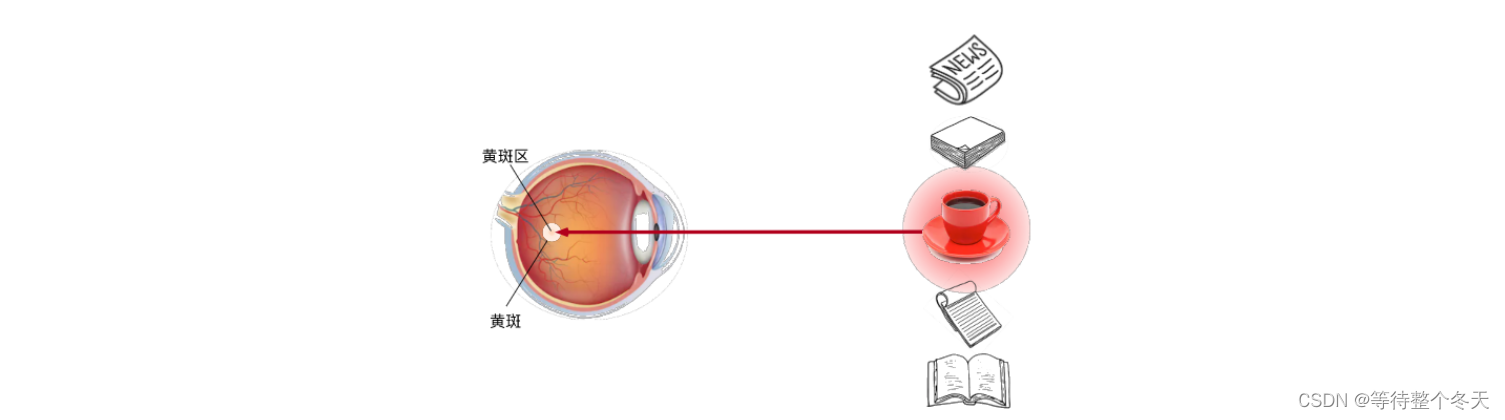

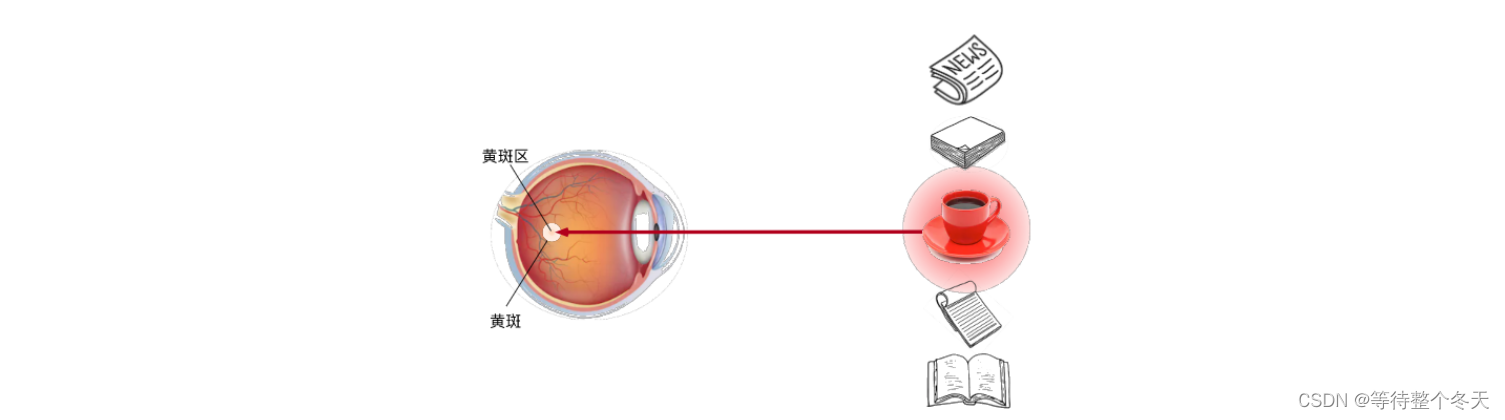

非自主性提示是基于环境中物体的突出性和易见性。假如你面前有五个物品: 一份报纸、一篇研究论文、一杯咖啡、一本笔记本和一本书,如下图所示。 所有纸制品都是黑白印刷的,但咖啡杯是红色的。 咖啡杯最突出显眼, 不由自主地引起人们的注意。 所以你把视力最敏锐的地方放到咖啡上。

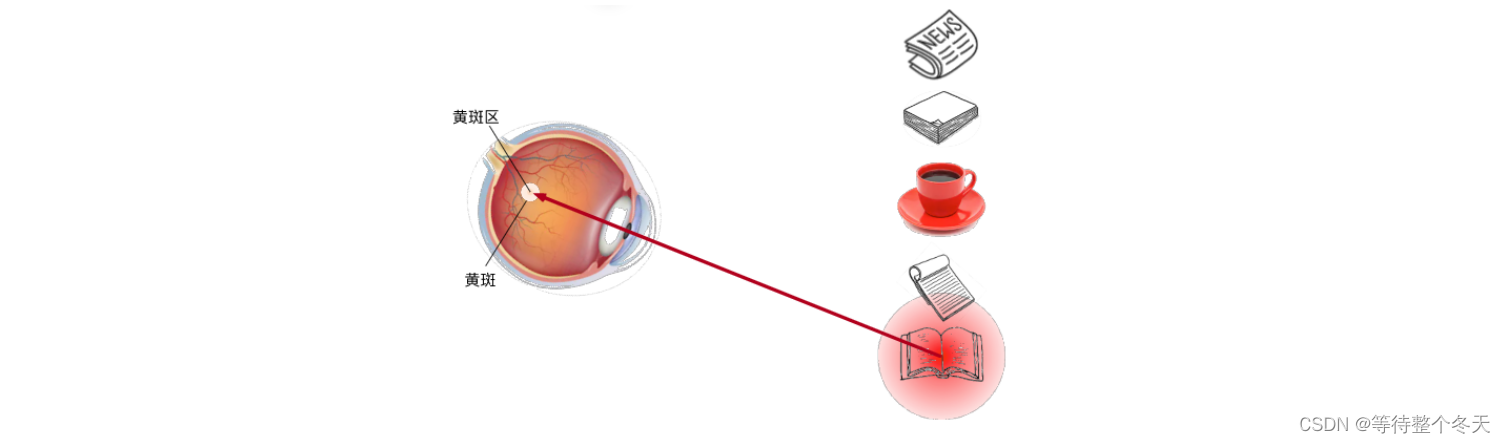

自主性提示:喝咖啡后,你觉得精力旺盛,想要看一本书。此时你的目光主动搜索并且聚集到了书上,如下图。与非自主性提示不同,此时选择书是受到了认知和意识的控制, 因此注意力在基于自主性提示去辅助选择时将更为谨慎。 受试者的主观意愿推动,选择的力量也就更强大。

2.查询、键和值

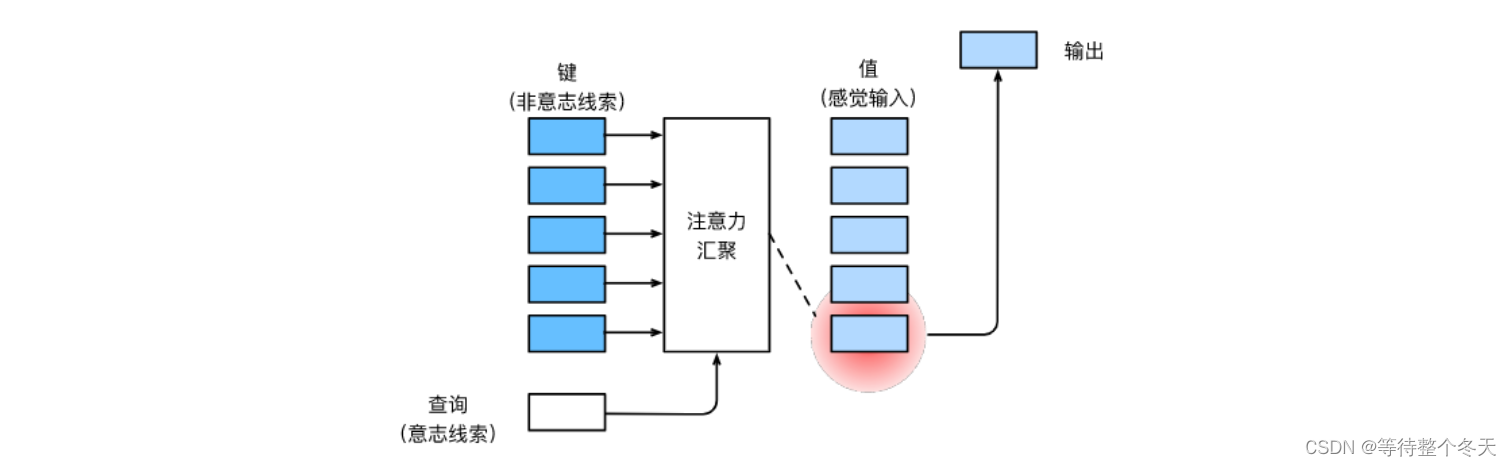

自主性的与非自主性的注意力提示解释了人类的注意力的方式, 下面通过这两种注意力提示用神经网络来设计注意力机制的框架。

卷积、全连接、池化层基本只考虑非自主性提示,选择都偏向于感官输入,以池化为例:池化只考虑把窗口中最大的值抽取出来,只要是最大的值就行。

在注意力机制的背景下,将自主性提示称为查询(query)。 给定任何查询,注意力机制通过注意力池化(attention pooling) 将选择引导至感官输入(sensory inputs,例如中间特征表示)。 在注意力机制中,这些感官输入被称为值(value) ,更通俗的解释每个值都与一个键(key)配对, 即感官输入的每个非自主提示都与一个值(value)匹配,注意力机制通过查询选择出我们需要的key-value。

如下图所示可以设计注意力池化, 以便给定的查询(自主性提示)可以与键(非自主性提示)进行匹配, 这将引导得出最匹配的值(感官输入)。

二、 注意力汇聚:Nadaraya-Watson 核回归

考虑一个回归问题:给定的成对的“输入-输出”数据集{(x1,y1),…,(xn,yn)},如何学习f来预测任意新输入x的输出y ^ = f ( x ) ?

根据下面的非线性函数来生成一个数据集,加入的噪声项为ϵ,其中ϵ 服从均值为0标准差为0.5 的正态分布

yi=2sin(xi)+xi**0.8+ϵ

1.平均池化(汇聚)

基于平均汇聚来计算所有训练样本输出值的平均值:

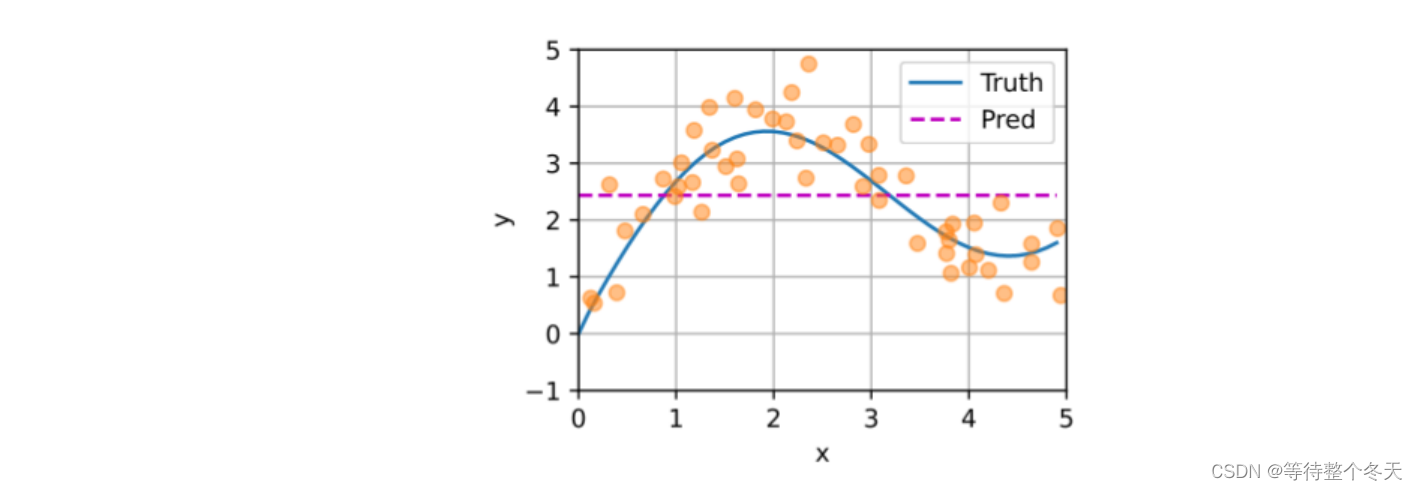

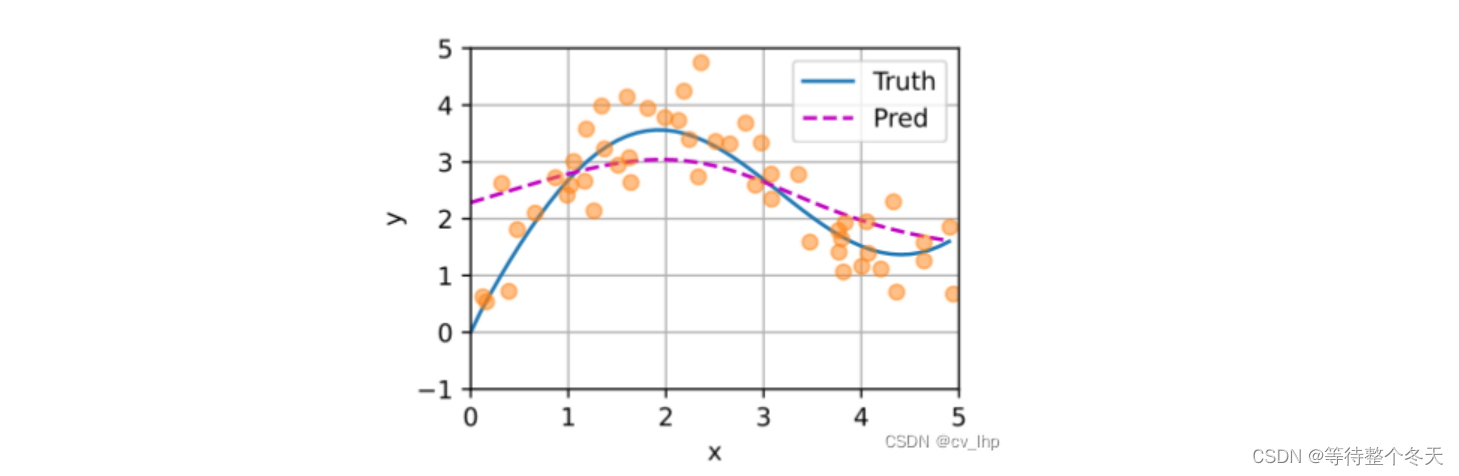

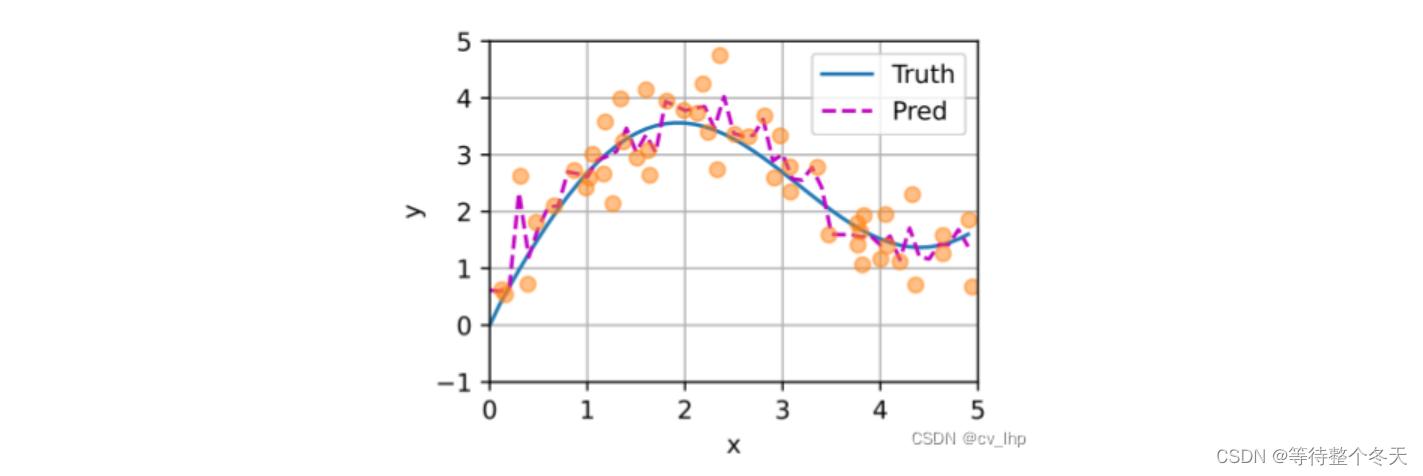

如下图所示:黄色的点为随机生成50个带噪(xi,yi)样本,蓝色线Truth为不带噪声项ϵ的真实函数曲线,紫色线Pred为带噪样本yi经过平均池化后,学习得到的预测函数曲线,可以看到预测函数和真实函数差距较大

2.非参数注意力池化(汇聚)

平均池化忽略了输入xi,更好的方法是根据输入的位置对输出yi进行加权,下式称为Nadaraya-Watson核回归:

K是(核kernel)衡量x(查询)与xi(候选物)距离的函数,将距离归一化作为权重,表示xi的相对重要性。将权重乘以yi求和,即可选择出跟查询x相近的(xi,yi)。

受此启发我们可以从注意力机制框架的角度重写Nadaraya-Watson核回归公式,成为一个更加通用的注意力汇聚(attention pooling)公式:

其中x是查询,(xi,yi)是键值对,注意力汇聚是yi的加权平均,将查询x核键xi之间的关系建模为注意力权重(attention weight)α (x ,xi) ,这个权重将分配给每一个对应值yi.对于任何查询,模型在所有键值对注意力权重都是一个有效的概率分布:他们是非负的,并且总和为1

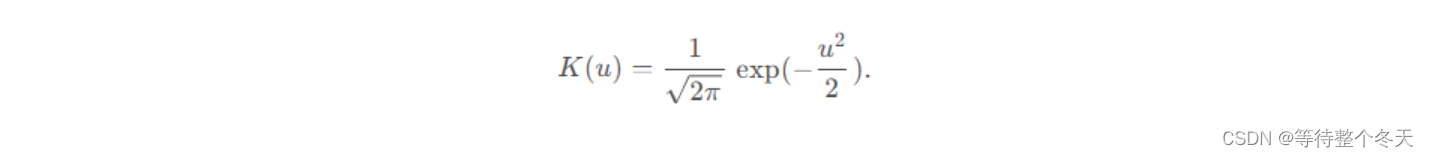

为了更好地理解注意力汇聚,考虑一个高斯核(Gaussian kernel),其定义为:

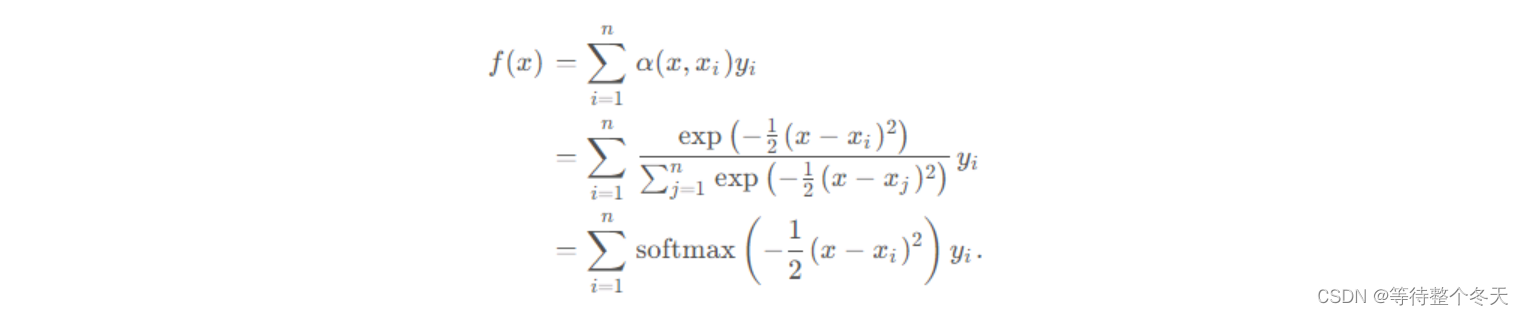

将高斯核代入Nadaraya-Watson核回归公式可以得到:

**如果一个键xi越是接近给定的查询x,那么分配给这个键对应值yi的注意力权重就会越大,也就获得了更多注意力。**注意:Nadaraya-Watson核回归是一个非参数的注意力汇聚。

由下图可知,根据注意力汇聚模型绘制的预测函数更加接近真实的函数。

3.带参数注意力池化(汇聚)

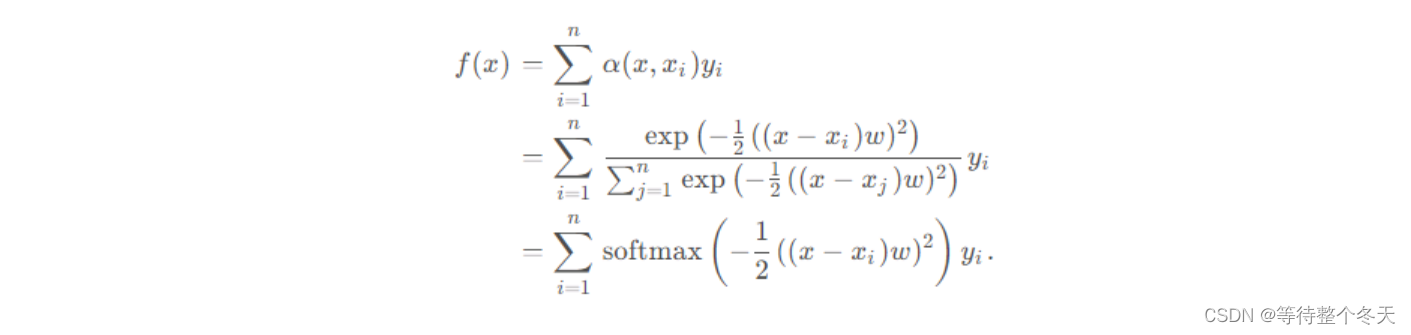

非参数的Nadaraya-Watson核回归具有一致性(consistency)的优点:如果有足够的数据,此模型会收敛到最优结果。但是我们也可以将可学习的参数集成到注意力汇聚中,如下面公式。

在下面的查询x和键xi之间的距离乘以可学习参数w:

经过训练得到更加贴合的曲线:

转载修改自

https://blog.csdn.net/flyingluohaipeng/article/details/125734409

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)