交叉熵损失函数--轻松了解

目录

交叉熵损失函数是一种常用的分类问题的损失函数,在深度学习中应用广泛。本文将对交叉熵损失函数进行介绍及其原理。

一、描述

交叉熵损失函数(Cross-Entropy Loss)是在机器学习和深度学习中常用的一种损失函数,用于衡量模型输出与真实标签之间的差异。交叉熵损失函数通常用于分类任务,特别是在多类别分类问题中。

二、定义与公式

公式一:

L(x)=−log(p(x))

p(x)为概率,取值范围为(0,1),所以L(x) = oo > -log(p(x)) > 0 (大于0小于正无穷)

-log(p(x))可以表示当结果概率p(x)越大时,L(x)损失值越小

定义:

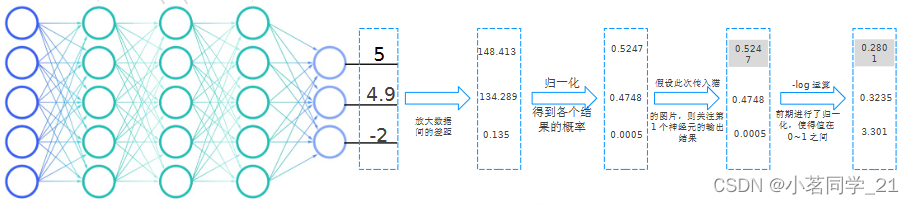

假设第一个输出神经元是猫,第二个是小狗,第三个是小鸟

1.我们传入猫的照片得到三份数据(输出层有三个神经元)

2.将数据进行放大(放大数据间的差距)

3.归一化,用来得到各个结果的概率

(因为我们传入的是猫的照片,而第一个输出神经元是猫,所以我们关注第一个神经元输出结果)

4.利用公式对三个输出结果概率进行 -log 运算(比较)

如果传入猫照片,猫的神经元输出数值相比其他越大,

计算的损失值会越小,也表明越靠近真实结果。

如果训练时,类别分错了,则会出现大的损失值

公式二:

-M —— 类别的数量

- —— 符号函数(0或1),如果样本 i 的真实类别等于c取1,否则取0

- —— 观测样本 i 属于类别 c 的预测概率

定义

1.先将所得到的损失值累加起来,如果传入的数据与样本类别相同,取1,否则取0,这样我 们就把符合样本的损失值累加起来了

2.如果传入多个样本,就将多个样本损失值数据累加起来,在除以样本数即可

三、优缺点

优点:

1.能够直接衡量模型预测和真实标签之间的差异,有效解决梯度消失问题

2.符合最大似然估计原理,并在多类别分类问题中表现良好。

缺点:

1.对极端预测值敏感,数值不稳定,并且不适用于回归问题或其他类型的任务。

2.在处理极端概率和数值不稳定性时,可能需要进行额外的处理。

3.对于其他任务类型,需要选择适当的损失函数。

更多推荐

已为社区贡献36条内容

已为社区贡献36条内容

所有评论(0)