将transformers模型保存到本地及加载本地模型与创建CLIPProcessor实例

由于网络宽带速度不一,所以想着把transformers模型保存到本地,并实现本地加载。

一键AI生成摘要,助你高效阅读

问答

·

一、前言

由于网络宽带速度不一,所以想着把transformers模型保存到本地,并实现本地加载

二、代码

1、下载模型,保存到本地

import torch

from transformers import AutoTokenizer, AutoModel

from transformers import CLIPProcessor, CLIPModel

# 指定预训练模型的名称或路径

model_name = "openai/clip-vit-base-patch16"

# 使用AutoModel和AutoTokenizer下载和加载模型及分词器

model = AutoModel.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name)

# 保存模型权重和分词器到本地

output_folder = "/root/model" # 替换为您想要保存的文件夹路径

model.save_pretrained(output_folder)

tokenizer.save_pretrained(output_folder)2、文件示例:

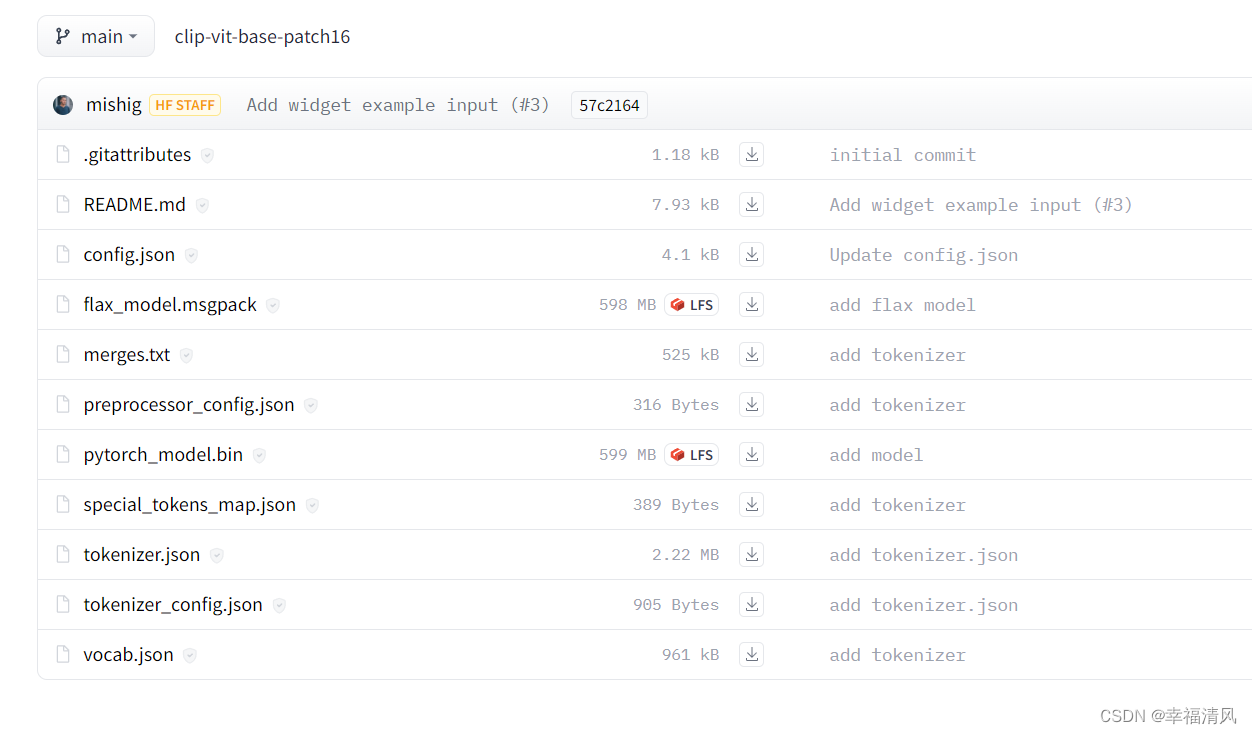

3、 手动下载网址:

openai/clip-vit-base-patch16 at main

4、本地调用模型与创建CLIPProcessor实例:

import torch

from transformers import CLIPProcessor, CLIPModel

# 从本地路径加载模型

clip_model = torch.load(output_folder)

print(clip_model)

# 创建CLIPProcessor实例

clip_processor = CLIPProcessor.from_pretrained(output_folder)

print(clip_processor)

注意:transformers库需要最新版,否则会出现问题。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)