win10+vs2017+opencv4.5.0+opencv_contrib-4.5.0+cuda源码编译详细教程

大家第一次安装opencv的时候一定要一定要一定要认真看一遍教程,很多错误是自己不认真仔细导致的,特别看安装过程的注意事项,等一定了解和熟练后再总结一套自己的教程,这样对自己以后安装东西有很大的帮助本人github准备工具cmake、vs2017、opencv4.5.0、opencv_contrib-4.5.0、cuda、cudnn一、下载安装cuda、cudn参考链接:https://blog.

大家第一次安装opencv的时候一定要一定要一定要认真看一遍教程,很多错误是自己不认真仔细导致的,特别看安装过程的注意事项,等一定了解和熟练后再总结一套自己的教程,这样对自己以后安装东西有很大的帮助

准备工具

cmake、vs2017、opencv4.5.0、opencv_contrib-4.5.0、cuda、cudnn

一、下载安装cuda、cudn

参考链接:windows10+nvidia驱动+cuda10.1+cudnn安装教程_Bubble_water的博客-CSDN博客

二、安装cmake

官方地址Download | CMake

下载安装cmake-3.13.2-win64-x64.msi,默认安装。

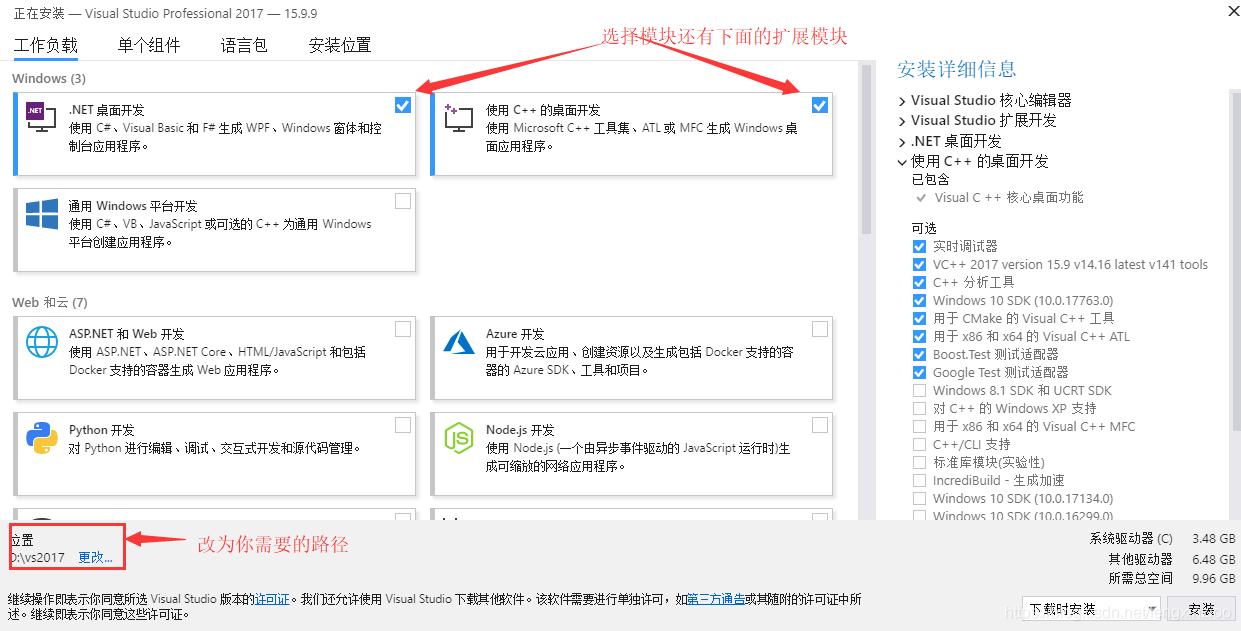

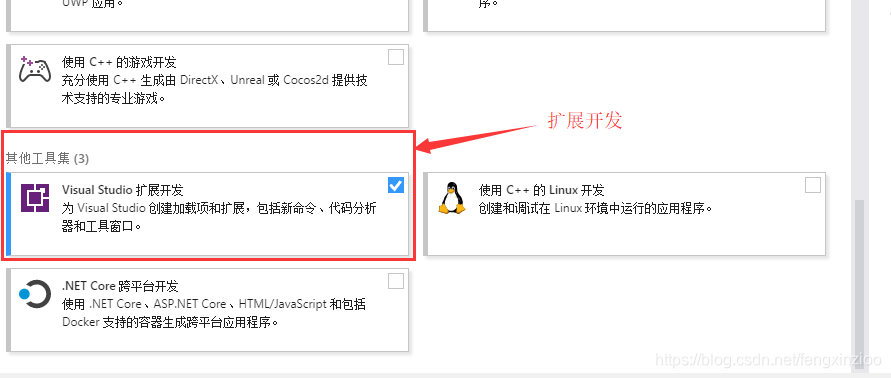

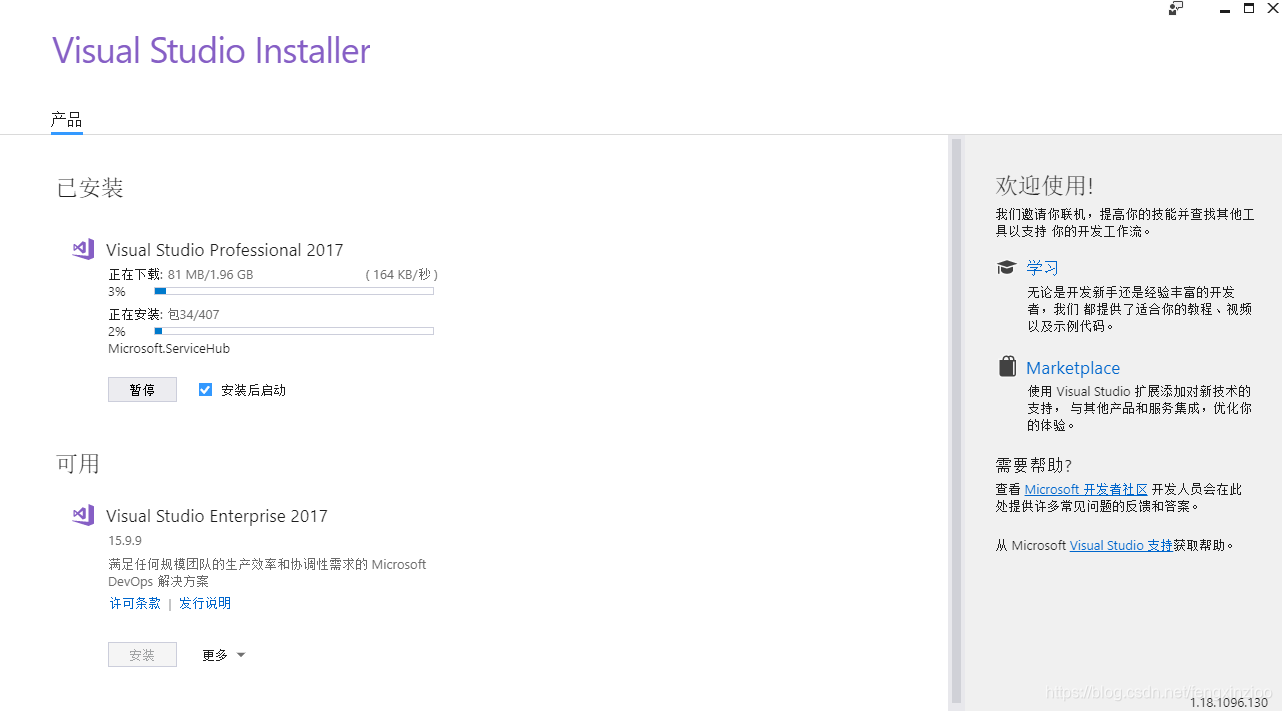

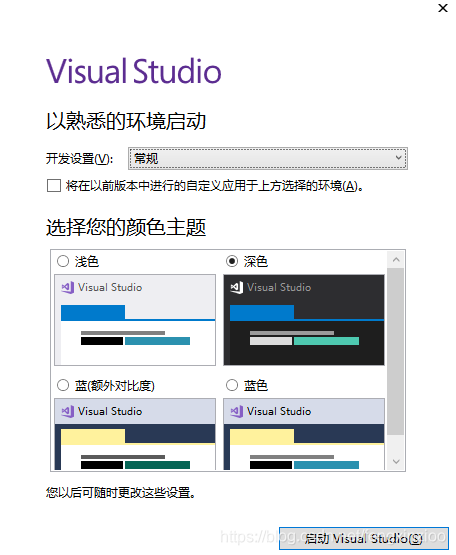

三、安装VS2017

这里直接在微软官网下载即可。链接: Visual Studio 2017 15.9 Release Notes | Microsoft Learn

其中三个版本都可以选,Community 2017是免费社区版本,Professional 2017和Enterprise 2017是付费版,功能好像没有区别,我这里选择的是Professional版本。

付费版可以使用密匙激活,这里提供两个密匙,如果不能用了就网上找,很多的:

Professional 2017:KBJFW-NXHK6-W4WJM-CRMQB-G3CDH

Enterprise 2017:NJVYC-BMHX2-G77MM-4XJMR-6Q8QF

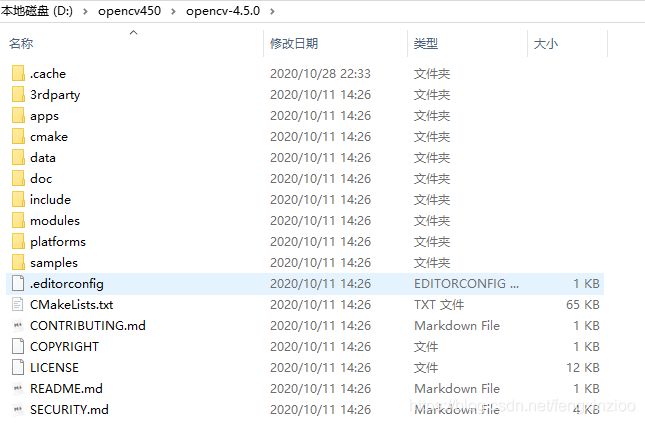

四、opencv_contrib下载安装

1、下载链接: Releases · opencv/opencv_contrib · GitHub.

2、选择你的opencv对应的contrib版本,例如我装的是opencv4.5.0,对应就下载opencv_contrib-4.5.0.zip。下载完成之后直接解压即可,留着cmake使用。

opencv_contrib-4.5.0.zip解压完如下图:

五、提取opencv4.5.0

1、Opencv官网:https://opencv.org/releases.html

2、下载后将opencv-4.5.0.zip解压

六、 CMake 编译

windows安装opencv4.1.1过程中ffmpeg、ippicv、face_landmark_model下载出错解决办法:windows安装opencv4.1.1过程中ffmpeg、ippicv、face_landmark_model下载出错解决办法_landmark安装出错_Bubble_water的博客-CSDN博客

或者第一次cmake的configure之后,在where is build the binaries位置里面有个CMakeDownloadLog.txt,将里面下载链接复制到浏览器或者迅雷中进行下载,将其和where is the source code里面的.cache文件夹里面内容相对应,可以把这篇教程后面第一个百度网盘里面的.cache.rar压缩包解压放到opencv源码文件夹中就可以了。

1、打开CMake,下图第一个红框输入Opencv(我的是opencv4.5.0)的sources目录(注意:不是opencv_contrib的目录,原来自己opencv的目录);第一个红框输入你自定义的输出目录。where is build the binaries那个位置是你编译opencv保存的文件夹位置,按照自己情况进行选择,最后点左下角的Configure

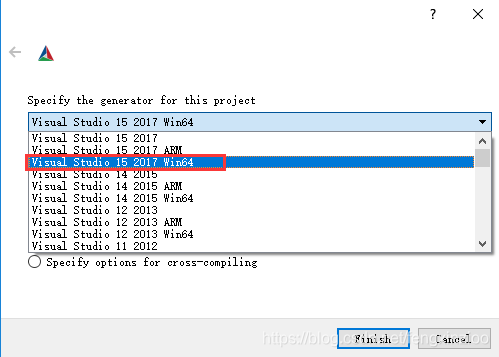

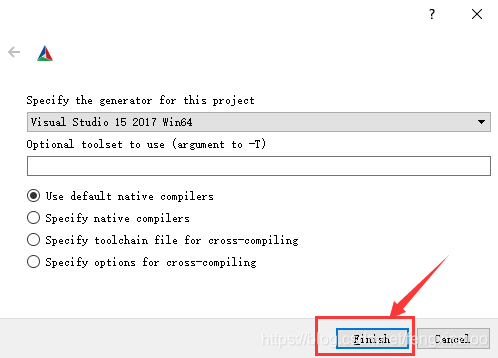

2、选择对应vs的版本,64位系统选择Win64,默认的是Win32。

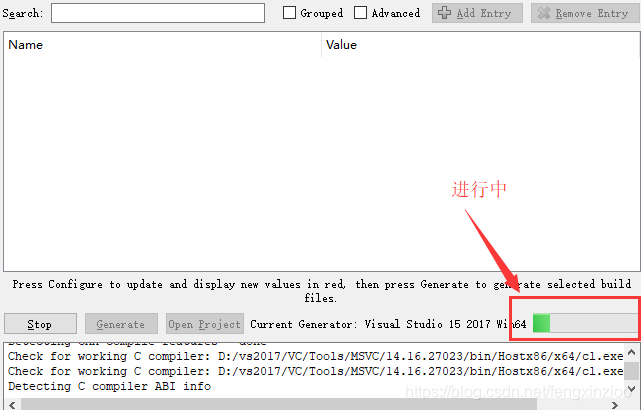

3、然后就是等待了。之后显示Configuring done第一次源码配置就完成了。

选择OPENCV_EXTRA_MODULES_RATH一项,添加你刚刚解压的opencv_contrib中的modules目录,其中要把OPENCV_ENABLE_NONFREE(下图红框上面一行)选上。

注意路径不要复制,需要通过cmake来选择路径!

将build_opencv_world选上,将所有opencv的库都编译在一起不需要自己一一添加每个小模块,利于移植算法的时候遗忘一些库。

再次单击 Configure,完成后将cuda_arch_bin即显卡的算力内容改成自己显卡的算力,如下图所示

查看自己N卡显卡算力网址:CUDA GPUs - Compute Capability | NVIDIA Developer

再次单击 Configure完成后,点击generate,之后会提示generating done,说明cmake编译成功了。点击open project进行编译部分了。

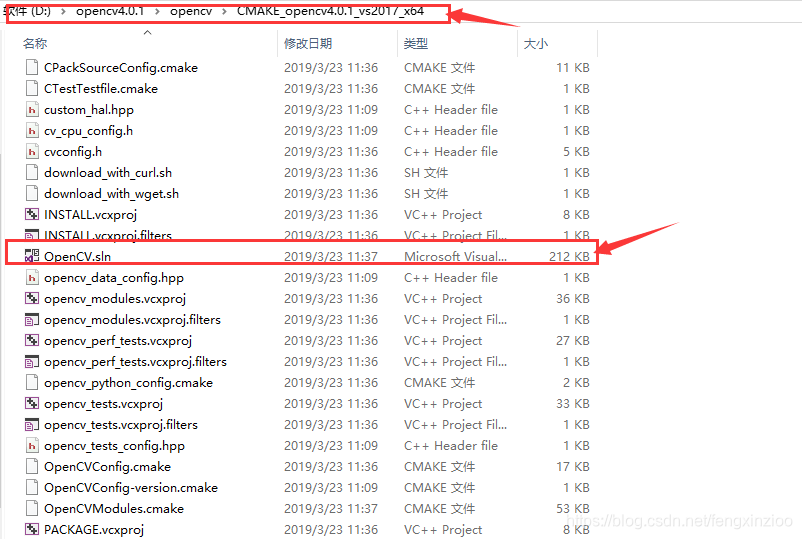

或者完成之后在你的输出文件夹中找到OpenCV.sln文件进行编译。

七、 VS2017 编译

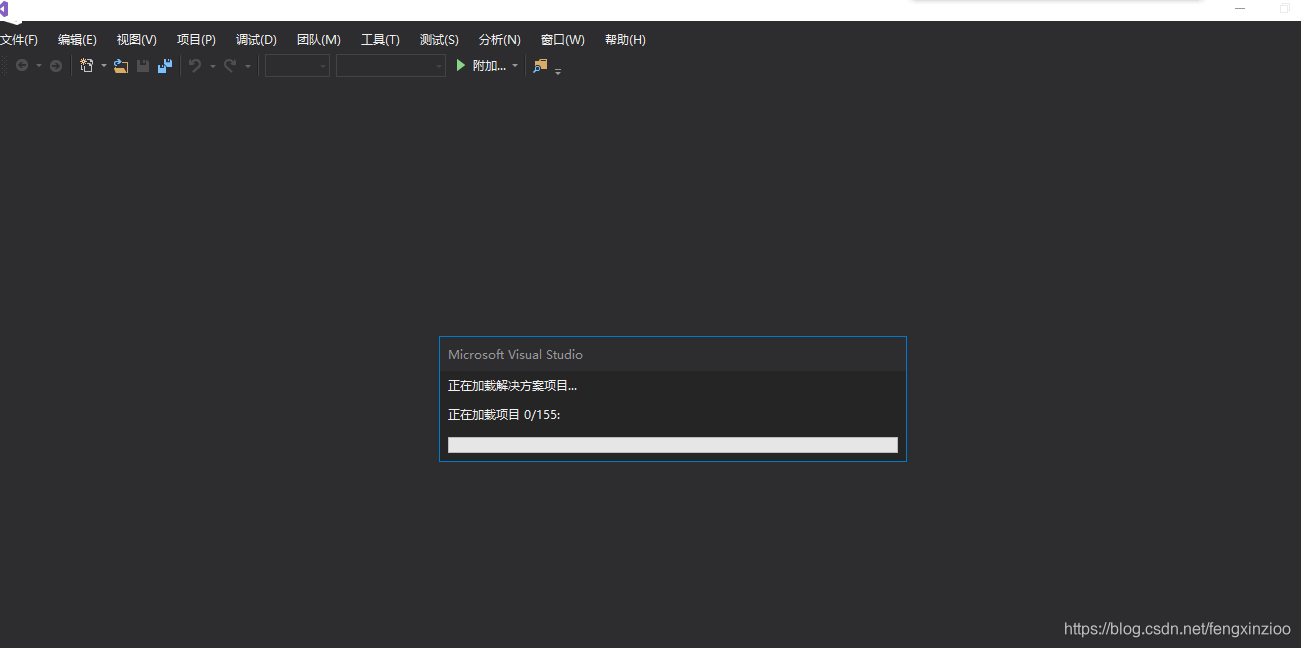

1、使用VS2017打开刚刚编译工程后,会反应一段时间如下图所示:

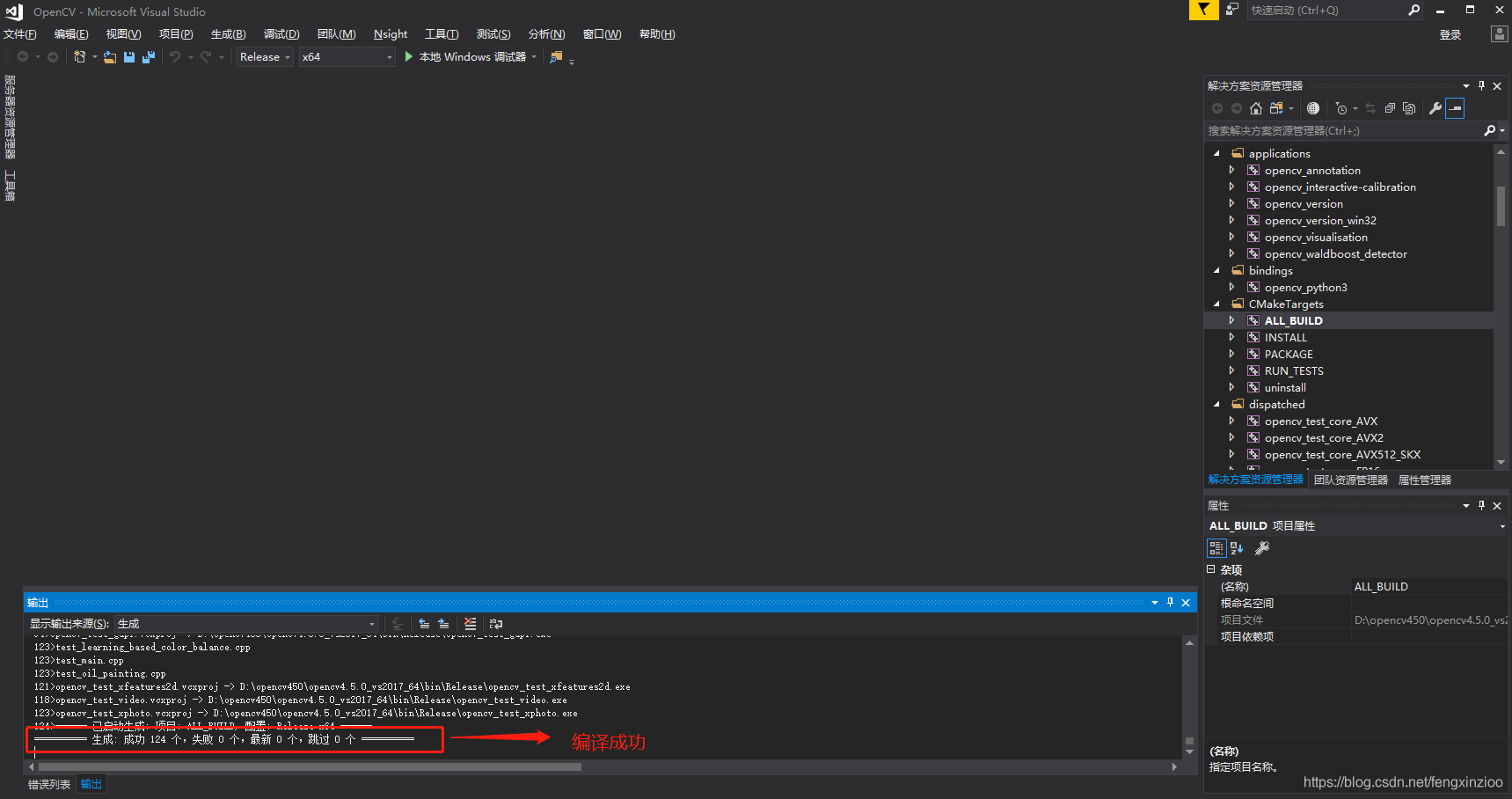

2、然后如图所示点击ALL_BUILD-->生成,这得等一段时间 ,如下图所示

3、完成后,如下图所示:

4、“解决方案资源管理器—>CMakeTargets—>INSTALL—>生成”然后又是等好一会儿

完成后

5、最后到自定义的文件夹确认一下,找到install文件夹,进去查看里面的内容(如下图,注:对于后边配置环境,install文件夹作用就像配置opencv4.5.0时的build文件夹一样):

八、 环境配置

1、 环境变量配置

- 右键电脑【属性】

- 【高级系统设置】

- 【环境变量】

- 【系统变量】【Path】

编译目录“ D:\opencv450\opencv4.5.0_vs2017_64\install\x64\vc15\bin” 的完整路径 (如下图),根据你自己Cmake时的路径进行修改。 - 环境变量配置好后,一定要重启系统!!!!

2、配置相关目录

1、打开VS2017新建一个空项目 输入名字,选择生成文件夹,然后选择“空项目”,直接确定就可以了。

确定之后就直接进到这个界面,先将Debug的X86改成release X64

然后找到属性管理器 ,如下图所示:

创建属性表,如下图所示

将属性表进行命名,根据你容易记住的命名风格来。

打开刚才建好的属性表

2、include目录

双击属性表,在通用属性—>VC++目录—>包含目录中添加:

D:\opencv450\opencv4.5.0_vs2017_64\install\include

D:\opencv450\opencv4.5.0_vs2017_64\install\include

根据你的路径进行修改

没有了以前的“…opencv4.5.0\build\include\opencv”这一条。

3、然后是添加lib目录,在通用属性—>VC++目录—>库目录中添加:

4、在通用属性—>链接器—>输入—>附加的依赖项中添加opencv_world450.lib(这个是cmake的时候编译成world格式的):

其他版本按照自己的版本号更改数字“450”为自己对应的版本即可(450意为4.5.0版本的release模式,debug模式会带有d)。

译好的opencv dll和lib库百度网盘:

链接:https://pan.baidu.com/s/1pA5zwH2WK5hhaAdJkQmJLg

提取码:t8vw

九、opencv dnn调用yolov4-tiny模型,推理使用cuda加速程序验证

验证代码如下:

#include <iostream>

#include <queue>

#include <iterator>

#include <sstream>

#include <fstream>

#include <iomanip>

#include <chrono>

#include <opencv2/core.hpp>

#include <opencv2/dnn.hpp>

#include <opencv2/dnn/all_layers.hpp>

#include <opencv2/imgproc.hpp>

#include <opencv2/highgui.hpp>

constexpr float CONFIDENCE_THRESHOLD = 0;

constexpr float NMS_THRESHOLD = 0.4;

constexpr int NUM_CLASSES = 80;

// colors for bounding boxes

const cv::Scalar colors[] = {

{0, 255, 255},

{255, 255, 0},

{0, 255, 0},

{255, 0, 0}

};

const auto NUM_COLORS = sizeof(colors) / sizeof(colors[0]);

int main()

{

std::vector<std::string> class_names;

{

std::ifstream class_file("yolo/coco.names");

if (!class_file)

{

std::cerr << "failed to open classes.txt\n";

return 0;

}

std::string line;

while (std::getline(class_file, line))

class_names.push_back(line);

}

cv::VideoCapture source("yolo_test.mp4");

auto net = cv::dnn::readNetFromDarknet("yolo/yolov4-tiny.cfg", "yolo/yolov4-tiny.weights");

net.setPreferableBackend(cv::dnn::DNN_BACKEND_CUDA);

net.setPreferableTarget(cv::dnn::DNN_TARGET_CUDA);

//net.setPreferableBackend(cv::dnn::DNN_BACKEND_OPENCV);

//net.setPreferableTarget(cv::dnn::DNN_TARGET_CPU);

auto output_names = net.getUnconnectedOutLayersNames();

cv::Mat frame, blob;

std::vector<cv::Mat> detections;

while (cv::waitKey(1) < 1)

{

source >> frame;

if (frame.empty())

{

cv::waitKey();

break;

}

auto total_start = std::chrono::steady_clock::now();

cv::dnn::blobFromImage(frame, blob, 0.00392, cv::Size(416, 416), cv::Scalar(), true, false, CV_32F);

net.setInput(blob);

auto dnn_start = std::chrono::steady_clock::now();

net.forward(detections, output_names);

auto dnn_end = std::chrono::steady_clock::now();

std::vector<int> indices[NUM_CLASSES];

std::vector<cv::Rect> boxes[NUM_CLASSES];

std::vector<float> scores[NUM_CLASSES];

for (auto& output : detections)

{

const auto num_boxes = output.rows;

for (int i = 0; i < num_boxes; i++)

{

auto x = output.at<float>(i, 0) * frame.cols;

auto y = output.at<float>(i, 1) * frame.rows;

auto width = output.at<float>(i, 2) * frame.cols;

auto height = output.at<float>(i, 3) * frame.rows;

cv::Rect rect(x - width / 2, y - height / 2, width, height);

for (int c = 0; c < NUM_CLASSES; c++)

{

auto confidence = *output.ptr<float>(i, 5 + c);

if (confidence >= CONFIDENCE_THRESHOLD)

{

boxes[c].push_back(rect);

scores[c].push_back(confidence);

}

}

}

}

for (int c = 0; c < NUM_CLASSES; c++)

cv::dnn::NMSBoxes(boxes[c], scores[c], 0.0, NMS_THRESHOLD, indices[c]);

for (int c = 0; c < NUM_CLASSES; c++)

{

for (size_t i = 0; i < indices[c].size(); ++i)

{

const auto color = colors[c % NUM_COLORS];

auto idx = indices[c][i];

const auto& rect = boxes[c][idx];

cv::rectangle(frame, cv::Point(rect.x, rect.y), cv::Point(rect.x + rect.width, rect.y + rect.height), color, 3);

std::ostringstream label_ss;

label_ss << class_names[c] << ": " << std::fixed << std::setprecision(2) << scores[c][idx];

auto label = label_ss.str();

int baseline;

auto label_bg_sz = cv::getTextSize(label.c_str(), cv::FONT_HERSHEY_COMPLEX_SMALL, 1, 1, &baseline);

cv::rectangle(frame, cv::Point(rect.x, rect.y - label_bg_sz.height - baseline - 10), cv::Point(rect.x + label_bg_sz.width, rect.y), color, cv::FILLED);

cv::putText(frame, label.c_str(), cv::Point(rect.x, rect.y - baseline - 5), cv::FONT_HERSHEY_COMPLEX_SMALL, 1, cv::Scalar(0, 0, 0));

}

}

auto total_end = std::chrono::steady_clock::now();

float inference_fps = 1000.0 / std::chrono::duration_cast<std::chrono::milliseconds>(dnn_end - dnn_start).count();

float total_fps = 1000.0 / std::chrono::duration_cast<std::chrono::milliseconds>(total_end - total_start).count();

std::ostringstream stats_ss;

stats_ss << std::fixed << std::setprecision(2);

stats_ss << "Inference FPS: " << inference_fps << ", Total FPS: " << total_fps;

auto stats = stats_ss.str();

int baseline;

auto stats_bg_sz = cv::getTextSize(stats.c_str(), cv::FONT_HERSHEY_COMPLEX_SMALL, 1, 1, &baseline);

cv::rectangle(frame, cv::Point(0, 0), cv::Point(stats_bg_sz.width, stats_bg_sz.height + 10), cv::Scalar(0, 0, 0), cv::FILLED);

cv::putText(frame, stats.c_str(), cv::Point(0, stats_bg_sz.height + 5), cv::FONT_HERSHEY_COMPLEX_SMALL, 1, cv::Scalar(255, 255, 255));

cv::namedWindow("output");

cv::imshow("output", frame);

}

return 0;

}结果图:

代码我已经上传到百度云了

链接:https://pan.baidu.com/s/1bAPlwkLAYdww7KqKoqZvnQ

提取码:cexy

里面包含了c++和python调用的cuda dnn的案例代码,下载的cache缓存和opencv450的cuda10.1版本编译好的opencv库

参考:

- https://gist.github.com/YashasSamaga/e2b19a6807a13046e399f4bc3cca3a49

- opencv4.2.0 源码编译,win7+VS2015,DNN模块支持cuda加速_蜡笔小心点的博客-CSDN博客

- https://my.oschina.net/u/4342169/blog/4479397

- OpenCV: Install OpenCV-Python in Windows

- 1.2. 在Windows中安装OpenCV Python — OpenCV-Python Tutorials 1 文档

- VS2017配置OpenCV4.0(Win10环境)_有关人士的博客-CSDN博客

- win10 + vs2017 + opencv4.0.0rc + contrib扩展库 配置_zjywell的博客-CSDN博客

- 【Win10】【VS2017】Opencv4配置contrib扩展_有关人士的博客-CSDN博客

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)