简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

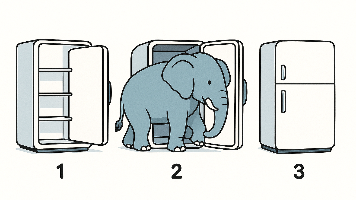

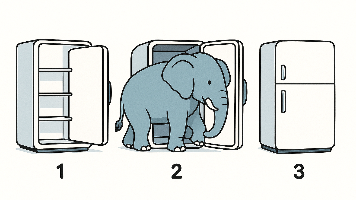

将大象装进冰箱里需要几步?- Edge AI模组的部署

本文详细介绍了将视频处理大模型部署到边缘设备GPU/NPU的技术流程和资源评估方法。部署过程分为需求与硬件选型、模型分析与预评估、模型优化与转换、跨平台验证与性能调优、集成与部署五个阶段。关键评估指标包括算力与吞吐、延迟与实时性、内存占用与带宽、功耗与热设计、精度与可接受降级等。文章以ONNX模型在NVIDIA Jetson Nano和RK3399Pro NPU上的部署为例,具体说明了模型转换、量

Wi-Fi QoS中AIFSN/CWmin/CWmax/TxOP参数是怎样计算的?

802.11e/WMM的EDCA机制通过AIFS、CWmin/CWmax和TxOP三组参数实现业务优先级控制。AIFS决定最短等待时间(AIFS=SIFS+AIFSN×SlotTime),CWmin/CWmax定义退避范围(2^ECW-1),TxOP设置最大占用时长(32µs单位)。默认配置中,语音业务(VO)优先级最高,其AIFSN最小(2)、CW范围最小(3-7)、TxOP适中(1.504ms

将大象装进冰箱里需要几步?- Edge AI模组的部署

本文详细介绍了将视频处理大模型部署到边缘设备GPU/NPU的技术流程和资源评估方法。部署过程分为需求与硬件选型、模型分析与预评估、模型优化与转换、跨平台验证与性能调优、集成与部署五个阶段。关键评估指标包括算力与吞吐、延迟与实时性、内存占用与带宽、功耗与热设计、精度与可接受降级等。文章以ONNX模型在NVIDIA Jetson Nano和RK3399Pro NPU上的部署为例,具体说明了模型转换、量

到底了