简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

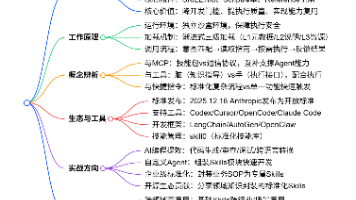

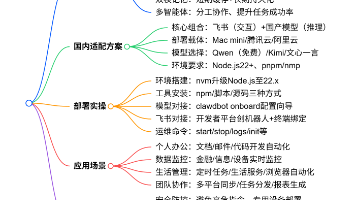

Agent Skills 作为 AI Agent 领域的核心能力扩展机制,从 Claude 的专属功能模块,逐步成为 Codex、Cursor、OpenCode 等主流 AI 编程工具的标配,更是在 2025 年 12 月 18 日由 Anthropic 正式发布为开放标准,与 MCP 一同成为 AI Agent 通用、跨平台发展的重要支撑。它彻底改变了 AI Agent「只会说不会做」的困境,让

OpenClaw 的核心价值,是让 AI 从 “对话工具” 变成 “执行工具”,其本地部署、模型自由、多平台适配的特点,让它在国内有极高的落地价值。通过飞书 + 国产模型的组合,能完美适配国内网络和办公场景,成为个人和小团队的 “智能数字助理”。但同时也要注意,OpenClaw 并非 “万能工具”,99% 的人若未明确其任务边界,易出现使用效率低甚至产生损失的情况。用好它的关键,是先明确哪些任务适

前序剧集提及插件市场雏形,本集大概率聚焦插件生态的 “标准化、可落地、易运营”,提供从插件开发、调试、发布到维护的全生命周期解决方案,降低第三方开发者参与门槛,丰富平台功能生态。插件技术架构定义:plaintext插件开发 API 与权限管控:javascript运行权限精细化管控:插件需在中声明所需权限(如 “本地文件读取”“网络请求”“硬件设备访问”),用户安装时可选择性授权,Electron

作为实操导向的剧集,本集大概率首先讲解开发环境的标准化搭建流程,解决开发者入门阶段的环境兼容、依赖安装等核心痛点,为后续开发奠定基础。基于系列前序剧集对 “高分项目重难点” 的关注,本集大概率会针对实操开发中的高频问题,提供针对性的解决方案,帮助开发者避坑。本集作为实操核心,大概率会聚焦 2-3 个高频核心功能的完整实现流程,展示技术组合的落地细节,让开发者能够直接参考复用。

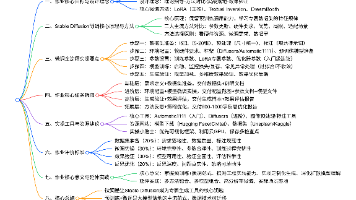

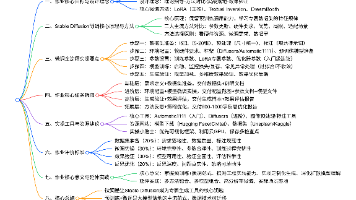

全模态:支持文本、图像、音频、视频的输入与输出,覆盖绝大多数人机交互场景;实时化:响应速度大幅提升,支持实时语音对话、实时视频分析,延迟控制在毫秒级,接近人类自然对话节奏;高效率:推理效率优化,在保持高精度的同时降低计算成本,支持更长上下文、更复杂任务的快速处理。GPT-4o 以多模态融合为核心突破,以实时交互、高效推理为性能支撑,重新定义了大模型的能力边界与应用场景。

本任务为微调的基础准备任务,要求学习者明确个性化微调需求,并完成高质量的数据集准备,锻炼数据处理与方案设计能力。核心要求确定微调需求:自选一个具体的微调场景(如专属风格生成:水彩画 / 油画风格;特定物体生成:专属宠物 / 产品;简单人物生成:卡通形象 / 虚拟人物),需求需具体、可落地;数据集收集与预处理:收集 5-20 张符合需求的样本,完成尺寸统一(512×512/768×768)、格式转换

本任务为微调的基础准备任务,要求学习者明确个性化微调需求,并完成高质量的数据集准备,锻炼数据处理与方案设计能力。核心要求确定微调需求:自选一个具体的微调场景(如专属风格生成:水彩画 / 油画风格;特定物体生成:专属宠物 / 产品;简单人物生成:卡通形象 / 虚拟人物),需求需具体、可落地;数据集收集与预处理:收集 5-20 张符合需求的样本,完成尺寸统一(512×512/768×768)、格式转换

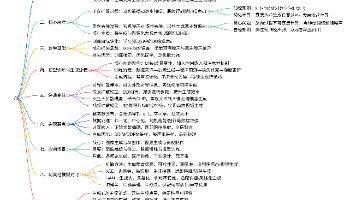

扩散方法以热力学扩散过程为灵感,通过正向加噪和反向去噪的迭代过程,实现了从随机噪声到真实数据的逐步生成,成为当前生成式 AI 领域的主流技术范式。其核心优势在于生成质量高、多样性好、训练稳定,同时能与多模态技术结合实现精准的可控生成,弥补了传统生成模型的诸多短板。从基础的 DDPM 到高效的 DDIM,从可控的引导扩散模型到跨模态的文生图模型,再到动态的视频扩散模型,扩散方法的技术演进始终围绕提升

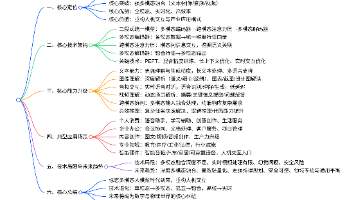

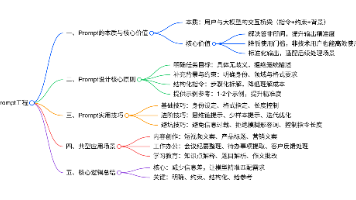

Prompt 工程的核心不是 “复杂的指令”,而是 “让模型精准理解需求”。其本质是通过 “明确目标、补充约束、结构化表达、提供参考”,减少模型与用户之间的信息差,让大模型的能力精准匹配实际场景。无论是普通用户还是技术开发者,掌握 Prompt 设计原则与技巧,都能在不修改模型的前提下,大幅提升大模型的使用效率与输出质量,真正让大模型成为 “高效工具” 而非 “麻烦制造者”。

Electron 的安全机制要求渲染进程(前端)不可直接调用系统资源,需通过。