简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

Dify插件使用教程:基于火山引擎大模型上下文缓存方案的集成与优化

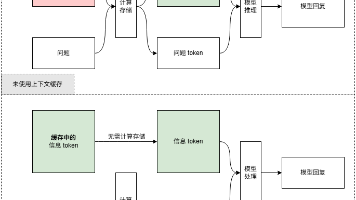

火山引擎大模型插件通过上下文缓存功能显著降低推理成本,测试显示可减少70%的token消耗。支持包括doubao、deepseek等系列模型的Session/前缀缓存模式,需配合Redis记录缓存状态。安装时若遇报错,需调整manifest.yaml文件中的author字段为GitHubID。使用自适应缓存方案时,长提示词缓存效果更佳,在催收场景测试中,笔均token从7714降至2348,效率提

Dify插件使用教程:基于火山引擎大模型上下文缓存方案的集成与优化

火山引擎大模型插件通过上下文缓存功能显著降低推理成本,测试显示可减少70%的token消耗。支持包括doubao、deepseek等系列模型的Session/前缀缓存模式,需配合Redis记录缓存状态。安装时若遇报错,需调整manifest.yaml文件中的author字段为GitHubID。使用自适应缓存方案时,长提示词缓存效果更佳,在催收场景测试中,笔均token从7714降至2348,效率提

Dify插件开发:基于火山引擎大模型上下文缓存方案的集成与优化

文章摘要:针对电话外呼场景中离线质检存在的重复推理、token消耗大等问题,提出采用火山引擎的上下文缓存策略优化流程。通过规则整合、批量处理和智能缓存机制,可减少同一对话文本的重复处理。测试数据显示,在催收场景中应用自适应缓存方案后,能有效节省70%的token消耗,显著降低质检成本。该方案支持多种缓存模式,包括Session缓存和前缀缓存,适用于不同长度的提示词和文本场景,为大规模通话质检提供了

到底了