简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

人形机器人是一种多功能的形态,支持多种机器人任务和应用,包括双手操作[1–3]、双足行走[4–7]和灵活的全身控制[8–14]。尽管这些努力展示了令人印象深刻的成果,每个项目都根据其特定任务和场景使用了不同的全身控制公式。

程序员面试、算法研究、编程艺术、红黑树、机器学习5大经典原创系列集锦与总结作者:July--结构之法算法之道blog之博主。时间:2010年10月-2018年5月,一直在不断更新中..出处:http://blog.csdn.net/v_JULY_v。说明:本博客中部分文章经过不断修改、优化,已集结出版成书《编程之法:面试和算法心得》。前言开博4年有余,...

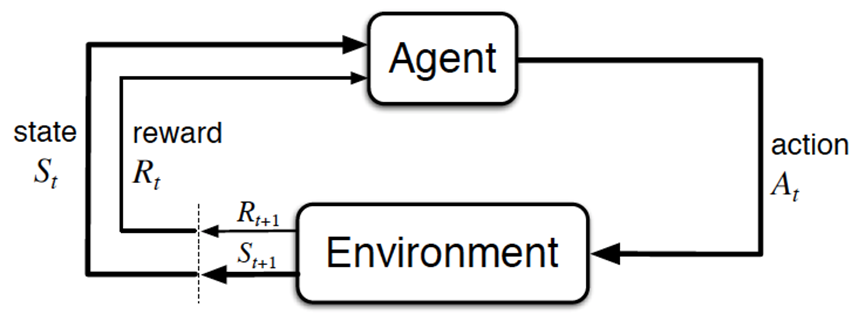

强化学习里面的概念、公式,相比ML/DL特别多,初学者刚学RL时,很容易被接连不断的概念、公式给绕晕,而且经常忘记概念与公式符号表达的一一对应(包括我自己在1.10日之前对好多满是概念/公式的RL书完全看不下去,如今都看得懂了,故如果读文本之前,你正在被RL各种公式困扰,相信看完这篇RL极简入门后就完全不一样了)。

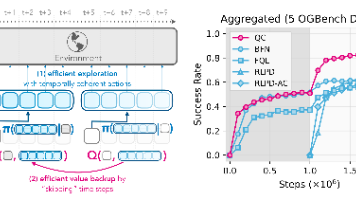

UC伯克利提出Q-chunking方法,通过动作分块改进离线到在线强化学习。该方法在动作序列层面运行RL策略,预测并执行未来h步动作,利用时序差分训练评估器进行无偏的n步价值回传。研究显示,这种方法能加速价值传播、保持无偏估计,同时通过行为约束利用离线数据中的时序连贯动作序列,有效缓解探索难题。相比分层RL,Q-chunking简化了优化过程,在保持探索优势的同时提升了样本效率。相关代码和论文已在

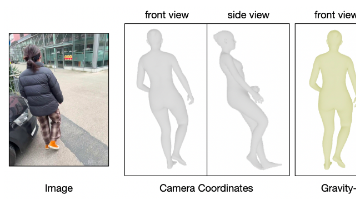

本文系统介绍了三种3D人体姿态估计方法:WHAM、HaMeR和GVHMR。重点阐述了WHAM的架构设计,它通过结合ViTPose检测的2D关键点和图像特征,利用RNN编码运动上下文,实现从视频到SMPL参数的精确估计。文章详细解析了WHAM的两阶段训练策略:先在AMASS数据集预训练,再在真实视频数据上微调。同时介绍了WHAM的创新点,包括全局轨迹解码器设计和接触感知轨迹优化方案,有效解决了脚滑问

AgiBot World Colosseo,这是一个全栈式大规模机器人学习平台,旨在推动可扩展和智能化的体感系统中的双手操作研究。他们建造了一个总面积达4000平方米的设施,涵盖五个主要领域——家庭、零售、工业、餐厅和办公室环境——专用于在真实的日常场景中进行高保真数据收集AgiBot World从100个真实机器人收集了超过100万条轨迹,提供了前所未有的多样性和复杂性。它涵盖了超过100个现实

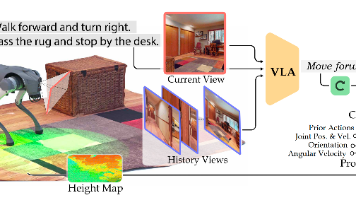

如此前的博客所说,我司「七月在线」正在并行开发多个订单,目前正在全力做好每一个订单,因为保密协议的原因,暂时没法拿出太多细节出来分享但可以持续解读我们所创新改造或的对象,即解读paper和开源库「当然 有些paper/库还没开始用,但也可以提前解读,作为关注了解而其中有一个订单涉及到行走之外的导航、避障,项目组在确定解决方案的过程中,看到了NaVILA这个工作,故本文来解读下。

一个多月前,有朋友曾说,一个月内,π0 会开源来着,当时虽然觉得不太可能,但还是抱着期待可还是没开..没开源必然是有点遗憾,故这两天我一直在考虑、对比,看目前哪个vla最逼近π0,然后借鉴π0的思路,去改造该vla前两天又重点看了下openvla,和cogact,然后对此文增加了不少解读内容,且发现总之,各种vlm + 各种动作预测头/方法,会出来很多vla。

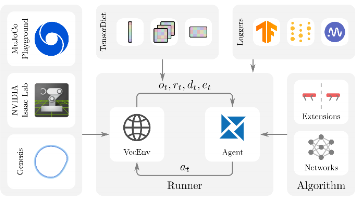

本文介绍了一个强化学习框架rsl_rl,重点解析了其PPO算法的实现。该框架包含Actor-Critic网络(包括普通版、CNN版、历史记忆版和RNN版)、PPO算法实现、训练运行器等核心组件。在PPO实现部分,详细说明了其初始化过程、动作选择、环境交互处理、回报计算和参数更新机制。其中参数更新采用了裁剪优势估计、自适应学习率调整等技术,通过代理损失、价值函数损失和熵奖励三部分构成总损失进行梯度优

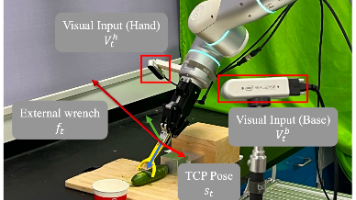

摘要:ForceVLA是一种新型视觉-语言-动作(VLA)模型,通过引入力感知专家混合(MoE)模块,将6D力反馈与视觉语言信息融合,显著提升了机器人在精密插拔等接触密集型任务中的表现。相比现有主要依赖视觉的VLA模型,ForceVLA能动态感知任务各阶段的力变化,实现更精确的物理交互。该模型在π0框架基础上,通过SigLIP视觉语言编码器处理多摄像头输入,并结合本体感知和力觉信息,利用条件流匹配