简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

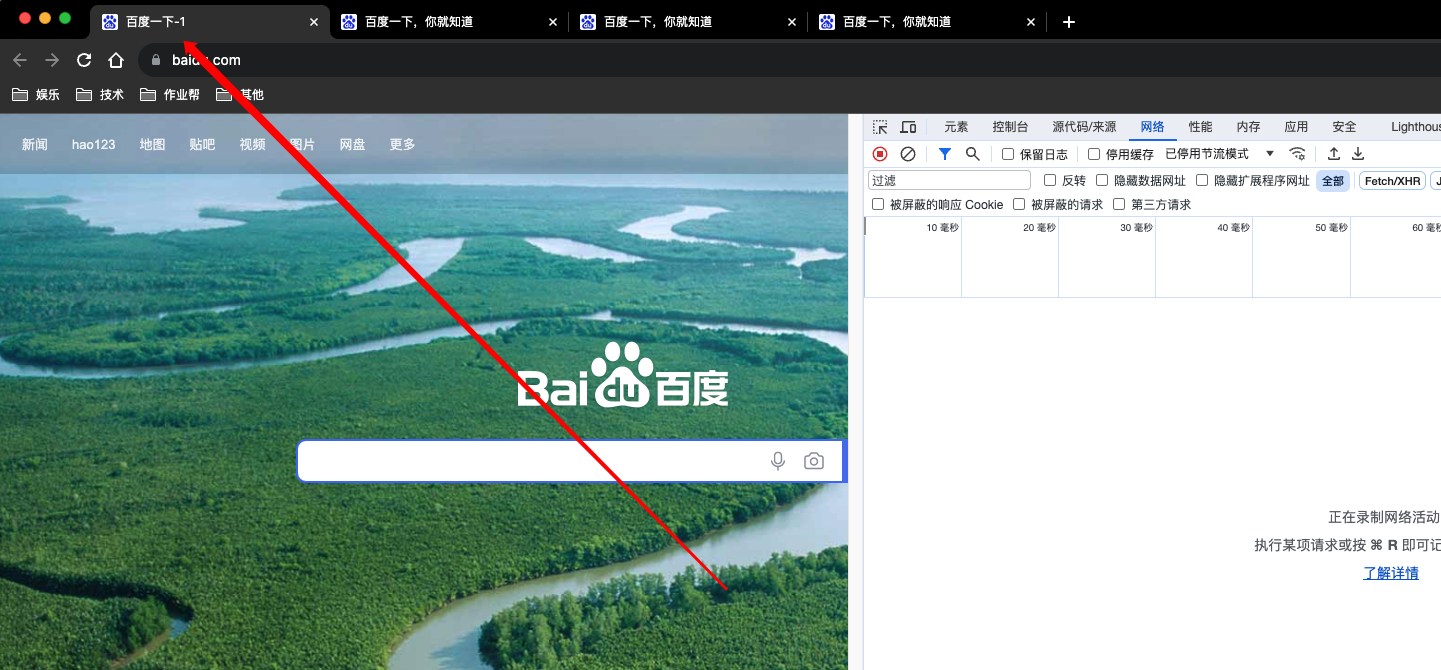

修改谷歌浏览器标签页名字

修改谷歌浏览器标签页名字

IDEA中编写并运行shell脚本

IEDA中的bashsupport插件支持在IDEA中编写shell脚本文件,有友好的代码格式,支持自动补全,检查错误,并且配置完之后,还可以在IEDA中直接运行shell脚本。下面将一步一步演示插件的安装和配置。打开IEDA,安装bashsupport插件安装完之后,保持插件选中并切实enable的状态,如下图所示,然后重启IDEA。...

flink-sql大量使用案例

本文是 flink sql 的一些使用案例,同时也包括了一些特殊用法展示。

flink-sql所有表连接器-1.13

本文基于 flink 官网翻译整理,基于1.13版本,内容十分全面

flink-sql所有表格式format-1.13

本文基于 flink 1.13 官网翻译整理,内容十分全面。

到底了