简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

1 原理《Dropout: A Simple Way to Prevent Neural Networks from Overfitting》在神经网络的训练过程中,对于一次迭代中的某一层神经网络,先随机选中一些神经元并将其临时隐藏(丢弃),然后再进行本次训练和优化。在下一次迭代中,继续随机隐藏一些神经元,如此直至训练结束。由于是随机丢弃,故而每一个mini-batch都在训练不同的网络。在训练时

1 训练的时候 loss 不下降模型结构问题。当模型结构不好、规模小时,模型对数据的拟合能力不足。训练时间问题。不同的模型有不同的计算量,当需要的计算量很大时,耗时也会很大权重初始化问题。常用的初始化方案有全零初始化、正态分布初始化和均匀分布初始化等,合适的初始化方案很重要,之前提到过神经网络初始化为0可能会带来的影响正则化问题。L1、L2以及Dropout是为了防止过拟合的,当训练集loss下不

1 什么是偏差方差在机器学习中,我们用训练数据集去训练一个模型,通常的做法是定义一个误差函数,通过将这个误差的最小化过程,来提高模型的性能。然而我们学习一个模型的目的是为了解决训练数据集这个领域中的一般化问题,单纯地将训练数据集的损失最小化,并不能保证在解决更一般的问题时模型仍然是最优,甚至不能保证模型是可用的。这个训练数据集的损失与一般化的数据集的损失之间的差异就叫做 泛化误差(generali

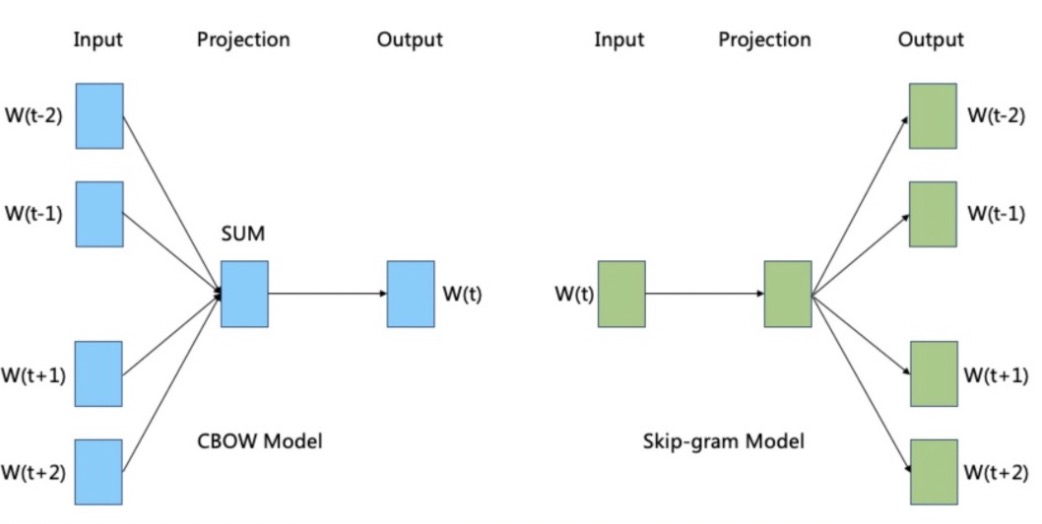

简单来说,Embedding就是用一个低维的向量表示一个物体,可以是一个词,或是一个商品,或是一个电影等等。在传统机器学习模型构建过程中,经常使用one hot encoding对离散特征,特别是ID类特征进行编码,但由于one hot encoding的维度等于特征的总数,比如阿里的商品one hot encoding的维度就至少是千万量级的,而且有的特征还会增量更新,所以这样的编码方式得到的特

核心思想隐语义模型LFM和LSI,LDA,Topic Model其实都属于隐含语义分析技术,是一类概念,他们在本质上是相通的,都是找出潜在的主题或分类。这些技术一开始都是在文本挖掘领域中提出来的,近些年它们也被不断应用到其他领域中,并得到了不错的应用效果。比如,在推荐系统中它能够基于用户的行为对item进行自动聚类,也就是把item划分到不同类别/主题,这些主题/类别可以理解为用户的兴趣。对于..

1 基于内容相似度的推荐注:为尊重大佬,博文第一部分来自:https://blog.csdn.net/qq_32690999/article/details/77434381 ,这篇文章一定要读一下,非常赞!1.1概念基于内容相似度的推荐就是把与你喜欢看的新闻内容相似新闻推荐给你。基于内容的推荐算法的主要优势在于无冷启动问题,只要用户产生了初始的历史数据,就可以开始进行推荐的计算。而且随着用...

0 用到的知识介绍ROC和PR前先介绍混淆矩阵便于理解。-预测值 正预测值 负真实值 正TPFN真实值 负FPTNTP(True Positive): 被判定为正样本,实际也为正样本FN(False Negative):伪阴性 ,被判定为负样本,实际为正样本FP(False Positive):伪阳性,被判断为正样本,实际为负样本TN(True Negative):被判断为负样本,实际为负样本假阳

1 混淆矩阵TP(true positive):表示样本的真实类别为正,最后预测得到的结果也为正;FP(false positive):表示样本的真实类别为负,最后预测得到的结果却为正;FN(false negative):表示样本的真实类别为正,最后预测得到的结果却为负;TN(true negative):表示样本的真实类别为负,最后预测得到的结果也为负.其中,TP与TN表示分类正确...

LDA(Latent Dirichlet Allocation)中文翻译为:潜在狄利克雷分布。LDA主题模型是一种文档生成模型,是一种非监督机器学习技术。它认为一篇文档是有多个主题的,而每个主题又对应着不同的词。一篇文档的构造过程,首先是以一定的概率选择某个主题,然后再在这个主题下以一定的概率选出某一个词,这样就生成了这篇文档的第一个词。不断重复这个过程,就生成了整篇文章(当然这里假定词与词之间是

1 原文点击【原文】即可进行下载2 NFM模型在当今互联网工业界中,有许多预测任务需要用到大量的类别特征。要想将这些类别特征送入到模型中,就必须得将其onehot。但这样一来,就会产生大量的稀疏特征,要想从这些稀疏特征中充分学习到有用的信息,必须要考虑特征之间的相互作用。FM算法是一种常用的解决方案,因为它充分考虑了二阶特征之间的相互作用。然而FM有一个缺点,就是它仅仅以线性的方式组合了特...