简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

开发环境:Unbuntu 18.04 LTS + ROS Melodic + ViSP 3.3.1 本文主要介绍了如何实现Pionner3dx移动机器人视觉伺服仿真,仿真环境是ROS+Gazebo,控制对象是Pioneer3dx(先锋)移动机器人,控制算法借助visp_ros工具实现。视觉伺服控制部分主要参考了visp_ros中的例程tutorial-ros-pioneer-visual-ser

开发环境:Unbuntu 18.04 LTS + ROS Melodic + ViSP 3.3.1文章内容主要参考ViSP官方教学文档:https://visp-doc.inria.fr/doxygen/visp-daily/tutorial_mainpage.html 本文是在前文Visp_ros学习笔记(二):在Gazebo环境下实现Pionner3dx移动机器人视觉伺服仿真的基础上改进而来

开发环境:Ubuntu 18.04 LTS + ROS Melodic + ViSP 3.3.1文章内容主要参考ViSP官方教学文档:https://visp-doc.inria.fr/doxygen/visp-daily/tutorial_mainpage.html 本文主要介绍了如何使用ViSP实现目标检测和定位,实现过程分为两步,第一步在参考图像中检测并提取目标物体表面的关键点,并保存其对

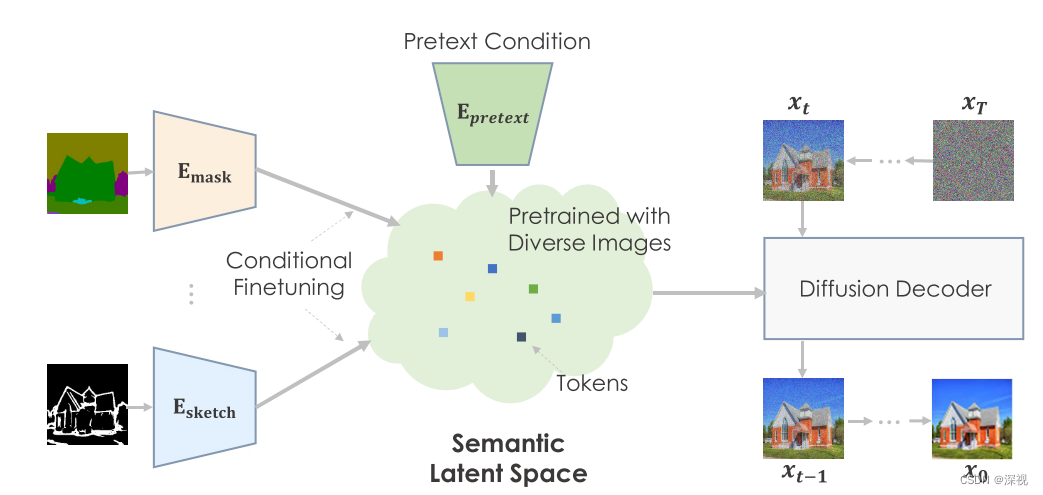

其思想并不复杂,就是借鉴现有视觉和NLP领域中常见的预训练方法,考虑预先在一个大规模的任务无关数据集上对扩散模型进行预训练,使其具备一个高度语义化的空间。然后,再针对特定任务对模型进行微调训练,此时微调过程只需要关注与任务相关的输入信息,而困难的图像生成工作,比如渲染一个合理布局和真实的纹理,将根据预训练时得到的知识来完成。由于扩散模型生成的结果通常分辨率较低,如64*64,因此作者也采用了一个基

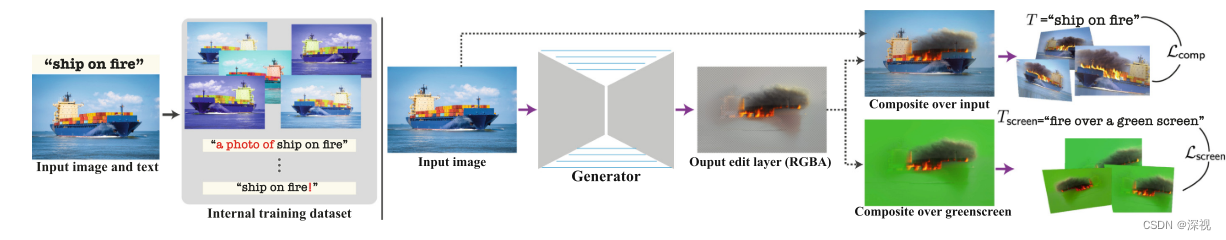

本文提出一种文本驱动的图像和视频编辑方法。与其他方法直接对图像进行编辑的方式不同,本文提出的方法并不是基于扩散模型的,更像是一个自编码器,通过对原图编码解码输出一个新的编辑图层,再与原图进行融合得到编辑后的图像。因此本文提出的方法更多适用于修改图中某个对象的纹理,或者增加一些特效,如火焰、烟雾等,而不能修改物体的动作、布局等等。另一方面,本文将提出的方法应用到了视频的编辑应用中。

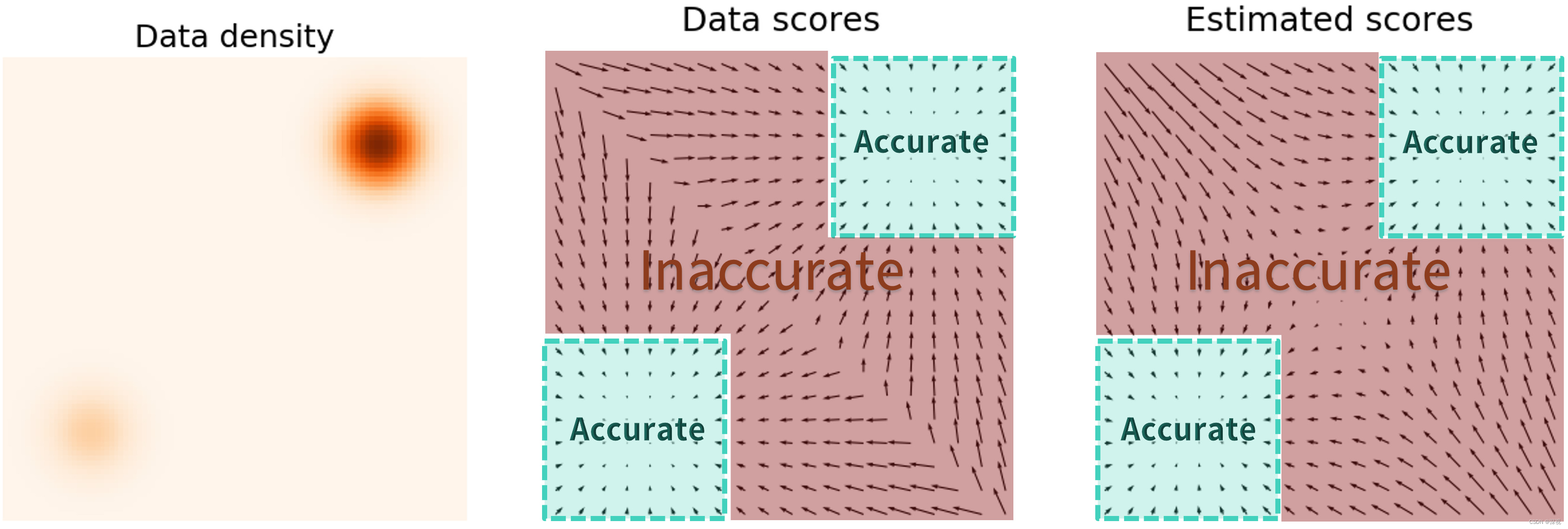

如下图所示,图中黑色的小箭头就表示对数密度函数的梯度,只有绿色区域内的估计结果才可靠,而在占据数据分布的绝大部分区域(红色区域)则是不可靠的,这将导致随机采样的初始样本很难移动到目标分布中。使用不同级别的噪声对原始分布进行干扰对应了DDPM中的扩散过程,训练一个NCSN模型来估计分数对应了DDPM中的噪声估计网络,使用退火朗之万动力学模型来生成目标分布内的样本对应了DDPM的采样过程。随着步数的增

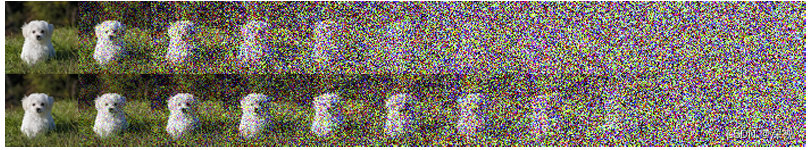

该篇文章《Improved Denoising Diffusion Probabilistic Models》(IDDPM)是对DDPM中存在的问题进行了多方面的改进和试验,显著提升了生成样本的对数似然指标(这是基于似然的图像生成领域最广泛使用的指标之一,表征模型拟合数据分布的能力),使用更少的采样步骤就达到了接近最佳的生成效果。是以线性方式变化的,这样做带来的问题是图像会很快就变成纯噪声,导致后

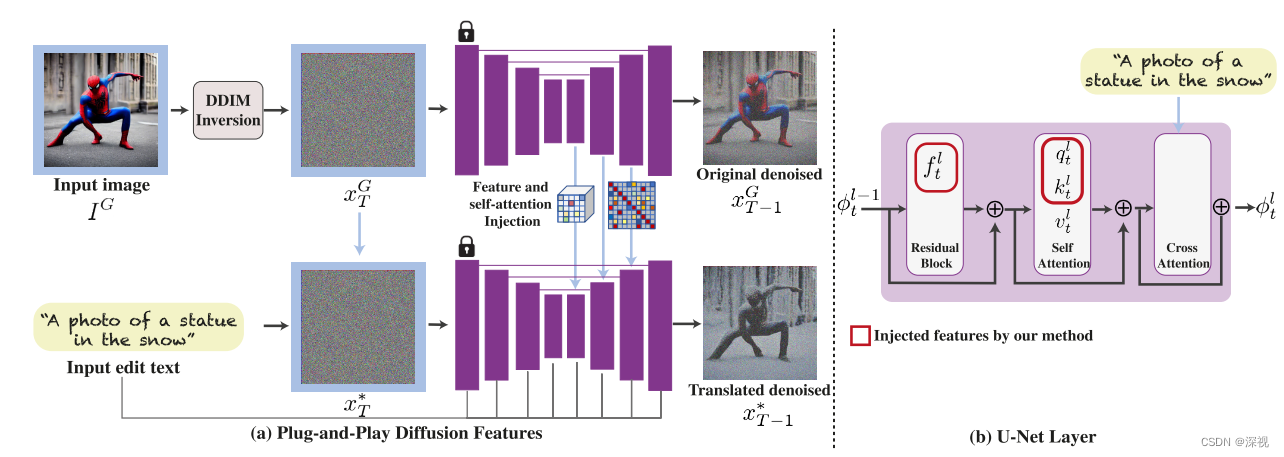

该文提出一种文本驱动的图像转换方法,输入一张图像和一个目标文本描述,按照文本描述对输入图像进行转换,得到目标图像。作者对输入图像进行重建,并将重建过程中的特征图和自注意力层中的相似性图抽取出来,注入到目标图像的生成过程中,从而实现对生成图像的布局、形状的约束和引导。文本的特征还是通过交叉注意力机制引入,来实现对目标图像的修改。

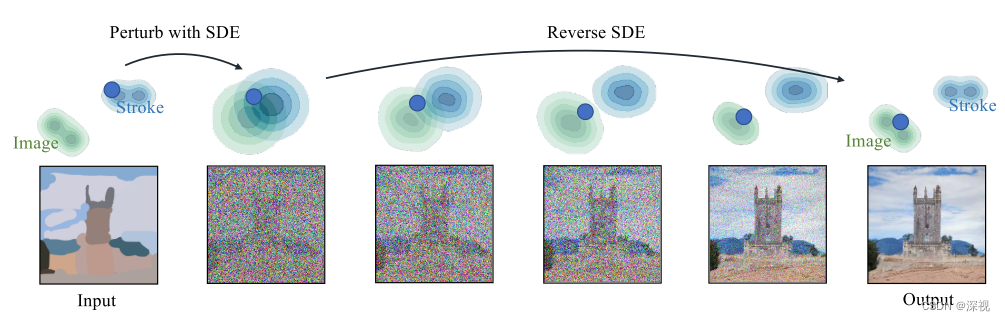

通过使用者在原图上给出一些引导,比如在图像上涂鸦或者增加一个图块,甚至可以不给定原图,直接纯手工绘制一个涂鸦作为输入,模型就能够根据输入的带有引导信息的图像生成对应的结果,如下图所示。生成的过程基本延续了SDE的方法,作者在正文中以VE-SDE为例介绍了扩散和采样的过程,在附录中给出了VP-SDE的介绍,二者本质上是一致的。作者将SDEdit与其他基于GAN的图像生成和编辑算法进行了对比,结果表明

核心思想 本文提出一种基于双目图像进行透明物体位姿估计的方法。作者首先回顾了现有的位姿估计方法,通常采用单目相机获取目标2D图像,并与物体的3D模型或者RGB-D获取的点云图像进行匹配,进而实现位姿估计。而RGB-D传感器对于透明的,光滑的物体,其距离感知效果并不好。为了解决这个问题,作者采用了双目立体视觉来获得透明物体的深度信息,并通过提取物体上的关键点,利用反透视变换来获取关键点的3D坐标。